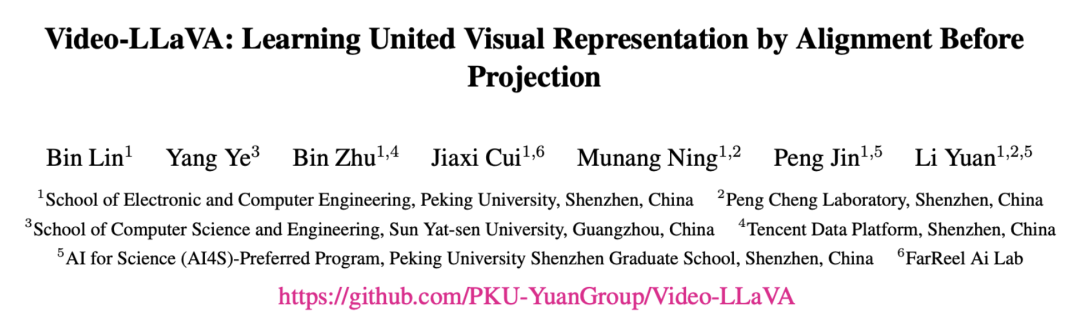

北京大学和其他机构的研究人员近期提出了一种名为 Video-LLaVA 的视觉语言大模型。该模型的创新之处在于能够同时处理图片和视频作为输入。在处理图片的任务中,该模型展现出了出色的性能,在多个评估榜单中名列前茅,尤其在视频方面取得了令人瞩目的成绩。这项研究的关键点在于关注如何将 LLM 的输入统一起来,从而提升 LLM 在视觉理解方面的能力。

北大开源视频大模型 Video-LLaVA 演示视频

- 论文地址:https://arxiv.org/pdf/2311.10122.pdf

- GitHub 地址:https://github.com/PKU-YuanGroup/Video-LLaVA

- Huggingface demo 地址:https://hf.co/spaces/LanguageBind/Video-LLaVA

Video-LLaVA 在图片,视频上的 13 个基准上达到先进的性能

Video-LLaVA 在图片,视频上的 13 个基准上达到先进的性能

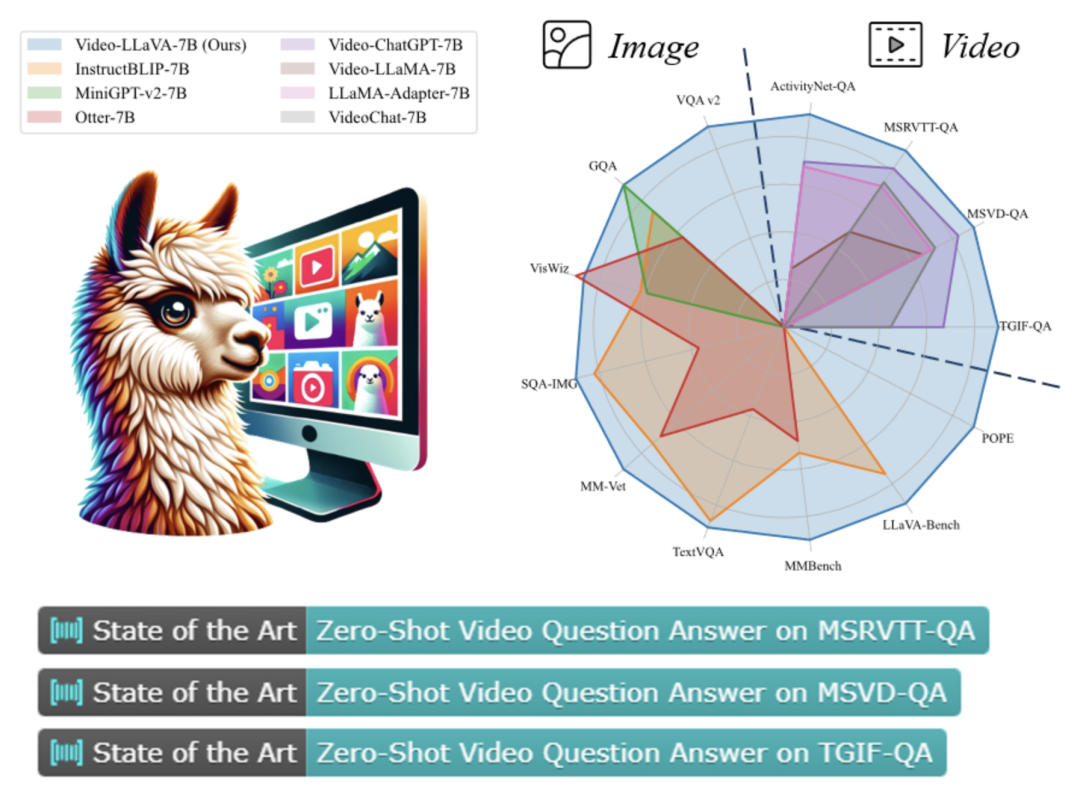

具体来说,北京大学的研究人员提出了一种名为 Video-LLaVA 的解决方案。与以往的视觉语言大模型不同,Video-LLaVA 的重点在于将图片和视频特征提前绑定到一个统一的特征空间中,以便语言模型能够从统一的视觉表示中学习模态之间的交互。为了提高计算效率,Video-LLaVA 采用了联合图片和视频的训练和指令微调策略。这项工作为解决”投影前对齐” (alignment before projection) 的问题提供了一种方法。研究人员希望更多的社区研究人员能够关注到通过优化视觉文本输入来提升语言模型的理解性能。

值得注意的是,Video-LLaVA 在训练过程中没有使用成对的视频和图片数据,但在训练后,LLM 令人惊讶地展现出同时理解图片和视频的能力。如下图所示,Video-LLaVA 成功地识别出自由女神像的图片是近景且细腻的,而视频描述了自由女神像的多个角度,表明它们来自同一个地方。

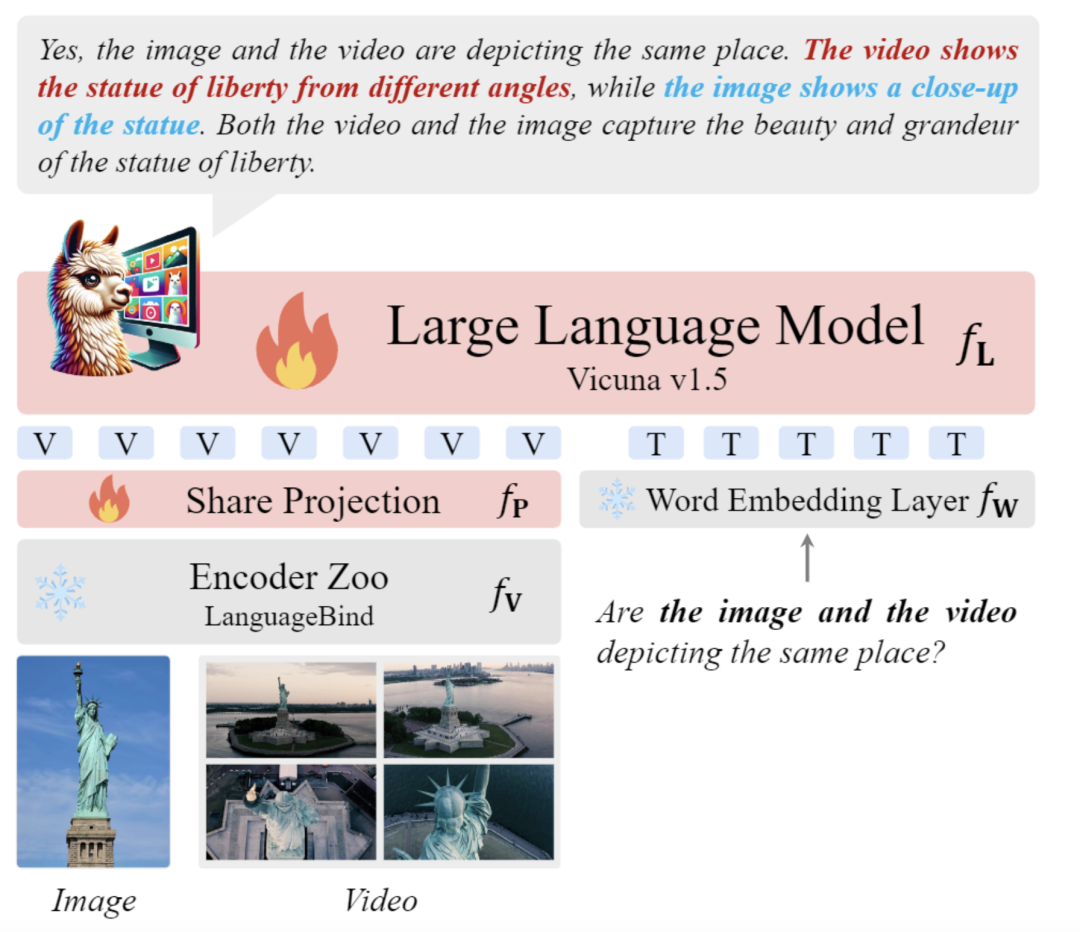

视觉理解阶段: 在这个阶段,使用了 558K 个 LAION-CC-SBU 图像-文本对和 Valley 的子集中的视频-文本对。模型通过广泛的视觉-文本对数据集来学习解读视觉信号的能力。每个视觉信号对应一个对话回合的数据。训练目标是原始的自回归损失,模型专注于基本的视觉理解能力。其他参数在此阶段被冻结。

指令微调阶段: 在这个阶段,收集了来自 LLaVA 的 665k 个图像-文本数据集和来自 Video-ChatGPT 的 100k 个视频-文本数据集。模型根据不同的指令提供相应的回复。这些指令通常涉及更复杂的视觉理解任务。对话数据包含多个回合,如果涉及多轮对话,输入数据会将之前回合的对话与当前指令连接起来。训练目标与第一阶段相同。在这个阶段,大型语言模型也参与训练。

实验

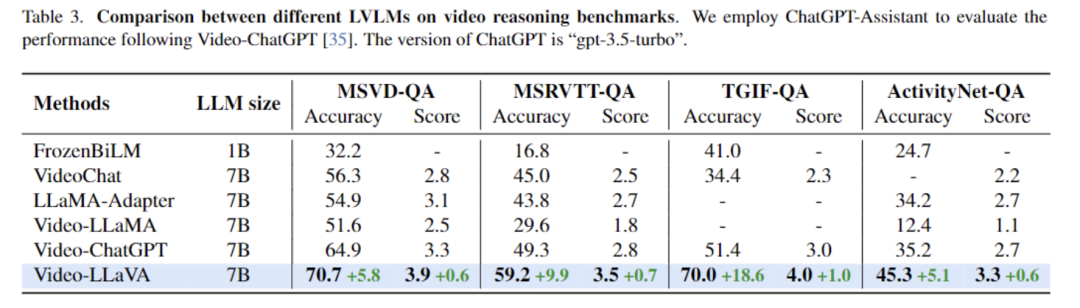

视频理解能力实验。 如表 3 所示,Video-LLaVA 在 4 个视频问答数据集上全面超过了 Video-ChatGPT,并且涨幅相当可观。

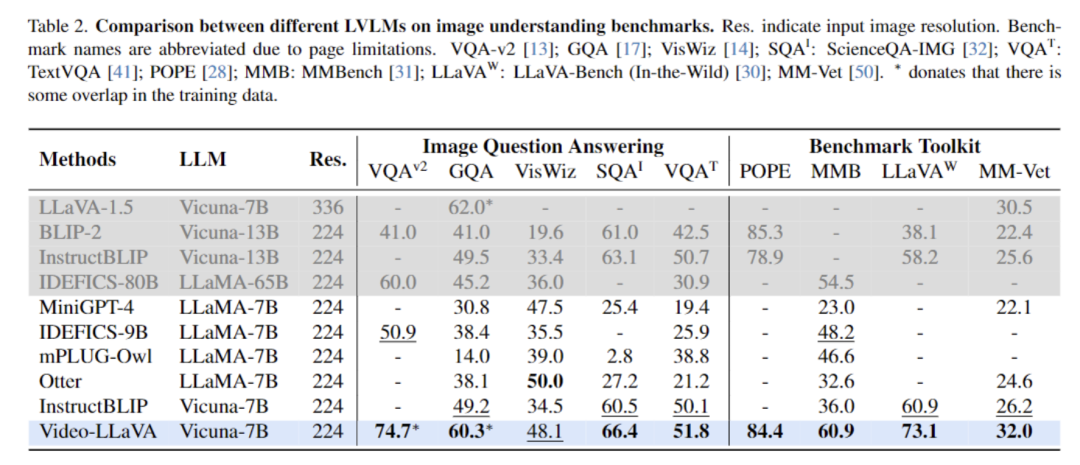

图片理解能力实验。 该研究还与 InstructBLIP、Otter、mPLUG-owl 等图片语言大模型在图片语言理解任务上进行了比较,结果如表 2 所示:

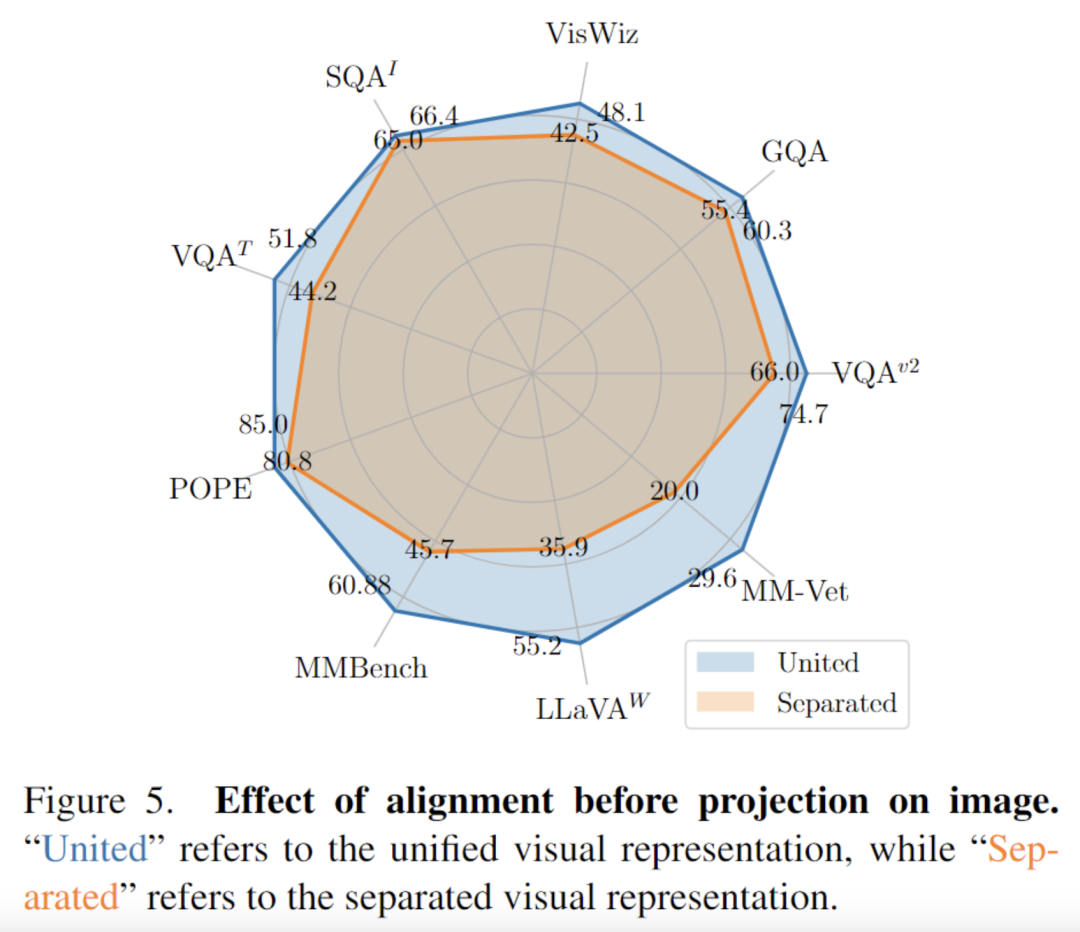

为了评估预先对齐视觉输入的效果,研究团队进行了大量的对比实验。他们使用了相同规模的 MAE 编码器替换了图片编码器,其中 MAE 编码器生成分离的视觉表示,而 LanguageBind 编码器生成统一的视觉表示 (因为预先对齐了视觉表征)。然后,他们在 13 个基准测试中比较了 MAE 编码器和 LanguageBind 编码器的性能,包括 9 个图片理解基准和 4 个视频理解基准。

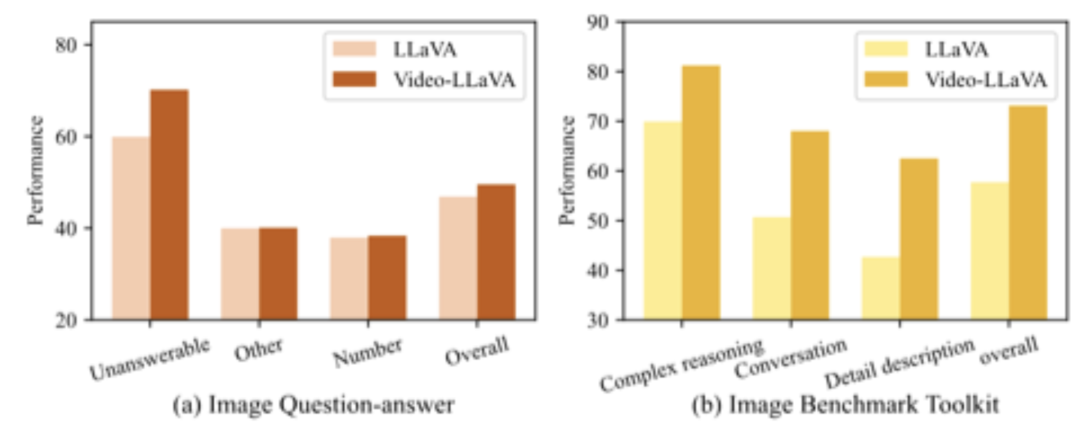

研究结果显示,统一的视觉表示在图片理解方面展现出强大的性能。它在 5 个图片问答数据集和 4 个基准工具箱上都明显优于分离的视觉表示。此外,团队还发现,在 POPE、MMBench、LLaVA-Bench 和 MM-Vet 这四个基准工具箱上,统一的视觉表示相较于分离的视觉表示有着显著的优势。这凸显了预先对齐视觉表征的好处,它不仅提升了图片问答性能,还在其他图片理解任务中带来了诸如减小幻觉和提升 OCR 能力等方面的收益。

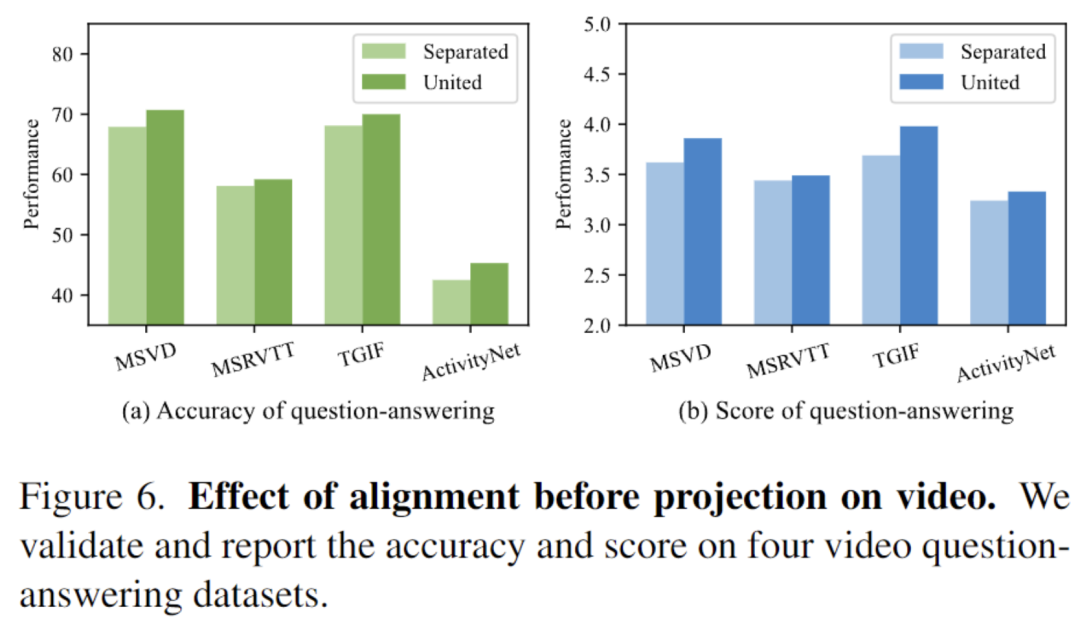

通过替换图片编码器为 MAE 编码器,LLM 在初始学习视觉表示时将视频特征和图片特征分开处理,不再将它们统一起来。有关图 6 的实验结果显示,与分离的视觉表示相比,联合的视觉表示在 4 个视频问答数据集上显著提升了性能。这一发现表明,预先对齐的视觉表征有助于 LLM 进一步学习和理解视频内容。它提供了更好的能力,使得模型能够更有效地处理视频问答任务并展现出更好的性能表现。

同时论文还验证了无论是对于图片还是视频,在联合训练中他们能相互受益。

通过联合训练视频数据,对于图片理解任务,可以缓解幻觉问题,并增强对图片中数字信号的理解能力。类似的趋势也在 LLaVA-Bench 基准测试上观察到,视频数据的引入显著提升了 LLM 在图片复杂推理和对话任务上的表现。这表明,视频数据的训练对于提升图片理解能力是有益的,它帮助模型更好地理解图片中的细节和上下文,并在复杂推理和对话方面表现更出色。

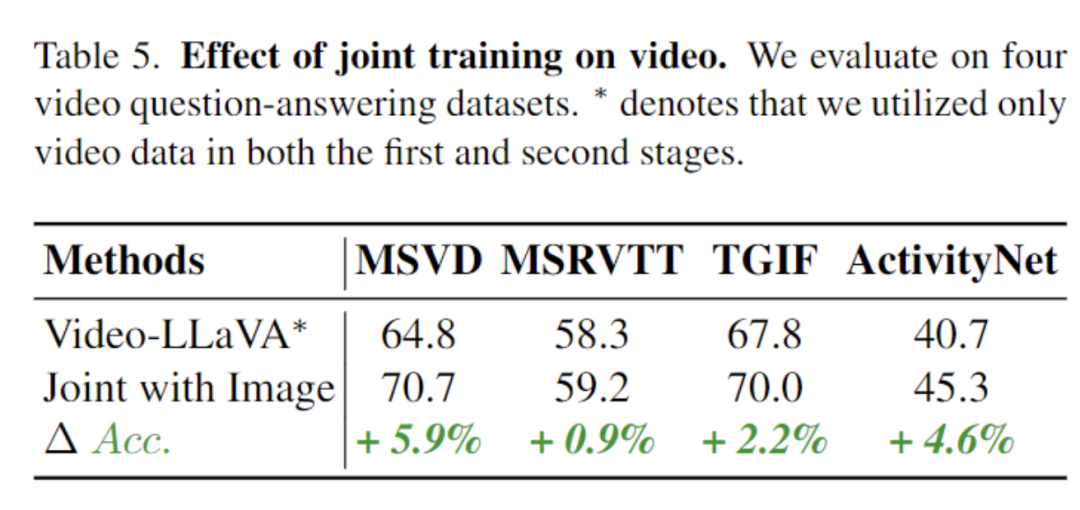

在视频理解方面,我们对 4 个视频问答数据集进行评估。与仅在视频数据上进行训练的 Video-LLaVA 模型相比,联合训练图片和视频的模型在这 4 个数据集上全面取得了更好的表现。这些结果表明,联合训练图片和视频能够促进 LLM 对视觉表示的理解能力。通过同时学习图片和视频的信息,模型能够更全面地理解和表示视觉内容,从而提高在视频问答任务上的性能。这证实了联合训练图片和视频的益处,对于增强 LLM 对视觉信息的理解具有积极的影响。

作者: (北京大学深圳信息工程学院) 林彬、叶阳、朱斌、崔家熙、宁慕楠、金鹏

指导老师: 袁粒

本文由 Hugging Face 中文社区内容共建项目提供,稿件由社区成员投稿,经授权发布于 Hugging Face 公众号。文章内容不代表官方立场,文中介绍的产品和服务等均不构成投资建议。文章来源: 北京大学 ChatLaw 课题组。

如果你有与开源 AI、Hugging Face 相关的技术和实践分享内容,以及最新的开源 AI 项目发布,希望通过我们分享给更多 AI 从业者和开发者们,请通过下面的链接投稿与我们取得联系:

https://hf.link/tougao

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง