AI 时代是否会催生“新时代的好莱坞”?AI 对视频制作的改造可以简单分为三类:视频生成(Text-to-Generate)、AI 视频编辑(AI Editor)以及数字人(Avator),后两者从视频编辑切入,用 AI 提效,而视频生成意味着内容创作的极度民主化,有机会彻底改造传统工作流,也最让我们感到兴奋。

技术视角下,相对于文本、代码和图片生成,视频生成(Text-to-Video)也一直被认为是 AIGC 的“高地”,面临庞大的计算需求、高质量数据集短缺、可控性等挑战。

视频领域何时会迎来自己的 GPT 时刻?过去一年,Text-to-Video 领域的进展远比想象中迅速:Runway 先后发布了 Gen1、Gen2,上周推出的 Motion Brush 则在可靠性上向前了一步,Stability AI 也在上周发布了自己的首个 Text-to-Video 模型 Stable Video Diffusion。

今年 7 月,Pika Labs 在 Discord 推出服务器,并在几个月时间内收获了 50 万用户,大家开始将视线转向这家被称为视频生成领域“黑马”的公司。

Pika Labs 的团队相当精简,目前仅有 4 位全职成员,但兼具学术和创意两个领域顶尖人才:Demi Guo 和 Chenlin Meng 同为 Stanford AILab 的博士研究人员,拥有顶尖的学术和科研经历;Karli Chen 作为团队第三位创始人及创始工程师拥有 CMU 的 ML&CV 硕士学位,Karlin 本科期间就在机器视觉公司 SenseTime 担任工程师;Matan Cohen-Grumi 则是拥有丰富经验的创意领域。

Pika Labs 最新官网

今天,Pika Labs 正式推出了最新一代视频生成模型 Pika 1.0。Pika 1.0 不仅对视频生成质量进行了提升,还支持 3D 动画、动漫或电影等多种风格视频,此外,用户还能够通过 Pika 实现画布延展、局部修改、视频时长拓展等编辑需求。在推出 Pika 1.0 的同时,团队也上线了最新官网,用户不仅能在 Discord 上使用 Pika 的服务外,还可以在官网进行视频生成和编辑(官网地址:https://pika.art)。

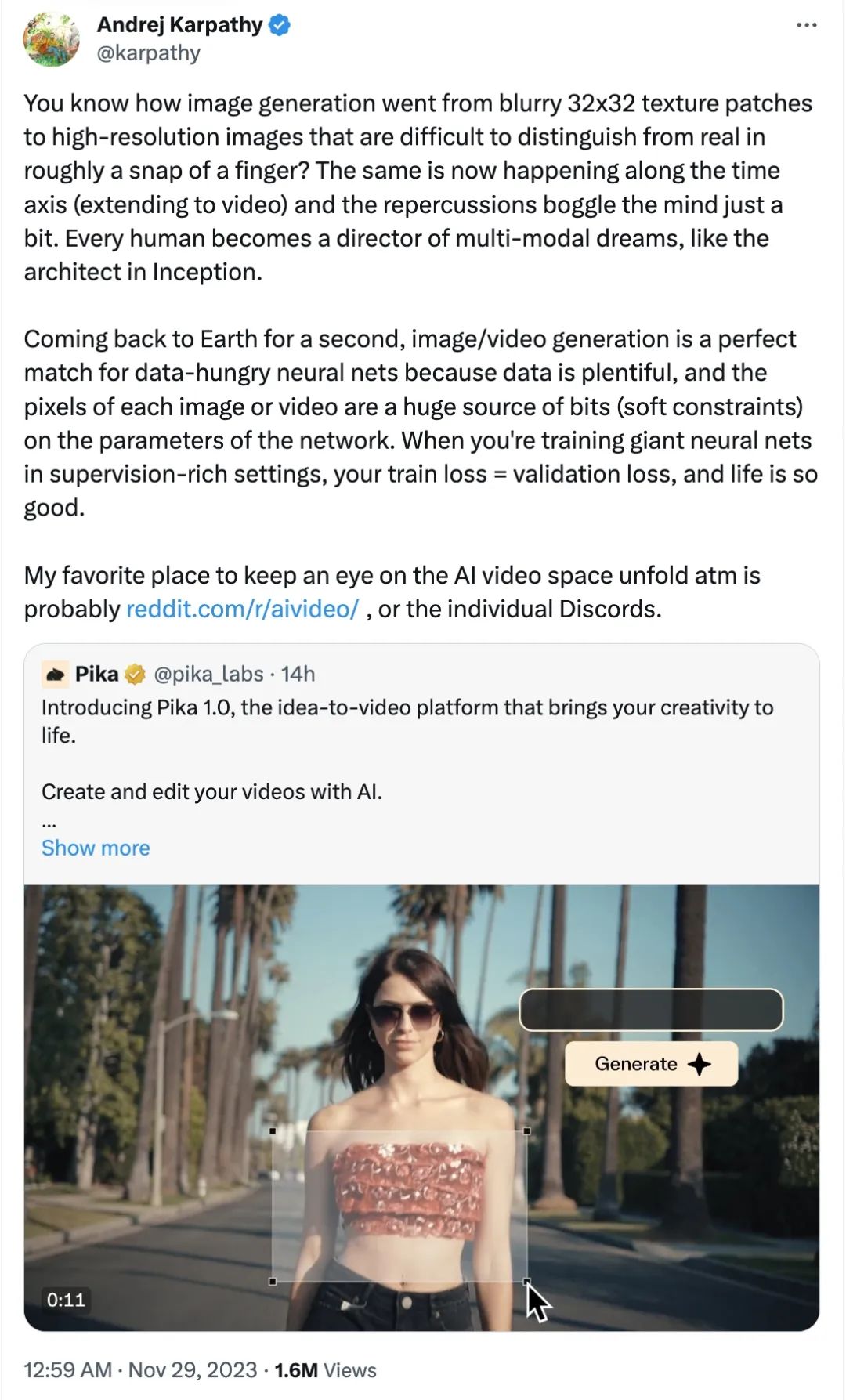

Pika Labs 目前已经累计完成 3 轮、共 5500 万美元融资,最新估值为 2.5 亿美元。Nat Friedman 、 Daniel Gross 和 Lightspeed 分别领投了 Pika 的 Pre-Seed、Seed 和 A 轮融资,此外,众多硅谷明星投资人、AI 领域重要公司 CEO 或核心成员也参与了 投资,例如:Elad Gil、Adam D’Angelo(Quora 创始人及 CEO)、Andrej Karpathy、Clem Delangue(Hugging Face co-founder 及 CEO)、Aravind Srinivas(Perplexity CEO)、Mateusz Staniszewski(ElevenLabs CEO)以及 Keith Peiris(Tome CEO ) 等。

海外独角兽在 Pika 1.0 发布之际也对 Pika Labs 两位创始人 Demi 和 Chenlin 进行了访谈,两位创始人分享了她们的个人经历和创业故事,对视频生成技术的理解,以及对 Pika Labs 产品及商业化的思考。

Demi Guo 和 Chenlin Meng,受访者供图

Demi Guo 和 Chenlin Meng,受访者供图

嘉宾简介

Demi Guo:Pika Labs 创始人兼 CEO,高中时期进入 IMO (Interational Math Olympiad) 国家集训队,并在2015年IOI (International Olympiad in Informatics) 中获得银牌。在哈佛大学获得数学学士学位时,Demi 同时攻读了计算机科学硕士学位,并转至 Stanford 攻读博士学位,师从 Ron Fedkiw 和 Chris Manning 教授,进行图形学和 NLP 交叉领域的研究。除此之外,Demi 在大二 gap year 时期成为 Meta AI Research 最年轻的全职员工,也在Microsoft、Google Brain、Epic Games 等公司实习,拥有很强的工程和科研能力。

Chenlin Meng:Pika Labs 联合创始人兼 CTO,在 Stanford 攻读数学学士学位期间即在 Stefano Ermon 教授指导下开始学习研究生课程,并在本科期间就发表了 5 篇 Generative AI 方向论文,完成本科学业后,Chenlin 继续在 Stanford 攻读计算机 Ph.D 学位,在 3 年时间中发表了 30 多篇论文,其中,她参与创作的 DDIM 论文是内容生成的重要论文之一,DDIM 是一种重要的内容路线, OpenAI 的 DALLE-2、Google Imagen 以及 Stable Diffusion 等模型都使用了这一方法。

01

天才少女创业,抓住行业变化窗口期

海外独角兽:为什么选择创业做视频生成,当时看到了什么样的机会?

Demi:我对创意行业和用 AI empower content creation 一直很感兴趣,很有热情。我从小学画画,家里人也有不少是做艺术行业的,我也一直想往这个方向创业,读博选的也是 AI 和 creation 方向。我在博士期间有两位导师,一位是做 AI 的 Christopher Manning,现在是 Stanford 人工智能实验室的主任。另一位是 Ron Fedkiw ,是做创意、电影行业的,得过两次奥斯卡奖,也参与过加勒比海盗、星球大战等电影的特效,他现在也是我们公司的 advisor,我有时候和老师开玩笑说,他在计算机图形学火起来的时候,改变了整个电影行业,而我们现在想用 AI 再次改变行业。我觉得这个方向能做十年。

在视频生成之前,我考虑过游戏行业,因为如果用 AI 去做 content creation,游戏最容易商业化,我在斯坦福读博期间还专门去 Epic Games 实习,了解游戏行业的痛点。但后来发现视频行业比游戏更不成熟,更有机会。

今年年初,Runway 举办了第一届 AI movie Festival,我找了几个 Stanford 的 AI 博士还有其他朋友,组成了一个六、七人的团队,还请来一位得过两次艾美奖的编剧。我当时以为这个团队一起制作电影应该不难,但实际制作的过程中意识到,现在的视频工具非常复杂,想表达心中的想法门槛很高。有时候我们想做很小的事情,比如换个背景,几秒钟的内容也要消耗几小时,软件还经常 crash。我意识到电影行业和视频制作过程之间有很大的 gap,对非专业的人来说,视频工具很难学,每个细节都要用很复杂的工具完成;而对专业的人来说,即使已经熟练运用工具,还是要消耗大量时间。

海外独角兽:在这个过程中,你感受到 AI 会在视频行业里起到什么样的作用?

Demi:我们当时已经在用 AI 赋能,那时候 Runway 还没发布 Gen-1,我们用一些 AI 算法实现了一个从 real action 到 live action 、再到 animation 的电影作品。那时制作视频的 AI 算法不少,但没有被嵌入到任何工具里。我个人认为当 AI 功能非常强大时,视频制作不可能再这么复杂,未来一定会有完全不同的体验。这件事非常确定,但当时好像没有很多人去做这件事。

我还意识到一件重要的事,就是 AI 无法替代艺术创作者。我们那个电影制作团队有这么多 AI PhD,还找了很好的编剧,但还是很难做一个很好的电影作品,做出来就是不够好看。所以我意识到,AI 能做的是高效生成内容,给创作带来无限可能,但要选择哪种可能,还是要有艺术家来导演。比如说,如果有一个 visual guidance 就能让 AI 生成任何东西,但我们不知道这个 visual guidance 应该怎么做,生成的东西可能景深有问题,可能灯光有问题,就是不好看。

很多艺术家会担心 AI 视频工具会替代他们,但我的亲身感受是 AI 无法代替,它可以帮助艺术家去更加效地去实现创意性的想法,并且让更广泛的非专业人士更容易上手使用创意工具。所以 AI 只是一个帮助人们解放创造力的工具,减少琐碎工作,让人去导演 AI,这是我们和 AI 的关系。

Pika1.0 Text-to-Video 效果

海外独角兽:Pika Labs 的创始团队成员是什么背景,你们是怎么聚在一起的?

Demi:我的 Co-founder 是 Stanford 本科,我是 Harvard 本科,留学圈很小,所以我们之前就认识。后来我们都在 Stanford 读博,她刚好也想做这个方向,而且在图像生成方向发了 30 多篇顶会了。我们还有一个创始人,Karli Chen,他是我的高中同学,高中信息竞赛获得过国家前12、是物理竞赛国际集训队成员,他主要做 engineering 方面的工作。他之前和我们一起做了电影的项目,对我们创业项目很感兴趣,所以公司还没成立他就来了。

我们最近加入了一个专门做视频的成员,他之前在以色列自己经营一个 production studio,现在准备到美国和我们一起做这个事情。我们团队目前全职只有四个人,但我们有很多 intern 和 part-time,大多是 MIT、Stanford 的博士和本科生,大多都有竞赛经历或者发了很多 paper,所以团队技术背景很强。

高中时我在 Quora 实习,认识了 Quora 的 CEO,和他 catch up 的时候聊到了我们的 idea,他非常感兴趣,帮我们介绍了后来的领投 Nat Friedman。我们给 Nat Friedman 展示了初步探索的成果,他也很感兴趣就投了。

Chenlin:我对创业的热情一直高于做学术。我和 Demi 在某些方面非常相似。我们都是从国内高中直接去美国读本科,认识很多年了。Demi 小时候就喜欢写作和绘画,我也有类似经历,花了多年时间学二胡和画画。小时候我就想象,如果有工具可以让我把想法直接画出来,就像哆啦 A 梦的工具箱一样该多好。这个想法一直延续到现在,成为我一直想实现的梦想。我们俩最神奇的地方就是,都有很强的技术背景,又都很喜欢艺术。在创业之前,甚至独立地参与了一些相似的项目,这种巧合让我们感觉非常契合,她给我讲对未来产品的设想和规划,我一听就觉得,我也是这样想的。

海外独角兽:你从高中一直参加计算机竞赛,是国家队里少有的女性成员,这样的经历对你创业带来了怎样的影响?

Demi:当时打竞赛纯粹出于热爱,觉得计算机非常有意思。现在看来打竞赛的经历让我在 engineering 方面比较有优势,写代码特别快,因为有些实时比赛,从读题到写对程序必须在五分钟内。我们现在也有些搞竞赛的实习生,他们也对 scaling 中的 engineer 工作很感兴趣。

海外独角兽:半年前,只有 Runway 在做视频生成,产品效果不如 demo,大家也觉得这块技术很难。如今 Pika Labs 等创业公司涌现,都实现了不错的效果,相关论文也多了,有人评价 Runway 的技术被追平了。你们怎么看这个行业的变化?

Demi:我觉得行业内之前的 player 没有很强的技术背景,优势在于先开始做这件事情。Pika 非常幸运的一点也是占据了先发优势,这也是我急着创业的原因——因为我看到了 AI 视频生成技术进展迅速,但其他人都没开始做。1 月份我们产生创业想法时,Runway 还没发布视频生成模型。当时所有 VC 都不看好视频行业,因为从商业化角度,他们只看到现在的视频生成模型还很不理想,但我们一直在做技术,我们知道速度的变化很快,进展非常 promising。现在随着技术的发展逐渐显露出来,越来越多的人开始做这件事。所以创业时我非常着急,觉得视频生成行业可能很快要火了,要抓紧做。

过去几个月,AI 视频生成已经取得了很大进步。如果看去年 AI 生成视频的效果,再看今年 3 月份的,再看最近一两个月的,你会发现视频生成模型的发展非常快。可能在不久的未来,也许明年,就能达到 AI 图片生成的效果。虽然现在视频模型没有那么完美,但图片模型在一年半前也不好,现在已经非常好了。

Chenlin:现在 Runway、Genmo、Imagen Video 等,生成的视频在质量上相差不大。大家似乎都卡在一个瓶颈上,没有人真正冲破。虽然宣传视频都不错,但实际使用有很多问题,比如存在不少 “artifact”,流畅度、时长不够。虽然 Runway 现在有 extension 功能,但效果也一般,如果我想要一个复杂、有逻辑的动作,比如让一个机器人先往前走,再右转,再左转,Runway 的 extension 功能是做不到的。行业里还没有人突破。这也是让我们兴奋的原因,还有很多技术创新和突破的空间。

Pika 1.0 Expand 功能效果

海外独角兽:从创业到现在短短六个月时间,Pika 的技术、产品、融资进展都很快,在这个过程中有哪些是预料之中的,有哪些是之前没预想到的挑战和困难?

Demi:也许六个月前不会想到现在的发展,我们的发展的确是比较顺利,四五月融了 3 轮,收获了将近 50 万用户,每周有上百万 generation。

但对于现在的发展我们并不意外,可能我们还觉得现在的发展和预期中比起来,做得还不够好。我们团队之前设立了非常 ambitious 的目标,想在暑假发布一个新产品,实现百万用户,然后再融一轮。我们的融资时间比预想的要早,还有一些细节上和设想中不一样的地方,比如早期 marketing 的时候我们试了很多方法,没有想到其中一些方法会发挥作用,帮助我们获得了很多用户。所以我们会继续做更多尝试。

海外独角兽:领投了你们 Pre-Seed 轮的投资人 Nat Friedman 非常有名,你跟他接触过程中印象比较深的是什么?他给你们提过什么好的建议?

Demi:我们的投资人非常 founder-friendly,非常 supportive。我们融资其实都是 pre-empted,所以其实没有跟很多投资人聊。非常幸运的是我们的投资人非常友好,给了我们很多 hands-on advice,他给的建议很难列举,都是针对一些特定问题给我们非常具体的建议。他回复消息很及时。

他也非常了解技术,有时还会写写代码。比如说我们有时候要改一些代码,他就给我们提供了一个专门改 code 的 plugin,还帮我们写过一个下载数据的脚本。

02

视频生成的 GPT 时刻

海外独角兽:如何更好的理解视频生成技术,它和图像生成有什么相同和不同?

Demi:AI 生成图片和 AI 生成视频的模型有共通之处,它们相比于语言模型就是完全两类模型,有专门生成图片或者视频的模型,比如 diffusion model。

视频有很多和图片不一样的问题,比如要确保视频的流畅性、确保动作,视频比图像更大,需要更大的 GPU 内存,视频生成需要考虑逻辑问题,还要考虑如何生成,是一帧一帧生成,还是一起生成,现在很多模型是一起生成,生成的视频就很短。但如果要一帧一帧生成,又要怎么做?很多都是图片生成不会面临的新的技术问题。

Chenlin:视频的每一帧都是一张图片,但比图片困难得多。每一帧的生成质量要高,相邻帧之间还要有关联性。当视频很长时,确保每一帧都协调一致是个相当复杂的问题。在训练时,处理视频数据时要处理多张图片,模型需要适应这种情况。比如,如何将 100 帧图片传输到 GPU 上是一个挑战。而在推理时,由于涉及到生成大量帧,推理速度相对于单张图片会更慢,计算成本也会增加。

此外,控制视频生成更难,因为模型需要生成每一帧发生的事情,而用户不会希望为每一帧都提供详细的描述。此外,视频生成涉及到更多的空间维度,让问题变得更复杂。再加上互联网上视频生成的训练数据集相对于图像更少,也给获取高质量数据增加了难度。

海外独角兽:现在视频生成有哪些关键点需要突破?

Demi:首先是时长,跟时长很相关的是动作的意义。所有模型都很容易做一个 extension 的功能,把视频时长延长很多,但它并没有真的延长,因为它生成的动作没有意义。比如说我们可以做 20 秒的走路视频,但它可能做不了比如说走路、翻滚、奔跑之类的一个体操系列。所以我们不仅要延长视频制作的时长,还要关注动作的意义,看它到底能做多复杂的动作。

视频的清晰度也需要进一步提高。尽管清晰度方面已经有突破,但还没有提高到电影级的水平,现在生成的视频一般是 720p 分辨率,视频的流畅性也不够理想,特别是一些细节的 texture。还需要考虑 general artifact 的问题,比如说一个人有两个头,就是这种明显不符合常理的问题,也是需要避免的。

海外独角兽:现在视频生成的技术收敛了吗?是否像语言模型那样有了确定的技术路线,通过 scaling 就能获得很大的提升?

Chenlin:现在还没有收敛,大家都在往各种方向尝试,每个人都认为自己的模型是最好的,可能有人认为 autoregressive 最好,有人认为 Masked Model* 最好。Pika 也不能完全算 Diffusion Model,我们开发了很多新东西,是一种新的模型。

Masked Language Modeling(MLM):指通过让模型预测文本中某些被掩盖的词语来训练模型,帮助模型理解上下文和语法。相对于 autoregressive 预测下一个Token,MLM 更像是“完型填空”,BERT 是 Masked Model 的典型代表。

现在语言模型的路线很确定,有一个原因是 OpenAI 投入了很多资金去试,为什么 GPT 没有用于视频,可能因为他们的资源、人力都集中到了文本模型上。如果有一个公司投入很多资金,也许 diffusion model 也能做出不错的语言模型。但大家既然已经看到 OpenAI 的方法奏效了,就觉得没必要花费大量资金去投入别的方法。

而视频还没到那个阶段,所以我觉得未来往什么方向走都有可能,比如 GPT 的方式可能在某种程度上适合,因为 GPT 可以捕捉上下文,而视频中也需要一个上下文,相当于每一帧都需要考虑整个系统。我觉得最终还是希望能够利用每个模型最擅长的那一部分,因为视频可能每一帧仍然是一张图片,那是不是 diffusion model 可以生成得更好,是不是应该同时使用 GPT 和 diffusion 网络,我觉得最后会有很多方式可以构建这样的模型。

海外独角兽:在你们看来,AI 视频生成什么时候会迎来 GPT 时刻,如何去形容这样的 GPT 时刻?

Demi:我希望明年就可以实现。给用户的感受就像 ChatGPT、Midjourney v5 那样,有一个显著提升。各方面都需要有改进,比如说视频生成模型的创新,engineering,包括数据、scaling 等等。

Chenlin:我觉得目前视频生成处于类似 GPT-2 的时期,很可能在未来一年内有一个显著的提升。如果回顾图像生成,我记得在 2018 年时,我们实验室的博士后提了一个酷的想法,“如果以后维基百科的插图,都能根据维基百科的描述来生成该多好!”,大家听了都觉得是个很遥远的目标。然而到了2021年,已经有了 stable diffusion 和大模型。仿佛技术的发展时间被大大压缩了。所以我认为视频生成的突破也会比想象中快,到那个时候,生成视频应该是一个非常可控的过程,我们应该能够以更自由的方式生成任意长度的视频,而且生成的视频可以是任意长度的,人们可以像导演一样控制主角的行动,比如去咖啡馆喝咖啡,然后去学校上课,再运用我们的产品把所有片段拼起来成为一个完整的小短片。

Pika 1.0 AI Change 效果

海外独角兽:在实现视频 GPT 时刻这件事上,创业公司会扮演什么样的角色?在你们视角中,视频生成领域未来会呈现什么样的格局?

Chenlin:我认为视频领域的竞争可能会类似语言模型的竞争格局——一家公司发布新模型的时候,他们内部可能已经有了更先进的模型,领先其他公司一到两年。我认为未来在视频领域也会是一家公司领先一到两年、在冲锋,其他公司在追赶。

海外独角兽:形成这种差距的原因在哪里?

Chenlin:首先在技术方面,例如团队是不是最聪明,是否是最创新的团队,其次也和团队相关,团队需要一个清晰的目标,并一步步去执行这个目标。例如,数据是一个重要问题,处理一个数据集并不简单,比如我们要获取到 10 亿条数据,过滤和标注 10 亿条数据不是简单的事,团队要有能力处理整个流程,不会有特别多团队能够把这个流程做得特别好的。

海外独角兽:在视频生成领域什么样的数据算高质量的数据?

Chenlin:首先是像素,就是我们说的画质好不好,然后看审美和艺术构图,第三方面是要有动作,并且这些动作是有意义的,比如电影里面其实有很多很漂亮的视频,但大部分动作都是人站在那边动嘴巴,虽然这些画面非常漂亮、也是很多著名导演专门设计出来的,但如果把它们用来训练模型不一定能完全训好。因为如果只用这些数据而不用其他内容的话,训出来的模型可能真的就学到后面所有人就只是在动嘴巴,也没有其他有意义的动作。

另外,视频的长度也很关键,如果模型都在 1 秒的视频上进行训练,那么想让模型去生成 30 秒的视频难度就很大,要么需要收集更多更长的数据让模型学习,要么就去重新训练模型的算法,让它只通过学习 1 秒的视频也能生成 30 秒的视频。所以数据创新或算法创新是必不可少的。

对于我们来说,版权始终也是一个重要问题,尤其在美国。我们肯定会与美国本地的律师团队合作,共同研究如何解决版权问题。

海外独角兽:你认为视频生成和 LLM 相比,哪个领域的人才和团队更稀缺?

Demi:长期来看,视频行业的人才可能更稀缺。视频行业不能看现在,要看未来。我们发布第一个产品的时候,还没有开源模型,我们自己训练模型然后发布。最近由于开源模型的出现,导致更多 player 进入这个行业,但这个现象是短暂的。

相较于 LLM 的发展已经有了比较明确的路线,只需要不断提升 Scaling,如果想要做出很好的视频模型并且想投入商用,还需要在模型架构和算法层面做出技术突破。举例来说,视频都是 Sequence of Images, 现在的方法是所有 Images 一起生成,受到 GPU 内存的限制生成的视频都很短,所以我们需要新的方法才能生成更长的视频。再比如,视频生成模型领域可能还没有像 LLM 的 Scaling Laws 那么清晰的原则或规律出来。

视频生成模型还需要模型的创新,也需要很多的 engineering,这件事情不是所有人都能做成的。哪怕在 LLM 领域,OpenAI 也掌握了技术壁垒,所以即使现在有了 LLaMa 这样的开源模型,有很多人能做很多事情,但只有 OpenAI 能做 GPT-4。

海外独角兽:Pika 有没有信心成为视频生成行业里技术最强的团队?

Demi:我们有这个信心,这也是我们想做的事情,我们想做技术最强的团队,之后我们可能还会招更多人。

海外独角兽:如果想要保持住先发优势行业领先地位,需要做什么?如何建立公司的护城河?

Demi:首先要有先发优势,然后要不断积累资源,包括用户资源、数据和 GPU 资源等等。技术的发展和资源的积累其实是一个滚动的过程,比如说积累更多用户也会有助于我们训练模型。技术团队也非常重要,要招募更多技术人才。

Interface 设计方面也很重要,最后很有可能一部分是技术,另一部分是设计与技术相结合,设计会为技术发展提供灵感,技术也可以支持设计,这个壁垒可能会越来越近。

海外独角兽:当年 Stable Diffusion 发布时,由于模型较小,对算力的需求较低,社区也做得很好。视频领域对算力需求较高,是否会因此导致开源贡献有限,有意思的东西更多由像你们这样的专业公司来完成?

Chenlin:我认为开源社区可能没有足够的算力来训练新的视频模型,因为训练一个新视频模型需要非常多的机器。对于 Stable Diffusion,有人可能用 8 张 A100 就能从头开始学习,并得到不错的结果。但对于视频模型,用 8 张 A100 可能不够了,可能无法训练出一个好的模型。而且视频模型本身的问题还没得到解决,因此大家可能会遇到一些瓶颈。首先,模型性能可能不够好,其次,一些算法方面的问题也不够好。但是修改模型、架构,修改算法都需要从头开始转换模型,我认为开源社区的人,甚至包括一些高校的人,没有这么多机器用来这些探索性工作。因此,我的理解是,开源社区会面临很大挑战,除非有一天像 POTX 或 TAI 这样的人有很多卡,愿意做慈善,开源一个模型。除了一些大公司开源模型外,普通开源社区很难进行探索性工作。

我们相信视频最终可能需要像训练 GPT 那样的大规模算力,现在大家还没使用那么多算力,一方面是因为视频模型还没达到像 GPT 那样的水平,另一方面是因为还有一些架构和技术上没解决的问题。我们相信这些问题改善后,未来会有新一代的视频模型达到类似 GPT 的规模。

该视频由 Pika Labs 团队的 Matan 仅用一天制作完成,而在过去,这样的广告要耗费一个 30 人团队一个月时间

03

要做最好的技术,也做新一代Interface

海外独角兽:前阵子你们发布的花朵视频效果非常惊艳,即将发布的新产品会有什么大的变化?

Demi:我们会发布新的模型,新产品和以前比会有很大的变化,首先肯定是生成质量的提升,能够生成的内容风格会更多,其次,编辑上也会更加灵活,我们会提供画布延展、局部重绘、视频时长拓展等功能。使用上除了 Discord 之外,我们也会上线全新官网,用户可以直接在网页端进行内容生成和编辑。我们计划明年推出能投入商用的产品,可能暂时不能制作整部电影,会先做影片中的一些素材或者 short clips。

海外独角兽:你们的模型现在是第一个,还是已经是第二个或者第三个版本了?

Demi:我们其实训练了很多模型,未来即将发布的是最新的版本。

海外独角兽:为什么 Pika 的艺术家生成的视频效果很惊艳,普通用户在 Discord 里生成的视频效果还没那么好,产品的使用门槛是否比较高?

Demi:一方面因为我们的艺术家用的已经是新模型了,模型本身就提高了很多。在生成花朵视频时,我们非常注重视频的连贯性,有很多方法可以控制视频的连贯性,比如说 prompt 一致,或者用 seed,用图片去控制。

另一方面,我们也计划提高产品的易用性,有时用户可能上传低分辨率的图片,或者复制了其他 prompt,在我们这里可能不适用,导致效果不佳。这些问题在我们的下一代版本中都将得到改善。

海外独角兽:Pika 团队现在是三个技术背景很强,还有一个视频行业的,那现在是谁主要负责产品设计,包括模型设计、整体的产品交互,以及怎么定位,最大的产品经理是谁?

Demi:因为我们团队人特别少,所以工作职责的划分比较模糊。最早的时候我们三个一起写代码,当时没有分谁做谁的。现在每个人都会有一个重心,比如说我高中同学主要做 engineering,我的co-founder 主要做 model。我主要做任何其他项目的事情, operation、product、融资都会去做,这也是创业公司的常态。不过这不是长期的事情,在有些事上我不一定是最合适的人选,我们今年年底会开始多招人。

海外独角兽:是否可以谈谈你们对产品设想、产品设计和迭代的方式是什么样的?你们和用户之间的沟通是什么样的?

Demi:关于产品的想法可以分为长期和短期。长期我们想做的不仅是一家公司,而是希望用 AI 改变视频行业,重新设计视频制作的 interface,给视频创作者带来完全不一样的体验。如果做成这件事,我觉得它的影响力会超越一家公司的影响力。另一方面我觉得,现在正处于 AI 发展过程中一个非常特殊的历史时刻,我们有机会用 AI 实现任何事情,所以我们希望给视频行业,乃至更广泛的内容创作行业的 interface 带来颠覆性的改变。

我们对公司 high level 的想象是,未来我们不仅想做最好的技术,也想做非常好的 interface,用技术去实现更好的interface,用 interface 来指导技术发展。

长远来看,我们未来的关注会更偏向用户端。现阶段我们和用户的交流在很多方面帮助产品发展,比如我们会记录用户的 interaction,比如用户上传或下载视频的行为、然后基于 RLHF 来改进模型。用户提供的数据也有助于我们进行产品的设计和迭代。

海外独角兽:你们理想中新的 Interface会是什么样的?

Demi:现在很难描述这个新的 Interface 会是什么样的,我现在能想象出来的 Interface 可能也不会是最好的,我们刚刚进入这个行业,这会是一个探索的过程。

海外独角兽:Pika 目前用户以个人用户为主,未来会更针对电影行业、广告行业还是短视频行业?对于目标受众有没有规划和讨论?

Demi:未来还不确定,但短期内会有比较具体的目标,比如明年上半年我们的目标主要是现在的 AI 用户。比如 Midjourney 已经有几亿美元的收入,有上千万用户,这是一个非常确定已知的市场,我们刚开始可能会偏向这一类对 AI 有热情、愿意尝试 AI 技术的用户群体,可能是同一批用户或者比他们更多,这是我们短期未来几个月内的目标。

现在的用户里,有出于兴趣的个人用户,也有处于工作目的的专业用户。AI 发展得非常快,等未来技术更加成熟了、我们有了更加先进的模型,可能会重新规划一下目标受众。

海外独角兽:现在 Pika 生成视频默认是 3 秒,这个时长可能很难商用,如果技术成熟到能给用户初步创造商业价值,还需要多久?产品要做到什么样才能达到这个第一阶段目标?

Demi:我们其实希望明年就能实现。现在不能确定视频时长能达到多长,可能不能制作一个完整的电影,但其实很多电影的片段就是 short clips, 所以我们希望明年至少在一定程度上能进行商用,可以帮助用户生成一些可以使用的素材或者片段,就像 Midjourney 的图像生成工具给用户提供一些商业价值。

明年视频时长可能会比现在长几倍,但还是小于 1 分钟。但其实很多电影或者商用广告的一个场景其实一般也就是几秒钟。所以说一方面我们会延长视频的时长,同时我们也会注重改善视频生成的质量,我们希望生成的视频中不要出现 artifacts、视频要好看、要高清、动作要更完美,确保即使比较短也能用,也可以把它们拼接到一起。

海外独角兽:很多人认为 Midjourney 产品取胜的关键除了技术,还有数据和审美。Pika 团队在这方面是怎么考虑的?内部会如何评估视频质量?

Demi:我们团队非常重视审美,我们也意识到不是所有的工程师都具备审美能力。团队现在有两位艺术家,最近也在面试更多艺术家专门做审美方面的工作。我们的团队很小,大家每天都在一起工作,因此在设计和技术方面的协作非常密切。艺术方面的人可能会提出设计建议,然后我们学习并进行测试,整个团队的沟通非常紧密。

Chenlin:视频数据处理的工程量很大,我们也雇佣了不少外包团队来标注数据。视频审美、评估的难度很大,需要艺术家来把控。我们虽然也有一些度量标准,但好看与否很难量化,最终取决于艺术家的感觉。就像 David Holz 经常说,他们公司地位最高的人是艺术家,因为艺术家可以决定哪个模型被发布,决定要用怎样的数据训练模型。模型生成的图像实际上就是训练数据集的一个缩影。如果训练数据集不够好看,模型学到的人物也不会好看,因此最终你需要一个具有艺术审美修养的人,他来选择数据集,把控标注的质量,并及时提供反馈。

海外独角兽:创意内容生成行业有不少创业公司,如何看待 Midjourney、Genmo、Typeface 等竞争对手?

Demi:我其实不是很喜欢去想一些竞争对手。可能很多人会问我们怎么跟 Runway 去竞争,但是对我们来讲,我们想做的事情现在没有人能做成,这不是竞争的东西,现在我们是在跟这个技术、跟我们自己去竞争,我们不再想抢占市场,而是要先把事情做成。另一方面,竞争对手也是在动态变化的。我们主要还是想做成 AI 视频生成这件事情,因为我们对这件事情充满热情,而且觉得它非常有意义,也非常有挑战性,所以如果竞争对手想要和我们合作,我们也非常欢迎。

也有很多人会说,以后 Midjourney 可能会成为你的竞争对手,但其实 Midjourney 的 Vision 是想做一个 3D 实时的世界,Pika 的目标是做一个新的 Video Making Interface。

海外独角兽:怎么看视频生成和视频编辑的关系?

Demi:视频生成本身也有编辑的成分,我们如果做好一个基础模型,然后在基础模型上去做一些应用程序是比较简单的。就像在图片生成领域,有了基础模型,比如想做一个手绘生成照片的应用很简单。到最后,视频生成和编辑的边界可能会很模糊。

短期内我们不会做特定类型的视频编辑,不会和剪映、Premiere 之类的工具走到一条赛道上,但我们可能会覆盖 Adobe After Effect 里的一些功能,比如单个视频的内容编辑、特效编辑功能。

海外独角兽:未来一年里公司在整体发展层面最关心的三个问题是什么?

Demi:第一是想招人,现在我们忙着做产品的升级,但是因为现在人比较少,之后我们还是会招募更多成员;第二,我们想去设计一个新的 Interface;第三个就是我们还想做一些技术突破,希望明年的技术能够至少在一定程度上达到商业化标准,能在简单的 case 上得到应用。我们希望这个视频生成工具可以让每个用户,包括更广泛的大众都能使用,都能生成好看的视频。

如果你关注大模型领域,欢迎扫码加入我们的大模型交流群,来一起探讨大模型时代的共识和认知,跟上大模型时代的这股浪潮。

更多阅读GPTs大爆发后,AI创业者该如何进场?AI女友产品开发记录:语音带来增长,OpenAI审查升级后访问量暴跌70%

拼多多创始人黄峥早期访谈:我们都是时代的产物,在大环境下做好自己该做的事情

月之暗面杨植麟:大模型需要新的组织范式,场景摩尔定律能催生 Super App

张鹏对话谢欣:飞书 7.0,如何重塑 AI 时代「人和组织」的关系?

转载原创文章请添加微信:geekparker

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง