《追AI的人》之AI科普系列短视频,将持续用简单清晰的语言向公众解释对于人工智能的普遍疑问,推动社会就人工智能的发展和治理达成共识。

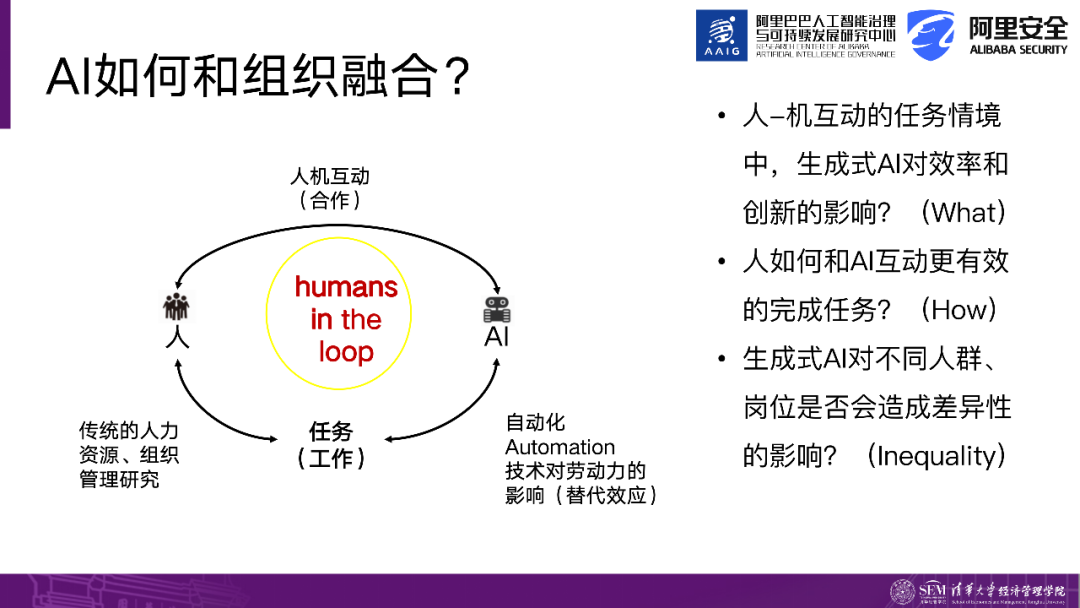

接下来的章节将分享一些最新的国际研究,重点是研究人与AI之间的互动,以及对效率和结果的影响。先看理论框架,过去的组织管理研究关注的是人与事之间的结合。事可以是任务或岗位,在职场中充当载体。这衍生出传统的人力资源管理实践方案、组织行为学研究以及领导力等领域,这些研究都旨在协调人更好地完成工作任务,将人与任务相结合。

随着AI的出现,一些学派或研究开始探讨AI与事的关系。其中,自动化是典型代表,比如在生产线流水线上的AI直接执行任务,如自动驾驶和无人机送快递等,AI与任务的连接。这些研究主要讨论技术对劳动力的影响,即技术是否替代还是增强。由于生成式AI的载体是语言,因此语言决定了人与AI之间有效互动的能力,人与AI形成合作关系,共同完成工作任务。

因此,出现了一个术语”human in the loop”。在讨论生成式AI时,我们不能将人与AI分开,必须考虑到人与AI互动的结果。在我们的研究设计中,有两个因素对技术和人的投入起作用。技术方面包括技术的升级、技术能力和算力等,而人方面包括培训和对人力资本的投资。这两者可能相互促进,相辅相成。因此,我们接下来分享的研究都从人机互动的角度出发,探讨人与AI如何合作,而这种合作将产生怎样的结果。

我们首先关注的问题是在人机互动任务情境中,AI对效率和创新的影响。过去的AI研究更加注重效率,并对其影响进行了研究。然而,生成式AI具有智能涌现的特点,因此在人机互动中,创新不再是人类特有的特质。当人与AI进行互动时,可能会出现创新性的结果。

这引发了一个问题——what即是什么?首先,我们需要了解人与生成式AI之间的互动对结果产生了什么影响。其次,我们需要探讨人与生成式AI之间的互动机制如何能够更有效地产生结果。如果你曾经使用过生成式AI,你可能会有这样的感受:别人使用生成式AI可以高效、高质量地完成许多任务,但是当你与生成式AI交流时,你会发现它表现愚笨,无法满足你的要求,这涉及到互动机制的问题。

第三个问题是生成式AI对不同人群和岗位是否会产生差异性的影响。公平性的讨论涉及到不同的人在AI浪潮中获益不同,即谁会受益,谁会受损。哪些岗位将被取代,哪些岗位将被增强,这是一些基本问题。

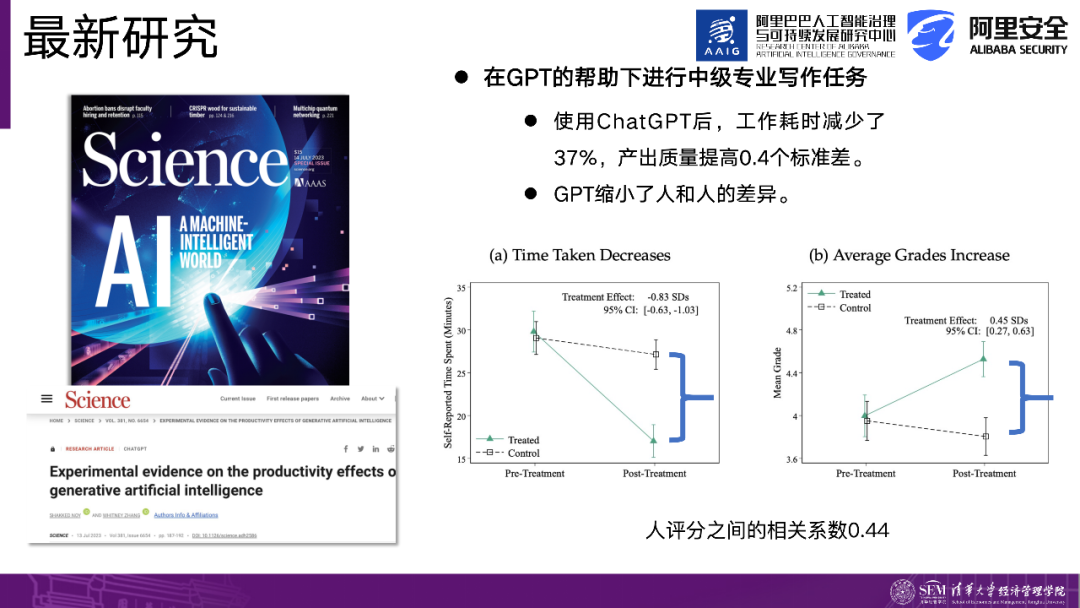

首先,我们来看一篇发表在《Science》杂志上的研究文章。该研究设计了一项实验,将参与者分为两组,一组使用了Chat GPT,另一组没有使用。然后观察使用Chat GPT对任务完成效率和绩效的影响。这些任务是一些职业化的写作任务,比如新闻稿和求职信等,这些任务在工作场景中很常见。

该研究得出了几个结论:第一个结论并不出乎意料,即相较于未使用Chat GPT的组,使用了Chat GPT的组在完成任务时所用时间减少了37%,同时产品质量提高了0.4个标准差。这一结论表明,在写作方面,使用Chat GPT确实能提高人们的效率。

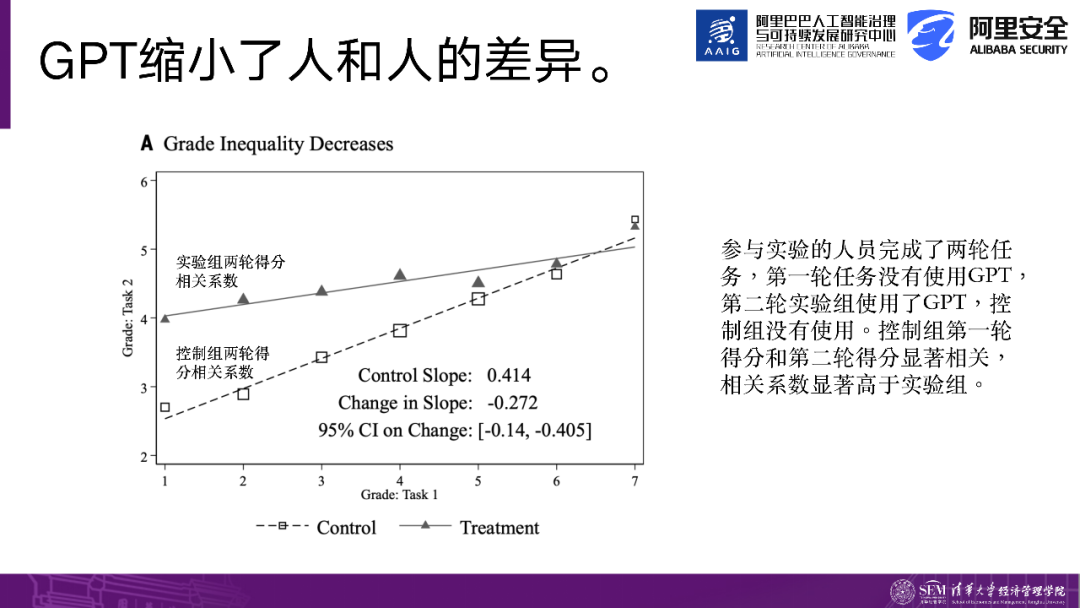

第二个研究结果非常有趣,它指出使用Chat GPT可以减小人与人之间的差异。那么我们如何解读这个结果呢?在参与者的能力上可能存在差异,例如某些人的能力较强,他们在完成各种任务时表现也较好。在引入了Chat GPT之后,出现了两种观点。一种观点认为,Chat GPT会放大人与人之间的差异,即如果我能力较强,在使用了Chat GPT后,我的能力会更加突出,因此与你的差距会更大。第二种观点认为,在使用Chat GPT之前,参与者的能力本来就存在差异,但使用之后,大家的能力反而变得相近。生成AI工具将大家带到了同一起跑线上。

该研究发现了支持第二种观点的情况。例如,在第一次任务中,未使用Chat GPT作为基准进行能力评估,然后在第二次任务中,一部分人不使用AI,另一部分人使用AI。研究发现,在未使用AI时,参与者的前后两次任务得分相关性较高,即能力较强的人在第二次任务中得分更高。然而,在使用了AI之后,参与者的前两次任务得分相关性降低了,相当于优秀的人在使用AI后,与那些不太优秀的人的能力变得差不多,拉平了人与人之间的能力差距。

然而,这篇文章也存在明显的局限性。首先,它仅仅使用了单一的写作任务作为研究对象,而Chat GPT在文本生成方面表现出色,因此该文章对人与AI互动的过程观察较少。在许多情况下,人给出一个提示词,AI生成结果,然后进行轻微的编辑,作为最终报告的成果。实际上,这篇文章没有充分观察到人与AI互动的结果。此外,该研究的任务范围较为狭窄,无法反映出事件的复杂性。

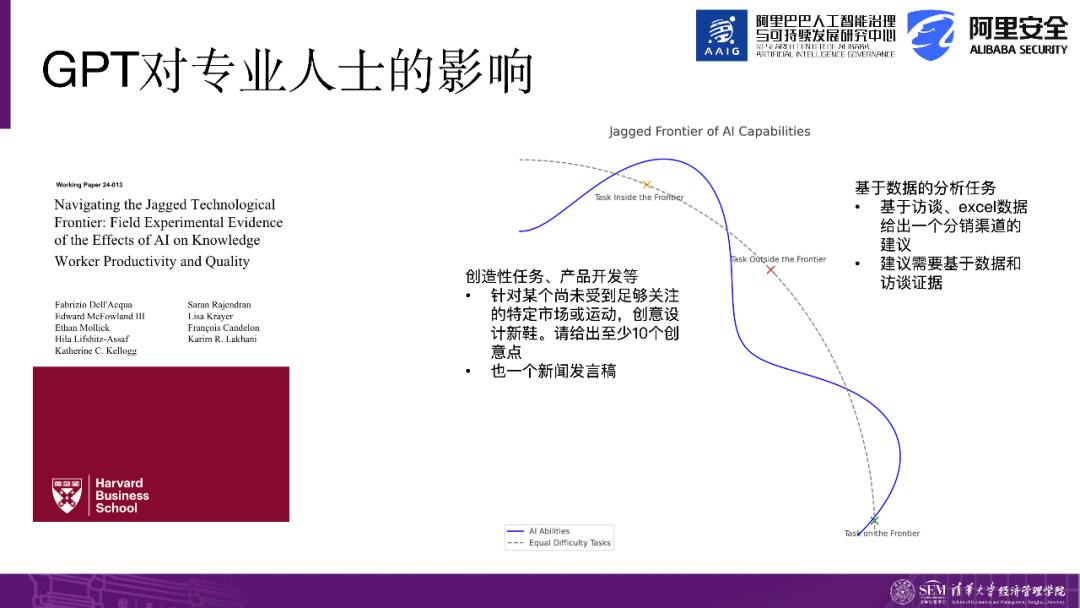

另外还有一项研究探索了生成AI在各种任务中的边界属性。这篇文章的创新之处在于将任务分为两类。一类是在AI能力范围内的任务,另一类是在AI能力范围之外但对于人类可能相对容易完成的任务。这两类任务的难度相近,但基于任务属性的不同,一类在AI能力范围内,另一类对于AI来说较为复杂且具有挑战性。

AI擅长的任务——创造性任务。例如,在某个尚未受到足够关注的特定市场或运动领域提出10个创意点子,此类任务是AI擅长的,因为它涉及到创造力的工作。然而,AI不擅长的任务是基于详实数据和访谈给出一个准确答案,即需要根据这些数据指向一个正确答案的任务。我们经常说AI一本正经地胡说八道,它无法给出正确答案。

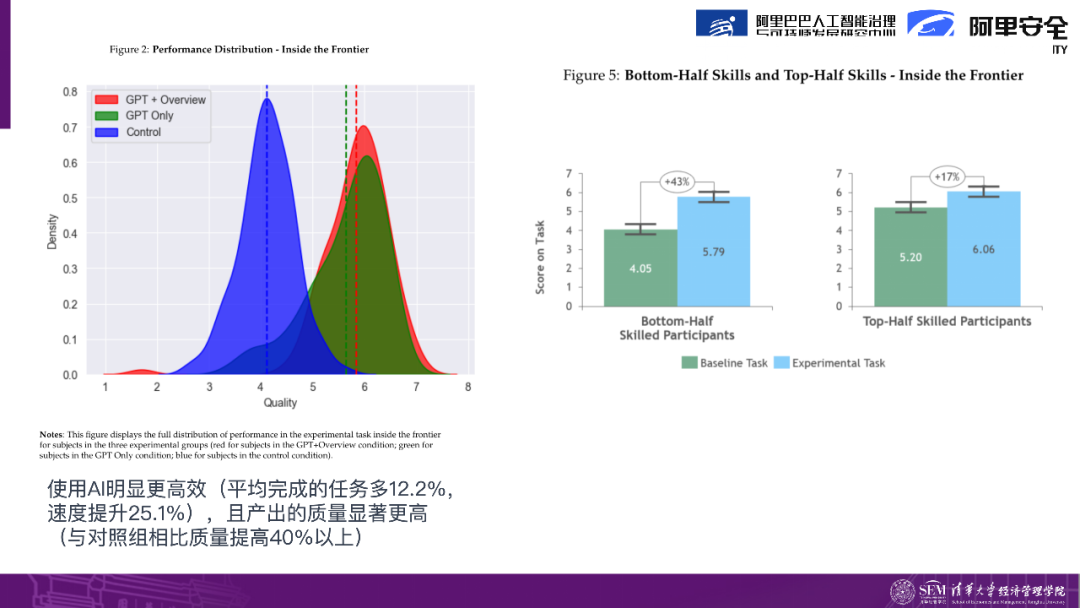

因此,这项研究得出了结论:对于在AI能力边界内的任务,使用AI可以增加平均任务完成数量增加12%,提升25%的速度,并且产出的质量比未使用AI的对照组提高了40%以上。这项研究由波士顿咨询集团(BCG)进行,参与研究的对象主要是一些典型的咨询师和智力工作者。特别是对于那些基础能力较差的人来说,使用AI后的改善幅度更大。研究结果显示,在AI的帮助下,他们的增长幅度达到了43%,而相对而言技能较好的人只有17%的改善幅度。

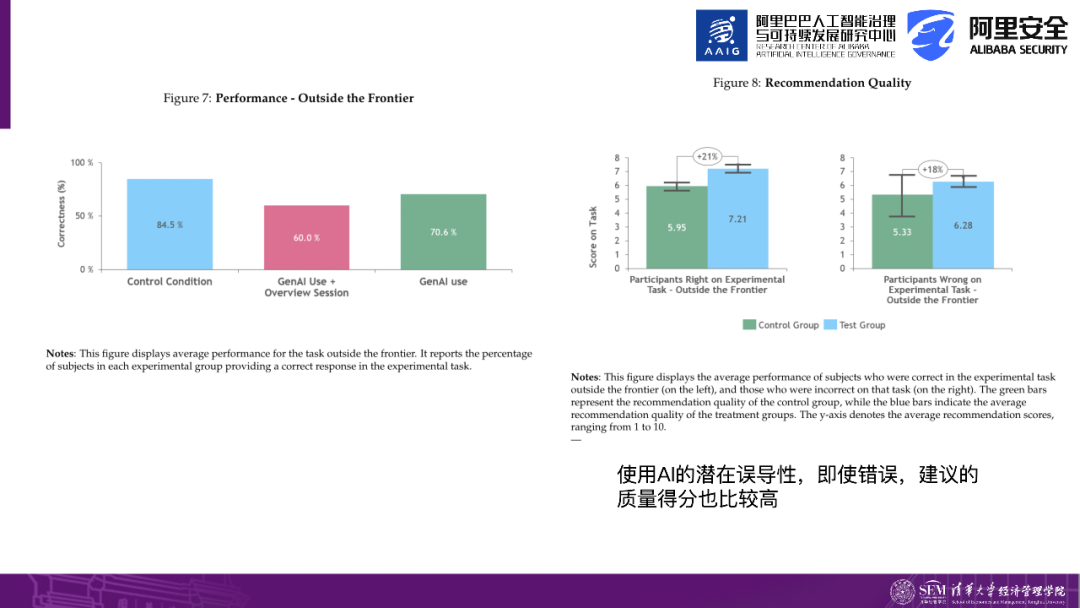

然而,研究还发现了AI的潜在误导性。在超出AI能力范围或边界范围的任务中,使用AI正确率相比于控制组更低,即AI更容易给出不正确的答案。

另一个有趣的发现是,即使AI给出了一个不正确的答案,它仍然会提供一个推荐意见。例如,当我选择A作为答案,而正确答案是B时,AI会告诉我选择A的原因,然后我会对这个原因进行评分。研究发现,这些推荐理由得到了更高的评分,同时也反映了AI的误导性更强。它以一种一本正经的方式给出了错误的答案,但同时告诉你看上去它的推荐是有道理的。这可能导致人们相信了它的结论。

因此,这也指出了一个潜在的问题。对于创意性的事物来说,这可能并不重要,你可以给出一些奇思妙想的想法。然而,对于一些有明确答案的任务,即基于数据分析什么是正确的和错误,比如,如果一个员工使用生成式AI算出一个错误的答案,并且还有一个很自洽的逻辑,那么你更容易被他说服。

更多关于人机协同的知识,点击阅读👇

为什么生成式AI更容易取代白领员工,对体力工作者的影响却微乎其微?更多人机互动如何影响知识型员工的知识,点击观看👇

📌往期推荐

生成式人工智能的发展以及担忧|生成式人工智能的治理愿景和框架...👉点击查收全文链接🌟2022人工智能治理系列丛书 精华大图集锦版 | 如何维护电商平台信息真实和竞争公平…👉点击查收白皮书全书连载

🔥《追AI的人》系列直播

深度学习如何提升数字水印的透明性和鲁棒性? | 如何避免ChatGPT被滥用…👉点击查收过往33期直播的全部文字回放

🎈《算法治理制度》系列丛书内容和电商领域推荐算法的应用与治理差异|“大数据杀熟” 的背后…👉点击阅读更多算法治理干货

📺 AI治理科普短视频流量为王的时代,教你如何“破圈”创作 | 3分钟Get多模态是什么|为什么生成式AI更容易取代白领员工,对体力工作者的影响却微乎其微…👉点击观看往期23期精彩视频

👇AAIG课代表,获取最新动态就找她

关注公众号发现更多干货❤️

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง