点击下方卡片,关注「集智书童」公众号

作者提出了GIFT(Generative Interpretable Fine-tuning Transformers),用于以参数高效的方式微调预训练的(通常是大型的)Transformer模型,同时具备内置的可解释性。作者的GIFT是一种深度参数残差学习方法,解决了微调预训练的Transformer模型时的两个问题:在哪里应用参数高效微调(PEFT),使其既轻量又足够表达能力,并且如何学习PEFT以更直接地利用预训练模型的知识?

对于前者,作者选择Transformer模型的多头自注意中的最终投影(线性)层,并验证其有效性。对于后者,与以前的方法直接引入新的模型参数(通常以低秩逼近形式)以在微调中学习不同,作者提出了一种学习生成微调参数的方法。作者的GIFT是一个超级Transformer,它以预训练的投影层参数作为输入,使用提出的Parameter-to-Cluster Attention(PaCa)生成其微调参数。PaCa导致一个简单的基于聚类的前向解释器,在测试中起到语义分割的作用。

在实验证明,作者提出的GIFT在VTAB基准和细粒度视觉分类(FGVC)基准上进行了测试。其性能明显优于先前的方法。

代码:https://github.com/savadikarc/gift

1 Introduction

利用预训练的深度神经网络(DNNs)作为下游任务的特征backbone进行微调,通常被称为迁移学习,自2012年AlexNet在ImageNet-1k数据集上训练以来,计算机视觉和深度学习领域一直是一个重要且具有挑战性的研究主题。微调DNNs的目标是将预训练域/任务的知識轉移到下游任務,以促進其在其他情況下可能無法從頭開始訓練的良好性能,因為考慮到各種因素,如數據量不足。DNNs的微调已成為實踐中的金標準,並取得了巨大和顯著的進步。

为了实现更好的迁移能力,仅通过使用下游任务数据(即完整微调)来更新预训练DNN的参数以实现微调并不总是简单明了的。关于平衡预训练模型和新任务数据探索的细微之处很重要:预训练DNN的哪些部分应该进行微调,以及如何进行训练?这些问题在连续(或终身)学习中变得尤为重要,其中处理灾难性遗忘是 streaming 任务中的关键因素。

最近,越来越多的特征backbone变得普遍,被称为大型基础模型,这使得从零开始训练它们以及将它们全部进行微调对没有高要求的计算资源的 researchers 和 practitioners 来说变得不可能。同时,由于所述的探索-利用权衡,可能不需要完整地微调预训练模型。为了解决这个问题,参数高效的微调(PEFT)变得必要,并仍然是一个活跃的研究主题。

在本文中,作者专注于预训练Transformer模型的参数高效的微调(PEFT),其中低秩适应(LoRA) 是当前最先进的方法,有许多后续工作。另一个较新的工作是自上而下注意引导(TOAST)方法。

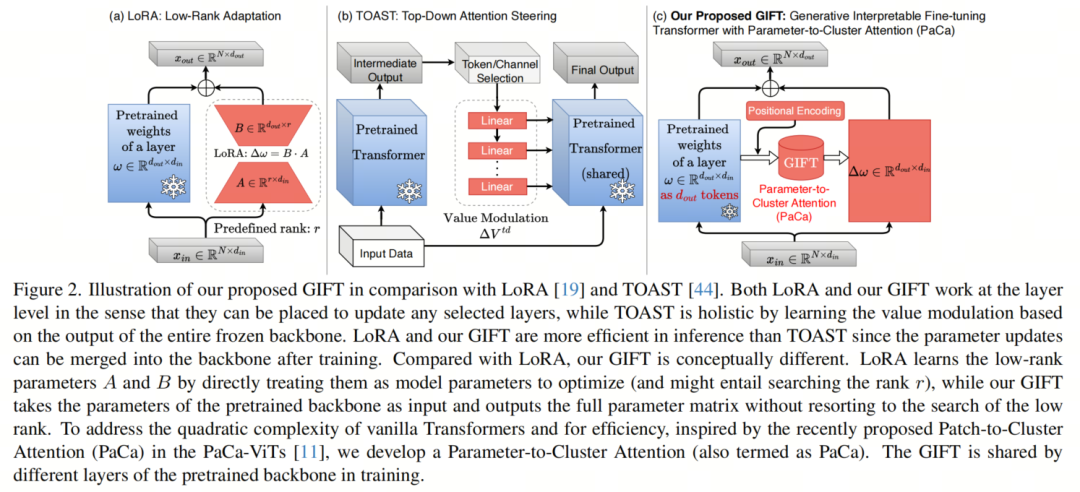

如图2所示,LoRA在微调过程中以低秩形式学习新模型参数,并适用于不同类型的DNNs。TOAST方法学习数据特定的值调制,并将其添加到多头自注意力中的值投影中,因此主要针对Transformer模型。作者受LoRA启发,但采取了一个不同的观点来处理PEFT。LoRA中的低秩参数(例如,和)作为新的模型参数直接引入到微调中,与预训练权重没有直接的信息交换,需要在适应中搜索秩以获得更好的性能。

作者问的一个问题是:作者可以直接从预训练权重中学习微调参数吗?这很符合直觉,因为预训练权重在相应的级别(例如,预训练视觉 Backbone 的低层反映了低级视觉特征/模式)。在文献中,有一些类似的精神方法被提出,称为超网络学习方法,它利用一个网络来预测另一个网络或其模块的参数。

在本文中,作者提出了一种生成可解释的微调Transformer(GIFT),如图2(c)所示,以促进预训练权重和微调权重之间的直接“信息交换”。在高层次上,作者的GIFT是一种超Transformer,通过直接利用预训练权重来更好地将预训练的 Backbone Transformer模型应用于下游任务。有了GIFT,作者还有一个需要解决的问题:如何将GIFT应用得足够高效且高度表达?例如,LoRA通常应用于Transformers中的 Query 、键和值投影层。TOAST具体调制了值激活(见图2(b))。受到最近一项关于自适应终身学习的研究启发,该研究在Vision Transformer(ViTs)中的多头自注意力(MHSA)模块的最终投影(线性)层中学习人工海马体(ArtiHippo),作者遵循他们的观察,并将作者的GIFT应用于最终投影层,并在实验中验证其有效性。

作者的GIFT具有几个优点:作者可以在一个共享的预训练模型上构建许多不同的下游任务的微调GIFT,从而减少存储需求和任务切换开销。在训练期间,作者只需要训练轻量级的GIFT,这非常高效且适用于消费级GPU。训练后,学习的微调参数可以被吸收进冻结的预训练参数中,从而不引入推理延迟。

最后,但并非最不重要的一点,作者提出的参数到集群注意力(PaCa)在作者的GIFT中作为微调后的副作用,促进可解释的模型,这以更有效的方式实现自上而下的注意引导,并可能与神经科学中观察到的分层预测编码原则 [21, 23] 相关。

2 Related Work and Our Contributions

超网络(Hypernetworks)。Ha等人[12]在语言建模任务中,通过生成LSTM的权重,提出了超网络,即能够生成其他神经网络参数的神经网络。超网络之前已经应用于少样本分类[56, 57],迁移学习和连续学习。

与作者提出的方案类似,[39] 通过适应网络来适应全局特征提取器。然而,他们使用独立的全局特征提取器从图像中提取特征。在少样本持续学习设置中,[47] 使用超Transformer为单独的卷积神经网络(ConvNet)生成参数,该网络作为输入既包括当前任务的图像支持集,也包括为以前任务生成的ConvNet参数。尽管与作者的方法类似,但[47]中的超Transformer仍然将原始数据与之前参数一起作为输入。

作者的提出的GIFT仅在参数空间中操作,并使用 Backbone 预训练参数自身来适应 Backbone 本身以执行下游任务。与[32]中的HyperFormer++最接近,它使用多层感知机(MLP)从层嵌入和跨预训练模型层的多任务设置中的潜在向量生成参数,并用于生成插件。与[32]不同,作者直接使用冻结的预训练模型本身的权重,从而消除了需要层嵌入的需要。作者的GIFT还方便捕捉预训练模型中各层特征维度的关系,并在测试图像中形成语义分割类似的地图作为副产品,从而提高解释性。

参数高效的微调(PEFT)。 PEFT方法的目标是减少微调大型模型(如Transformer)所需的计算资源(内存占用,计算时间等)。PEFT方法可以分为两类:

- 基于提示的方法,在数据 Token 中学习“提示”,同时保持 Backbone 模型冻结;

- 微调方法,将新参数引入到冻结的 Backbone 模型的层中,要么作为新的注入层,要么作为所选层的参数-残差。

基于提示的方法要么将提示附加到输入 Token,要么附加到中间层。早期的PEFT工作使用了在多头自注意力(Multi-Head Self Attention)和/或FFN块之后添加的可学习Adapter。LoRA及其变体使用线性层中的权重矩阵的低秩分解,并将新学习的权重添加到 Backbone 模型的冻结权重中,以在基于Adapter的低秩分解方法中消除推理开销。低秩分解也被应用于多模态模型。还提出了所有这些PEFT方法的组合。作者的工作受到像LoRA这样的参数-残差微调方法的启发,但利用超网络使其更具泛化性。

本文在PEFT领域做出了三个主要贡献,特别是在预训练Transformer Backbone 方面:

-

提出了GIFT(生成可解释的微调Transformer),这是一种深度参数-残差学习方法,它完全在参数空间中使用超Transformer,并利用线性复杂度的参数到集群注意力(PaCa)。

-

提出的GIFT通过PaCa在参数空间中学习参数簇,当映射到特征空间时,这些参数簇具有可解释性,并且可以发挥语义分割的作用,即使图像从未经过GIFT。

-

提出的GIFT在两个基准测试(VTAB和细粒度分类)上的性能优于先前的PEFT方法。与先前的艺术相比,当预训练模型变得更强大时,作者的GIFT的性能按比例增加,而不同于先前的艺术,这是对于大型基础模型的PEFT的一个有利的特性。

3 Approach

在本节中,作者首先概述了PEFT问题的表述,然后详细介绍了作者提出的GIFT。

Problem Formulation of PEFT

假设表示预训练 Backbone 模型的参数集,例如ViT-B在ImageNet21k上的预训练参数,在整个微调过程中都将保持不变。

在不损失一般性的情况下,假设表示 Backbone 模型中某一(基本)层的预训练权重,,例如线性层或卷积层,取决于 Backbone 模型的类型。考虑线性层,其中,和分别表示输出和输入维度,表示偏置项。给定输入,作者通过以下方式计算输出:

其中。

对于一个下游任务,微调的目标是使用任务数据学习更新的参数。在PEFT(如LoRA方法)中,一种流行的表述是采用参数更新的加性形式(为了简单起见,作者将偏置保持不变)。

其中通常被假设为两个低秩参数矩阵和的乘积。

其中表示预定义的秩(例如,)。和都被视为需要通过优化定义在下游任务数据上的目标函数(例如,分类问题的交叉熵损失)来学习的模型参数。由于和通常比预定义的低秩要大得多,因此中的可学习参数数量要远远小于冻结的预训练权重中的参数数量。

为了在实践中真正高效地应用PEFT,作者还需要指定在给定的预训练模型中应用PEFT的位置,这本身通常被视为超参数调优,其目标是从预训练模型的众多层中选择一组以平衡效率和表达能力(即在下游任务上的性能)。对于秩也是如此。

Our Proposed GIFT

作者的GIFT通过学习一个参数生成网络,扩展了公式3中的参数化方案。

其中表示生成网络的参数集,该参数集将通过使用下游任务数据进行训练。

采用这种生成形式的表达式,作者不需要像公式3那样假设低秩形式(这是公式4的特定情况)。得益于生成网络的表达能力,作者可以学习更好的适应性,正如作者将通过实验进行比较所看到的那样。而且,参数-残差是直接由预训练权重驱动的。

生成网络的输入空间是给定 Backbone 模型的预训练权重,整个微调过程中该模型都被冻结。作者没有”好的”归纳基础来利用自身的参数化。因此,作者利用Transformer的表达建模能力,从而提出了GIFT。

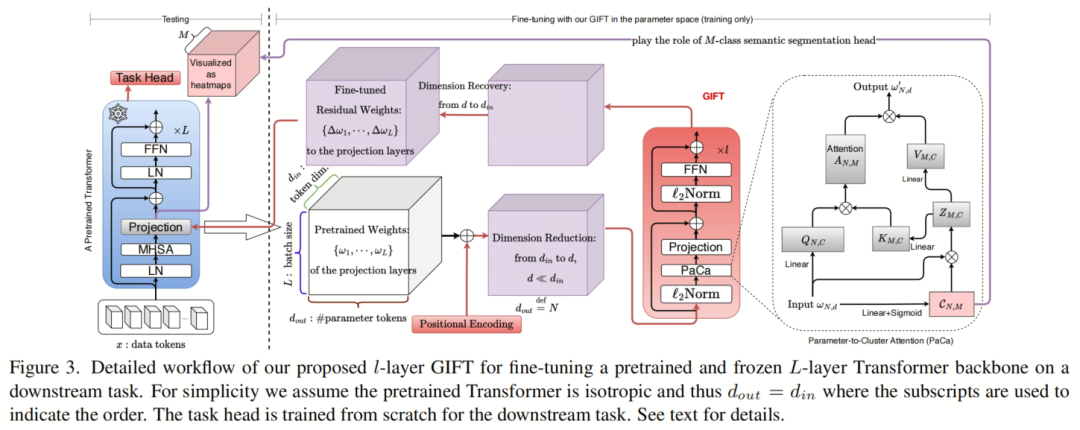

考虑输入,作者将其视为个-维向量组成的个”token”。对于微调预训练 Backbone 模型的多个层(例如,层),它们的参数将被视为批量输入数据。作者的GIFT由四个组成部分(见图3):

位置编码层:由于Transformer的排列不变性,作者引入一个可学习的位置编码向量,正如在训练Transformer时通常所做的那样。

。(5)

降维层:考虑到DNNs通常具有过参数化,为了效率和轻量化,作者将每个 Token 的输入维度降维到预定义的-维(例如,)通过一个线性投影层。

。(6)

Transformer模块:在作者的GIFT(例如,4个模块)中,所有参数都收集在中。它采用传统的元架构,包括通过多头自注意力(MHSA)模块进行 Token 混合和通过前馈网络(FFN)进行通道混合,两者都使用残差连接。

(7) (8)

其中是正则化,与Transformers中通常使用的LayerNorm不同,因为输入是参数而不是原始数据。是具有GELU非线性函数的多层感知机(MLP)。是作者提出的参数到簇注意力(PaCa)模块(见第3.4节),以解决原始Transformer的二次复杂度问题,该模块是根据最近提出的 patch-to-cluster attention 方法改编的。作者将在下一小节中详细介绍PaCa模块。

维度恢复层:为了补偿在Transformer模块之前的维度减少,作者使用另一个线性投影层来恢复所需的维度。在此上下文中,作者仍然使用来表示最终Transformer模块的输出。作者已经生成了微调参数。

。(9)

在作者的GIFT中,作者具有可训练参数,作者将使用标准的损失函数(例如分类中的交叉熵)使用下游任务数据来学习这些参数。

The GIFT for Pretrained Transformers

迄今为止,作者描述了作者的GIFT,以便于展示。虽然它通常适用于许多不同的预训练 Backbone 模型,但由于其在计算机视觉和机器学习中的日益主导地位,作者专注于将GIFT应用于预训练Transformer,因为它们在下游任务上的微调中占据了越来越大的比例。一个尚未解答的问题是,在哪里应用GIFT才能在微调预训练Transformer Backbone 模型以执行下游任务时既极其高效又足够表达。

为了达到这个目的,作者遵循ArtiHippo方法中的观察,即识别多头自注意力(MHSA)的最后投影(线性)层是转移学习和终身学习(见图3)的一个甜蜜点。作者在作者的GIFT实验中验证了这一点,无论是作者的GIFT还是LoRA方法。

因此,对于L层预训练Transformer Backbone (例如,12层的ViT-B),作者总共将有L个线性层需要使用作者的GIFT进行微调。

PaCa: the Parameter-to-Cluster Attention

原始的MHSA模块具有二次复杂度,而在作者的GIFT中, Token 的数量通常较大,尤其是对于预训练的大型模型。

为了实现PEFT的优势,作者提出了一种参数到簇注意力(PaCa)的机制,灵感来自于最近提出的patch-to-cluster attention(PaCa)。作者使用相同的简写名称,PaCa。

对于一个具有个-维 Token 输入序列的单头自注意力,定义如下:

其中和是从输入(通常通过线性投影层)计算的 Query 、键和值。二次复杂度来自Softmax内部的分母。MHSA可以很简单地在公式10的顶部定义。为了解决二次复杂度同时保留输出序列的长度,一个解决方案是将键和值的长度减少到预定义的小数(例如,)。作者可以通过以下方式重写公式10:

为了实现这一点,作者在[11]中提出了一种可学习的聚类模块。它首先通过以下方式计算每个 Token 的簇分配:

其中可以简单地是一个线性投影层,然后在 Token 上应用Softmax。然后,通过以下方式形成个簇:

其中和是通过上述方式计算的。公式13表示每个 Token 对簇的贡献程度。因此,每个簇可以被视为 Token 的加权混合。

在作者的GIFT中,作者观察到在簇分配(公式12)中的Softmax并不是使用适当的非线性函数。原始PaCa方法中使用Softmax在公式12中的目的是将整个输入特征图压缩成一些可能对当前任务有意义的前景簇(例如,图像分类)。在作者开发的过程中,使用Softmax在作者的GIFT中会强制它学习近似均匀的簇分配,即。相反,作者使用Sigmoid函数,并将公式12更改为:

其中可以被视为先验,而可以被视为将每个个 Token 分配给簇的似然度。

由于 Token (即预训练权重)的性质,公式14对作者来说更为合理。在MHSA的投影层中,作者选择进行微调(其目标是融合来自分裂的多头自注意力中的信息),参数 Token 并没有作者在分类任务中通常在数据 Token 空间中观察到的前景/背景分离。

Softmax归一化可能会通过引入过于激烈的 Token 之间竞争而过度惩罚某些 Token ,这可能阻碍参数-残差学习的有效性。作者观察到Softmax导致几乎均匀的簇分配验证了这一点:如果使用不适当的“信用分配”函数,为了确保在下游任务上的微调性能,作者的GIFT别无选择,必须找到使“信用分配”函数简单化的方法。在FFN的通道之间的注意力的背景下也做出了类似的论点。公式14导致了作者在图1中观察到的效果。

The Interpretability of GIFT

在公式14中,或更精确地说在作者的GIFT中起着核心作用。为了理解在训练GIFT期间它“捕获”了什么信息,作者使用将数据/激活空间映射回,以查看是否可以出现有意义的数据/特征簇。作者惊讶地观察到在某种程度上扮演了语义分割头分类器的角色。

考虑图像分类任务,在训练后,被冻结,对于一个测试图像的基于块的 Token ,其在一个特定层上的激活映射遵循公式1。

类似于公式13,作者可以计算激活的个簇分配映射。

对于每个个簇分配映射,作者可以将其可视化为 Heatmap 来直观地检查其意义。请注意,簇的相对值在公式13中比绝对值更重要,它表示每个输出维度对簇的贡献程度。因此,在用公式16可视化簇时,作者使用簇的平均值和标准差对在方向上进行归一化。

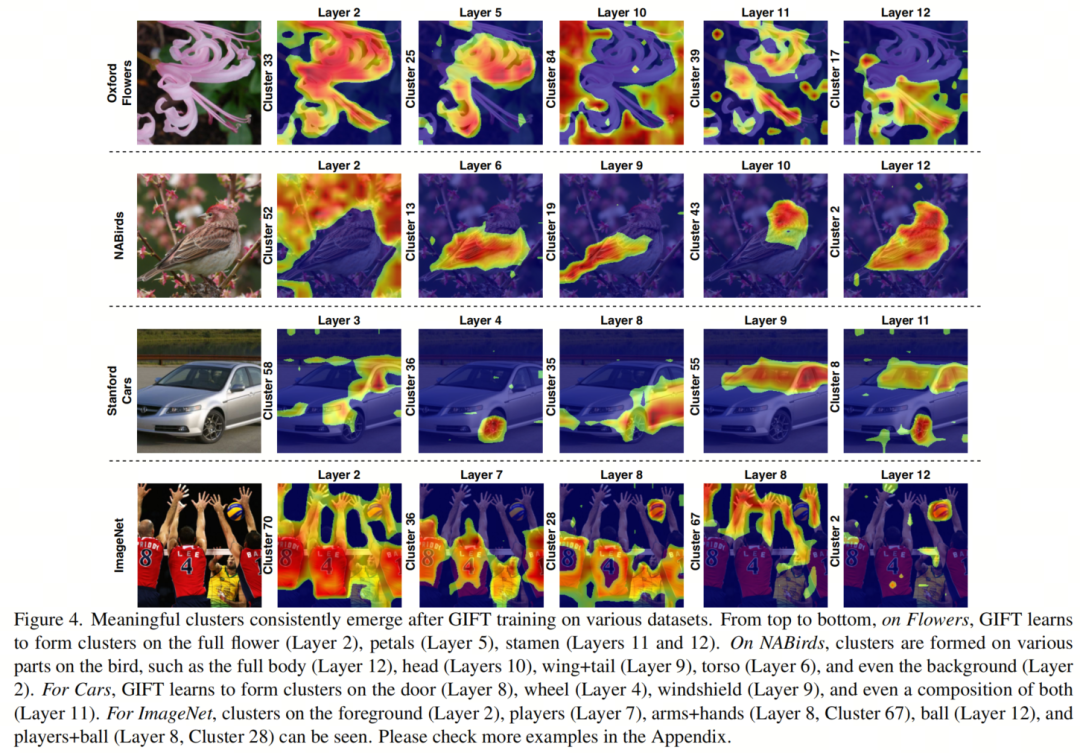

如图1所示,作者可以看到簇分配映射在不同的示例之间是合理的。作者注意到表示在微调过程中,作者的GIFT在模型参数空间中如何看待图像。在测试数据上的的有意义性证明了作者提出的GIFT的 interpretability。

可以看到,不同的簇关注图像的不同部分(鸟的喙/头/身体)。请注意,这种行为在参数簇中出现,尽管在训练过程中数据激活从未直接通过GIFT传递,而且分簇模块仅通过训练过程中反向传播计算得到的梯度接收数据激活的信息。

The Interpretability Emerged in our GIFT

为了理解聚类行为如何出现,考虑参数-残差与损失函数(例如,网络预测与真实值之间的交叉熵)在某个投影层的梯度,作者有,

也就是说,参数-残差接收到的梯度是上下信息(由携带,即在投影层上的类激活图[58])和底层特征信息()的矩阵乘积,因此提供了测量上下信息之间一致性的方法。因此,在GIFT的回向传播过程中,通过超Transformer结构,聚类模块具有足够的表现力并诱导学习有意义的”分割”,以增强上下信息的一致性或校正上下信息之间的不一致性。

这种行为模仿了顶端注意引导的行为。有了这种直观的解释,不难理解作者的GIFT可以学习注意-like簇,但不需要额外的前向传播,也不需要采用TOAST中的 Token /通道选择。

从高层次来看,作者GIFT中聚类模块的学习行为可能与神经科学中的分层预测编码原则相关,该原则认为高级皮层提供上下信息,以合作、竞争和纠缠的方式进行计算,以使底部的前馈感官过程具有强大的联合推理能力。

请注意,像LoRA这样的参数-残差方法也遵循类似的梯度,但它们的底层低秩近似表示可能不足以捕获顶端向下信号中的丰富语义信息。

4 Experiments

在本节中,作者将GIFT应用于两个分类基准,并超过了先前的艺术。

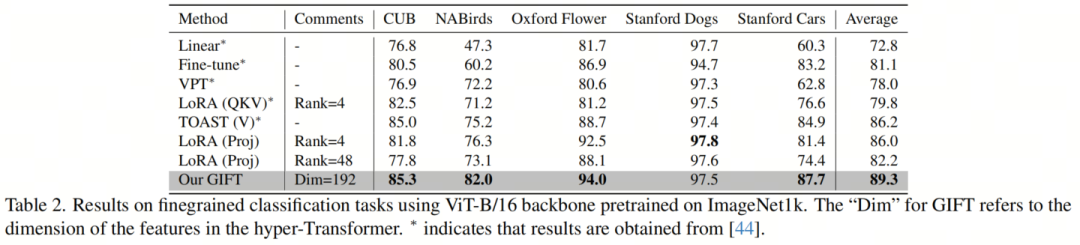

数据和度量。有两个基准被测试。第一个是视觉任务适应基准(VTAB-1k),它包括来自各种领域的19个任务(自然、专业和结构),具有各种语义。第二个是广泛使用的细粒度视觉分类(FGVC)基准,在迁移学习中使用,包含5个数据集,包括加州大学圣地亚哥分校鸟类(Caltech-UCSD Birds),NABirds,牛津花(Oxford Flowers),斯坦福汽车(Stanford Cars)和斯坦福狗(StanfordDogs)。使用Top-1精度进行评估。

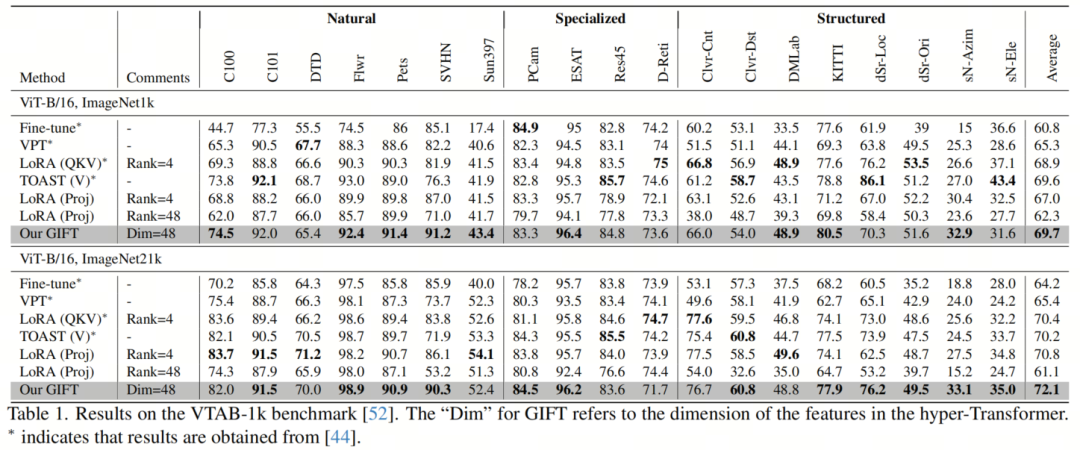

预训练模型和基线方法。作者将GIFT与视觉提示调优(VPT),LoRA和Top-Down Attention Steering(TOAST)进行比较,使用ViT-B/16作为 Backbone 模型。在VTAB-1k基准测试中,作者使用在ImageNet-21k(使用监督训练)和ImageNet1k上预训练的 Backbone 模型。在细粒度分类基准上,作者使用在ImageNet1k上预训练的ViT-B/16 Backbone 模型。由于空间限制,作者提供了图像的简要说明。

Results

VtAB-1k:如表1所示,作者的GIFT在所有其他方法上表现更好。值得注意的是,当使用更强的预训练 Backbone (ViT-B/16在ImageNet21k上预训练)时,作者的GIFT的性能显著提高,而其他方法只显示微小的改进。这表明作者的方法可以更好地利用更强的 Backbone ,因为作者的方法在预训练 Backbone 的参数空间中直接微调。更大的参数空间自然会导致更好的性能。

FGVC:如表2所示,作者的GIFT在所有基线方法上都有很大的优势,这展示了作者方法的数量有效性。

对于包含555个类别的NABirds数据集,作者的方法的优势尤为明显,表明作者的方法在数据复杂度和大小方面比其他比较方法更好地扩展。

此外,如图4所示,当从参数空间映射到特征空间时,作者的方法可以形成有意义和多样化的簇。与第二名方法TOAST(V)相比,作者的GIFT在推理效率上提高了两倍(3.1%的改进)。

对LoRA的观察:在两个基准测试中,LoRA对秩敏感,增加秩会降低性能。作者的GIFT观察到具有鲁棒性。

MHSA投影层在PEFT中的有效性:在VTAB-1K基准测试中,使用更强的ImageNet-21k预训练 Backbone ,LoRA(Proj)比LoRA(QKV)稍好,为70.8 vs 70.4,同时也优于TOAST(V)。在FGVC基准测试中,LoRA(proj)比LoRA(QKV)显著更好,为86.0 vs 79.8。在这两种情况下,LoRA(proj)使用的微调参数更少。这些验证了将投影层作为PEFT中的甜点,并从[42]中采用的有效性。

Ablation Studies

作者在FGVC数据集上测试聚类行为,这些数据集相对较小。一个自然的问题是,在像ImageNet1k这样更多样化的数据集上是否会出现类似的聚类行为。为了测试这一点,作者将ImageNet1k视为另一个“下游”任务,并像FGVC基准中其他数据集一样,使用冻结的ImageNet1k训练 Backbone 来训练作者的GIFT。

如图4所示,作者的GIFT可以在大规模数据集上学习形成聚类,这暗示了作者的方法在微调之外的通用性。请注意,这种行为即使作者只训练GIFT2个周期(1个 Warm up 周期)也会出现。这显然表明了作者GIFT中PaCa模块的有效性。请参阅附录中有关在ImageNet1k上学习的聚类的更多可视化。

5 Conclusion

作者提出了GIFT(生成可解释的微调Transformer),这是一种深度参数-残差学习方法,直接使用 Backbone 模型的预训练权重作为 Token 来学习生成微调参数-残差,使用超Transformer。作者还提出了一种参数到簇注意力(PaCa)模块,用于学习对参数 Token 进行聚类以提高效率。学习的簇可以映射回特征(数据)空间,形成多样且有意义的地块样地图,展示了作者GIFT的内置解释性。在实验中,作者表明作者的GIFT可以在低数据环境下进行高效的微调,这由作者在VTAB-1k基准上的强大性能证明。此外,作者的性能与底层预训练模型的强度成正比。在FGVC基准上,作者表明作者的GIFT在数据复杂性和大小增加时可以更好地扩展,与其他基线相比。

A Appendix

作者将首先介绍实现细节(第B节),然后阐述作者提出的GIFT的 interpretability 方面(第C节)。

Appendix B Implementation Details

对于所有实验,作者使用ViT-B/16模型,它包含12个Transformer块,每个块在多头自注意力(MHSA)块中包含12个头,维度为768。为了与先前的作品进行公平比较,作者使用随机梯度下降(SGD)并使用动量优化,训练100个周期,批量大小为32。

所有实验都使用0.9的动量和Cosine衰减学习率调度。对于VTAB和FGVC实验,作者使用验证集上的超参数搜索来确定每个数据集的学习率和权重衰减量(类似于TOAST)。由于作者发现权重衰减会减少簇多样性,因此作者没有对聚类参数应用权重衰减。作者还遵循常见的做法,将偏置参数排除在权重衰减之外。实验的超参数在实验日志目录的args.yaml文件中列出。

The VTAB Benchmark

作者在VTAB基准测试上评估作者提出的GIFT,使用预训练在ImageNet1k和ImageNet21k上的ViT-B/16模型1的检查点,并使用监督训练协议。作者使用与[44]中相同的检查点。对于作者的GIFT,作者在学习率{0.5,0.25,0.1}和权重衰减{0.01,0.001,0.0001,0.0}上进行网格搜索,并使用超Transformer的维度为48。

对于应用LoRA到投影层的实验,作者在学习率{2.0,1.5,1.0,0.5,0.1}和权重衰减{0.01,0.001,0.0001,0.0}上进行网格搜索。作者使用与[44]相同的训练、验证和测试划分。作者在单个Nvidia Quadro RTX 8000 GPU上进行所有实验。

The FGVC Benchmark

作者使用ViT-B/16预训练在ImageNet1k上的权重1在5个FGVC数据集上评估作者的GIFT,使用相同的训练和验证划分。对于作者的GIFT,作者在学习率{0.5,0.25,0.1}和权重衰减{0.1,0.01,0.001,0.0001,0.0}上进行网格搜索,并使用超Transformer的维度为192。作者使用比VTAB实验中使用的更大的维度,以考虑FGVC数据集的大小和复杂性。作者的初步研究表明,更大的尺寸稍微更好。

对于应用LoRA到投影层的实验,作者在学习率{2.0,1.5,1.0,0.5,0.1}和权重衰减{0.01,0.001,0.0001,0.0}上进行网格搜索。作者使用与[44]相同的训练、验证和测试划分,除了Stanford Cars数据集外。由于原始数据集不可用,并且提供的数据格式不同,作者创建了自己的训练和验证划分(与[44]相同数量的图像)并使用官方的测试划分。作者在单个Nvidia Tesla V100 GPU上进行所有实验。

Appendix C More Qualitative Results on the Interpretability of GIFT

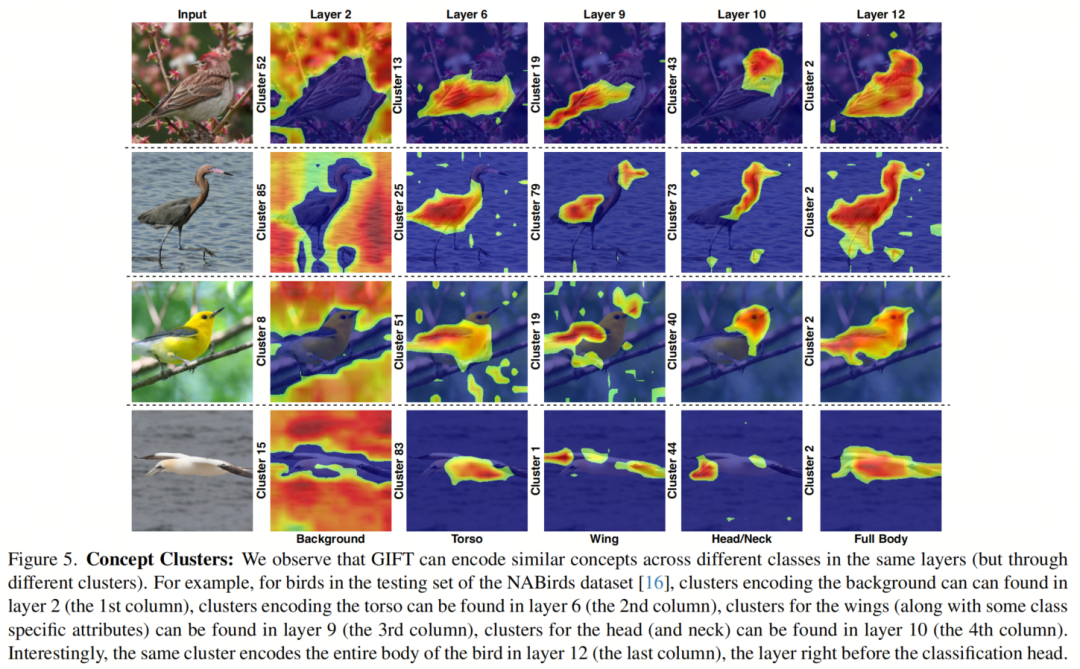

Concept Clusters

如图5所示,作者提出的GIFT可以在同一层中编码不同类别之间的相似概念(但通过不同的簇)。请参阅图5的说明。

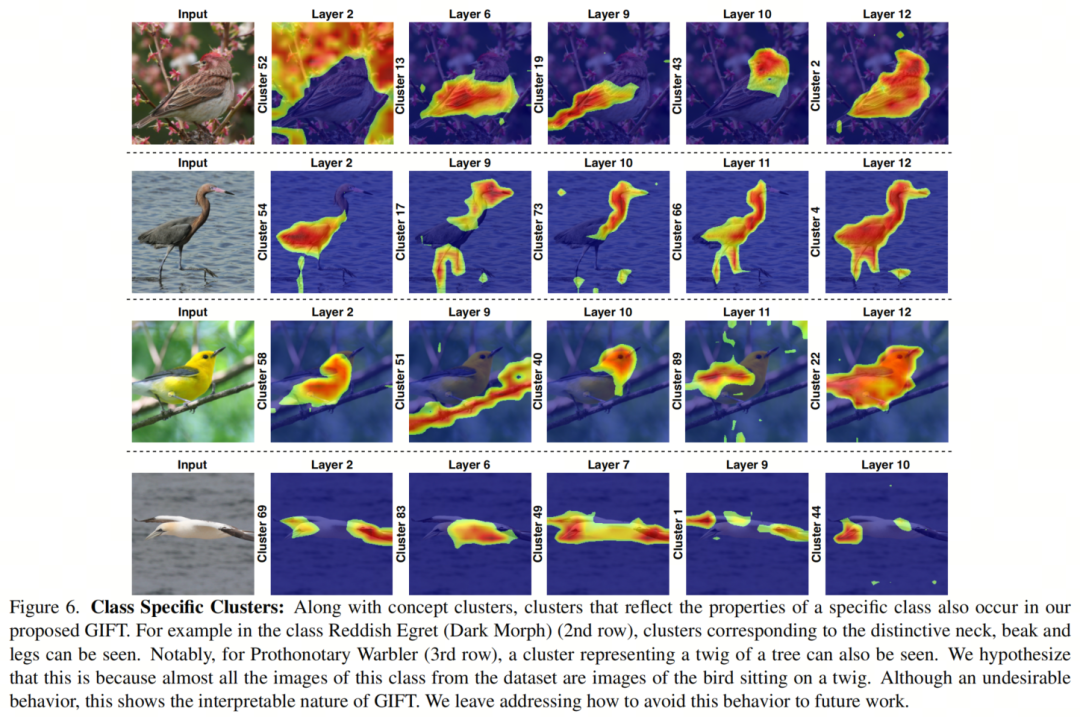

Class-Specific Clusters

如图6所示,GIFT可以形成反映特定类属性以及概念簇的簇。请参阅图6的说明。

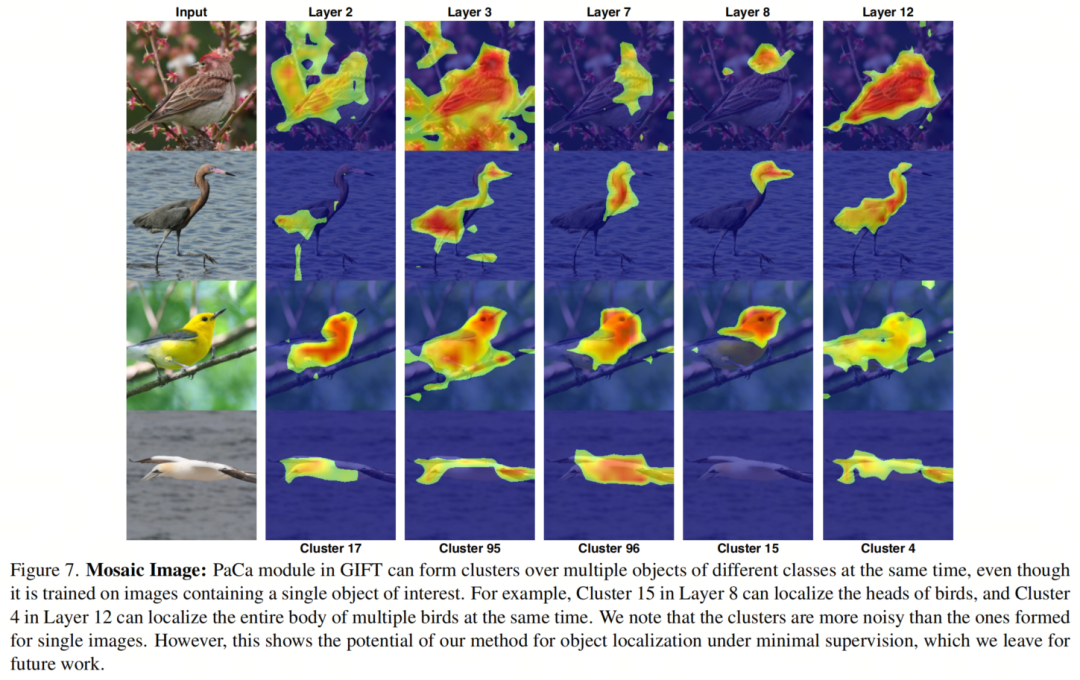

Behavior under multiple classes

如图7所示,GIFT中的PaCa模块可以在同一张图像中同时对多个不同类别的目标形成簇(尽管类别预测会受到影响)。这显示了作者提出的方法的潜力,用于在最小监督下进行目标定位。

请注意,[43]也展示了类似的行为,并可以通过 Token 选择机制控制网络的注意力。未来的工作可以探索如何将作者的方法扩展为对目标定位的精确控制。

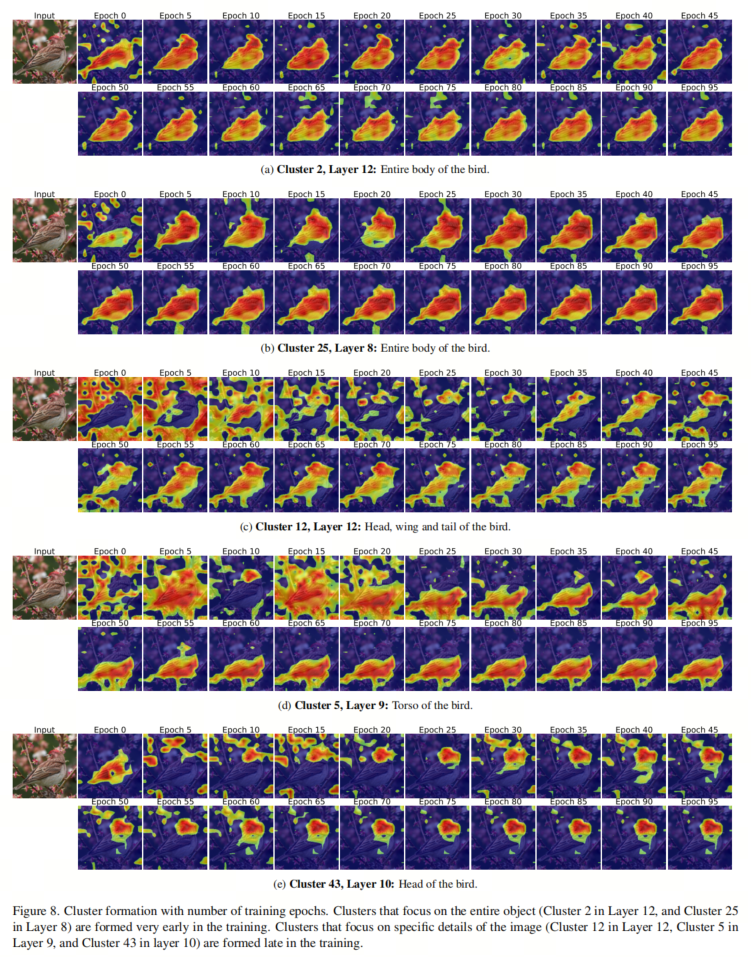

Cluster development throughout training

如图8所示,训练过程中各个簇的形成时间。可以看到,专注于图像特定细节的簇在训练后期形成,而专注于整个目标(在本例中,整个鸟)的簇在训练过程中非常早期形成。请参阅图8的说明。

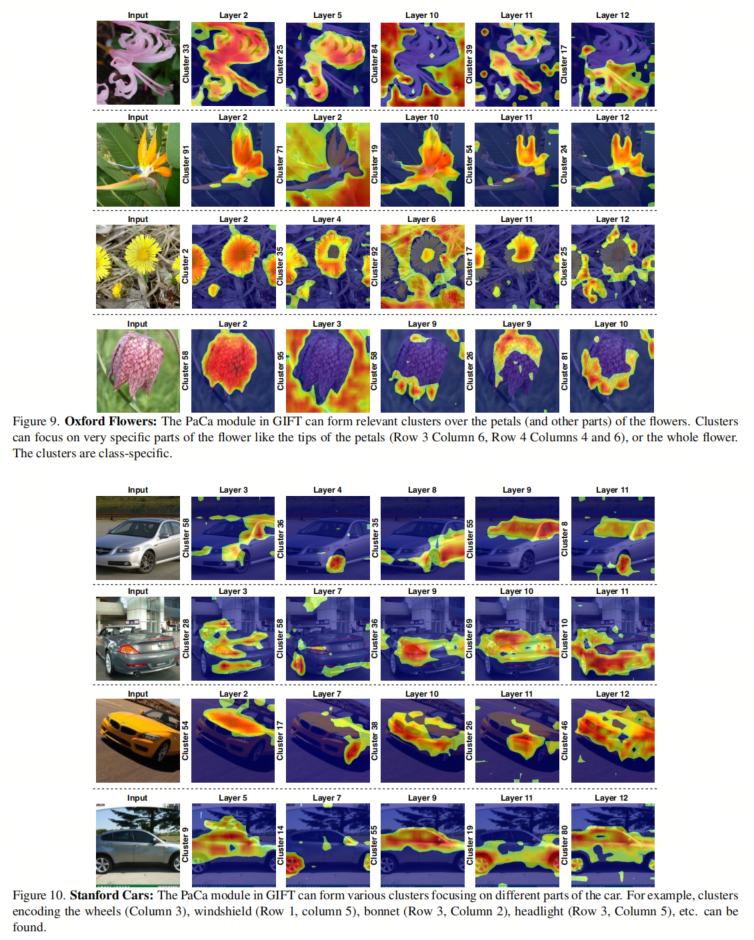

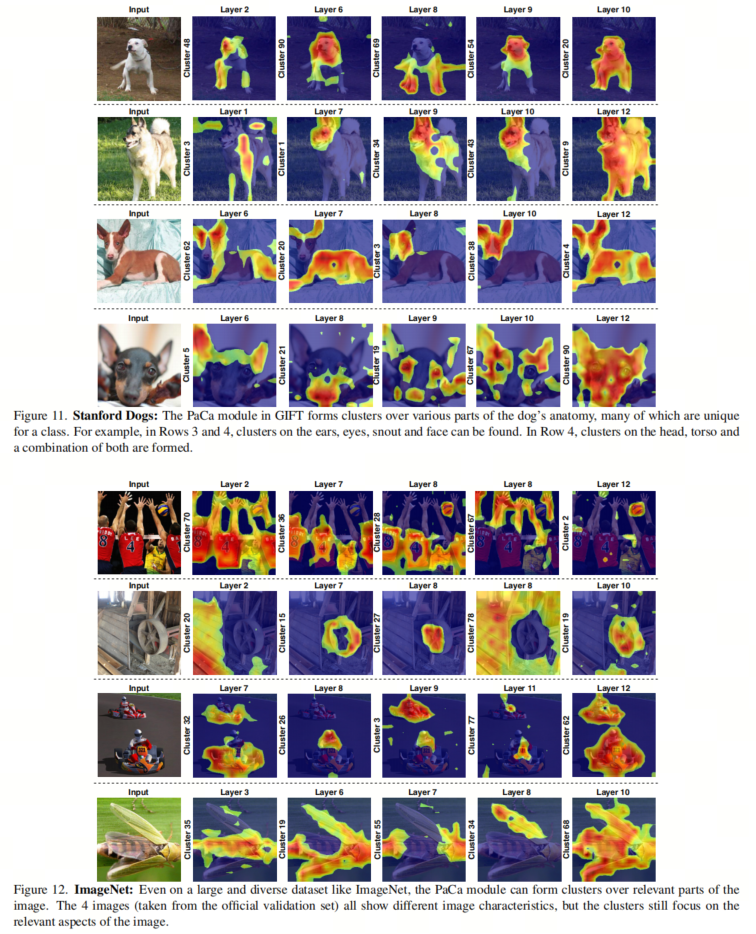

Qualitative results on Oxford Flowers, Stanford Cars, Stanford Dogs, ImageNet

如图9、10、11和12所示,牛津花、斯坦福汽车、斯坦福狗和ImageNet1k上的额外簇。请参阅各自图的说明。

参考

[1]. GIFT: Generative Interpretable Fine-Tuning Transformers.

点击上方卡片,关注「集智书童」公众号

点击上方卡片,关注「集智书童」公众号

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง