卷友们好,我是rumor。

前阵子OpenAI新成立的SuperAlignment放出了他们的第一篇工作[1],虽然没有带来太多震撼,只是验证了一个简单的直觉:用弱一点的模型标注数据,精调更强的基模型,得到的效果好于弱模型本身。

但通过上面的结论,就可以推断出:用人类标注的数据,精调强于人类的基模型,就能超越人类了。

这就是OpenAI的风格,论文看着也没说啥,只是说了一个小规律,但如果把这个小规律scale起来,就大力出奇迹了。

不过这篇文章跟之前SuperAlignment放出的计划[2]还是有些区别,也没我预期那么fancy(我不配),下面先简要介绍下这篇文章的重点结论,再聊下个人观后感。

Weak-to-Strong讲了啥

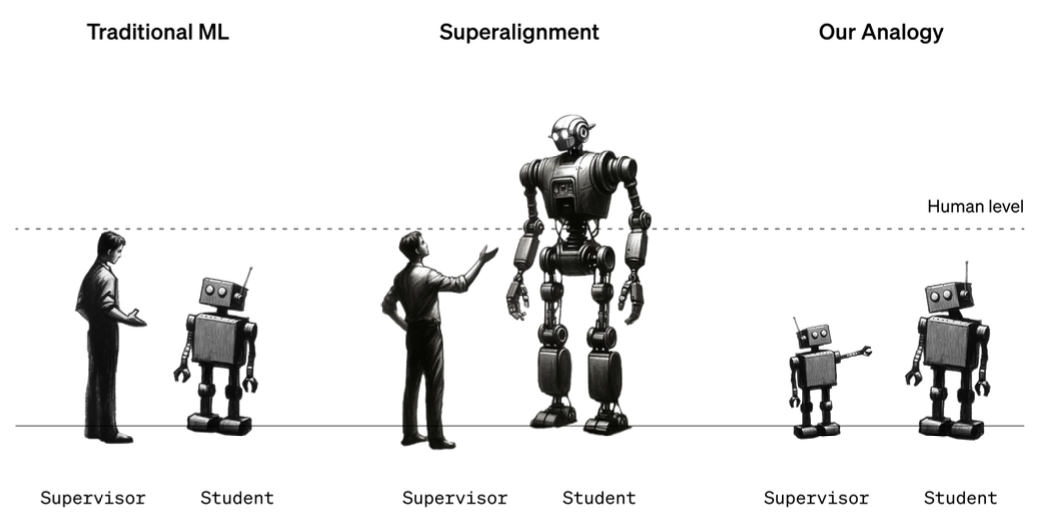

这篇文章主要是验证:用弱模型的输出训强基座,是否能产生大于弱模型的效果?

作者的做法很简单:

- 用监督数据训一个弱模型,作为基线

- 用弱模型产生label,训练强模型

- 用监督数据训strong模型,作为天花板

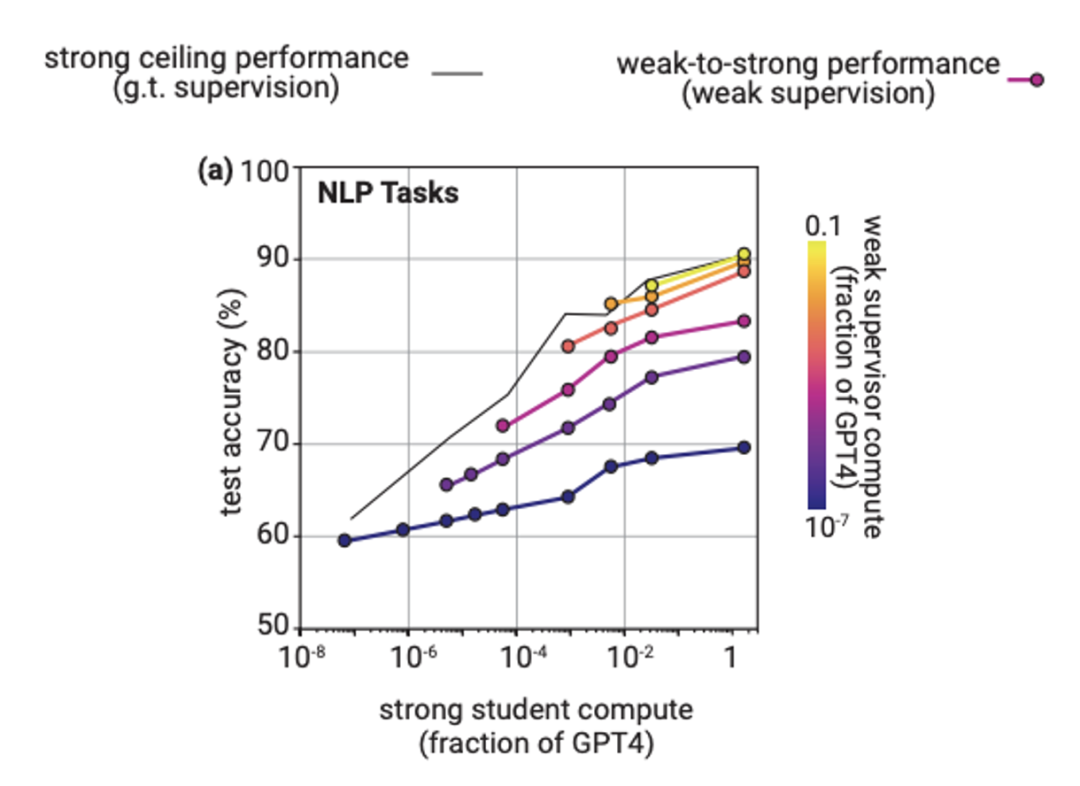

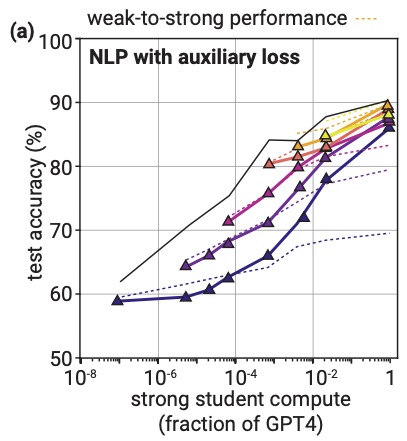

在NLP任务上,得到的效果很理想,精调出的模型好于弱模型,且效果会随着弱模型尺寸、强模型尺寸的提升而提升。

但问题马上就来了,在chess puzzles、reward modeling这两个任务上效果并不理想,效果有可能不升或者下降:

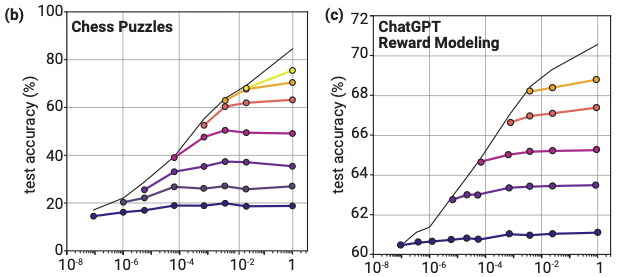

对于chess任务,可以发现图上弱模型和强模型计算量差距很大时有下降,因此作者尝试了bootstrapping的方法,在由弱到强的一系列模型上进行逐步精调。比如先用弱模型训稍强的M1,再用M1作为弱模型训更强的M2。这样做可以显著提升chess任务的表现,但对于NLP或RM任务并没有提升:

那对于RM任务怎么办呢?作者认为RM的泛化不好主要是因为强模型会拟合弱模型的错误label,因此加了一个额外loss,核心思想是当强模型对于和精调label不一致的结果很置信时,用模型自己置信的结果。增加这个loss之后RM任务有了很大改善:

提出上述两种优化Weak-to-Strong泛化能力的方法后,作者进一步分析了这种设置下的两个主要问题:

- 越强的模型约会模仿弱监督的错误:除了增加额外的loss,也可以通过early stop或正则化方法来规避。

- 是否能激发某种能力取决于基模型:比如某些任务只经过prompting就可以表现很好,所以某能力是否被激发取决于基模型是否具备该能力,如果没具备也可以有提升的犯法,比如作者提前用强模型在RM数据上进行LM精调,之后再精调排序,效果能提升10-20%。

当然,这篇文章只是一次模拟,最终能否做出超越人类的模型还有待验证。不过作者在最后给出了他们认为重要的几个方向:

- 模拟环境设置:怎样规避强模型拟合错误结果、解决预训练的数据泄露等

- 规模化的方法:现在的实验依赖ground truth,无法规模化,最理想是找到无监督的方法

- 科学的理解:上述只是一些实验结果,这些方法为什么有效、什么情况有效都需要更深入的理解

问题转嫁?

在OpenAI今年8月的放出的计划中,核心思想是训练出一个人类水平的模型,让该模型训练出强于人类的模型,属于延续Alignment的思想,用强数据(人类)训弱模型(GPT3)。而从这篇文章来看,思路直接反转了,用弱数据(人类)训强模型。

那么问题来了,到底是哪个时刻突破了人类水平?

首先从已有的经验来看,核心逻辑是一样的,智能大概率来源于计算量的scaling,即数据+模型尺寸的共同增长。

OpenAI在8月份的计划是在对齐阶段超越人类:

- 让人类水平的AI研究器自动规划实验、提供监督信号训练模型

- 把上述流程规模化,同时AI研究器本身也是一个模型,让它和新模型相互迭代,在某一时刻达到计算量临界点,超越人类

而这篇文章的设定则就变成了在预训练阶段超越人类,再用人类数据去把强基座对齐,即使label不一定全对,但对齐完也能超越人类。

到底是先有更强的对齐模型,还是更强的基模型再对齐?这两个方案的差别还是挺大的,一个是对齐团队的工作,一个是预训练团队的工作。

如果OpenAI选择后者也可以理解,一方面预训练的scaling law他们已经做的很好了,如何训出更强的基座是更promising的,之后难点就在于高质量合成数据和计算效率的提升了。另一方面RLHF确实有它自己的难点,RM的overoptimization无法避免,需要持续的人工介入,影响迭代效率。

后续怎么做?

如果一切都顺利发展,真的能训出一个强基座,得到超越人类的对齐模型,那后续如何持续迭代,才能越来越好?

这个问题的难点在于评估,按照文章的结论,最naive的做法就是找一批较难的prompt,人工给一些还行的结果,在强基座上精调一把。然后呢?我们怎么知道模型真的超越了人类表现?超越了多少?后续继续迭代如何能确定每次迭代都在提升?

作者可能也是出于这样的考虑,所以才在RM任务上尝试Weak-to-Strong的泛化。如果用强基座训出超越人类的奖励模型,也能指导出超越人类的对齐模型,同时能给出模型的大概效果。但这里也有两个问题:

- 训练用的奖励模型会有overoptimization,打分虚高:可以用更强的基座训出RM v2,来给出更客观的分数

- 如何确认训练的RM效果足够好:可能需要研究RM的scaling law,根据训练数据、基模型预测RM的表现,虽然也可以研究生成模型的scaling law,但RM的预测直觉上更加容易

注:以上是个人开的脑洞

总结

虽然SuperAlignment的进展看起来不是很大,但OpenAI把这些问题拿出来讨论还是很感人的。训出强于人类的基模型确实是更加promising的方向,不急不急,从GPT1到GPT4不也就五年而已。

参考资料

[1]

WEAK-TO-STRONG GENERALIZATION: ELICITING STRONG CAPABILITIES WITH WEAK SUPERVISION: https://cdn.openai.com/papers/weak-to-strong-generalization.pdf

[2]

Our approach to alignment research: https://openai.com/blog/our-approach-to-alignment-research

我是朋克又极客的AI算法小姐姐rumor北航本硕,NLP算法工程师,谷歌开发者专家欢迎关注我,带你学习带你肝

一起在人工智能时代旋转跳跃眨巴眼

「给我一个强基模型,我也行」

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง