-

01

-

研究动机

-

虽然神经机器翻译(NMT)近年来在技术上取得了显著进步,但其翻译质量仍未能满足工业应用的高标准,这导致在实际应用中仍然需要人工干预,增加了成本并降低了效率。为应对这一问题,交互式机器翻译(IMT)被作为一种解决方案提出。IMT是一种结合人类译者干预的翻译方法,通过多次交互步骤来提高翻译的准确性和质量。传统的IMT系统采用从左到右的修改方式。这种方法虽然在技术上易于实现,但缺乏灵活性,因为译员可能希望按照不同的顺序进行文本修订。这导致了新的IMT范式的提出,该范式允许译员在翻译的任何位置进行修订,这种方法的核心技术是词约束翻译,即使用修改后的单词作为约束来生成新的翻译。

尽管提出了多种IMT技术,但目前缺乏一个统一的平台来公平和系统地评估这些方法,特别是在端到端的方式上。这主要是因为先前的IMT方法在交互策略、评估环境和指标上存在差异,使得它们的性能和效率难以进行公平比较。此外,过去的评估方法,如随机删除单词或短语后比较BLEU分数,与真实的交互体验相去甚远。这种评估方法未能考虑到整个迭代协作过程的总成本,不足以全面反映IMT系统的效率和有效性。

基于这些挑战和局限性,论文提出了IMTLab这一开源平台。IMTLab的目的是填补现有技术的空白,提供一个统一的平台来评估IMT系统,特别是以端到端的方式进行。该平台不仅支持最新的IMT模型构建和评估,还提供了模拟和真实交互环境的端到端评估,以及系统地评估和诊断IMT系统的能力。通过这种方式,IMTLab旨在推动IMT技术的发展,使其更好地满足实际应用的需求。

-

02

-

贡献

-

-

1. 首次开发了一个开源的端到端IMT系统平台IMTLab,方便学术界和工业界快速构建和评估IMT系统。

-

3. 进行了模拟和真人实验,系统地比较了几种流行的IMT系统。收集的用户交互数据将发布给社区,供未来研究使用。

-

03

-

方法

3.1. 总体设计

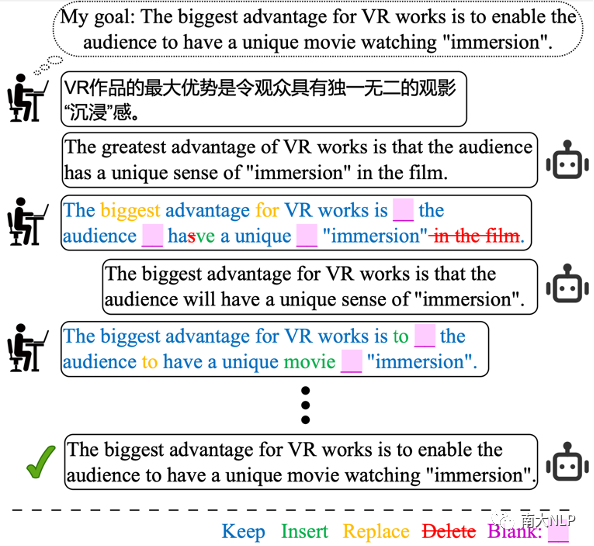

IMTLab将整个交互式翻译过程类比为任务型对话,用户的目标是获得源句子的参考翻译,而IMT系统则基于用户的反馈生成翻译。用户提供编辑操作(如保留、插入、替换、删除和填空)来请求系统的响应。如图1所示,这一交互过程持续进行,直到用户的目标达成或用户放弃该轮交互。IMTLab允许IMT系统利用明确的人类的编辑来优化翻译,并使研究人员能够以端到端的方式评估不同的IMT系统。

图1 交互式翻译流程示意图

图1 交互式翻译流程示意图

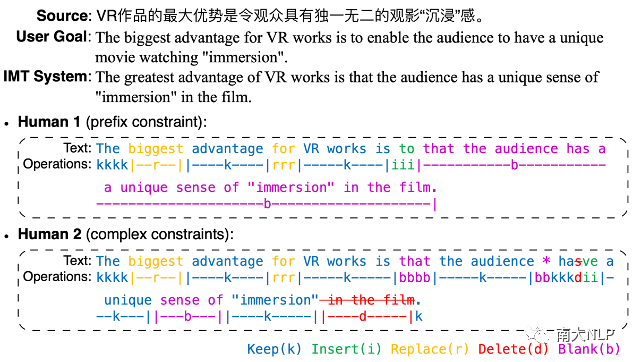

3.2. 通信接口

为了支持各种IMT系统的灵活架构,IMTLab设计了一个通用的通信接口。用户可以使用五种常见的编辑操作:(1)保留,即保留正确的翻译部分;(2)插入,即插入正确的翻译;(3)替换,即将一个片段替换为新的内容;(4)删除,即删除一个片段;(5)填空,即将一个连续的片段替换为空,或直接在一个位置插入空,期望IMT系统来填这个空。基于这些编辑操作可以实现几乎所有的编辑策略。为了记录用户的编辑信息和适配多种语言,系统在字符级别维护编辑操作的记录。因此,用户反馈可以分解为修改后的翻译和相应的操作标签两部分,为IMT系统提供尽可能多的用户编辑信息。

如图2所示,当IMT系统返回的翻译不令人满意时,用户可以通过上述的编辑操作来编辑这个翻译,使翻译接近他们的目标。不同的用户可能会用不同的编辑操作。编辑完成后,图中的文本和操作标签都会发送给IMT系统,以得到新的翻译。删除和填空是两个非常像的操作,它们的区别在于删除意味着这些单词是冗余的,而填空则表示这个片段需要被替换为新的正确的内容。最后,用户的所有编辑操作都可以转换为词约束模板,其中保留、插入和替换的字符就是词约束。

图2 通信接口模板示意图

图2 通信接口模板示意图

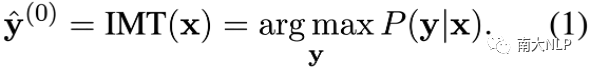

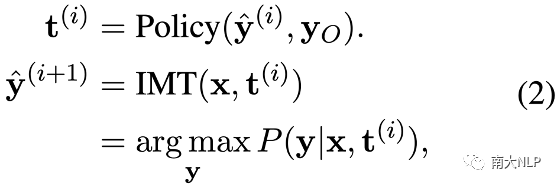

3.3. IMT系统

在交互过程中,IMT系统必须基于用户的编辑操作不断生成翻译,能够支持正常和词汇约束的翻译。给定一个源句子,用户首先通过查询IMT系统获得一个初始翻译,如公式(1)。如果这个翻译不符合用户的要求,就开始交互过程。在每个交互轮次中,用户根据自己的目标修改IMT系统返回的翻译,并将相应的编辑操作转换为词汇约束模板,以获得下一个翻译,如公式(2)。

3.4. 交互环境

为了进行端到端的交互式翻译评测,IMTLab同时搭建了模拟实验环境和真人交互环境。在搭建的虚拟评估环境中,包含五种常见的编辑策略,即译后编辑策略(MTPE)、自左向右策略(L2r)、随机策略(Rand)、自左向右填充策略(L2rI)和随机填充策略(RandI)。每个策略的定义如下:

-

MTPE:模拟用户基于最优编辑距离的操作序列,将初始翻译直接编辑成参考翻译。

-

L2r:模拟用户首先识别最左边的错误单词并使用替换操作纠正它。然后采用填空操作来删除后缀。

-

Rand:模拟用户从初始翻译中随机修改一个错误的单词后作为起点,并使用填空操作删除其前缀和后缀。在后续迭代中,用户识别新翻译中上一轮约束的位置,随机选择一个方向(左或右),并使用替换操作纠正该方向上的第一个不正确的单词。

-

L2rI:模拟用户用填空操作替换所有不正确的单词跨度,并在每一轮最左边的不正确单词的位置使用插入操作附加一个正确的单词。

-

RandI:该策略与L2rI策略类似,不同点在于它每轮随机选择一个保留片段旁边的错误进行修改。

为了模拟用户对交互过程失去耐心的情况,假设使用L2r策略时如果不满足中的约束,模拟用户将失去耐心。使用Rand、L2rI、RandI策略时,假设用户最多能容忍三次约束的不满足。如果约束不满足,将根据当前策略和翻译结果重新进行交互。此外,最大交互轮数的阈值设置为使用MTPE的操作数。如果交互轮数超过这个阈值,用户也会失去耐心。一旦模拟用户对交互过程失去耐心,就会被用MTPE来纠正当前的翻译。

在真人评估环境中,真人用户可以采用任意编辑操作和策略来修改翻译。用户也可以自己决定是否接受当前翻译和是否失去耐心。

3.5. 评价指标

在端到端的评测环境中,本发明设计了不同的评价指标,从不同的方面来评价IMT系统在端到端场景下的表现。

-

编辑代价(Editing Cost,EC):各个编辑操作的代价为

-

保留:0

-

插入:插入的字符数

-

删除:1

-

替换:插入的字符数 + 1

-

填空:1

在交互翻译过程中,将用户每轮编辑操作的累积代价相加来计算总编辑代价

-

成功率(Success Rate,SR):用户不失去耐心的比率

-

一致性(Consistency, Con.):相邻两轮翻译的平均编辑距离

-

平均轮数(Average Turns,AT):每句翻译所用的交互轮数

-

响应时间(Response Time,RT):IMT系统每次返回结果所用的时间

其中,编辑代价反映了用户的工作量,而其他指标则反映了用户在交互过程中的体验。

-

04

-

实验

4.1.实验设置

数据:WMT14 ende和WMT17 zhen,从测试集中随机抽取500个样本作为新测试集。

模型:基于前缀解码的Transformer模型(Prefix),基于动态束分配的词约束模型(DBA)[1],基于双语文本填充的IMT模型(BiTIIMT)[2],词约束感知的NMT模型(LeCA)[3]。

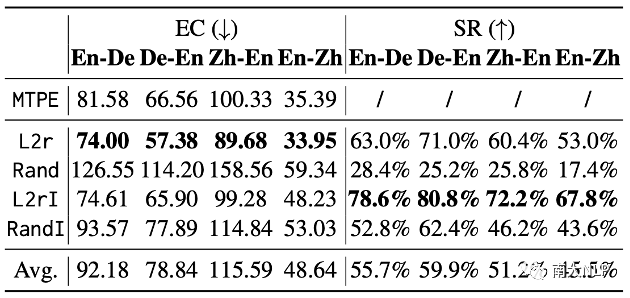

4.2. 模拟实验结果

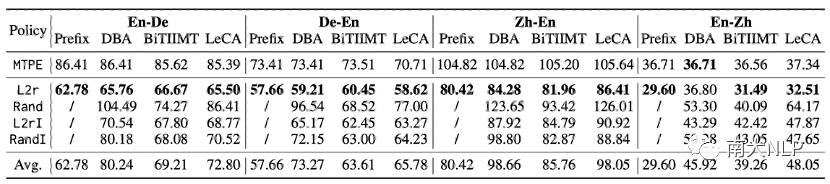

如表1所示,相比MTPE,大部分交互策略所用的代价更小,说明了交互式翻译的有效性。在这些模型中,L2r策略比其他策略取得了更小的编辑代价。其中,Prefix+L2r取得了最小的编辑代价。BiTIIMT使用L2r策略时取得了与Prefix相当的编辑代价,同时BiTIIMT可以适配更多的策略,在大部分策略上优于DBA和LeCA。

表1 各模型使用各策略在模拟实验中的编辑代价

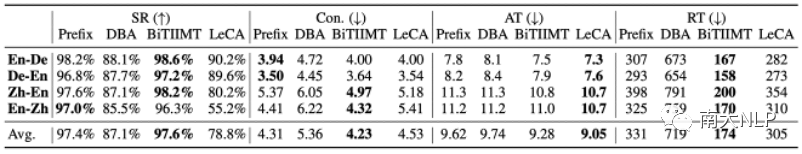

在其他指标上,如表2所示,总体来说BiTIIMT相比其他模型表现更好,拥有更好的用户体验。软约束模型LeCA由于不保证满足约束,在端到端的交互中成功率相对较低。而DBA模型由于解码速度慢,所以响应时间较长。

表2 在模拟实验中各模型使用各策略的平均成功率、一致性、交互轮数和响应时间

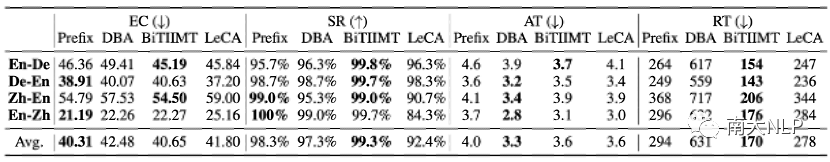

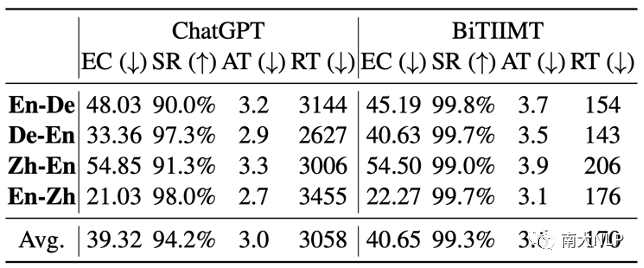

4.3. 真人实验结果

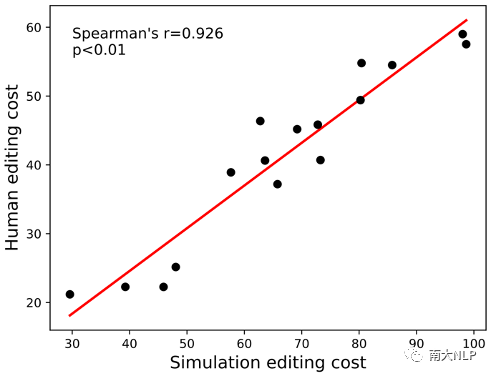

在真人实验中,我们搭建了一个网页用于人机交互。译员可以采用任意的交互策略来编辑翻译。同时我们也收集了用户的编辑操作数据,并进行开源。如表3所示,真人实验的结果与模拟实验比较相似,Prefix模型同样取得了最小的编辑代价,而BiTIIMT与之相当,同时BiTIIMT在其他指标上更好。我们计算了模拟编辑代价与真人编辑代价的Spearman相关系数,如图3所示,表明两者之间具有强相关性。。

表3 真人实验中各模型的编辑代价、成功率、交互轮数和响应时间

图3 模拟编辑代价与真人编辑代价的相关性示意图

4.4. 对ChatGPT的评测

我们将ChatGPT当作词约束模型接入IMTLab进行评测,使用zero-shot的prompt来提示ChatGPT完成词约束翻译任务。我们进行了模拟和真人评测,结果见表4和表5。结果表明,L2r依然是编辑代价最小的策略,同时我们也发现ChatGPT成功率较低,对词约束的满足不是很好。

表4 ChatGPT的模拟评测结果

表5 ChatGPT与BiTIIMT的真人评测结果

-

05

-

总结

-

在本文中,我们介绍了IMTLab,这是一个用于构建、评估和诊断交互式机器翻译系统的开源平台。IMTLab将整个交互翻译过程视为一种任务型对话,我们设计了一个通用的通信接口,以支持IMT系统的灵活架构,并进一步构建了用于端到端评估的模拟和真人交互环境。实验表明,在端到端的评估中,前缀约束解码方法仍然实现最低的编辑代价,而BiTIIMT在提供类似的编辑成本的同时,提供了更好的交互体验。IMTLab还可以与大语言模型兼容,如ChatGPT。

论文链接:

https://aclanthology.org/2023.emnlp-main.922.pdf

代码链接:

https://github.com/xuuHuang/IMTLab

参考文献

[1] Post, Matt and David Vilar. “Fast Lexically Constrained Decoding with Dynamic Beam Allocation for Neural Machine Translation.” North American Chapter of the Association for Computational Linguistics (2018).

[2] Xiao, Yanling, Lemao Liu, Guoping Huang, Qu Cui, Shujian Huang, Shuming Shi and Jiajun Chen. “BiTIIMT: A Bilingual Text-infilling Method for Interactive Machine Translation.” Annual Meeting of the Association for Computational Linguistics (2022).

[3] Chen, Guanhua, Yun Chen, Yong Wang and Victor O.K. Li. “Lexical-Constraint-Aware Neural Machine Translation via Data Augmentation.” Proceedings of the Twenty-Ninth International Conference on International Joint Conferences on Artificial Intelligence (2021)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง