新智元报道

编辑:Aeneas 好困

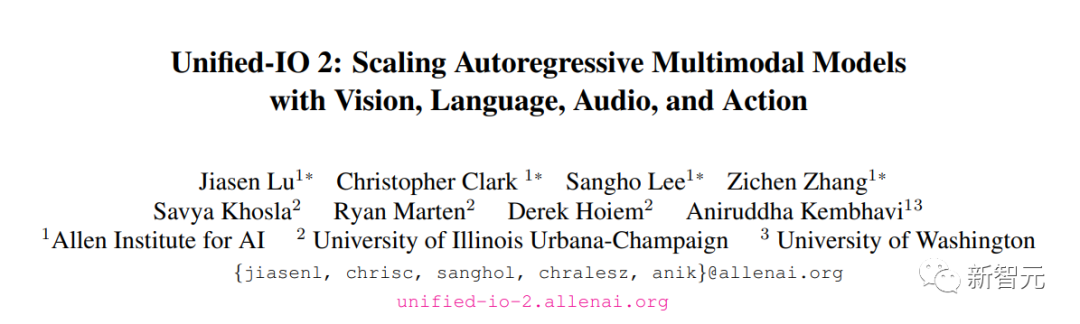

【新智元导读】首个视觉、语言、音频和动作多模态模型Unified-IO 2来了!它能够完成多种多模态的任务,在超过30个基准测试中展现出了卓越性能。

首个具备理解和创造图像、文本、音频以及动作能力的自回归多模态模型来了!来自艾伦人工智能研究所、伊利诺伊大学厄巴纳-香槟分校、华盛顿大学的学者提出了Unified-IO 2。

论文地址:https://arxiv.org/abs/2312.17172为了整合不同类型的数据,研究人员将图像、文本、音频、动作等各种输入和输出转换成统一的语义表征,再通过一个统一的编解码器Transformer模型进行处理。训练这样多样化的数据类型是极其复杂的,因此研究人员设计了多种架构优化方案,来提高模型的稳定性。研究人员使用来自各种来源的大型多模态预训练语料库,通过具有去噪器目标的多模态混合,从头开始训练模型。 为了掌握如遵循多模态指令等广泛的技能,研究人员还特意构建并微调了一个包含120 个现有数据集的集合,并对其进行了扩展和优化。Unified-IO 2作为一个统一的多功能模型,在GRIT基准测试中取得了SOTA,在超过30个基准测试中展现出了卓越的性能,包括图像生成与理解、文本理解、视频和音频理解以及机器人操作等领域。研究人员会将这些模型开放给研究社区,共同推动科学研究的进展。

为了掌握如遵循多模态指令等广泛的技能,研究人员还特意构建并微调了一个包含120 个现有数据集的集合,并对其进行了扩展和优化。Unified-IO 2作为一个统一的多功能模型,在GRIT基准测试中取得了SOTA,在超过30个基准测试中展现出了卓越的性能,包括图像生成与理解、文本理解、视频和音频理解以及机器人操作等领域。研究人员会将这些模型开放给研究社区,共同推动科学研究的进展。

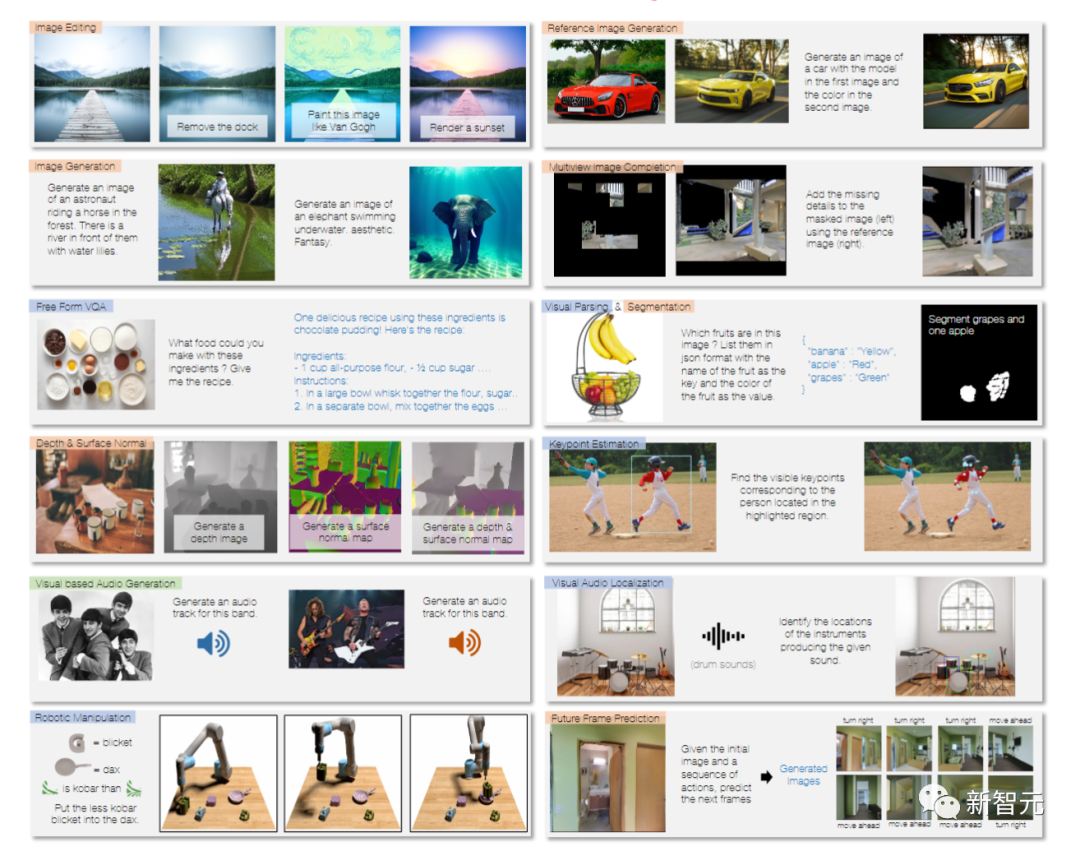

效果展示

Unified-IO 2能够完成多种多模态的任务:为图片添加标注,执行各种自由格式的指令,编辑图片,检测图中物体,进行图片的语义分割(semantic segmentation)、表面法线(surface normal)分析,以及根据图片生成音频等。比如,输入一幅湖景,它就会给出眼前景象的描述。你可以要求它给出更细节的描述,分享自己对此的个人印象,还能让它告诉你来这里游玩有哪些注意事项。你可以让它根据眼前的景象生成一段音乐,让画风变得像闹鬼一样、把桥变成红色、把场景变成午夜或者日出、把画面变成达芬奇的画风,甚至把桥移除。

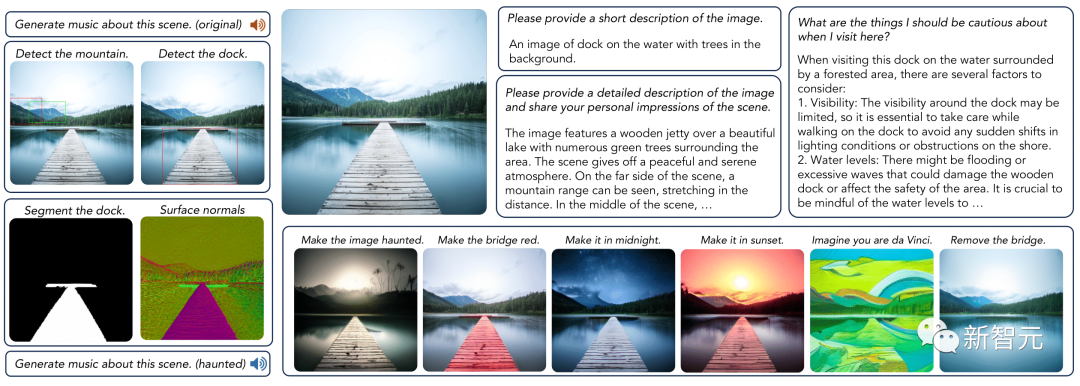

自然语言

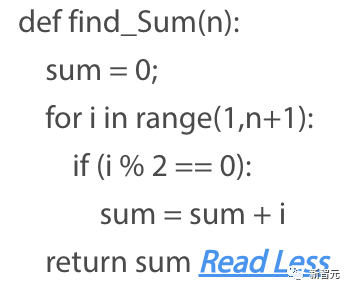

在自然语言上,Unified-IO 2的性能也很强大。它可以写一个python函数,来查找列表中最短的字符串: 写一个Python函数,找到小于n的所有偶数自然数的和:

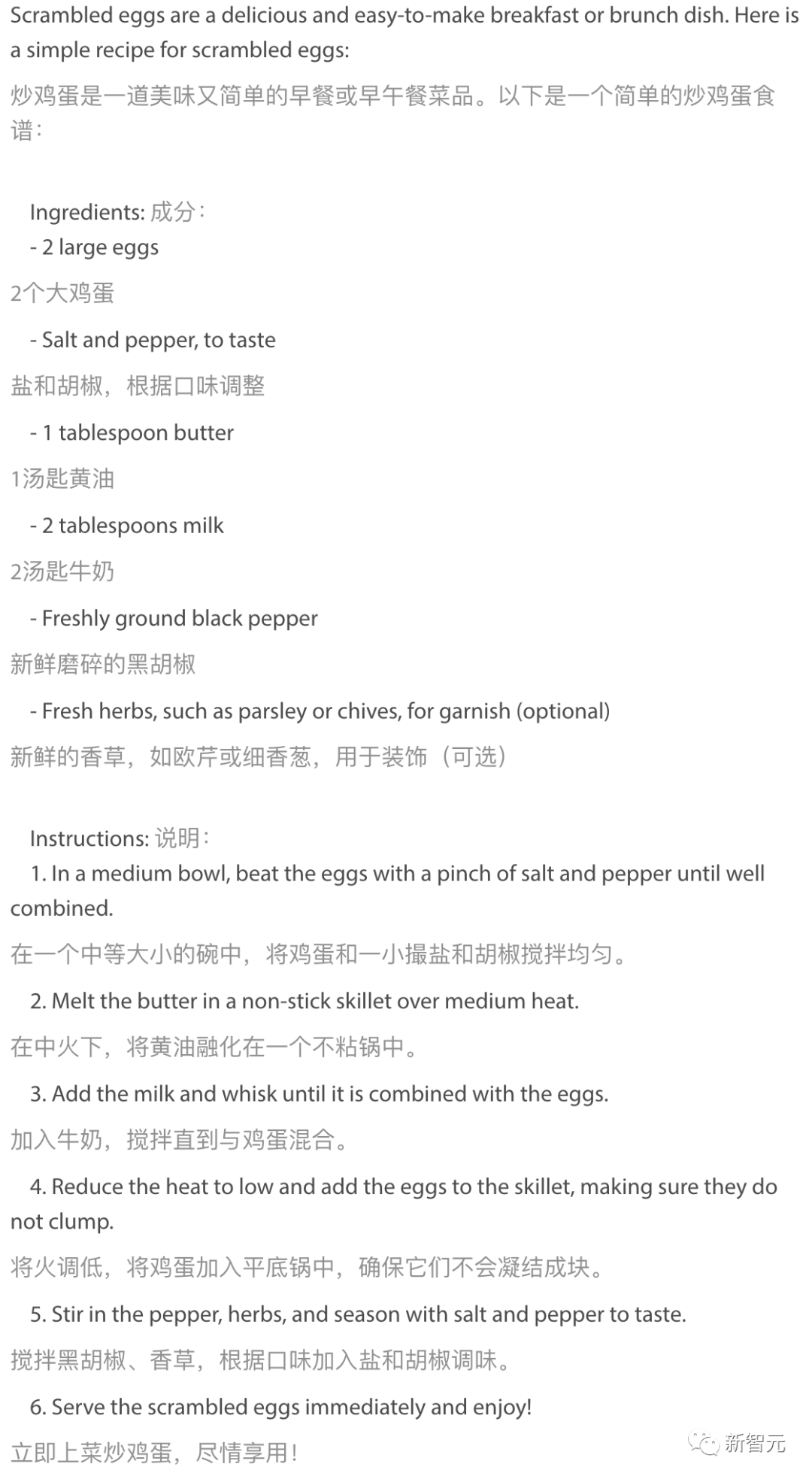

写一个Python函数,找到小于n的所有偶数自然数的和: 给一份炒鸡蛋的食谱:

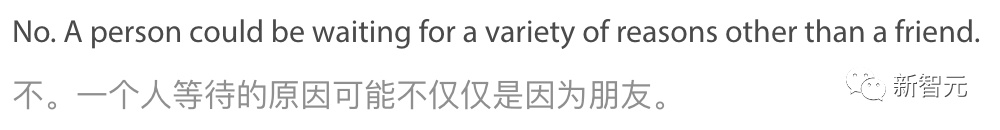

给一份炒鸡蛋的食谱: 还能成功做出逻辑题。前提: 「有人站在一栋建筑的外面。」假设: 「站在建筑附近的人正在外面等他的朋友。」请问这个假设能从前提中推断出来吗?请给出你的解释。

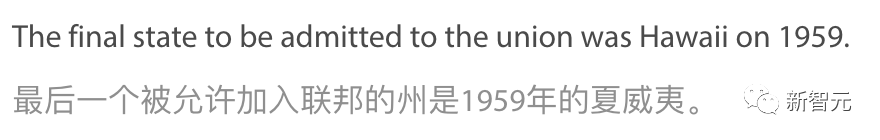

还能成功做出逻辑题。前提: 「有人站在一栋建筑的外面。」假设: 「站在建筑附近的人正在外面等他的朋友。」请问这个假设能从前提中推断出来吗?请给出你的解释。 常识问题,都回答得很好,比如最后加入美国的州是哪个?

常识问题,都回答得很好,比如最后加入美国的州是哪个? 彩虹是怎么产生的?

彩虹是怎么产生的? 甚至能读懂语句中很细微的暗示。比如「图片很漂亮,但缺乏实质性的东西」,这个产品评论是偏正面还是偏负面?

甚至能读懂语句中很细微的暗示。比如「图片很漂亮,但缺乏实质性的东西」,这个产品评论是偏正面还是偏负面? 它会回答:是负面。

它会回答:是负面。

图像生成

图像生成上,Unified-IO 2的表现也很让人惊喜。一张快乐的狗狗在纽约旅行时与地标合影的照片。 将木板路改成小径。

将木板路改成小径。

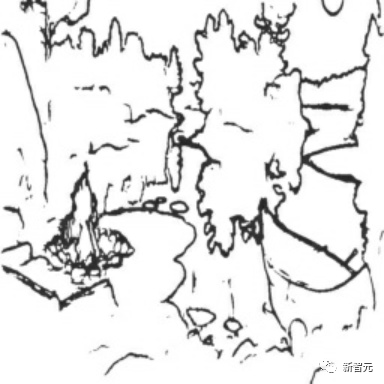

绘制一幅图像:夜晚的河畔,倒映着月光,散发着浪漫气息。一只小船静静地泊在河中,周围是旅游胜地的岛屿和闪烁的篝火。这幅图应当与草图风格保持一致,画面中还应包含艺术家Kim Norlien的特色元素。

绘制一幅图像:夜晚的河畔,倒映着月光,散发着浪漫气息。一只小船静静地泊在河中,周围是旅游胜地的岛屿和闪烁的篝火。这幅图应当与草图风格保持一致,画面中还应包含艺术家Kim Norlien的特色元素。 Photo wallpaper night, reflection, river, stay, the moon, romance, boat, picture, Kim Norlien, tourism, island, the fire. It should match sketch

Photo wallpaper night, reflection, river, stay, the moon, romance, boat, picture, Kim Norlien, tourism, island, the fire. It should match sketch

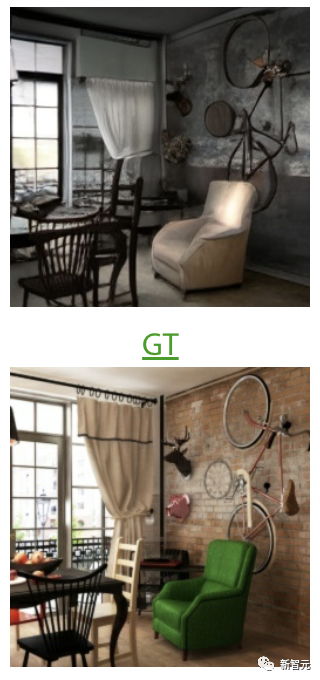

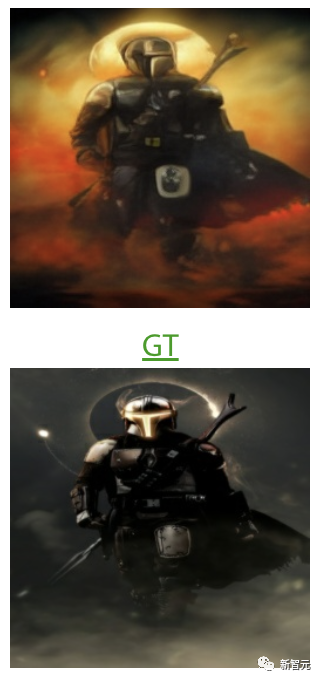

上面为生成的,下面是原图根据提供的表面法线图(surface normal map),创作一幅图像,这幅图像要体现出homify设计的工业风格餐厅的特点。

上面为生成的,下面是原图创建与草图一致的1280×2120曼达洛人第2季4k 2021 Iphone 6高清4k壁纸、图像、背景、照片和图片的图像。

上面为生成的,下面是原图

音频生成

文本转音频显然是小case了。比如,朗读:「Many animals of even complex structure which live parasitically within others are wholly devoid of an alimentary cavity.」很多结构上相当复杂的动物,它们寄生在其他生物体内,却完全没有消化系统。不仅如此,我们随便给一张乐器的照片,Unified-IO 2都能生成对应的声音。

甚至,Unified-IO 2还可以根据图片中的场景生成音乐。 有趣的是,当我们把这幅图的色调和氛围调「暗」之后,生成音乐也变得阴郁了起来。

有趣的是,当我们把这幅图的色调和氛围调「暗」之后,生成音乐也变得阴郁了起来。 此外,我们还可以通过自然语言描述,让Unified-IO 2生成对应风格的音乐。比如,创作一首慢节奏的雷鬼风格歌曲,以浓郁的贝斯和鼓点为主导。

此外,我们还可以通过自然语言描述,让Unified-IO 2生成对应风格的音乐。比如,创作一首慢节奏的雷鬼风格歌曲,以浓郁的贝斯和鼓点为主导。

图像理解

问:在这种情况下,我应该注意什么?答:在雾蒙蒙的夜晚或能见度低时驾车,要特别留意。路上停有几辆车,包括卡车,因此驾驶时要格外小心,维持适当的车速,并时刻准备应对夜晚灯光可能带来的眩光和突如其来的障碍物。密切关注交通标志和信号,以及其他车辆的动向,确保在这种复杂的驾驶条件下安全行驶。另外,由于能见度可能影响你对前后车辆的观察,建议你采取防御性驾驶策略,并与其他车辆保持足够的安全距离。 问:有几把椅子?答:房间里有三把椅子。

问:有几把椅子?答:房间里有三把椅子。 问:这张图片最有可能在哪里?答:这幅图片极有可能是展示了华盛顿州雪白覆盖的雷尼尔山。雷尼尔山以其显赫和壮丽著称,无论是从附近的森林、小山丘还是山脉,都能享受到令人赞叹的美景。

问:这张图片最有可能在哪里?答:这幅图片极有可能是展示了华盛顿州雪白覆盖的雷尼尔山。雷尼尔山以其显赫和壮丽著称,无论是从附近的森林、小山丘还是山脉,都能享受到令人赞叹的美景。 问:请详细描绘这幅图像,并谈谈你对这一场景的感受。答:画面中,一座木制的小码头静静地伸向宁静的湖面,湖周围绿树成荫。整个场景透出一股宁谧祥和的气息。远处,山脉层峦叠嶂,绵延至天际。码头几乎横跨整个画面,映衬着周遭自然的壮丽。湛蓝的湖水与远处翠绿山峰的鲜明对比,使得这幅景色更加迷人。总的来说,这幅图捕捉到了户外大自然的宁静与纯粹,展现了一片让人向往的田园风光。

问:请详细描绘这幅图像,并谈谈你对这一场景的感受。答:画面中,一座木制的小码头静静地伸向宁静的湖面,湖周围绿树成荫。整个场景透出一股宁谧祥和的气息。远处,山脉层峦叠嶂,绵延至天际。码头几乎横跨整个画面,映衬着周遭自然的壮丽。湛蓝的湖水与远处翠绿山峰的鲜明对比,使得这幅景色更加迷人。总的来说,这幅图捕捉到了户外大自然的宁静与纯粹,展现了一片让人向往的田园风光。

视频理解

问:视频里的那个男人在做些什么?答:视频里,这位男士在镜头前跳着舞,摆出各种姿势,炫耀他那精湛的舞步和流畅的身姿。 问:机器人在做什么?答:把桌上的橙色物品放到烤箱里。

问:机器人在做什么?答:把桌上的橙色物品放到烤箱里。 根据物体之前的位置信息,能预测出它接下来会出现在哪里吗?

根据物体之前的位置信息,能预测出它接下来会出现在哪里吗?

音频理解

在给定图像中找到声源的边界框。 找到产生给定声音的乐器的位置。

找到产生给定声音的乐器的位置。

图像稀疏标注

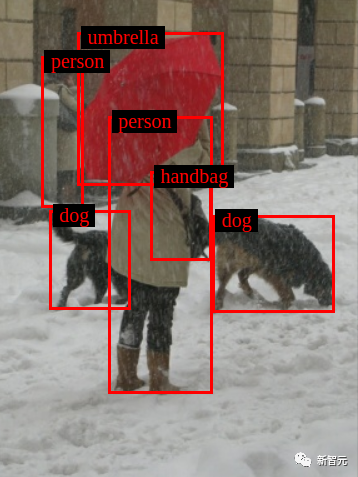

给出图像中物体的种类和定位框。(参照COCO数据集)

找到图像中的所有对象。

找到图像中的所有对象。

找出并标识出这只猫的关键特征点。

找出并标识出这只猫的关键特征点。

图像密集标注

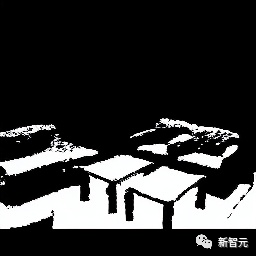

创建一个用于识别朝上表面的分割图(segmentation map)。

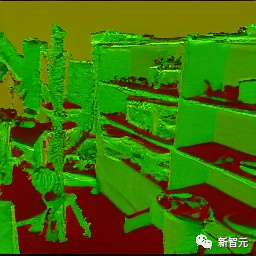

通过将每个像素的方向编码到图像中来计算此图像的表面法线。请使用红色表示z方向,绿色表示y方向。

通过将每个像素的方向编码到图像中来计算此图像的表面法线。请使用红色表示z方向,绿色表示y方向。

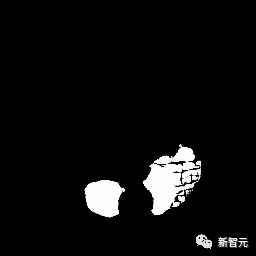

将葡萄和苹果分割开来。

将葡萄和苹果分割开来。

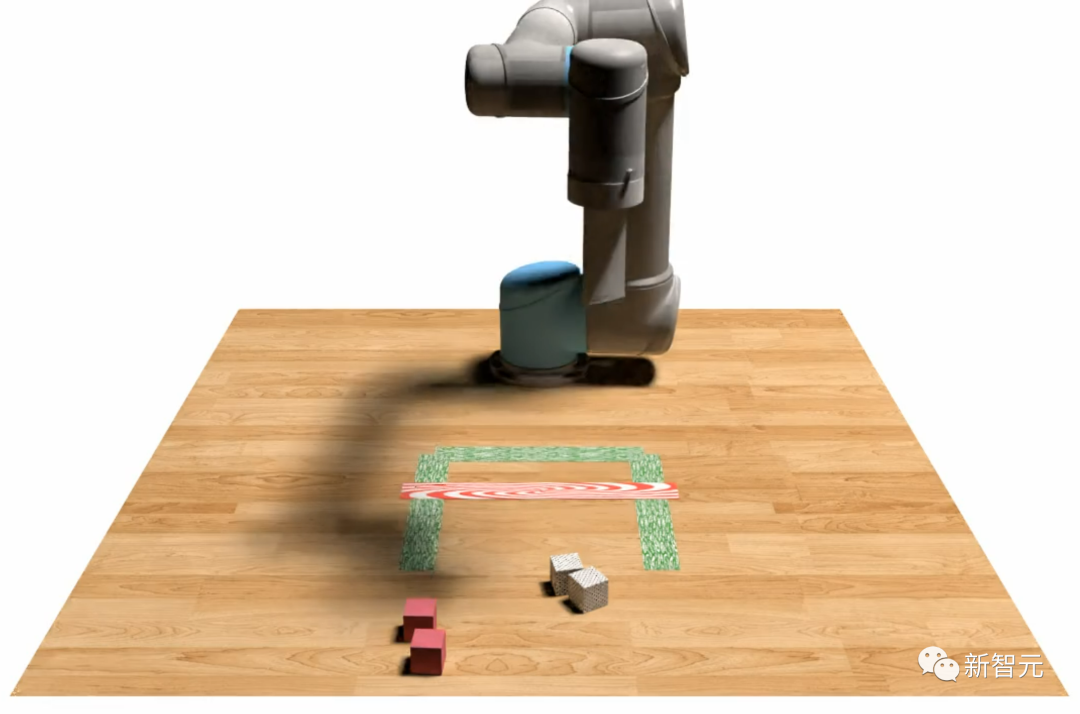

具身智能与3D

通过Unified-IO 2,可以让机器人把所有红色木块扫到绿色框内,同时不越界。

在当前机器人RGB观察和提示「选择绿色矩形块并将其放在黄色和红色块之间的桌子上」的情况下,目标图像是什么样子的?

在当前机器人RGB观察和提示「选择绿色矩形块并将其放在黄色和红色块之间的桌子上」的情况下,目标图像是什么样子的?

根据智能体的观察和行动创建图片。

根据智能体的观察和行动创建图片。

方法

统一任务表征

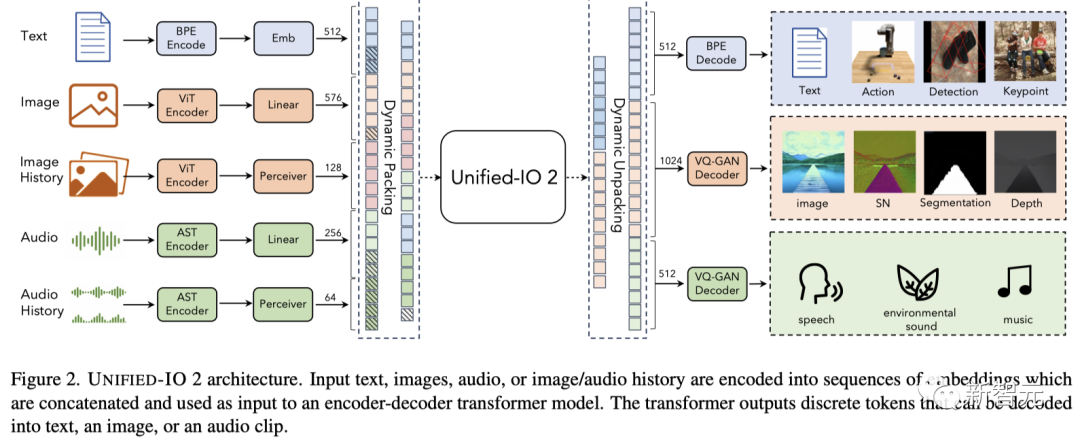

Unified-IO 2通过一个统一的编解码器Transformer来处理不同类型的数据,如图片、文本、音频、动作和边界框等。它会将这些不同形式的输入和输出转换为共享表征空间里的token序列。顾名思义,该方法是在Unified-IO基础上进行改进的。这次,研究人员不仅提升了处理效能,还为更多的数据类型增加了新的编码器和解码器。

模型架构

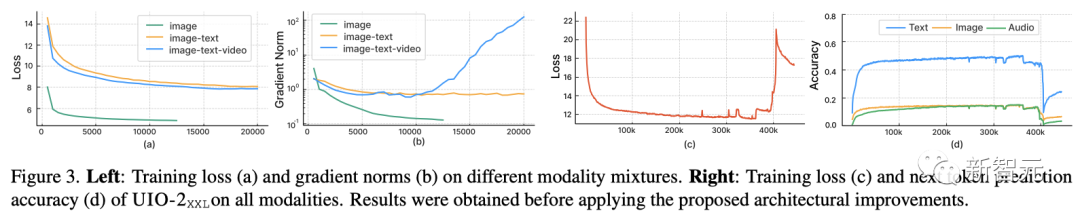

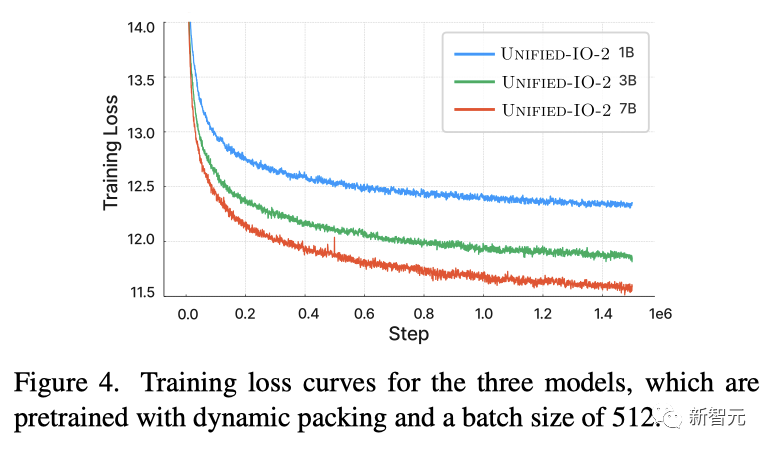

研究人员发现,直接在初代Unified-IO方案中加入更多类型的数据,会让训练过程会变得不稳定。如图3 (a) (b)所示,如果只进行图像生成任务(绿色曲线),损失值和梯度范数会稳定下降。当加入图像和文本任务的混合(橙色曲线)时,梯度范数相较于单一数据类型有轻微上升,但整体仍然稳定。然而,一旦加入视频数据(蓝色曲线),梯度范数就会无限制地飙升。当模型的超大型(XXL)版本在所有类型的数据上进行训练时,如图3 (c) (d)所示,训练步数达到350k后损失值急剧上升,到了400k步数时,下一个token的预测准确度也大幅下降。 为了应对这个问题,研究人员引入了多项架构改进,显著提高了多类型数据训练的稳定性。– 2D旋转位置嵌入模型每一层Transformer中都采用了旋转位置嵌入(RoPE),而不是相对位置嵌入。并且,对于图像等非文本数据,研究人员还对RoPE进行了二维空间的扩展——对于任意的二维坐标(i, j),把Transformer注意力机制中的查询(query)和键(key)向量分为两部分,然后分别对这两部分应用由两个坐标生成的旋转嵌入。– QK归一化在将图像和音频模态结合进来时,多头注意力对数值非常大,这会导致注意力权重要么是0,要么是1,从而造成训练的不稳定。为了克服这一问题,研究人员在进行点积注意力机制的计算之前,对查询(query)和键(key)向量先进行了层归一化(LayerNorm)。– 缩放余弦注意力研究人员采用了一种称为感知器重采样器的技术,将每一帧图像和音频片段转换成固定数目的token。为了解决QK归一化后,感知器内部计算出的注意力对数依然会增长到极值的问题,研究人员在感知器中采用了一种称为缩放余弦注意力的更为严格的归一化方法,从而大大增强了训练过程的稳定性。为了防止数值计算上的不稳定,研究人员还启用了32位浮点数来处理注意力对数。此外,同时更新视觉 Transformer(ViT)和音频空间 Transformer(AST)这两个预训练模型可能会导致不稳定现象。于是,研究人员选择在预训练阶段冻结这两个模型的参数,然后在训练的最后阶段再进行微调。如图4所示,尽管处理的输入和输出数据类型多种多样,Unified-IO 2模型在预训练过程中显示出了稳定的损失曲线。

为了应对这个问题,研究人员引入了多项架构改进,显著提高了多类型数据训练的稳定性。– 2D旋转位置嵌入模型每一层Transformer中都采用了旋转位置嵌入(RoPE),而不是相对位置嵌入。并且,对于图像等非文本数据,研究人员还对RoPE进行了二维空间的扩展——对于任意的二维坐标(i, j),把Transformer注意力机制中的查询(query)和键(key)向量分为两部分,然后分别对这两部分应用由两个坐标生成的旋转嵌入。– QK归一化在将图像和音频模态结合进来时,多头注意力对数值非常大,这会导致注意力权重要么是0,要么是1,从而造成训练的不稳定。为了克服这一问题,研究人员在进行点积注意力机制的计算之前,对查询(query)和键(key)向量先进行了层归一化(LayerNorm)。– 缩放余弦注意力研究人员采用了一种称为感知器重采样器的技术,将每一帧图像和音频片段转换成固定数目的token。为了解决QK归一化后,感知器内部计算出的注意力对数依然会增长到极值的问题,研究人员在感知器中采用了一种称为缩放余弦注意力的更为严格的归一化方法,从而大大增强了训练过程的稳定性。为了防止数值计算上的不稳定,研究人员还启用了32位浮点数来处理注意力对数。此外,同时更新视觉 Transformer(ViT)和音频空间 Transformer(AST)这两个预训练模型可能会导致不稳定现象。于是,研究人员选择在预训练阶段冻结这两个模型的参数,然后在训练的最后阶段再进行微调。如图4所示,尽管处理的输入和输出数据类型多种多样,Unified-IO 2模型在预训练过程中显示出了稳定的损失曲线。

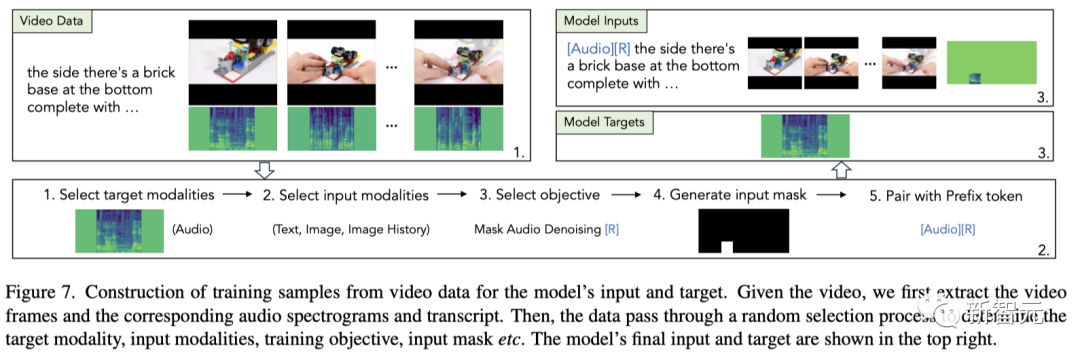

多模态数据

与之前的研究相比,UNIFIED-IO 2从一开始就使用了多种类型的多模态数据对模型进行训练。这就需要精心准备高质量的开源多模态数据,既用于模型的预训练,也用于模型根据指令进行微调。

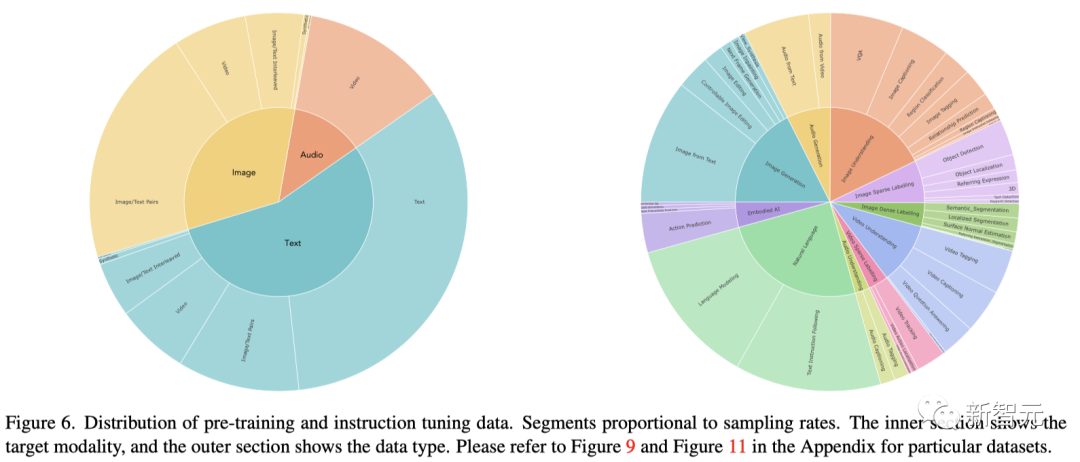

预训练

– 自然语言处理(33%)

– 图文(40%)

– 音视频(25%)

– 3D和具身(1%)

– 数据增强(1%)

指令微调

多模态指令调整是一个关键过程,它使得模型能够掌握多种模态的丰富技能和能力,并能够适应新颖和特殊的指令。研究人员通过组合多种监督学习的数据集和任务,构建了一个多模态指令调整数据集,确保每个任务都配有明确的任务指令。此外,研究人员还引入了开放式任务,并为那些不太常见的模态设计了合成任务,以此来丰富任务类型和指令的多样性。最终完成的任务集合包含了超过120个外部数据集中的220个任务。

– 自然语言理解(25.0%)

– 图像生成(17.6%)

– 音频生成(7.5%)

– 图像理解(17.8%)

– 视频理解(10.6%)

– 音频理解(10.6%)

– 图像稀疏标注(7.25%)

– 图像密集标注(4.06%)

– 视频稀疏标注(3.42%)

– 具身智能(4.33%)如图6所示,指令微调数据的分布情况如下:60%的提示性数据(prompting data);为了防止模型学习新知识时出现灾难性遗忘而保留的30%的预训练数据;6%的任务扩展数据;由自由对话组成的4%文本数据,从而更好地生成类似聊天的回答。

实验评估

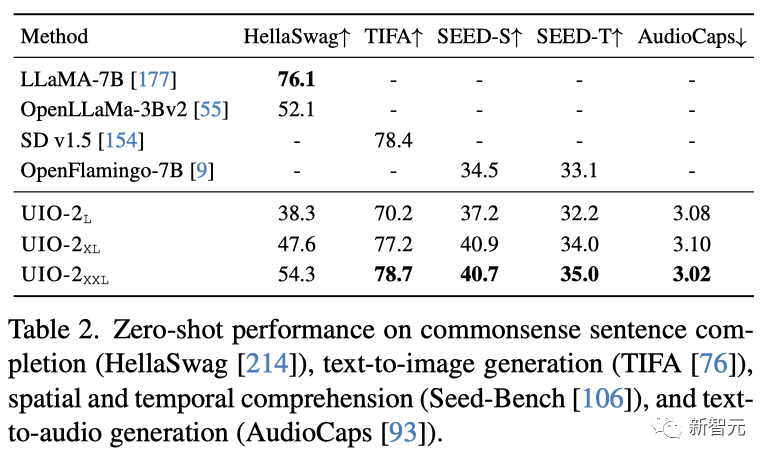

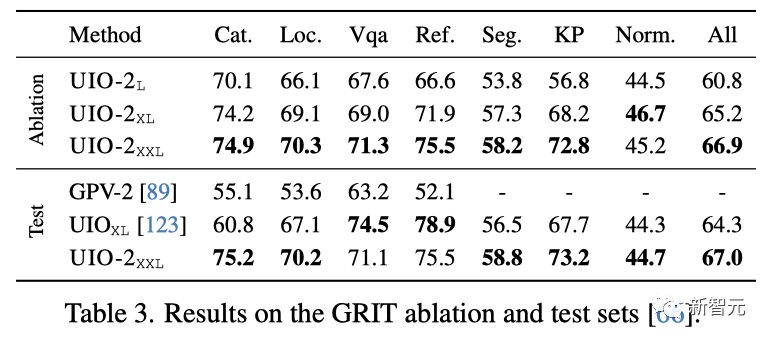

研究人员在包括自然语言推断、文本生成图像以及文本生成音频等关键领域对Unified-IO 2进行评估。如表2所示,Unified-IO 2在生成和理解任务上,性能与专门针对特定任务的模型或通用的多模态模型相当,甚至更强。 研究人员对通用图像任务鲁棒性(GRIT)基准进行了评估,该基准包含七项任务:分类、定位、视觉问答、指代识别、实例分割、关键点检测和表面法向量估计。要完成这七项任务,需要理解图像、文本和稀疏输入,并能够生成文本、稀疏和密集型输出。尽管这些任务只 Unified-IO 2支持的模式的一部分,研究人员之所以选择在GRIT上进行评估,是因为它为这些能力提供了一个标准化且综合性的评价体系。评估结果见表3。总体来看,Unified-IO 2在GRIT上的表现达到了行业领先水平,比之前最好的模型Unified-IO高出了2.7分。在各项单独任务中,可以观察到在定位(提高了3分)、分类(提高了14分)、分割(提高了2分)和关键点检测(提高了5分)方面取得了进步。在视觉问答任务上,GRIT评估显示Unified-IO 2在处理相同数据源的问题上表现更佳,这表明性能差距主要是由于处理从视觉基因组数据库新构建的问题时会表现不佳。

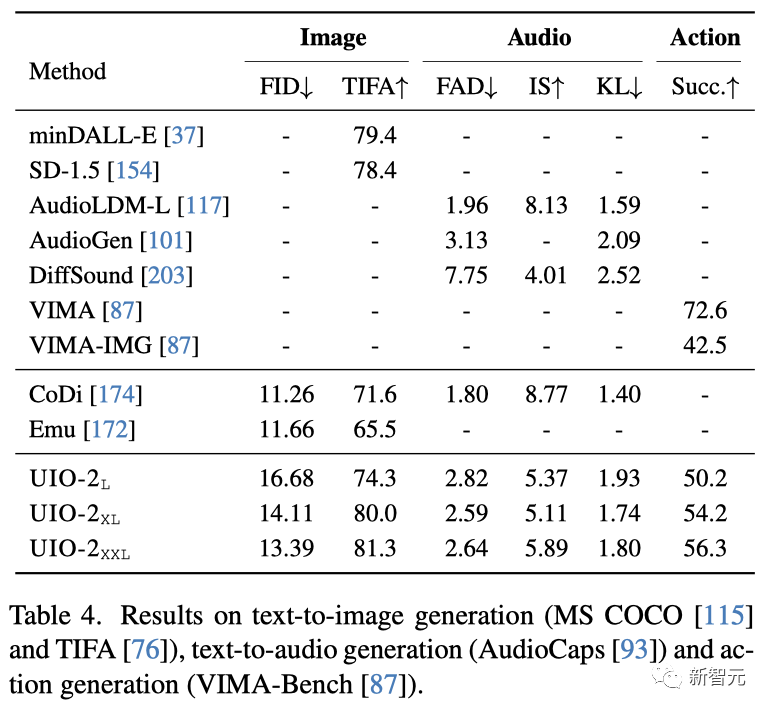

研究人员对通用图像任务鲁棒性(GRIT)基准进行了评估,该基准包含七项任务:分类、定位、视觉问答、指代识别、实例分割、关键点检测和表面法向量估计。要完成这七项任务,需要理解图像、文本和稀疏输入,并能够生成文本、稀疏和密集型输出。尽管这些任务只 Unified-IO 2支持的模式的一部分,研究人员之所以选择在GRIT上进行评估,是因为它为这些能力提供了一个标准化且综合性的评价体系。评估结果见表3。总体来看,Unified-IO 2在GRIT上的表现达到了行业领先水平,比之前最好的模型Unified-IO高出了2.7分。在各项单独任务中,可以观察到在定位(提高了3分)、分类(提高了14分)、分割(提高了2分)和关键点检测(提高了5分)方面取得了进步。在视觉问答任务上,GRIT评估显示Unified-IO 2在处理相同数据源的问题上表现更佳,这表明性能差距主要是由于处理从视觉基因组数据库新构建的问题时会表现不佳。 表4展示了模型在生成图像、音频和动作输出方面的任务上的成绩。研究人员采用了TIFA进行评估,该方法通过视觉问答模型来衡量生成内容与指令的吻合度,并且与人类评价有较高的一致性。研究人员还使用了在MS COCO数据集上的FID指标进行评估。在TIFA上的测试结果显示,Unified-IO 2的得分与minDALL-E相近,并且比其他综合型模型,比如CoDi和Emu,领先约10分。

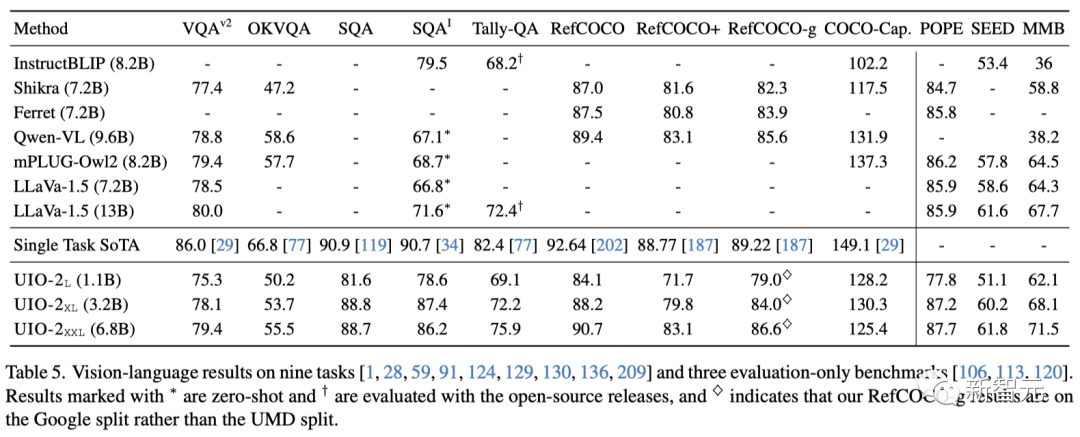

表4展示了模型在生成图像、音频和动作输出方面的任务上的成绩。研究人员采用了TIFA进行评估,该方法通过视觉问答模型来衡量生成内容与指令的吻合度,并且与人类评价有较高的一致性。研究人员还使用了在MS COCO数据集上的FID指标进行评估。在TIFA上的测试结果显示,Unified-IO 2的得分与minDALL-E相近,并且比其他综合型模型,比如CoDi和Emu,领先约10分。 从表5可以看出,Unified-IO 2在指代理解能力上仍然取得了出色的成绩,与之前在通用多模态模型方面的研究相比,有着明显的优势。在支持更高品质的图像和文本生成方面,Unified-IO 2还能处理更多种类的任务和多种形式的数据,这充分证明了模型在处理多任务方面的强大能力。研究人员对视觉与语言任务的性能进行了评估,并将其与其他能够执行多项任务并遵循指令的视觉-语言综合型模型进行了对比,结果如表5所示。

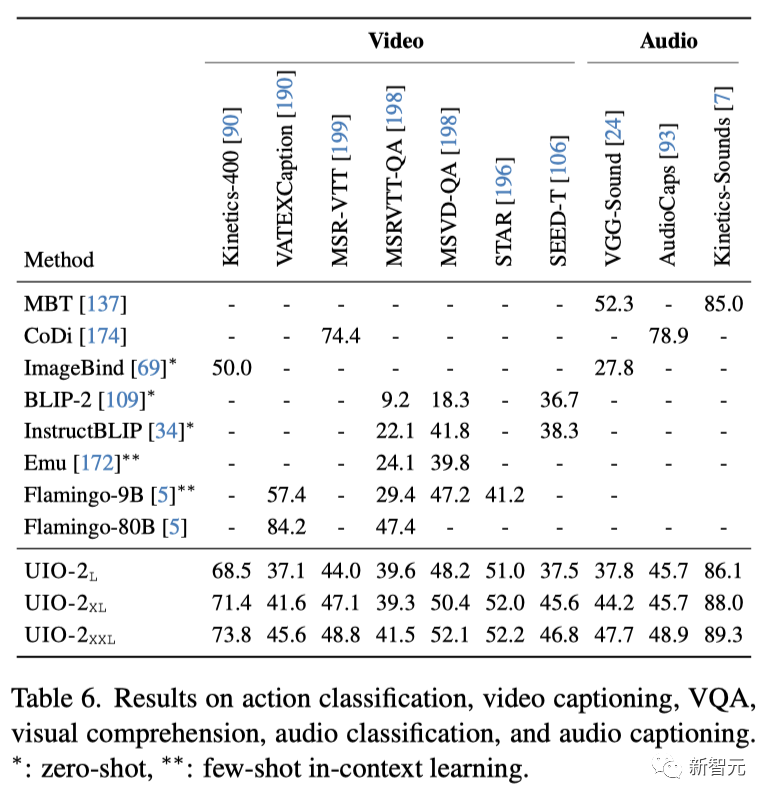

从表5可以看出,Unified-IO 2在指代理解能力上仍然取得了出色的成绩,与之前在通用多模态模型方面的研究相比,有着明显的优势。在支持更高品质的图像和文本生成方面,Unified-IO 2还能处理更多种类的任务和多种形式的数据,这充分证明了模型在处理多任务方面的强大能力。研究人员对视觉与语言任务的性能进行了评估,并将其与其他能够执行多项任务并遵循指令的视觉-语言综合型模型进行了对比,结果如表5所示。 Unified-IO 2在视觉问答任务(VQA)中表现出色,仅次于体量更大的13B LLaVa模型在VQA v2的成绩,并在ScienceQA和TallyQA上超过了所有其他综合型模型。OK-VQA是个例外。研究人员推测,这可能是因为该任务需要外部知识,因此广泛的语言预训练变得尤为重要,这也是为什么模型在性能上不如Qwen-VL和mPLUG-Owl2这些进行了深入文本预训练的专用语言模型。如表6所示,Unified-IO 2在音频和视频的分类、生成视频标注以及视频问答任务上都有不错的表现。值得一提的是,在Seed-Bench Temporal的测试中,Unified-IO 2比BLIP-2和InstructBLIP高出了8.5分。在Kinetics-Sounds的测试上,Unified-IO 2也超过了只在这一数据集上进行训练的MBT。

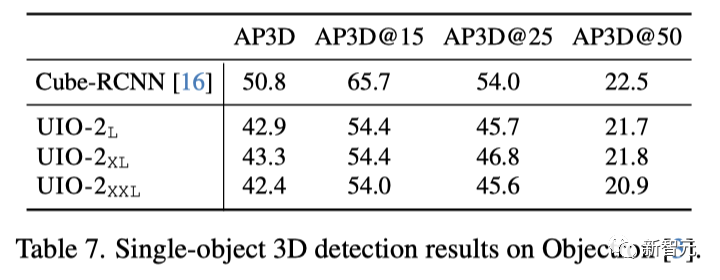

Unified-IO 2在视觉问答任务(VQA)中表现出色,仅次于体量更大的13B LLaVa模型在VQA v2的成绩,并在ScienceQA和TallyQA上超过了所有其他综合型模型。OK-VQA是个例外。研究人员推测,这可能是因为该任务需要外部知识,因此广泛的语言预训练变得尤为重要,这也是为什么模型在性能上不如Qwen-VL和mPLUG-Owl2这些进行了深入文本预训练的专用语言模型。如表6所示,Unified-IO 2在音频和视频的分类、生成视频标注以及视频问答任务上都有不错的表现。值得一提的是,在Seed-Bench Temporal的测试中,Unified-IO 2比BLIP-2和InstructBLIP高出了8.5分。在Kinetics-Sounds的测试上,Unified-IO 2也超过了只在这一数据集上进行训练的MBT。 表7展示了单个物体的3D检测结果。模型在Objectron基准上取得了与CubeRCNN相媲美的好成绩。然而,在nuScenes和Hypersim上的多物体3D检测任务中,性能却有了明显的下降。这可能是因为训练数据中只有1.0%是针对3D检测的。

表7展示了单个物体的3D检测结果。模型在Objectron基准上取得了与CubeRCNN相媲美的好成绩。然而,在nuScenes和Hypersim上的多物体3D检测任务中,性能却有了明显的下降。这可能是因为训练数据中只有1.0%是针对3D检测的。

结论

Unified-IO 2是首个能够理解和创造图像、文本、音频以及动作的自回归多模态模型(autoregressive multimodal model)。这个模型从零基础开始,在各种多模态数据上接受训练,并通过针对大型多模态语料库的指令微调,进一步提升了其性能。为了稳定多模态训练过程,研究人员进行了若干架构上的改进,并提出了一种多模态混合去噪目标(multimodal mixture of denoiser objective),这使得模型能够更有效地处理多种类型的数据信号。研究证明了从大语言模型(LLM)向多模态模型(LMM)的发展,将会为我们带来了更多的新能力和可能性。

作者介绍

Jiasen Lu

Jiasen Lu是艾伦人工智能研究所的研究科学家,研究领域包括计算机视觉和视觉与语言的交叉研究。他本科毕业于南京邮电大学,在纽约州立大学布法罗分校获得了硕士学位。随后,分别于弗吉尼亚理工大学和佐治亚理工学院取得了计算机工程和计算机科学的博士学位。

Jiasen Lu是艾伦人工智能研究所的研究科学家,研究领域包括计算机视觉和视觉与语言的交叉研究。他本科毕业于南京邮电大学,在纽约州立大学布法罗分校获得了硕士学位。随后,分别于弗吉尼亚理工大学和佐治亚理工学院取得了计算机工程和计算机科学的博士学位。

Zichen Zhang

Zichen Zhang是艾伦人工智能研究所的预博士研究员(Predoctoral Young Investigators, PYI),由Luca Weihs指导。在此之前,他曾在由斯坦福视觉与学习实验室(SVL)和英伟达组成的联合团队中从事研究工作,负责人分别是Jim Fan和Yuke Zhu。他毕业于山东省实验中学,并在玛卡莱斯特学院获得数学与计算机科学学士学位。

Zichen Zhang是艾伦人工智能研究所的预博士研究员(Predoctoral Young Investigators, PYI),由Luca Weihs指导。在此之前,他曾在由斯坦福视觉与学习实验室(SVL)和英伟达组成的联合团队中从事研究工作,负责人分别是Jim Fan和Yuke Zhu。他毕业于山东省实验中学,并在玛卡莱斯特学院获得数学与计算机科学学士学位。

参考资料:https://unified-io-2.allenai.org/

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง