今天是2023年12月30日,星期六,北京,天气晴,2023年倒数第二天

今天我们来聊聊一个有趣的话题,2023年学术界应对chatgpt守城之战,通过arxiv来看看目前学术界对chatgpt发起的各种“反击”【评估】,里面涉及到的知识图谱相关的评估结论很有趣。

但是,评测偏差,测试与工业界业务gap明显,谈不上如何规避,评测偏差,不要太迷信这些探索能力边界的论文,这半年做评估最大的感受就是,这些评估榜单【尤其是学术集合】,误导性不弱。评测结论以及泛化性,能把人带沟里。

此外,关于文档智能,我们在2023年讲了许多,其中包括Nougat(https://arxiv.org/pdf/2308.13418.pdf)等,而最近旷视开源的面向文档处理的大模型OCR引擎Vary,试了下,效果还不错,这里也做下介绍。

坚持一下,2023年马上过完,供大家一起参考。

一、2023年学术界应对chatgpt的守城之战一瞥

2023年,chatgpt引发了学术界的恐慌【大实话】,与chatgpt做对比的论文层出不穷,通过构造各种特定任务,来测试chatgpt,目的在于证明chatgpt不是无所不能,找到其缺点,很有趣。

1、关于chatgpt的一些论文

今年关于chatgpt,标题中很明确地提及chatgpt的,就包括670篇。

2、关于chagtpt can做啥的一些论文

今年,在标题中明确提及关于chatgpt can的,就包括45篇。

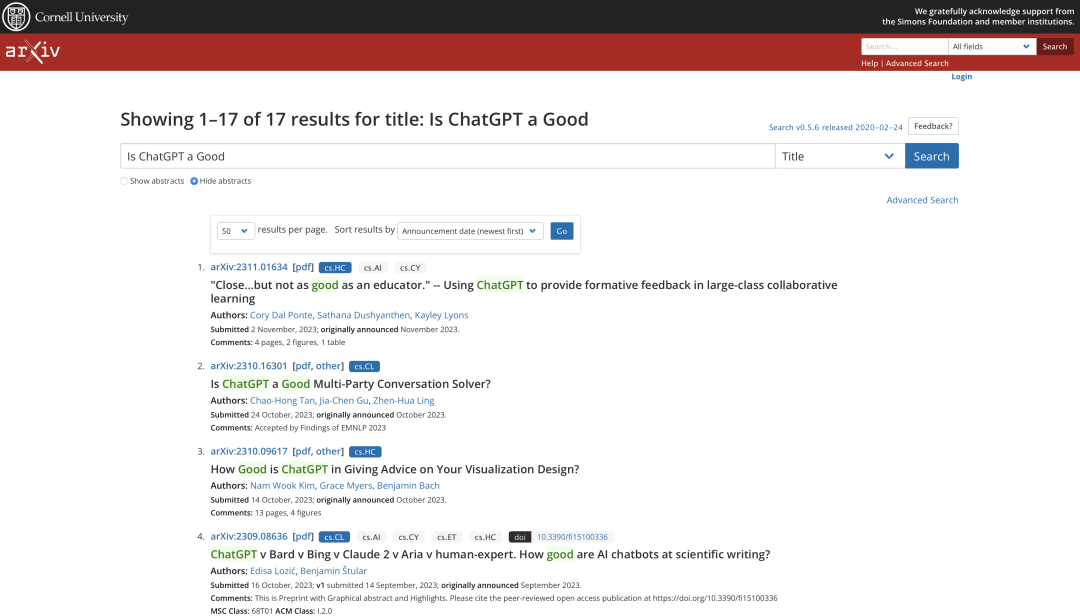

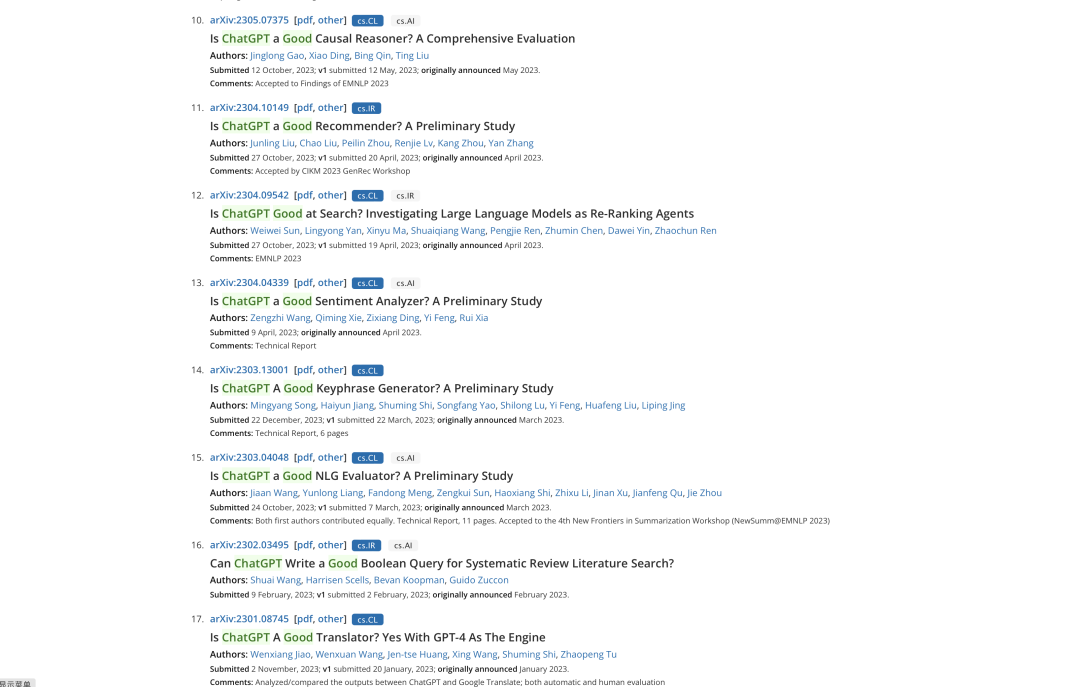

3、关于is chatgpt a good的一些论文

我们可以使用”is chatgpt a good”作为关键词,在arxiv中进行检索:

我们可以在搜索的结果中看到很多有趣的十分相似的论文来验证chatgpt的能力边界,比如推荐、情感分析、关键词生成、生成任务评估、翻译、多轮对话处理等。

4、其中一些很有趣的结论

我们重点来看看其中关于大模型与知识图谱、事理图谱的一些评估结论,讲三个,包括知识图谱问答、信息抽取以及事理图谱。

1)ChatGPT是个好的因果推理器么?

今天早上看到一个工作:《Is ChatGPT a Good Causal Reasoner? A Comprehensive Evaluation》(https://arxiv.org/abs/2305.07375),利用事件因果关系识别(ECI)任务、因果发现(CD)任务、因果解释生成(CEG)任务来测试chagpt的因果能力。

其结论在于:

ChatGPT不是一个好的因果推理器,但擅长因果解释生成,存在严重的因果幻觉,这可能是由于因果的报告偏见,随着ChatGPT版本的提升,以及ICL和CoT技术的应用,这种因果幻觉进一步加剧;

ChatGPT对于提示中表达因果概念的方式敏感,且开放式提示不适合ChatGPT,,对于句子中的事件,ChatGPT擅长捕捉明确的因果关系,在事件密度较低和事件距离较小的句子中表现更好。

开放式生成提示无法提高ChatGPT的因果推理能力。“

2)ChatGPT真的可以取代知识图谱问答吗?

又如比较早期的,也是今年3月份工作,《Can ChatGPT Replace Traditional KBQA Models? An In-depth Analysis of the Question Answering Performance of the GPT LLM Family》(https://arxiv.org/abs/2303.07992)评估ChatGPT作为问答系统(QAS)利用其自身知识的表现,进行最小功能测试(MFT)、不变性测试(INV)和方向性期望测试(DIR),也得到了一些有趣的结论,如下:

在单语言的问答测试中,ChatGPT的大多数表现优于类似模型,但在回答数字或基于时间的问题时表现并不是最佳的。此外,在涉及多跳或星型事实推理的问题时,其表现也不如GPT3.5 V3。在多语言测试中,ChatGPT对于回答低资源语言问题表现更为优秀。

在CheckList测试中,ChatGPT在知识库问答方面存在一些限制,包括:MTF测试结果显示,它不擅长回答只涉及一种类型推理的问题。INV测试结果表明,与传统的KBQA相比,ChatGPT在处理相似或几乎相同的输入时不够稳定。DIR测试显示,ChatGPT并不总是对正确提示提供积极反馈。当面对修改后的测试样本时,其输出的变化并不总是符合我们的预期。

3)ChatGPT能解决信息抽取吗?

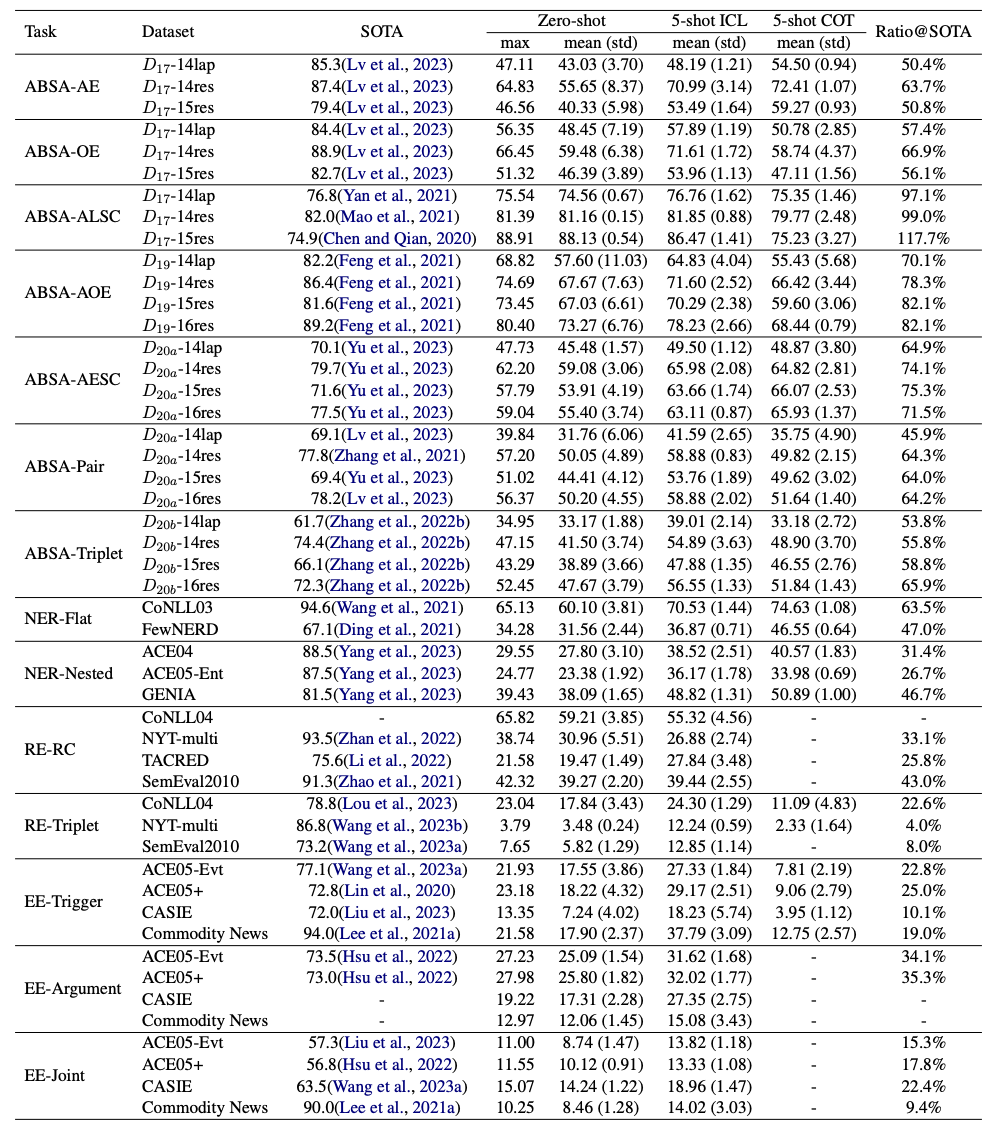

又如,今年8月份,Is Information Extraction Solved by ChatGPT? An Analysis of Performance, Evaluation Criteria, Robustness and Errors(https://arxiv.org/pdf/2305.14450.pdf)采用4类常见的信息抽取任务,包括命名实体识别(NER),关系抽取(RE),事件抽取(EE)和基于方面的情感分析(ABSA),共包含14类子任务,对ChatGPT在信息抽取任务上的能力进行评估。

其也有一些有趣的结论:

ChatGPT和SOTA方法之间存在显著的性能差距;任务的难度越大,场景越复杂, 性能差距越大;

在一些简单的情况下,ChatGPT可以达到或超过SOTA方法的性能;

使用few-shot ICL提示通常有显著提升(约3.0~13.0的F1值),但仍明显落后于SOTA结果;

与few-shot ICL提示相比,few-shot COT提示的使用不能保证进一步的增益,有时它比few-shot ICR提示的性能更差。

但是,评测偏差,测试与工业界业务gap明显,谈不上如何规避,评测偏差,不要太迷信这些探索能力边界的论文,这半年做评估最大的感受就是,这些评估榜单【尤其是学术集合】,误导性不弱。评测结论以及泛化性,能把人带沟里。

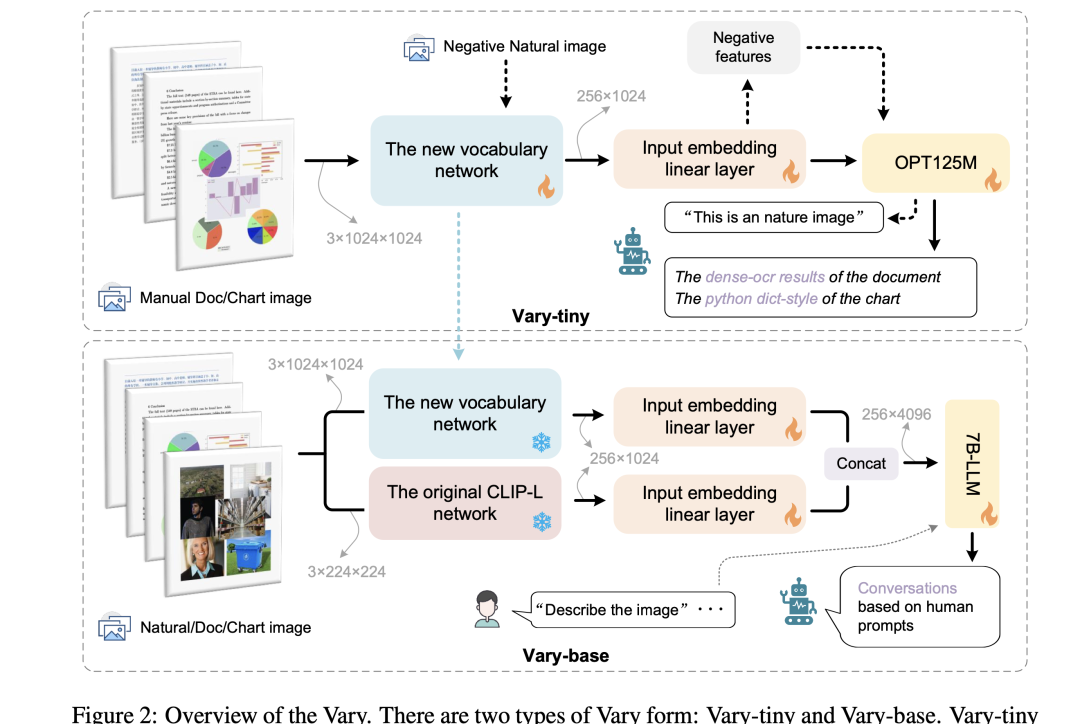

二、可用于文档OCR与表格理解的大模型Vary

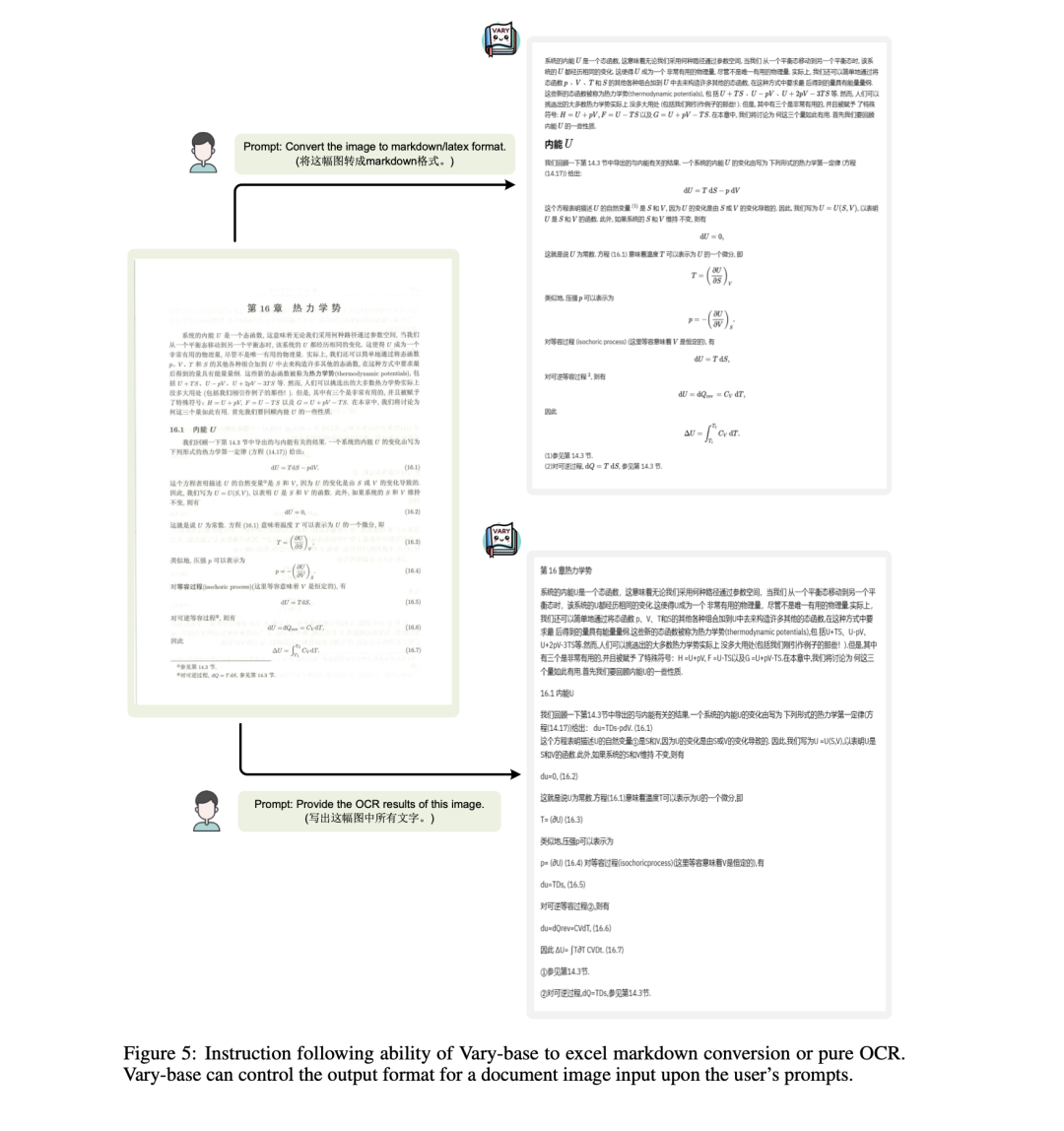

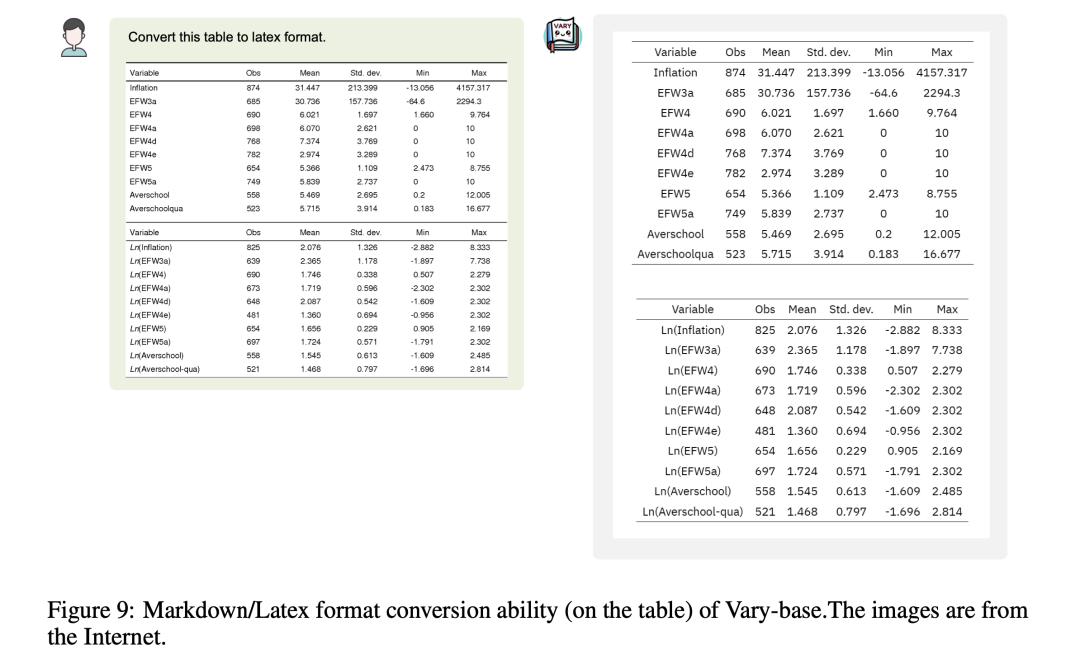

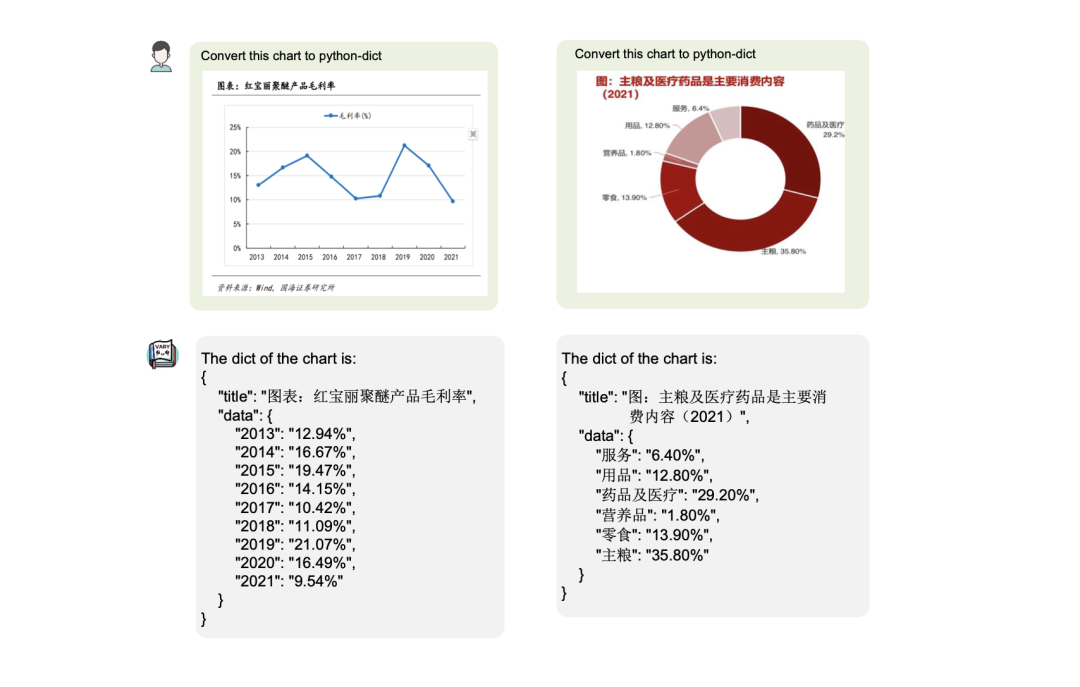

Vary(https://github.com/Ucas-HaoranWei/Vary)是旷视开源的大模型,支持中英文,识别图片中的文本、公式、表格,这个在之前的文档智能话题中,我们有介绍过其他方案。

这个实际测试过,效果还不错,但就是很慢,这个项目可以与我们的大模型RAG系统进行融合,通过RAG召回对应的图表,然后进行问答。也可以作为线下建知识库阶段进行使用,比如对图片解析内容以建立索引。

1)识别文本公式

2)识别表格

3)识别图表

技术细节可以查看技术报告《Vary: Scaling up the Vision Vocabulary for Large Vision-Language Models》(https://arxiv.org/pdf/2312.06109.pdf)

在模型处理阶段,当使用Vicuna-7B作为LLM时,对话格式遵循Vicunav1,即USER:”””textsinput”ASSITANT:”textsoutput”。由于Vicuna的文本词汇处理中文的效率较低,选择Qwen-7B作为LLM进行中文处理。当使用Qwen-7B时,设计了遵循LLaVA-MPT的对话风格,可以描述为:<|im_start|>user:”””textsinput”<|im_end|><|im_start|>助手:“文本输出”<|im_end|>。

项目地址:https://varybase.github.io/

总结

本文主要今天我们来聊聊一个有趣的话题,2023年学术界对抗chatgpt守城之战,通过arxiv来看看目前学术界对chatgpt发起的各种“反击”【评估】,里面涉及到的知识图谱相关的评估结论很有趣,尤其是关于事理图谱。

此外,面向文档处理的大模型OCR引擎Vary,感兴趣的也可以试试,进一步验证其在更多复杂场景下的效果。

参考文献

1、https://mp.weixin.qq.com/s/TeFxseHyqZ96aL6eN6X64g

2、https://mp.weixin.qq.com/s/zDCk4ZEfOyUggwfnVa-B7w

3、https://arxiv.org

关于我们

老刘,刘焕勇,NLP开源爱好者与践行者,主页:https://liuhuanyong.github.io。

老刘说NLP,将定期发布语言资源、工程实践、技术总结等内容,欢迎关注。

对于想加入更优质的知识图谱、事件图谱、大模型AIGC实践、相关分享的,可关注公众号,在后台菜单栏中点击会员社区->会员入群加入。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง