点击下方卡片,关注「AI视界引擎」公众号

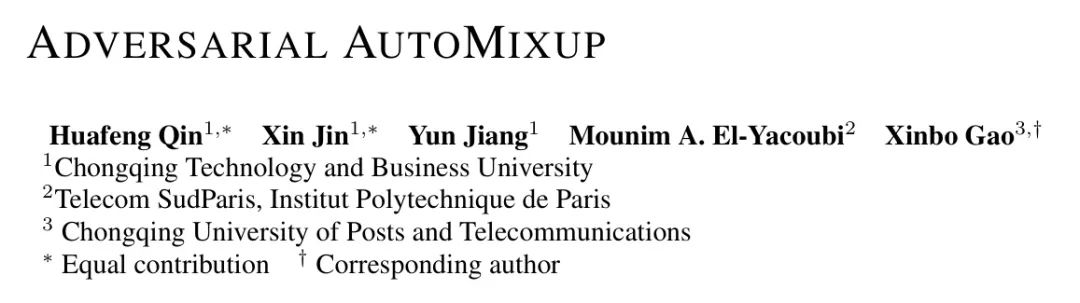

数据混合增强技术已被广泛应用于提高深度神经网络的泛化能力。最近,离线数据混合增强(例如,手工制作和显著性信息基础的混合)逐渐被自动混合方法所取代。通过端到端地最小化两个子任务,即混合样本生成和混合分类,AutoMix显著提高了图像分类任务上的准确性。然而,由于两个子任务的优化目标一致,这种方法倾向于生成一致而不是多样性的混合样本,这导致了对目标任务训练的过拟合。

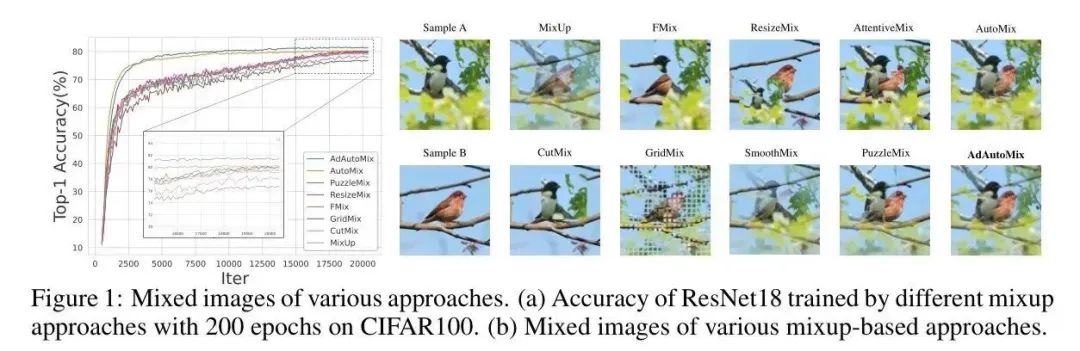

在本文中,作者提出了一种对抗自动混合增强方法AdAutomixup,它通过交替优化分类器和混合样本生成器来生成具有挑战性的样本,以训练一个强大的图像分类器。AdAutomixup包括两个模块,一个混合示例生成器和一个目标分类器。混合示例生成器旨在生成挑战目标分类器的困难混合示例,而目标分类器的目标是学习从困难混合示例中强大的特征,从而提高泛化能力。为了防止图像的固有含义崩溃,作者进一步引入了指数移动平均(EMA)教师和余弦相似度,以端到端地训练AdAutomixup。

在七个图像基准上的广泛实验证明,作者的方法在各种分类场景中超过了最先进的状态。

源代码:https://github.com/JinXins/Adversarial-AutoMixup

1 Introduction

由于它们强大的特征表示能力,如卷积神经网络(CNN)和 Transformer (Transformer)模型已在各种任务中成功地应用,例如图像分类、目标检测和自然语言处理。其中一个重要原因是它们通常利用大型训练数据集来训练大量网络参数。然而,当数据不足时,它们容易发生过拟合并产生过度自信的预测,这可能会降低测试样本上的泛化性能。

为了减轻这些缺点,数据增强(DA)被提出以提高下游目标任务的泛化能力。是一种最近的数据增强方案,由于它可以通过简单地将一对示例及其标签的凸组合来生成虚拟混合示例,从而有效地训练深度学习(DL)模型而受到了越来越多的关注。用于图像分类的DA方法,可以大致分为三类:

- 基于手工制作的混合增强方法,其中来自一张图像的块被随机裁剪并粘贴到另一张图像上。后者与前者的标签按替换块的面积比例混合。代表性的方法包括CutMix、Cutout、ManifoldMixup和ResizeMix;

- 基于显著性图的混合增强方法,它根据图像显著性图生成高质量的样本,同时保留最大显著性区域。代表性的方法(Salien-cymix)通过最大化显著性区域学习最优的混合策略;

- 自动混合增强方法,该方法学习一个模型(例如,DL模型),而不是策略,以自动生成混合图像,例如,提出了一种AutoMix模型用于DA,该模型包括一个目标分类器和生成网络,通过交替优化目标分类器和生成网络自动生成混合样本,以训练一个强大的分类器。

然而,手工制作的混合增强方法在随机混合图像时没有考虑其上下文和标签,因此可能会在混合图像中遗漏目标目标,导致标签不匹配的问题。基于显著性的混合增强方法可以缓解这个问题,因为图像与监督信息相结合,即最大显著性区域。

这些混合模型与上述前两种类别共享相同的学习范式:由随机或可学习混合策略生成的增强训练数据集和图像分类的深度学习(DL)模型。由于图像生成与目标任务(即分类)不直接相关,即基于显著性的,因此生成的图像可能不适合用于目标网络训练。此外,对于目标训练,无法生成所有可能的混合实例。

因此,随机选择的合成样本可能无法代表分类任务,最终降低分类器的泛化性能。此外,这些生成的样本将被目标网络多次输入,导致在长轮次训练中不可避免地过拟合。为了克服这些问题,自动混合增强方法通过一个具有良好复杂度-准确性权衡的子网络生成增强图像。这种方法包括两个子任务:一个混合样本生成模块和一个分类模块,这两个子任务共同优化,通过端到端地最小化分类损失。然而,由于两个子任务的优化目标一致,生成模块可能无法有效地受到指导,并可能生成简单的混合样本以实现这一目标,从而限制了样本的多样化。

因此,在过拟合方面,使用这种简单示例训练的分类器往往受到限制,导致在测试集上的泛化性能较差。另一个局限性是,当前的自动混合增强方法仅将图像混合用于图像生成,而无法有效利用丰富的、有鉴别力的信息。

为了解决这些问题,在本文中提出了一种名为AdAutomixup的对抗自动混合增强方法,该方法可以端到端地自动生成具有对抗训练的混合样本,如图2所示。

首先,作者调查了基于注意力的生成器,以动态地从与相应混合标签相关联的样本对中学习判别像素。其次,作者将基于注意力的生成器与目标分类器相结合,构建一个对抗网络,其中生成器和分类器通过对抗训练交替更新。与AutoMix(Liu等人,2022年)不同,生成器被学习以通过生成对抗样本增加目标网络的训练损失,而分类器则从困难的示例中学习更强的特征以提高泛化能力。此外,作者的生成器可以接受任何一组图像作为输入进行图像生成,而不是仅限于两个图像,这导致混合样本的更多样化。作者的主要贡献如下:

作者提出了一种基于对抗学习策略的在线数据混合方法,该方法可以端到端地自动生成混合样本。

作者提出了一种对抗框架,用于同时优化目标网络训练和混合样本生成器。生成器旨在生成困难的样本以增加目标网络损失,同时,在这样困难的样本上训练的目标网络可以学习到一个强大的表示,从而提高分类性能。为了避免图像固有含义的崩溃,作者应用了指数移动平均(EMA)和余弦相似度来减小搜索空间。

作者探索了一种基于注意力的混合样本生成器,该生成器可以组合多个样本而不是只有两个样本来生成混合样本。生成器的架构在输入图像数量增加时不会改变,因此具有灵活性。

2 Related Work

手工制作的混合增强Mixup,第一种混合数据增强方法,通过减去任意两个样本及其one-hot标签来生成混合样本。ManifoldMixup将这种混合增强从输入空间扩展到特征空间。为了利用其空间局部性,CutMix通过裁剪一个区域并替换为另一个图像的 Patch 来改进MixUp和CutMix。

为了改进MixUp和CutMix,FMix使用从频域采样得到的低频图像应用阈值获得的随机二进制Mask。RecursiveMix迭代地重新缩放输入图像 Patch 并将其粘贴到当前 Patch 中。为了解决由CutMix引起的强烈“边缘”问题,SmoothMix根据软边缘混合混合图像,并相应地计算训练标签。

基于显著性引导的混合增强SaliencyMix,SnapMix和Attentive-CutMix基于由Class Activation Mapping(CAM)检测的显著性区域生成混合图像。类似地,PuzzleMix和Co-Mixup提出了一种优化策略,通过最大化样本显著性区域来获得最优Mask。然而,这些方法都存在样本多样化不足的问题,因为它们总是确定性选择具有最大显著性的区域。为了解决这个问题,Saliency Grafting将显著性图放大并设置阈值,以使所有显著性区域都被考虑,从而增加样本多样性。受到计算机视觉领域Vit的成功启发,基于注意图的适应性混合策略,例如TransMix,TokenMix,TokenMixup,MixPro,以及SMMix,被提出用于生成混合图像。

自动混合增强Automatic Mixup based augmentationThe mixup方法在第一个和第二个类别中允许在精确混合策略和优化复杂性之间进行权衡,因为图像混合任务在训练过程中与目标分类任务不直接相关。为了解决这个问题,AutoMix将混合分类划分为两个子任务,混合样本生成和混合分类,并提出了一个自动混合框架,其中两个子任务以端到端的方式共同优化,而不是独立优化。训练后,生成器直接产生混合样本,而目标分类器保留用于分类。

近年来,对抗数据增强和生成对抗网络被提出用于自动生成图像以进行数据增强。为了解决领域漂移问题,Adversarial MixUp研究了合成混合样本或特征以进行域适应。虽然自动混合增强方面的研究很少,但后者将成为未来的研究趋势。

3 AdAutoMix

在本节中,作者介绍了AdAutoMix的实现,它由一个目标分类器和生成器组成,如图2所示。首先,作者介绍了混合分类问题并定义了损失函数。然后,作者详细介绍了一种基于注意力的生成器,该生成器学习动态地生成图像生成增强Mask策略。最后,作者展示了如何端到端地联合优化目标分类器和生成器。

Deep learning-based classifiers

假设是一个训练集,其中是图像的数量。从中选择任意个样本以获得一个样本集,其中是其相应的标签集。令为任意特征提取模型,例如ResNet(He等人,2016年),其中是一个可训练的权重向量。分类器将示例映射到标签。实现深度学习分类器以预测后验类概率,并通过最小化分类损失(即交叉熵损失)来学习,即式(1):

对于样本集中的个样本,平均交叉熵(ACE)损失由式(2)计算:

在混合分类任务中,作者将与混合比例相关的任意个图像输入到生成器中,该生成器输出一个混合样本,定义在3.2节中的方程(8)中。对于这样的混合图像的标签,可以通过获得。通过平均混合交叉熵(AMCE)损失在方程(3)中进行优化:

类似地,作者也使用方程(4)计算混合交叉熵(MCE)。

Generator

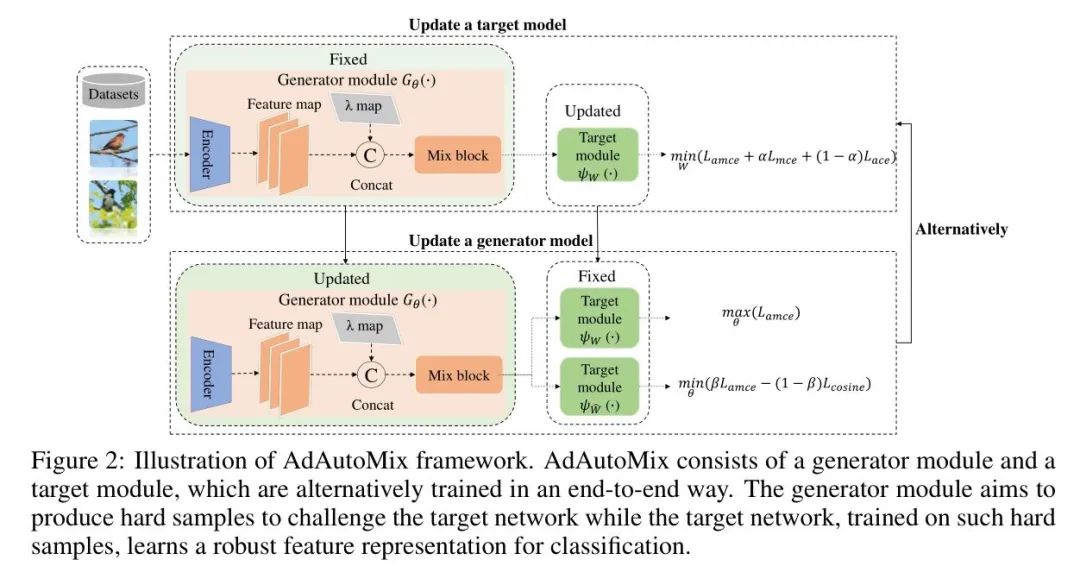

如同第2节所述,大多数现有方法通过手动设计策略或自动学习策略将两个样本混合,这导致了对训练样本提供的可能数据增强监督信息的不足利用。在作者的工作中提出一个通用的生成框架,将两个图像混合扩展到多个图像混合。为了学习一个稳健的混合策略矩阵,作者利用自注意力机制提出一个基于注意力的混合样本生成器,如图3所示。

如第3.1节所述,是一个具有个原始训练样本的样本集,是相应的标签。作者定义作为图像的混合比例集,其和受到约束等于1。如图3所示,每个图像首先映射到特征图,其中是通道数,和分别表示图的大小。然后,作者将混合比例嵌入到产生的特征图,以使生成器学习图像混合的Mask策略。

例如,对于个图像中的第个图像,其中和分别表示图像大小,作者将其输入到编码器,并从其第个层中获取特征图。然后,作者构建一个大小为的矩阵,其中所有值都等于1,乘以相应的比例以获得嵌入矩阵。作者将与第个特征图以简单而有效的方式连接(如图3所示),即。然后,作者将嵌入特征图映射到三个嵌入向量,和,分别由三个带有核的CNN计算。

因此,作者得到个图像的嵌入向量,,…,,,,…,和,,…,。如图3所示,通道数被减少到其一半以节省计算时间,并且的通道数被设置为1。这样,所有图像的嵌入向量都被计算出来,用,,…,,,,…,和,,…,表示。然后,作者计算第个图像的交叉注意力块(CAB),由方程(5)计算:

其中是规范化项。作者使用方程(6)将个注意力矩阵拼接在一起:

矩阵通过上采样被重新缩放到。作者从中分割出个矩阵,将其作为Mask策略矩阵,通过方程(7)在样本集中混合图像:

其中表示Hadamard乘法。为了便于表示,混合图像生成过程用方程(8)表示为一个生成器:

其中表示生成器的所有可学习参数。

Adversarial augmentation

本节提供作者提出的对抗框架,通过对抗学习联合优化目标网络和生成器。具体而言,生成器试图产生一个增强的、混合的图像集以增加目标网络的损失,而目标网络的目标是使分类损失最小化。可以达成一种平衡,其中学习到的表示达到了最大性能。

3.3.1 Adversarial loss

如图8所示,生成器将和混合比例作为输入,并输出一个合成图像来挑战目标分类器。后者接收生成器生成的真实或合成图像作为输入,然后预测其属于每个类的概率。对抗损失定义为以下最小最大问题的最小化,以通过方程(9)训练两个玩家:

其中和分别是训练集和图像集。为了使稳健分类器不仅正确分类混合图像,还能正确分类原始图像,作者引入了两个正则化项和来增强性能。因此,目标函数被重写为方程(10):

为了优化参数,使用给定的图像集来挑战分类器。因此,图像的固有含义(即它们的语义意义)可能会崩溃。

为了应对这个问题,作者引入余弦相似度和教师模型作为两个正则化项来控制混合图像的质量。损失因此被相应地改变,如方程(11)所示:

其中,是余弦相似函数,是一个教师模型,其权重作为目标(EMA)模型权重的指数移动平均更新,即。

注意,是标准交叉熵损失。损失有助于基础模型在早期阶段提供稳定的特征图,从而加快收敛速度。

目标损失旨在在生成的混合样本中学习任务相关的信息。有助于在原始混合样本中捕获任务相关的信息。和用于控制生成混合图像的质量。

Adversarial optimization

与许多现有的对抗训练算法一样,很难直接找到方程(11)中的最小最大问题的鞍点解和。另一种选择是使用梯度下降和上升来更新目标网络和生成器。

考虑目标分类器和损失函数,其中训练好的生成器将多个原始样本映射到混合样本。目标网络的学习过程可以定义为方程(12)中的最小化问题:

方程(12)中的问题通常通过使用常规的梯度下降算法(学习率,批量大小)来解决,训练过程可以用方程(13)计算:

其中是来自块集的混合图像或图像集的数量。由于余弦相似度和教师模型与无关,方程(13)可以改写为方程(14):

请注意,训练过程可以看作是对个实例的梯度计算的平均,这可以减少梯度方差并加速目标网络的收敛。然而,由于长训练周期期间有限的数据量,训练可能会容易出现过拟合。

为了克服这个问题,与AutoMix不同,作者的混合增强生成器将生成一组更难的混合样本以增加目标分类器的损失,这导致了一个最小最大问题来自训练网络。这样的自监督目标可能足够挑战,以防止目标分类器过度拟合目标。因此,目标被定义为以下最大化问题:

为了解决上述问题,作者使用梯度上升来更新参数,学习率定义在方程(16)中:

直觉上,方程(16)的优化是两个子任务的结合,即最大化和最小化。

换句话说,这是试图将生成的合成混合样本推远离真实样本以增加多样性,同时确保合成混合样本对教师模型是可识别的,并且保持在与原始图像特征表示的约束相似性,以避免图像固有含义的崩溃。这种方案可以通过紧密跟踪分类器的更新来生成具有挑战性的样本。作者提供了附录B.2和B.3中的混合样本。

4 Experiments

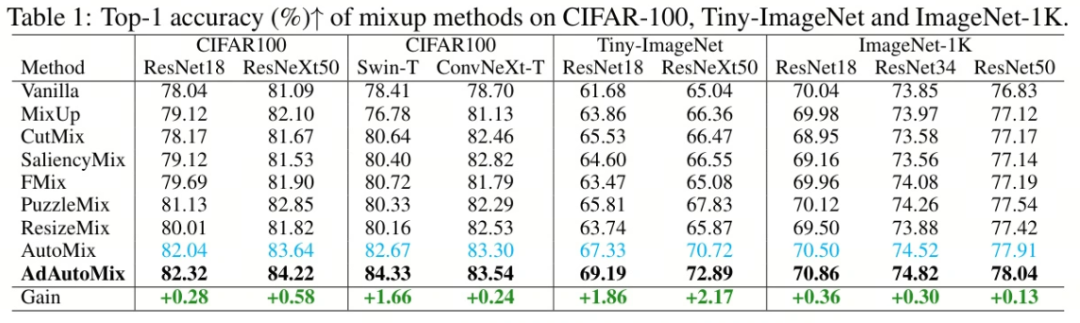

为了估计作者的方法性能,作者在七个分类基准上进行了广泛实验,包括CIFAR100,Tiny-ImageNet,ImageNet-1K,CUB-200,FGVC-Aircraft和Stanford-Cars。

为了公平评估,作者将作者的AdAutoMixture与一些当前的Mixup方法进行比较,例如Mixup,CutMix,ManifoldMix,FMix,ResizeMix,SaliencyMix,PuzzleMix和AutoMix。

为了验证作者的方法的可扩展性,作者使用了五个 Baseline 网络,即ResNet18,ResNet34,ResNet50,ResNeXt50,Swin-Transformer和ConvNeXt,来计算分类准确性。

作者在开源库OpenMixup上实现了作者的算法。一些常见参数遵循AutoMix的实验设置,作者在附录A.2中提供了作者自己的超参数。对于所有分类结果,作者报告了每个试验的平均性能,其中记录了每个试验中最后10个训练周期中top-1测试准确率的中位数。为了便于比较,作者将最佳和次佳结果以粗体和青色突出显示。

Classification results

4.1.1 dataset classification

作者首先在CIFAR100上训练ResNet18和ResNeXt50,共800个epochs。实验设置如下:基本学习率是0.1,动态调整为余弦调度器,使用带有动量的SGD优化器,权重衰减为0.0001,批量大小为100。

为了训练基于ViT的方法,例如Swin-Tiny Transformer和ConvNeXt-Tiny,作者使用AdamW优化器,权重衰减为0.05,批量大小为100,200个epoch。在Tiny-ImageNet上,除了学习率改为0.2,训练超过400个epoch外,训练设置与CIFAR100相似。在ImageNet-1K上,作者使用PyTorch风格的设置,在ResNet18,ResNet34和ResNet50上训练100个epoch。实验实现细节见附录A.3。

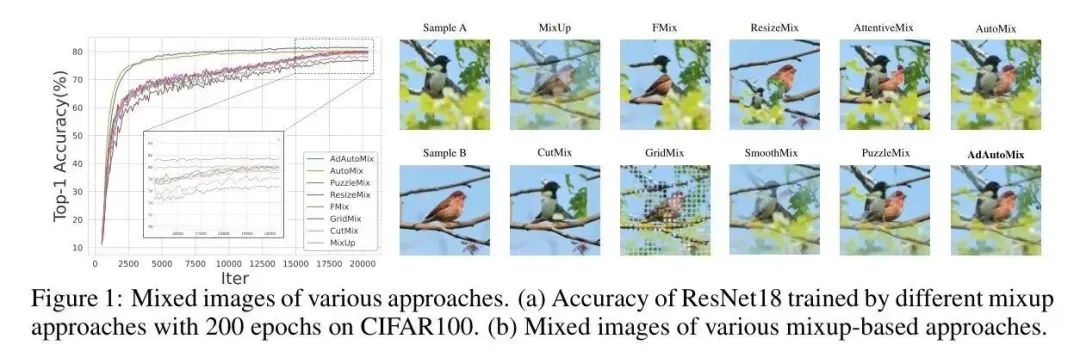

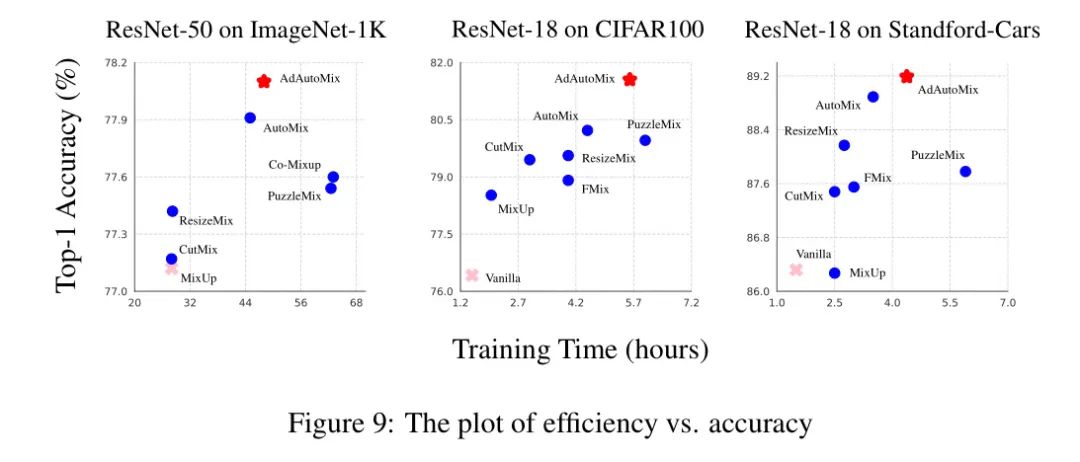

表1和图1显示,作者的方法在CIFAR100上优于现有方法。经过作者的方法训练,ResNet18和ResNeXt50的准确率分别提高了0.28%和0.58%,与最佳结果相比。同样,基于ViT的方法实现了最高的分类准确率84.33%和83.54%,比以前的最佳方法提高了1.66%和0.24%。

在Tiny-ImageNet数据集上,作者的AdAutoMix始终优于现有方法,在提高ResNet18和ResNeXt50的分类性能方面,分别取得了1.86%和2.17%的显著提高。

此外,表1显示,AdAutoMix在ImageNet-1K大型数据集上取得了0.36%的ResNet18,0.3%的ResNet34和0.13%的ResNet50的准确率提高。

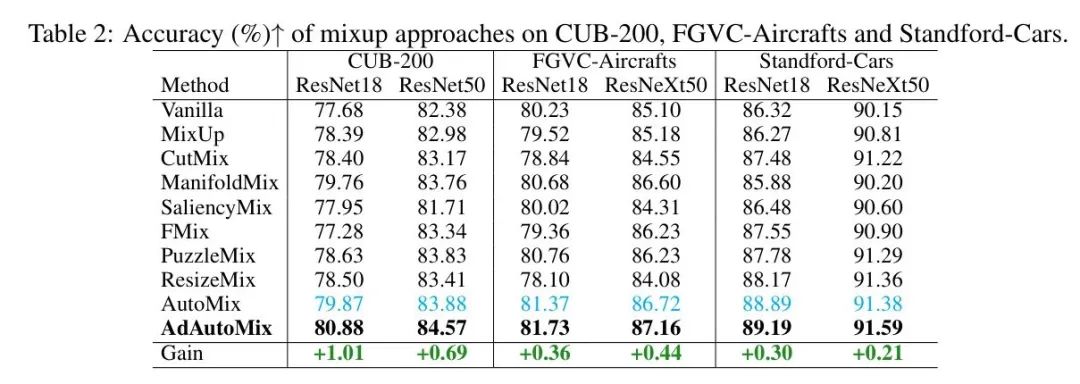

4.1.2 Fine-grained classification

在CUB-200,FGVC-Aircrafts和Standford-Cars上,作者使用SGD优化器进行微调,具有动量0.9,权重衰减0.0005,批量大小16,200个epoch,学习率0.001,由余弦调度器动态调整。

表2的结果表明,AdAutoMix取得了最佳性能,并显著提高了基础(3.20%/2.19%在CUB-200,1.5%/2.06%在Aircraft和2.87%/ 1.44%在Cras)的性能,这意味着AdAutoMix对更具有挑战性的场景也具有鲁棒性。

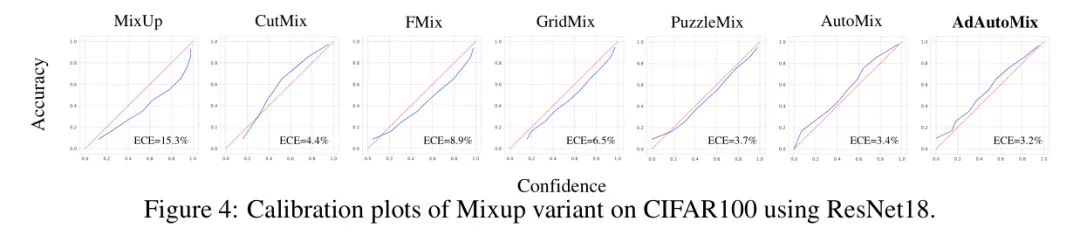

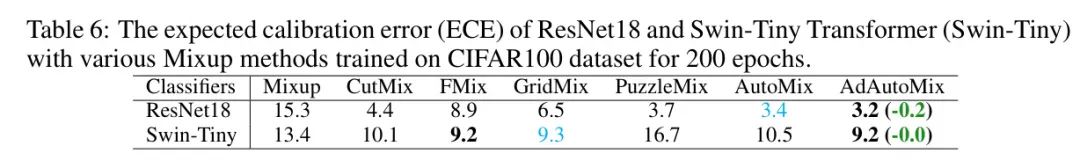

Calibration

DNNs容易在分类任务中变得过于自信。Mixup方法可以有效地缓解这个问题。为此,作者在CIFAR100数据集上计算了各种Mixup方法预期的校准误差(ECE)。

从图4中的实验结果可以看出,作者的方法实现了最低的ECE,即3.2%,与现有方法相比。此外,在附录A.5的表6中提供了更多的实验结果。

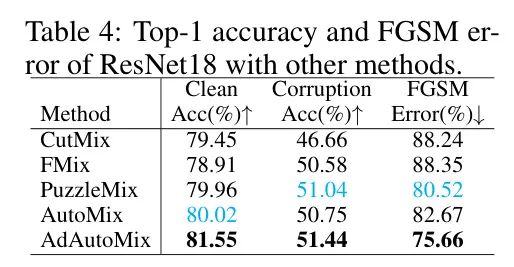

Robustness

作者在CIFAR100-C数据集上进行了实验,以验证对损坏的鲁棒性。作者手动生成了一个包含19种不同损坏类型的数据集(噪音,模糊,雾,亮度等)。作者将AdAutoMix与一些流行的混合算法进行比较:CutMix,FMix,PuzzleMix和AutoMix。

表4显示,作者的方法在干净和损坏的数据上都实现了最高的识别准确性,即与AutoMix相比,分类准确性提高了1.53%和0.40%。作者还进一步研究了对FGSM的白盒攻击的鲁棒性,这是一种8/255 epsilon球攻击。作者的AdAutoMix显著优于现有方法,如表4所示。

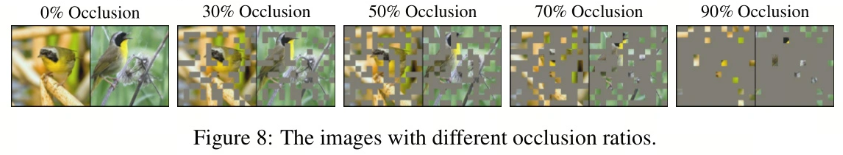

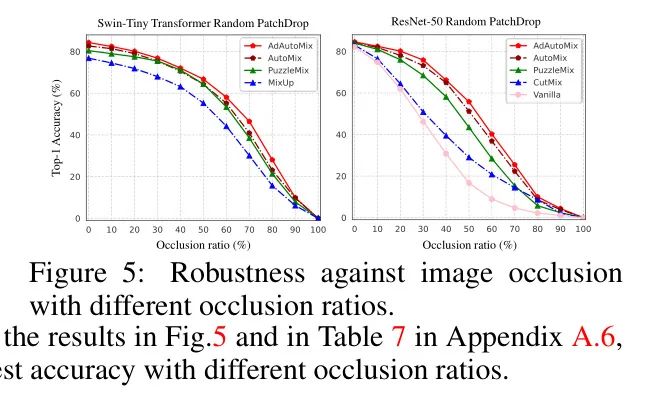

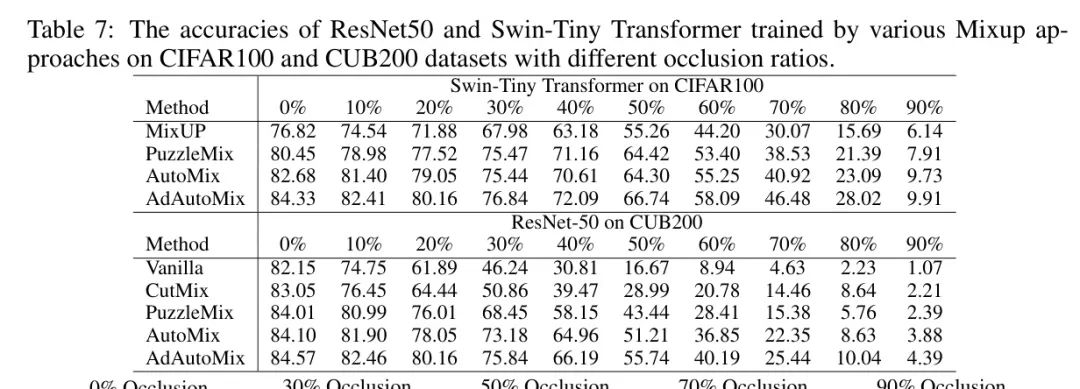

Occlusion Robustness

为了分析AdAutoMix对随机 Mask 的鲁棒性,作者使用CIFAR100和CUB200的数据集,随机 Mask 1616的 Patch ,不同的 Mask 比例(0-100%)。作者将生成的 Mask 图像输入到两个分类器Swin-Tiny Transformer和ResNet-50中,这些分类器由不同的Mixup模型训练,以计算测试准确性。

从图5和附录A.6中的表7的结果,可以观察到,在不同的 Mask 比例下,AdAutoMix实现了最高的准确性。

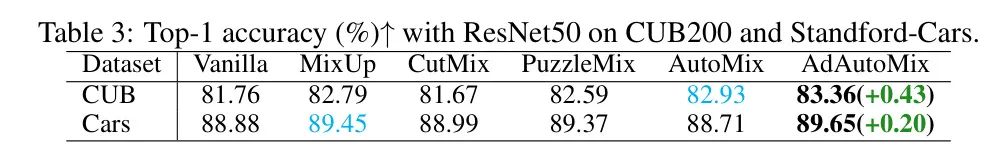

Transfer Learning

作者进一步研究了AdAutoMix学习到的特征在下游分类任务中的可迁移性。4.1.2小节中的实验设置用于在CUB-200和Standford-Cars上进行迁移学习,除了训练100个epoch。在ImageNet-1K上训练的ResNet50用于在CUB-200和Standford-Cars上进行分类。表3显示,AdAutoMix取得了最佳性能,证明了作者的方法在下游任务上的有效性。

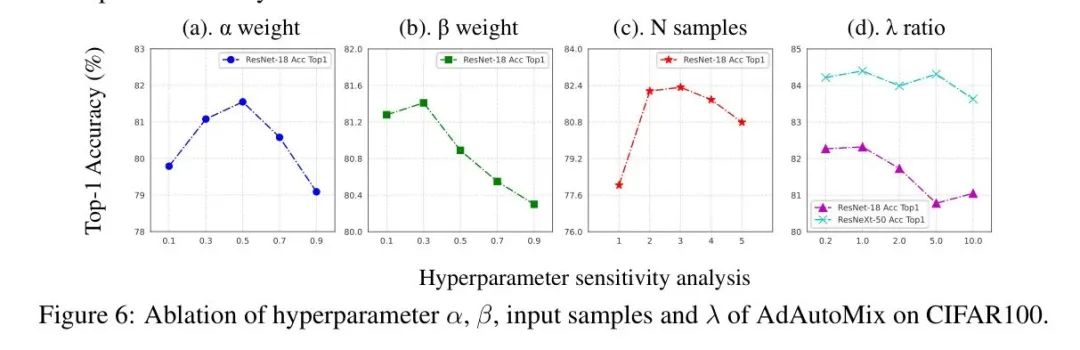

Ablation experiment

在AdAutoMix中,四个超参数,即输入图像数,权重,和混合比例是固定在所有实验中的重要参数,以实现高性能。为了节省时间,作者在作者的AdAutoMixup上训练分类器ResNet18200个epoch。不同,,和的ResNet18的准确性如图6(a),(b),(c)和(d)所示。

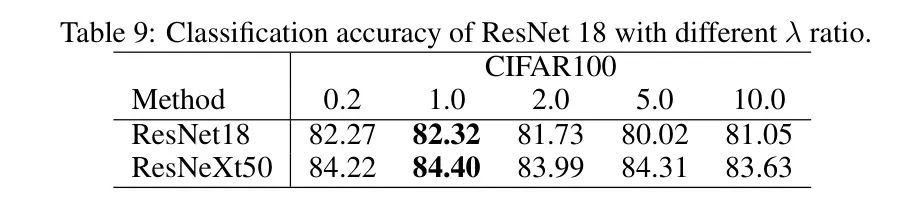

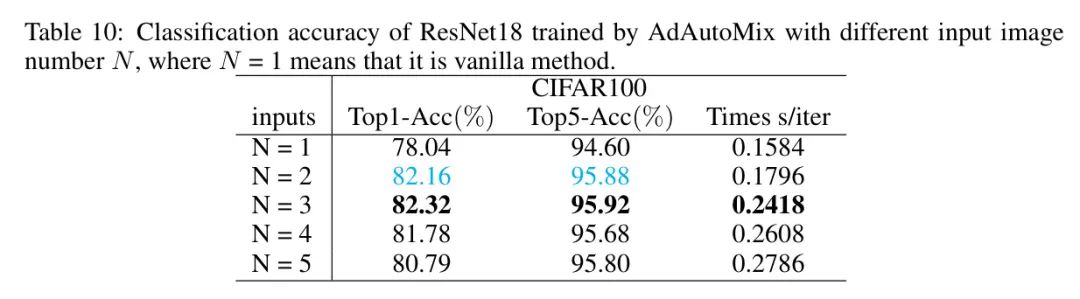

此外,表9和表10中的附录A.8部分显示了不同和的AdAutoMixup的分类准确性。默认情况下,具有=3,=0.5,=0.3和=1的AdAutoMix,在各种数据集上实现最佳性能。

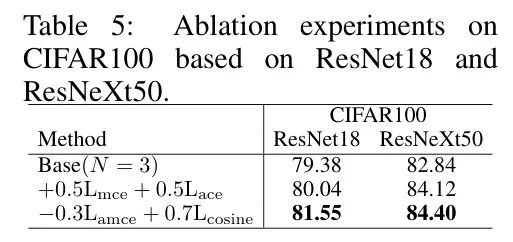

此外,为了提高分类器的鲁棒性,作者采用了两种正则化项,即和,以及另外两种正则化项,即余弦相似度和EMA模型,以避免在AdAutoMix中图像固有意义的崩溃。

因此,作者进行了实验以评估每个模块对分类器性能改进的性能。为了便于描述,作者将AdAutoMix中的四个模块从AdAutoMix中移除,并将其表示为基本AdAutoMix。然后,作者逐步引入两个模块和,以及另外两个模块和,并计算分类准确性。

表5中的实验结果表明,和通过约0.66%提高了分类器准确性。然而,在引入和以约束生成的混合图像后,作者观察到分类准确性显著提高,即1.51%的准确性改进,这意味着这两种模块能够控制生成图像的质量和在对抗训练中。

此外,作者在附录A.8中显示了逐步增加单个正则化项的方法。附录A.8中的实验结果表明,每个正则化项都可以提高准确性。

5 Conclusion

在本文中,作者提出了框架,该框架在对抗方式下同时优化目标分类器和混合图像生成器。具体而言,生成器生成具有挑战性的混合样本以增加分类损失,同时分类器基于这些具有挑战性的样本进行训练以提高泛化能力。此外,生成器可以处理多种样本混合情况。在六个数据集上的实验结果证明了作者的方法的有效性。

Dataset Information

本文使用的图像数据集如下:

- CIFAR-100,包含3232分辨率的50,000个训练图像和10,000个测试图像,共有100个类别。

- Tiny-ImageNet,包含6464分辨率的10,000个训练图像和10,000个验证图像,共有200个类别。

- ImageNet-1K,包含12,811,67个训练图像和50,000个验证图像,共有1000个类别。

- CUB-200-2011,包含11,788个图像,来自200种野鸟物种。

- FGVC-Aircrafts,包含10,000张飞机图像,分为100个类别。

- Standford-Cars,包含8,144张训练图像和8,041张测试图像,分为196个类别。

Experiments Hyperparameters Details

在作者的工作中,特征层设置为3,动量系数从0.999开始,以余弦曲线增加到1。此外,AdAutoMix在所有实验中使用相同的超参数设置,如下所示:=0.5,=0.3,=1.0,=3或=2。

Experiments Implementation Details

在CIFAR100上,作者使用RandomFlip和RandomCrop进行4像素内切的数据增强。对于ResNet18和ResNeXt50,作者使用以下实验设置:SGD优化器具有动量0.9,权重衰减0.0001,批量大小100,训练800个epoch;基本学习率0.1,由余弦调度器动态调整;使用CIFAR版本的ResNet变体,即用3×3卷积和MaxPooling替换7×7卷积和MaxPooling。

为了训练基于ViT的方法,例如Swin-Tiny Transformer,作者将图像缩放到224×224,并使用AdamW优化器具有动量0.05,权重衰减0.05,批量大小100,总训练200个epoch。基本学习率0.0005,由余弦调度器动态调整。对于ConvNeXt-Tiny训练,图像保持32×32的分辨率,除了基本学习率0.002外,其余与基于ViT的方法相同。对于CIFAR上的ResNet18和ResNeXt50,作者设置和为0.5和0.3。

在Tiny-ImageNet上,作者使用RandomFlip和RandomResizedCrop进行64×64的基本数据增强。除了学习率0.2和超过400个epoch的训练外,训练设置与CIFAR100相似。

在ImageNet-1K上,作者采用PyTorch风格的设置:使用SGD优化器训练100个epoch,批量大小为256,基本学习率为0.1,SGD权重衰减为0.0001,SGD动量为0.9。

在CUB-200,FVGC-Aircrafts和Standford-Cars上,作者采用了在ImageNet-1k上预训练的PyTorch官方模型作为初始化。作者使用SGD优化器,具有动量0.9,权重衰减0.0005,批量大小16,200个epoch,学习率0.001,由余弦调度器动态调整。和分别设置为0.5和0.1。

The curves of efficiency against accuracy

各种Mixup数据增强方法与准确性的训练时间如图9所示。AdAutoMix需要更多的计算时间,但它始终在具有不同ResNet架构的不同数据集上的先前最先进的状态上表现出色。

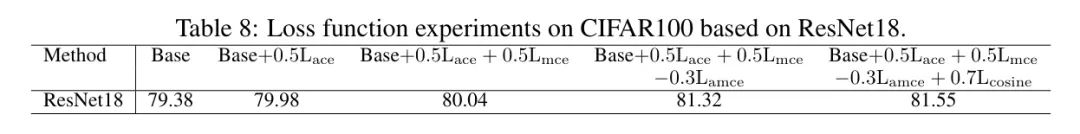

AdAutoMix modules experiment

表8列出了作者的AdAutoMix通过逐渐增加正则化项所获得的准确性。实验结果表明,每个正则化项都能够提高AdAutoMix的鲁棒性。

表9显示了不同下作者的AdAutoMix的准确性。实验结果表明,具有默认=1的AdAutoMix在CIFAR100数据集上实现了最佳性能。

表10显示了不同输入图像数下作者的AdAutoMix的准确性。从表10中,作者可以看到在CIFAR100数据集中,AdAutoMix在=3时实现了最高准确性。

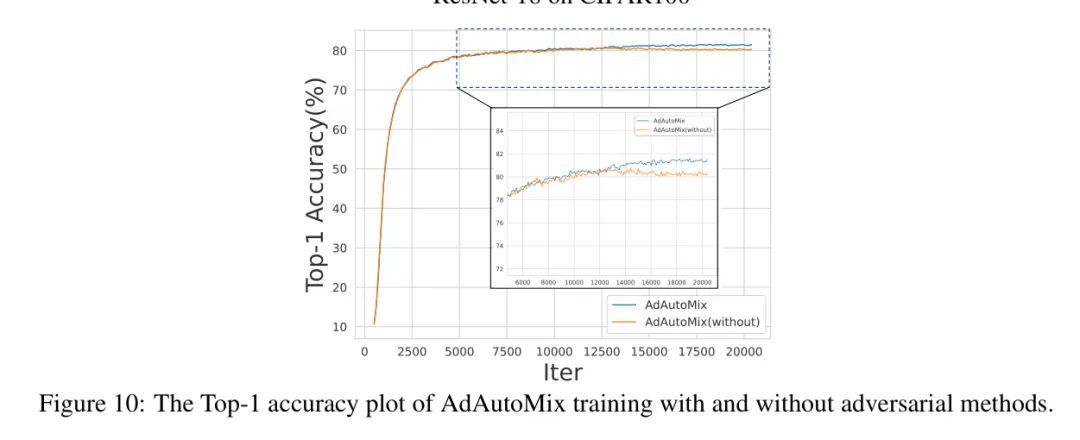

Accuracy of ResNet-18 trained by AdAutoMix with and without adversarial methods.

图10显示了作者的AdAutoMix在CIFAR100数据集上训练ResNet-18时,有和不进行对抗训练的准确性。实验结果表明,具有对抗训练的AdAutoMix在CIFAR100数据集上实现了更高的分类准确性,这表明所提出的对抗框架能够生成更难的样本以提高分类器的鲁棒性。

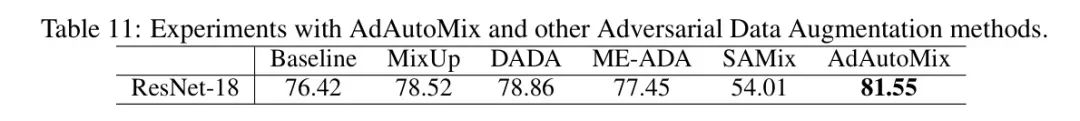

Comparison with other adversarial data augmentation

作者进一步比较了Mixup和作者提出的AdAutoMix与现有的Adversarial Data Augmentation方法,例如DADA,ME-ADA和SAMix。

表11显示了各种方法的分類準確率。表11中的实验结果表明,作者的AdAutoMix超过了现有的Adversarial Data Augmentation方法,并在CIFAR100数据集中获得了最高的分类准确性。

Appendix B Visualization of Mixed Samples

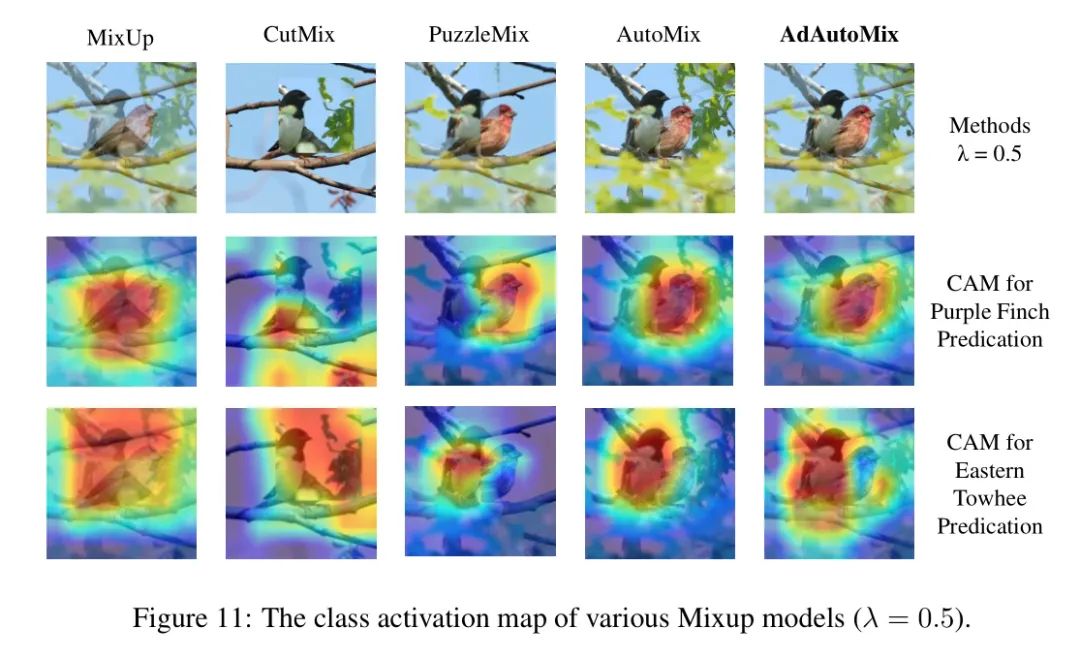

Class activation mapping (CAM) of different mixup samples.

各种Mixup模型的CAM如图11所示。

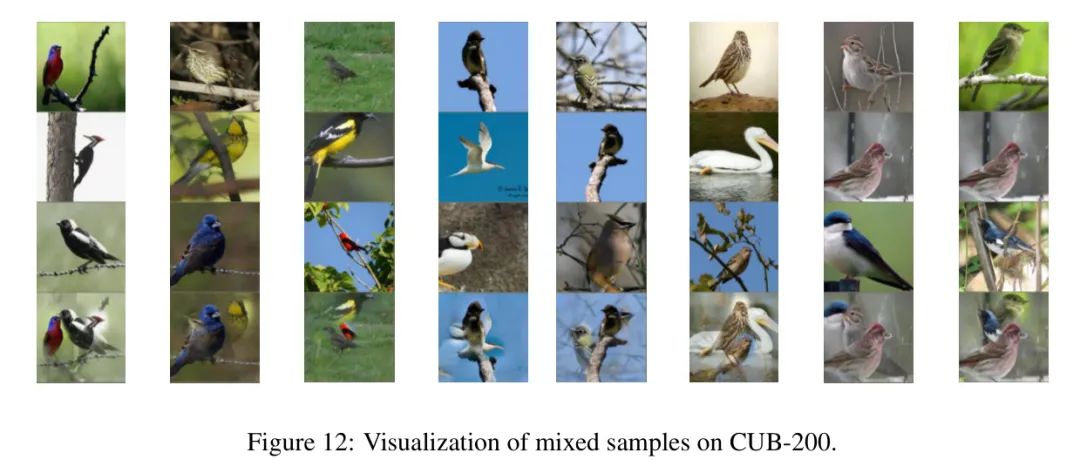

Mixed Samples on CUB-200

由作者的方法在CUB200数据集上训练生成的混合样本如图12所示。

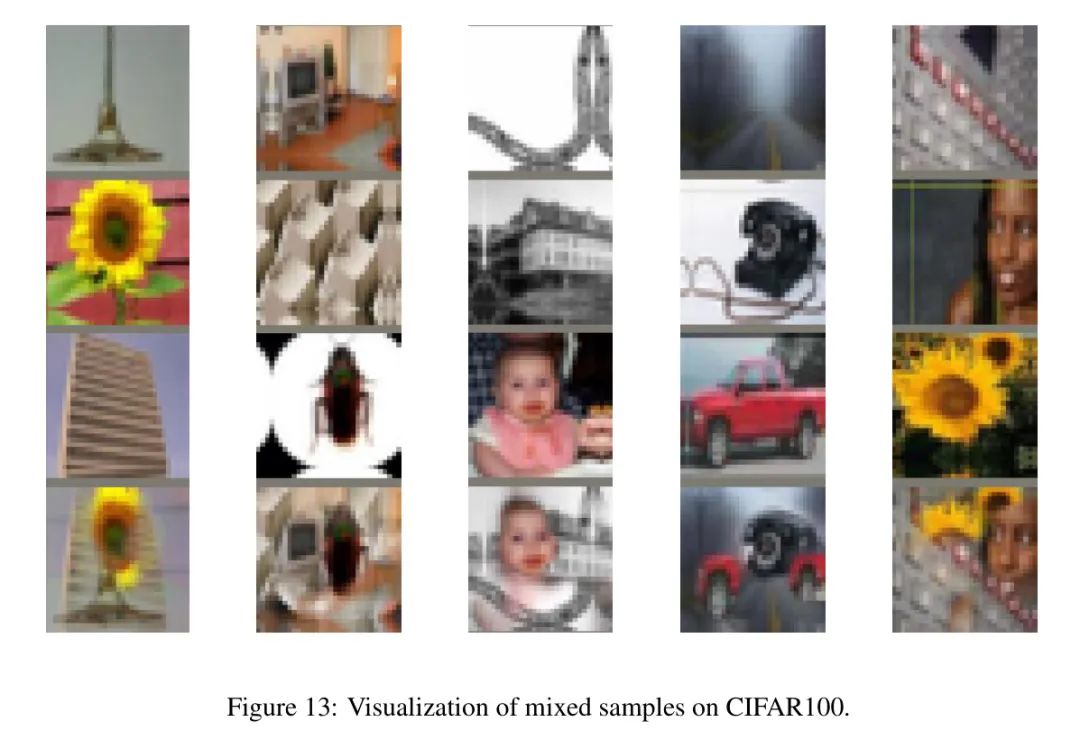

Mixed Samples on CIFAR100

由作者的方法在CIFAR100数据集上训练生成的混合样本如图13所示。

Diversity of samples generated by various approaches

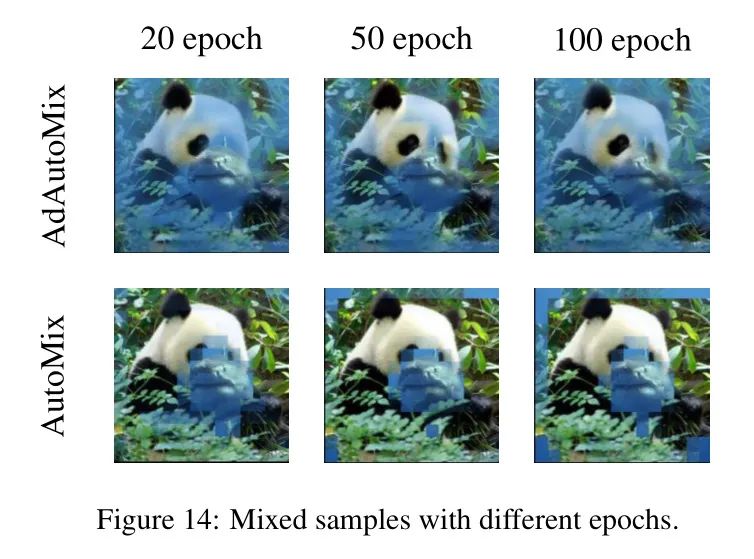

为了证明AdAutoMix能够生成具有多样性的样本,作者在ImageNet-1K上展示了AdAutoMix和AutoMix生成的合成图像。

从图14中,作者可以看到AdAutoMix生成的混合样本具有更多的差异。相比之下,AutoMix在不同的迭代周期生成相似的图像,这意味着提出的AdAutoMix具有通过对抗训练生成多样性图像的能力。

参考

Adversarial AutoMixup

点击上方卡片,关注「AI视界引擎」公众号

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง