2023 年,是机器学习和人工智能发展最为迅速的一年,这里分享 10 篇最值得关注的论文。

当然,这里主要是以大语言模型(LLM)论文为主。选择标准可能也会稍显主观,但还是基于笔者个人特别喜欢或认为有影响力、值得关注的论文。(注:这里的排序顺序是推荐阅读顺序,而不是根据质量或影响力排序)。

作者:SEBASTIAN RASCHKA, PHD原文名称:Ten Noteworthy AI Research Papers of 2023

由公众号「阿法兔研究笔记」编译。

01

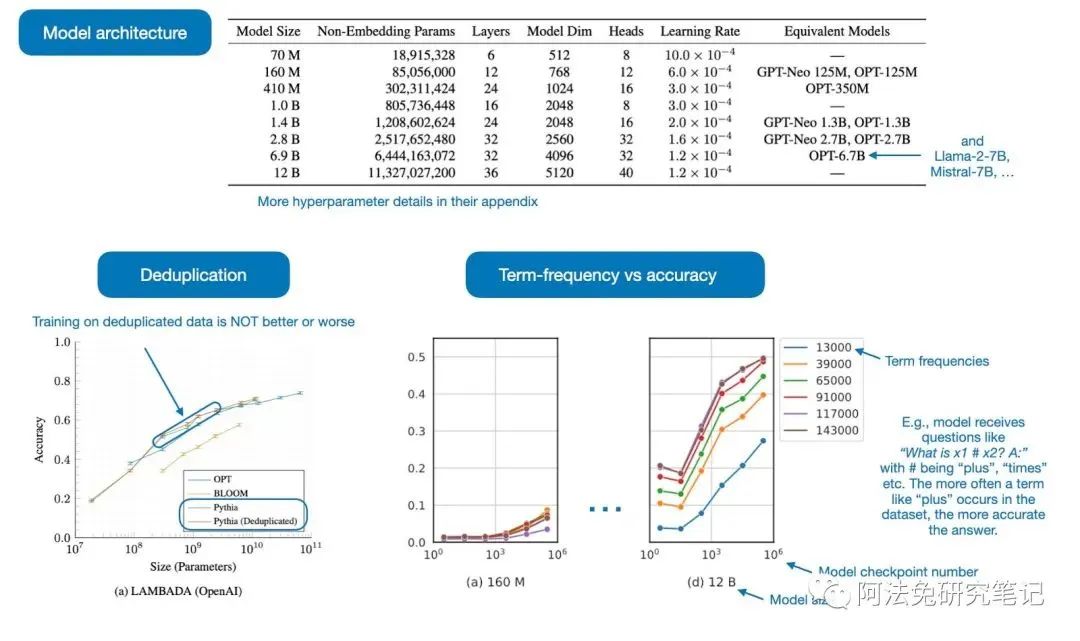

Pythia—Insights from Large-Scale Training Runs

Pythia 的应用:研究人员最初发布了 8 个 LLM,参数范围从 7000 万到 1200 亿(权重和数据均已公开发布,并不多见)。这篇论文最突出的特点是公布了训练细节、分析和见解(其中一些见下图注释)

Pythia 论文中的注释图,https://arxiv.org/abs/2304.01373

下面是 Pythia 论文要解决的一些问题:

-

对重复数据进行预训练 (i.e., training for >1 epoch) 是否会产生影响?事实证明,重复数据不会对性能产生任何影响。

-

训练顺序是否会影响 memorization?事实证明不会。如果可以的话,我们就可以通过调整训练数据的顺序来缓解不理想的 verbatim memorization 问题。

-

预训练术语频率会影响任务表现吗?是的,对于出现频率较高的术语来说,few-shot 的准确率往往较高。

-

Batch size 是否会影响训练效率和模型收敛性?batch size 增加一倍会使训练时间减半,但不会影响收敛性。

时至今日,仅仅过去了六个月,LLMs 的主题已经不能算开创性的成果。不过,之所以收录这篇论文,是因为它不仅试图回答有关训练设置的有趣问题,而且在细节和透明度方面也属于积极范例。此外,<1B range 的小型 LLM 是微型研究的好方法,也是预训练实验的起步。

(这是他们 GitHub 的链接:https://github.com/EleutherAI/pythia)。

希望 2024 年能看到更多这样的研究论文!

02

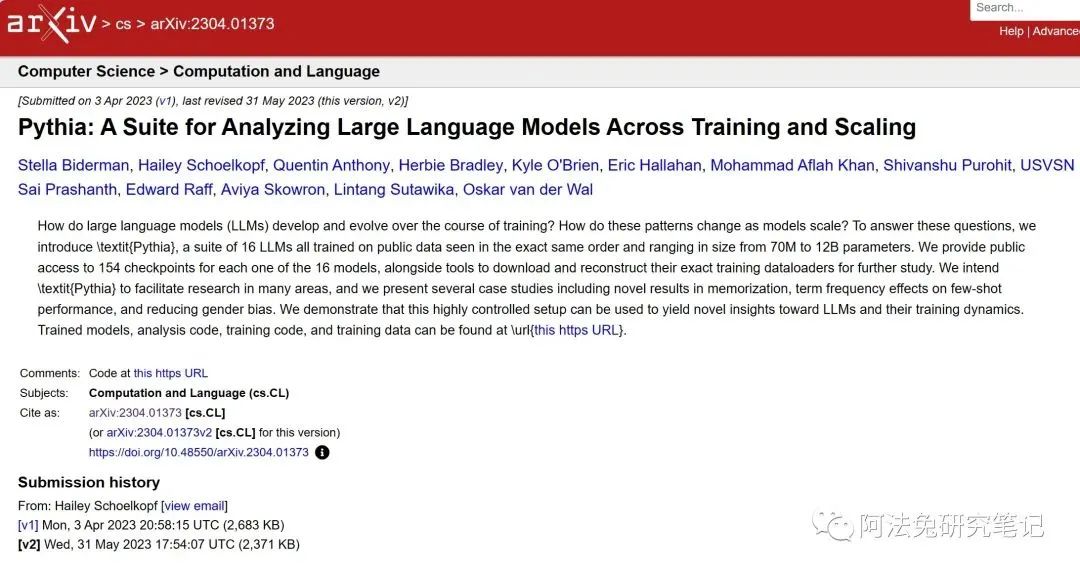

Llama 2: Open Foundation and Fine-Tuned Chat Models

https://arxiv.org/abs/2307.09288

本篇论文,是 Meta 广受欢迎的第一篇 Llama 论文的后续。

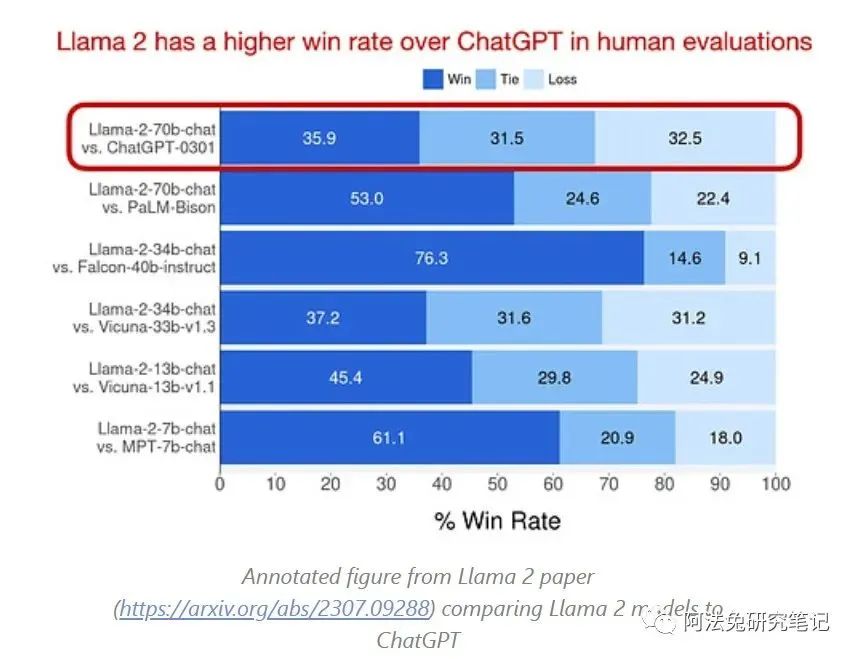

Llama 2 模型的参数从 7B 到 70B 不等,这些模型仍然是能力最强、应用最广泛的公开可用模型之一,这也是这篇论文入选的原因之一。不过值得注意的是 Llama 2 许可证,根据许可证的详细内容,Llama2 还并没有真正完全允许在商业应用中使用。

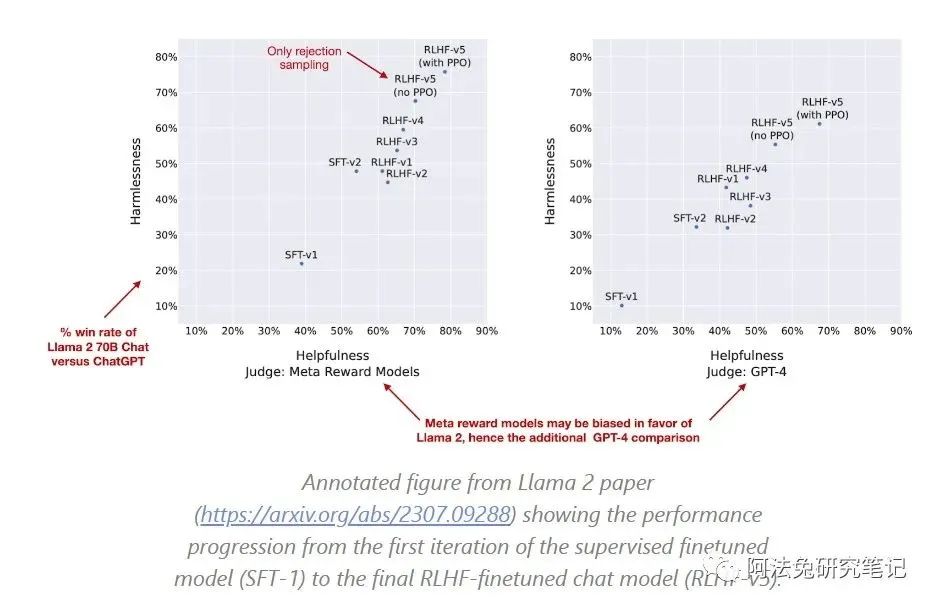

Llama 2 论文(https://arxiv.org/abs/2307.09288)中的注释图,

将 Llama 2 模型与 ChatGPT 进行比较

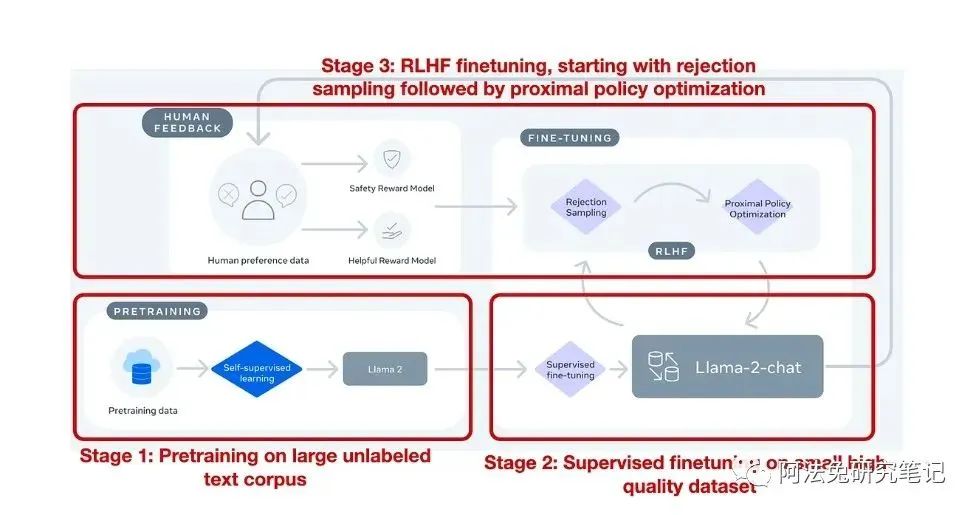

在模型方面,Llama 2 与许多其他 LLM 的不同之处在于,这些模型既有标准的预训练模型,也有 RLHF(用于创建 ChatGPT 的方法)进行 Finetune 的聊天模型,以便遵循与 ChatGPT 类似的人类指令——目前经过 RLHF Finetune1 的模型仍然很少见。

来自 Llama 2 论文(https://arxiv.org/abs/2307.09288)的注释图,总结了指令 Fine-tune 的 RLHF 过程。

除了 Llama 2 被广泛使用并配备了 RLHF 指令调整变体这一事实之外,我决定将这篇论文列入本列表的另一个原因是论文附带的的 77 页深度研究报告。

在这份报告中,作者还很好地说明了 Llama 2 70B Chat 型号的演变过程,追溯了它们从最初的有监督微调(SFT-v1)到最后的带有 PPO 的 RLHF Finetune 阶段(RLHF-v5)的发展历程。如下图所示:

尽管在公开 Benchmark 测试中,Mistral-8x7B(下篇会介绍)、DeepSeek-67B 和 YI-34B 等模型在 Llama-2-70B 模型中名列前茅,但在公开可用的 LLM 和基于它的基础和持续开发这块,Llama 2 仍然是比较流行和常见的选择。

此外,尽管有的 benchmark 表明,确实可能存在更好的模型,但今年面临的一大挑战是 Benchmark 的可信度。例如,我们怎么知道模型没有经过上述 benchmark 的训练,分数也没有被夸大?在传统机器学习中,当有人提出新的 Gradient boosting model 的时候,进行检查相对容易。如今,鉴于训练 LLM 的成本和复杂程度(而且大多数研究人员要么不公开架构,要么不公开训练数据的细节),我们根本无法判断。

总之,尽管其他各大公司都在推出自己专有的大型语言模型(谷歌的 Bard 和 Gemini、亚马逊的 Q、Twitter/X 的 Grok 以及 OpenAI 的 ChatGPT),但 Meta 仍然加倍致力于开源,这令人耳目一新。

03

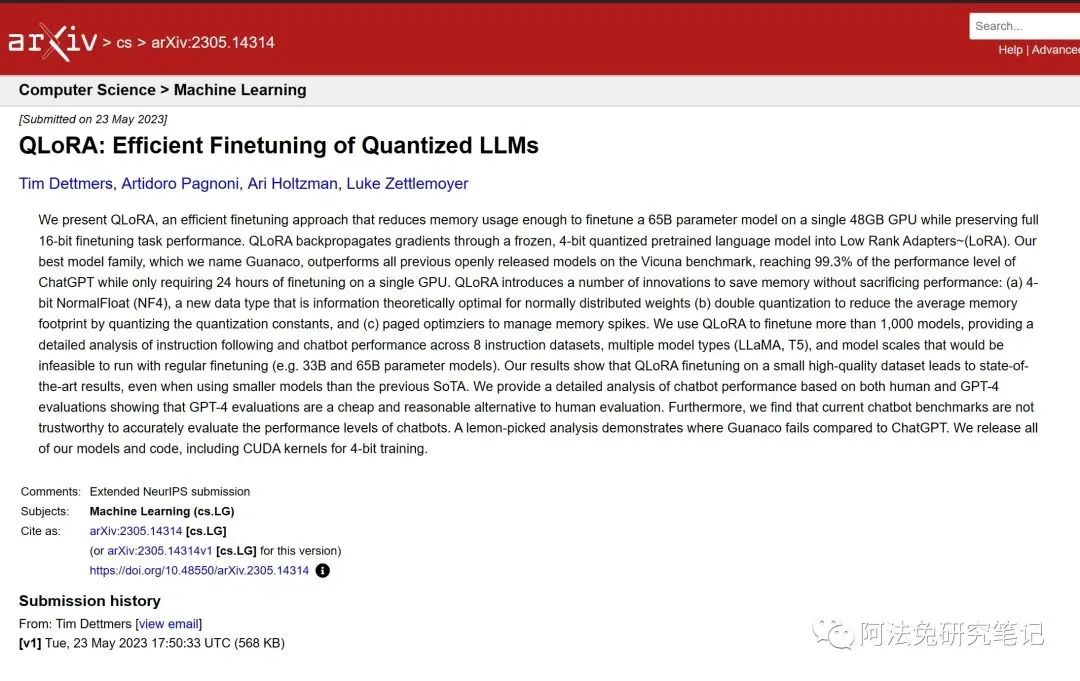

QLoRA: Efficient Finetuning of Quantized LLMs

https://arxiv.org/abs/2305.14314

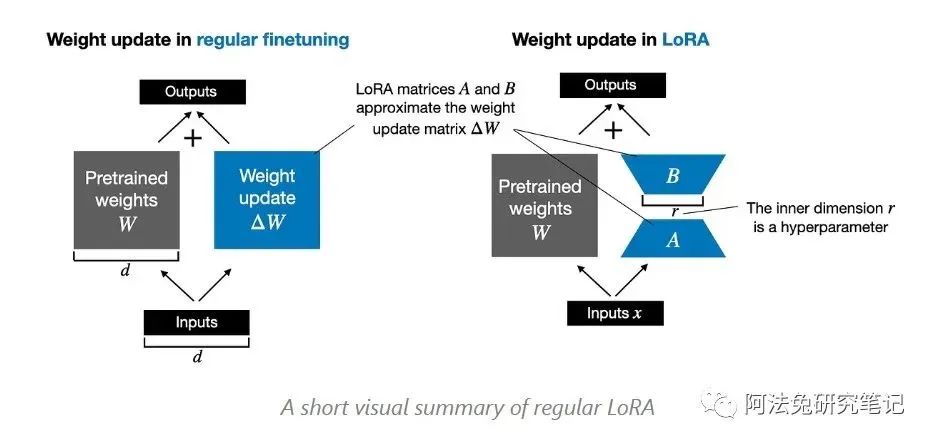

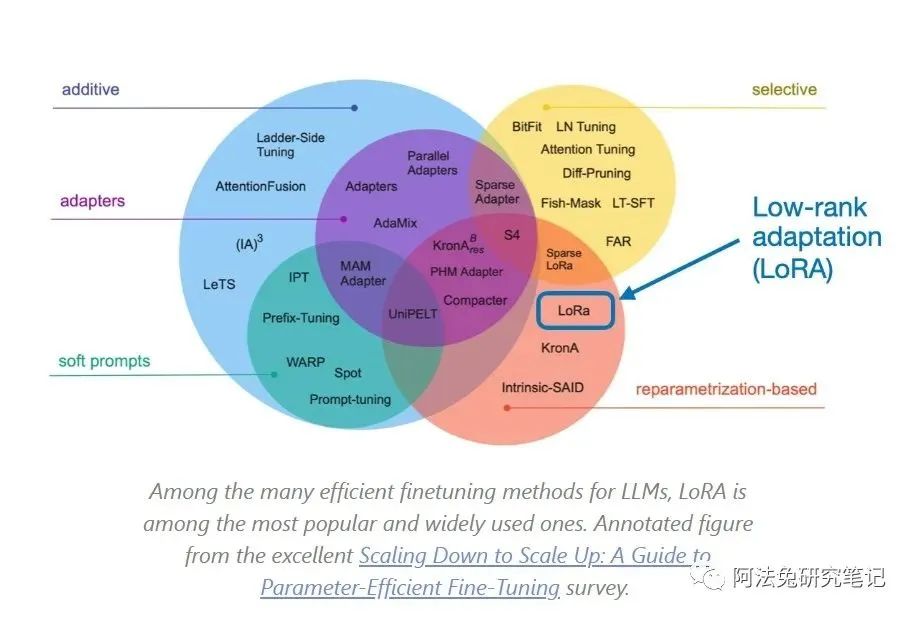

QLoRA:Efficient Finetuning of Quantized LLMs,是今年 LLM 研究和 Finetune 界最受欢迎的技术之一,因为它使已经很流行的 LoRA(low-rank adaptation) 技术变得更节省内存。简而言之,这意味着我们可以将更大的模型安装到更小的 GPU 上。

常规 LoRA 的简短可视化摘要

QLoRA 代表量化 LoRA(low-rank adaptation)。标准 LoRA 方法通过在模型层的权重中添加低秩矩阵来修改预训练的 LLM,这些矩阵较小,因此在 Finetune 过程中需要更新的资源较少。

在 QLoRA 中,这些低秩矩阵被量化,这意味着它们的数值精度降低了。具体做法是将这些矩阵中连续的数值范围映射到一组有限的离散水平上。这一过程减少了模型的内存占用和计算需求,因为对低精度数字的运算对内存的消耗更少。

根据 QLoRA 的论文,QLoRA 可将 65B Llama 模型的内存需求降至适合单个 48 GB GPU(如 A100)。从 65B Llama 的量化 4 位训练中获得的 65B Guanaco 模型保持了完整的 16 位 Finetune 任务性能,仅在 24 小时的 finetune 后就达到了 ChatGPT 性能的 99.3%。

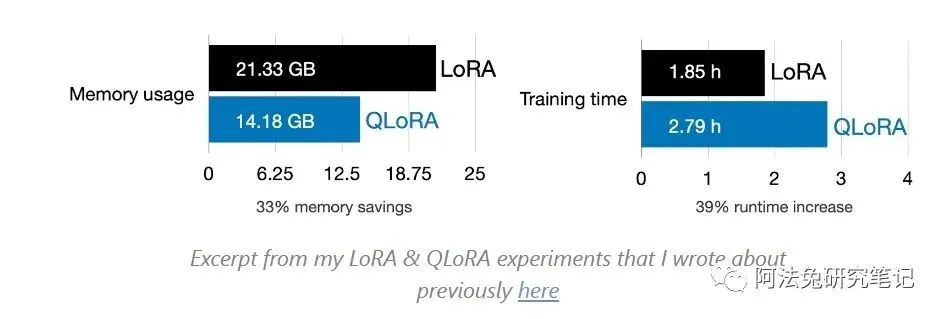

今年,我还进行了许多 QLoRA 实验,发现 QLoRA 是在 finetune 过程中减少 GPU 内存需求的得力工具。不过这也有代价:额外的量化步骤会带来额外的计算开销,这意味着训练会比普通的 LoRA 慢一些。

随着研究人员和从业人员致力于创建定制 LLM,LLM 的 finetune 仍然具有现实意义。笔者很欣赏像 QLoRA 这样的技术,它通过降低 GPU 内存要求的门槛,使这一过程更容易实现。

04

BloombergGPT: A Large Language Model for Finance

https://arxiv.org/abs/2303.17564

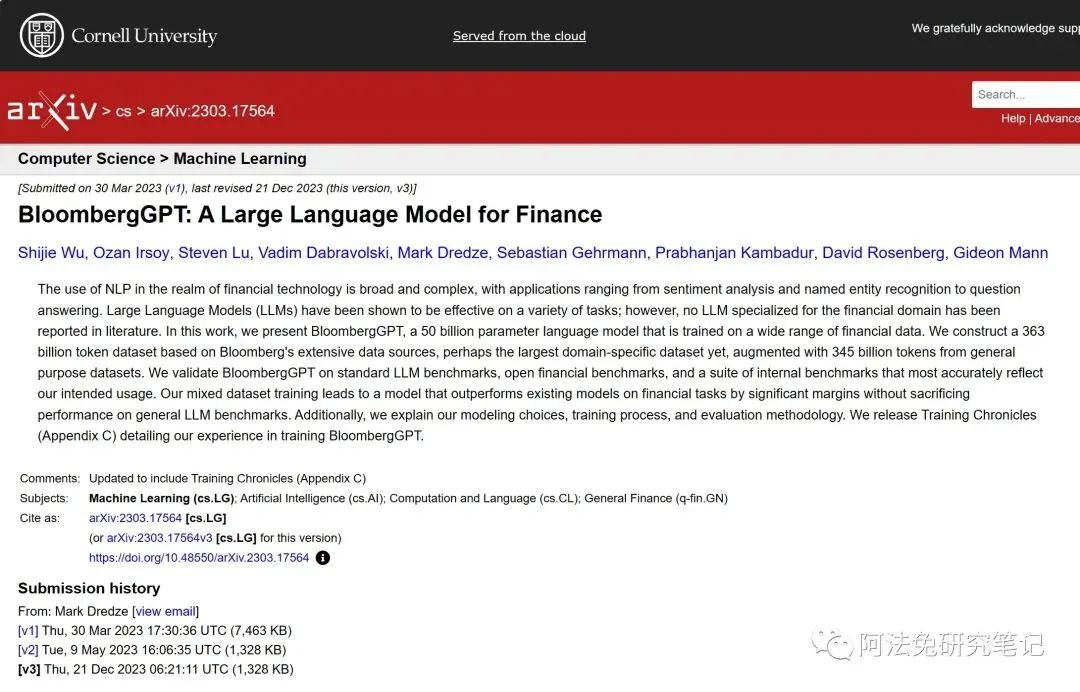

纵观今年的所有论文《BloombergGPT:A Large Language Model for Finance》看起来像是一个奇怪的选择,因为它并没有产生突破性的新见解、新方法或开源模型。

之所以将它列入榜单,是因为这是一个有趣的案例研究,有人在特定领域的数据集上预训练了一个相对较大的 LLM。此外,它的描述也相当详尽,这一点正变得越来越罕见,特别是当论文作者受雇于公司时,因为今年的趋势之一是,各大公司对架构或数据集的细节越来越保密,以便在竞争激烈的环境中保护商业机密(注:笔者并不会因此而就责怪他们)。

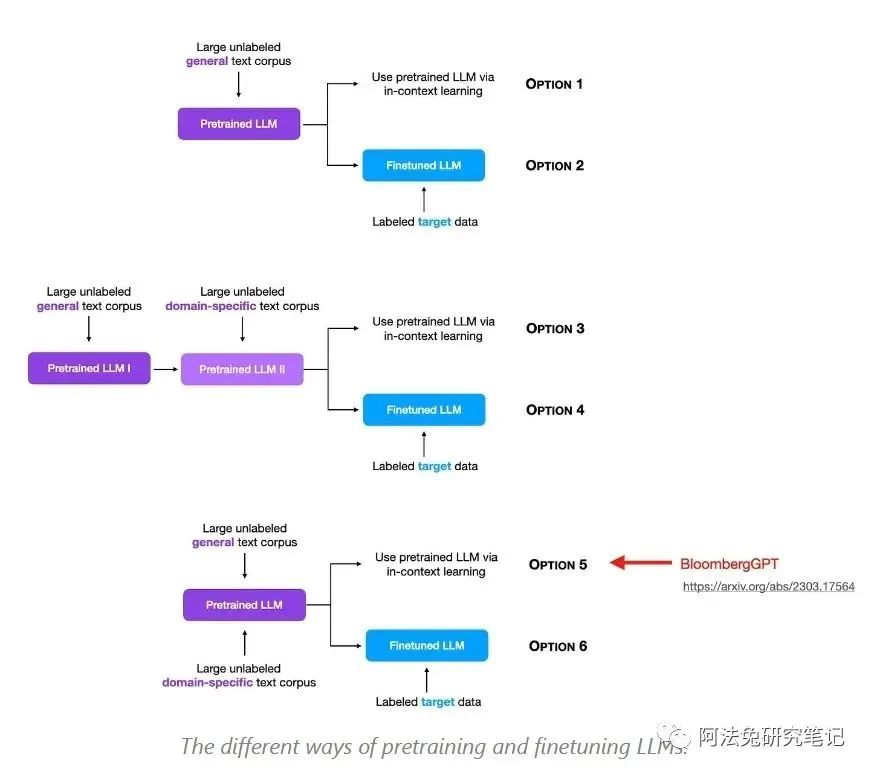

此外,BloombergGPT 还让我想到了在特定领域数据上对模型进行预训练和 Finetune 的各种不同方法,如下图所示。(BloombergGPT 的论文中并未对此进行探讨,但如果今后能对此进行研究,将会非常有趣)

预训练和 Finetune LLM 的不同方法

简而言之,BloombergGPT 是一个 500 亿参数的金融语言模型,它是在 3,630 亿个金融数据和 3,450 亿个一般公开数据集上训练出来的。相比之下,GPT-3 要大 3.5 倍(1750 亿个参数),但训练的 token 数量要少 1.4 倍(4990 亿个) 。

既然 GPT-3 是 3.5 倍的规模,为什么作者要使用 “只有 “500 亿个参数的架构呢?这个问题比较容易回答。他们采用了 Chinchilla scaling laws,考虑到现有的金融数据规模,认为这是一个不错的规模。

是否值得在组合数据集上从头开始(预)训练 LLM?根据论文,该模型在目标领域的表现非常出色。但是,我们不知道它是否比:

a) 在特定领域数据上进一步预训练预训练模型或

b) 在特定领域数据上 Finetune预训练模型更好。

尽管有上述小问题,但总的来说,这是一篇有趣的论文,为特定领域的 LLM 提供了一个有趣的案例研究和范例;此外,它还为进一步研究预训练 Finetune 向 LLM 灌输知识留下了空间。

(附注:对于那些对 Finetune 比较感兴趣的人来说,正如 Rohan Paul 与我分享的那样,”小 “AdaptLLM-7B 模型在一个数据集上的表现优于 BloombergGPT,在其他三个金融数据集上的表现也几乎与 BloombergGPT 相当。虽然 BloombergGPT 总体上似乎略胜一筹,但值得注意的是,AdaptLLM-7B 的训练成本约为 100 美元,而 BloombergGPT 的投资则高达数百万美元。)

05

Direct Preference Optimization: Your Language Model is Secretly a Reward Model

https://arxiv.org/abs/2305.18290

在讨论这篇论文之前,让我们先回过头来讨论一下它试图取代 Reinforcement Learning from Human Feedback,RLHF)。RLHF 是 ChatGPT 和 Llama 2 Chat 模型背后的主要技术。在 RLHF 中,使用了一个多步骤程序:

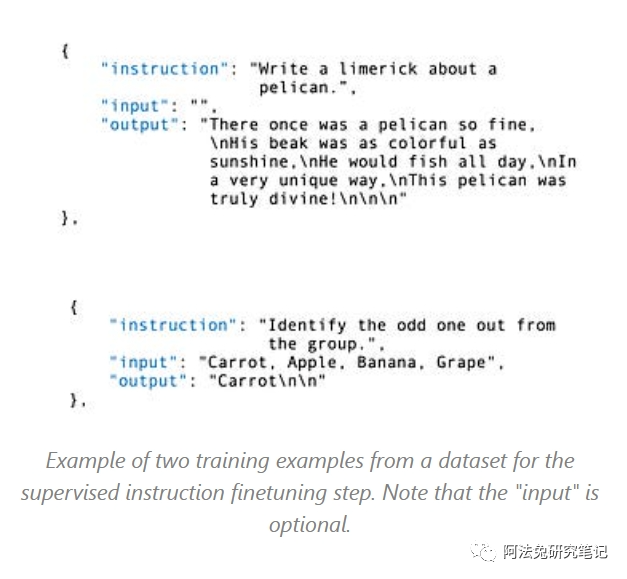

1. 监督 Finetune:首先在包含指令和期望回复的数据集上对模型进行训练。

2. 奖励建模:人类评分员对模型的输出提供反馈。这种反馈被用来创建奖励模型,该模型通过学习来预测哪些类型的输出会受到青睐。

3. 近端策略优化(PPO):模型生成输出,奖励模型对每个输出进行评分。PPO 算法使用这些分数来调整模型的策略,使其趋向于 生成更高质量的输出。(一种强化学习算法,用于对模型的策略进行 Finetune)

示例:用于监督指令微调步骤的数据集中的两个训练示例。请注意,”输入 “是可选的。

正如我们在 ChatGPT 和 Llama 2 中看到的那样,虽然 RLHF 既流行又有效,但它的实现也相当复杂和棘手。

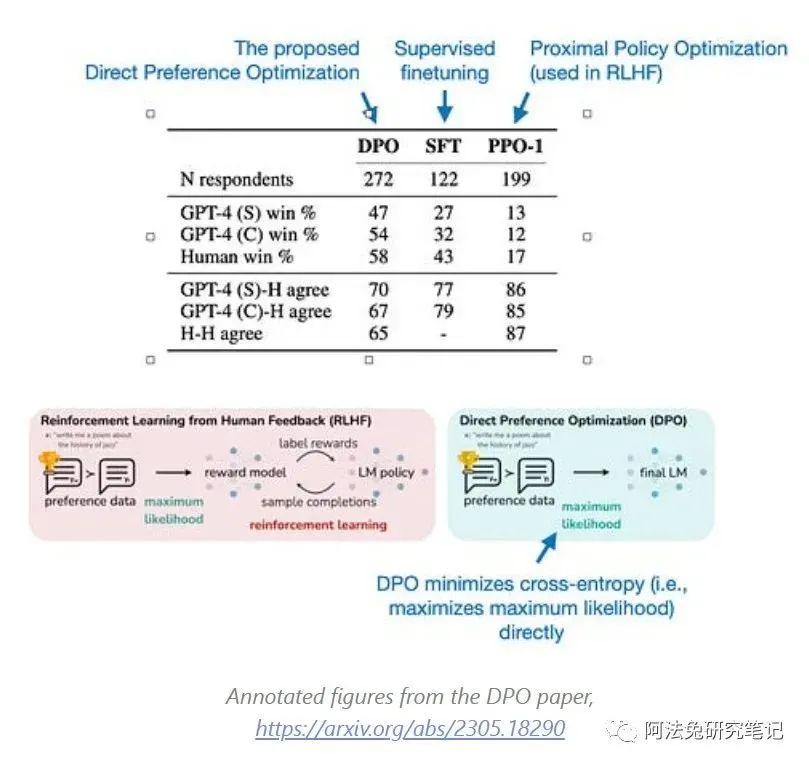

直接偏好优化(Direct Preference Optimization,DPO)论文介绍了一种算法,它可以优化语言模型,使之符合人类偏好,而无需明确的奖励建模或强化学习。相反,DPO 使用了一个简单的分类目标。

DPO 论文中的注释图,https://arxiv.org/abs/2305.18290

在 DPO 中,我们仍然保留了有监督的微调步骤(上述步骤 1),但我们用一个步骤取代了步骤 2 和步骤 3,以便在偏好数据上进一步 Finetune 模型。换句话说,DPO 完全跳过了 RLHF 所要求的奖励模型创建,从而大大简化了 Finetune 过程。

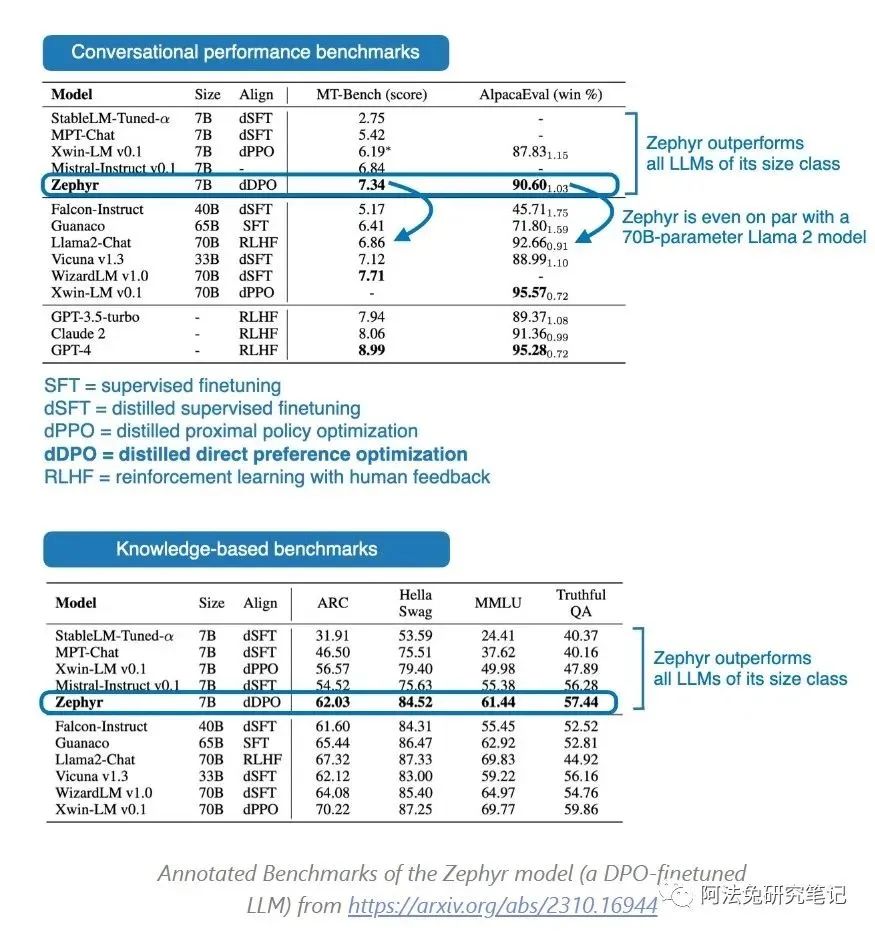

效果如何?直到最近,使用 DPO 训练的模型还不多。(This makes sense because DPO is also a relatively recent method.) However, one recent example is the Zephyr 7B model described in Zephyr: Direct Distillation of LM Alignment. Zephyr-7B is based on a Mistral-7B base LLM that has been finetuned using DPO)

正如下面的性能表所示,7B 参数的 Zephyr 型号在发布时的性能超过了同尺寸级别中的所有其他型号。更令人印象深刻的是,在会话 MT-Bench 基准测试中,Zephyr-7B 甚至超过了比它大 10 倍、参数为 70B 的 Llama 2 Chat Model。

(https://arxiv.org/abs/2310.16944)

总之,DPO 论文的魅力在于其方法的简单性。使用 RLHF 训练的 Chat 模型很少,Llama 2 是个明显的例外,这可能是由于 RLHF 方法的复杂性造成的。有鉴于此,我认为来年采用 DPO 模型的情况会越来越多。

06

Mistral 7B

尽管 Mistral 7B 论文有些简短,但它提出的模式很有影响力:

决定将这篇论文列入这份名单,是因为 Mistral 7B 模型不仅在发布时非常受欢迎,而且还作为基础模型,促进了其他两个知名模型的进步:Zephyr 7B 与最新的 Mistral Mixture of Experts (MoE)。而这些是我预见的 2024 年上半年小型 LLM 趋势的良好范例。

在讨论 Zephyr 7B 和 Mistral MoE 模型之前,先简单谈谈 Mistral 7B 本身:

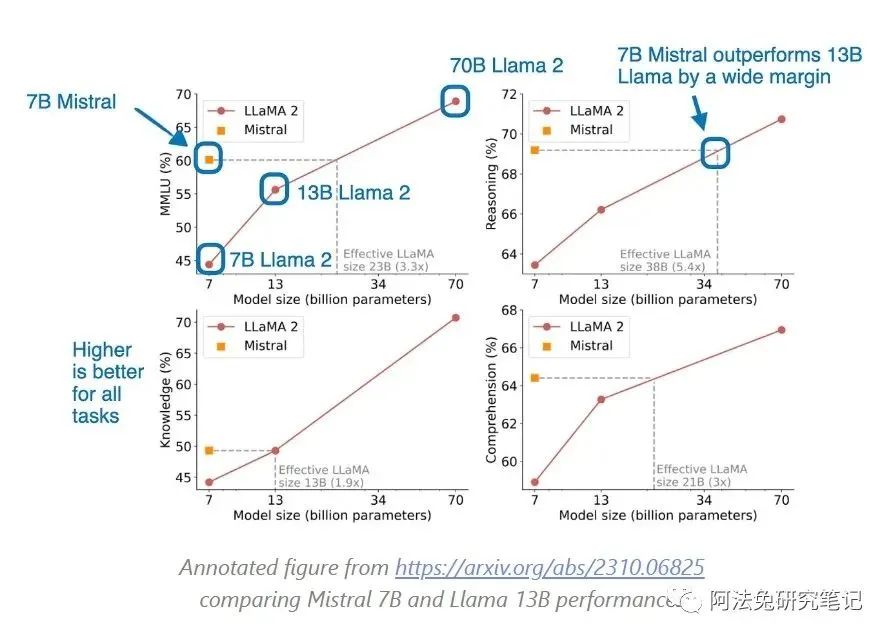

简而言之,Mistral 7B 论文介绍了一个紧凑但功能强大的语言模型,尽管它的规模相对较小,只有 70 亿个 Token,但在各种 benchmark 测试中,它的表现却优于更大的同类模型,比如它的表现超过了 13B Llama 2 模型。(除了比其大两倍的 Qwen 14B 之外,Mistral 7B 也是今年 NeurIPS LLM Finetuning & Efficiency 挑战赛获胜方案中使用的 base mode)

来自 https://arxiv.org/abs/2310.06825 的注释图,Mistral 7B 和 Llama 13B 的性能比较

Mistral 7B 的性能为什么如此之好的原因尚不清楚,但很可能是和它的训练数据有关。Llama 2 和 Mistral 都没有公布训练数据,因此我们只能推测。

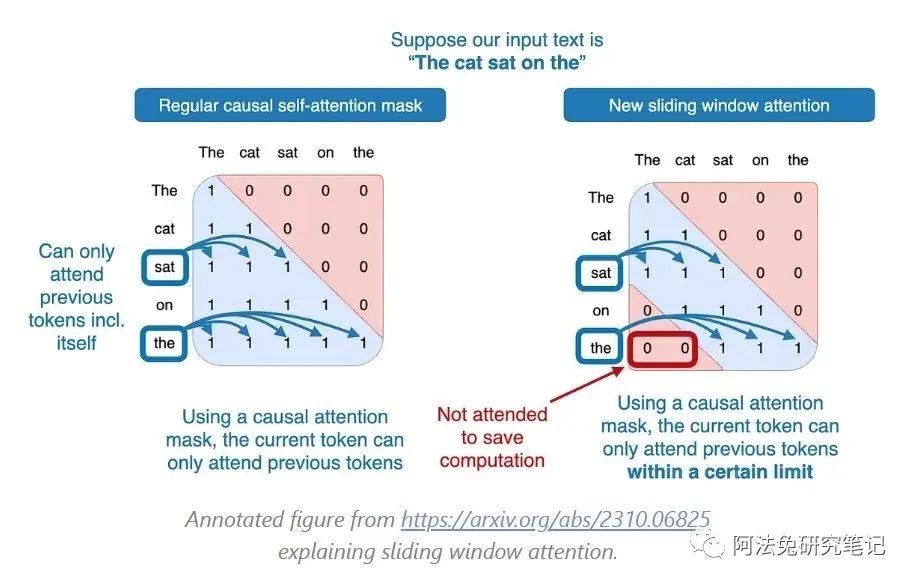

从架构上来看,Mistral 7B 与 Llama 2 共享了 group-query attention,虽然与 Llama 2 非常相似,但 Mistral 架构中的一个有趣的补充是 sliding window attention,用以节约内存并提高计算吞吐量,从而加快训练速度。(Sliding window attention was previously proposed in Child et al. 2019 and Beltagy et al. 2020)

Mistral 中使用的 The sliding window attention mechanism,本质上是一个固定大小的注意力块 ( fixed-sized attention block),它只允许当前标记关注特定数量的前一个 Token((instead of all previous tokens)

如下图所示:

在 7B Mistral 的具体案例中,the attention block size 是 4096 个 Token,研究人员训练模型时使用了多达 100,000 个 Token 的 context size。举一个具体的例子,在常规的自注意力机制中,处于第 50,000 个 Token 的模型可以关注之前的所有 49,999 个 token。而在 sliding window self-attention 机制中,Mistral 模型只能关注从 45,904 至 50,000 的 Token(因为 50,000 – 4,096 = 45,904)

然而,sliding window self-attention 主要用于提高计算性能。而 Mistral 性能优于更大的 Llama 2 模型,很可能不单单是因为 sliding window self-attention。

Zephyr 和 Mixtral

Mixtral Mistral 7B 之所以是有影响力的模型,原因在于它可以作为 Zephyr 7B 的 base model,正如之前在 DPO 部分提到的。Zephyr 7B 是第一个使用 DPO 训练并超越其他替代模型的流行模型,可能为 DPO 成为未来几个月内调整聊天模型的首选方法,铺平了道路。

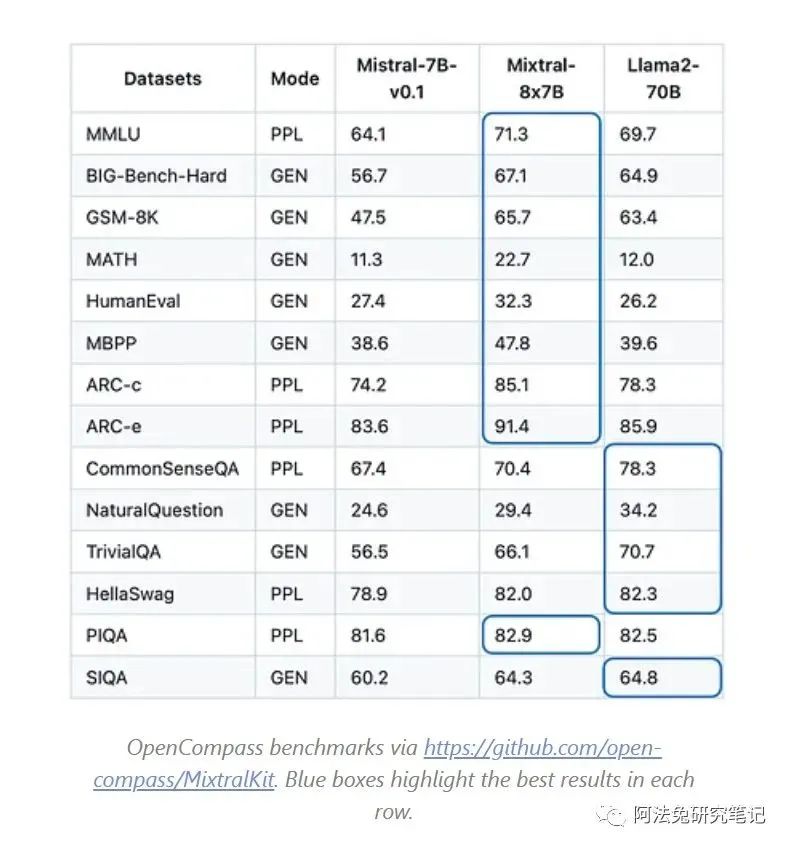

另一个从 Mistral 7B 衍生出的值得注意的模型是最近发布的 Mistral Mixture of Experts (MoE) model,也称为 Mixtral-8x7B。这个模型在几个 Public benchmarks 中匹敌或超过了更大的 Llama-2-70B 模型的性能。

有关更多 Benchmark 测试,请参阅 Mixtral 的官方博客文章公告。Mixtra 团队还发布了经 DPO 调整后的 Mixtral-8x7B-Instruct 模型(但截至目前,尚无与 Llama-2-70-Chat 进行比较的基准测试数据,后者是经过 RLHF 调整的模型)。

也有传闻认为,GPT-4 是由 16 个 submodule 组成的 MoE。据说这 16 个 submodule 中的每一个都拥有 1110 亿个参数((for reference, GPT-3 has 175 billion parameters)。不知道 MoE 是否能在 2024 年将开源模型提升到新的高度,看起来 Mixtral 已经提前开始了这一趋势,相信这只是个开始。

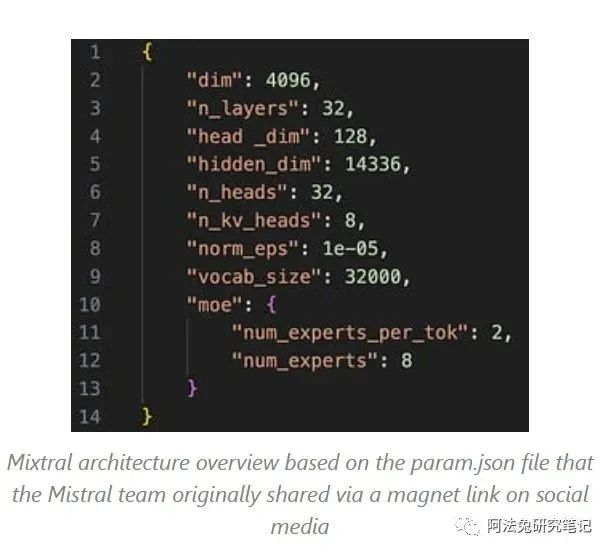

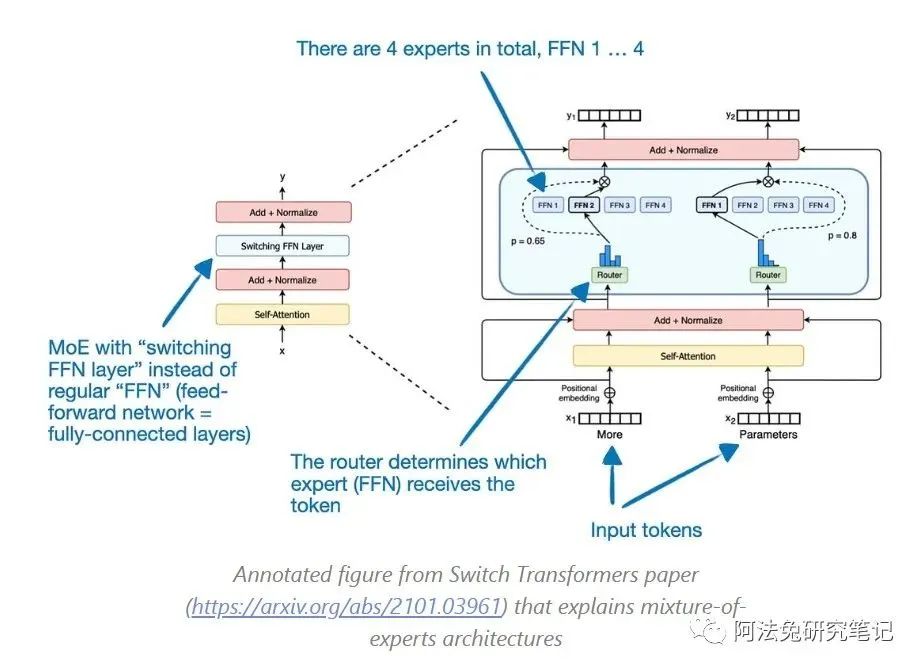

Mixture of Experts 101

如果你对 MOE 还比较陌生,可以参考下面的解释:

上面的图表展示了 Switch Transformer 的架构,该架构对每个 Token 使用 1 个 Expert,总共有 4 个 Expert。另一方面,Mixtral-8x-7B 由 8 个 Expert 组成,每个 Token 对应 2 个 Expert。

为什么选择 MoE?

结合起来,像 Mixtral 这样的 7B 模型中的 8 个 Expert,总共有约 56B 个参数。实际上,它少于 56B,因为 MoE 方法仅应用于 FFN (feed forward network, aka fully-connected),而不是 self-attention weight matrices。因此,它可能更接近 40-50B 个参数。请注意,Router 会 rerouteToken,这样在前向传播过程中一次只使用<14B 个参数(2x <7B,而不是全部<56B),因此与传统的非 MoE 方法相比,训练(尤其是 inference)将会更快。

如果想要了解更多关于 MOE 的内容,这里有一个 Sophia Yang 推荐的阅读清单:

-

The Sparsely-Gated Mixture-of-Experts Layer (2017)

-

GShard: Scaling Giant Models with Conditional Computation and Automatic Sharding (2020)

-

MegaBlocks: Efficient Sparse Training with Mixture-of-Experts (2022)

-

Mixture-of-Experts Meets Instruction Tuning (2023)

此外,如果读者对尝试 MoE 和 LLM 感兴趣,也可以查看 OpenMoE 的 repository,在今年早些时候实现并分享了 MoE LLM。

地址:https://github.com/XueFuzhao/OpenMoE

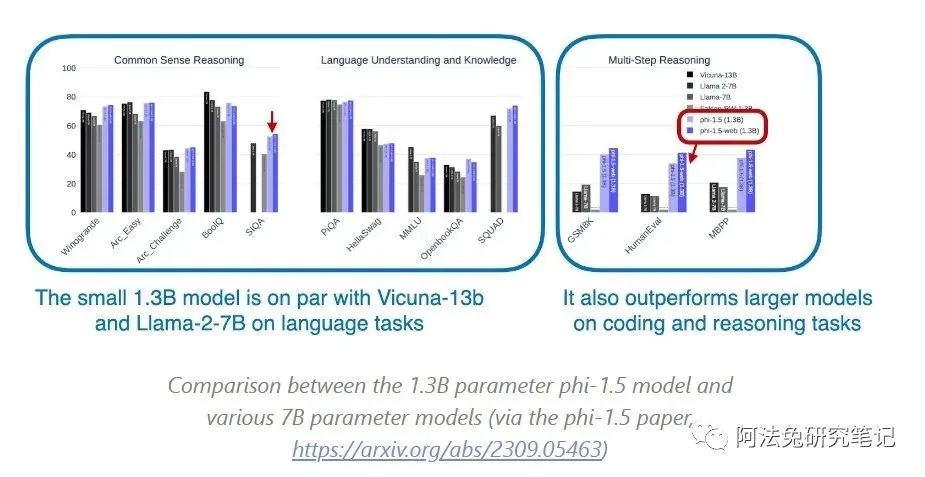

其他小型但有竞争力的 LLM Mistral 7B、Zephyr 7B 和 Mixtral-8x7B 是 2023 年小型但功能强大的模型取得进展的优秀例子,这些模型具有公开可用的权重。另一个值得注意的模型,也是我最喜欢的论文列表中其中一个是微软的 phi 系列。phi 的优势在于训练高质量数据,这些数据是通过过滤网络数据获得的。phi 模型在 2023 年分阶段发布,包括 phi-1(1.3B parameters)、phi-1.5(1.3B parameters))和 phi-2(2.7B parameters)。phi-2 两周前刚刚发布,有说法已经与 Mistral 7B 匹敌甚至超过,尽管它的大小只有一半。

(via the phi-1.5 paper,https://arxiv.org/abs/2309.05463)

更多关于 phi models 的资料:

-

Textbooks Are All You Need– the phi-1 paper

-

Textbooks Are All You Need II: phi-1.5 Technical Report

-

The Phi-2: The Surprising Power of Small Language Models announcement

07

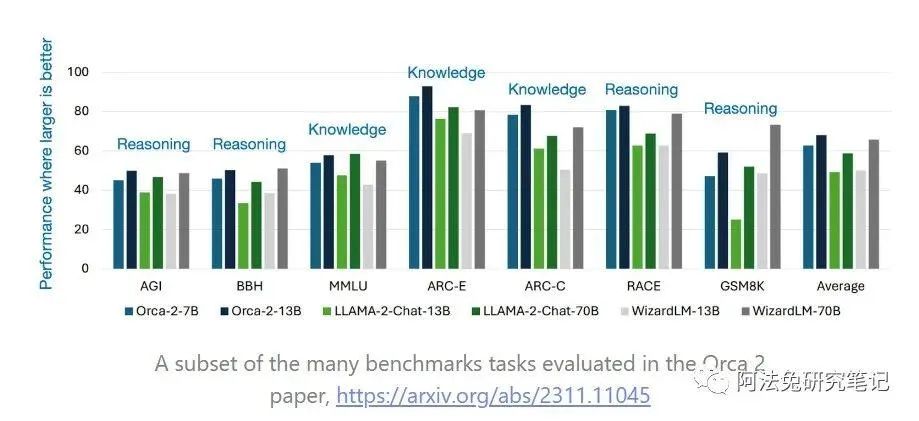

Orca 2: Teaching Small Language Models How to Reason

这是一篇相对较新的论文,因此时间会证明它是否会在未来数月或数年内对我们如何训练 LLM 产生持久的影响。

收录这篇论文的原因在于:它融合了多个概念和观点:

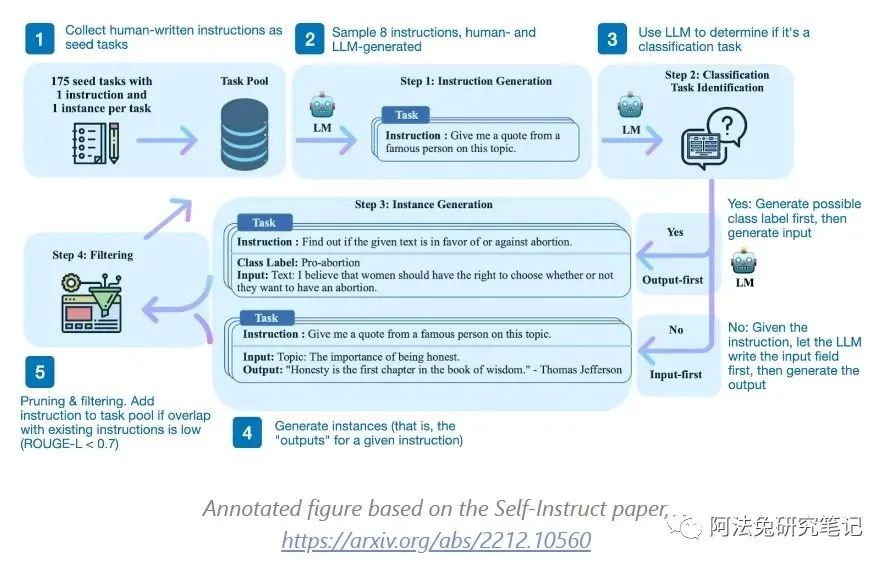

其一,从 GPT-4 等大型、功能强大的模型中提炼数据,创建一个合成数据集来训练小型但功能强大的 LLM。这一想法在去年发表的《Self-Instruct》论文中有所描述。今年早些时候,Alpaca(根据 ChatGPT 输出 Finetune 的 Llama 模型)真正推广了这种方法。

它是如何工作的?简而言之,主要分为 4 个步骤:

-

用一组人类编写的指令(本例中为 175 条)和示例指令建立任务池;(Seed task pool with a set of human-written instructions (175 in this case) and sample instructions;)

-

使用预训练 LLM(如 GPT-3)确定任务类别;(Use a pretrained LLM (like GPT-3) to determine the task category)

-

给定新指令,让经过预训练的 LLM 生成响应(Given the new instruction, let a pretrained LLM generate the response)

-

收集、修剪和过滤回复,然后将其添加到任务池中(Collect, prune, and filter the responses before adding them to the task pool)

注释图基于 Self-Instruct 论文,https://arxiv.org/abs/2212.10560

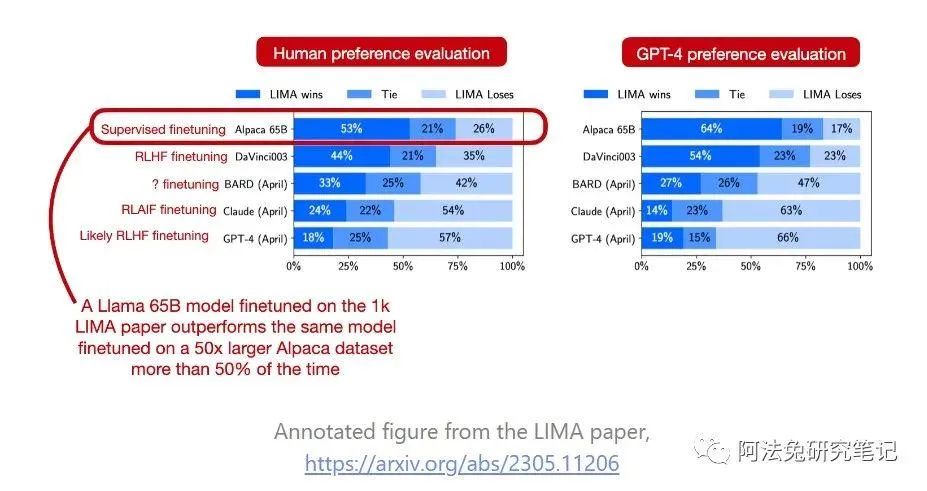

另一个思路可能并不出人意料,但值得强调:高质量的数据对于 finetuning 非常重要。例如,LIMA 论文 (https://arxiv.org/abs/2305.11206) 提出了一个由人类生成的高质量数据集,该数据集仅包含 1k 个训练示例,可用于微调,其效果优于在 50k ChatGPT 生成的回复上进行 finetuning 的同一模型。

LIMA 论文中的注释图,https://arxiv.org/abs/2305.11206

与以往严重依赖模仿学习来复制大型模型输出结果的研究不同,Orca 2 的目标是向 “小型”(即 7B 和 13B)LLM 传授各种推理技巧(如逐步推理、先召回再生成等),并帮助它们为每项任务确定最有效的策略。通过这种方法,Orca 2 的表现明显优于类似大小的模型,甚至可以与 5-10 倍大的模型相媲美。

虽然还没有看到这方面的广泛研究,但 Orca 2 方法或许还能解决《the The False Promise of Imitating Proprietary LLMs》论文中强调的使用合成数据的问题。在这篇论文中,研究人员使用 Alpaca 和 Self-Instruct 等实例,研究了如何对较弱的语言模型进行微调,以模仿 ChatGPT 等较强的专有模型。最初,模仿模型显示出了可喜的成果,与 ChatGPT 相比,它们在遵循指令方面表现良好,并从人群工作者那里获得了有竞争力的评分。然而,更多的后续评估显示,这些模仿模型似乎只在人类观察者面前表现良好,但却经常产生与事实不符的回答。

08

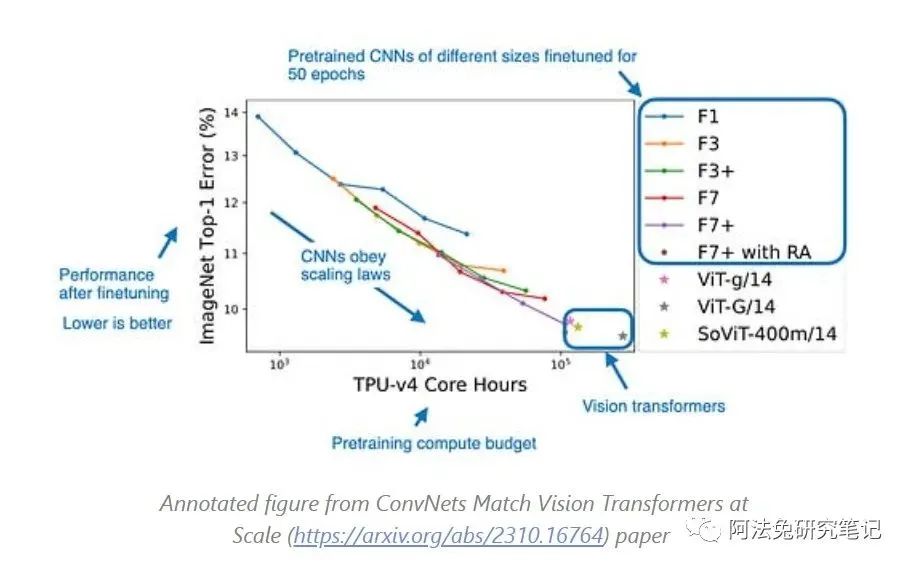

ConvNets Match Vision Transformers at Scale

近年来,由于 Large language transformers 和 vision transformers (ViTs) 的良好性能,我使用它们的频率很高。

在过去的三篇论文中,我从语言模型论文转向了计算机视觉论文,计算机视觉变换器特别吸引人的地方在于,预训练的视觉变换器甚至比卷积神经网络更容易进行 Finetune。还有就是《ConvNets Match Vision Transformers at Scale》这篇论文,该论文显示,如果能够访问足够大的数据集,卷积神经网络(CNN)实际上与 ViTs 具有竞争力。

ConvNets Match Vision Transformers at Scale (https://arxiv.org/abs/2310.16764) 论文中的注释图

在这里,研究人员投入了多达 11 万 TPU 小时的计算预算,对 ViT 和 CNN 进行了公平的比较。结果表明,当使用与 ViTs 通常使用的计算预算类似的计算预算对 CNN 进行预训练时,CNN 的性能可以与 ViTs 相媲美。为此,他们在 JFT 的 40 亿张标注图像上进行了预训练,随后在 ImageNet 上对模型进行了 Finetuning。

09

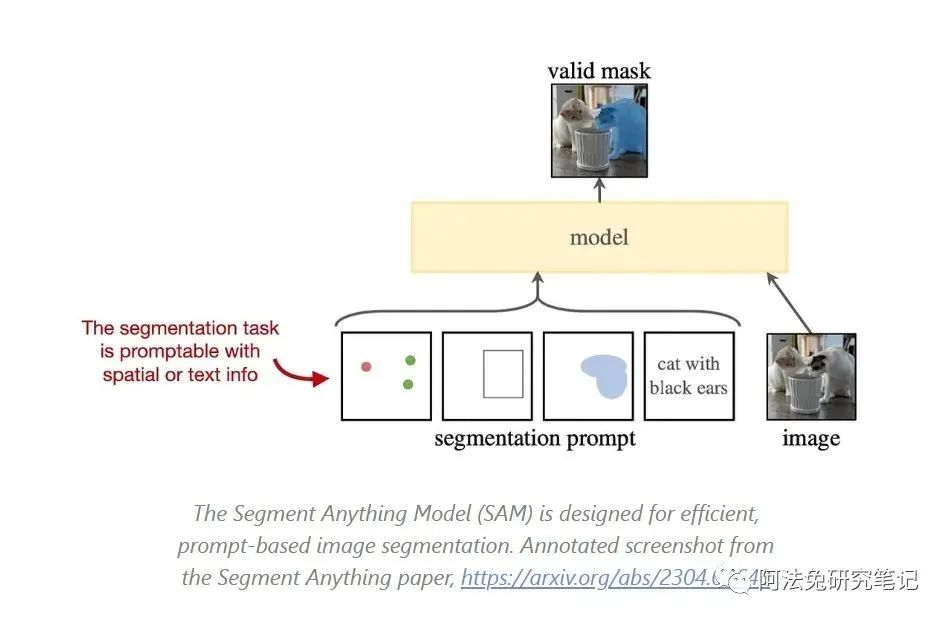

Segment Anything

在图像和视频中的 Object recognition 和 segmentation,以及分类和生成建模,是计算机视觉的主要研究领域。

简要说明这两项任务之间的区别:Object recognition 是预测边界框和相关标签;segmentation 则是对每个像素进行分类,以区分前景和背景物体:

Object recognition(上图)与 Segmentation(下图)。图片来自 YOLO 论文(https://arxiv.org/abs/1506.02640)和 Mask R-CNN 论文(https://arxiv.org/abs/1703.06870v3)

Meta 的论文「Segment Anything」论文是开源和图像 segmentation 研究的一个重要里程碑。该论文介绍了图像 segmentation 的新任务、新模型和新数据集。随附的图像数据集是迄今为止最大的 segmentation 数据集,包含超过 10 亿个 mask,构建在 1100 万张图像基础上。

SAM 旨在高效、基于提示的图像 Segmentation: 来自「Segment Anything」论文的标注截图,https://arxiv.org/abs/2304.02643

然而,罕见且值得称赞的是,研究人员使用了许可和尊重隐私的图像,因此该模型可以在没有重大版权问题的情况下开源。

The Segment Anything Model 三个主要组成部分,见 https://arxiv.org/abs/2304.02643

稍微详细一点,这三个部分可以总结如下:

-

An image encoder utilizing a masked autoencoder based on a pretrained vision transformer (ViT) that can handle high-resolution inputs. This encoder is run once per image and can be applied before prompting the model

-

A prompt encoder that handles two types of prompts: sparse (points, boxes, text) and dense (masks). Points and boxes are represented by positional encodings combined with learned embeddings for each prompt type. And free-form text uses an off-the-shelf text encoder from CLIP. Dense prompts, i.e., masks, are embedded using convolutions and summed element-wise with the image embedding.

-

A mask decoder maps the image embedding, prompt embeddings, and an output token to a mask. This is a decoder-style transformer architecture that computes the mask foreground probability at each image location.

图像 segmentation 对于自动驾驶汽车、医学成像等应用至关重要。在短短 6 个月内,该论文已经被引用超过 1500 次,并且已经有许多项目在这篇论文的基础上构建。

10

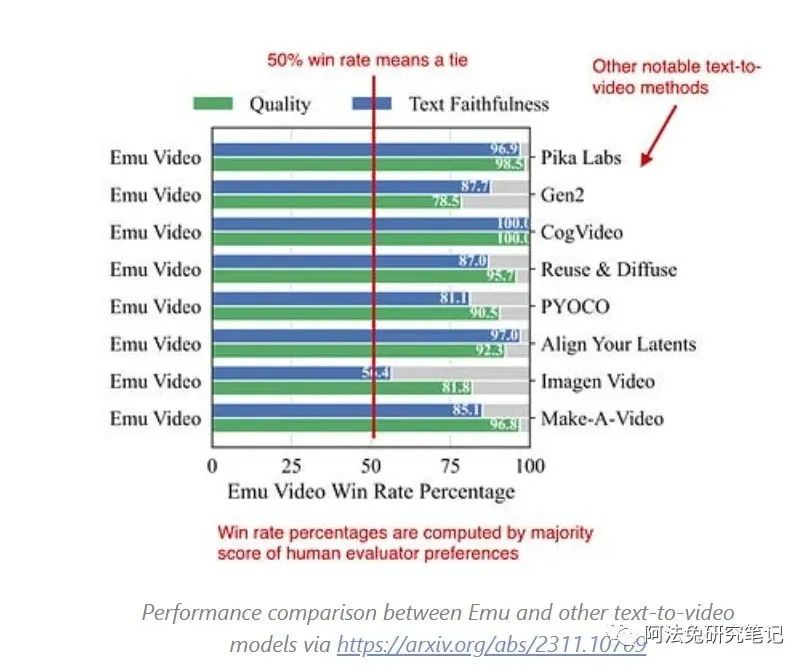

Align your Latents: High-Resolution Video Synthesis with Latent Diffusion Models

Emu 视频:通过显式图像条件分解文本到视频生成,是 Meta 研究部门的另一个值得注意的计算机视觉项目。

Emu 是一个可以从文本提示生成整个视频的文本到视频模型, 虽然它不是第一个令人印象深刻的文本到视频生成模型,但它与以前的作品相比有很大优势:

Emu 与其他文本到视频模型的性能比较,见 https://arxiv.org/abs/2311.10709 正如作者所指出的,与之前的方法相比,Emu 架构的设置相对简单。

本论文作者所指出的,Emu 的架构设置相较于以往的方法来说相对简单。这里的一个主要思想是,Emu 将生成过程分解为两个步骤:首先基于文本生成图像(使用扩散模型),然后基于文本和生成的图像创建视频(使用另一个扩散模型)。

2022 年对于文本到图像模型(如 DALL-E 2、Stable Diffusion 和 Midjourney)来说是重要的一年。尽管文本到图像模型在 2023 年仍然非常受欢迎(尽管大型语言模型(LLMs)在这一年里获得了更多关注),但我认为文本到视频模型即将在在线社区中变得更加普遍。

笔者不是图像或视频设计师,目前我没有使用这些工具的用例;然而,文本到图像和文本到视频模型作为衡量计算机视觉进步的一般指标,仍然值得关注。

如果你关注大模型领域,欢迎扫码加入我们的大模型交流群,来一起探讨大模型时代的共识和认知,跟上大模型时代的这股浪潮。

更多阅读Adobe 放弃收购 Figma,真正的原因是 AI 正在重构交互设计行业

生成式AI的2023:技术突破、商业落地、政策监管与AI恐慌

AGI Hackathon获奖项目介绍:AI如何落地,这6个项目给出了回答

纳瓦尔对于AI创业的思考:寻找技术创新的本源性

Notion的AI实践:如何在产品中集成AI,打造让用户信任的AI体验?

OpenAI 官方 Prompt 工程指南:写好 Prompt 的六个策略

转载原创文章请添加微信:geekparker

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง