文章转自「量子位」,Founder Park 有所调整

斯坦福炒虾机器人在社交媒体大火,大家似乎终于看到了机器人成为生活助手的可能性。

几乎是和斯坦福「炒虾洗碗」机器人同一时间,谷歌 DeepMind也发布了最新具身智能成果。并且是三连发:

先是一个主打提高决策速度的新模型,让机器人的操作速度(相比原来的 Robotics Transformer)提高了 14%——快的同时,质量也没有下滑,准确度还上升了 10.6%。

然后再来一个专攻泛化能力的新框架,可以给机器人创建运动轨迹提示,让它面对 41 项从未见过的任务,取得了 63% 的成功率。

别小看这个数组,对比之前的 29%,进步可谓相当大。

最后是一个机器人数据收集系统,可以一次管理 20 个机器人,目前已从它们的活动中收集了 77000 次实验数据,它们将帮助谷歌更好地完成后续训练工作。

那么,这三个成果具体是什么样?我们一个一个来看。

01

机器人日常化第一步:没见过的任务也能直接做

谷歌认为,要生产出真正可进入现实世界的机器人,必须要解决两个基本挑战:

1、新任务推广能力

2、提高决策速度

本次三连发的前两项成果就主要在这两大领域作出改进,且都建立在谷歌的基础机器人模型 Robotics Transformer(简称 RT)之上。

首先来看第一个:帮助机器人泛化的RT-Trajectory。

对于人类来说,譬如完成擦桌子这种任务简直再好理解不过了,但机器人却不是很懂。

不过好在我们可以通过多种可能的方式将这一指令传达给它,让它作出实际的物理行动。

一般来说,传统的方式就是将任务映射为一个个特定的动作,然后让机械臂完成,例如对于擦桌子,就可以拆解为「合上夹具、向左移动、向右移动」。

很明显,这种方式的泛化能力很差。

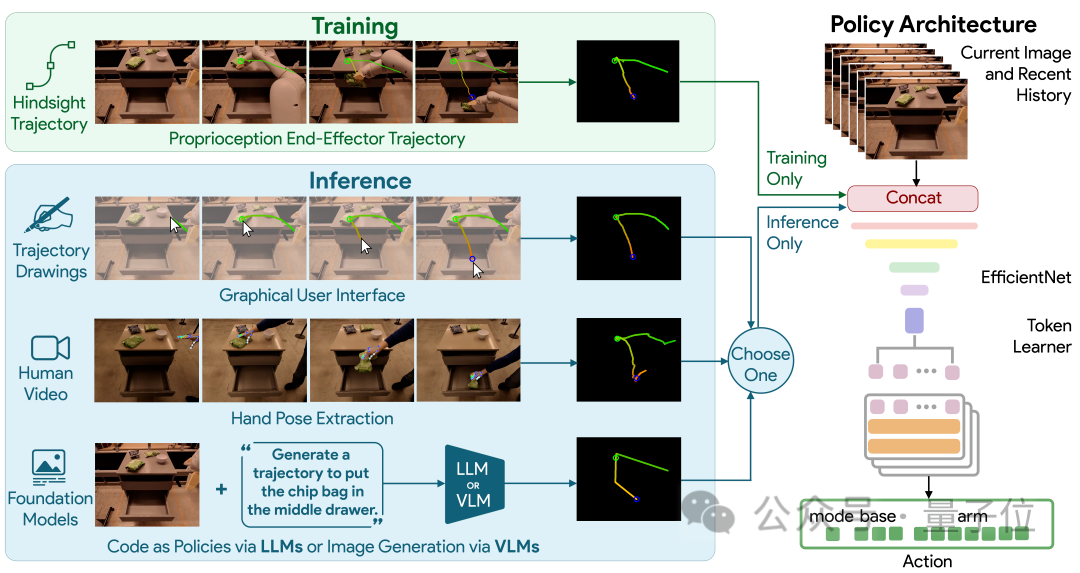

在此,谷歌新提出的 RT-Trajectory 通过给机器人提供视觉提示的方法来教它完成任务。

具体而言,由 RT-Trajectory 控制的机器人在训练时会加入 2D 轨迹增强的数据。

这些轨迹以 RGB 图像的形式呈现,包括路线和关键点,在机器人学习执行任务时提供低级但非常实用的提示。

有了这个模型,机器人执行从未见过的任务的成功率直接提高了 1 倍之多(相比谷歌的基础机器人模型 RT-2,从 29%=>63%)。

更值得一提的是,RT-Trajectory 可以用多种方式来创建轨迹,包括:通过观看人类演示、接受手绘草图,以及通过 VLM(视觉语言模型)来生成。

02

机器人日常化第二步:决策速度一定要快

泛化能力上来以后,我们再来关注决策速度。

谷歌的 RT 模型采用的是 Transformer 架构,虽然 Transformer 功能强大,但严重依赖于有着二次复杂度的注意力模块。

因此,一旦 RT 模型的输入加倍(例如给机器人配上更高分辨率的传感器),处理起来所需的计算资源就会增加为原来的四倍,这将严重减慢决策速度。

为了提高机器人的速度,谷歌在基础模型 Robotics Transformer 上开发了SARA-RT。

SARA-RT 使用一种新的模型微调方法让原来的 RT 模型变得更为高效。

这种方法被谷歌称之为「向上训练」,它主要的功能就是将原来的二次复杂度转换为线性复杂度,同时保持处理质量。

将 SARA-RT 应用于具有数十亿参数的 RT-2 模型时,后者可以在各种任务上实现更快的操作速度以及更高的准确率。

同样值得一提的是,SARA-RT 提供的是一种通用的加速 Transformer 的方法,且无需进行昂贵的预训练,因此可以很好地推广开来。

03

数据不够?自己创造

最后,为了帮助机器人更好地理解人类下达的任务,谷歌还从数据下手,直接搞了一个收集系统:AutoRT。

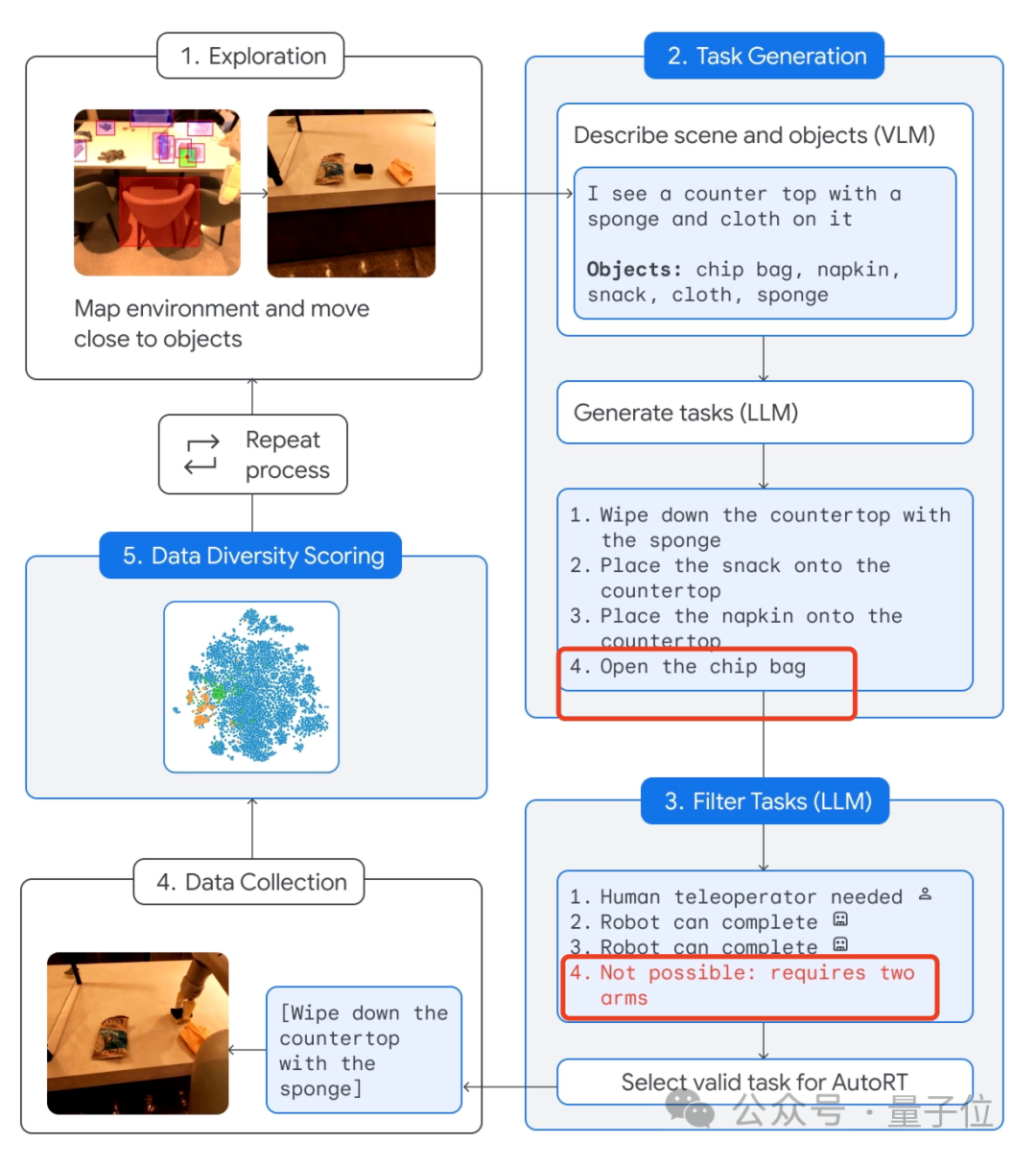

这个系统将大模型(包括 LLM 和 VLM)与机器人控制模型(RT)相结合,不断地指挥机器人去执行现实世界中的各种任务,从而产生数据并收集。

具体流程如下:

让机器人「自由」接触环境,靠近目标。

然后通过摄像头以及 VLM 模型来描述眼前的场景,包括具体有哪些物品。

接着,LLM 就通过这些信息来生成几项不同的任务。

注意了,生成以后机器人并不马上执行,而是利用 LLM 再过滤一下哪些任务可以独立搞定,哪些需要人类远程控制,以及哪些压根不能完成。

像不能完成的就是「打开薯片袋」这种,因为这需要两只机械臂(默认只有 1 只)。

再然后,做完这个筛选任务以后,机器人就可以去实际执行了。

最后由 AutoRT 系统完成数据收集并进行多样性评估。

据介绍,AutoRT 可一次同时协调多达 20 个机器人,在 7 个月的时间内,一共收集了包括 6650 个独特任务在内的 77000 次试验数据。

最后,对于此系统,谷歌还特别强调了安全性。

毕竟 AutoRT 的收集任务作用于现实世界,「安全护栏」不能少。

具体而言,基础安全守则由为机器人进行任务筛选的 LLM 提供,它的部分灵感来自艾萨克·阿西莫夫的机器人三定律——首先也是最重要的是「机器人不得伤害人类。

其次还包括要求机器人不得尝试涉及人类、动物、尖锐物体或电器的任务。

但这还远远不够。

因此 AutoRT 还配有常规机器人技术中的多层实用安全措施。

例如,机器人在其关节上的力超过给定阈值时自动停止、所有行动都可由保持在人类视线范围内的物理开关停止等等。

还想进一步了解谷歌的这批最新成果?

好消息,除了 RT-Trajectory 只上线论文以外,其余都是代码和论文一并公布,欢迎大家进一步查阅~

04

One More Thing

说起谷歌机器人,就不得不提 RT-2(本文的所有成果也都建立之上)。

这个模型由 54 位谷歌研究员耗时 7 个月打造,今年 7 月底问世。

嵌入了视觉-文本多模态大模型 VLM 的它,不仅能理解「人话」,还能对「人话」进行推理,执行一些并非一步就能到位的任务,例如从狮子、鲸鱼、恐龙这三个塑料玩具中准确捡起「已灭绝的动物」,非常惊艳。

如今的它,在短短 5 个多月内便迎来了泛化能力和决策速度的迅速提升,不由地让我们感叹:不敢想象,机器人真正冲进千家万户,究竟会有多快?

参考链接:

https://deepmind.google/discover/blog/shaping-the-future-of-advanced-robotics/

如果你关注大模型领域,欢迎扫码加入我们的大模型交流群,来一起探讨大模型时代的共识和认知,跟上大模型时代的这股浪潮。

更多阅读Adobe 放弃收购 Figma,真正的原因是 AI 正在重构交互设计行业

拾象科技李广密:硅谷大模型的融资由巨头主导、复现GPT-4是大模型竞赛的关键门槛

那些 2023 年创业失败的 AI 项目,踩了那些坑?

生成式AI的2023:技术突破、商业落地、政策监管与AI恐慌

AGI Hackathon获奖项目介绍:AI如何落地,这6个项目给出了回答

转载原创文章请添加微信:geekparker

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง