在这个数据为中心的时代,机器学习模型正迅速变得更加庞大和复杂。随着模型参数数量的激增,我们面临着在有限的计算资源和存储空间中部署这些大型模型的挑战和成本。因此,“模型压缩”和“高效运行小型模型”已成为人工智能领域的关键议题。

要理解“以小博大”即小模型如何与大模型竞争的概念,我们首先需要了解模型大小在人工智能和机器学习中的意义和重要性。在这个快速发展的时代,技术创新往往伴随规模扩大。例如,GPT-4或BERT等大型模型,因其庞大的数据集、复杂的架构和显著的处理能力,已成为行业热点。这些模型能够处理大量数据和复杂任务,尤其在处理复杂语言、图像识别或预测任务时,它们的性能通常优于小模型。

然而,大模型的高效能并非无代价。它们需要大量计算资源和能源,这增加了成本并对环境产生影响。大模型的训练和部署还需要专业硬件和软件支持,限制了它们的可访问性和普及性。因此,尽管大模型在性能上有优势,但它们在实际应用中的限制不容忽视。

在这种情况下,“以小博大”成为了重要的研究方向。这里的“小”,指的是结构更紧凑、计算需求较低的模型。这些模型的优势在于对资源的低需求,易于在不具备高端硬件的环境中部署和运行。此外,它们在更新和维护上也更灵活和高效。近年来的研究显示,通过创新的设计和优化,小模型在特定任务上也能达到或超越大模型的性能。

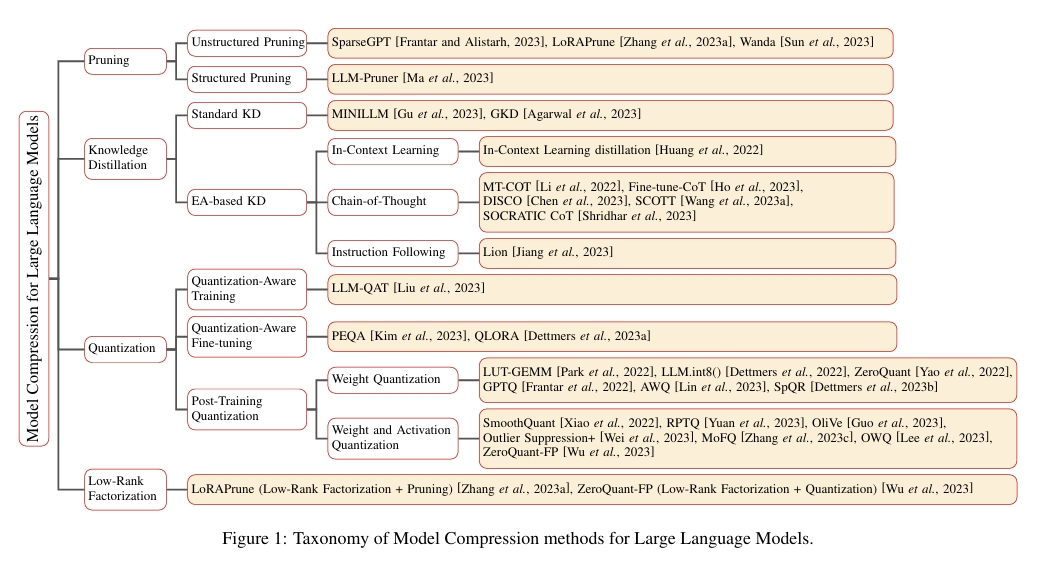

“以小博大”的策略使我们能够探索小模型的潜力,同时应对大模型面临的挑战。例如,通过模型剪枝、量化和知识蒸馏等技术,可以有效减小模型大小,同时保持或提升性能。此外,小模型的训练和调整过程通常更高效,使它们能快速适应新数据和任务。在嵌入式系统或移动设备等特定应用场景中,小模型因其轻便和高效而成为首选。

因此,探讨小模型如何与大模型竞争,不仅是技术挑战,也是面向未来的策略性思考。本文将深入探讨小模型的设计原则、性能优化技术,以及它们如何在实际应用中实现“以小博大”的目标。通过这种方式,我们可以更好地理解在资源有限的情况下,如何有效利用人工智能技术,实现技术普及和应用广泛化。

那么,关键问题是:如何使参数较少的模型达到与大模型类似的性能水平?以下是两个潜在的发展方向

数据质量

其一是提高数据质量。多伦多大学最近在《自然通讯》上发表的研究,由Jason Hattrick-Simpers教授领衔,挑战了深度学习模型需要大量训练数据的传统假设。该研究团队专注于设计新型材料,比如将碳转化为燃料的催化剂和防止飞机机翼结冰的涂层。他们发现,尽管面临庞大的潜在搜索空间挑战(例如,开放催化剂项目涵盖超过2亿个催化剂材料数据点),但并非所有数据都是必要的。

Hattrick-Simpers教授指出,虽然训练准确的AI模型通常需要大量数据,但这可能导致资源不均的问题,因为并非每个人都能访问强大的超级计算资源。此外,现有的许多小型材料数据集都是针对特定领域开发的,可能限制了探索新材料的可能性。

其研究所里的Kangming Li博士提出了一种新方法,从大型数据集中识别出高质量的子集,这些子集更易于处理且保留了原始数据集中的所有信息和多样性。他的模型使用原始数据集和缩减95%后的数据子集进行训练,并发现两种方法在预测特定材料属性时表现相似。这表明,在某些情况下,大量数据并非必要,关键在于数据的信息含量。

这项研究不仅提出了一种衡量数据集冗余的方法,而且强调即使去除高达95%的训练数据,模型在特定分布内的预测性能也不会受到显著影响。这一发现挑战了机器学习领域中“更多数据就是更好”的普遍观念,强调构建数据集时应注重数据质量而非数量。同时,这也证实了基于不确定性的主动学习算法在创建更小但同样有效的数据集方面的高效性。

知识蒸馏

其二是通过知识蒸馏的方法提炼。

知识蒸馏是深度学习领域中是一项关键技术,旨在优化神经网络模型。其核心理念在于通过一个大型且复杂的网络(即“教师模型”)来指导一个小型且简单的网络(即“学生模型”)的训练。这种方法的显著优势在于,它能够将大模型的强大性能和优越的泛化能力转移给更轻量级、运算成本更低的小模型。因此,在模型压缩和加速方面,知识蒸馏扮演了极其重要的角色,特别是在计算资源受限的场合。

知识蒸馏的必要性源自于当前深度学习模型在多个领域(例如计算机视觉、语音识别等)所面临的高性能需求与资源限制之间的冲突。尽管大模型在性能上表现卓越,但它们通常需要大量计算资源和众多参数,不适合在移动设备或嵌入式系统上部署。知识蒸馏通过巧妙的训练过程解决了这一难题,不仅提升了小模型的准确性,同时也降低了模型的延迟和参数量。

实施这项技术涉及几个关键步骤:首先是训练一个高性能的教师模型;然后,利用该模型的输出和真实标签来训练一个结构更为简单的学生模型。这个过程使得学生模型能够学习并模仿教师模型的行为,从而在不显著牺牲性能的前提下,大幅减小模型的规模和计算需求。

除了传统的知识蒸馏外,还有其他模型压缩技术,如模型剪枝、量化、参数共享和参数矩阵近似。这些方法各有所长,但知识蒸馏的独到之处在于,它不仅减少了模型的规模,还维持了模型的高性能。在工业应用中,尤其是在需要快速反应和资源有限的环境下,知识蒸馏显示出其独特的价值。

与从零开始训练模型相比,知识蒸馏具有其特有的优势。尽管小型网络在理论上可能由于有限的搜索空间而受限于其性能,但通过模仿已在更广阔的搜索空间中经过优化的教师模型,学生模型能够在其解决方案空间中实现更优的性能。这一过程不仅提升了小模型的效能,也为实际应用提供了更灵活、高效的解决方案。

研究进展

目前,国内外有许多研究团队在小模型调优领域取得了显著的进展。

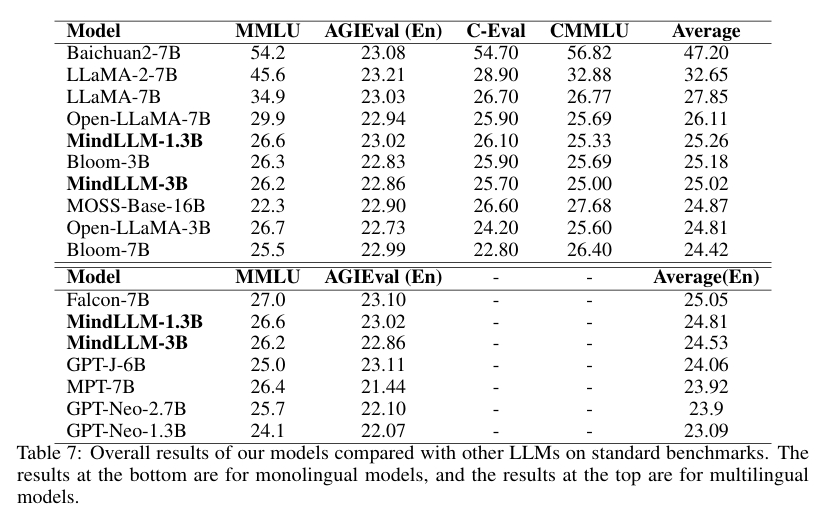

国内方面,北京理工大学的自然语言处理团队开发出了一种名为MindLLM的双语轻量级大模型。这个模型在应对高计算成本和资源限制方面表现出色。MindLLM有1.3B和3B两个版本,它们在多项基准测试中的表现与或超越了其他大模型。该团队分享了他们在数据处理方面的经验和技巧,这包括维护高质量网络文本、合理分配数据类型,以及专门为小模型设计的指令调整框架,旨在增强模型在特定领域的表现。

文章还详细介绍了MindLLM模型的评估结果和应用实例。即便没有进行指令微调,MindLLM也在多个评测中优于某些大模型。特别是在法律和金融等专业领域,MindLLM展现了其出色的适应能力。此外,文章还探讨了不同的双语学习策略,发现对于轻量级模型而言,从零开始的学习策略更为有效。

研究还强调了数据处理方法的重要性,如格式清洗、数据去重和敏感信息过滤,以确保数据的高质量。通过研究数据的混杂和课程,团队发现不同数据来源对模型学习有着不同的影响。MindLLM模型结构采用了多种优化算法,以提高训练的稳定性和模型的性能。这些综合措施使MindLLM在轻量级模型中特定领域的应用上表现尤为出色。

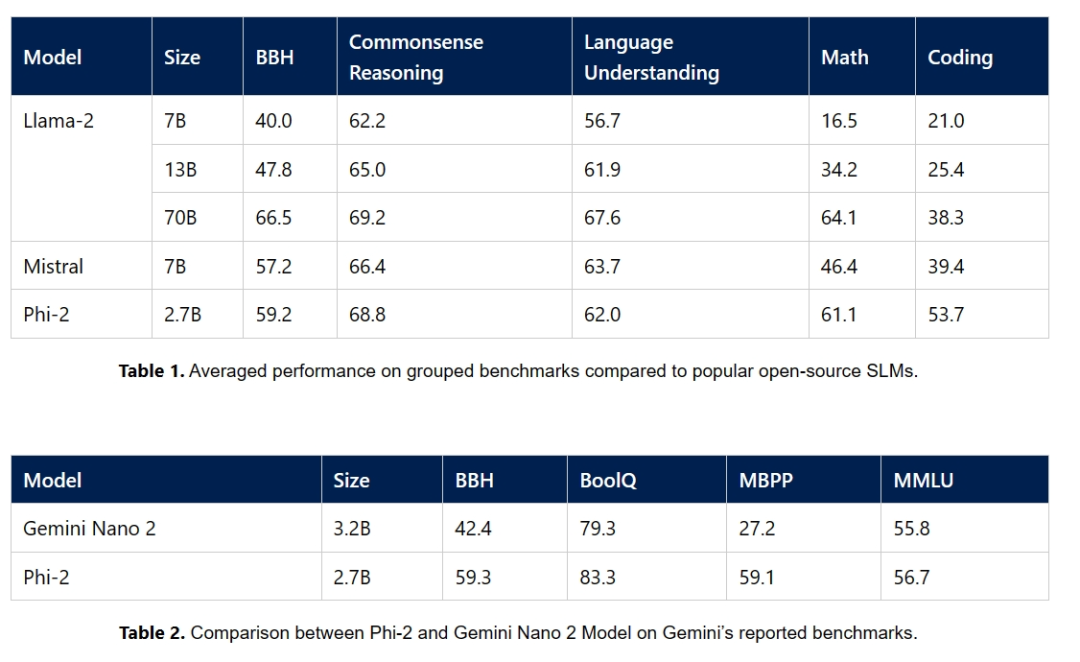

国外方面,微软研究院的机器学习基础团队近期推出了一系列名为”Phi”的小型语言模型(SLMs),在多种基准测试中取得了印象深刻的成绩。第一个模型拥有13亿个参数,在Python编码方面达到了行业领先的水平。随后,该团队拓宽了研究范围,涉足常识推理和语言理解领域,开发出了一个参数规模相同但性能相当于其五倍大小模型的新型模型。现在,他们推出了Phi-2,一个拥有27亿参数的语言模型,表现出了卓越的推理和语言理解能力。Phi-2在复杂的基准测试中超越了体量比它大25倍的模型,这得益于模型扩展和训练数据精选方面的创新。Phi-2成为了研究人员在机器解释性、安全性改进和细节调整方面的有价值工具。

该模型可在Azure AI Studio的模型库中使用,以促进进一步的研究和开发。通过展示训练数据质量和创新扩展技术如何实现高性能,该团队挑战了传统的语言模型扩展法则。Phi-2是在合成数据和网络数据集的结合下进行训练的,重点放在高质量的教育内容上。其训练过程耗时14天。

写在最后

以上两个案例说明,轻量级模型可以通过高效的训练策略和数据集精简实现与大模型相媲美的性能。在MindLLM和Phi-2的示例中,我们看到了精心设计的小模型如何在处理速度、资源利用率和灵活性方面超越大模型。这些成果不仅为人工智能研究提供了新的方向,也为实际应用中的机器学习模型部署提供了可行的选择。在未来,我们可能会看到更多类似的研究,这些研究将进一步推动小模型在处理效率和性能方面的发展,同时也会为资源受限的环境提供更多的机器学习解决方案。

总之,通过提高数据质量、知识蒸馏等方法的应用,机器学习领域正在朝着实现高效、高性能的小模型迈进。这些方法不仅提高了模型的可用性,也降低了部署成本,使得人工智能技术更加普及。随着技术的不断进步,未来的机器学习模型将更加精准、高效,且更加易于在各种设备上部署,从而推动人工智能技术的广泛应用和发展。

同时我们也要明白,随着模型规模的增大,一些当前存在的问题会得到解决。比如7B和13B的模型中比较严重的幻觉问题。通过比较GPT4和GPT3.5可以明显看出,在超过100B、200B甚至400B的模型中,这些幻觉问题大大减少了。因此我们也需要用动态的视角来看待这个问题。随着计算能力和算法的发展,大模型的边际成本会迅速降低,而其效果的提升将保持稳定。也许在未来考虑模型时,性能将成为更重要的考量因素而不仅仅是效率。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง