点击下方名片,即刻关注【智驾实验室】

点击下方名片,即刻关注【智驾实验室】

在自动驾驶领域,预测未来事件并评估可预见的风险,使自动驾驶车辆能够更好地规划其行动,从而提高道路上的安全性和效率。为此,作者提出了Drive-WM,这是第一个与现有端到端规划模型兼容的自动驾驶世界模型。通过由视角分解促进的联合空间-时间建模,Drive-WM在驾驶场景中生成高保真度的多视图视频。在强大的生成能力的基础上,首次展示了将世界模型应用于安全驾驶规划的潜力。

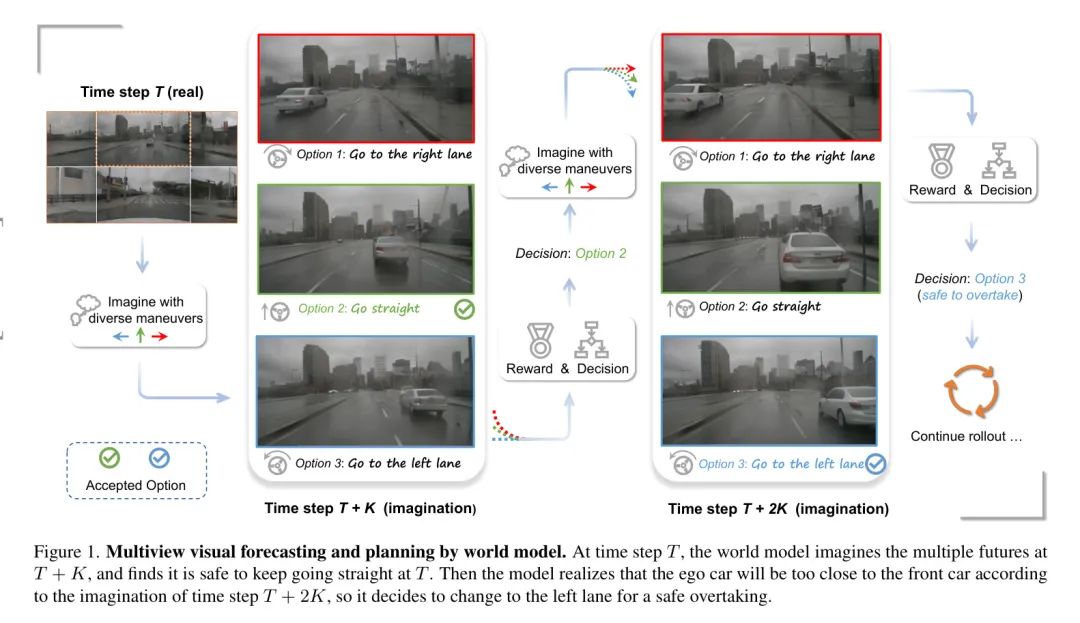

特别是Drive-WM可以根据不同的驾驶动作进入多个未来,并根据基于图像的奖励确定最佳轨迹。

在实际驾驶数据集上的评估证实,Drive-WM可以生成高质量、一致且可控的多视图视频,为实际仿真和安全性规划开辟了可能性。

1 Introduction

端到端自动驾驶的出现最近引起了越来越多的关注。这些方法将多传感器数据作为输入,并在联合模型中直接输出规划结果,允许所有模块进行联合优化。然而,当一个端到端规划器仅基于专家驾驶轨迹进行训练时,它在面对out-of-distribution(OOD)案例时的泛化能力是否存在,这是一个值得怀疑的问题。

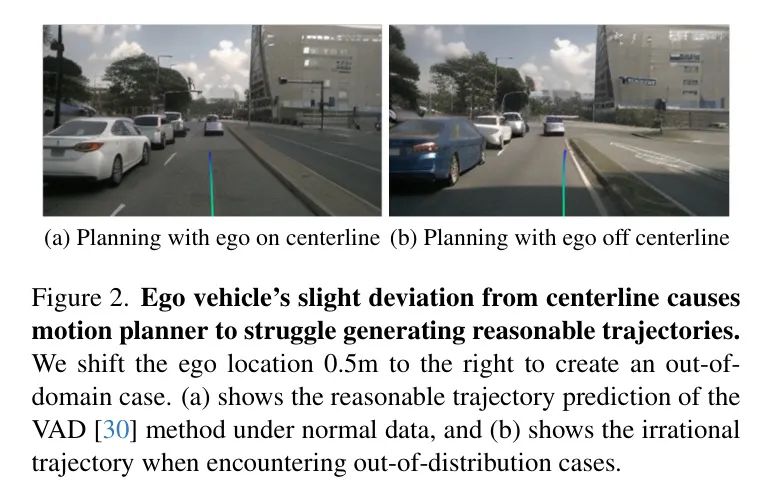

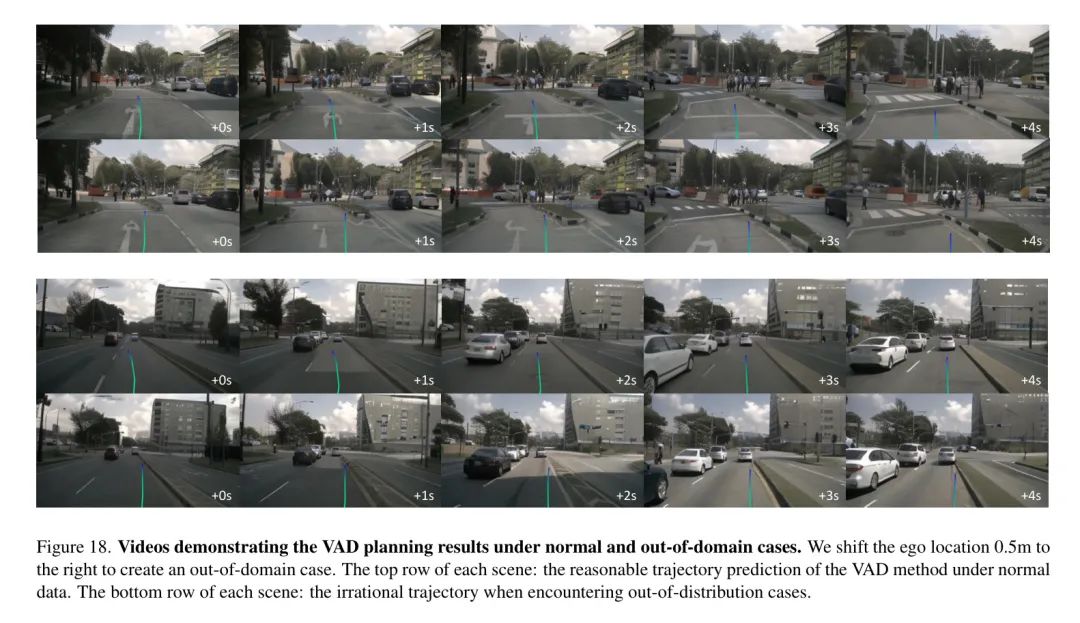

如图2所示,当自动驾驶车辆的位置横向偏离中心线时,端到端规划器很难生成一个合理的轨迹。为了解决这个问题,作者提出通过开发一个预测模型来提高自动驾驶的安全性,该模型在决策之前可以预见规划器退化。这种模型被称为世界模型,它旨在根据当前状态和自车动作预测未来的状态。通过提前视觉化未来并从不同未来获得反馈,在实际决策之前,它可以提供更合理的规划,从而提高端到端自动驾驶的泛化性和安全性。

然而,学习与现有端到端自动驾驶模型兼容的高质量世界模型是具有挑战性的,尽管在游戏模拟和实验室机器人环境[12, 20]方面已经取得了一些成功尝试。具体来说,存在三个主要挑战:

- 驾驶世界模型需要在高分辨率像素空间中进行建模。以前低分辨率的图像或向量化的状态空间方法无法有效地表示现实世界中的许多细粒度或非向量化的事件。此外,向量空间世界模型需要额外的向量标注,并受到感知模型状态估计噪声的影响。

- 生成多视图一致视频具有挑战性。以前和同时期的研究仅限于单视图视频或多视图图像生成, leaving 多视图视频生成成为自动驾驶所需全面环境观测的开放问题。

- 灵活适应各种异质条件,如变化中的天气、光线、自车行为和道路/障碍物/车辆布局,具有挑战性。

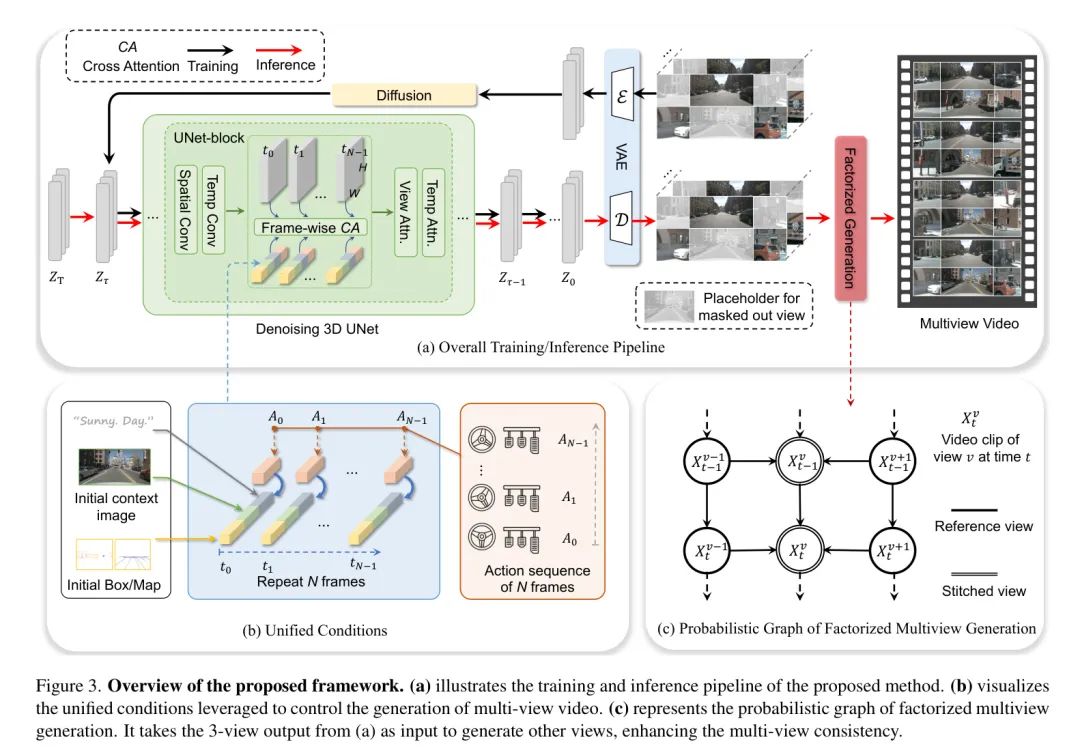

为了解决这些挑战,作者提出了Drive-WM。受到潜在视频扩散模型的启发,作者引入了多视图和时间建模,共同生成多个视图和帧。为了进一步提高多视图一致性,提出了将联合建模因式分解,以预测基于相邻视图的条件中间视图,从而极大地提高视图之间的一致性。作者还引入了一个简单而有效的统一条件接口,使得可以使用异质条件(如图像、文本、3D布局和动作)进行灵活的条件生成,极大地简化了条件生成过程。最后,在多视图世界模型的基础上,作者探讨了端到端规划应用,以提高自动驾驶安全性,如图1所示。

作者的工作的主要贡献可以总结如下。

-

提出了Drive-WM,这是一个多视图世界模型,能够在自动驾驶场景中生成高质量、可控和一致的多视图视频。

-

在nuScenes数据集上进行的广泛实验展示了领先的视频质量和可控性。Drive-WM还实现了优越的多视图一致性,通过一种新的基于关键点匹配的度量方法进行评估。

-

作者是第一家探索将世界模型应用于端到端自动驾驶规划的潜在应用。作者通过实验表明,Drive-WM可以增强规划的整体一致性和在非分布情况下的鲁棒性。

2 Related Works

Video Generation and Prediction

视频生成旨在生成逼真的视频样本。过去已经提出了各种生成方法,包括基于VAE(变分自编码器)的(Variational Autoencoder),基于GAN(生成对抗网络)的(generative adversarial networks),基于流的(flow-based)和自回归模型(auto-regressive models)。

值得注意的是,扩散模型在图像生成的领域最近取得了成功,从而激发了将扩散模型应用于视频生成的兴趣。扩散模型在提高逼真度、可控性和时间一致性方面取得了显著的改进。由于可控性生成,文本条件视频生成引起了更多的关注,并出现了许多方法。

视频预测可以被视为一种特殊的生成形式,利用过去的观察来预测未来的帧。尤其是在自动驾驶中,DriveGAN学会了以车辆控制信号作为输入来模拟一个驾驶场景。GAIA-1和DriveDreamer进一步扩展到动作-条件扩散模型,提高了生成的视频的可控性和逼真度。然而,这些以前的工作仅限于单目视频,无法理解整个3D环境。作者已经率先实现了多视图视频的生成,允许与现有的BEV感知和规划模型更好地集成。

World Model for Planning

世界模型学习世界的通用表示,并预测由一系列动作引起的世界状态。无论在游戏还是在实验室环境中学习世界模型都得到了广泛研究。Dreamer从过去的经验中学习一个潜在的动力学模型,以预测潜在空间的州值和动作。它能够在DeepMind Control Suite中处理DeepMind Control Suite中的挑战性视觉控制任务。DreamerV2改进了Dreamer,在Atari游戏中达到了人类 Level 的性能。DreamerV3使用更大的网络并从稀疏奖励中学习,这在Minecraft中被认为是长期挑战。Day-Dreamer将Dreamer应用于在真实世界中训练4个机器人,并在不改变超参数的情况下解决移动和操作任务。

最近,学习驾驶场景中的世界模型引起了关注。MILE采用基于模型的模仿学习方法,在CARLA中联合学习动力学模型和驾驶行为。上述工作仅限于模拟器或受控实验室环境。相比之下,Drive-WM可以与现有的端到端驾驶规划器集成,以提高在实际场景中的规划性能。

3 Multi-view Video Generation

在本节中首先介绍了如何联合建模多个视图和帧,这将在第3.1节中介绍。然后,在第3.2节中通过将联合建模因式分解来增强多视图一致性。最后,在第3.3节中将阐述如何构建一个统一条件接口,以集成多个异质条件。

Joint Modeling of Multiview Video

为了联合建模多视图时间数据,首先从已经研究透彻的图像扩散模型开始,并通过引入额外的时间层和多视图层将其适应到多视图时间场景。在本小节中首先介绍联合建模的整体公式,并详细阐述时间和多视图层。

形式化。假设有一个多视图视频的数据集,其中,是一个包含张图像的序列,每张图像有个视角,高度和宽度分别为和。给定编码的视频潜在表示,扩散的输入,其中和定义了一个由扩散时间步长参数化的噪声时间表。一个去噪模型(由空间参数、时间参数和多视图参数参数化)接收扩散的作为输入,并通过最小化去噪得分匹配目标进行优化。

在这里,表示条件,目标是随机噪声。是在扩散时间上均匀分布的分布。

时间编码层。首先引入时间层,将预训练的图像扩散模型提升到时间模型。在每个块中的空间层之后,添加时间层,遵循VideoLDM中的做法。时间层将帧内和视角内的潜在编码为三维卷积。然后,将潜在值重新排列以保留时间维度,即(TK)CHWKCHW,并在空间-时间维度上应用3D卷积。然后,将潜在值重新排列为(KHW)TC,并应用于时间维度上的标准多头自注意力,以增强时间依赖性。公式1中表示这部分的参数。

多视图编码层。为了联合建模多个视图,必须在不同视图之间进行信息交换。因此,将单视图时间模型提升到多视图时间模型,通过引入多视图编码层来实现。具体来说,将潜在值重新排列为(KHW)TC (THW)KC,以保留视图维度。然后,在视图维度上应用由参数化的自注意力层,以实现多视图注意力。多视图注意力允许所有视图具有相似的风格和一致的整体结构。

多视图时间调优。考虑到强大的图像扩散模型,并没有从头训练时间多视图网络。相反,首先使用单视图图像数据和条件训练一个标准的图像扩散模型,这对应于公式1中的参数。然后,将参数冻结,并使用视频数据微调附加的 temporal layers()和 multiview layers()。

Factorization of Joint Multiview Modeling

尽管第3.1节中的联合分布可以产生不同视图之间的相似风格,但在重叠区域很难保证严格的 consistency。在本小节中引入分布因式来增强多视图一致性。首先介绍因式化的公式,然后描述它如何与上述联合建模合作。

形式。令表示第i个视图的样本,第3.1节本质上建模了联合分布,它可以写成。公式2表明,不同的视图以自回归方式生成,其中一个新的视图取决于现有视图。这些条件分布可以确保更好的视图一致性,因为新视图了解现有视图的内容。然而,这种自回归生成是低效的,使得在实践中实现这样的完全因子化变得不可行。

为了简化公式2中的建模,将所有视图分为两种类型:参考视图和拼接视图。例如,在nuScenes中,参考视图可以是,而拼接视图可以是。作者使用“拼接”这个词,因为拼接视图似乎是从其两个相邻的参考视图中“拼接”而成的。同一类型的视图不会相互重叠,而不同类型的视图可能相互重叠。这启发作者首先模型化参考视图的联合分布。

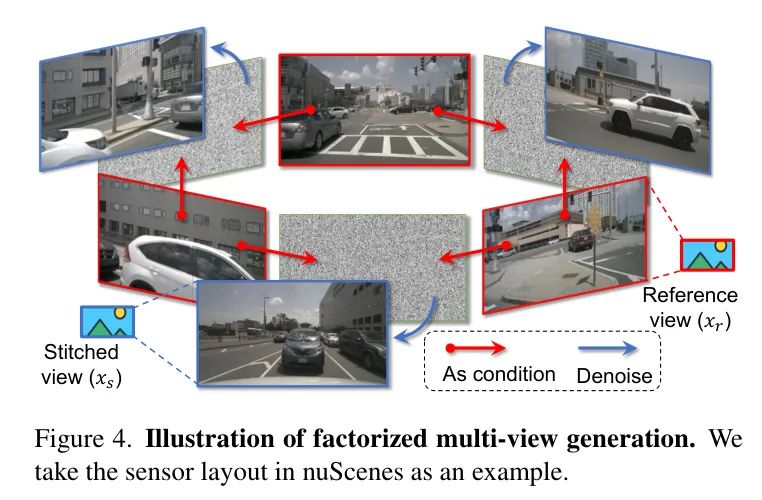

在这里,由于非重叠的参考视图不需要严格的一致性,联合建模是有效的。然后,将的分布建模为条件分布,条件于。图4说明了nuScenes中多视图因子化的基本概念。因此,将公式2简化为

考虑到时间连贯性,将前几帧作为额外的条件。公式3可以重写为

其中是来自之前生成的视频片段的上下文帧(例如,最后两帧)。参考视图的分布由第3.1节中的 Pipeline 实现。关于,采用类似的 Pipeline ,但将相邻的参考视图作为额外的条件,如图4所示。

Unified Conditional Generation

由于现实世界的复杂性,世界模型需要利用多个异质条件。在作者的情况下,使用初始上下文帧、文本描述、自车行为、3D框、BEV图和参考视图。可以进一步包含更多的条件以提高可控性。为每个一个条件开发专门的接口是耗时的且不灵活的,无法添加更多的条件。

为解决这个问题,作者引入了一个统一的条件接口,它在集成多个异质条件方面既简单又有效。接下来,作者首先介绍如何编码每个条件,然后描述统一的条件接口。

图像条件。将初始上下文帧(即,视频片段中的第一帧)和参考视图视为图像条件。给定图像条件,使用ConvNeXt作为编码器进行编码并 flatten 到一序列 -维嵌入,其中表示图像的数量,表示嵌入的维度。来自不同图像的嵌入在第一维上进行拼接。

布局条件。布局条件指的是3D框、高分辨率地图和BEV分割。为了简单起见,将3D框和高清地图投影到2D视角视图。这样,可以使用与图像条件编码相同的策略来编码布局条件,从而得到一序列嵌入,其中是投影的布局和BEV分割的嵌入总数。

文本条件。遵循扩散模型的惯例,采用预训练的CLIP作为文本编码器。具体来说,将视图信息、天气和光线结合在一起,以推导出文本描述。嵌入被表示为。

动作条件。动作条件对于世界模型生成未来是必不可少的。为了与现有的规划方法兼容,在时间步中定义动作为,表示自车位置到下一个时间步的移动。使用MLP将动作映射到-维嵌入。

一个统一的条件接口。到目前为止,所有的条件都映射到-维特征空间。将所需嵌入的拼接作为输入用于去噪UNet。以基于动作的联合视频生成为例,这使能够利用初始上下文图像、初始布局、文本描述和帧级动作序列。因此,在某个时间处,拥有统一的条件嵌入。

其中下标表示生成的第帧,下标表示当前的实拍帧。作者强调,将不同条件组合在一起可以提供一个统一的接口,并且可以根据需要进行调整。最后,通过帧内交叉注意力与3D UNet中的潜在进行交互。

4 World Model for End-to-End Planning

盲目地规划动作而不预测后果是危险的。利用Drive-WM可以对自动驾驶的安全规划进行全面评估。在本节中,探索使用世界模型进行端到端规划,这是自动驾驶领域的一个未知的领域。

Tree-based Rollout with Actions

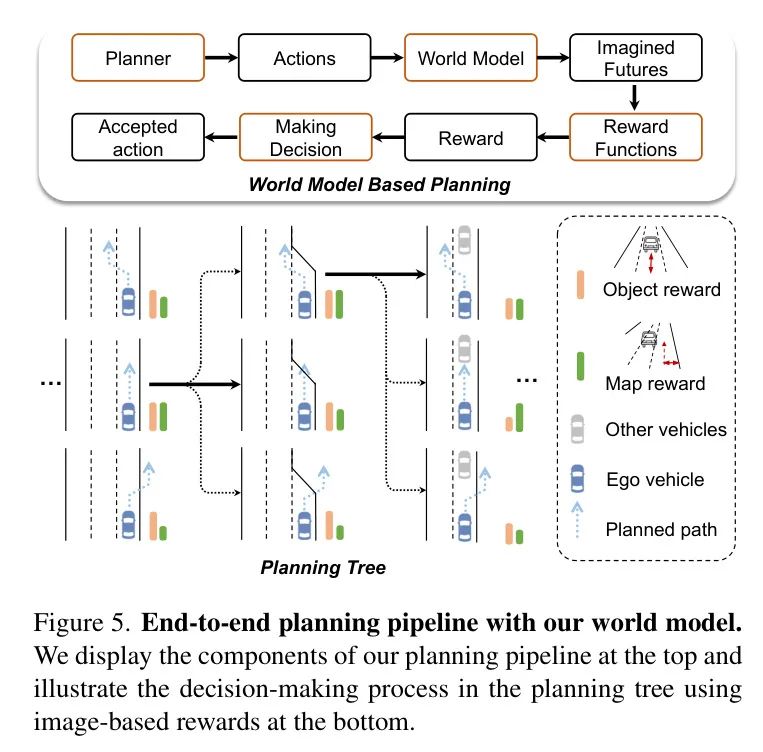

在本节中,作者描述了利用世界模型进行规划的过程。在每个时间步中,作者利用世界模型为从规划器中采样的轨迹候选项生成预测的未来场景,使用基于图像的奖励函数评估未来场景,并选择最优轨迹来扩展规划树。

如图5所示定义规划树为一系列随时间演化的预测自车轨迹。对于每个时间步,相机可以捕捉到真实的多视图图像。预训练的规划器将真实的多视图图像作为输入,并从轨迹候选项中采样可能的轨迹。

为了与主流规划器的输入兼容,在时间定义其动作为每个轨迹的,其中和是在时间时的自车位置。给定动作,采用公式5中的条件组合进行视频生成。生成后,使用基于图像的奖励函数选择最优轨迹作为决策。这样的生成-决策过程可以重复,形成基于树的rollout。

Image-based Reward Function

在为计划轨迹生成未来视频之后,需要奖励函数来评估多个未来的健全性。

首先从感知结果中获取奖励。特别是,使用基于图像的3D目标检测器和在线高分辨率地图预测器在生成的视频中获取感知结果。然后定义地图奖励和物体奖励,灵感来自传统的规划器。地图奖励包括两个因素:距离路缘的距离,鼓励自车保持在正确的行驶区域内,以及车道中心线的一致性,防止自车频繁变更车道并偏离横向车道。物体奖励意味着自车在纵向和横向距离其他道路交通参与者的距离。这种奖励可以避免自车与其他道路交通参与者发生碰撞。总奖励定义为物体奖励和地图奖励的乘积。最后选择具有最大奖励的自车预测。然后,规划树向前推进到下一个时间戳,并依次计划后续轨迹。

由于所提出的世界模型在像素空间中运行,因此可以从非向量化的表示中获取奖励,以处理更一般的案例。例如,喷头喷出的水和损坏的路面很难被监督感知模型向量化,而世界模型从大量的无标签数据中训练,可以生成这样的像素空间案例。利用最近强大的基础模型如GPT-4V,规划过程可以从非向量化的表示中获得更全面的奖励。在附录中,作者展示了一些典型的例子。

5 Experiments

Setup

数据集。采用nuScenes数据集进行实验,这是用于3D感知和规划最流行的数据集之一。该数据集包括总共700个训练视频和150个验证视频。每个视频由六个环绕视图的摄像头捕捉约20秒。

训练方案。将原始图像从1600 900裁剪和缩放到384 192。Drive-WM使用Stable Diffusion checkpoints进行初始化。所有实验均在48GB的A40 GPU上进行。有关附加细节,请参阅附录。

质量评估。为了评估生成的视频的质量,使用FID(Frechet Inception Distance)和FVD(Frechet Video Distance)作为主要指标。

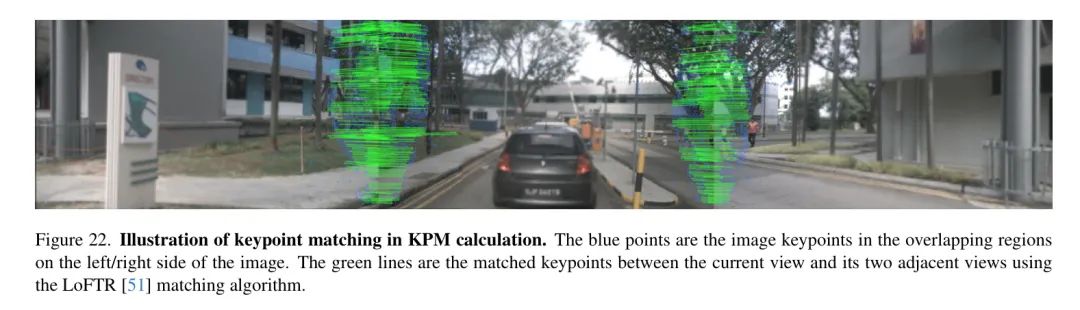

多视图一致性评估。引入了一个新的度量标准,即Key Points Matching(KPM)分数,用于评估多视图一致性。这个度量标准利用一个预训练的匹配模型来计算平均匹配关键点的数量,从而量化KPM分数。在计算过程中,对于每个图像,首先计算当前视图与相邻视图之间的匹配关键点数量。然后,计算生成数据中匹配关键点数量与实际数据中匹配关键点数量之间的比率。最后,跨所有生成图像的平均这些比率,以获得KPM分数。在实际应用中,在验证集中均匀选择每个场景的8帧来计算KPM。

控制性评估。为了评估视频内容生成的可控性,作者使用预训练的感知模型评估生成的图像。遵循以前的方法,采用了CVT进行前景和背景分割。此外,还评估了3D目标检测和在线地图构建。

规划评估。遵循开环评估指标进行端到端规划,包括距离GT轨迹的L2距离和物体碰撞率。

模型变体。支持基于动作的视频生成和基于布局的视频生成。前者将每帧的自车动作作为条件,而后者将每帧的布局(3D框、地图信息)作为条件。

Main Results of Multi-view Video Generation

作者首先展示了优越生成质量和可控性。在这里,生成是基于帧级的3D布局的。Drive-WM在nuScenes train 分割中进行训练,并在 val 分割中的条件下进行评估。

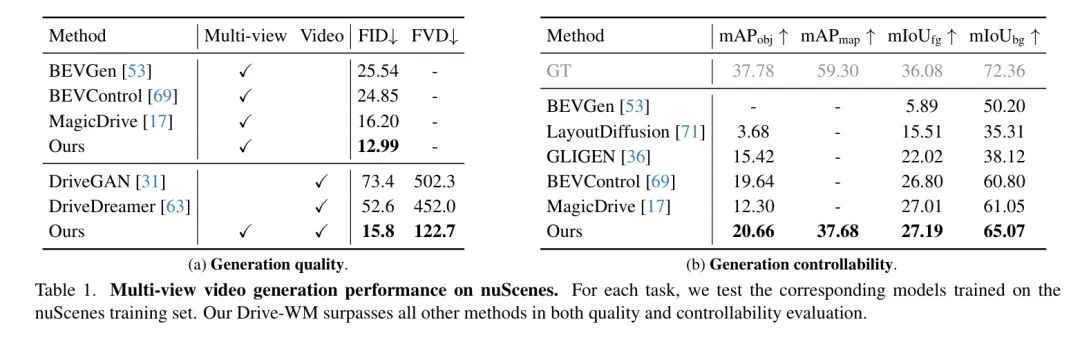

生成质量。 由于作者是第一个探索多视图视频生成的团队,将与先前的方法在多视图图像和单视图视频中进行分别比较。对于多视图图像生成,在第3.1节中移除了时间层。表1a展示了主要结果。在单视图图像生成中,实现了12.99 FID,相比先前的方法实现了显著的改进。对于视频生成,Drive-WM在单视图视频生成方法的基础上取得了显著的质量改进,实现了15.8 FID和122.7 FVD。此外,Drive-WM是第一个能够生成一致多视图视频的工作,这在第5.3节中得到了量化的证明。

可控性。 在表1b中,在nuScenes验证集上评估了Drive-WM的可控性。对于前景可控性,评估了在生成的多视图视频中3D目标检测的性能,报告了mAP。此外,在BEV布局上分割前景,报告了mIoU。关于背景控制,报告了道路分割的mIoU。此外,还评估了HDMap的mAP。这种优越的可控性突出了统一的条件接口(第3.3节)的有效性,并展示了世界模型作为神经模拟器的潜力。

Ablation Study for Multiview Video Generation

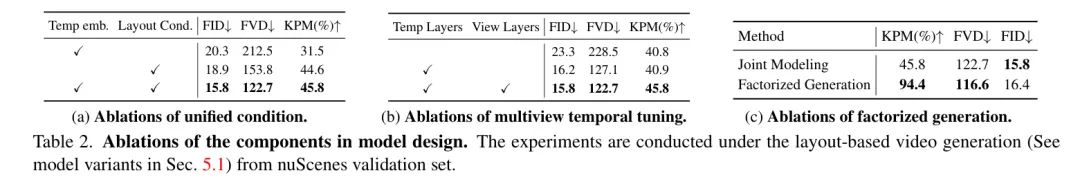

为了验证设计决策的有效性,对模型中的关键特征进行了消融研究,如表2所示。这些实验是在布局型视频生成下进行的。

统一的条件。在表2(a)中发现布局条件对模型的能力有显著影响,提高了生成的视频质量和一致性。此外,时间嵌入可以增强生成的视频质量。

模型设计。在表2(b)中探索了在多视图时间调优中,时间层和视图层的作用。实验表明,仅采用多视图层而没有因式分解(第3.2节)的时间层和视图层可以略微提高KPM。

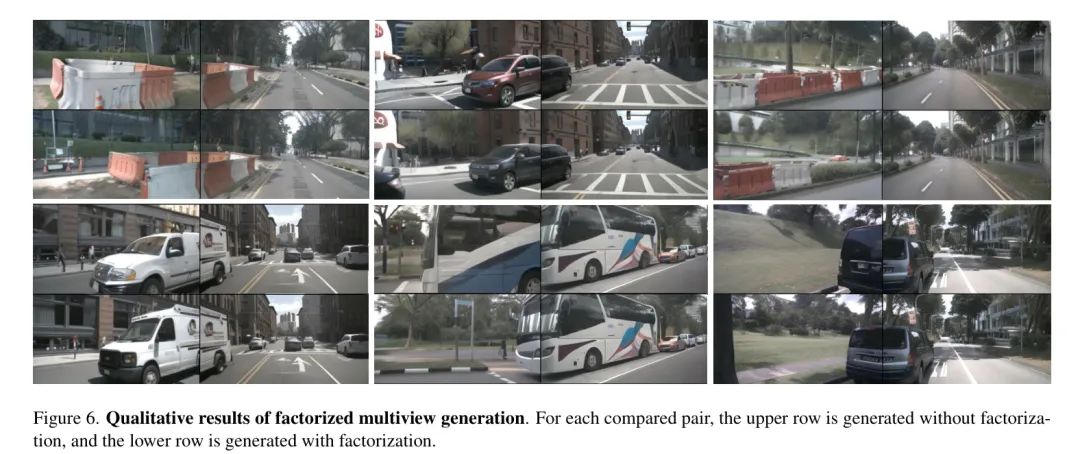

分因式多视图生成。如表2(c)所示,分因式生成显著提高了多个视图之间的一致性,从45.8%提高到94.4%,与联合建模相比。这种增强是在确保图像和视频质量的同时实现的。如图6所示的定性结果。

Exploring Planning with World Model

在本小节中探索了世界模型在端到端规划中的应用,这在最近的自动驾驶研究中还很少被探索。作者的尝试主要集中在两个方面。(1) 首先,证明评估生成的未来是有益的规划。 (2) 然后,展示了世界模型可以用来改进一些域外情况的规划。

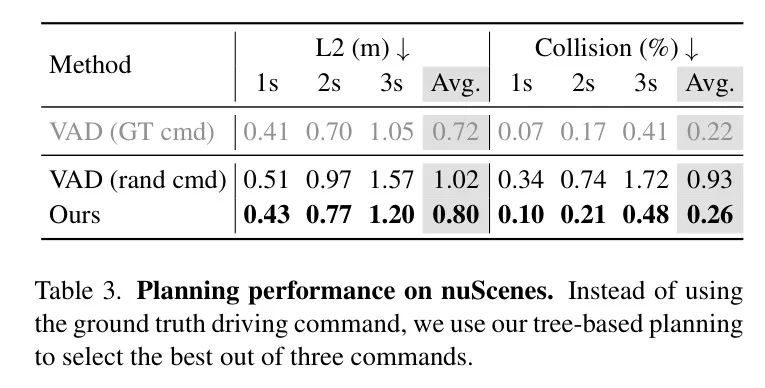

使用 GT 驾驶指令,从VAD中按照“直行”、“左转”和“右转”三个命令采样计划轨迹。然后,这些采样动作用于基于树的规划(见第4节)。如表3所示,基于树的规划器优于随机驾驶指令,甚至实现了接近GT指令的性能。

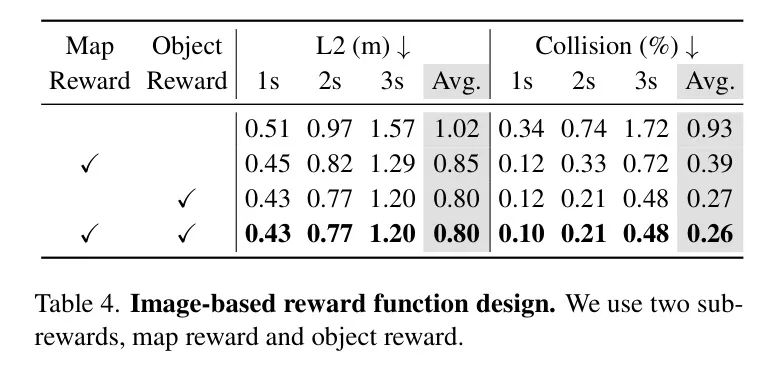

此外,如表4所示消融了两个采用的奖励,结果表明组合奖励优于每个子奖励,尤其是在物体碰撞指标方面。

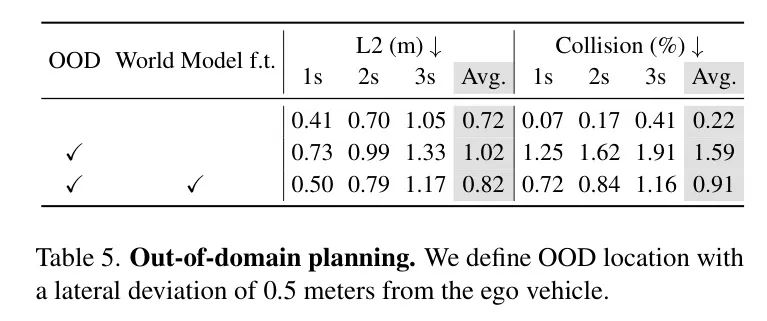

从域外使用Drive-WM,可以在像素空间模拟域外的自车位置。特别是,将自车位置横向移动0.5米,如图2中的右侧一样。在这种情况下,现有的端到端规划器VAD[30]的性能会显著降低,如表5所示。

为了缓解这个问题,使用生成的视频来监督规划器,该规划器使自车驶回车道。从这些域外数据中学习,规划器的性能可以更好,接近正常水平。

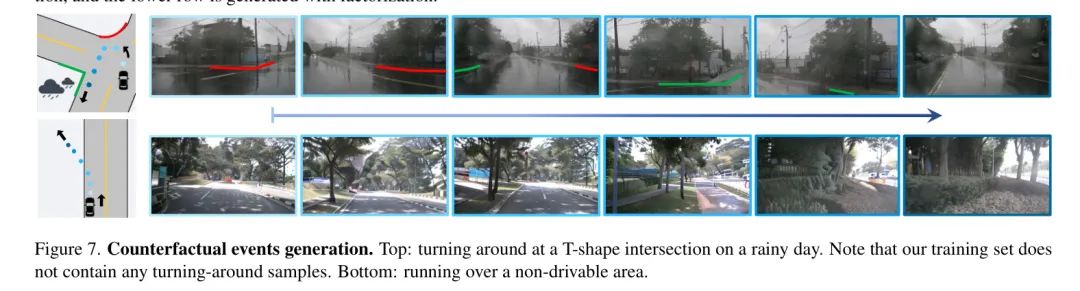

Counterfactual Events

给定一个初始观测和行动,Drive-WM可以生成反事实事件,例如掉头和驶入非可行驶区域(如图7所示),这些与训练数据有显著不同。生成这样的反事实数据再次揭示了Drive-WM预测和处理域外案例的潜力。

6 Conclusion

作者提出了Drive-WM,这是第一个用于自动驾驶的多视图世界模型。Drive-WM在各种条件下,利用文本描述符、布局或自车动作等信息控制视频生成,展示了生成高质量和一致的多视图视频的能力。引入的分因式生成显著增强了各种视图之间的空间一致性。

此外,在nuScenes数据集上的广泛实验表明,Drive-WM可以增强在域外情况下的规划整体有效性和鲁棒性。

Appendix A Qualitative Results

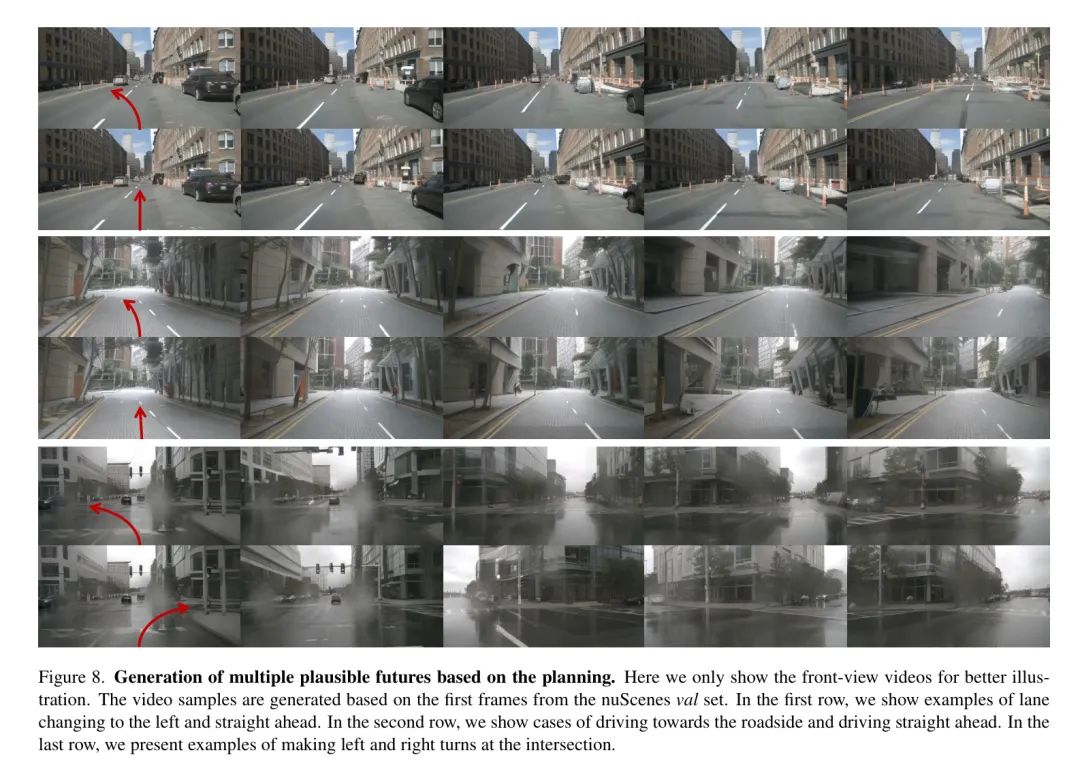

Generation of Multiple Plausible Futures

Drive-WM可以根据规划器从不同的动作中预测多种多样的未来结果,如图8所示。基于VAD的计划,Drive-WM预测与初始观测一致的多个可能的未来。在nuScenes验证集中生成视频样本。图8中的行显示了左转或保持当前车道(行1),向路边驶去并直接前进(行2),以及交叉口的左/右转(行3)的预测未来。

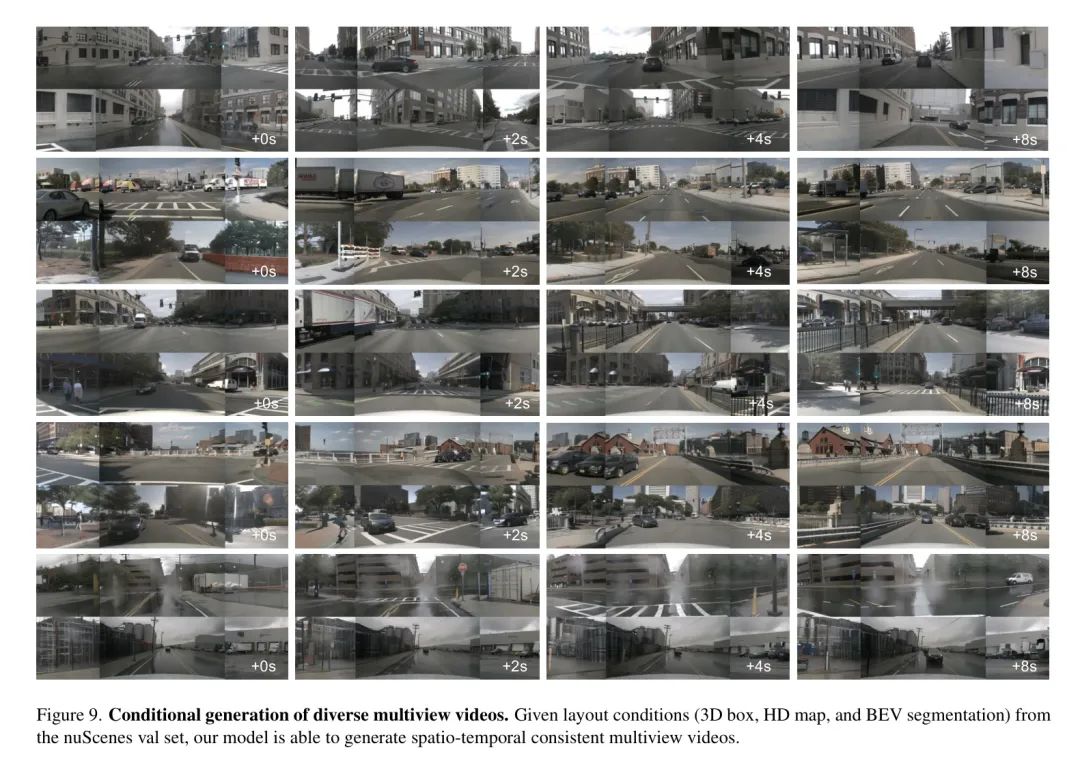

Generation of Diverse Multiview Videos

Drive-WM可以作为一个根据时间布局的多视图视频生成器。这使得它可以作为一个神经模拟器来应用。尽管是在nuScenes train集中训练的,但Drive-WM在val集中表现出创造力,通过生成新的物体、运动和场景的组合。

正常场景生成。Drive-WM可以根据布局条件生成多样化的多视图视频预测,如图9所示,这在nuScenes验证集中得到了验证。

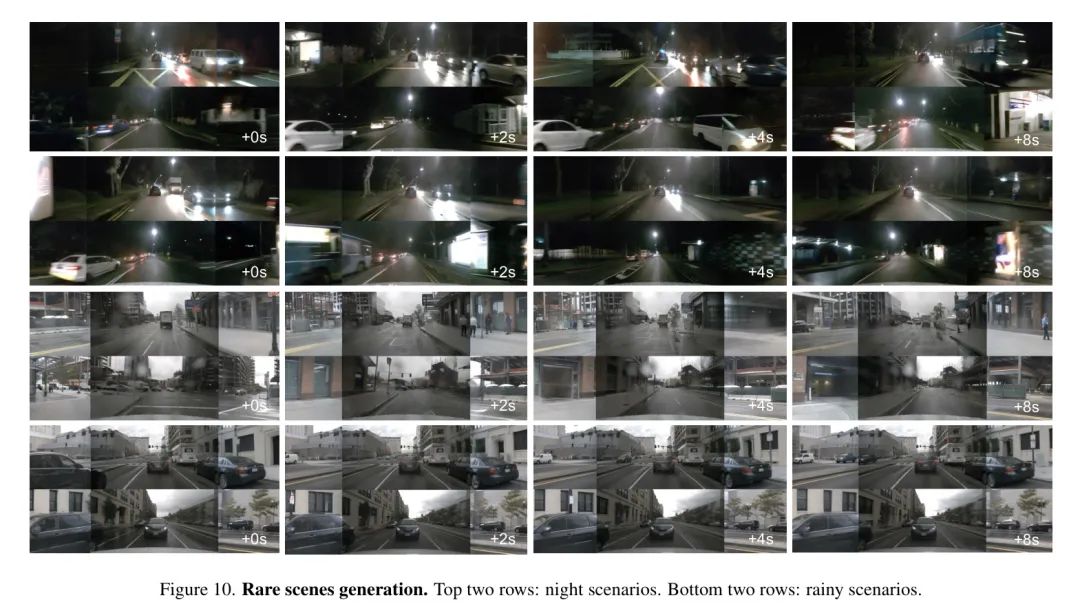

稀有场景生成。尽管在训练期间仅有限地暴露于白天场景,但Drive-WM仍可以在夜间和雨天等罕见驾驶条件下生成高质量的视频,如图10所示。这证明了模型在训练数据分布之外的有效泛化能力。

Visual Element Control

Drive-WM允许通过各种形式控制进行条件生成,包括文本提示修改全局天气和照明,自车车辆动作改变驾驶动作,以及3D框改变前景布局。本节展示了Drive-WM基于用户指定条件的交互式视频生成灵活的控制机制。

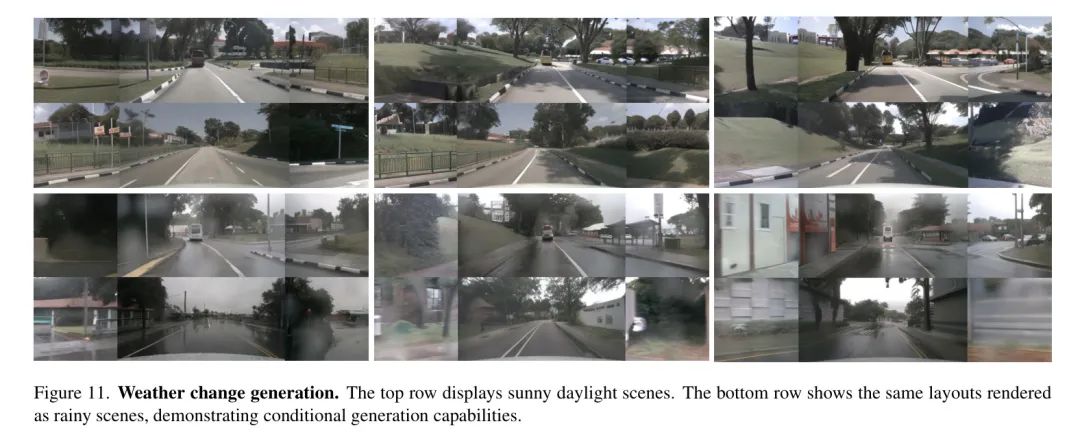

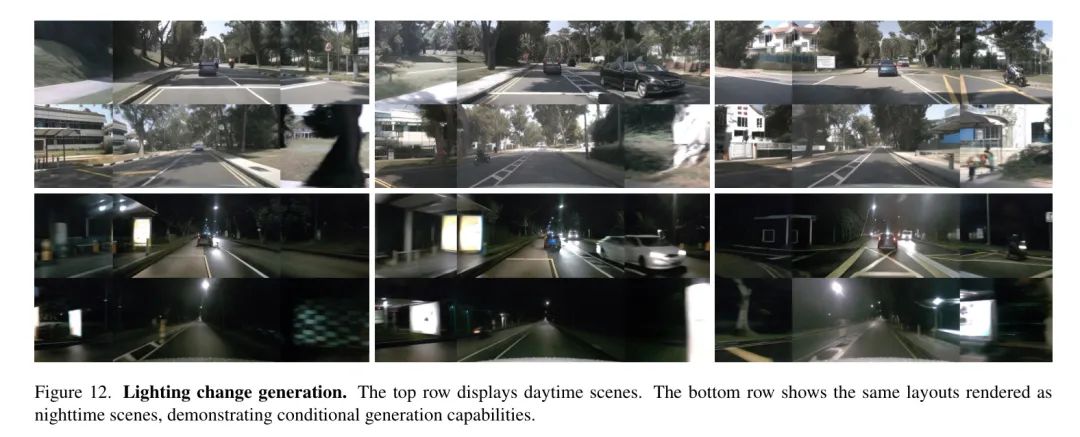

天气和照明变化。如图11和图12所示展示了模型在保持相同场景布局(道路结构和前景物体)的同时改变天气或照明条件的能力。基于nuScene val集中的布局条件,生成了视频示例。这种能力对于未来的数据增强具有很大的潜力。通过在各种天气和照明条件下生成多样化的场景,Drive-WM可以显著扩大训练数据集,从而提高模型的泛化性能和鲁棒性。

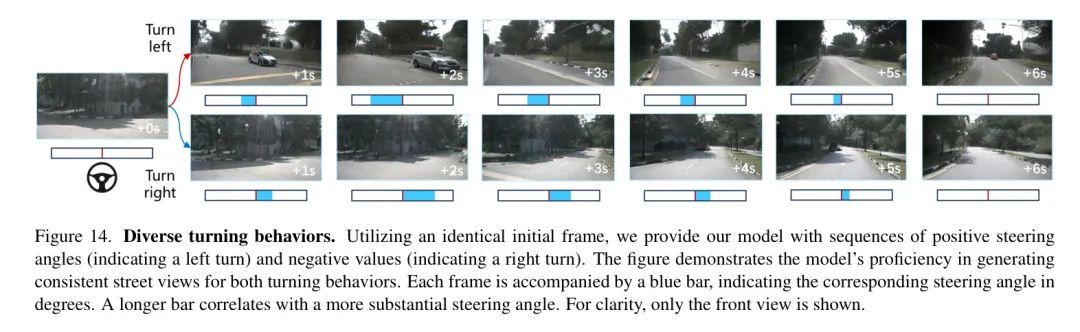

动作控制。Drive-WM能够根据给定的自车动作信号生成高质量的街道视图。例如,如图14所示,模型根据输入的转向信号正确生成了左转和右转的视频。

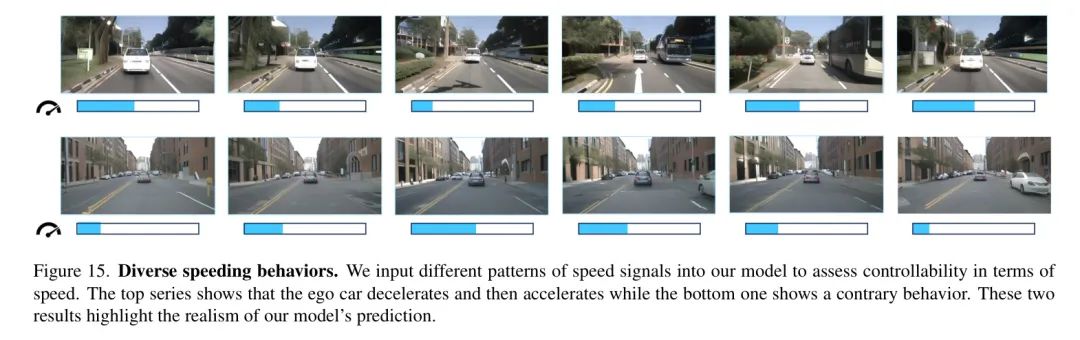

如图15所示,模型成功预测了符合加速和减速信号的周围车辆的位置。这些定性结果证明了Drive-WM的可控性很高。

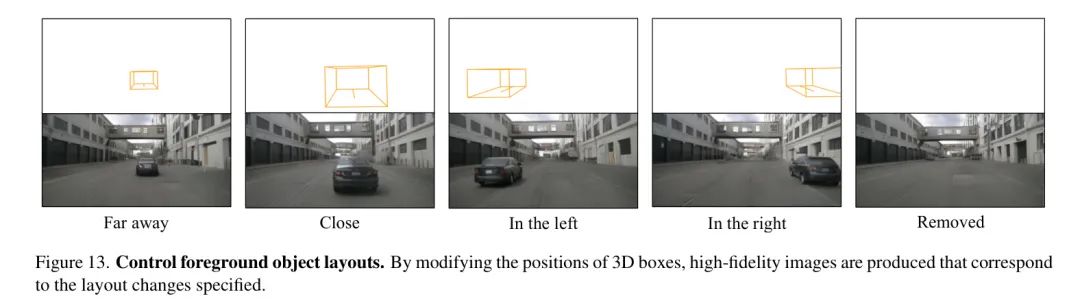

前景控制。如图13所示,Drive-WM可以在生成的视频中精细控制前景布局。通过修改横向和纵向条件,可以生成对应于布局变化的逼真图像。

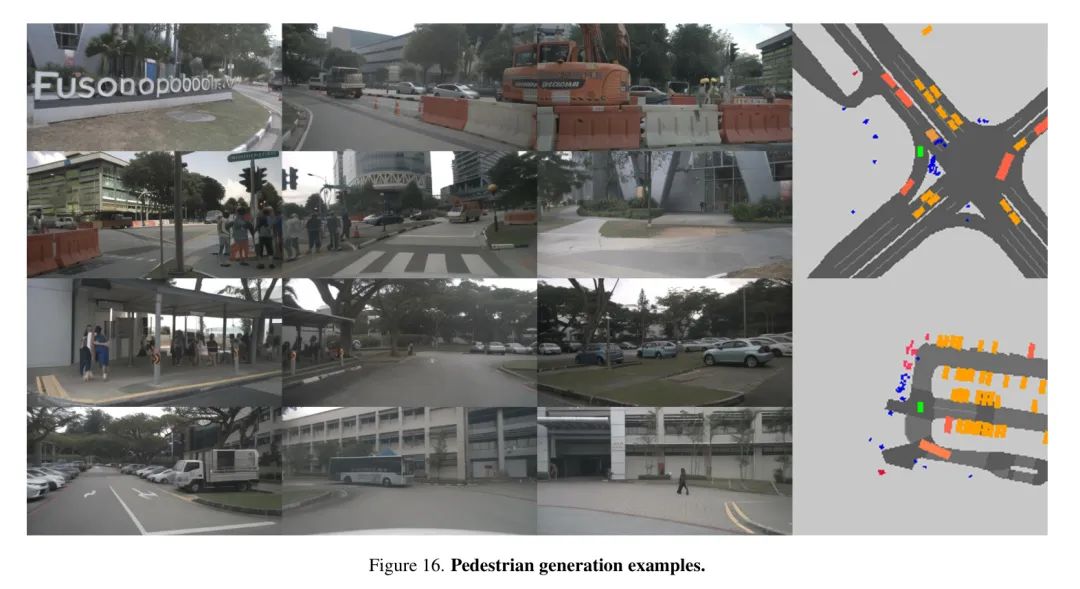

行人生成对于街道视图合成方法来说是一个挑战。然而,与以前的工作不同,图16表明Drive-WM可以有效地生成行人。第一组前六张图像显示一辆车在等待行人过马路,而第二组后六张图像则显示行人在公交车站等待。这表明Drive-WM有潜力生成详细的多人交互。

A.4. End-to-end Planning Results for Out-of-domain Scenarios

现有的端到端规划器是针对与车道中心对齐的专家轨迹进行训练的。如图2所示,这导致在生成离中心偏移的轨迹时存在困难,这在行为克隆中被称为“缺乏探索”问题。使用Drive-WM进行模拟,图18展示了更多的计划轨迹偏离车道中心。作者发现规划器在这些生成的域外案例上无法恢复。这突显了Drive-WM在探索特殊情况并提高鲁棒性方面的实用价值。

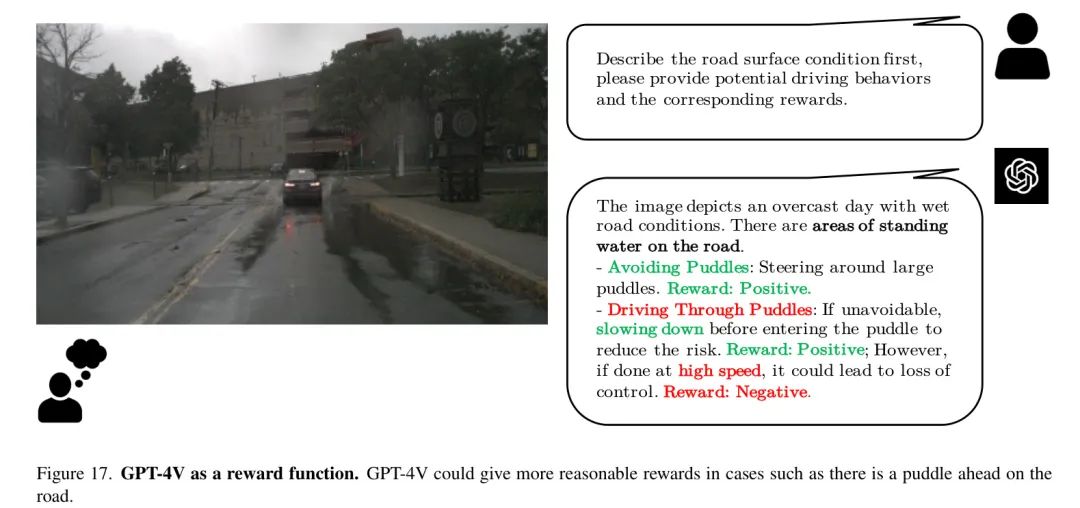

Using GPT-4V as a Reward Function

为了评估不同计划下预测的不同未来安全性的差异,利用最近发布的GPT-4V模型作为评估者。具体来说,使用Drive-WM在不同的道路条件和代理行为下合成多样化的未来驾驶视频。然后,使用GPT-4V分析这些模拟视频,并从整体安全性的角度提供奖励。

如图17所示,它展示了当道路上有一个水坑时,GPT-4V计划的不同驾驶行为。与具有向量输入的奖励函数相比,GPT-4V提供了对Drive-WM视频中的危险情况更广泛的场景理解。

通过利用GPT-4V的多模态推理能力进行未来场景评估,可以实现增强的评估,识别通过更广泛的场景理解推理出的风险,而不是直接表示的奖励函数。这证明了将生成性的世界模型如Drive-WM与奖励生成的模型如GPT-4V相结合的价值。通过使用GPT-4V来批评Drive-WM的预测,可以实现更强的反馈,从而最终在各种实际条件下提高自主驾驶的安全性。

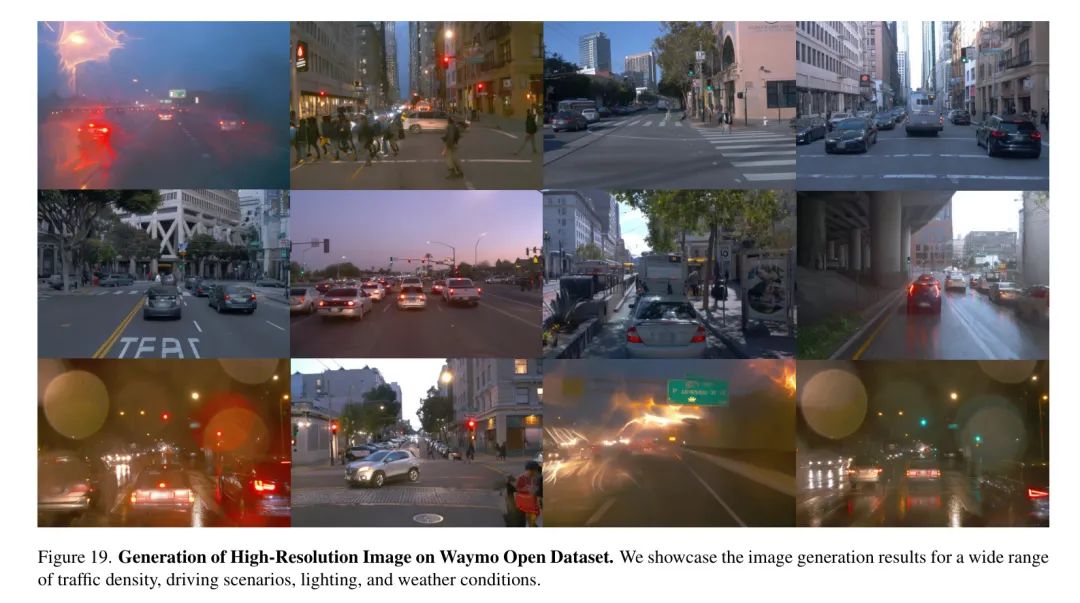

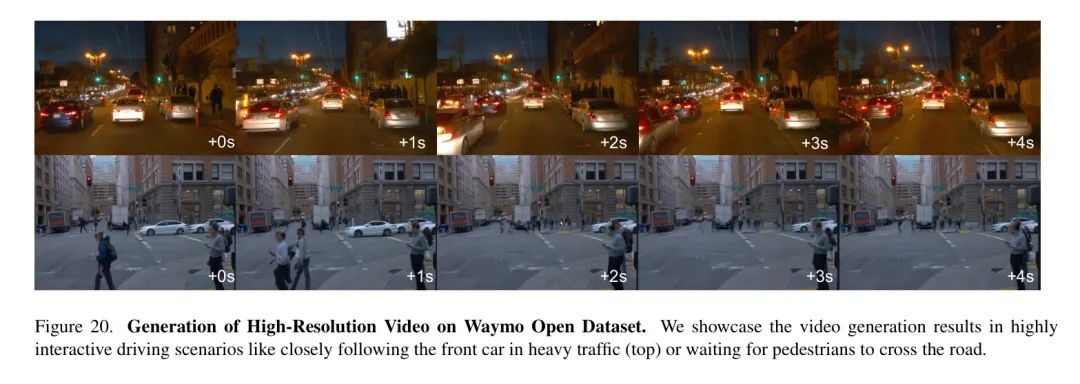

Video Generation on Other Datasets

为了展示Drive-WM的广泛适用性,在Waymo Open Dataset上应用它,以生成768×512的高分辨率图像。如图19和图20所示,Drive-WM在相同的超参数下,以nuScenes相同的超参数,生成了这种分辨率的实时且多样化的驾驶预测图像。

通过有效地泛化到新数据集和分辨率,这些Waymo示例验证了Drive-WM在不同驾驶数据集之间提供了一种广泛适应性的高保真视频合成方法。

Appendix B Implementation Details

在本节中介绍了_联合多视图视频模型_和_因子分解模型_的训练和推理细节。

Joint Multiview Video Model

训练细节。nuScenes的原图像分辨率为1600×900。作者最初将其裁剪为1600×800,并丢弃顶部区域,然后将其缩放到384×192以进行模型训练。类似于VideoLDM,作者首先训练一个条件图像潜在扩散模型。该模型条件于各种场景元素,例如高分辨率地图、BEV分割、3D边界框和文本描述。所有条件都在标记长度维度上拼接。图像模型使用Stable Diffusion checkpoints初始化。这个_条件图像模型_在60,000迭代中训练,总批量为768。使用AdamW优化器,学习率。

然后,通过引入时间和多视图参数构建多视图视频模型,并在此模型上进行40,000迭代,批量为32,视频帧长为T=8。对于基于动作的视频生成,区别仅在于每帧条件信息的变化,而训练和模型结构相同。使用AdamW优化器,学习率。从模型中采样,通常使用Denoising Diffusion Implicit Models (DDIM)的采样器。无分类器引导(CFG)强化了条件引导的影响。对于每个条件,训练期间有20%的概率随机丢弃它。所有实验均在A40 GPU上进行。

推理细节。在推理过程中,采样步数为50,使用随机性=1.0,CFG=5.0。对于视频生成,使用第一帧作为条件来生成后续视频内容。类似于VideoLDM,使用生成的帧作为后续条件进行长视频生成。

Factorization Model

因子分解的训练实现类似于第B.1节中联合建模的实现。对于因子分解生成,额外使用参考视图作为额外的图像条件。

因子分解的训练实现以nuScenes数据集为例。首先顺时针将六个多视图视频片段排序,记为到。然后定义一个训练样本,即,其中是从所有六个视图中随机采样拼接的一个缝合视图,是一对参考视图。是第i个视图的先前生成的帧,也作为额外的图像条件。训练流水线与联合建模非常相似,不同之处在于这里每次迭代只生成一个视图。从训练样本中可以看出,在训练中,单缝合视图的视图维度。

在推理过程中,先预定义一些视图作为参考视图,对应的这些参考视图的视频首先由联合模型生成。然后,根据配对的参考视频片段和之前生成的视图(即)生成拼接视图的视频。特别地,在nuScenes中,选择F、BL、BR3作为参考视图。

三组参考视图构成三对,作为三个拼接视图的条件。例如,Drive-WM在生成前左视图时,以前视图、后左视图和之前生成的前左视图为条件。推理参数与第B.1节相同。

Appendix C Data

在本节中首先描述了数据集的准备,然后介绍了数据集的筛选以增强基于行动的生成。

Data Preparation

NuScenes Dataset.

nuScenes数据集提供了完整的360度摄像头覆盖,是目前3D感知和规划的主要数据集。根据官方配置,使用700个街道视图场景进行训练,150个进行验证。接下来,介绍每个条件的处理过程。对于3D框条件,将3D边界框投影到图像平面,利用八边形角点描绘物体的位置和尺寸,同时使用颜色区分不同的类别,以确保准确的物体定位和分类。对于HD地图条件,将向量线投影到图像平面,颜色表示不同的类型。

在BEV分割方面,遵循CVT中的生成过程。该过程生成鸟瞰视图分割掩码,表示场景中不同物体和景观的分布。对于文本条件,遍历每个场景描述中的信息。对于规划条件,使用真实的自车位置运动信息进行训练,并使用VAD的规划输出进行推理。这使模型可以从准确的 ego-motion 信息中学习,并做出与规划轨迹一致的预测。最后,对于 ego-action 条件,提取每帧车辆速度和转向的信息。

The Waymo Open Dataset.

Waymo Open Dataset 是一个著名的自动驾驶大规模数据集。只利用“前”摄像头的数据来训练视频模型,图像分辨率为像素。对于地图条件,遵循OpenLane中的数据处理。

Data Curation

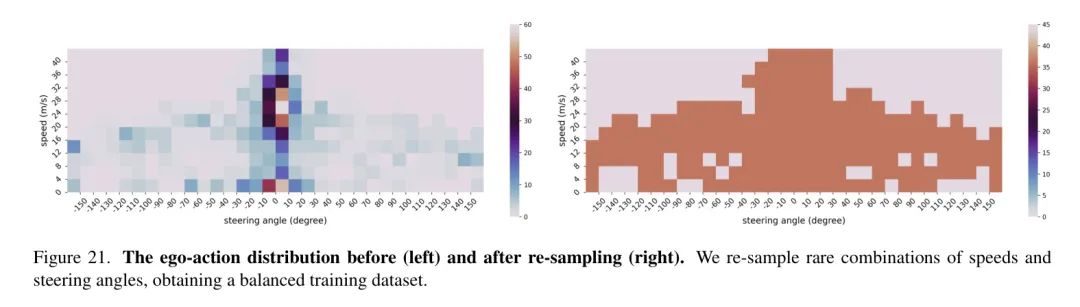

nuScenes数据集中的自车动作分布严重不平衡:大量帧的转向角小于30度,速度在10-20 m/s之间。这种不平衡导致模型对转向角和速度的稀有组合的泛化能力较弱。

为了缓解这种负面影响,通过重新采样罕见的自车动作来平衡训练数据集。首先,将每个轨迹分成几个片段,每个片段只展示一种驾驶行为(例如,左转、直行或右转)。这一过程产生了1048个唯一的片段。然后,将这些片段通过数字化平均转向角和速度的组合进行聚类。速度范围[0, 40](m/s)被分成10个相等长度的桶。超过40 m/s的极快速度将落入第11个桶。转向角范围[-150, 150](度)被分成30个相等长度的桶。同样,超过150度或小于-150度的极角将落入另外两个桶。作者用图21展示了这种分类产生的自车动作分布。

为了平衡这些片段的动作分布,作者从每个2D 网格的桶中分别采样36个片段。对于包含超过个片段的桶,作者随机采样个片段;对于包含少于个片段的桶,作者遍历这些片段直到收集到个样本。因此,总共收集了7272个片段。重新采样后的动作分布如图21所示。

Appendix D Metric Evaluation Details

Video Quality

FID和FVD计算是在nuScenes数据集的150个验证视频片段上进行的。由于Drive-WM可以生成多视图视频,将它分解为六个视图的视频进行评估。作者有总共900个视频片段(40帧)并按照VideoLDM中描述的计算过程进行。作者使用官方的UCF FVD评估代码4。

KPM Illustration

正如第5.1节中所述引入了KPM分数指标来衡量生成图像的多视图一致性,该指标并未在FID和FVD指标中考虑。如图22所示,展示了关键点匹配的过程。蓝色点是图像左右两侧重叠区域的键点。

参考

[1]. Driving into the Future: Multiview Visual Forecasting and Planning with World Model for Autonomous Driving

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง