01

研究动机

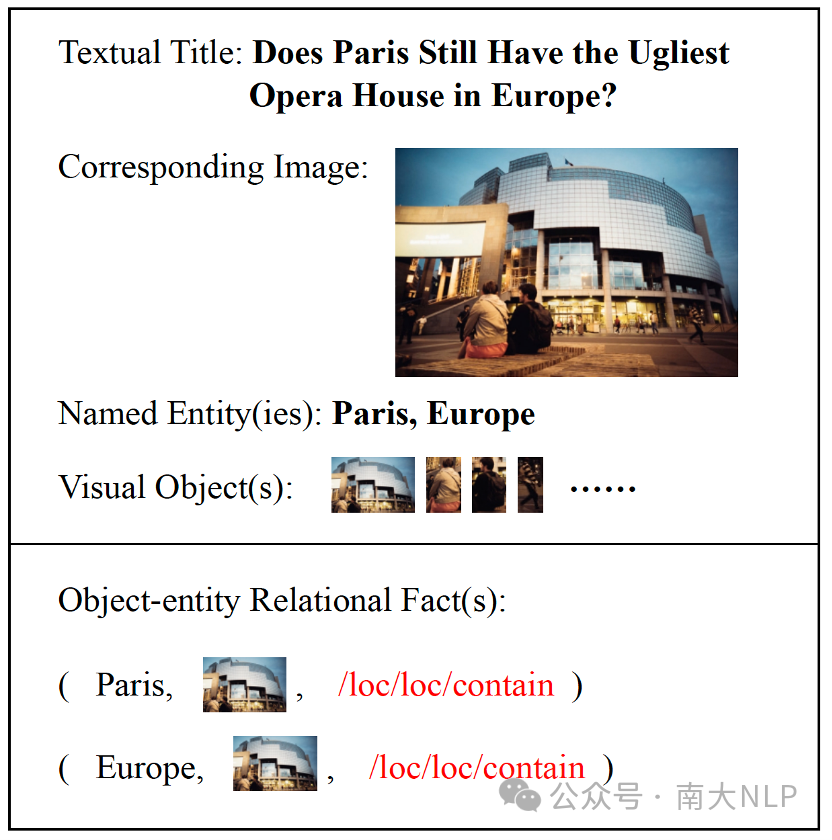

随着数据资源的丰富,许多研究人员开始探索从多模态数据中提取实体和预测它们之间的关系。如Zheng等人首次提出了多模态关系抽取(MRE)的概念,利用图像来辅助文本实体关系的识别。但是,在实际应用中,关系实体往往涉及多个模态,例如,一个实体可能出现在文本中,而另一个实体可能出现在图像中(为与文本实体相区别,下文都称为“视觉对象”或“对象”)。这样的情况需要准确地识别文本所指代的目标视觉对象,以便正确配对“对象–实体”并抽取新的关系事实。本文介绍了一个新任务,即多模态对象–实体关系抽取,旨在从图像和文本数据中提取对象–实体关系的事实。该任务的难点在于文本和图像中多个对象的语义对齐,尤其是这种语义对齐可能是隐式的。以新闻标题和配图为例,文本通常不是相应配图的直接说明,而配图中往往又包含多个对象,这使得识别文本所指代的对象更加困难。

为此,我们人工标注了一个名为MORE的多模态对象–实体关系抽取数据集,该数据集从3559对文本新闻标题和配图中,抽取了21种关系类型、13520个视觉对象和20264个多模态关系事实,每张图像平均有3.8个对象,每一条多模态关系事实都需要从文本中提取实体和从图像中提取对象(图1)。除了构建数据集外,我们将最新的MRE方法针对这个新任务进行了适配,结果表明现有方法在MORE上的性能都显著降低。因此,我们提出MOREformer来改进图像–文本的理解,以便更好地实现文本和图像中多个对象的语义对齐,包括属性感知的文本编码、深度感知的视觉编码和位置融合的多模态编码。

图1:MORE数据集中的一个例子

图1:MORE数据集中的一个例子

02

贡献

一个新的任务:提出了多模态对象–实体关系抽取任务,旨在从图像和文本数据中提取对象–实体关系的事实,弥补了传统任务对跨模态的对象–实体关系抽取的缺失,使得多模态关系抽取更贴近实际应用场景。

一个新的数据集MORE:该数据集从真实的新闻数据中通过人工标注抽取了大规模高质量的对象–实体关系事实,并充分体现出新任务的难点和挑战,能有效地验证模型的有效性。

针对新任务的挑战,我们提出MOREformer来探索将对象属性,深度和位置编码进行融合的新方法,并通过全面评估和深入分析,给出了多模态对象–实体关系抽取任务未来潜在的研究方向。

03

MORE数据集的构建

3.1数据采集

已有的MRE数据集主要从社交媒体采集数据,而我们选择使用新闻数据,因为新闻数据中的文本标题和配图通常都经过了编辑的精心选择,因此数据质量相对较高,而且新闻数据包含及时且信息丰富的知识。我们采集了2019年至2022年的纽约时报英文新闻和雅虎新闻。每条数据包含一个文本新闻标题和一张相应的新闻配图,涵盖了体育和政治等各个领域。在过滤掉不合格的数据(包括不相关的文本和图像、不包含任何实体的文本新闻标题以及不包含任何对象的图像)后,我们获得了一个包含15000篇多模态新闻数据的候选集。经过筛选后,我们确保该数据集与我们的研究目标相一致。

3.2数据标注

数据标注分为三个阶段:首先,自动识别文本新闻标题中的实体和图像中的对象,并人工审核和校对;其次,人工标注对象和实体之间的关系;最后,过滤文本中提到的重叠对象。

阶段1:实体识别和对象检测。我们利用AllenNLP命名实体识别工具来识别文本新闻标题中的实体并进行标记。此外,我们使用Yolo V5对象检测工具来检测对应新闻图像中的对象区域。考虑到两种工具都存在遗漏和错误的可能性,标注人员将对所有提取的对象和实体进行人工审核和校对,为了提高效率,我们针对性地设计和开发了标注审核和校对工具。

阶段2:对象–实体关系标注。我们聘用了具有专业知识背景的标注员来手动标注对象和实体之间的关系。每个样本均由至少两个标注员进行标注。为了确保无偏的标注过程,我们对关系进行了随机分配。每个标注员负责检查文本标题和图像,并推断对象和实体之间的关系。数据没有明确指示的预定义关系将被标记为none。存在差异或冲突的情况时,会请第三个标注员参与讨论以达成共识。

阶段3:实体–对象重叠数据过滤。为了聚焦多模态对象–实体关系抽取任务的核心问题,我们期望数据集中每条关系里的视觉对象是在文本新闻标题中未被提及的(避免在文本新闻标题中已经明确提到的实体关系)。为此我们移除了出现在文本新闻标题中的所有视觉对象。经过这个过滤流程后,数据集从原始的15000篇多模态新闻数据中抽取出了包括超过3000个新闻文章和超过20000个对象–实体关系事实的高质量数据。

3.3数据集分析

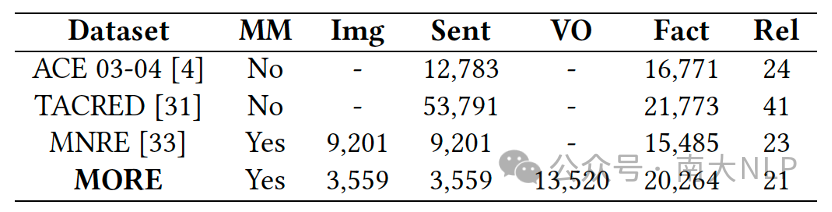

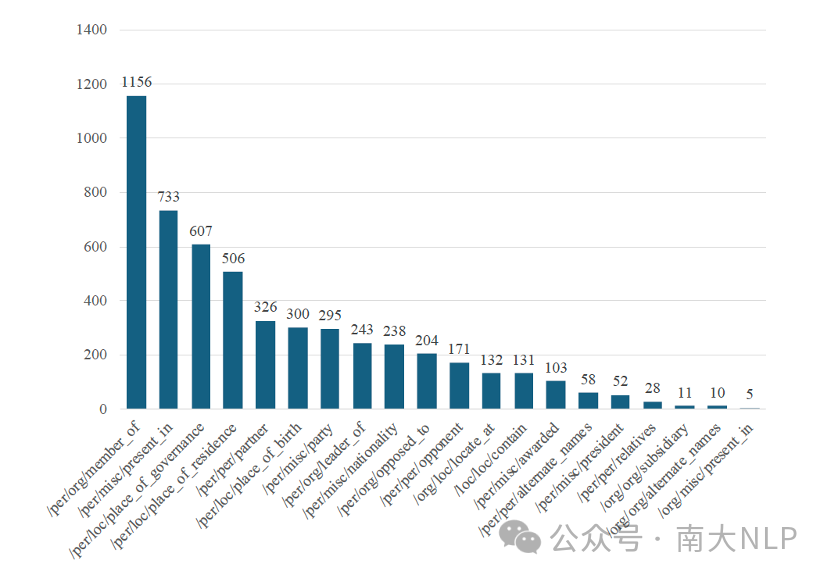

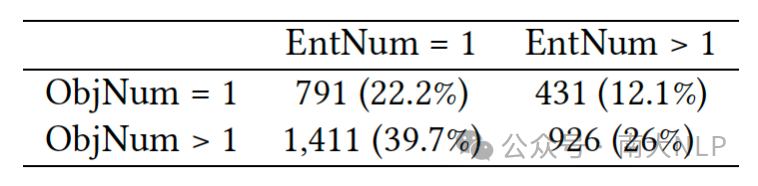

表1给出了数据集的统计信息,MORE的特点在于提供了丰富的视觉对象信息(平均每张图像有3.8个对象),关系类型分布的长尾现象也符合实际应用场景(图2),并且有高达77.8%的数据包含多个实体或者多个视觉对象(表2)。这些特点凸显了多模态对象–实体关系抽取任务的复杂性。

表1: 数据集统计信息

(MM:Multimodal,Img:images,Sent:sentences,

VO:visual objects,Rel:relations)

图2: 关系类型分布

图2: 关系类型分布

表2: 实体和对象分布

多模态关系抽取模型都需要具有对文本和图像的理解能力。除此之外,针对上述MORE数据集的特点,模型还需要能应对文本和图像语义不一致的问题,并具备多对象消歧的能力(multi-object disambiguation)。如图3所示,文本和图像之间语义上并非完全一致,文本通常并不是对图像的说明(caption),且每张图像都包含多个对象,但只有其中一部分是文本所隐式指向的。图3(a)需要将文本中的“Black Woman”与图像中每个对象的属性进行对齐,最终定位到前排左侧的女性。在图3(b)中,对象位置、深度和大小等信息可以帮助模型在文本没有提供任何线索时识别所需的对象。在图3(c)中,理解文本中的“goalkeeper”一词可以将右侧穿着蓝色衣服的第二名运动员确定为图像中的目标对象。最后,在图3(d)中,根据文本提供的信息(Opera House),图像中的建筑物才是目标对象,而不是图中的任何人物。

图3:MORE数据集中多对象消歧的例子,红框代表正确的对象

图3:MORE数据集中多对象消歧的例子,红框代表正确的对象

04

基准评估

我们选择了两类基准模型:多模态关系抽取(MRE)模型和视觉语言预训练(VLP)模型。BERT+SG将文本向量表示与由scene graph生成的视觉特征进行拼接。Bert+SG+Att 利用注意机制考虑图像和文本内容之间的语义相似性。MEGA设计了一种高效的图对齐方法,同时考虑图像和文本之间的结构相似性和语义一致性。IFAformer基于Transformer,并融合了前缀注意力增强机制。MKGformer是当前MRE任务的SOTA之一,其中M-Encoder模块可实现视觉Transformer和文本Transformer的多级融合。ViLBERT基于BERT拓展为多模态的双流模型,通过共同注意力Transformer层分别处理视觉和文本输入。VisualBERT是一个扩展了Transformer模型以适应视觉输入的单流网络。

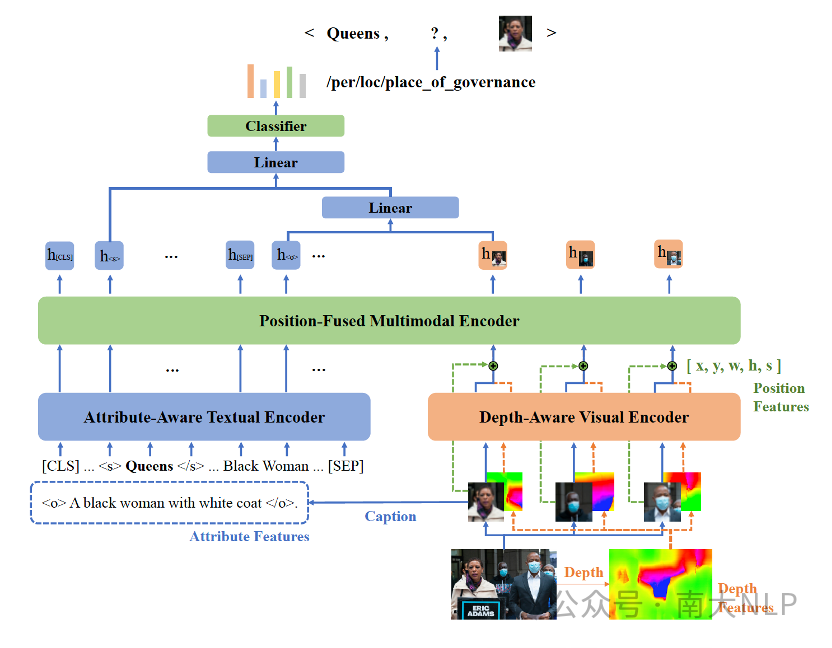

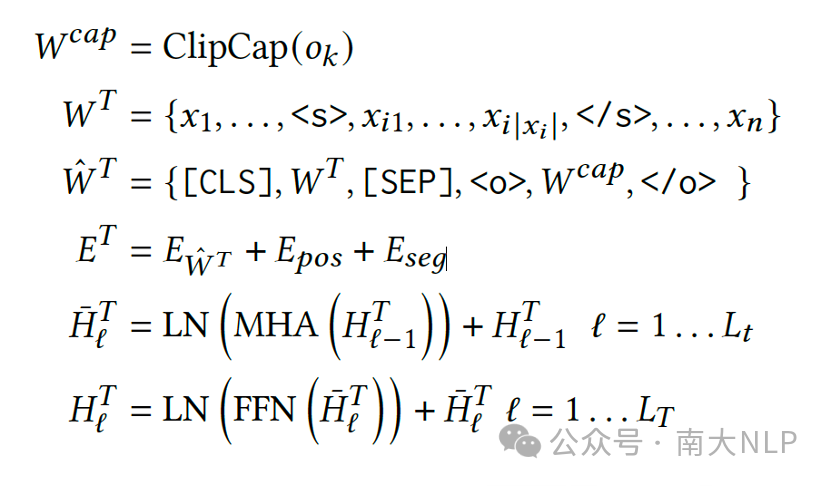

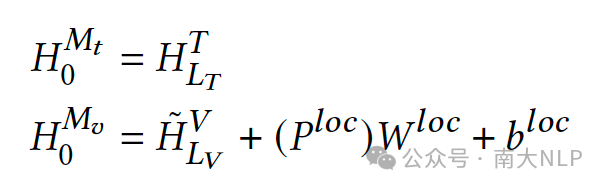

针对多模态对象–实体关系抽取任务,我们基于MKGformer设计了MOREformer,在MKGformer基础上融合了对象属性,视觉深度和位置编码等信息,增强模型对文本和图像中多个对象的语义对齐的学习(图4)。

图4:MOREformer框架示意图

图4:MOREformer框架示意图

Attribute-Aware Textual Encoder对文本中对象的属性和文本描述之间的关系进行建模。

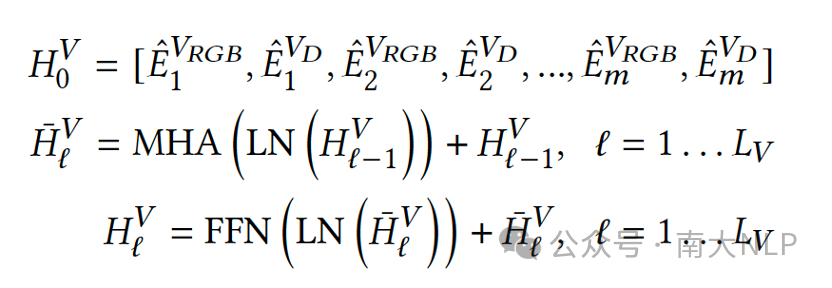

Depth-Aware Visual Encoder使用S2R-DepthNet获取整个图像的深度地图。从对应于每个对象的区域获取单独的深度图像。

Position-Fused Multimodal Encoder融合每个对象的RGB-D视觉特征和位置特征。

最终,我们将融合了深度和位置信息的图像特征和对应的属性词特征进行拼接作为对象的表示,再与实体表示进行拼接进行关系分类。

05

实验

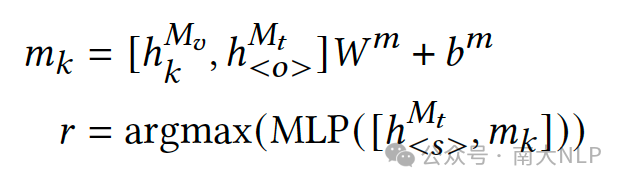

5.1总体实验结果

通过分析各模型在MORE数据集上的实验结果(表3),我们可以得出以下观察结论:1) BERT+SG,BERT+SG+Att和MEGA都是试图基于scene graph进行视觉到文本内容的映射。然而,MORE数据集中的新闻文本标题通常不是配图的直接说明,文本和图像之间的语义不一致会导致scene graph引入更多的噪声,从而导致这些模型在数据集上的表现较差。2) IFAformer和MKGformer作为MRE模型,利用细粒度的图文对齐来缓解由无关视觉信息引起的误差。与其他相关模型相比,它们在数据集上的性能有了大幅提升。3) VLP模型主要通过大规模数据的预训练学习不同模态之间的语义对应关系。显然,预训练有利于学习视觉和文本模态之间的细粒度语义对齐,从而显著提高了这项任务的性能。4) 我们提出的MOREformer则针对任务的特点进一步整合了诸如对象属性、深度和位置等信息,增强了模型捕捉图像和文本之间关系的能力,缓解了多目标歧义问题,显著提高了性能。

表3:总体实验结果

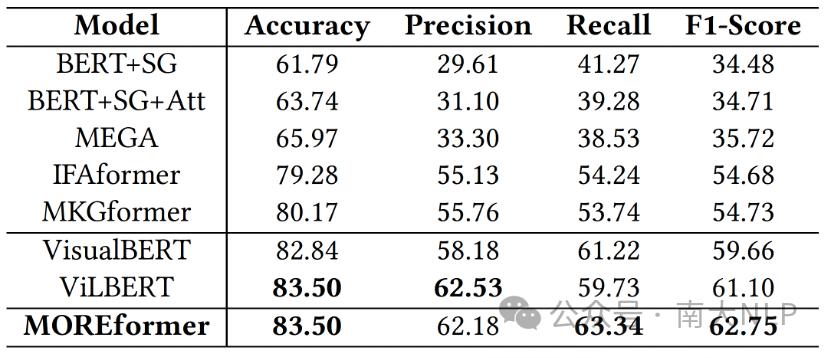

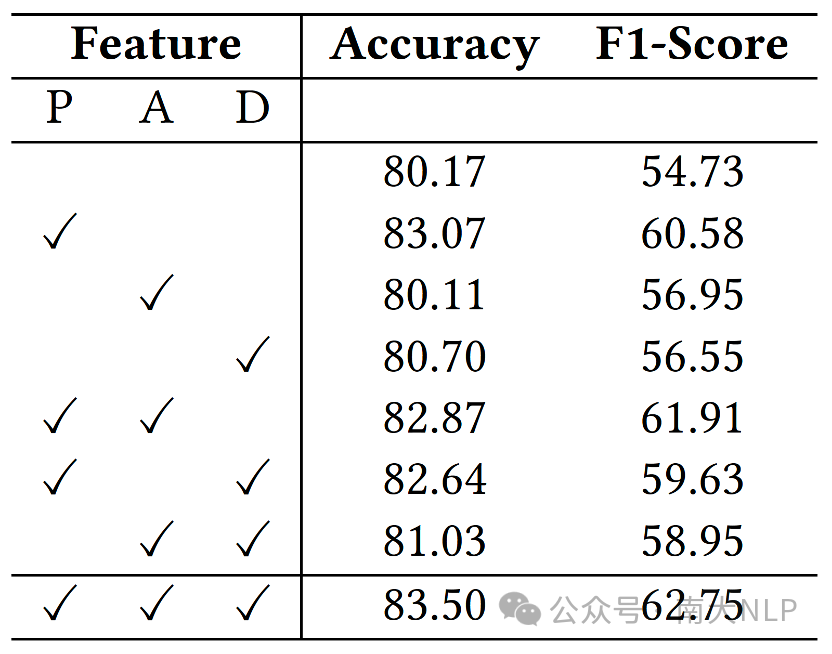

5.2消融实验

消融实验表明(表4),对象属性特征、对象的深度和位置等视觉特征,对模型性能都有积极的贡献,整合更多的特征可能会获得更好的性能。对象位置特征对模型性能的影响最显著,特别是在包含多个对象的图像中,因为目标对象常常占据图像相对中心的位置,仅通过位置信息即可实现对目标对象的准确识别。

表4: 消融实验结果(P表示位置,A表示属性,D表示深度)

5.3多实体/对象的性能表现

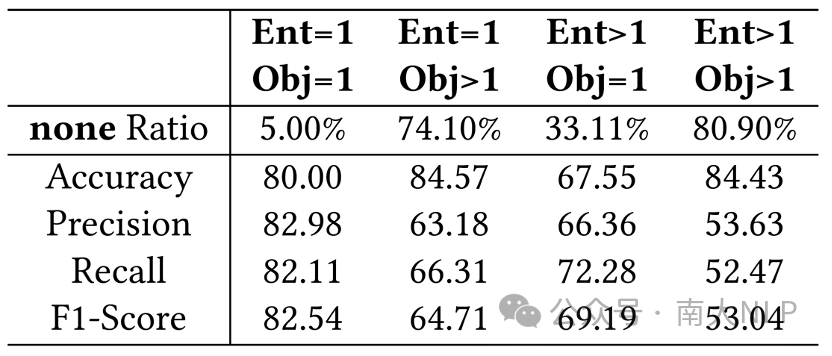

我们评估了模型在多实体和多对象的不同组合上的性能(表5)。实验结果显示,当文本中只有一个实体或者图像中只有一个对象时,模型性能较高。然而,随着实体或对象数量的增加,模型性能显著下降。当实体和对象都有多个时,模型性能最差。这表明,实体和对象数量的增加给模型在预测关系方面带来更大的困难,这也证明了MORE数据集的高难度。尤其需要注意的是,当图像中有多个对象时,模型的F1得分显著下降,而准确率仍然很高。这是由于数据集具有类别不均衡的特点,存在相当数量的none关系,导致模型准确预测了这些none关系,但缺少实际意义。因此,在处理包含多个实体和对象的数据时,模型需要克服过拟合none关系的挑战,以实现更好的性能。

表5: 多实体/对象的性能表现

5.4长尾关系分布上的性能表现

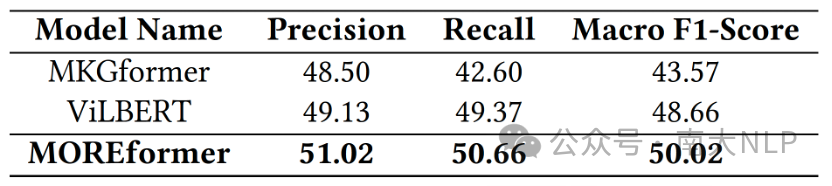

在实际情况下,数据经常呈现出长尾分布现象,MORE数据集中的关系也呈现出明显的长尾分布。因此,模型可能倾向于拟合大部分关系数据,而忽略长尾关系,导致macro-F1值偏低。我们使用macro-F1指标来全面快速地评估我们模型在长尾分布上的性能。实验结果表明(表6),尽管我们的模型优于基线模型,但所有模型在解决长尾关系方面的表现仍然不理想。因此,在此任务中,需要更有效的技术来应对长尾分布问题。

表6: 模型的Macro F1性能

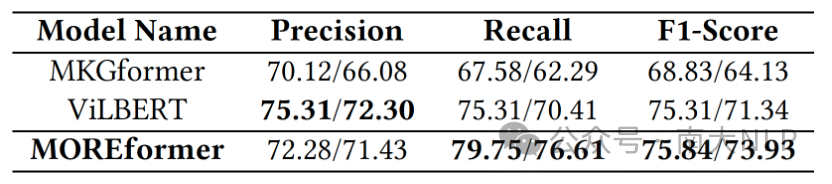

5.5文本和图像中多个对象的语义对齐性能

在MORE数据集中,平均每张图像包含3.8个对象,因此,消除多个对象之间的歧义是一个巨大的挑战。文本和图像之间的语义不一致进一步增加了多对象消歧的难度。我们在MORE数据集上评估了各模型在多对象消歧方面的性能,评估时假设如果预测的三元组的实体和对象是正确的,且预测的关系和标注结果均不为none,则该三元组被视为分类正确。结果如表7所示,我们的模型无论在全样本数据上还是在多对象样本数据上,都表现出了优于基线模型的性能,表明通过利用我们设计的特征信息,模型可以更好地识别图像中的目标对象。

表7: 多对象消歧性能

(每组数值分别表示:全样本上的性能/多对象样本上的性能)

06

总结

我们提出了一项新任务——多模态对象–实体关系提取,并相应地构建了一个高质量的大规模多模态关系抽取数据集——MORE。该数据集提供了丰富的视觉对象信息,关系类型分布的长尾现象也符合实际应用场景,并且需要模型具有多对象消歧能力,这些为多模态对象–实体关系抽取任务提出了更高的挑战。针对新任务的挑战,我们提出MOREformer来探索将对象属性、深度和位置编码进行融合的新方法,获得了较好的性能,并通过全面评估和深入分析,给出了多模态对象–实体关系抽取任务未来潜在的研究方向。

最新版论文:https://arxiv.org/abs/2312.09753

代码及数据:https://github.com/NJUNLP/MORE

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง