点击下方卡片,关注「AI视界引擎」公众号

视频定位的目标是找到与输入文本 Query 相关的视频中的一个空间-时间部分。本文通过引入一个开放词汇空间-时间视频定位任务,解决当前视频定位方法中的一个关键限制。与普遍的闭集方法不同,作者的模型利用基础空间定位模型的预训练表示,可以有效地弥合自然语言和多样化视觉内容之间的语义鸿沟,在闭集和开放词汇设置中都取得了强大的性能。作者的贡献包括一个新颖的空间-时间视频定位模型,在多个数据集的闭集评估中超越了最先进的结果,并展示了在开放词汇场景中的优越性能。

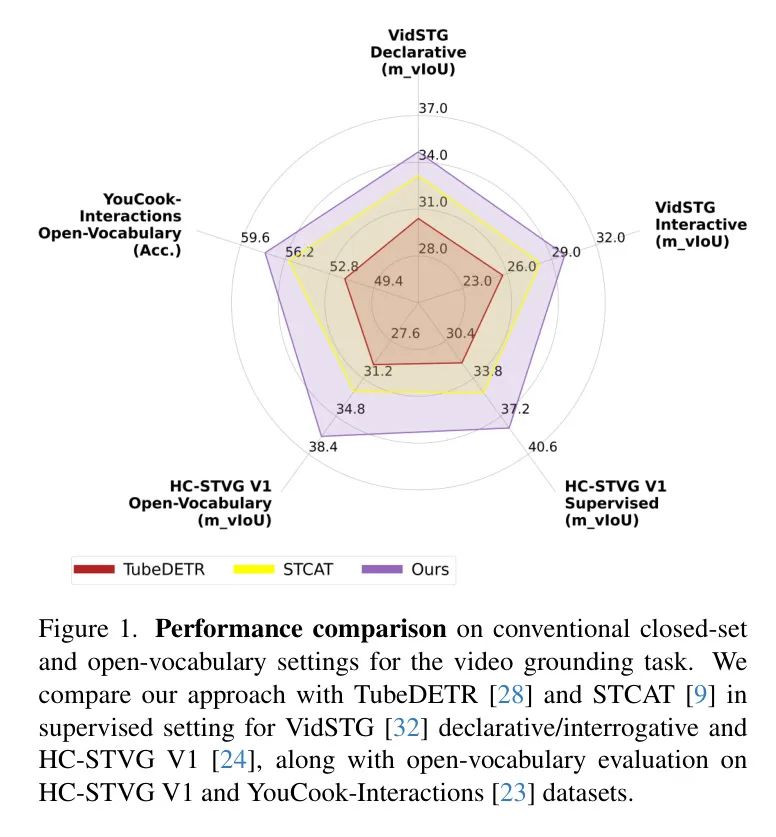

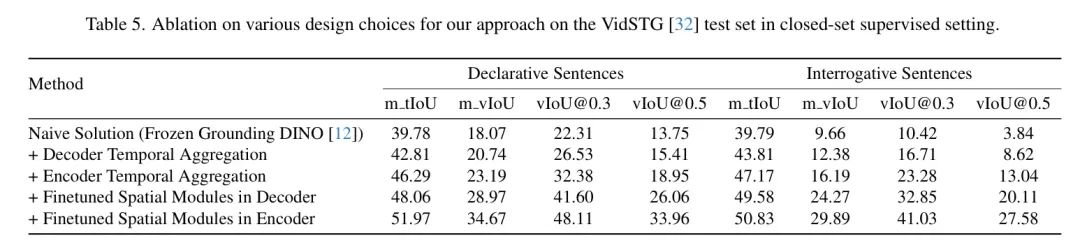

值得注意的是,该模型在VidSTG(陈述性和疑问性)和HC-STVG(V1和V2)数据集上的闭集设置中,超过了最先进方法的4.26 mvIoU和1.83%的准确性,展示了其在处理多样化的语言和视觉概念以提高视频理解方面的有效性。

代码:https://github.com/TalalWasim/Video-GroundingDINO

1 Introduction

空间-时间视频定位在将视觉内容与自然语言描述联系起来,从而在视觉数据中促进语义解释方面至关重要。目前视频定位的常见方法,如TubeDETR,STCAT,和STVGFormer,主要关注监督的闭集设置,其中模型在具有预定义词汇和精心标注的数据集上进行训练。尽管这些当前最先进的方法在VidSTG和HC-STVG等数据集上的闭集设置上表现出色,但它们在训练数据分布之外的泛化能力有限,这是一个重大的挑战。现有视频数据集的相对较小规模和有限样本多样性使模型难以有效地适应未见过的场景。

受限于监督闭集方法在词汇方面的固有局限性,本文研究了开放词汇空间-时间视频定位。与传统方法不同,这种范式解决了自然语言和视觉概念在野外无限多样性的挑战。目标是基于基础类别进行训练,并通过开放词汇性质的 Backbone 模型进行泛化,以应对未见物体/动作。本文探索了开放词汇视频定位所固有的挑战和机遇,为更强大和灵活的视频理解奠定了基础。

然而,训练一个有效的开放词汇视频定位模型需要一个足够大的数据集,其中包含丰富的自然语言表达和相应的空间-时间定位。这样一个广泛的数据集可以让模型学习通用的视觉和文本表示,并处理超出分布的样本。但是,视频定位数据集在规模上相当有限,例如,VidSTG只有5.4k个训练视频,80.6k个不同的句子。相比之下,图像定位模型GLIP使用了约2.65亿图像-文本对进行训练。

因此,研究探索了以下基本问题:如何在不要求大规模视频标注的情况下,使空间-时间视频定位模型在闭集和开放词汇场景中实现稳健的性能,并有效地泛化到训练数据集之外?

为了回答这个问题,作者从专注于空间定位的基础模型的成就中得到启示。这些模型在广泛的电影-文本数据集上进行训练,从而有效地泛化到给定目标分布的样本。作者打算利用这种预训练表示来增强作者的视频定位模型。作者提出的解决方案是一个采用DETR类似架构的空间-时间视频定位模型,通过时间聚合模块进行增强。

空间模块使用基础图像模型的预训练表示进行初始化。同时,图像和文本特征提取器保持冻结,而视频特定的空间-时间适应性通过可学习适配块进行建模。这种方法旨在保留基础模型的细微表示,从而增强作者的模型有效地泛化到新样本的能力。

作者的闭集和开放词汇结果的总结如图1所示,其中提出的方法在两种设置中都明显优于其他方法。作者的主要贡献如下:

请将前面这段文本出公式以外的所有内容翻译为中文,尽量不要删减内容,公式就原始输出公式,同时标题保持原有的形式不要改变,以及一些专有词汇也不进行翻译,诸如,Transformer、CNN等。

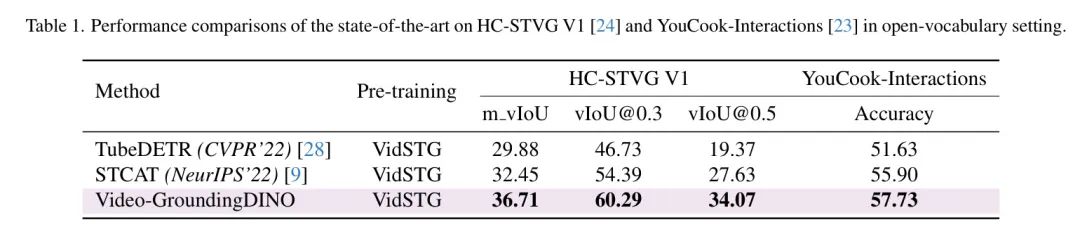

首次,在零样本的方式下,在HCV-STVG V1和YouCook-Interactions基准测试上评估了空间-时间视频定位模型在开放词汇设置中的性能。作者分别以4.26 m_vIoU和1.83%的准确率超过了最先进的方法TubeDETR和STCAT。

通过结合空间定位模型的优势和互补的视频特定 Adapter ,在四个基准测试(VidSTG(陈述性),VidSTG(疑问性),HC-STVG V1 和HC-STVG V2)上的闭集设置中始终优于以前的最先进方法。

2 Related Work

空间定位基础模型:最近的文章介绍了许多空间定位模型。GLIP [10] 通过一个语言图像预训练模型将目标检测和短语定位统一起来,利用大量的图像-文本对获得语义丰富的表示。Grounding DINO 结合了语言和基于 Transformer 的检测器,实现了一个开放集检测器,在COCO和ODinW等基准测试上表现出色。

Kosmos-1 和 Kosmos-2 贡献了多模态大型语言模型(MLLMs),具有零样本和少样本学习、语言理解和多模态任务等能力。Kosmos-2 特别地将定位集成到下游应用程序中,引入了 GrIT,这是一个大规模的带有定位的图像-文本对数据集。Shikra 通过处理输入和输出的空间坐标,解决了MLLMs的参考能力,展示了在各种视觉语言任务上的 promising 性能。Ferret 在LLM范式中统一了指代和定位,在经典的指代和定位任务上获得了优越的性能,在基于区域的视觉语言对话和图像描述方面表现出色。

最近,GLaMM 允许与LLM进行像素级定位的对话,展示了对多个标注和引用分割任务的 generalizability。然而,空间方法不能用于视频中的定位物体,这是一个由本文解决的问题。

空间-时间视频定位:几种方法针对未剪辑视频中的物体定位问题,基于 Query 句子进行处理。STVGBert 提出了一个阶段性的视觉-语言 Transformer ,同时进行空间和时间定位。TubeDETR 引入了一个基于 Transformer 的架构,以高效地建模时间、空间和多模态交互。增强的 2D-TAN 采用两阶段方法,通过一个具有时间上下文感知双向 LSTM 聚合模块增强 2D-TAN。

OMRN 解决了空间-时间视频定位中未对齐数据和多形式句子的挑战,提出了一种基于目标的多个分支关系网络,以实现有效的关系发现。MMN 引入了一个互匹配网络作为指标学习框架,实现时间定位,并取得了具有竞争力的性能。STCAT 是一个端到端的单阶段框架,解决特征对齐和预测不一致问题。

最后,STVGFormer 提出了一种有效的框架,包括静态和动态分支,用于跨模态理解。虽然上述方法在视频定位方面取得了进步,但由于受限制的视频数据集,它们的泛化到非分布和开放词汇样本的能力有限。为解决此问题,作者利用在大量图像文本数据集上训练的闭集视频定位基础模型的泛化表示,可以在闭集和开放词汇评估中取得良好的效果。

3 Methodology

正如上述讨论中所述,当前最先进的空间-时间视频定位方法主要在有监督的设置下在 VidSTG 和 HC-STVG 数据集上进行评估。然而,这些方法缺乏在非分布样本上进行良好表现所需的跨模态空间-时间理解。因此,这项工作的目标是实现改进的开放词汇性能,同时保持强大的闭集视频定位性能。

从最近的视觉-文本数据空间定位基础模型中获得灵感。这些模型在大量视觉-文本数据上进行训练,因此,对未见样本的泛化能力很强。作者打算利用这种基础模型的强大泛化能力来实现强大的开放集空间-时间视频定位性能。提出的空间-时间视频定位方法采用类似于 DETR 的设计,具有时间聚合和适应模块来学习视频特定的表示。

Problem Definition

空间-时间视频定位任务涉及通过整合空间和时间信息,在视频序列中定位和识别物体和动作。与仅关注单个帧内的物体或动作定位的空间定位不同,空间-时间定位将此概念扩展到包括时间维度。这意味着理解物体或动作在每帧中的位置以及它们如何随时间演变和移动。

考虑一个包含 个帧、 空间分辨率和 个通道的视频 以及一个文本提示 。空间定位问题可以定义为在帧 中,使用边界框 定位与提示 相关的一个或多个物体,其中 和 是边界框 的左上角坐标, 和 是边界框 的宽度和高度, 是帧 的物体数量。

另一方面,时间定位问题涉及理解物体或动作如何随时间演变。它旨在定位在整个时间持续期内发生特定动作/交互的时间间隔 ,其中间隔 表示物体在总帧数 内的发生时间段的开始和结束帧 ($1leq t_{s}<t_{e}leq t$)。因此,与提示=”” $p$=”” 相关的物体的空间-时间定位问题可以概括为与物体存在的一子集相关的空间-时间坐标集:$(x^{t}_{i},y^{t}_{i},w^{t}_{i},h^{t}_{i},t)$=”” 和=”” $tin{t_{s},…,t_{e}}$。间隔=”” $(t_{s},t_{e})$=”” 是一个子集,总帧数=”” $t$。<=”” p=””>

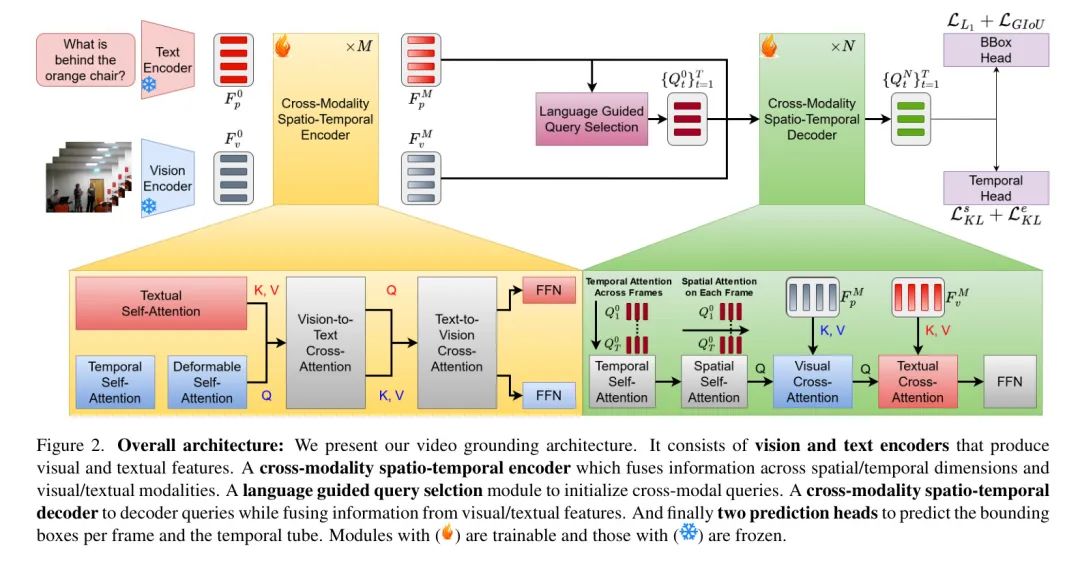

Spatio-Temporal Video Grounding

在这里解释视频定位模型在图2中的设计。如前所述,作者的目标是设计一个能够在闭集和开放词汇设置中表现良好的空间-时间视频定位模型。强大的开放词汇性能需要学习丰富的视觉/文本表示,这反过来又需要大量的训练数据。不幸的是,空间-时间视频定位数据集的规模相当有限,导致当前视频定位方法在将数据泛化到非分布样本方面表现不佳,因为它们缺乏所需的强视觉/文本表示。

为了解决这个问题,作者的方法受到最近的空间定位方法的启发,这些方法通过在大量图像文本语料库上进行训练,具有强大的开放词汇性能。作者可以利用这些模型的泛化表示来丰富从有限数量训练样本获得的视频定位方法较弱的表示。作者的方法旨在利用空间定位方法的强大预训练表示来实现强大的闭集监督和开放词汇视频定位性能。作者的空间-时间视频定位方法基于最先进的基于DETR的目标检测框架DINO 以及从Grounded Language-Image Pre-training (GLIP) 和Grounding DINO 借用的图像-文本对齐和定位概念。

从 Backbone 视觉和文本编码器 和 中提取初始特征。然后,模拟帧间和帧内特征,并在跨模态时空编码器(Sec. 3.2.1)中学习跨模态视觉/文本关系。通过跨模态时空编码器,得到丰富的跨模态特征,用于初始化每个帧的 Query 。这些 Query 随后通过在空间/时间维度上聚合信息并注入来自丰富的视觉/文本上下文的交叉注意力进行解码,预测每个帧的边界框和时间定位开始/结束帧。

给定视频 和文本提示 作为描述,从视觉编码器 和文本编码器 分别获得每帧特征 和文本特征 。视觉编码器基于 Swin Transformer,文本编码器定义为 BERT 模型。与其他基于 DETR 的检测器一样,图像特征是从多个尺度的视觉编码器块中提取的。然后,这些特征被传递到跨模态时空编码器。

3.2.1 Cross-Modality Spatio-Temporal Encoder

因此,作者进一步通过跨模态时空编码器编码初始特征,以模拟跨帧的时间信息并学习跨模态特征。

在 层编码器中的每一层,首先对视觉特征 沿时间维度应用多头自注意力(),然后对空间维度应用变形注意力。这是为了在帧内建模关系和在帧间建模时间关系。同样,作者对文本特征 应用 。这如图 1 所示。

其中, 和 是第 层的视觉和文本输入特征, 和 是第 层的视觉和文本中间特征表示,, 和 是第 层的空间-变形、时间和平行自注意力。在初始的空间、时间和文本注意力之后,作者在视觉和文本模式之间融合特征,就像在 GLIP 中一样。

更具体地,使用投影的中间特征 和 计算联合视觉-文本注意力 。然后,这种注意力与中间特征 和 一起,用于计算图像-文本和文本-图像交叉注意力,如图 2 和 3 所示。

在第 层, 和 分别表示视觉和文本特征的 Query 投影。

在第 层, 和 分别表示编码器中第 层的最终输出特征, 和 分别是视觉和文本的前馈网络(FFN),而 和 是线性层,用于将视觉和文本特征投影。在第 层的最终编码特征被用于初始化跨模态 Query 。

3.2.2 Language-Guided Query Selection

该模块旨在选择与输入文本相关的特征作为解码器 Query 以实现语言-视觉融合的有效性。作者将 DETR/DINO 风格的 Query 与正弦波时间位置编码相结合,将位置部分添加到 Query 中。正弦波位置编码添加到 Query 的位置部分,可以提供有关帧序列顺序的重要上下文信息,从而提高时间相关性和定位。

Query 选择模块将编码器的视觉和文本特征作为输入,并输出 个索引,这些索引对应于每帧目标检测的最相关特征,即 ,其中 是帧 的初始 Query 。模块使用选择的索引和动态 Anchor 框的组合来初始化解码器 Query 。Query 的内容部分在训练期间设置为可学习,而位置部分则使用使用编码器输出的初始化动态 Anchor 框计算。作者还向 Query 的位置部分添加了正弦波时间位置编码。

3.2.3 Cross-Modality Spatio-Temporal Decoder

为了将上述 Query 解码为边界框位置和时间开始/结束管,作者需要将它们转换为输出嵌入,然后将其输入到预测头中。解码器允许 Query 在帧内全局与其他交互,同时利用整个视觉和文本特征作为上下文。

正式地,之前产生的 Query 被输入到 层解码器。每个层开始时都有一个时间自注意力,然后是一个空间自注意力,接下来是视觉交叉注意力和文本交叉注意力,最后是一个前馈网络。这如图 4 所示。

在第 层, 是输入 Query , 是第 层的空间和时间注意力后的中间 Query , 是第 层的输出 Query , 和 是第 层的视觉和文本交叉注意力。交叉注意力在公式 5 中进一步详细说明。

在第 层解码器中,, 和 分别表示视觉 Query 、键和值投影,, 和 分别表示文本 Query 、键和值投影。第 层解码器产生的最终 Query 用于预测。

3.2.4 Prediction Heads

解码器输出每帧的 refined Query 。作者遵循标准的 DETR 类似边界框回归头,实现为多层感知机(MLP),预测每帧的边界框 。为了预测时间间隔 $(t_{s},t_{e})|{1leq t_{s}<t_{e}leq t}$,作者在边界框回归头旁边添加了一个时间定位头,实现为=”” mlp,类似于现有工作=”” [9,=”” 28]。<=”” p=””>

新的头预测了间隔的开始 和结束 的概率。在推理过程中,计算起始和结束间隔,方法是取 的联合分布的最大值。任何与 不合法的组合都被屏蔽。

Loss Function

为了利用空间定位基础模型的泛化预训练表示,从头开始初始化所有空间模块和交叉注意力,使用 Grounding DINO 空间定位模型。为了在确保下游任务有效建模的同时保留这个泛化表示,冻结了视觉和文本编码器 和 ,并微调剩下的组件。

在训练期间,模型接收一个批次包含视频 和文本提示 的视频。真实的标注包含边界框序列 ,以及相应的开始和结束时间戳 。对于空间定位,遵循 DETR 所使用的标准损失函数,即 损失 和广义交集与并集(GIoU)损失 。正式地,空间定位损失 定义在公式 6 中。

对于时间定位,生成两个一维高斯热映射 ,分别表示开始和结束位置。因此,时间定位损失因此定义在公式 7 中,如下所示:

在这里, 和 分别表示开始和结束分布的 KL 散度损失。

请注意,在推理期间,模型输出边界框和开始/结束分布。通过选择具有最大联合开始和结束概率的段来确定时间定位段 。然后,仅考虑该管内的边界框进行空间定位。

4 Results

Experimental Setup and Protocols

4.1.1 Implementation Details

正如在方法(第3节)中所讨论的,从 Grounding DINO 空间定位模型中初始化作者的模型中的空间模块,并保持视觉和文本编码器冻结。空间和时间预测的预测头都设置为 3 层多层感知机(MLP)。在训练和推理期间,采样 128 帧,将其缩小到较短边分辨率为 448。将 M 和 N 都设置为 6,并使用批量大小为 8 和学习率 1e^-4 进行训练,如果有 10^-4 的权重衰减。对于 VidSTG,设置 epoch 为 10,对于 HC-STVG V1/V2,设置 epoch 为 90。

4.1.2 Evaluation Settings

作者在作者的视频定位模型中评估了两种设置,即开放词汇和闭集监督。

在开放词汇评估中,在 VidSTG 数据集上训练作者的模型,然后将其评估在两个不同的数据集上,分别是 HC-STVG V1 和 YouCook-Interactions,以了解模型对新分布的泛化能力。选择这两个数据集的原因是,前者与训练数据集 VidSTG 中的视角和物体相似,因此提供了相对较小的分布移动。相比之下,后者提供了重大的分布移动,包括视角和标注物体的变化。

在闭集监督评估中,在训练集上训练模型,并评估每个数据集的相应验证/测试集。这种评估方法针对的是在空间-时间视频定位中广泛使用的三个主要数据集,即 VidSTG,HC-STVG V1 和 HC-STVG V2。

4.1.3 Datasets

评估作者的方法,并将其与最先进的 state-of-the-art 进行比较,在两个设置中进行:开放词汇和闭集监督,横跨总共四个定位数据集,即:VidSTG,HCSTVG V1,HCSTVG V2 和 YouCook-Interactions。

VidSTG: VidSTG 数据集是从 VidOR 数据集中派生而来的,包含目标关系标注。它包括 99,943 个视频-文本对,包括 44,808 个陈述性句子 Query 和 55,135 个疑问性句子 Query 。训练、验证和测试集分别包含 80,684 个句子和 5,436 个视频。VidSTG 的文本 Query 仅限于描述 VidOR 中预定义的目标/关系类别。

HC-STVG V1/V2: HC-STVG 数据集来源于电影场景,每个视频片段大约20秒。由于视频片段中有多个人参与相似的动作,这些数据集在空间-时间定位方面具有挑战性。HC-STVG V1 包括 4,500 个训练和 1,160 个测试的视频-文本对。HC-STVG V2 扩展了 HC-STVG V1,增加了训练、验证和测试的样本数量,分别为 10,131、2,000 和 4,413。由于 HC-STVG V2 的测试集标注不可公开,因此结果报告在验证集上。

YouCook-Interactions: YouCook-Interactions 数据集是针对烹饪指示的 YouCook2 数据集的扩展。这个扩展包括6000个精心选择的帧,通常涵盖对应句子级标注中的手和工具的边界框。评估围绕使用这个数据集来检查模型的空间定位能力。

Experimental Results and Analysis

4.2.1 Open-Vocabulary Evaluation

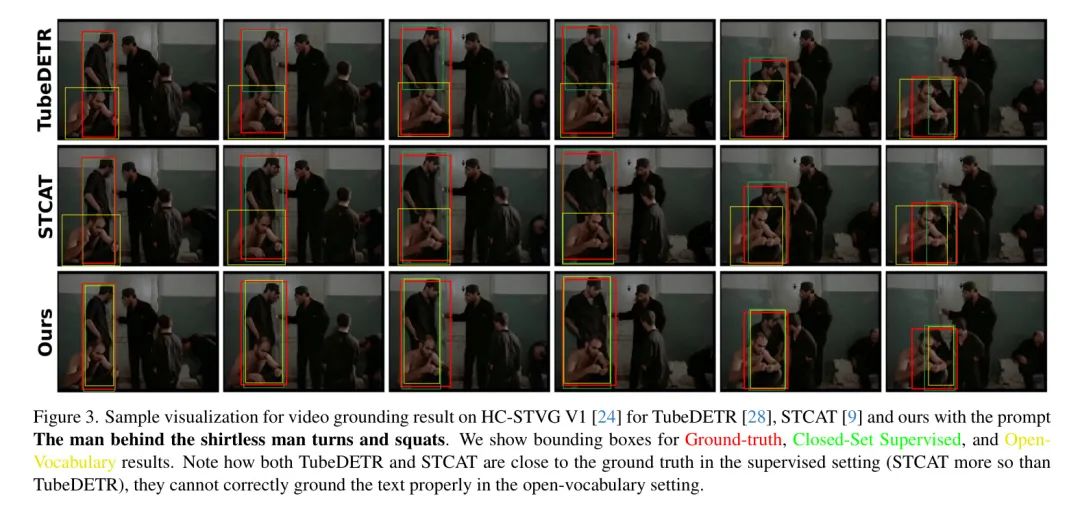

对于开放词汇评估,在 VidSTG 上进行训练,并呈现了 HC-STVG V1 和 YouCook-Interactions 的结果。结果汇总在表 1 中。

HC-STVG V1 结果: 报告了在 m_vIoU,vIoU@0.3 和 vIoU@0.5 上的开放词汇评估,以及相对于封闭集监督评估的准确性减少。在 TubeDETR 和 STCAT 上实现了最先进的性能。

归因于作者设计的强大性能,该设计利用了一个空间定位基础模型的强大预训练通用特征。

YouCook-Interactions 结果: 进一步在 YouCook-Interactions 数据集上评估作者的方法,报告了空间定位的 pointing game 准确性。作者的方法在 STCAT 上取得了近 2% 的准确性提升,与 TubeDETR 相比超过了 6% 的提升。这进一步展示了作者在开放词汇设置下的强大泛化能力。

4.2.2 Closed-Set Supervised Evaluation

作者在三个数据集上进行了封闭集评估,分别是 VidSTG,HC-STVG V1 和 HC-STVG V2。

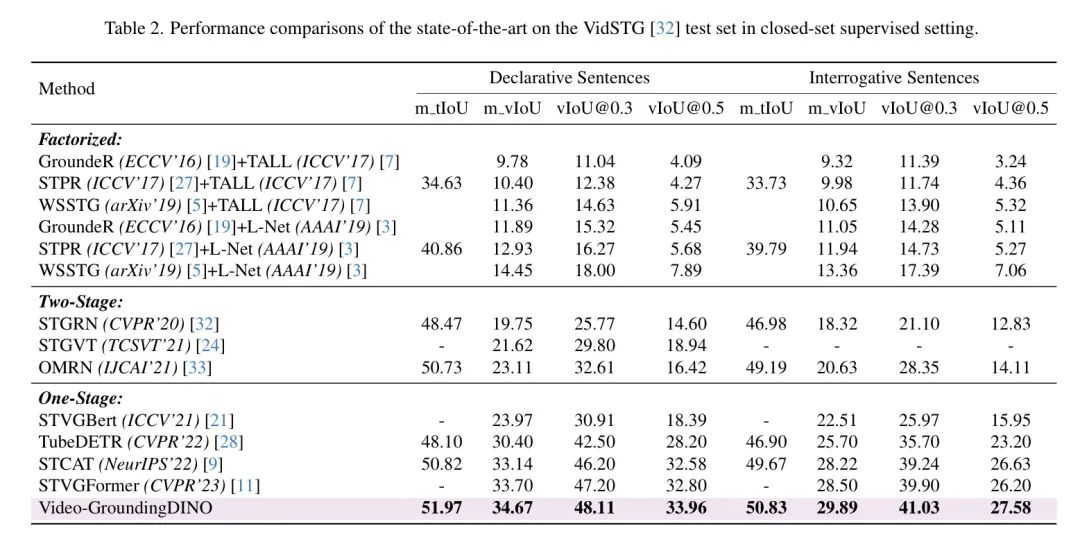

VidSTG 结果: 在 VidSTG 测试集的封闭集设置中报告了 m_tlOU,m_vlOU,vIoU@0.3 和 vIoU@0.5 的结果,如表 2 所示。结果表明,作者的方法在比较 Two-Stage 和 One-Stage 方法方面,在时间定位方面达到了最先进的性能。

特别是,在陈述性和疑问性句子的时间定位方面,比之前的最佳方法 OMRN(_One-Stage_)和 STVGFormer(_Two-Stage_)实现了超过 1 个单位的性能提升。

同样,对于 m_vlOU,vIoU@0.3 和 vIoU@0.5,作者在状态最先进的 STVGFormer 和 STCAT 方法上实现了超过 1 个单位的性能提升。请注意,作者的方法使用了冻结的视觉和文本编码器。相比之下,上述提到的所有最先进的状态最先进方法都训练了整个编码器。

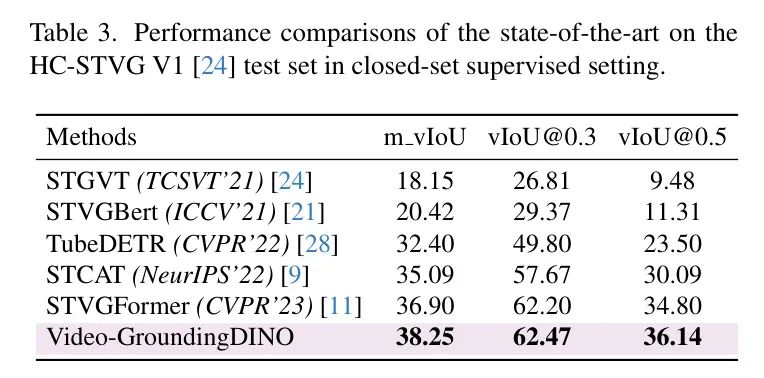

HC-STVG V1 结果: 在 HC-STVG V1 数据集上报告了 m_vlOU,vIoU@0.3 和 vIoU@0.5 的结果,如表 3 所示。在 m_vlOU 和 vIoU@0.5 上实现了近 1.5 个单位的性能提升,并在 vIoU@0.3 上实现了 1 个单位的性能提升,超过了之前最佳方法 STVGFormer。这表明作者的方法在具有挑战性的这个数据集上表现一致。

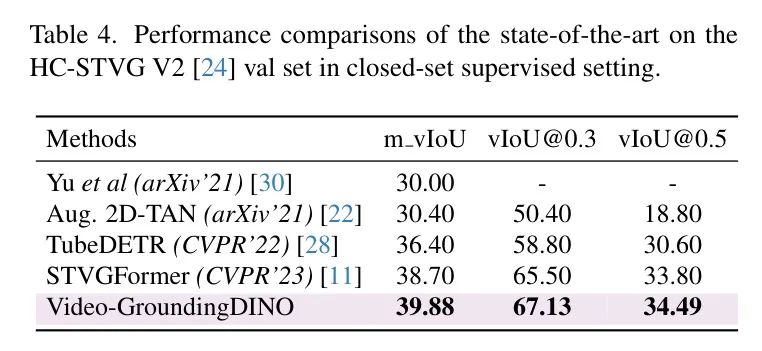

HC-STVG V2 结果: 在 HC-STVG V2 数据集上报告了 m_vlOU,vIoU@0.3 和 vIoU@0.5 的结果,如表 4 所示。性能提升也体现在 HC-STVG V2 上,与 STVGFormer 和 TubeDETR 相比,在 HC-STVG V2 上也保持了一致的性能提升。

Ablative Analysis

作者对模型的各种设计选择进行了消融分析。特别地,首先评估了一个简单的 Baseline ,其中没有添加额外的时空聚合模块,并且在编码器和解码器中冻结了所有预训练的空间模块。这个 Baseline 在时空定位方面相对较弱。接下来在解码器中添加了时空模块,然后又添加到编码器中。作者发现这显著提高了时空定位,同时也提高了空间定位。最后,在解码器和编码器中微调了预训练的空间模块,这提供了在空间定位上的强烈改进,同时时空定位也保持了一致的改进。

Limitation

虽然作者的视频定位模型在闭集和开放词汇场景中表现出色,但它利用了像 Grounding DINO [12] 这样的图像文本预训练模型。为了在开放词汇设置中增强理解,像 CLIP 这样的更大且更多样化的视频语言预训练数据集的扩展可以帮助进一步提高性能。

构建一个包含多种自然语言表达和空间-时间定位的全面视频语言预训练数据集至关重要,因为像 VidSTG 和 HC-STVG 这样的数据集存在当前的约束。未来的努力可以探索创建一个大规模的视频语言定位数据集,使模型能够学习通用的视觉和文本表示,从而提高对非分布样本的适应性。

5 Conclusion

本文提出了一个开放词汇空间-时间视频定位任务,通过利用预训练的空间定位模型来解决当前方法学的限制。所提出的模型在闭集和开放词汇场景中表现出色,在像 VidSTG 和 HC-STVG 这样的数据集上超过了最先进的结果。

通过可学习的 Adapter 模块进行视频特定适应,它有效地弥合了自然语言 Query 和视觉内容之间的语义鸿沟。这项研究有助于理解开放词汇挑战,并为多样化的视频解释技术奠定了基础。

参考

[1]. Video-GroundingDINO: Towards Open-Vocabulary Spatio-Temporal Video Grounding

点击上方卡片,关注「AI视界引擎」公众号

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง