AI对齐:法典的类比

如果请你编写一部无所不包的法典,并且这部法典将雷打不动、不经修改地生效一百年,你有多大信心能够给出一个完善的方案?

这想必会遇到诸多困难,包括但不限于:

错误规范(Misspecification):

你所设想出的法条虽然看似完善,但可能存在很多隐含的漏洞。当有人试图利用钻法条的空子时,会发现存在许多可乘之机。这可以看作是经济学中古德哈特定律(Goodhart’s Law)的体现——任何评价指标一旦被作为优化目标,就不再是好的评价指标(这里我们把 “遵从法典” 视为一个评价指标),这是因为相关性不代表因果性,故对一个与真实目标具有相关性的 “代理目标”(proxy goal)施以优化,很可能因因果关联的缺失而导致相关性的消失。

错误泛化(Misgeneralization):

你对这部法典的构思,发生在你对当下世界的理解框架下,因此它不可避免地以当下世界中的概念为基础、并依赖于诸多在当下世界中成立的假设。因此,若把法典视为从行为到合法性的预测模型,那么一百年后它将会在分布外运作。如果百年后世界在一些重要方面与当今世界有本质不同,则法典中的一些内容可能变得完全不合理,从而给出完全不合理的合法性判断。

自致的分布偏移(Auto-Induced Distributional Shifts):

法典本身的内容会对世界的发展轨迹造成影响,因此前述的分布外情形的出现,甚至有可能正是其自身造成的。这意味着,在编写这部法典时,我们或许不应把世界轨迹看作一个给定的量,而应从互动的角度来刻画这一问题。

道德不确定性(Moral Uncertainty):

法典的编写必定涉及道德判断,故一定是特定于一组具体的价值观的。然而围绕道德议题的辩论从古至今从未停息过,就连专精于此的伦理学家也几乎不能就任何问题达成一致。这种情况下,怎样的道德判断是合理的,是一个很难回答的问题。

AI对齐:实际中试图解决的问题

在当下和未来, “AI 对齐“ 指的是让 AI 系统(包括能力超越人类的 AI 系统)的优化目标与人类意图、人类价值观相匹配,而它所要解决的正是上述这些问题[1]。所有这四种困难,在给当下和未来的 AI 系统设定目标时,都已经出现或可能会出现。一些例子如:

目标错误规范(Goal Misspecification):

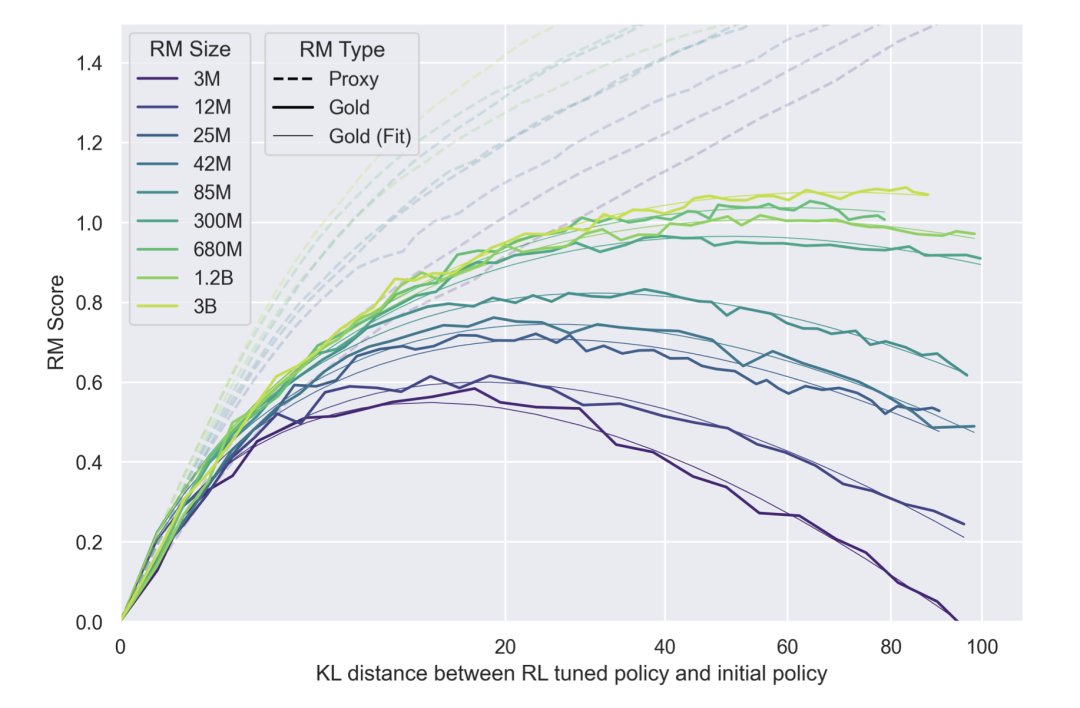

这一类的例子在各类游戏和仿真环境中较为常见,甚至有一个网页专门维护了一系列此类案例[2]。一个较新的例子是大语言模型的恶言恶语行为——这些行为往往从训练集中的恶语习得,体现了训练集这一目标规约(goal specification)的不理想之处。不过这类恶言恶语只是从数据中被动习得坏行为,如果大语言模型的训练流程被与强化学习一类的主动规划和执行能力结合,则可能带来更为主动的 “钻漏洞” 行为。与之相关的另一例是大语言模型中的奖励过度优化(Reward Overoptimization)现象:若大语言模型的对齐训练采用习得的人类偏好模型为优化目标,则优化到一定程度后,与真实人类偏好的吻合程度会随训练而下降[3]——还记得古德哈特定律吗?

目标错误泛化(Goal Misgeneralization):

优化目标的错误泛化在游戏和仿真环境中也时有出现,也同样出现了维护此类案例的数据库[4]。而在大语言模型的 Scaling Laws 盛极一时的现在,一个受到较多担忧的可能性是从“人类可有效监督”情景到“人类难以有效监督”情景的泛化过程中,是否会出现优化目标的表征的错误泛化。易见监督训练只能发生在前者情境下,故后者将会依赖于分布外泛化。已经出现的错误泛化早期征兆包括大语言模型的“谄媚”倾向,即迎合用户观点的倾向——证据表明这很可能是在对齐训练中,人类监督者易受谄媚影响的倾向所致[5]。

自致的分布偏移:

这方面的研究尚处于早期阶段[6],但一些受到关注的问题包括推荐系统与用户之间形成的反馈回路 ,和大语言模型与互联网文本之间形成的反馈回路[7]。

道德不确定性:

有关自动驾驶场景下的道德问题讨论、AI 系统中偏见与歧视的讨论,都是该问题的已有案例。随着 AI 系统在社会中日渐广泛的应用,AI 的道德判断的影响范围和影响程度可能还将大幅扩大。从更高的角度看,价值分歧的博弈刻画等问题,都是这一问题中值得考虑的对象。

AI对齐的“控制论进路”

基于人类反馈的强化学习(Reinforcement Learning from Human Feedback, RLHF)是至今为止,AI 对齐中毫无争议的最主流、最成熟的算法之一。它的思路是先从人类数据习得一个人类偏好模型,再以该偏好模型为优化目标,对大语言模型用强化学习作微调。

这一算法其实代表了 AI 对齐中两种主要的思路之一,不妨称之为“控制论进路”。这种思路假定,AI 系统所真正应对齐的目标,其对人类而言是清晰明了的,而问题仅在于有效地确保这一目标被 AI 所执行,确保错误规范和错误泛化都不会发生。

这一进路的优势在于它的简洁性,通过把问题的范围缩小而获得了更高的实际可行性——RLHF 这一最成熟方法归属于这一类进路,这绝不是巧合。但同时,它也忽略了人类自己对于目标和价值观的分歧、不确定性、随时间演化等特性,并且把被控制者(AI 系统)与控制者(人类)置于对抗的关系下,这对于控制能力强于人类的 AI 系统是不利的。

AI对齐的“博弈论进路”

合作逆强化学习(Cooperative Inverse Reinforcement Learning, CIRL)是另一类方法中的代表[1][8]。它的核心思想是,把人类与 AI 系统视为同一环境中的两个平等行动者,二者共享一个目标(即奖励函数),但只有人类能获得奖励信号,而 AI 系统则只能从人类行为中推断奖励函数的内容 —— 即 “人类到底想要什么” 。并且,因为 AI 始终持有对奖励函数的不确定性,人类作为信息来源的重要性意味着 AI 误导和操纵人类的动机将会降低(但不一定消失)。

这一方法,本质上是通过将人类与 AI 系统置于合作的关系中,以减少二者对抗的动机。

除了该方法外,与社会选择理论(Social Choice Theory)、博弈论等结合的一些其他 AI 对齐方法,则有着不同的优点[9]。它们通过显式地刻画不同行动者之间目标和价值观的冲突,使得我们可以直面道德不确定性、复杂社会互动等困难问题。

另一方面,这类方法较高的复杂程度,也意味着它们的工程可实现性也往往较低。如何能将这些方法使用在实际规模的 AI 应用上,是一个亟待解决的问题。

参考文献

[1] Ji, J. et al. (2023). AI Alignment: A Comprehensive survey. arXiv. https://doi.org/10.48550/arxiv.2310.19852

[2] https://docs.google.com/spreadsheets/d/e/2PACX-1vRPiprOaC3HsCf5Tuum8bRfzYUiKLRqJmbOoC-32JorNdfyTiRRsR7Ea5eWtvsWzuxo8bjOxCG84dAg/pubhtml

[3] Gao, L., John, S., & Hilton, J. Scaling laws for reward model overoptimization. ICML 2023. https://dl.acm.org/doi/10.5555/3618408.3618845

[4] https://docs.google.com/spreadsheets/d/e/2PACX-1vTo3RkXUAigb25nP7gjpcHriR6XdzA_L5loOcVFj_u7cRAZghWrYKH2L2nU4TA_Vr9KzBX5Bjpz9G_l/pubhtml

[5] Perez, E. et al. Discovering Language Model Behaviors with Model-Written Evaluations. Findings of the Association for Computational Linguistics: ACL 2023. https://doi.org/10.18653/v1/2023.findings-acl.847

[6] Krueger, D. A., Maharaj, T., & Leike, J. (2020). Hidden Incentives for Auto-Induced Distributional Shift. arXiv. https://doi.org/10.48550/arxiv.2009.09153

[7] Taori, R., & Hashimoto, T. (2022). Data feedback loops: model-driven amplification of dataset biases. arXiv. https://doi.org/10.48550/arxiv.2209.03942

[8] Hadfield-Menell, D., Russell, S., Abbeel, P., & Dragan, A. D. Cooperative inverse reinforcement learning. NeurIPS 2016. https://dl.acm.org/doi/10.5555/3157382.3157535

[9] Critch, A., & Krueger, D. W. (2020). AI Research Considerations for Human Existential Safety (ARCHES). arXiv. http://export.arxiv.org/pdf/2006.04948

文 | 邱天异

图 | 朱成轩

— 版权声明 —

本微信公众号所有内容,由北京大学前沿计算研究中心微信自身创作、收集的文字、图片和音视频资料,版权属北京大学前沿计算研究中心微信所有;从公开渠道收集、整理及授权转载的文字、图片和音视频资料,版权属原作者。本公众号内容原作者如不愿意在本号刊登内容,请及时通知本号,予以删除。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง