点击下方卡片,关注「AI视界引擎」公众号

随着深度学习技术的迅速发展,行人重识别(ReID)已经取得了显著的性能改进。然而,大多数先前的研究传统上主要通过从单一视角提取特征来解决问题,例如均匀分区、Hard注意力机制或语义掩码。

虽然这些方法在特定情境下有效,但在多样化场景下则不足。在本文中提出了一种新颖的方法,称为互学学习用于行人重识别(称为MDPR),它从多个视角在单个统一模型中解决这个具有挑战性的问题,利用互学的力量集体增强特征表示。

具体而言,MDPR包括两个分支:一个Hard Content分支通过均匀的水平分区策略提取局部特征,一个Soft Content分支通过精心设计的注意力机制动态区分前景和背景,并促进多粒度特征的提取。为了促进这两个分支之间的知识交流,采用互学和融合过程,提高每个分支的输出能力。

在广泛使用的行人重识别数据集上进行了大量实验,以验证MDPR的有效性和优越性。值得注意的是,MDPR在DukeMTMC-reID数据集上实现了令人瞩目的mAP/Rank-1,达到88.7%/94.4%。

源代码:https://github.com/KuilongCui/MDPR

I Introduction

行人重识别(ReID)旨在在不同摄像机下重新识别感兴趣的人。由于其在公共安全、监控和社会媒体分析等领域的广泛应用,它在计算机视觉和机器学习领域引起了大量关注。行人重识别是一个具有挑战性的问题,因为存在姿态变化、光照变化、遮挡和摄像机视角变化等问题 。

因此,近年来出现了许多旨在解决这个具有挑战性的问题的方法,行人重识别研究领域也取得了显著的进展。在现有文献中,大多数现有的行人重识别方法主要设计用于提取判别性特征,可以分为两类,基于注意力的方法和步进方法。

注意力机制,旨在突出输入中的显著区域,对于行人重识别具有很大的潜力。通过动态模拟图像中不同空间区域的重要性,注意力可以帮助跨摄像头的行人匹配关注有判别性的身体部分。这有效地过滤了背景干扰并捕获了更丰富的细节特征。此外,引入了诸如注意力正交性 和强化学习等各种技术来提高学习到的注意力图的有效性。然而,注意力机制主要关注具有固定语义的具体部分,姿态或遮挡的变化可能会影响表示的可靠性。此外,基于粗糙特征生成的注意力可能由于这些特征固有的噪声而不太准确。

另一种简单而有效的方法提取特征是步进分区。在这些方法中,图像被分成条纹,每个条纹都被视为细粒度的局部特征。与专注于识别具有特定预定义语义的区域以学习局部表示的方法相比,分区在存在显著变化的场景中证明是高效和鲁棒的。此外,调整部分数量可以获取在不同粒度下具有判别性的局部信息。然而,需要承认的是,这种策略可能为图像的对齐或遮挡生成无效的局部特征。

作者可以看到,大多数现有的行人重识别方法主要是设计用于提取判别性特征,可以将它们分为两类,基于注意力的方法和基于步进的方法。注意力机制旨在突出输入中的显著区域,有助于跨摄像头的行人匹配关注有判别性的身体部分。然而,注意力机制主要关注具有固定语义的具体部分,姿态或遮挡的变化可能会影响表示的可靠性。此外,基于粗糙特征生成的注意力可能由于这些特征固有的噪声而不太准确。

现有的许多行人重识别方法主要是设计用于从单一视角提取判别性特征。即使在使用多分支网络的情况下,每个分支通常遵循相似的基本原理。例如,MGN 只是在分支数量上引入了变化,而作为主要区别。然而,行人重识别通常涉及复杂和多样化的场景。仅依赖单一视角的方法可能在某些情况下表现出色,但在其他情况下可能无法应对。有一些方法在模型中同时采用Hard分区和Soft注意力,但它们忽略了两种策略之间的知识转移,这有可能充分利用两个分支的专业特性并促进全面学习。

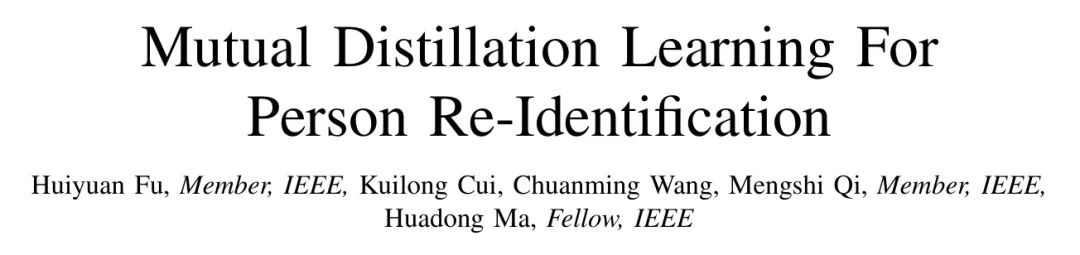

在本文中,作者提出了一种行人重识别框架,该框架在一个统一模型中同时采用Hard步进分支和Soft注意力分支。MDPR的整体结构如图1所示。第一个分支,称为Hard Content分支,采用均匀的水平分区间输入图像以提取局部特征。相比之下,第二个分支,称为Soft Content分支,利用注意力机制区分个体和背景,并在人体内部识别有判别性的区域。此外,作者还引入了一个知识蒸馏和融合模块,该模块促进分支之间的相互蒸馏,并将每个分支的结果聚合在一起。

Hard Content分支采用一个与图像内容无关的均匀分区间方法,因此被称为“Hard”。相反,Soft Content分支动态确定图像中人体位置,因此得名“Soft”。尽管这两个分支在特征提取的起点不同,但它们提取的特征应该一致,因为它们都针对同一个个体。互学学习有助于Hard Content分支学习目标行人的细粒度信息,同时使Soft Content分支专注于局部细节,而融合模块将两种方法提取的特征融合在一起,进一步提取有效特征。此外,MDPR设计为端到端,简化了训练和部署过程。

需要注意的是,本文是作者之前会议论文的延伸,该论文使用了多个分支提取局部特征和增强特征。在这次扩展版本中,作者在分支之间引入了互学学习,以增强每个分支的特征表示。现在,注意力分支包括注意力指导和多粒度特征提取。此外,来自每个分支的特征被融合在一起,以提取额外的有价值信息。这些修改大大提高了模型在特征表示方面的能力。在测试阶段,作者在广泛使用的行人重识别基准数据集上进行实验。这使作者能够提供更全面、定量的结果以及详细的消融分析,这些分析证明了作者在提出的框架中每个组成部分的有效性。

在总结中,贡献可以概括如下:

- 提出了一种双分支框架,该框架在一个单一模型中利用两种不同类型的异质线索进行特征提取。Hard Content分支采用均匀的水平分区间方法提取细粒度的局部特征,同时Soft Content分支利用注意力机制在多个粒度上提取全局特征。

- 一个互学蒸馏和融合过程使两个分支之间可以进行知识交换。在这个过程中,Hard Content分支向Soft Content分支传授局部细节,而Soft Content分支则将细粒度细节和位置信息反馈给Hard Content分支。

- 在主流行人重识别数据集上进行了全面的实验,以证明MDPR的优势,超越了当前最先进的表现。

II Related Works

近年来,行人重识别技术取得了快速进展,许多与图像和视频相关的方法被提出,以应对这一挑战。在强大的 Baseline 之后 [26],作者将介绍各种方法,包括基于全局的方法、基于注意力的方法、基于姿态的方法、基于掩码的方法和基于步进的方法。此外,作者将简要介绍蒸馏学习。

Global-based Approach

基于全局的方法通常采用高效的 Backbone 网络来学习身份特征,重点在于数据增强、损失函数设计和提高性能的训练技术。总的来说,这些方法能够实现高效但有限的结果。

数据增强技术通常用于多样化训练数据并提高模型性能。例如,随机擦除(REA) 随机擦除图像中的一个矩形区域,以鼓励网络学习更健壮的特征。另一个技术是随机块(RPT),它使用数据集中其他图像的一个区域来覆盖目标图像的一个区域,从而提高对遮挡和其他变体的泛化能力。

对于行人重识别,通常使用两种类型的损失函数:分类损失函数和Triplet Loss函数。分类损失函数将行人重识别视为分类问题,其中每个人都被视为独立的ID。Triplet Loss函数将其视为聚类问题,旨在增加样本点和负样本之间的距离。

训练技巧也对提高最终性能做出了重要贡献。例如,BNeck是在训练过程中解决ID损失函数和Triplet Loss函数之间冲突的方法。提高学习率、标签平滑和最后步长为1等额外的技术也被用于通过在平均精度(mAP)中提高10%以上来增强性能。

Attention-based Approach

注意力机制在计算机视觉领域具有显著效果,并在行人重识别中得到广泛应用。ABD-Net引入了一对互补的注意力模块,分别关注于通道聚合和位置感知。同时,正交性约束也被引入以促进隐藏激活和权重的多样性。在AP-Net中,特征被分成多个局部部分。相应的局部注意力被合并并堆叠在残差连接作为注意力金字塔的方式下,以多尺度方式利用注意力区域,模拟人类的视觉感知。RGA-SC提出了一种堆叠每个特征位置和特征本身之间的双向相关性来学习注意力和获得对全局结构信息和局部外观信息的紧凑理解。SCAL试图通过在强化学习方式下估计注意力图的质量来学习注意力,使其比许多现有方法采用的弱监督训练方法更有效。

与目前采用的许多注意力机制不同,作者在Soft Content分支中的注意力生成相对简单,主要涉及几个卷积操作。此外,作者还引入了一个注意力指导机制,以进一步增强为粗粒度特征生成的注意力图的质量。

Pose-based, and Mask-based Approach

最近,姿态估计和人类语义解析在准确性方面有了很大的改进。通常,这些模型识别出个体的骨骼点或生成身体部分的掩码,以提取关键的位置信息。在行人重识别中,使用姿态估计和人类语义解析处理姿态变化和背景杂乱是合理的,并且这样的尝试已经取得了很大的性能改进。

AACN深入挖掘姿态信息,使用十四个人体关键点来指导部分注意力,以在特征图上处理部分遮挡,遮挡不利的背景特征。SPReid通过人类语义解析模块生成概率图。DSA使用DensePose估计2D图像的密集语义,并构建一组密集语义对齐的部分图像,作为调节器引导模型学习密集语义对齐的特征。由于存在许多有用的时间上下文线索,这些线索并未纳入预定义的人体部分或属性,-Net应用一个人类解析模型提取二进制人体部分掩码和自注意力机制捕捉Soft潜在(非人体)部分掩码。ISP是另一种方法,它在像素 Level 定位人体部分和个人信息,仅用于对齐行人重识别,仅使用人体身份标签。

当前市场上可用的姿态估计和人类语义解析方法表明,它们主要是针对特定场景设计的,因此在行人重识别中缺乏泛化性。这可以归因于用于训练的数据集之间的巨大差异,包括分辨率、图像质量、光照等因素的变化。此外,行人重识别数据集中缺乏语义或姿态标签,这使得在行人重识别的背景下生成精确的关键点或人体掩码的过程更加复杂。

Stride-based Approach

步进方法将图像分成几个部分并从每个部分中学习局部特征,然后将它们聚合以获得最终的特征表示。

PCB是第一个基于步进的深度学习行人重识别方法。除了对图像进行分区外,他们还使用一个添加模块将异常值重置为最近的部分以增强每个部分内的一致性。MGN提出了一种多分支深度网络架构,其中包含一个分支用于全局特征表示,两个分支用于局部特征表示,将图像分成不同的条纹以获得局部特征表示。HPM使用在不同水平金字塔尺度上的部分特征表示进行分类,增强各种特征部分的区分度。Pyramid提出了一种从粗到细的金字塔模型,不仅整合了局部和全局信息,还整合了它们之间的渐进提示。HLGAT使用从水平分区间获得的局部特征构建一个图来模拟局部和局部之间的关系,实现了出色的性能。尽管步进方法已经做出了努力,但它们不可避免地陷入了未对齐图像和遮挡的困境。

Distillation learning

模型蒸馏是一种有效且广泛使用的技术,可以将教师网络的知识转移到学生网络中。在知识表示方面,现有模型通常使用教师的类别概率和/或特征表示。此外,一些方法提出了另一种替代方法,通过互相蒸馏的元组学习来使一组学生互相教学。

对于当前的蒸馏技术,重点在于利用多个 Backbone 网络来促进知识转移。相比之下,MDPR采用了一个具有两个独特分支的单 Backbone 网络。值得注意的是,这两个分支从不同的角度提取特征,确保了知识转移的有效性。

III Proposed Method

问题陈述:给定一个包含张图像的数据集,其中表示由个不同的人通过非重叠的摄像头视角捕获的个个体,对应的标签,目标是学习一个用于行人重识别匹配的深度特征表示模型。为此,作者提出了一种增强的双视角特征提取模型,该模型通过互学蒸馏方法进行改进。

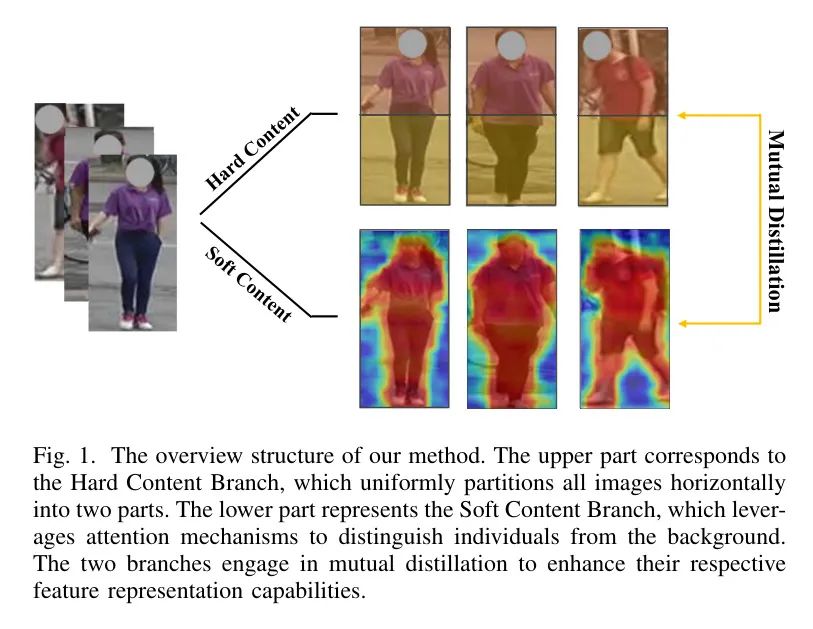

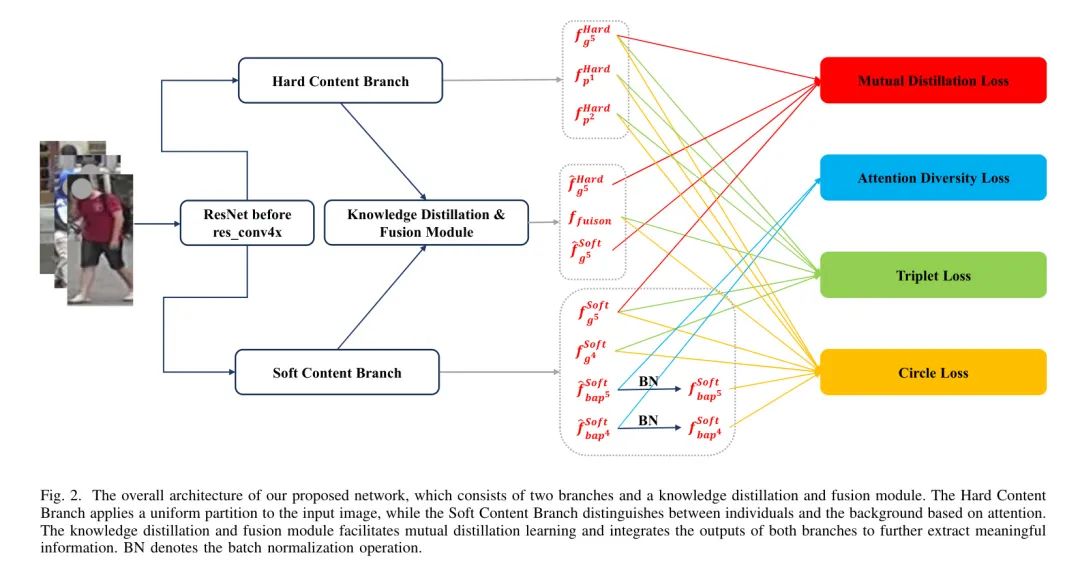

框架概述:如图2所示,作者提出的网络结构包括两个分支和一个知识蒸馏和融合模块。作者采用ResNet作为 Backbone 网络,其中两个分支共享低级网络,而独立利用高级网络。这些分支使用不同的技术提取不同的特征,而知识蒸馏和融合模块进行互学蒸馏并将两个分支的输出集成以提取有意义的信息。

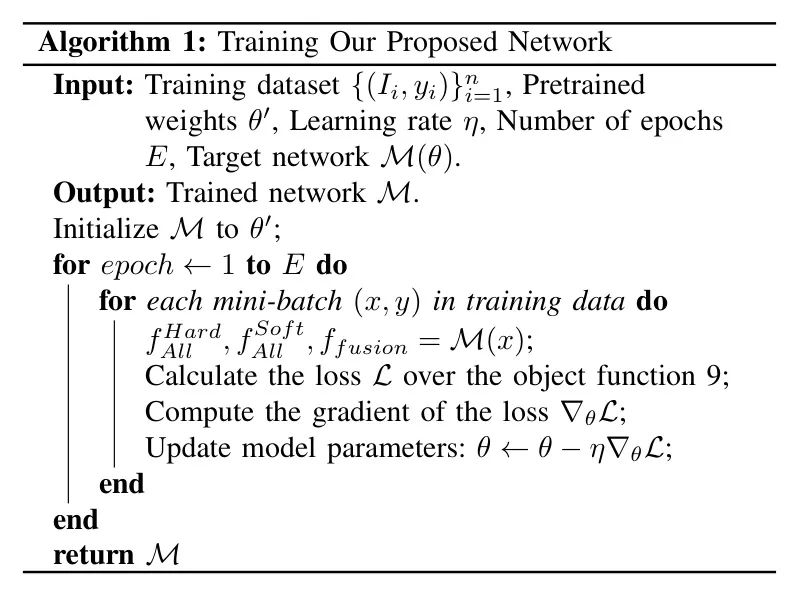

训练过程中使用的算法在算法1中详细说明,采用端到端框架,提供了方便的训练方法,,和分别对应由Hard Content分支生成的所有特征,由Soft Content分支生成的所有特征以及知识蒸馏和融合模块的融合输出。MDPR中的每个组件在整体结构中起着关键作用,作者将在下一节中描述这些组件如何执行。

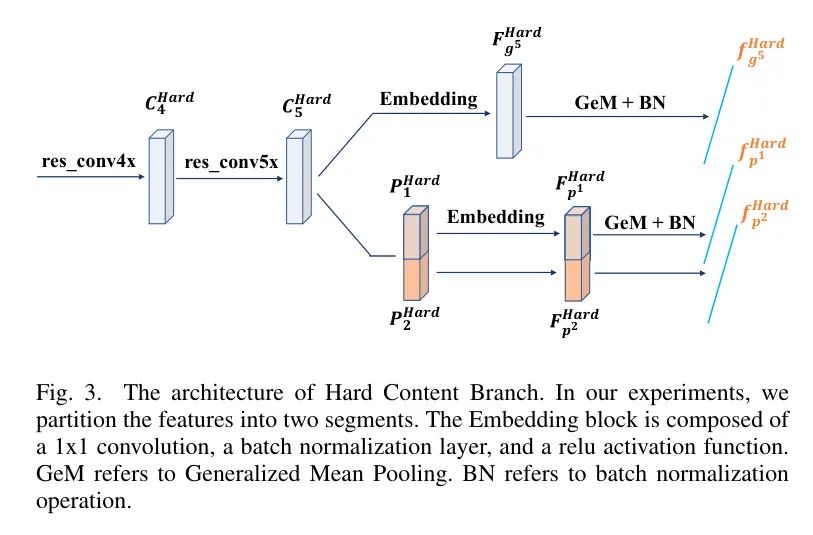

Hard Content Branch

Hard Content分支采用均匀的水平分区间方法提取多个判别性局部特征。对于每个输入图像,分区间过程保持一致,不考虑图像内容的唯一性。

在这个分支中,res-conv5的输出定义为,其中,和分别表示通道数、高度和宽度。然后,作者将在高度维度上均匀分成个段。

许多先前的研究采用了类似的方法。在本研究中,考虑到行人重识别数据集中的大多数图像是对齐的,作者通过经验定义 = 2,以根据人体的上半身和下半身提取目标行人的关键特征。分区的特征用表示,其中包含特定区域的信息。

为了增强关键上下文信息的提取并减少特征维度,作者使用了一个嵌入块,通常包括一个卷积层、批量归一化(BN)层和ReLU激活函数,用于处理 Backbone 网络输出和每个分区的特征。在嵌入后,为每个特征执行通用平均池化(GeM)。定义为嵌入后的特征,其中是嵌入维度,是特征图大小,是GeM的输出。

通用平均池化(GeM)操作可以表示为以下形式:

在这个分支中,每个分区的特征经过嵌入块处理后,生成一个批次归一化(BN)层的输出。具体而言,对于每个分区的特征,嵌入、通用平均池化(GeM)和批量归一化(BN)不共享参数。总的来说,Hard Content分支生成一个全局特征和两个分区间特征{, }。

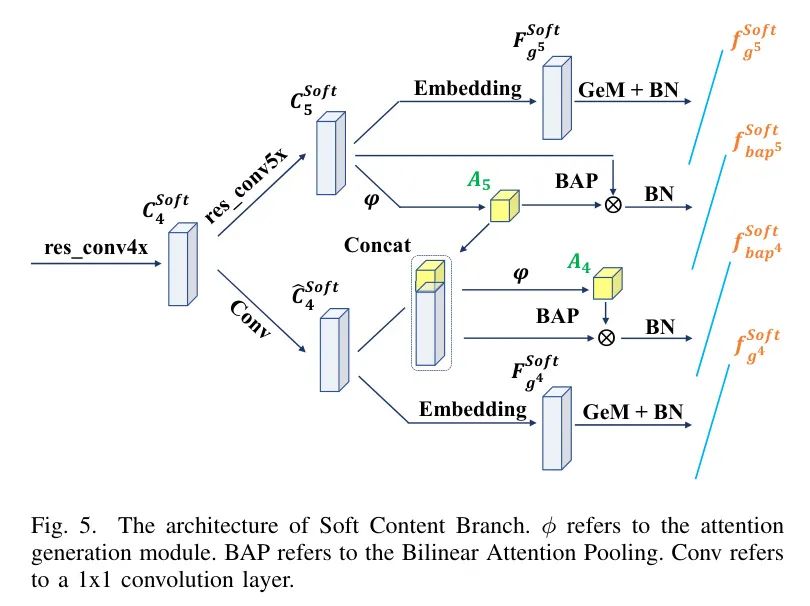

Soft Content Branch

与Hard Content分支不同,Soft Content分支根据每个图像的内容生成独特的注意力图来指导特征提取。为了进一步提高模型的特征表示能力,作者采用多粒度注意力来增强相应粒度的特征。此外,细粒度特征生成的注意力图被用于引导粗粒度特征的注意力图生成,从而减轻后者噪声的影响。

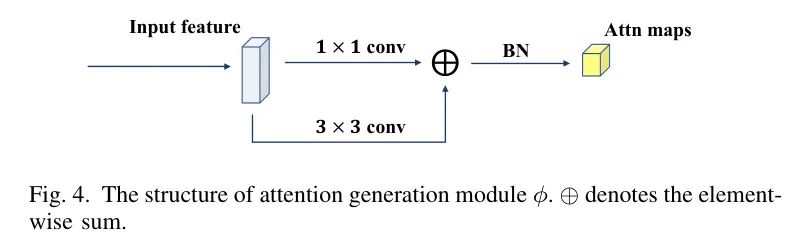

在介绍具体设计之前,首先描述如何生成注意力图。给定一个输入特征,其中C、H和W分别表示通道数、高度和宽度,作者使用模块来生成原始注意力。

其中K是生成的注意力图的数量,表示模型的参数。

模块包括一个1×1卷积、一个3×3卷积、一个批量归一化层和一个ReLU激活函数。如图4所示,两个卷积的输出进行逐元素求和,然后进行批量归一化和ReLU操作。因此,产生了K个注意力图,每个注意力图都对应不同的身体部位。

为了有效地区分个体和背景并增加注意力图的变异性,作者遵循[50]提出的方法,生成个注意力图,并在注意力图的通道维度上应用softmax操作,然后选择前K个图作为最终输出。这导致了表示背景的最后注意力图的生成,而剩下的图则专注于身体部位。

Soft Content分支的整体架构如图5所示。在这个分支中,使用第几阶段残差块的输出特征和,其中_res-conv4_和_res-conv5_表示残差块的输出。最初,生成模块被用来创建基于的注意力图。然后,应用双线性注意力池(BAP)[51],并在BAP结果上执行批量归一化操作。这个过程可以表示为:

其中表示逐元素乘法,表示中的第个注意力图,_EO_表示嵌入操作。具体而言,嵌入和GeM操作在不同的注意力图之间不共享参数。然后,使用来指导的生成。如图5所示,将subject到卷积操作。

然后,作者将进行卷积操作,与和对应的注意力图进行拼接,基于这个拼接生成特征图和。接下来,执行BAP和批量归一化操作,生成特征图和。此外,对和执行嵌入、GeM和批量归一化操作,生成和。

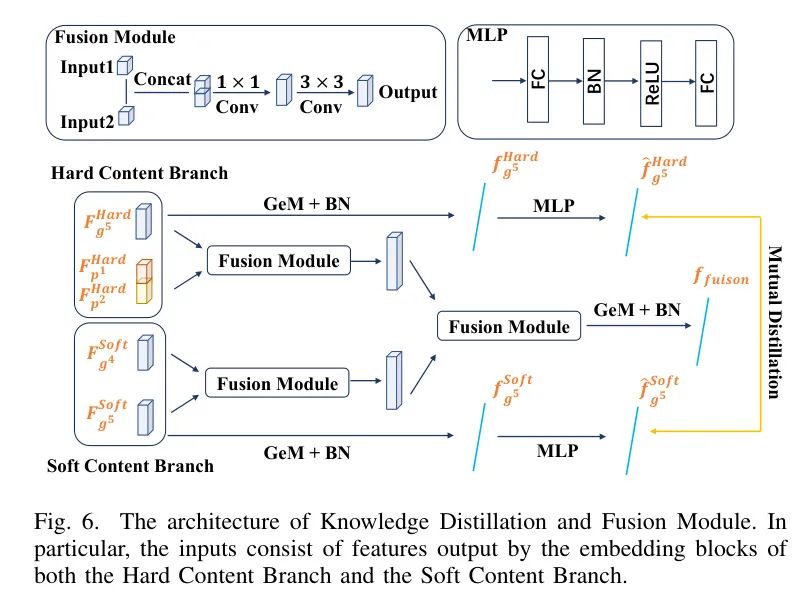

Knowledge Distillation and Fusion Module

知识蒸馏和融合模块基于从Hard Content分支和Soft Content分支的输出特征进行互学蒸馏学习,并将两个分支的特征集成起来以提取有价值的信息。

作者基于Hard Content Branch的和Soft Content Branch的进行互学蒸馏学习。一个多层感知机层(MLP)包含两个线性层、一个批量归一化层和一个ReLU激活函数,负责将一个域的特征转换为匹配另一个域的特征。将输入MLP的和的结果分别记为和,作者基于和以及和之间的余弦相似度进行蒸馏学习。关于损失设计详细信息请参见III-D节中的互学蒸馏损失。

为了融合多个特征,作者引入了一个融合模块,包括一个1×1卷积、一个3×3卷积、一个批量归一化层和一个ReLU激活函数。首先,将每个分支内的特征进行合并,然后进一步将来自每个分支的融合结果进行集成以获得最终的融合特征。然后,执行GeM和BN以获得最终的融合特征。

Objective Function

为了增强作者模型内的特征表示,将环形损失和Triplet Loss集成为作者损失函数。此外,为了增强Soft Content分支中产生的注意力图的多样性和有效性,作者引入了一个专门的损失函数,用于促进注意力独特性。然后,作者使用互学蒸馏学习损失来促进Hard Content分支和Soft Content分支之间的知识转移,进一步增强模型的特征表示能力。

Circle损失将每个相似度分数根据其距离到最优效应赋予不同的惩罚强度,允许它使用不同的梯度优化每个相似度分数,从而获得更好的总体性能。作者计算 Anchor 特征与其他特征在子批次之间的相似度分数。

具体而言,作者定义,其中是负样本集中的第个样本,,其中是正样本集中的第个样本。相应地,,。Circle损失可以表示为:

其中,,表示“在零处截止”的操作,以确保,为非负数。,,,。有两个超参数:比例因子和松弛边界。遵循SBS[27],作者在实验中设置为64,为0.35。

以下是Triplet Loss的公式:

Triplet Loss是一种经典的学习度量损失,它同时增强了模型的鲁棒性和性能。具有一个间隔超参数的Triplet Loss可以表示为:

在每个mini-batch中,,和分别表示 Anchor 特征、正特征和负特征,它们来自-th身份的个选中身份和每个身份的张图像。Triplet Loss函数鼓励模型学习特征表示,使得 Anchor 特征和正样本之间的距离小于 Anchor 特征和负样本之间的距离至少为间隔参数。作者在实验中设置为0.05。

为了生成所需的注意力以执行BAP操作,作者采用了一种简单的卷积方法。使用softmax函数的有效利用增强了模型在前景和背景之间的区分能力。然而,关注于前景的注意力图往往集中在相同的key区域,导致生成的注意力图之间存在显著的相似性。

为了鼓励生成的注意力图关注不同的key区域,作者定义了一种基于关键区域敏感度的损失函数。给定特征,该损失函数可以表示为:

作者定义了一个基于Bilinear Attention Pooling(BAP)的结果之间的相似度度量。此外,还引入了一个正则化项来降低过拟合的风险。注意力多样性损失可以表示为:

在作者的实验中,被设置为0.001。

互学蒸馏损失。Hard Content分支和Soft Content分支从不同的域中提取特征,作者利用由两个分支生成的特征进行互学蒸馏学习,以实现知识的传递。定义为向量和之间的负余弦相似度,互学蒸馏损失可以表示为:

其中表示防止梯度反向传播。

最后,MDPR使用这四种损失函数的组合,可以表示为:

Inference Strategy

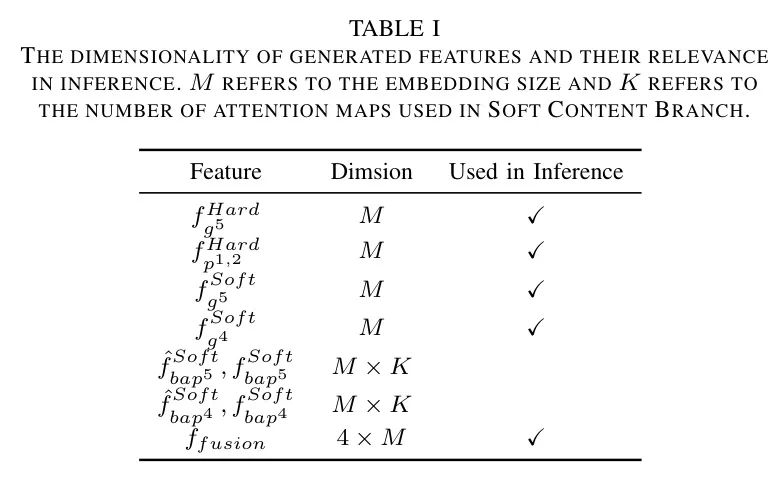

在推理阶段,将来自Hard Content分支、Soft Content分支和知识蒸馏与融合模块的融合结果结合起来,以获得最终的特征矩阵。每个特征的维数以及其对推理的相关性在表I中详细说明。具体而言,BAP获得的特征不包括在参考中,所有参考中的特征都被连接在一起。作者计算 Query 图像与所有画廊图像之间的余弦距离,然后对它们进行排序以获得检索结果。

IV Experiment

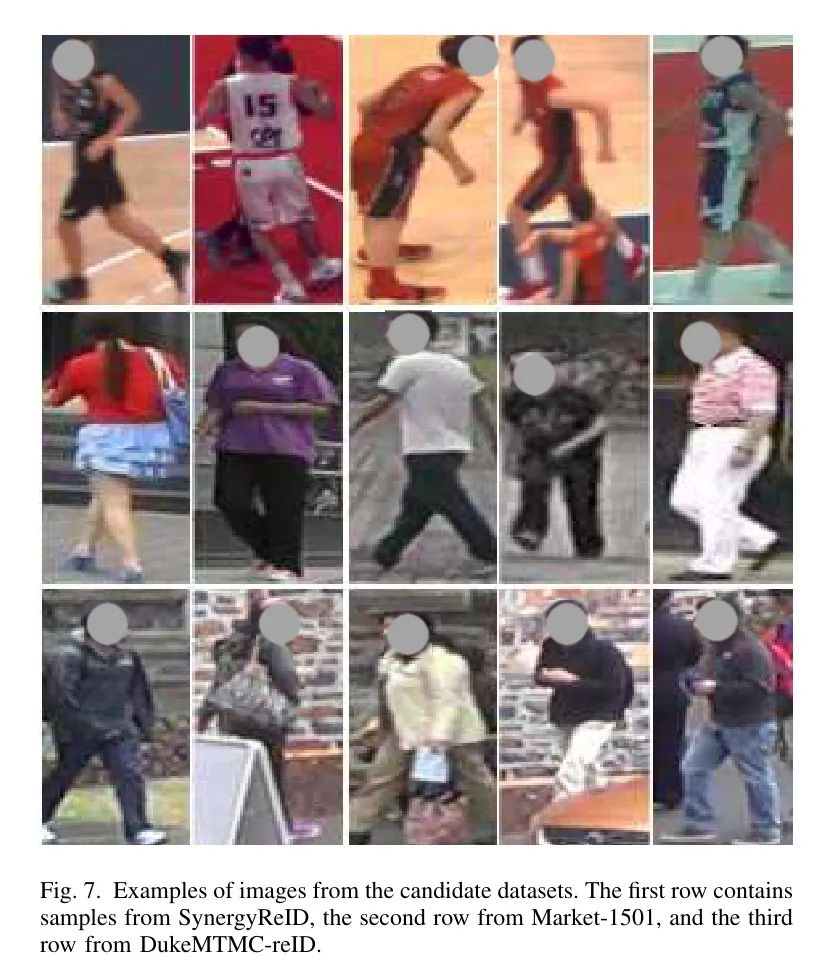

为了评估作者模型的有效性并与其他方法进行比较,作者在一个玩家重识别数据集和一个两个人重识别数据集上进行实验。候选数据集中的部分样本如图7所示。

Dataset and Evaluation

SynergyReID。这个数据集使用了99个来自29个不同场馆的LNB proA联赛的篮球比赛中的97个专业篮球视频序列。它涵盖了各种球员和运动服外观,捕捉了在多个场馆和不同照明和场地布局下游戏的动态性质。数据集中包括9,529个球员、裁判和教练的图像裁剪。训练集包含8,569张图像,代表436个个体,测试集进一步分为50个 Query 图像和910个 gallery图像。

Market-1501。这个数据集在清华大学的一家超市前面收集。数据集包含由六个摄像头捕获的32,668张图像,其中每个数据集中的个体至少被两个摄像头捕获。整个数据集分为一个训练集,包含751个人的12,936张图像,以及一个测试集,包含750个人的3,368张 Query 图像和19,732张 gallery图像。

DukeMTMC-reID。这个数据集包含在户外的八个高分辨率摄像头捕获的36,411张行人图像。在这1,812名行人中,有1,404名被超过两个摄像头的摄像头捕获,而剩下的408名只被一个摄像头的摄像头捕获。数据集被分为三个不同的集:训练集、测试集和 Query 集。训练集包括702名行人,总计16,522张图像。在测试集中,有702名行人,此外还有408名干扰行人,总共17,661张图像。 Query 集包括702名行人,是从测试集中随机选择的,每个行人选择一张来自每个摄像头的图像,总共2,228张图像。

评估指标。为了评估MDPR的性能并与其他方法进行比较,作者在所有候选数据集的Rank-1位置上报告平均平均精度(mAP)和累积匹配特性(CMC)。

Implementation

MDPR采用了一个修改过的ResNet-101作为其 Backbone 网络,因为它在ReID模型中展示了出色的性能。具体来说,在MDPR中,除了res-conv4之前的 Backbone 部分由每个分支共享外,res-conv4和res-conv5不被每个分支共享。为了在特征图中保留更多的细粒度细节,作者在两个分支的最后下采样操作中的步长从2更改为1,以减少下采样操作过程中损失的空间信息。此外,使用IBN-a来增强卷积神经网络的建模能力。虽然这些修改会增加计算成本,但性能优势显著。

考虑到图像大小的不一致,所有图像在训练和测试阶段都统一被重新缩放到。为了充分利用数据集,采用了数据增强。图像以0.5的概率进行水平翻转,以0.5的概率使用随机擦除(REA)和随机块(RPT),这有助于防止过拟合并提高模型的鲁棒性。在将其输入网络之前,图像通过减去均值[0.485, 0.456, 0.406]并除以标准差[0.229, 0.224, 0.225]进行归一化,这有助于提高训练过程的收敛速度和准确性。

在训练阶段,使用预训练在LUPerson上的ResNet-101模型作为 Backbone 网络。注意力数量设置为2,嵌入大小设置为512。为了满足Triplet Loss的要求,每个批次使用随机选择的16个身份,对于每个身份,从训练集中随机选择16张图像。如果特定身份没有必要的16张图像,则使用随机重复技术来补充可用图像,直到获得所需图像。

权重衰减因子设置为0.0005,使用Adam优化器,并设置动量因子为0.9。模型通过线性增长的學習率从增加到进行预热。然后,使用余弦退火学习率衰减。考虑到数据集大小的差异,SynergyReID在40个周期中进行训练,其中包含200个 Warm up 迭代,而Market-1501和DukeMTMC-reID分别经过60个周期和2000个 Warm up 迭代。

MDPR使用PyTorch框架实现,并在训练时使用分布式数据并行(DDP)。所有实验都在4台NVIDIA GeForce RTX 3090 GPU上进行。

Comparison with State-of-the-Art Methods

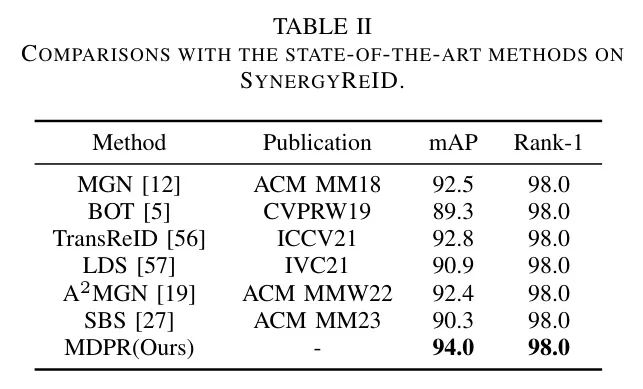

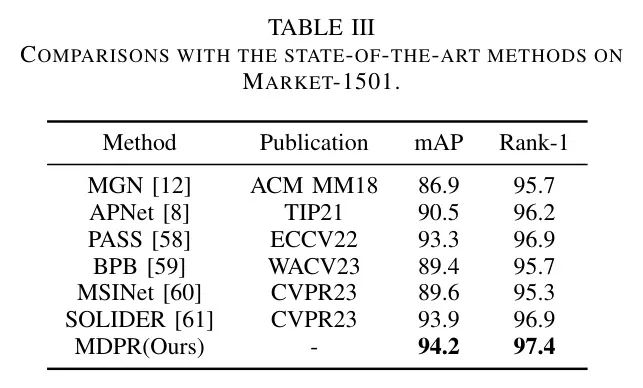

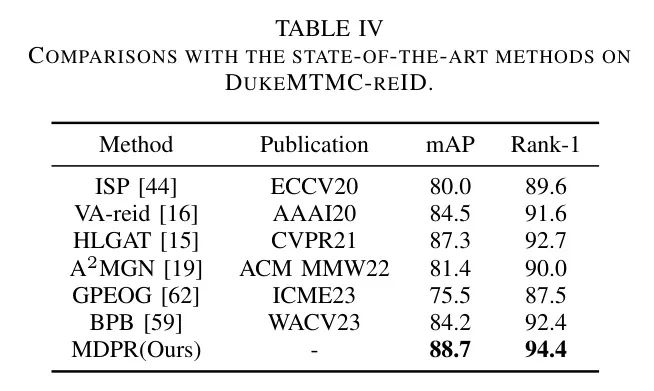

为了证明MDPR的有效性,在候选数据集上与当前最先进的算法进行了比较。结果表明,MDPR超过了其他最先进的算法或在所有候选数据集上达到了可比性能。

在SynergyReID数据集上,MDPR分别取得了94.0%/98.0%的mAP/Rank-1精度,分别超过了大多数先前的结果。与作者的先验方法相比,MDPR采用了更少的分支,但实现了mAP的1.6%提升。考虑到数据集的大小相对较小,值得注意的是,大多数方法也实现了98.0%的Rank-1精度。

在Market-1501数据集上,MDPR得到了令人满意的结果。如表III所示,SOLIDER目前处于领先地位,利用人类图像的先验知识构建伪语义标签并导入更多的语义信息到学习的表示中。MDPR在mAP和Rank-1性能指标上分别取得了94.2%和97.4%,分别优于SOLIDER的mAP和Rank-1。此外,与采用复杂注意力设计的网络相比,如APNet所采用的注意力金字塔网络,MDPR在mAP和Rank-1上分别取得了+3.7%和+1.2%的显著改进,展示了作者使用的注意力机制的有效性。

在DukeMTMC-reID数据集上,MDPR明显超过了所有先前的结果,在表IV中,MDPR在DukeMTMC-reID数据集上超越了所有先前的结果,实现了mAP和Rank-1精度分别为88.7%和94.4%。作者的性能在状态最先进的HLGAT上取得了显著的提升,mAP和Rank-1分别提高了1.4%和1.7%。

作者可以看到,大多数先前的最先进工作集中在从特定视角提取特征。例如,SOLIDER利用先验语义信息,而HLGAT广泛探索局部特征之间的信息。相比之下,MDPR从两个不同的视角提取特征,有助于适应更复杂的场景。此外,MDPR采用互学蒸馏学习,以增强每个视点的特征表示能力,并提高模型的整体有效性。

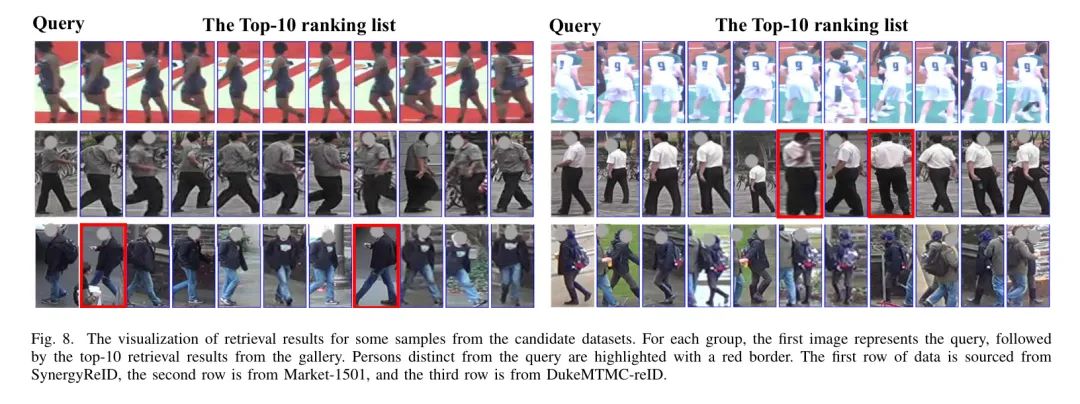

为了更直观地展示作者模型有效性,作者在候选数据集的测试集的图像检索结果中呈现了一些结果,如图8所示。对于每个 Query ,作者将gallery中的前10个检索结果按顺序显示,并用红框框出不匹配的标识。第一行包含SynergyReID数据集的样本。MDPR在描述个体的姿势和步态变化时表现出很强的鲁棒性。在第二行Market-1501图像中,模型在 Query 不严格对齐时表现良好。第三行显示DukeMTMC-reID数据集的示例,其中第二行 Query 表示模型可以很好地泛化,尽管存在严重的遮挡。

Ablation Study

为了更深入地了解超参数设置和每个模块的有效性,作者进行了一系列的比较实验。具体来说,将模型在不同的超参数设置下进行训练,并比较不同超参数设置下模型的性能。同时,也会对每个模块进行单独的比较实验,以了解每个模块对模型性能的影响。通过这些实验,作者可以更深入地理解模型的工作机制,并进一步优化模型的超参数设置。在Market-1501和DukeMTMC-reID数据集上进行了广泛的消融实验。

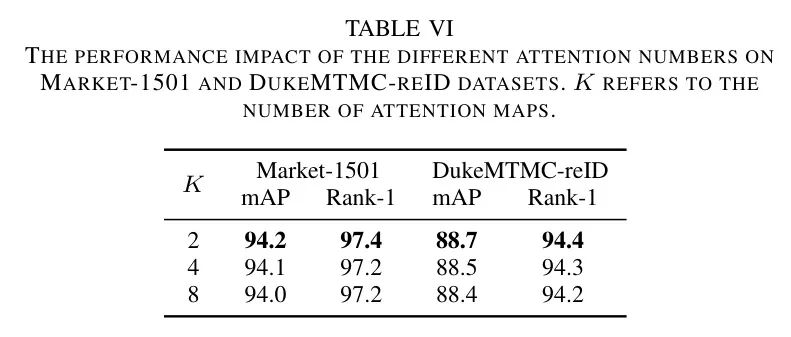

V-B1 Attention Number in Soft Content Branch

在MDPR中,Soft Content分支所使用的注意力图的数量是一个关键的超参数。这些生成的注意力图在区分前景和背景以及关注人体关键区域方面起着决定性作用。为了全面理解注意力图数量对作者模型性能的影响,作者进行了一项消融实验。具体来说,作者从2,4,到8个注意力图的数量,分别评估它们对模型准确性的影响。

如表VI所示,对于Market-1501和DukeMTMC-reID数据集,当注意力图数量设置为2时,模型性能最佳。增加注意力图数量对两个数据集的模型性能都有一定程度的降低。

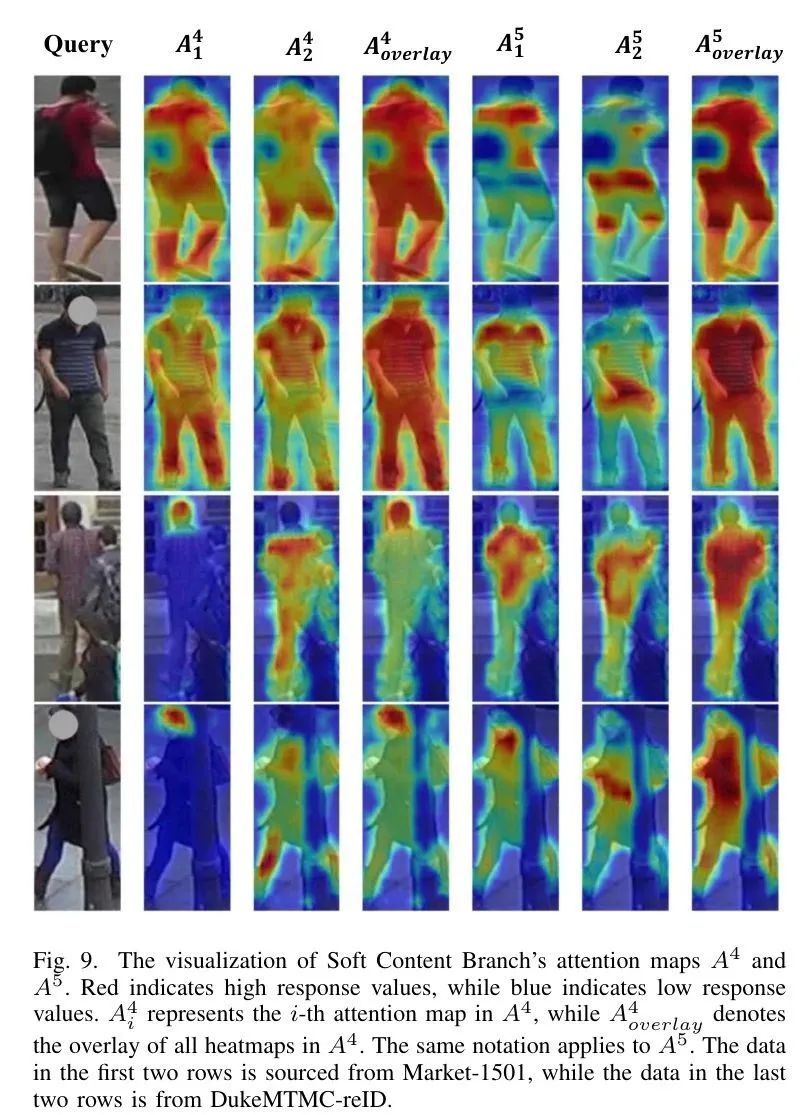

为了进一步说明注意力图如何影响模型区分前景和背景以及关注人体关键区域的能力,作者在图9中可视化了生成的注意力图。如图9所示,对于一个图像生成的注意力图,它们并不包含特定的语义信息。然而,粗粒度和细粒度特征的注意力图叠加,如图9中的和所示,可以明显强调图像中目标人的整体身体。

值得注意的是,对于一个特征生成的不同注意力图,它们强调的是对应不同身体部位的区域,这突显了作者注意力图生成的效率。图9中的前两行图像来自Market-1501数据集,展示了MDPR对个体的有效关注,无论来自正面还是背面。后者两行图像来自DukeMTMC-reID数据集。由于DukeMTMC-reID数据集中常见遮挡情况,作者特意选择了具有遮挡相关挑战的样本。第三行图像中的遮挡涉及其他行人,而第四行图像中的遮挡则是由于物体引起的。

在处理遮挡场景时,作者的注意力图证明非常有用,能够突出个体的未受遮挡部分,超越了仅仅关注图像中的人体。这种能力使作者能够有效地区分目标个体,同时尽量减少非目标元素的影响。

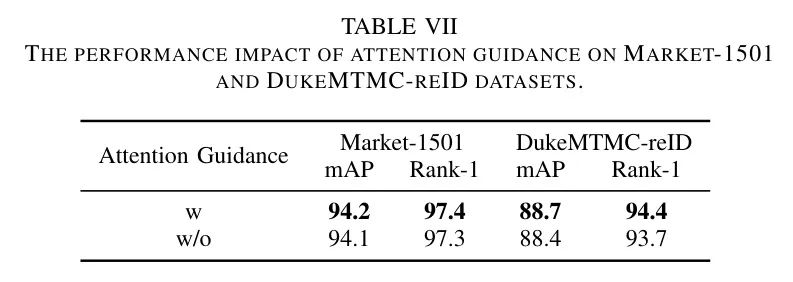

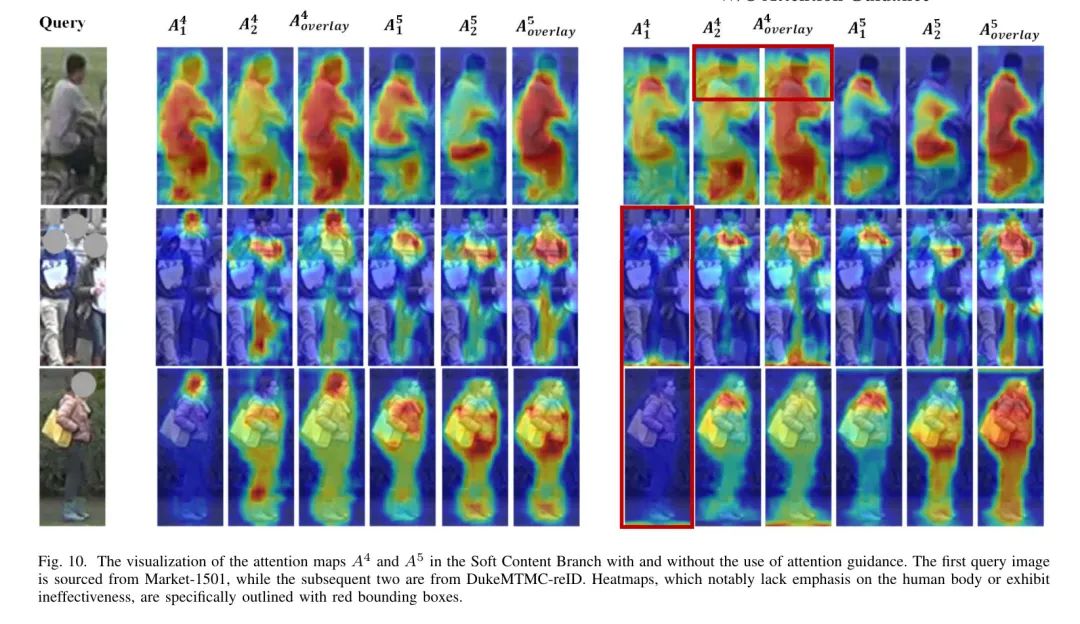

V-B2 Attention Guidance in Soft Content Branch

在Soft Content分支中,作者采用了一种注意力引导机制来促进粗糙特征的注意力图的生成。更具体地说,作者使用来指导的生成。为了全面调查注意力引导的影响,作者在决定是否使用注意力引导的背景下评估其对性能的影响。

如表VII所示,对于Market-1501数据集,采用注意力引导可以带来轻微的性能提升,而对于DukeMTMC-reID数据集,采用注意力引导可以提高mAP和Rank-1精度,分别提高了0.3%和0.7%。

此外,作者在图10中展示了带有和不带有注意力引导的注意力图的热分布。第一张 Query 图像来自Market-1501数据集,而后两张来自DukeMTMC-reID数据集。很明显,注意力引导机制的应用显著帮助模型将注意力集中在人体区域。对于图10中 Query 图像的第一张,如果没有使用注意力引导,注意力图往往会集中在目标个体的 Neck 附近,而不是包含人体区域的区域。

对于后两张图像,如果没有使用注意力引导,一些生成的注意力图(如)可能无效。通过引入注意力引导,生成的注意力图变得更加准确,对提高性能起着关键作用。

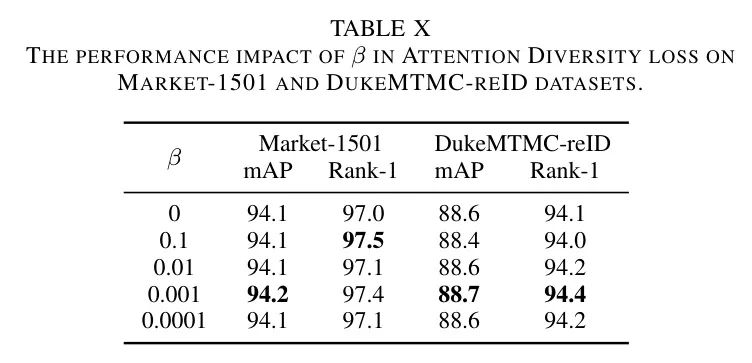

V-B3 Hyper-Parameters in Attention Diversity Loss

在注意力多样性损失中,作者引入了一个正则化项来减少生成的注意力对噪声的敏感性并防止过拟合。为了确定最合适的参数,作者对超参数进行了相关的消融实验,实验结果如图X所示。

对于Market-1501数据集,Rank-1对不敏感,而mAP在0.1和0.001时达到高水平。相反,对于DukeMTMC数据集,当设置为0.001时,mAP和Rank-1都达到了最高值。综合考虑所有因素,作者选择将设置为0.001。

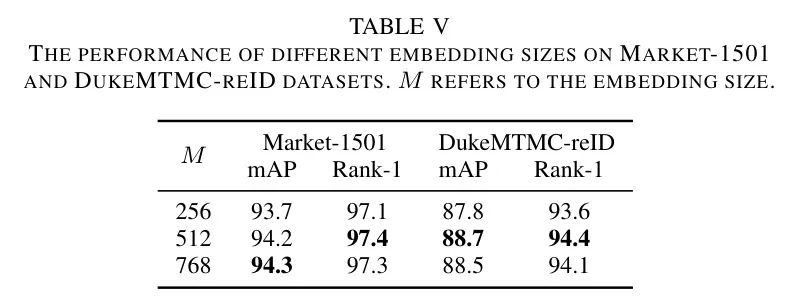

V-B4 Embedding Size

嵌入大小的选择直接影响到模型的最终输出维度,这一点在表I中得到了体现。为了理解不同的嵌入大小对MDPR性能的影响,作者进行了相应的消融实验。具体来说,作者将嵌入大小从512调整到1024,并评估模型在候选数据集上的性能。

如图11所示,当嵌入大小为512时,模型在Market-1501数据集上的性能优于其他数据集。然而,当嵌入大小增加至1024时,模型在所有数据集上的性能均有所下降。这表明,嵌入大小的选择对模型性能有直接影响,需要根据具体情况进行调整。

作者进行了全面的调查。具体来说,作者探索了256、512和768个嵌入大小,并评估它们对mAP和Rank-1的影响。

如图V所示,对于Market-1501数据集,将嵌入大小设置为512或768会导致非常相似的结果。然而,选择较小的嵌入大小会导致模型参数减少和推理速度更快。因此,建议将嵌入大小设置为512。相反,对于DukeMTMC-reID数据集,512个嵌入大小同时实现了最高的mAP和Rank-1值,因此值得推荐。

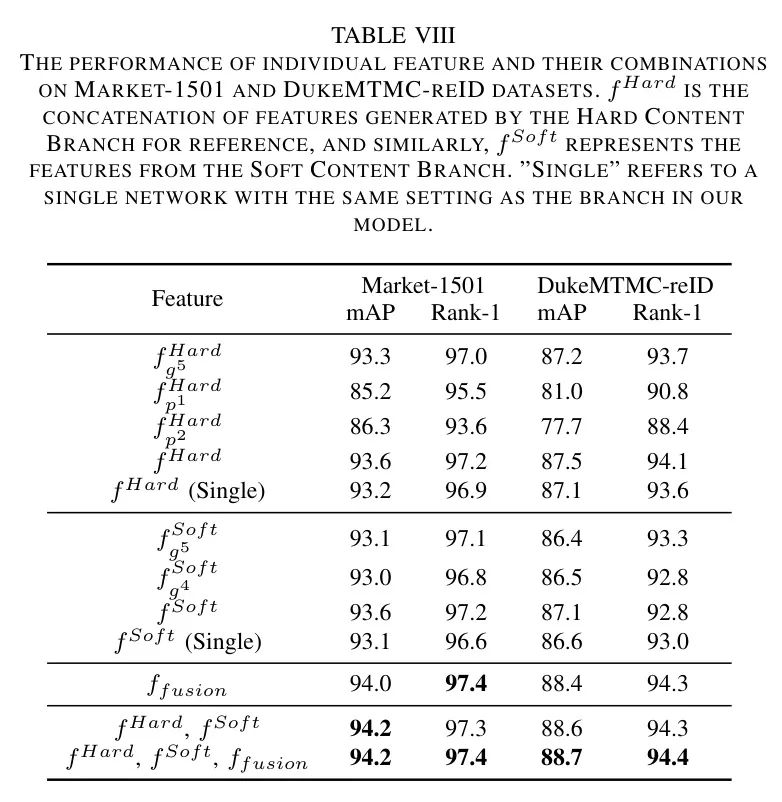

Iv-B5 The Performance of Individual Features and Their Combinations

为了探索单个特征及其组合对最终输出的贡献,作者首先训练整个网络,然后基于单个特征及其组合进行推理。此外,为了评估MDPR对每个单独分支的影响,作者分别训练了与MDPR中单个分支设置相同的网络。结果如表VIII所示。

可以看出,Market-1501数据集上,Hard Content分支和Soft Content分支的表现相似,而在DukeMTMC-reID数据集上,Hard Content分支稍微优于Soft Content分支。与使用与MDPR中分支相同设置的单个网络相比,MDPR中的分支通常会导致单个网络的性能更好。这可以归因于知识蒸馏和融合模块的应用,该模块增强了两个分支的特征提取能力。此外,在两个数据集上,都超过了Soft Content分支和Hard Content分支,非常接近同时使用和时的结果。

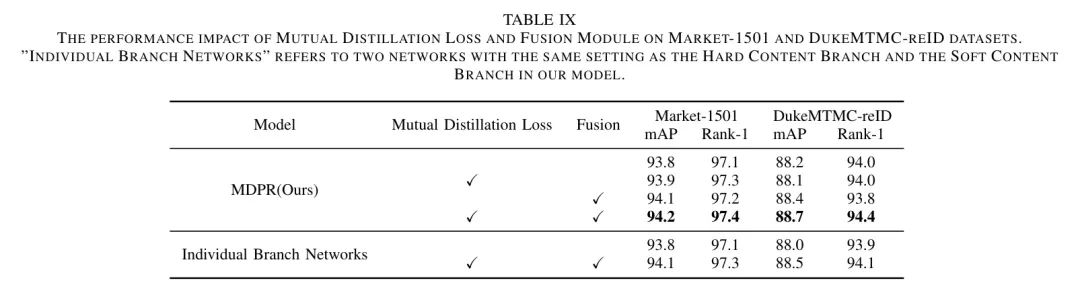

Iv-B6 The Effectiveness of Knowledge Distillation and Fusion Module

为了进一步探究互学蒸馏损失和融合模块的影响,作者对MDPR和两个单独分支网络的两种场景进行了消融实验。实验结果如表IX所示。对于作者模型来说,仅使用互学蒸馏损失或融合模块并不能保证性能提升。但是,将两者结合使用可以获得更好的结果。此外,同时使用两者还可以提高单个分支网络的性能。

V Conclusion

综上,作者提出了一种双分支框架用于行人重识别,该框架将多个视角集成到统一的模型中。Hard Content分支采用均匀的水平分区间技术来捕获局部特征,而Soft Content分支则引入了一个精心设计的注意力机制,以增强前景和背景的区分,并促进在多个粒度下提取关键的全局特征。

通过利用知识互学蒸馏和融合模块,作者的框架使得分支之间可以进行知识共享,并将每个分支的输出进行融合,以获得更全面的特征表示。MDPR在广泛使用的行人重识别数据集上进行了评估,证明了其有效性和优越性,性能指标达到了或超过了最先进的水平。

参考

[1]. Mutual Distillation Learning For Person Re-Identification.

点击上方卡片,关注「AI视界引擎」公众号

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง