ADAS Laboratory

点击上方蓝字关注 智驾实验室

仅摄像头视角的Bird’s Eye View(BEV)在3D空间的环境感知方面具有巨大的潜力。然而,大多数现有研究都是在监督设置下进行的,而当处理各种新数据时,其扩展性不佳。无监督域自适应BEV,即从各种无标签目标数据中有效学习,这一领域尚待充分探索。

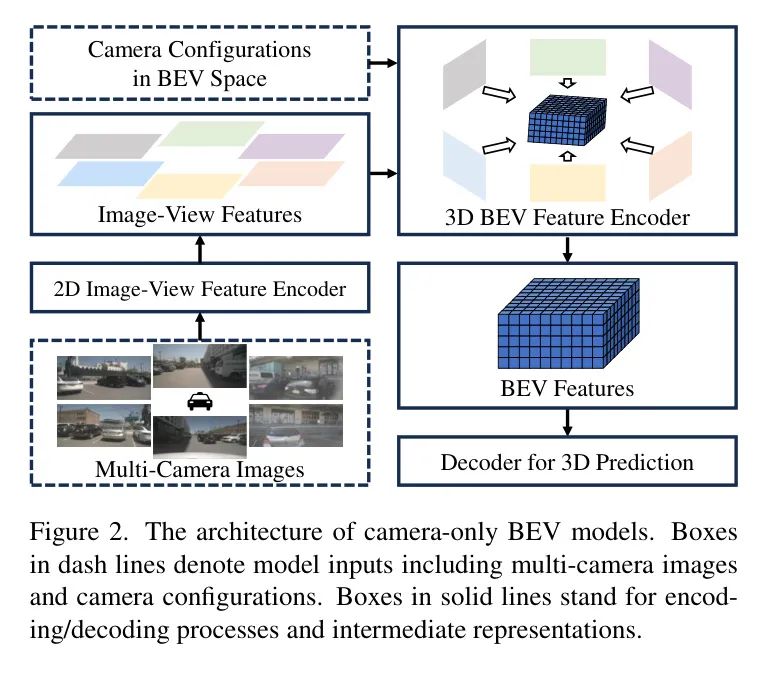

在本文中,作者设计了一个名为DA-BEV的域自适应仅摄像头视角BEV框架,该框架通过利用图像视图特征和BEV特征的互补性来解决域自适应BEV的挑战。DA-BEV将 Query 引入域适应框架,以从图像视图和BEV特征中获得有用信息。它包括两种基于 Query 的设计,即 Query 对抗学习(QAL)和 Query 自训练(QST),它们利用图像视图特征或BEV特征来正则化其他适应性。

大量实验表明,DA-BEV在多个数据集和任务(如3D目标检测和3D场景分割)上始终如一地实现了优越的域自适应BEV感知性能。

1 Introduction

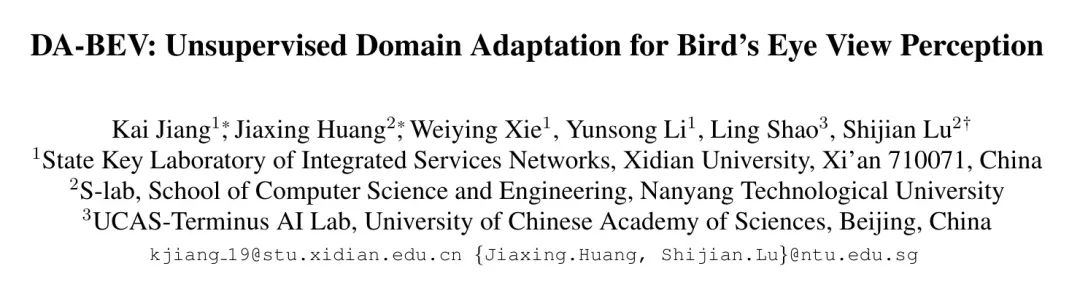

3D视觉感知旨在在3D空间中感知和理解周围环境,这对于各种应用(如移动机器人,自动驾驶,虚拟现实等)至关重要。尽管单目和基于激光雷达的3D感知取得了显著的进步,但仅使用摄像头的3D感知在鸟瞰视角(BEV)近年来越来越受到关注,得益于其在全面3D理解,丰富的语义信息,高计算效率和低部署成本方面的优势。另一方面,在源域训练的仅使用摄像头的BEV模型在应用到目标域时通常会出现明显的性能退化,如图1所示,这主要是由于明显的跨域差异。

无监督域自适应(UDA)旨在通过迁移在标记源域上训练的深度网络模型来解决跨域差异,以应用于无标签的目标域。它已经被广泛探索用于各种2D计算机视觉任务,这些任务在2D空间中感知环境。然而,对于仅使用摄像头的鸟瞰视角(BEV)感知,如何减轻跨域差异的问题更加困难,但尚未得到充分的探索。

作者探索了仅使用摄像头的鸟瞰视角(BEV)感知的无监督域自适应,从简单的观察开始,即仅使用摄像头的BEV感知通常分为两个阶段:

- 首先将多摄像头图像编码为图像视图特征

- 然后将图像视图特征与相应的摄像头配置融合为BEV特征。

如图2所示,图像视图特征捕获了单个视图图像中的大量局部信息,这些信息受到与传统无监督域自适应中的2D图像类似的跨域差异。作为比较,BEV特征捕获了来自BEV空间中的摄像头配置的全局3D信息,由于摄像头配置的变化超出了图像风格和外观的变化,通常会导致更严重的跨域差异。因此,一种有效的方法是通过利用图像视图特征和BEV特征的互补性来缩小仅使用摄像头的BEV感知的跨域差异。

为此,作者设计了DA-BEV,这是第一个针对仅使用摄像头的BEV感知的域自适应BEV感知框架,通过利用图像视图特征和BEV特征的互补性来解决BEV域适应性挑战。将可学习的 Query 引入域适应框架,以促进图像视图和BEV特征之间的互动。

具体而言,BEV特征提供的全局3D信息有助于适应图像视图特征,而图像视图特征中较少变化的2D信息有助于适应BEV特征。遵循这一理念,作者设计了两种基于 Query 的域适应技术,包括 Query 对抗学习(QAL)和 Query 自训练(QST):QAL/QST利用从图像视图特征或BEV特征中 Query 的有用信息来规范另一个“对抗学习”/“自训练”。

所提出的DA-BEV具有三个优点:

- 引入了一种新颖的基于 Query 的域适应策略,利用图像视图特征和BEV特征的互补性进行无监督BEV感知适应;

- 设计了基于 Query 的对抗学习和基于 Query 的自训练,通过分别对齐跨域特征并最大化目标域的似然度,实现UDA。两种设计相互补充,共同有效地实现强大的无监督BEV感知适应;

- 具有泛化性,可以用于不同的仅使用摄像头的BEV感知任务,如3D目标检测和3D场景分割。

本文的贡献可以概括为三个主要方面:

- 首先,探索了无监督的仅使用摄像头的BEV感知适应,并提出了一个基于 Query 的技术,通过利用图像视图特征和BEV特征的互补性来减轻跨域差异。据作者所知,这是第一个利用特定BEV网络架构进行无监督BEV感知适应的工作。

- 其次,设计了DA-BEV,该架构引入了基于 Query 的对抗学习和基于 Query 的自训练,以有效地共同解决域适应的BEV感知问题。

- 最后,大量实验表明,DA-BEV在不同的数据集和任务(如3D目标检测和3D场景分割)上始终如一地实现了优越的BEV感知适应性。

2 Related Work

Camera-only BEV Perception

仅摄像头视角(BEV)感知最近引起了越来越多的关注,因为它具有丰富的语义信息,高计算效率和低部署成本。它捕获了场景的多视图图像,并在 ego-car 坐标系中为各种3D视觉任务(如3D检测,地图分割等)制定统一的BEV特征。根据视图转换方式,大多数现有的仅摄像头视角BEV方法可以分为四类,即同构法,深度法,多层感知(MLP)法和Transformer法。

- 同构法直接将多视图图像特征转换为BEV特征,使用明确构建的单应矩阵。最近的计算效率较高,但在复杂的实际场景中表现有限。

- 深度法估计深度分布,并将其应用于生成多视图2D特征到BEV特征的BEV特征。

- MLP方法学习多视图特征与BEV特征之间的转换,旨在在调整摄像头的设置后减轻固有的归纳偏差。

- 最近的Transformer法设计了一组BEV Query ,通过交叉注意力从图像特征中检索相应的图像特征,最终以自上而下的方式构建BEV特征。

不同于这些方法,作者探索了仅摄像头视角BEV感知的无监督域自适应。

Domain Adaptation

域适应旨在将源域训练的模型适应到各种目标域。大多数现有工作集中在无监督域适应(UDA)上,通过差异最小化,对抗训练或自训练来最小化域间差异。然而,大多数现有2D UDA方法在3D视觉任务中表现不佳,这些任务旨在理解三维空间中的物体和场景。3D UDA最近得到了探索。例如,STMono3D引入了跨域单目3D目标检测的自训练。 [5, 53]和[1]利用激光雷达和多模态数据在3D UDA中,但它们不能用于仅使用摄像头的BEV感知,其中额外数据模态。

最近,MATS研究了多视图3D检测的域适应,但仍然依赖于激光雷达的深度监督。无监督域适应尚未被广泛用于仅使用摄像头的BEV感知的任务。

3 Domain Adaptive BEV Perception

Preliminary

任务定义。本工作关注的是仅使用摄像头的BEV感知的无监督域自适应任务。它涉及一个标记的源域和一个 未标注 的目标域,其中表示多摄像头图像的集合,表示摄像头的配置,表示BEV空间中的3D物体标注,由和表示。目标是学习一个在 未标注 的目标域上表现良好的BEV感知模型。

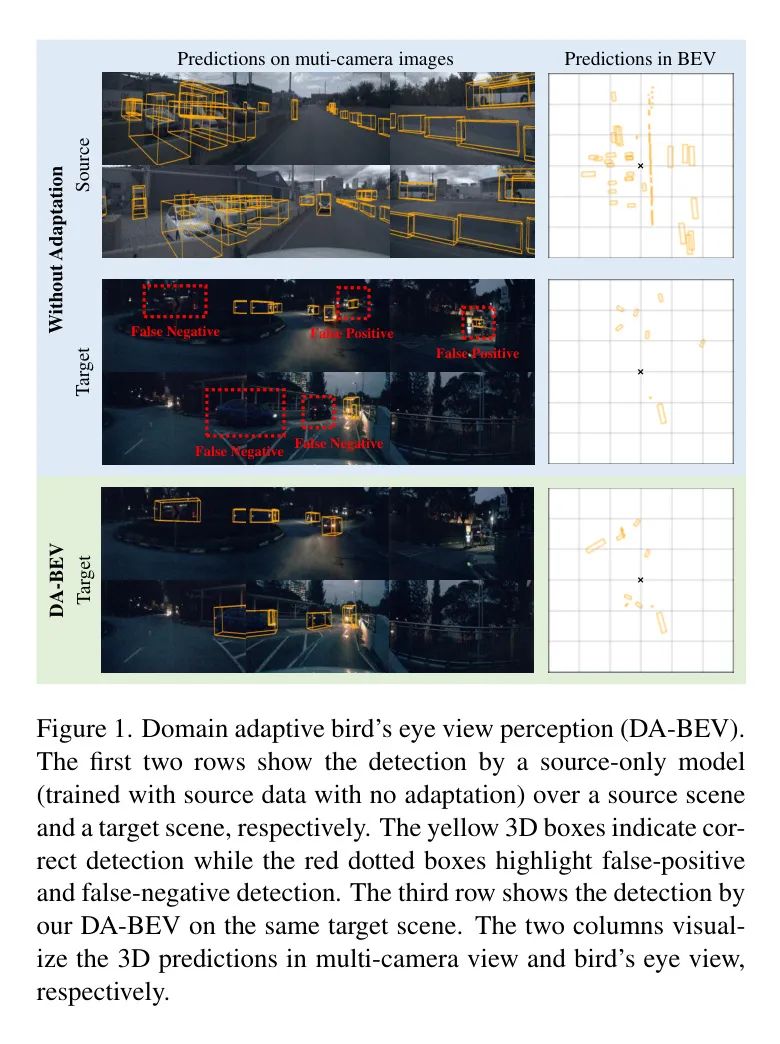

对BEV模型的重新审视。仅摄像头视角的BEV模型通常分为两个阶段,如图2所示。首先将多摄像头图像编码为图像视图特征,然后将图像视图特征与相应的摄像头配置融合,生成3D感知中的BEV特征。

具体而言,仅摄像头视角的BEV模型包括一个2D图像视图特征编码器,一个3D BEV特征编码器,一个BEV特征解码器和一个3D检测Head。给定一组多摄像头图像及其相应的摄像头配置,仅摄像头视角的BEV模型首先将编码为图像视图特征,使用如下所示:

然后,图像特征使用相应的摄像头配置与编码为BEV特征:

BEV特征解码器接着使用一组可学习的BEV Query 解码BEV特征:

其中,解码的 Query 特征与BEV特征相互作用并聚合BEV中物体的3D位置信息,从而得到解码的 Query 特征。给定解码的 Query 特征,3D检测Head通过以下方式预测3D物体边界框:

在监督学习设置下,仅摄像头视角的BEV模型可以表示如下:

其中,表示3D检测损失函数。

Framework of DA-BEV

通过利用图像视图特征和BEV特征的互补性来解决BEV域适应性挑战,如图3所示。具体而言,设计了一种新颖的基于 Query 的域适应技术,引入可学习的 Query ,以实现图像视图和BEV特征之间的互动以及它们的协同适应。

直观上,BEV特征提供的全局3D信息有助于适应图像视图特征,而图像视图特征中较少的域变化提供的局部2D信息有助于适应BEV特征。基于这一理念,作者设计了两种基于 Query 的域适应技术,即 Query 对抗学习(QAL)和 Query 自训练(QST)。QAL/QST利用从图像视图特征或BEV特征中 Query 的有用信息来规范另一个“对抗学习”/“自训练”,如图3所示。

为了捕捉图像视图特征中的2D信息,且减少跨域差异,作者引入了一个图像视图特征解码器,并使用一组可学习的图像视图 Query 。因此,和之间的交互产生了图像视图 Query 特征,如下所示:

Query 特征随后被输入到一个多标签分类头中,以预测每个物体类别的概率。其中,通过一个多标签分类损失函数进行训练,如下所示:

其中,表示图像视图多标签分类的标注。

注意,对于源数据和目标数据都进行计算。对于源数据,通过将中的物体类别标签合并来生成图像视图多标签分类标注。对于目标数据,根据定义在方程14中的模型预测来生成。

因此,解码的图像视图 Query 特征能够捕获图像视图特征中的丰富2D语义和位置信息。与BEV特征相比,它们包含的跨域差异要少得多,因此可以极大地促进BEV特征的适应。

此外,图像视图 Query 的多标签分类训练目标鼓励捕获不同类别之间的更平衡信息,这有助于促进使用一热物体类别标注训练的BEV特征的适应,因为这些特征通常容易受到明显的类别不平衡问题的影响。

为了捕获BEV特征中的全局3D信息,作者直接使用方程3中提供的现成的BEV Query ,这些 Query 与BEV特征相互作用以生成解码的BEV Query 特征。

由于BEV特征与摄像头配置编码,与3D物体标注训练,解码的BEV Query 特征捕获了丰富的全局3D信息,包括3D BEV空间中的物体位置。它们可以帮助捕获BEV空间中少量全局3D信息的图像视图特征的适应。

Query-based Adversarial Learning

作者提出的QAL利用从图像视图或BEV特征中 Query 的有用信息来规范化另一个的对抗学习。如图3所示,QAL使用两个域分类器分别测量图像视图 Query 特征和BEV Query 特征之间的跨域距离,并利用测量的跨域距离进行相互规范化。

因此,QAL同时减轻了图像视图特征中局部2D信息的跨域差异和BEV特征中全局3D信息的跨域差异,这两者对于在3D空间中定位和识别物体和背景都是至关重要的。

此外,2D图像视图 Query 特征的对抗学习涉及很少的3D信息,而BEV Query 特征可以通过提供丰富的全局3D信息来有效地规范化它,即增强具有显著3D BEV跨域差异的2D图像视图对抗学习样本,同时减弱具有较小3D BEV跨域差异的2D图像视图对抗学习样本。同样,3D BEV Query 特征的对抗学习可以通过捕获丰富的2D语义和位置信息的图像视图 Query 特征进行规范化。

具体而言,使用域分类器和来度量2D图像视图特征和3D BEV特征之间的跨域距离,如下所示:

其中,和分别表示与源图像视图特征和目标图像视图特征交互的解码图像视图 Query 特征(在式(6)中),和分别表示与源域和目标域BEV特征交互的解码BEV Query 特征(在式(3)中)。

QAL在图像视图特征和BEV特征之间的相互正则化可以表示如下:

其中,是一种广泛采用的对抗学习损失函数,用于跨域对齐。

Query-based Self-training

作者提出的QST利用从图像视图和BEV特征中 Query 的有用信息来规范化它们的自我训练,如图3所示。直观上,解码的图像视图 Query 特征捕获了具有较少跨域差异的丰富的2D语义和位置信息,而解码的BEV Query 特征捕获了丰富的全局3D信息(在BEV空间中)。因此,这两种类型的特征相互补充,共同利用全面的2D和3D信息有效地规范化自我训练。

具体而言,QST首先利用图像视图或BEV特征的预测来去噪另一个特征的预测:

其中,和分别表示图像视图预测和BEV预测在跨视图去噪前后的最大概率。请注意,对每个相机视角分别进行上述跨视图去噪操作。

然后,QST通过累积捕获全面2D和3D信息的去噪预测来获取全局类别分布,并进一步利用它来促进伪标签生成。具体而言,将全局类别概率分布建模为高斯分布,其中表示类别索引。作者通过维护一个先进先出(FIFO)的历史预测队列来估计和:

其中,表示队列长度,表示队列中的第个历史预测。请注意,仅使用,因为它在跨去噪后的中已经包含了2D信息。

在训练过程中累积和,以获得对更稳定的估计:

其中,表示用于平滑更新的指数移动平均参数。

根据估计的全局类别概率分布,作者选择每个类别的顶部百分比的预测作为伪标签。伪标签阈值可以通过求解以下方程来确定:

其中,表示的累积密度函数。请注意,作者对图像视图预测和以及BEV预测都应用了阈值,以获得图像视图和BEV的伪标签和。

因此,作者的伪标签生成方法具有三个优点:

- 阈值随着训练过程中图像视图和BEV特征捕获的互补2D和3D信息而动态更新;

- 通过为每个类别选择相同百分比的伪标签来缓解类别不平衡问题;

- 可以在线工作,不需要像[27, 87]中的额外推理轮次。

QST的训练损失可以因此表示为:

Overall objective

总之,所提出的DA-BEV的总体训练目标可以表示如下:

其中,,,,。

4 Experiments

Datasets

作者在各种BEV适应场景下广泛评估了作者的DA-BEV,包括在不同光照条件、不同天气条件、不同城市和不同摄像头系统下的适应。这四种BEV适应场景涉及两个3D感知数据集,包括nuScenes和Lyft。

nuScenes是一个大规模的自动驾驶3D数据集,包括从1000个场景中捕获的6个摄像头的图像,这些场景包括白天/晚上和“晴朗天气”/“雨天”条件,以及来自新加坡/波士顿城市。对于3D目标检测,它包括140万带有10个类别标注的3D边界框。对于3D场景分割,它包含200万帧具有3D空间细粒度分割标注的帧。

Lyft是一个用于3D感知的自动驾驶数据集,它拥有一组具有不同内参和外参的摄像头。它包括366个场景,其中包含130万个3D目标检测标注,这些标注是从加利福尼亚州捕获的,与nuScenes使用的不同摄像头系统。

有了nuScenes和Lyft,四种子BEV适应场景可以表示为:“nuScenes白天 nuScenes夜晚”用于跨光照适应,“nuScenes晴朗天气 nuScenes雨天”用于跨天气适应,“nuScenes新加坡 nuScenes波士顿”用于跨城市适应,“Lyft相机系统 nuScenes相机系统”用于跨不同相机配置的适应。

Implementation Details

作者在PETR的基础上实现了DA-BEV,并采用VoVNetV2作为 Backbone 网络。遵循PETR,作者使用AdamW优化器,初始学习率为,权重衰减为0.01。所有模型在一个2080Ti GPU上训练50k次,批量大小为2。对于3D目标检测,Transformer解码器包含6层,每个物体 Query 有900个。对于3D场景分割,采用625个分割 Query 和6层Transformer解码器进行语义分割结果。

Main Results

由于在域自适应仅摄像头视角的BEV方面缺乏研究,作者将作者的方法与在2D目标检测和单目3D目标检测方面取得最先进性能的许多域自适应方法进行比较。

这些比较方法可以通过直接将它们的对抗学习和技术/自我训练技术引入到仅摄像头视角的BEV感知模型中来轻松应用于域自适应的仅摄像头视角的BEV感知。比较是在以下文本中详细描述的四种具有挑战性的BEV适应场景进行的。

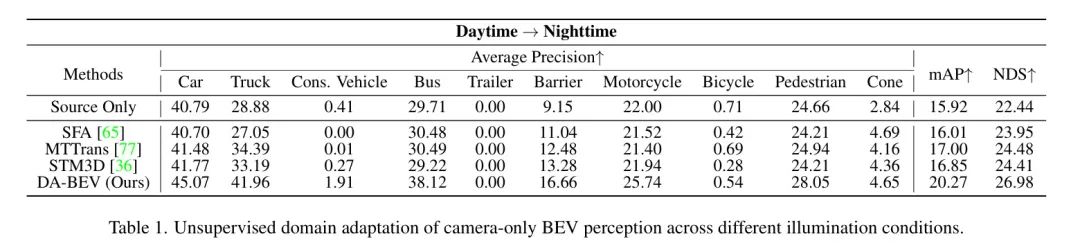

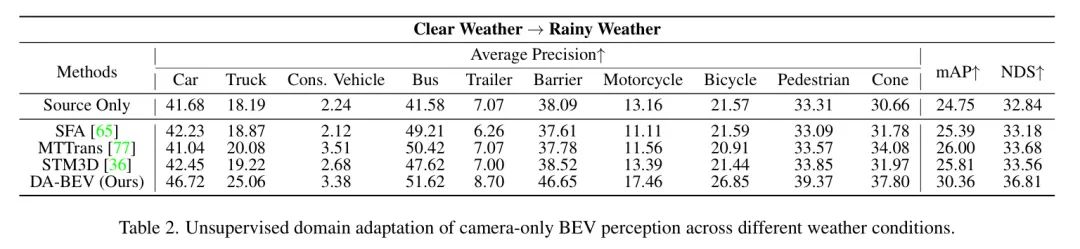

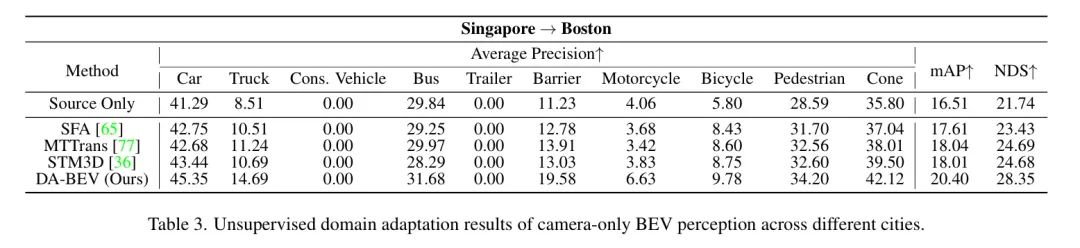

表1、2和3分别报告了在不同的光照条件、天气和城市下,仅摄像头视角的BEV感知的无监督域自适应。作者可以观察到,与基准相比,DA-BEV在这些三个自适应场景上取得了显著的改进,包括在mAP上的、和的改进,以及在NDS上的、和的改进。此外,DA-BEV在这些三个自适应场景上明显且一致地优于最先进的UDA方法。

DA-BEV在BEV感知方面的优越自适应性能主要归因于两个因素:

- DA-BEV引入了基于 Query 的域自适应,巧妙地利用了BEV模型中图像视图特征和BEV特征的互补性,有助于有效地解决BEV感知中的域间隙。

- DA-BEV引入了两种基于 Query 的域自适应方法,即QAL和QST,它们相互补充,共同实现强大的BEV感知自适应。

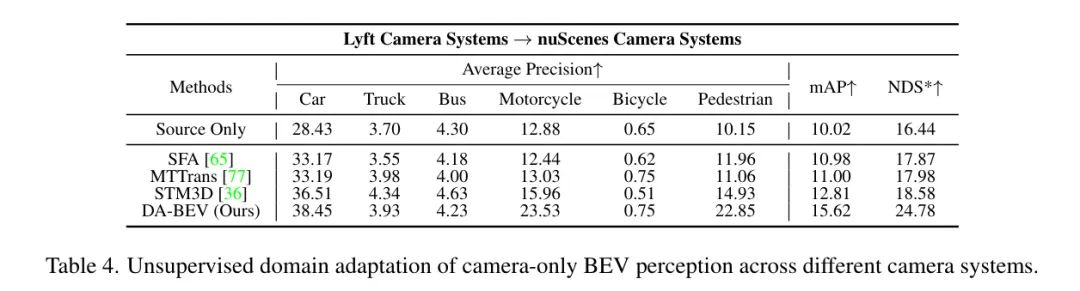

表4报告了仅摄像头视角的BEV感知的无监督域自适应在不同摄像头系统下的表现。Lyft和nuScences数据分别使用具有非常不同的摄像机系统,这些摄像机系统在摄像机内参(包括焦距和视场角)和摄像机外参(包括摄像机姿态和摄像机位置)方面存在明显的域间隙。

可以观察到,与 Baseline 和最先进的UDA方法相比,DA-BEV在mAP和NDC指标上取得了显著的改进,包括在mAP上超过3.98%的改进和NDS上超过7.31%的改进。这些实验表明,DA-BEV可以很好地处理不同摄像机系统之间的BEV自适应,这些自适应受到来自摄像机配置输入的域间隙的影响,超过了来自图像输入的域间隙。

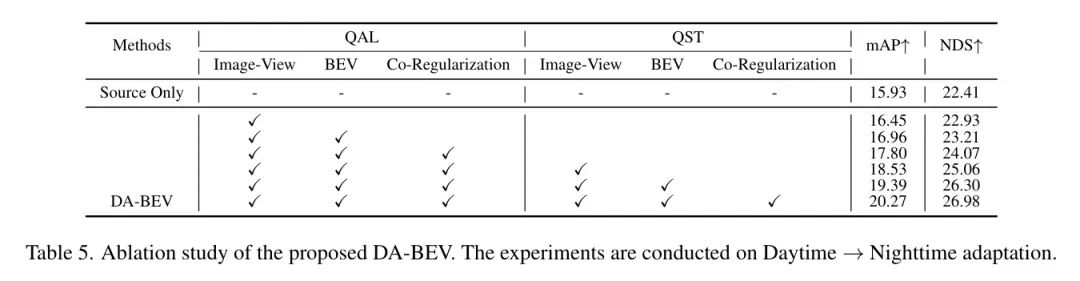

Ablation Study

作者进行了广泛的消融研究,以了解DA-BEV中不同组件的贡献。实验在Daytime Nighttime自适应上进行。如表5所示,由于域间隙, Baseline 表现不佳。

作为比较,包括在图像视图特征和/或BEV特征上进行基于 Query 的对抗学习改进了 Baseline ,表明QAL可以同时减轻2D图像视图特征和3D BEV特征之间的跨域差异。此外,引入图像视图和BEV Query 对抗学习之间的共正则化进一步明显地改进了性能,表明图像视图和BEV特征编码了互补的跨域差异信息,有效地调节了每种对抗学习的自适应。

此外,在图像视图和/或BEV特征上应用基于 Query 的自训练也带来了明显的改进,表明QST有助于从图像视图和BEV分别学习有效的2D和3D信息。此外,图像视图和BEV特征之间的共正则化进一步改进了基于 Query 的自训练,表明图像视图和BEV特征提供了互补且全面的目标信息,有效地调节了它们的自我训练。此外,QAL和QST的组合表现最好,清楚地表明QAL和QST互补,共同有效地实现了强大的无监督BEV感知适应。

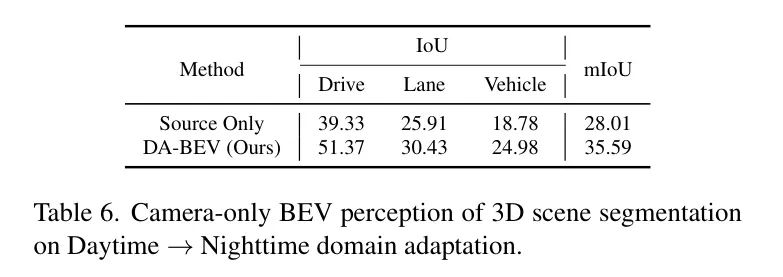

Discussion

作者通过评估DA-BEV在两个代表性的3D感知任务上的性能,包括3D目标检测和3D场景分割,来研究它在3D感知任务上的泛化能力。实验结果如表1-4和6所示,DA-BEV在3D检测和分割任务上始终取得了优越的性能,这证明了DA-BEV在不同3D感知任务上的泛化能力。

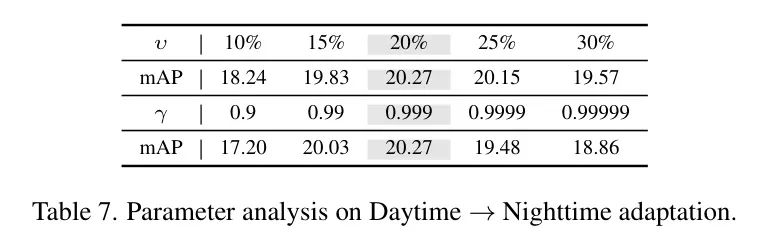

参数研究。如方程13所示,参数控制作者将多少个预测选择为伪标签。作者通过将从10%变化到30%,步长为5%,来研究的变化。

表7上半部分的实验表明,当从15%变化到30%时,域适应性不会受到很大影响。但是,当设置为10%时,性能下降更多,因为当目标样本的伪标签非常有限时,适应性会倾向于源域。如方程12中所述,参数控制估计的全局类别概率分布的更新速度。通过将从0.9变化到0.99999,来研究的变化。表7下半部分的实验表明,当在0.99到0.9999之间变化时,DA-BEV对参数的变化是容忍的,因为这两个值可能导致更新速度过快或过慢,导致全局类别概率分布的估计不稳定或接近固定,从而降低性能。

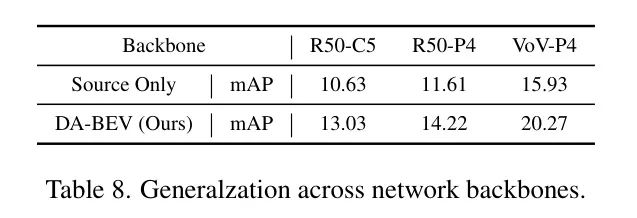

通过评估DA-BEV在不同大小的网络 Backbone 上的性能,包括ResNet-50-C5(46.9M),ResNet-50-P4(46.9M)和VoV-P4(96.9M),来研究它在不同网络 Backbone 上的泛化能力。表8的结果表明,DA-BEV在小型和大型 Backbone 上都取得了稳定的改进,这证明了DA-BEV在不同网络 Backbone 上的泛化能力。

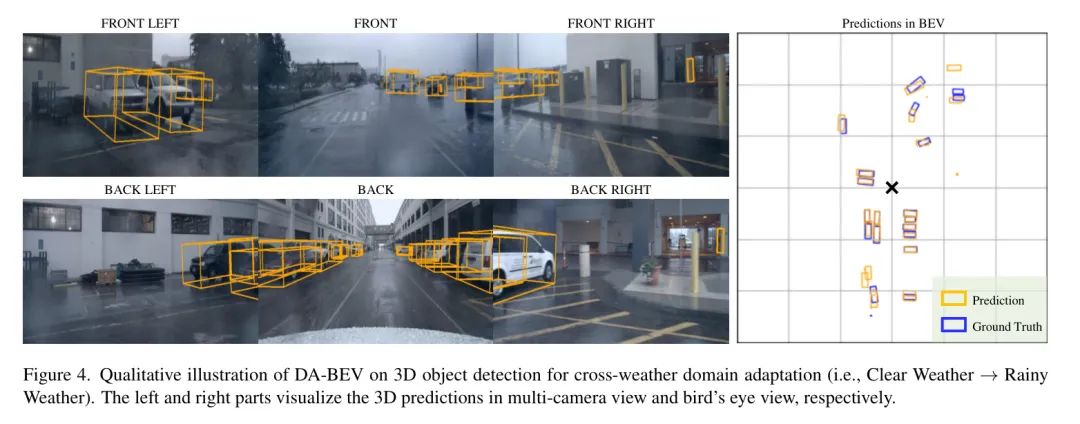

作者提供DA-BEV在跨天气域自适应方面的定性说明。如图4所示,DA-BEV可以在天气诱导的域间隙下产生准确的3D目标检测。例如,前端左摄像头的最左边的车辆在雨中变得模糊,但作者的DA-BEV仍然可以准确地检测到它。

由于篇幅限制,作者在附录中提供了更多关于DA-BEV的讨论以及额外的定性说明。

5 Conclusion

在本文中作者提出了,这是第一个解决域适应BEV挑战的仅摄像头视角BEV框架,它通过利用图像视图特征和BEV特征的互补性来应对域适应BEV的挑战。DA-BEV引入了基于 Query 的对抗学习(QAL)和基于 Query 的自训练(QST),其中QAL/QST利用从图像视图特征或BEV特征中 Query 的有用信息来规范另一个“对抗学习”/“自训练”。

大量的实验证明了DA-BEV在各种数据集和任务上的优越域适应BEV感知性能。并进一步探索图像视图和BEV特征的互补性,通过引入它们的时间信息。

参考

[1].DA-BEV: Unsupervised Domain Adaptation for Bird’s Eye View Perception.

扫描下方二维码,添加AI驾驶员

获取更多的大模型与多模态等信息

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง