点击下方卡片,关注「AI视界引擎」公众号

本文介绍了Aim,这是一个预训练的视觉模型集合,采用自回归目标。这些模型受到文本对应物(即大型语言模型(LLMs))的启发,并表现出类似的扩展性质。具体来说,作者提出了两个关键发现:

- 视觉特征的性能与模型容量和数据量均有关;

- 目标函数值与模型在下游任务上的性能相关。

作者通过预先训练一个70亿参数的Aim模型在20亿图像上的结果来解释这些发现,该模型在ImageNet-1k上的性能达到84.0%,且Backbone网络保持冻结。

有趣的是,即使在这个规模上,作者并未观察到性能出现饱和的迹象,这表明Aim可能代表了一种新的大型视觉模型训练的前沿。Aim的预训练类似于LLMs的预训练,不需要任何针对图像的特定策略来在规模上稳定训练。

1 Introduction

自然语言处理领域最近的大语言模型(LLMs)革命使得预训练任务无关模型成为标准。这些模型能够从几个例子中解决复杂的推理任务,遵循指令,现在已经成为广泛使用的AI助手,如ChatGPT的动力。使它们成功的一个关键因素是,随着模型容量(,参数数量)或预训练数据量的增加,它们能够持续改进。

这些模型的扩展行为有两个关键原因。首先,尽管这些模型使用简单的目标 – 在给定句子的过去的情况下,预测下一个单词 – 他们却能够在长期的上下文中学习复杂的模式。其次,当与某些架构结合使用时,这种自回归目标的扩展性最为明显,特别是Transformer [79],突显了自回归预训练和这种架构之间的潜在协同作用。

这些观察结果自然提出了一个后续问题,即自回归目标下的Transformer扩展是否仅限于文本。尤其是在考虑到上述元素中没有一个具有语言建模的固有特性时,这一点尤为重要。自回归目标源于数据压缩,类似的方法在音频和图像中也得到了研究。Transformer架构在计算机视觉等其他领域中也得到了成功应用,特别是Vision Transformers(ViT) 的成功。因此,作为将LLMs的发现推广的第一步,作者探索是否使用自回归目标训练ViT模型会导致在表示学习方面具有与LLMs相同的扩展能力。

在本文中,作者介绍了自回归图像模型(A1M),这是一种自回归方法,用于大规模视觉特征的预训练。作者使用现代工具集,包括视觉Transformer、大规模网络数据集合和最近在LLM预训练方面的进展,重新检查了自回归表示学习的前期工作,如iGPT。此外,还引入了两个架构修改,以将自回归预训练适应于视觉特征。首先,不是像LLMs那样将自注意力限制为完全因果,而是采用前缀注意力,如T5。这个选择使作者能够在下游任务中切换到完全双向注意力。其次,作者使用了一个参数化的标记级预测头,灵感来自对比学习中使用的头。作者观察到这种修改在训练过程中几乎不增加开销,显著提高了后续特征的质量。总体而言,Aim的训练类似于最近LLMs的训练,并且不需要任何稳定性增强技术,这些技术是监督学习或自监督学习所需的。

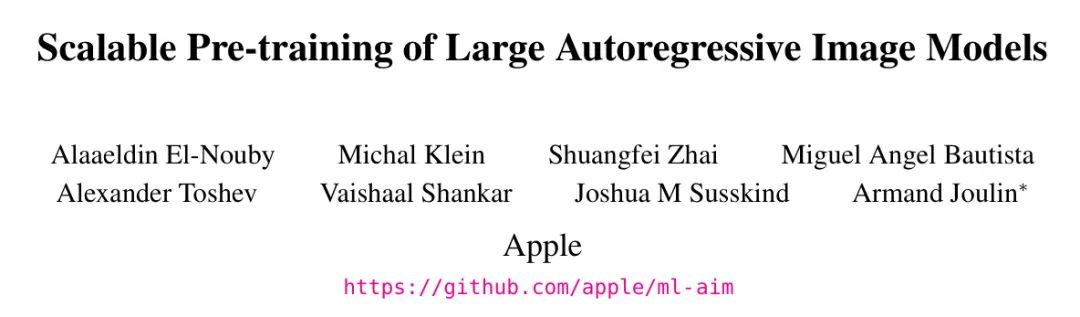

作者提供了一系列模型的研究,这些模型在6亿到70亿参数之间,使用20亿张未整理的图像进行预训练,这些图像具有宽松的许可证。作者的Aim模型在模型大小方面表现出强大的扩展性,如图1所示,更高的容量模型在15个图像识别基准测试上的平均准确性更好。更重要的是,作者的目标函数在验证集上的值与后续冻结特征的质量之间存在相关性。这一观察确认了自回归目标对于视觉特征的训练是充足的。此外,作者观察到在训练更多的图像时,下游性能持续改进,没有出现饱和的迹象。总的来说,这些观察与关于扩展大规模语言模型的先前研究相一致。

2 Related Work

自回归模型。尽管关于自回归模型的文献大多来自语言建模或语音,但很少有工作探讨这种方法在图像上的潜力。特别有趣的是,Van den Oord等人表明,使用一个针对图像的适应性架构,即卷积网络,显著优于使用更通用的架构,即循环网络。Parmar等人 通过采用Transformer架构,进一步改进了这些自回归模型的质量。更近一些,Chen等人 表明,随着计算能力的增加,扩展性会带来连续的改进。作者的工作遵循这一研究线,并从训练在显著更多的数据上,以及进一步改进架构设计,训练和理解扩展定律中受益。与此同时,Bai等人 证明了大规模自回归视觉模型在上下文像素预测任务(例如,语义分割,深度估计)的有效性。

自监督预训练。在近年来,预训练在图像数据集上没有监督的情况下在视觉模型上进行研究已经是一个富有成果的领域。采用了各种代理任务进行特征学习。例如,Noroozi和Favaro 学习重新排列随机打乱的图像块的顺序。一些其他的工作依赖于聚类。另一种流行的方法涉及使用对比目标,这类似于预测编码,其中目标是识别每张图像。最近的对比方法包括DINO,BYOL 或 iBot。在类似的情况下,一些工作提出了预测方法或一种形式的特征去噪。更接近作者的方法的工作受到BERT的启发,其中块被遮盖并使用自动编码器以离散或像素的形式进行预测。

其他生成式预训练。自动回归建模是一种生成式建模形式,很少有其他生成式方法被考虑用于学习视觉特征。第一类利用某种形式的自动编码,其中预训练任务对应某种去噪任务。例如,噪声可以是椒盐噪声或Mask。另一条工作线利用生成对抗网络(GANs)。值得注意的是,BigGAN训练一个大的GAN,并重复使用图像判别器来生成图像特征。最近,Diff-MAE使用扩散模型来学习图像特征。

预训练规模扩展。有许多关于在无监督条件下扩展视觉特征预训练的工作。这个领域的最突出工作是DINOv2,他们在一个私人数据集上,包含14.2亿张图像和一个4.6亿参数的模型,通过扩展iBot方法产生最佳自监督特征。从这项工作的结论中可以得出,经过仔细调整的对比方法可以合理地扩展,但他们没有表现出语言建模中观察到的扩展定律。他们还依赖于对比学习的复杂实现来避免Chen等人描述的陷阱。与此同时,Singh等人研究了Masked Autoencoders(MAE) 的扩展性。虽然这项研究关注的是弱监督设置,但它并没有展示出在数据扩展到数十亿张图像时自监督预训练的明显改进。相反,作者观察到在参数规模为数十亿和图像规模为数十亿时,特征质量的明显优势。

3 Pre-training Dataset

作者在Fang等人引入的DFN数据集上预训练作者的模型。该数据集包括从Common Crawl中过滤出的12.8亿图像-文本对。数据已经预处理,以删除不适宜内容,模糊人脸,并通过对评估集进行去重以减少污染。一个数据过滤网络根据图像和它们相应的标题之间的对齐得分对12.8亿样本进行排序。从DataComp 12.8B数据集中提取了20亿图像的一个子集,称为DFN-2B,方法是保留前15%的样本。请注意,除了隐私和安全过滤外,此过程不涉及根据图像内容进行任何额外的筛选。由于作者的预训练不需要文本,作者的方法可以利用不与标题配对或图像文本对齐较低的其他DataComp 12.8B图像集合进行预训练。

受到LLM预训练中过度采样高质量数据源(如维基百科和书籍)的常见做法的启发,在预训练期间,作者从DFN-2B中以概率p=0.8采样图像,从ImageNet-k中以概率p=0.2采样图像。作者将这种数据集称为DFN-2B+。

4 Approach

Training Objective

作者遵循标准自回归模型在图像块序列上的训练目标。更具体地说,图像x被分成一个大小为K的非重叠块,其中,这些块共同形成一个标记序列。作者假设所有图像的序列顺序固定,默认为行(即块)主要顺序,除非另有指定。根据上述顺序,图像的概率可以分解为块条件概率的乘积:

$P(x)=prod_{k=1}^{K}P(x_{k}mid x_{<k}), tag{1}$<=”” p=””>

其中$x_{<k}$表示前$k-1$个块,并作为预测第$k$个块的上下文。与语言建模不同,作者的序列长度固定为k,并可以存储在内存中,因此作者不需要截断上下文长度。然后,对于一组图像$mathcal{x}$,训练损失被定义为负对数似然度(nll):< p=””></k}$表示前$k-1$个块,并作为预测第$k$个块的上下文。与语言建模不同,作者的序列长度固定为k,并可以存储在内存中,因此作者不需要截断上下文长度。然后,对于一组图像$mathcal{x}$,训练损失被定义为负对数似然度(nll):<>

$sum_{xinmathcal{X}}sum_{k=1}^{K}-log P(x_{k}mid x_{<k}).$< p=””></k}).$<>

在没有进一步假设的情况下,最小化这个目标函数在无限多图像上,在理论上等价于学习真实的底层图像分布。

预测损失作者的训练目标自然产生了一些损失的变体,每个变体对应于对分布$P(x_{k}mid x_{<k})$的选择。默认为采用类似于he等人 [41]=”” 的归一化像素级回归损失。这种损失对应于将$p(x_{k}mid=”” x_{<k})$设置为具有常方差的gaussian分布。即,给定从网络参数化$theta$中预测的第$k$个块的$hat{x}_{k}(theta)$和其对应的=” gt=”” p=”” data-tool=”mdnice编辑器” style=”cursor:pointer;” span=”” role=”presentation” data-formula=””k” data-formula-type=”inline-equation” svg=”” xmlns=”http://www.w3.org/2000/svg” focusable=”false” viewbox=”0 -666 3024.9 823.8″ aria-hidden=”true” g=”” stroke=”currentColor” fill=”currentColor” stroke-width=”0″ transform=”translate(2524.9, 0)” data-mml-node=”mn” path=”” data-c=”30″ d=”M96 585Q152 666 249 666Q297 666 345 640T423 548Q460 465 460 320Q460 165 417 83Q397 41 362 16T301 -15T250 -22Q224 -22 198 -16T137 16T82 83Q39 165 39 320Q39 494 96 585ZM321 597Q291 629 250 629Q208 629 178 597Q153 571 145 525T137 333Q137 175 145 125T181 46Q209 16 250 16Q290 16 318 46Q347 76 354 130T362 333Q362 478 354 524T321 597Z” data-mjx-texclass=”ORD” rect=”” width=”828.6″ height=”60″ x=”120″ y=”220″ h3=”” backbone=”” figure=”” img=”” src=”https://imgs-1315907026.cos.ap-shanghai.myqcloud.com/AIM_%E8%A1%A81.png” alt=””>i” data-formula-type=”inline-equation” style=”position: relative;”>,并且。这种方法使作者能够在训练期间,用单次前向传播处理图像,而不会产生额外的计算开销。</k})$设置为具有常方差的gaussian分布。即,给定从网络参数化$theta$中预测的第$k$个块的$hat{x}_{k}(theta)$和其对应的=”>

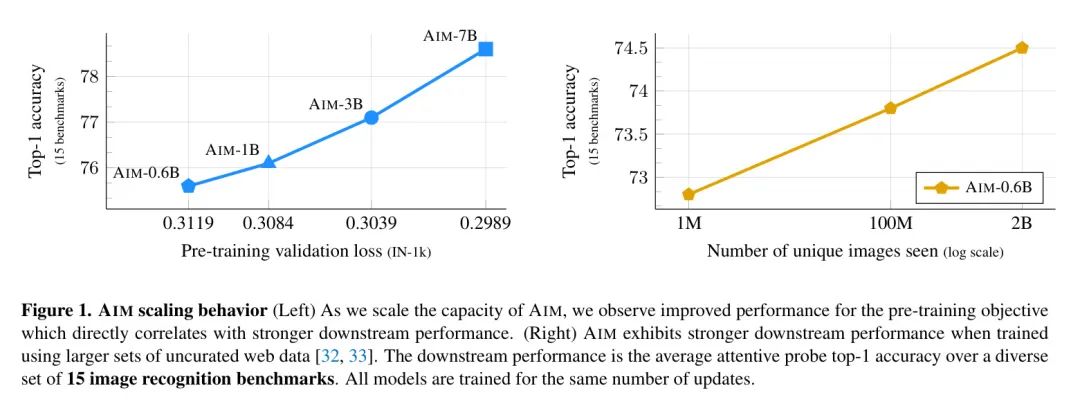

前缀Transformer。预训练中的自回归目标需要因果Mask在自注意力操作中。然而,这与ViT模型在下游任务中的标准使用不同,在下游任务中采用的是双向自注意力。这种差异导致无论在下游适应过程中是否保留因果Mask,性能都会降低(如表3中呈现的消融实验所示)。

为了解决这个问题,作者提出将序列的初始块,称为前缀,作为预测剩余块的上下文。前缀块不包括在自回归预测中,因此不受到因果Mask的约束。更具体地说,作者选择一个前缀长度大小为,并移除因果Mask,即对于$k<s$。这种修改有助于模型在没有因果mask的情况下工作,允许在下游适应过程中将其移除。这种方法改进了模型在下游任务中的性能,并消除了对vit架构的更改需求。图3说明了因果注意和前缀注意之间的差异。< p=””></s$。这种修改有助于模型在没有因果mask的情况下工作,允许在下游适应过程中将其移除。这种方法改进了模型在下游任务中的性能,并消除了对vit架构的更改需求。图3说明了因果注意和前缀注意之间的差异。<>

MLP预测头。在预训练期间,采用某些预测头是一种常见的做法,在转移到下游任务时弃用这些头。这些头的作用是防止 Backbone 特征过于专业化,从而增强其适合于下游转移的能力。作者选择了简单的设计,即在最终 Transformer 层之上使用个MLP块,每个块独立处理每个块。作者观察到这种设计在性能和预训练期间产生的额外成本之间达到了良好的平衡。

直接实现。值得注意的是,Aim不需要特定的优化稳定性增强机制,如LayerScale,随机深度,QK-Norm或冻结块投影器。这些机制对于其他方法的成功至关重要,无论是有监督的还是自监督的。相反,作者观察到Aim使用相同的优化超参数集在模型大小不同的情况下进行扩展,而无需进一步调整(见表1)。

在 Transformer 之前和MLP头之前,作者为输入块添加了正弦位置嵌入。作者使用所有MLP块的标准扩展比例4。作者省略了偏置项以简化实现,与原始ViT不同,作者并未在输入中添加分类标记。默认为所有模型容量使用12个MLP块头。在损失计算之前,作者对每个块进行像素目标的归一化,这是根据He等人提出的。作者使用bfloat16精度训练模型。作者使用AdamW [52]优化器,具有线性 Warm up 和余弦衰减调度。作者在附录D中详细介绍了预训练和下游适应所使用的超参数。

下游适应。预训练大规模模型是一项资源密集型过程,即使微调它们也是耗时的。因此,作者专注于所有模型权重在下游任务中保持固定的场景。在这种背景下,作者只训练一个分类头,这可以减少在小型下游数据集上过拟合的风险,并显著降低适应成本。

与对比学习不同,作者的损失是针对每个块独立计算的。这意味着作者的预训练不包括任何全局图像描述符的概念,因此作者没有全局图像标记。尽管一些方法依赖于全局平均池化从块特征中构建全局特征,但作者发现,结合其他生成式方法如MAE的作者的方法,在线性分类器之前放置注意力池化操作更有利。其他一些工作采用了这种注意力池化以在参数或浮点运算数量最小的情况下提高性能。

具体来说,给定一组块特征,作者通过在块特征上进行多头注意力池化来计算全局描述符:

其中,对于每个注意力头, 分别对应键和值权重矩阵; 是一个可学习的 Query 向量。作者得到池化特征,作为线性分类器的输入。默认为头数,使得总的可学习参数数为,这是一个可以忽略不计的成本,与主要的模型大小相比。包括这种注意力池化使得整个操作不再严格为线性,因此作者称其为“注意 Prob ”。然而,线性检测的优势,例如,额外的参数数量较少,过拟合的风险较小,仍然得以保留。

5 Results

Impact of scaling

作者衡量了在参数和训练数据扩展作者的方法时的影响。特别是,作者研究了预训练目标与各个基准上的下游性能之间是否存在关联。作者还研究了扩展对损失函数值的影响。对于所有这些实验,作者在IN-1k的验证集上报告了作者的损失函数值。

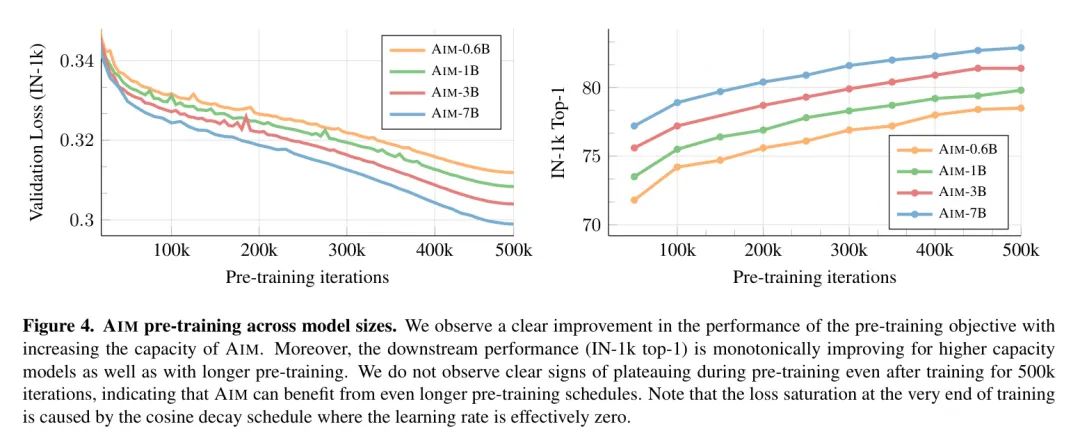

在图4中,作者测量了每个模型在训练迭代次数为函数时的预训练损失和验证集上的分类准确率。作者观察到这两个 Prob 在训练过程中相应地提高,表明直接优化作者的目标可以导致更好的下游性能。

参数数量。作者观察到,随着作者模型的容量扩展,损失值和下游任务的准确率都有所提高。这一观察与语言模型的趋势一致,可以直接归因于作者目标函数的优化,这反过来又导致了更强的表示的学习。

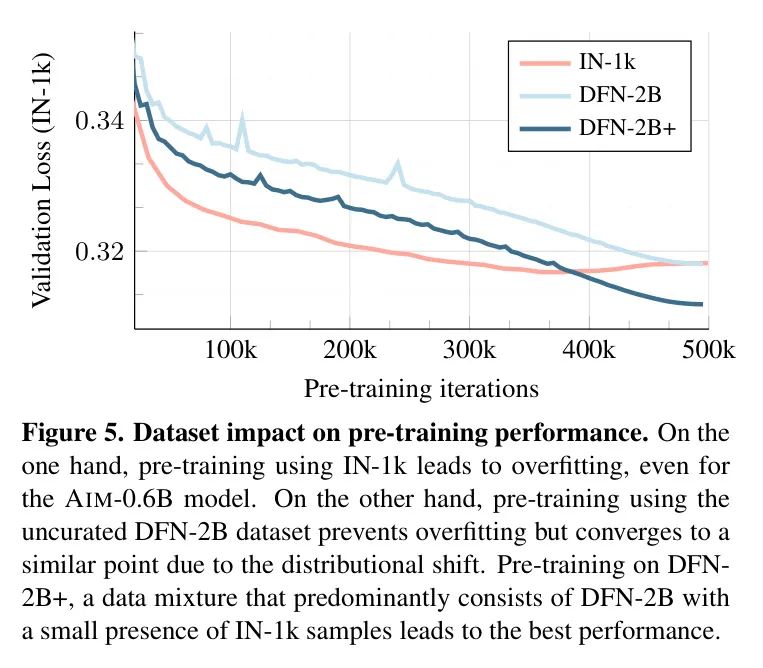

在图5中,作者显示了在预训练时,作者在一个大小为100万张图像的小型精选数据集(即IN-1k)上,或者在更大的一组2亿张图像(即DFN-2B+)上进行预训练时,验证损失的变化。可以预见,在IN-1k上训练会快速导致验证损失的降低,这是因为该损失与同一分布的验证集上的IN-1k数据分布相关。然而,在训练结束时,该损失开始恶化,表明对训练数据的过拟合。

当在未整理的DFN-2B数据集上进行训练时,模型开始时具有更高的验证损失,但损失持续减小,没有过拟合的迹象。当该数据集与少量的IN-1k数据进行扩充,如SS 3中详细描述的那样,作者观察到性能进一步改善,并最终超过了在IN-1k上预训练的性能。作者确认,导致更好下游性能的模型也出现在表2中。

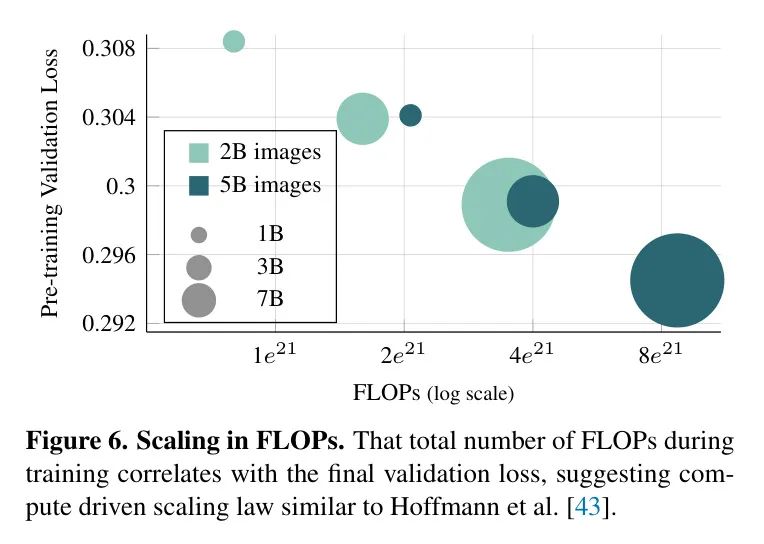

计算最优预训练。由于作者在使用DFN-2B+数据集进行训练时未观察到过拟合迹象,作者继续检查预训练时间表长度的变化对性能的影响。在图6中,作者研究了将预训练时间表长度从50万次迭代增加到120万次迭代的影响,即在预训练期间看到的图像数量从2亿增加到5亿。作者观察到,预训练时间更长的模型实现了显著的较低验证损失。

这表明,可以通过增加模型容量或预训练更长的时间表来改进Aim的性能。有趣的是,作者发现,在相同数量的浮点运算(FLOPs)下,训练时间较长的低容量模型实现的验证损失与训练时间较短的高容量模型相当。这一发现与Hoffmann等人一致,表明Aim可能遵循类似的扩展定律。然而,作者将在未来的工作中进一步研究这一方面。

Architecture and Design

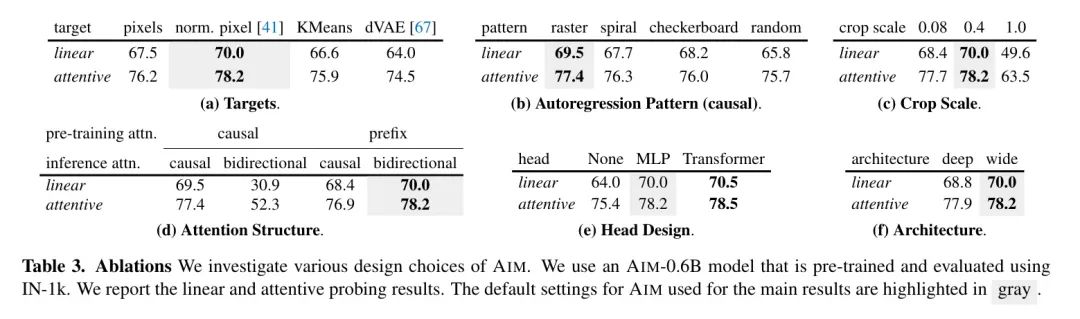

在本节中,作者研究了作者的模型和训练目标的一些变化对性能的影响。这些正则化实验使用的是预先在IN-1k数据集上预训练和评估的Aim-0.6B模型。这些正则化实验的结果在表3中呈现。

目标与目标函数(a)。作者探索各种潜在的目标块表示。一种方法是利用原始像素值,并使用均方误差(MSE)回归损失进行训练。另一种方法是采用与He等人提出的相同MSE损失,使用每个像素值归一化的像素值而不是原始信号。最后,另一种方法是使用块的离散表示,可以是k均值或离散VAE。在这种情况下,模型使用类似于语言模型的交叉熵目标进行训练。作者的实验表明,当使用归一化像素值MSE目标时,Aim的表现最好。

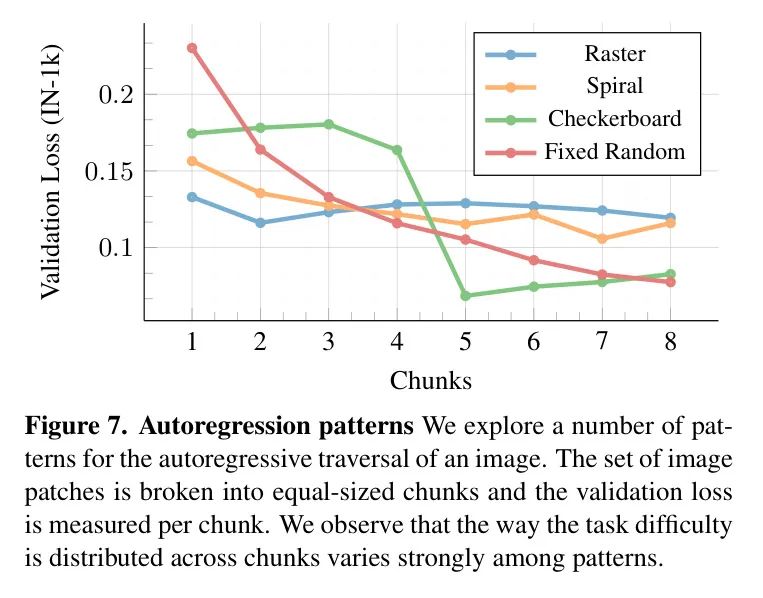

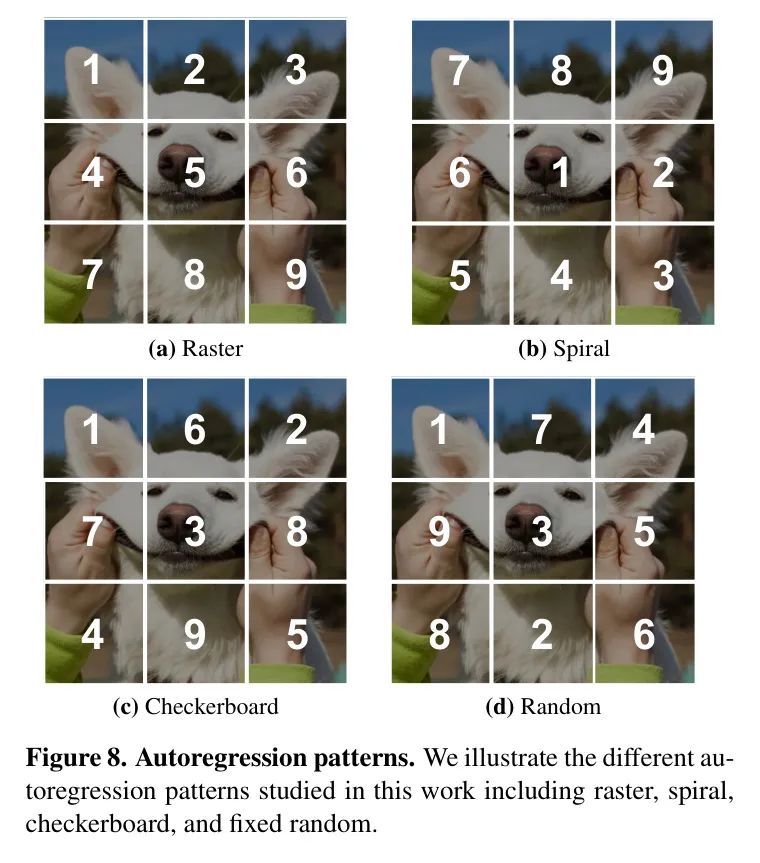

自回归模式(b)。自回归预训练通常遵循特定的遍历顺序,以方便预测下一个标记。在语言中,遍历模式非常明确,因为文本是按顺序一次读取和写入一个单词的(_e.g._,从左到右为英语)。然而,对于图像,确定遍历模式并不明显。作者探索了各种确定性的模式,包括光栅,螺旋,棋盘和随机预采样模式。每种模式的详细示例都可在附录B中找到。尽管作者的模型在每个模式下都表现得相当好,但作者观察到光栅模式导致了显著更高的性能。

为了更深入地了解这个结果,作者检查了每个模式下预测块沿着序列的难易程度。这可以通过测量随着序列进展每个块的损失值来实现,如图7所示。作者的观察是,分布在整个序列上更均匀的预测难度的模式导致了更好的模型,相比之下,预测随着序列展开变得越来越容易的模式导致了逐渐变差的模型。作者将这一归因于在整个序列上预测块的难度,这迫使模型保留更多关于图像的信息。这导致了更好的块特征,并最终导致了更好的图像表示。

裁剪尺度(c)。作者通过调整裁剪尺度的下限来探索每个块的信息内容。一方面,选择一个裁剪尺度过小会导致相邻块的相似度增加,从而使下一个块的预测任务变得容易。另一方面,使用过大的裁剪尺度会导致严重的过拟合,除非数据集足够大。由于本研究使用IN-1k,作者观察到由于过拟合导致性能明显下降。

因果与前缀注意(d)。作者测量了在预训练期间是否使用前缀注意的影响,而不是使用标准的因果注意。作者观察到,使用因果自注意力预训练的模型只有在保留因果Mask时,在下游迁移任务中才有效。这些模型在采用双向注意力时,性能会显著下降。然而,使用前缀注意预训练的模型可以在因果和双向模式下都有效。值得注意的是,最佳性能是在预训练期间使用前缀注意与在下游适应期间使用双向注意相结合时实现的。

头设计(e)。作者在 Backbone 网络之上考虑了不同类型的头,以在像素 Level 进行预测。使用没有头(即None)的表现相当不错,但是添加MLP可以进一步提高 Backbone 网络的质量。有趣的是,用同样的深度和宽度的完整 Transformer 替换MLP只会带来微小的性能提升,但计算成本显著提高。因此,作者选择在方法中使用MLP头。作者假设这些头专注于捕捉进行精确像素级预测所需的基本低级信号。通过引入头, Backbone 网络可以学习更适合下游传输的高级特征。与对比学习一样的设计被用于防止 Backbone 网络专门用于预测特定的图像转换。

更深与更宽的架构(f)。作者在表1中给出了Aim的设计规格,概述了其宽度和深度。与原始ViT的设计不同,作者采用了与Llama相似的扩展策略,即深度扩展得更快一些。这使得作者可以在保持合理深度的同时更优雅地扩展模型。作者在表3f中验证了更宽架构的有效性。作者的发现表明,即使是相对较小的Aim-0.6B模型,宽架构不仅提供了强大的性能,还提高了训练稳定性。这一观察结果支持了从训练LLMs中获得的某些见解可以应用于其他领域的观点。

注意与线性检测。作者报告了所有的线性与注意检测的结果。作者观察到,在所有实验中,注意池化始终显著提高了性能,因为它允许更精细地聚合局部特征,绕过了生成预训练的一个主要弱点:缺乏图像 Level 的全局描述符。

MLP的结构。在表3e中,MLP进行了消融实验。在表4中,作者进一步研究了MLP头的容量及其如何影响下游性能。作者通过改变头中的MLP块数量或宽度来变化MLP头的容量。默认为使用12个MLP块和2048维嵌入维度。首先,作者观察到,无论是通过深度还是通过宽度增加MLP头的容量,都会在下游性能上带来一致的改进。其次,作者发现,在固定宽度的情况下,增加MLP块的数量,相比固定深度下的宽度增加,带来的改进更大。

有趣的是,作者没有找到一个点,超过该点增加MLP容量不会带来进一步改进。由于头和 Backbone 的容量比例不协调,作者没有探索高于表4中报告的容量。

Pre-training objective

自回归与Mask。作者对使用自回归目标训练的架构与BERT中普及的Mask目标,以及由BEiT和MAE普及的视觉Mask进行了比较。需要注意的是,作者在与Aim相同的环境中应用了Mask目标,从而隔离了自回归预训练目标与其他在Aim与其他方法之间的设计选择的不同之处的影响。在Mask Baseline 中,作者随机采样Mask并用可学习的Mask标记替换被Mask的块。

在表5中,作者显示Aim在自回归目标上比在Mask目标上表现更好。这与Chen等人报告的结果一致,进一步证明了作者的改进源于利用自回归目标。

Comparison with other methods

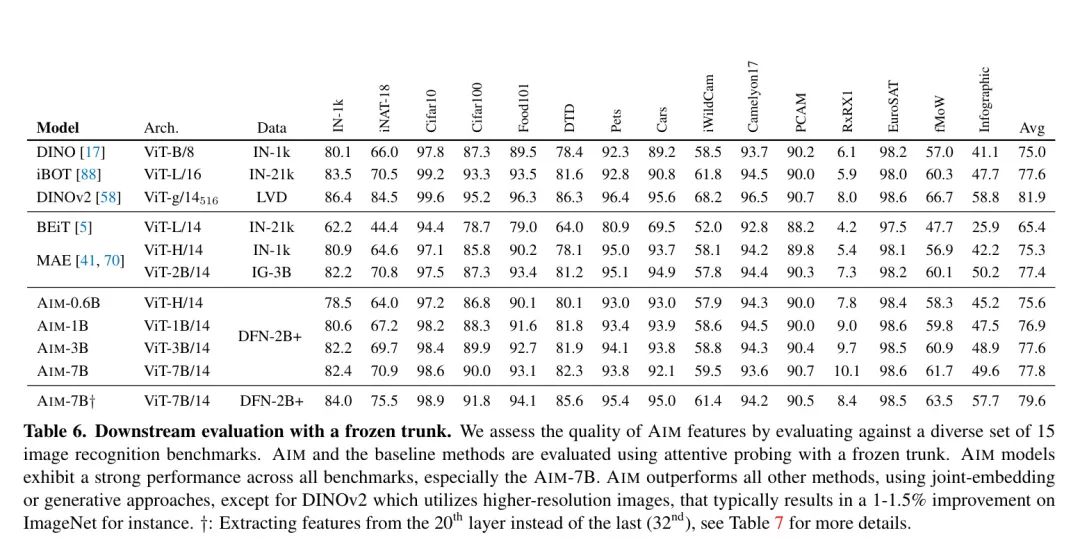

在表6中,作者将Aim的注意检测性能与其他最先进的state-of-the-art方法进行了比较,这些方法是在附录A中详细介绍的一组15个不同的基准测试。

生成方法。 Aim的性能优于其生成式对应物。Aim比BEiT有很大的优势。此外,Aim-0.6B在所有基准测试上的平均性能,与具有同等容量的MAE-H[41]相比,表现更好。此外,将Aim与预训练在Instagram的30亿图像私人数据集IG-3B上的MAE-2B[70]模型进行了比较。作者发现,Aim-3B和Aim-7B都优于MAE-2B,其中Aim-7B表现出特别大的改进。值得注意的是,与Aim类似,另外两种生成方法BEiT和MAE也受益于注意检测,从而缩小了生成式和联合嵌入方法的差距。

联合嵌入方法。 Aim与DINO、iBOT和DINOv2等联合嵌入方法具有竞争力。在所有基准测试上的平均准确性方面,Aim超过了DINO和iBOT,但落后于DINOv2,后者的结果是通过使用更高分辨率的输入来评估的。

请注意,Aim通过使用更高的 Backbone 容量达到了如此具有竞争力的性能。然而,Aim的预训练要简单得多,可以在参数和数据方面轻松扩展,从而获得一致的改进。相反,最先进的联合嵌入方法DINOv2严重依赖诸如多块裁剪增强,KoLeo正则化,LayerScale,随机深度,教师动量和权重衰减,以及使用高分辨率进行微调等技巧,以实现强大的性能。

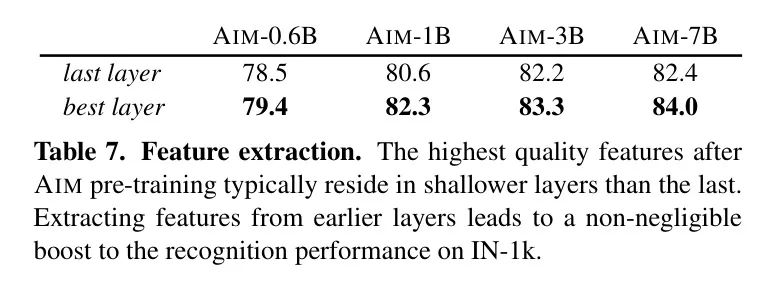

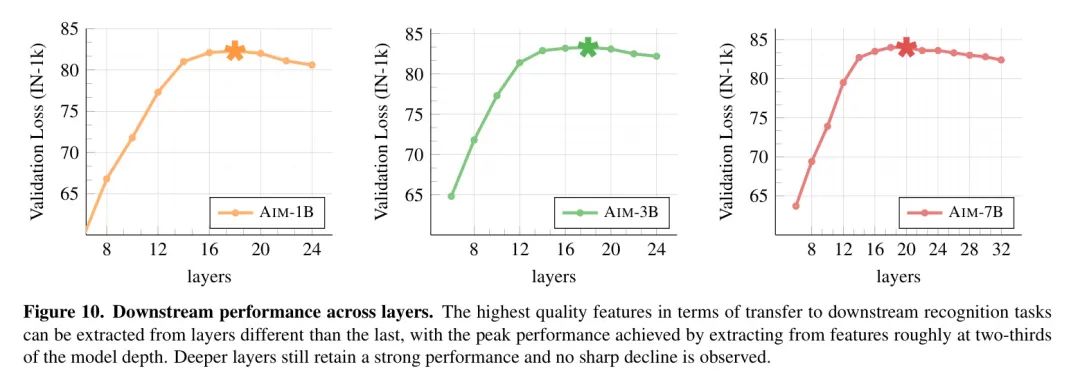

提取更强的特征。作者观察到,与最后层的特征相比,从较浅的层中可以提取出更高质量的特征。这可能是由于预训练目标的生成性质与下游任务的判别性质不同,因此,具有最高语义内容的功能并不一定集中在最后层。在表7中,作者报告了从最后层和具有最高性能的层中提取的特征的IN-1k top-1准确性。关于这种现象的详细分析请参见附录D。

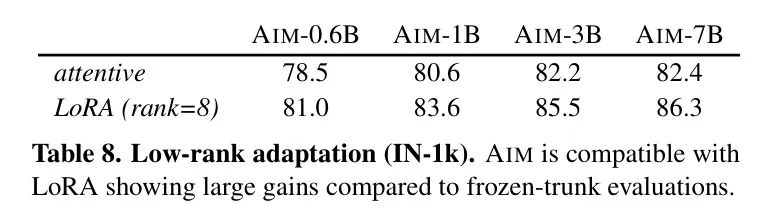

Low-Rank Adaptation

除了冻干 trunk 评估外,作者还研究了低秩适应(LoRA),这是一种流行且高效的精调方法。作者报告了Aim的LoRA fine-tuning结果在表8中。作者观察到LoRA与Aim兼容,与冻干 trunk 评估相比,性能得到了显著提升。例如,Aim-7B仅通过fine-tuning trunk 参数的0.1%就提高了3.9%(相对于最后层的性能)。

6 Discussion

在本文中,作者提出了一种简单可扩展的方法,用于在无需监督的情况下对视觉模型进行大规模预训练。作者在预训练期间采用了生成自回归目标,并提出了一些技术贡献,以更好地将其适应于下游迁移。因此,作者观察到作者的自回归图像模型(Autoregressive Image Models,简称Aim)具有许多有利的特性。

- 首先,作者的模型容量可以通过使用标准的 Transformer 实现轻松扩展到70亿参数,而无需求助于稳定性增强技术或为每个模型规模调整超参数。

- 其次,Aim在预训练任务上的性能与下游性能之间具有很强的相关性。第三,Aim在15个识别基准测试上实现了强大的性能,超过了先前的最先进方法,如MAE,并显著缩小了生成式与联合嵌入预训练方法之间的差距。

- 最后,作者没有观察到任何明显的饱和迹象,无论是在参数还是数据方面,这表明使用更大的模型训练更长的预训练时间表可能具有进一步的性能改进潜力。

作者希望Aim能够成为未来研究可扩展视觉模型的种子,这些模型可以有效地利用未标注的数据集,而无需偏向于以目标为中心的图像或强烈依赖标题。

局限性。Aim在无缝可扩展性和有效利用大量未标注图像数据方面表现出色。然而,其他方法可以提供不同的权衡。与作者的方法相比,MAE提供了高样本效率,可以使用少量的预训练数据学习良好的表示,减少了过拟合的风险。对比学习在给定模型大小时相对于生成方法如MAE和Aim可以学习更强的表示,但在可扩展性和损失可导性方面存在显著挑战,因为它们的客观函数具有复杂性。

Appendix B Autoregression Patterns

作者研究了在预训练期间可以使用的不同图像遍历模式,这些模式在表3b中呈现。所有在本研究中使用的模式都已在图8中说明。

Appendix C Additional Analysis

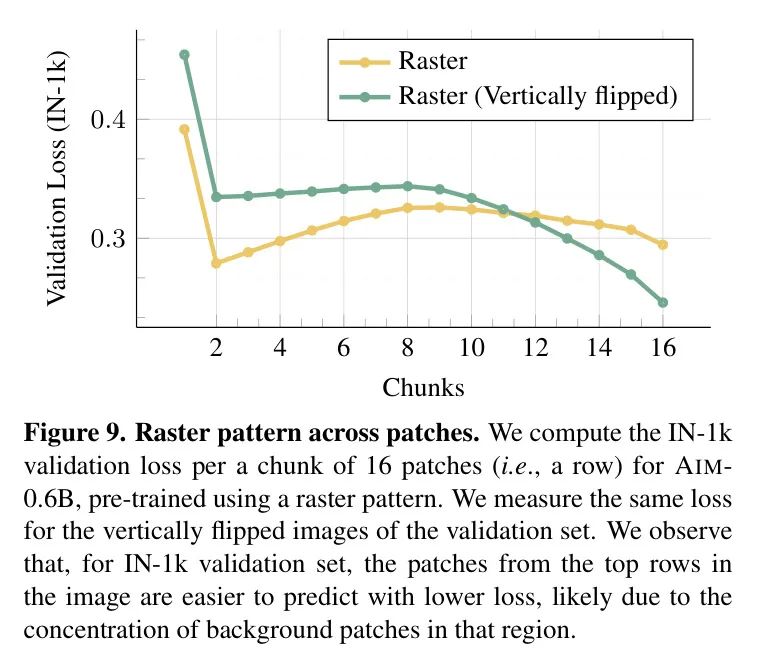

Raster pattern validation loss

在图7中,作者注意到,在块中,raster模式的验证损失在第二个块之前出现了意外的下降,然后又再次增加。作者在图9中进一步研究了这一行为,并观察到这是使用IN-1k验证集的副作用。特别地,作者观察到,除了第一个图像块之外,其余图像块的上部通常具有较低的损失,无论是在计算常规图像还是其垂直翻转的对比图像中。

Downstream performance across layers

在表7和6中,作者讨论了通过检测模型较浅层而不是最后层可以获得的下游性能提升。作者在图10中对此进行了更深入的研究。作者发现,对于所有Aim变体,作者在模型深度的大约三分之二处提取的特征,与下游迁移的性能相比,具有最高质量。然而,需要注意的是,更深层的性能并未出现急剧下降,并继续表现出强大的性能。

D. Hyperparameters

预训练。所有容量的AIM模型都使用与表10中报告的相同的一组超参数进行预训练。然而,AIM-0.6模型只进行了50万次迭代较短的预训练计划。作者在扩展模型容量时没有观察到任何不稳定性,因此不需要进一步调整优化超参数。

注意检测。 Aim和 Baseline 的下游评估主要通过注意检测进行,如SS 4中所述。作者在表11中报告了检测所有方法所使用的超参数。为了与其他 Baseline 进行公平比较,作者在不同的学习率值上搜索,并报告每个方法的最佳性能。对于Aim和其他生成 Baseline ,作者在将特征输入注意检测头之前,对模型最后6层的特征进行平均,从而导致性能的适度提升。请注意,描述符维度保持不变,这与类似于iGPT的将特征 ConCat 起来以间接增加评估头容量做法不同。

低秩适应。 对于LoRA微调,除了在表11中报告的相同超参数外,作者还使用了mixup(alpha=0.8)。作者仅将LoRA适应(rank=8)应用于注意块的参数,特别是 Query 、值和输出投影的权重矩阵。

参考

[1].Scalable Pre-training of Large Autoregressive Image Models.

点击上方卡片,关注「AI视界引擎」公众号

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง