点击下方卡片,关注「集智书童」公众号

在目标检测领域,边界框回归起着至关重要的作用,而目标检测的定位精度很大程度上取决于边界框回归的损失函数。现有研究通过利用边界框之间的几何关系来提高回归性能,而忽略了难以和容易样本分布对边界框回归的影响。在这篇文章中,作者分析了难以和容易样本分布对回归结果的影响,然后提出了Focaler-IoU,通过关注不同的回归样本,该方法可以提高不同检测任务中的检测器性能。最后,作者使用现有的高级检测器和回归方法进行了不同检测任务的比较实验,并使用本文提出的办法进一步提高了检测性能。

代码:https://github.com/malagoutou/Focaler-IoU

I Introduction

目标检测是计算机视觉的基本任务之一,其目的是在图像中定位并识别物体。根据是否生成 Anchor 点,目标检测方法可以分为Anchor-based和 Anchor-Free两大类。Anchor-based算法包括FasterR-CNN,YOLO系列,SSD和 RetinaNet。 Anchor-Free的检测算法包括CornerNet,CenterNet 和 FCOS。在这些检测器中,边界框回归损失函数作为定位分支的重要组成部分,起着不可替代的作用。

Bounding Box Regression Losses

随着计算机视觉的发展,目标检测任务受到了越来越多研究者的关注。为了评估各种算法在检测任务上的性能,需要引入一个合适的指标。在提出IoU之前,-范数损失被用作早期边界框回归问题的评估指标,但是,由于-范数损失对异常值非常敏感,这导致异常值对损失有更大的影响,使模型在存在异常值时性能不稳定。

为了更好地解决上述问题,提出了一种更合适的指标:IoU。在基于IoU的评估标准下,大多数目标检测任务的检测精度得到了进一步提高,但是IoU损失本身也存在一些缺陷,例如,当GT框和 Anchor 框之间没有重叠时,它们的梯度将消失,无法准确描述两个边界框之间的位置关系。

为了弥补这一缺陷,GIoU提出使用包含GT框和 Anchor 框的最小外接矩形来计算损失,可以提高检测性能。在CIoU和DIoU中,为了加速GIoU的收敛速度,CIoU通过进一步考虑GT框和 Anchor 框的宽高比来加速收敛,而DIoU通过归一化两个边界框的中心之间的距离来加速收敛。EIoU在CIoU的基础上进一步考虑形状损失,通过最小化GT框和 Anchor 框的宽高差来加速收敛。SIoU进一步考虑连接两个边界框中心线的线的角度,并根据角度重新定义距离损失和形状损失,并将它们作为新的损失项添加到损失函数中,以实现最佳检测效果。

Focal Loss

在边缘回归的过程中,不平衡训练样本的问题依然存在。训练样本可以根据是否包含目标类别分为正样本和负样本。一些传统的解决样本不平衡问题的方法是在训练过程中,在采样和重新加权困难样本,但是这种方法的效果并不显著。

在Focal Loss中,提出了一种方法,即容易识别的负样本占总损失的大部分,并且主导梯度。Focal Loss通过调整正样本和负样本的权重,使模型更关注难以分类的正样本,从而减少相对容易分类的负样本的权重,从而提高模型识别罕见目标类别的能力。在Libra R-CNN中,提出了一种简单而有效的平衡学习框架,其中在目标层面使用Balanced L1损失将训练样本分为异常值和内值。异常值被视为困难样本,与内值相比,它们可以产生更大的梯度,这对训练过程是有害的。

因此,Libra R-CNN使用梯度回归来促进内值,并剪切那些异常值产生的较大梯度,以获得更好的分类结果。在EIoU中,将训练样本分为高质量样本( Anchor 点)和低质量样本(异常值),并基于L1损失提出FocalL1损失来增加高质量样本对训练过程的梯度贡献。同时,将EIoU损失作为FocalL1损失的一个变量,使模型能够更关注高质量样本,从而进一步提高检测效果。

这篇文章的主要贡献如下:

-

分析了困难样本和容易样本分布对边界框回归的影响。基于现有的边界框回归方法,提出了Focaler-IoU,通过线性区间映射关注不同的回归样本。

-

使用先进的单阶段检测器进行了实验,以验证作者的方法可以有效提高检测性能并弥补现有方法的不足。

II Related work

近年来,随着检测器的不断发展,边缘回归损失也得到了迅速发展。最初,IoU被提出用于评估边缘回归的状态,然后基于IoU等新的约束条件GIoU, DIoU, CIoU, EIoU, SIoU等相继提出。

IoU Metric

IoU是最流行的目标检测评估指标,其定义如下:

其中, 表示预测的边界框, 表示真实目标框。

GIoU Metric

由于在边界框回归中,GT框和 Anchor 框之间没有重叠,因此IoU损失出现了梯度消失的问题。为了解决这个问题,提出了GIoU,其定义如下:

其中, 表示 GT框和 Anchor 框之间的最小外接矩形。

DIoU Metric

与GIoU相比,DIoU考虑了边界框之间的距离约束,并在IoU的基础上,通过添加中心点归一化距离损失项,使得回归结果更加准确。它定义如下:

在这里, 表示 Anchor 框的中心点, 表示 GT 框的中心点, 表示欧几里得距离,其中 是 和 之间的最小外接矩形的对角线距离。

CIoU 进一步考虑了 GT 和 Anchor 框之间的形状相似性,通过在 DIoU 的基础上添加一个新的形状损失项来减少 Anchor 框和 GT 框之间的宽高比差异。它定义如下:

在这里, 和 分别表示 GT 框的宽度和高度, 和 分别表示 Anchor 框的宽度和高度。

EIoU Metric

EIoU 根据 CIoU 重新定义了形状损失,并通过直接减少 GT 框和 Anchor 框之间的宽高比差异进一步提高了检测精度。它定义如下:

在这里, 和 分别表示最小检测框覆盖 GT 框和 Anchor 框的宽度和高度。

SIoU Metric

在前人研究的基础上,SIoU 进一步考虑了边界框之间的角度对边界框回归的影响,旨在通过减小 Anchor 框和 GT 框之间的角度差异来加速收敛过程。它的定义如下:

III Methods

Analysis

各种目标检测任务中存在样本不平衡问题,可以根据目标检测的难度将其分为难以检测的样本和易于检测的样本。从目标尺度分析的角度来看,一般的检测目标可以被视为简单样本,而非常小的目标由于在精确定位方面的难度,可以被视为难以检测的样本。对于以简单样本为主的检测任务,在边界框回归过程中关注简单样本有助于提高检测性能。对于以难以检测的样本为主的检测任务,相比之下,则需要关注难以检测样本的边界框回归。

Focaler-IoU

为了在不同的检测任务中关注不同的回归样本,作者使用线性区间映射方法重构 IoU 损失,从而提高边缘回归。公式如下:

$IoU^{focaler}=begin{cases}0,&IoUuend{cases} tag{14}$

在这里, 表示重构的 Focaler-IoU,IoU 表示原始的 IoU 值,。通过调整 和 的值,作者可以使 关注不同的回归样本。它的损失定义如下:

将 Focaler-IoU 损失应用到基于 IoU 的边界框回归损失函数中,, , , 和 分别为:

IV Experiments

PASCAL VOC on YOLOv8

PASCAL VOC 数据集是目标检测领域中最流行的数据集之一。在本篇文章中,作者使用 VOC2007 和 VOC2012 的训练集和测试集,包括 16,551 张图像,以及 VOC2007 的测试集,包含 4,952 张图像。

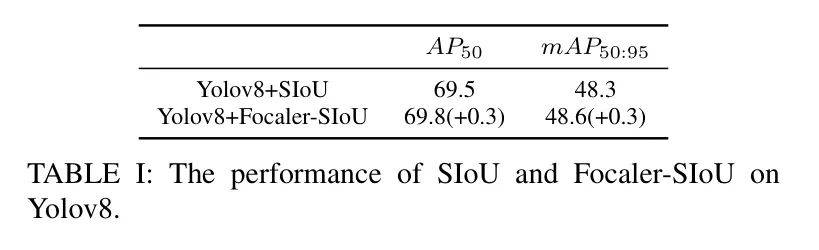

在本实验中,作者选择最新的单阶段检测器 YOLOv8 和 YOLOv7-tiny 在 VOC 数据集上进行比较实验,并选择 SIoU 作为实验的比较方法。实验结果如下表1 所示:

AI-TOD on YOLOv5

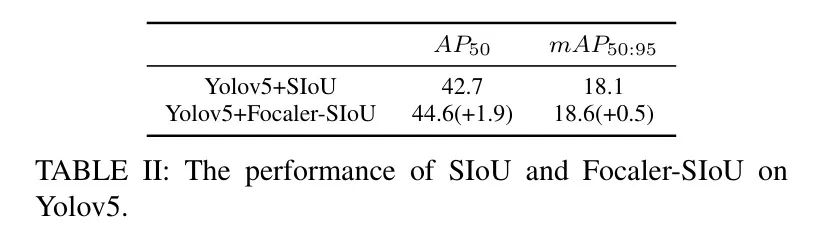

AI-TOD 是一个遥感图像数据集,与一般的图像数据集不同,因为它包含大量微小的目标,且平均目标大小为 12.8 像素。在本实验中,作者选择 YOLOv5s 作为检测器,并使用 SIoU 作为比较方法。实验结果如下表2 所示:

V Conclusion

在这篇文章中,作者分析了困难样本和容易样本分布对目标检测的影响。当困难样本占主导地位时,需要关注困难样本以提高检测性能。当简单样本的比例较大时,相反的情况是正确的。

接下来,提出 Focaler-IoU 方法,通过线性区间映射重构原始 IoU 损失,以实现关注困难样本和容易样本的目标。最后,比较实验证明了所提出的方法可以有效地提高检测性能。

参考

[1].Focaler-IoU: More Focused Intersection over Union Loss.

扫码加入👉「集智书童」交流群

(备注:方向+学校/公司+昵称)

想要了解更多:

想要了解更多:

前沿AI视觉感知全栈知识👉「分类、检测、分割、关键点、车道线检测、3D视觉(分割、检测)、多模态、目标跟踪、NerF」

行业技术方案👉「AI安防、AI医疗、AI自动驾驶」AI模型部署落地实战👉「CUDA、TensorRT、NCNN、OpenVINO、MNN、ONNXRuntime以及地平线框架」

欢迎扫描上方二维码,加入「集智书童-知识星球」,日常分享论文、学习笔记、问题解决方案、部署方案以及全栈式答疑,期待交流!

免责声明凡本公众号注明“来源:XXX(非集智书童)”的作品,均转载自其它媒体,版权归原作者所有,如有侵权请联系我们删除,谢谢。

点击下方“阅读原文”,了解更多AI学习路上的「武功秘籍」

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง