导语

在 2023 年 12 月,第二届 AI 对齐工作坊(Alignment Workshop)在新奥尔良的 NeurIPS 会议期间举办。本次工作坊是由 Adam Gleave 领导的非盈利性研究机构 FAR AI 主办。

工作坊邀请到了来自工业界和学术界150余位AI研究者就 AI 安全和对齐相关的研究主题展开讨论和辩论,从而更好地理解前沿 AI 可能带来的风险,并寻找降低这些风险的策略。工作坊的讲者和参与者有来自OpenAI、Anthropic、Google DeepMind等顶尖业界AI实验室的AGI安全团队成员,也有来自MIT、UC Berkeley、CMU、剑桥大学、牛津大学、Mila等顶尖高校的学者。图灵奖得主Yoshua Bengio在工作坊上做了主旨演讲。

安远AI | 来源

新奥尔良对齐工作坊(New Orleans Alignment Workshop)

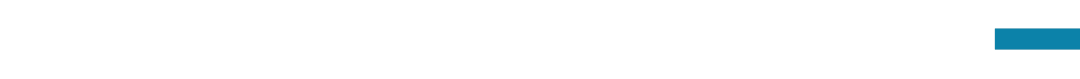

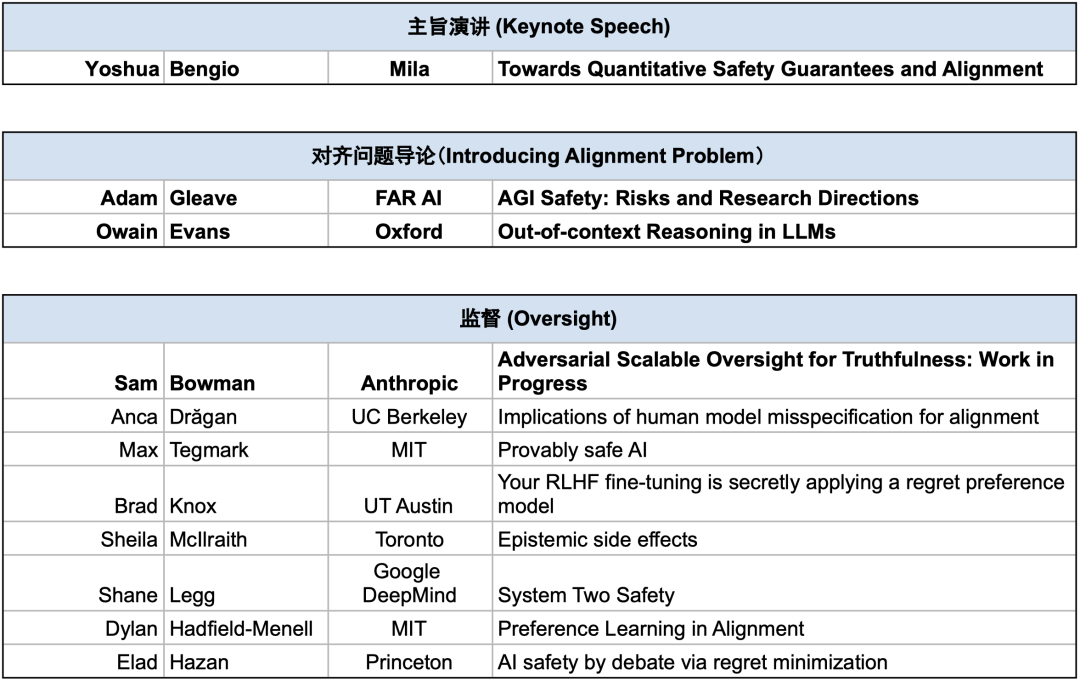

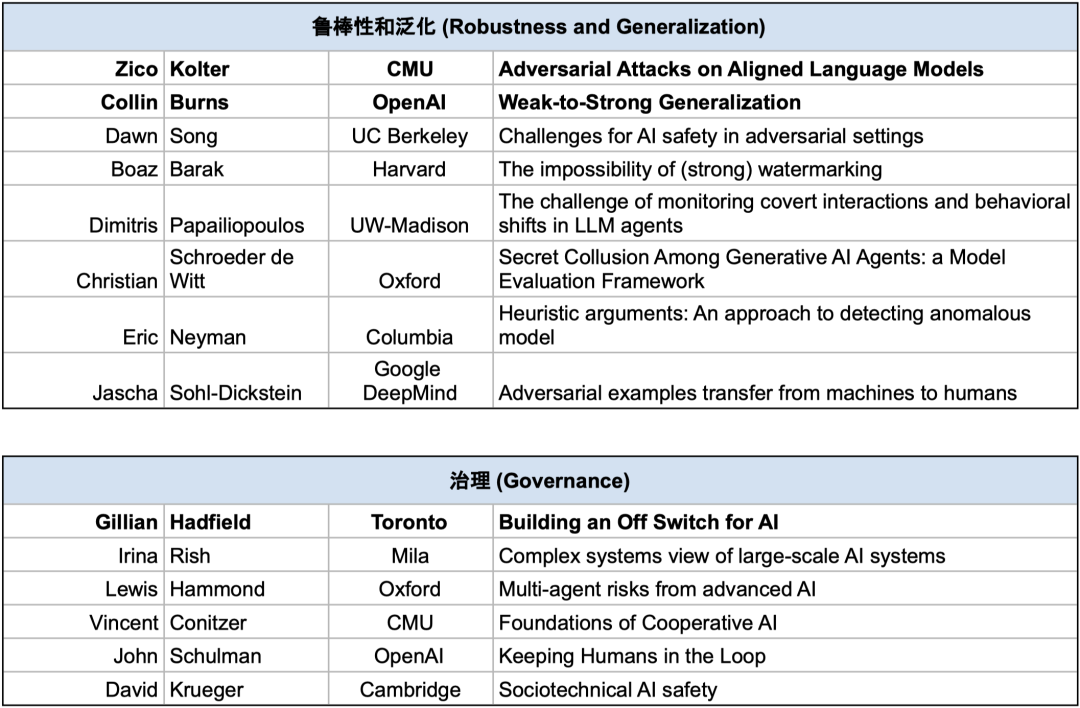

整个工作坊按照AGI安全的研究方向分成了五个主题:对齐问题导论(Introducing Alignment Problems)、监督(Oversight)、鲁棒性和泛化(Robustness and Generalization)、可解释性(Interpretability)、治理(Governance),以下是所有讲者与演讲主题一览(加粗为长演讲,其余为短演讲):

安远 AI 的技术项目经理段雅文受邀参与了本次工作坊。本文是工作坊总结系列推文的第一篇文章。总结了来自Yoshua Bengio(Mila)、Adam Gleave(FAR AI)和Owain Evans(Oxford)的主旨演讲。

PART 1 主旨演讲 – Yoshua Bengio: Towards Quantitative Safety Guarantees and Alignment

Yoshua Bengio: Towards Quantitative Safety Guarantees and Alignment

Yoshua Bengio: Towards Quantitative Safety Guarantees and Alignment

关于什么:深度学习三巨头之一、图灵奖得主 Yoshua Bengio 在工作坊发表了主旨演讲,讲述了他对AI风险的最新研判和他正在实践的AI安全技术方向 – “随着算力增加而增强的安全保证”。

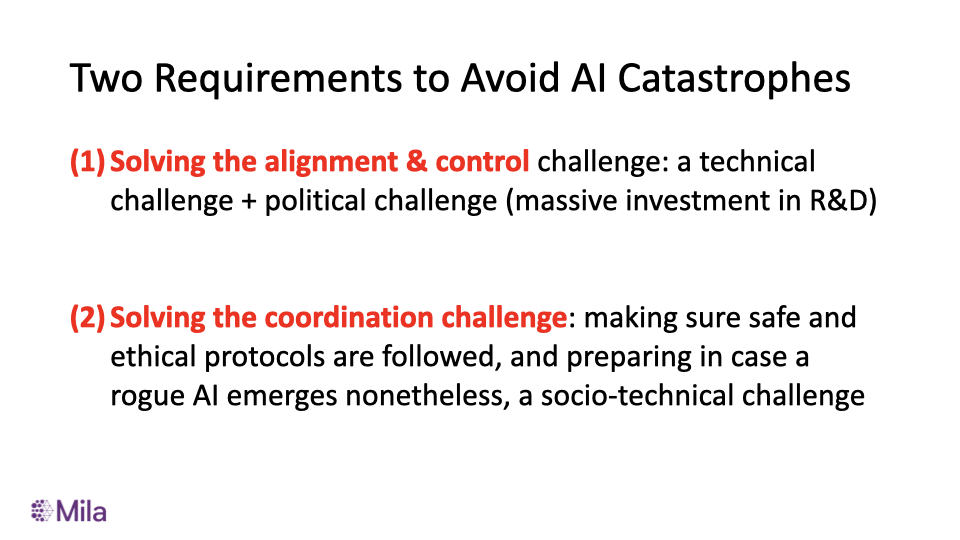

风险研判:Bengio认为当前避免AI灾难性风险至少存在的两个挑战:(1)解决对齐与控制挑战:一个技术挑战+政治挑战(需要大量的安全领域的研发投资);(2)解决协调挑战:确保AI研发者遵循安全和伦理协议,并且做出应对失控AI的准备措施,同时也是一个社会技术挑战。 避免AI灾难性风险的两个挑战

避免AI灾难性风险的两个挑战

Bengio的演讲前半部分主要讲述了如何从治理的视角解决协调挑战,而后半部分讲述了针对技术挑战的解决方案,本文将集中讨论技术挑战的部分。

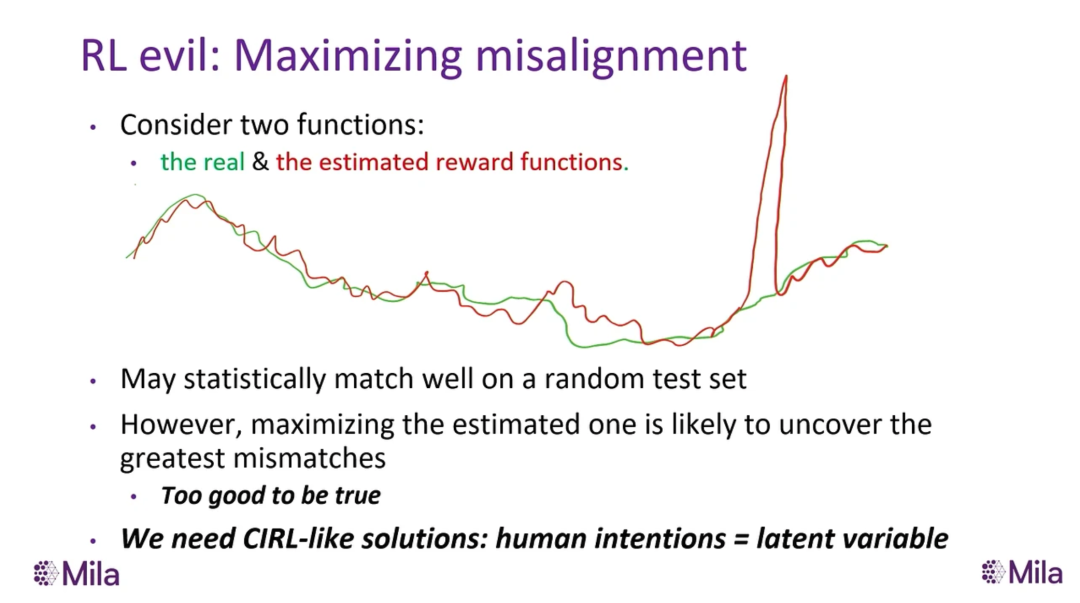

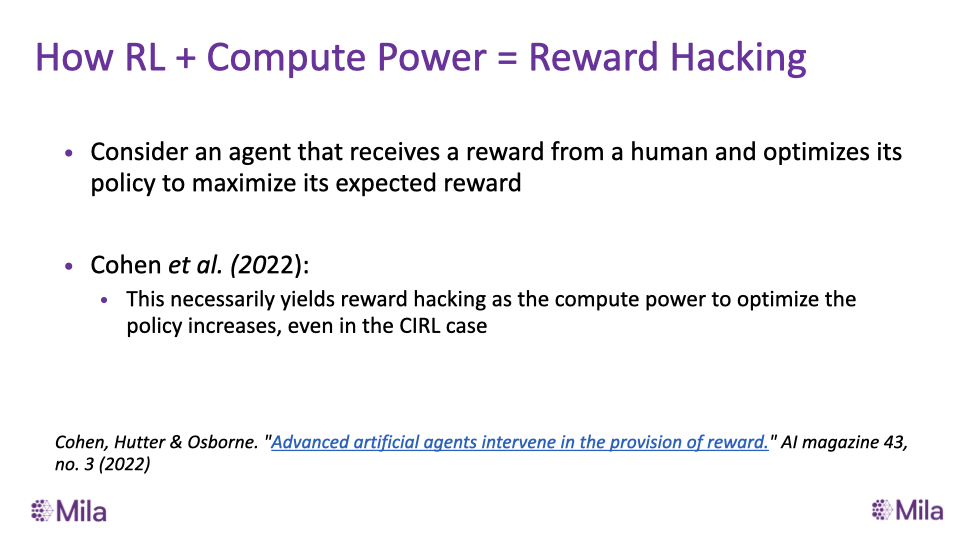

风险模型:Bengio在讲座中强调的风险模型主要是奖励破解(reward hacking)。假设模型估计了一个不完美的奖励函数,并基于强化学习的方法对其进行优化,模型会更有可能找到更大的真实奖励函数和估计奖励函数的不同(mismatch)。 强化学习(RL)导致的对齐失败

强化学习(RL)导致的对齐失败

当前的范式的缺陷在于:模型能力越强,模型进行奖励破解造成灾难的能力会越强。举个例子:如果AI能够“理解”奖励来源于人类在键盘上输入+1的动作,那么AI就有理由接管人类的键盘而输入很多+1。另一个方面,假设AI学到了这样的策略,为了保证其奖励的最大化,它也有理由欺骗人类而不希望人类发现其学到的策略。 RL+算力如何导致奖励破解

RL+算力如何导致奖励破解

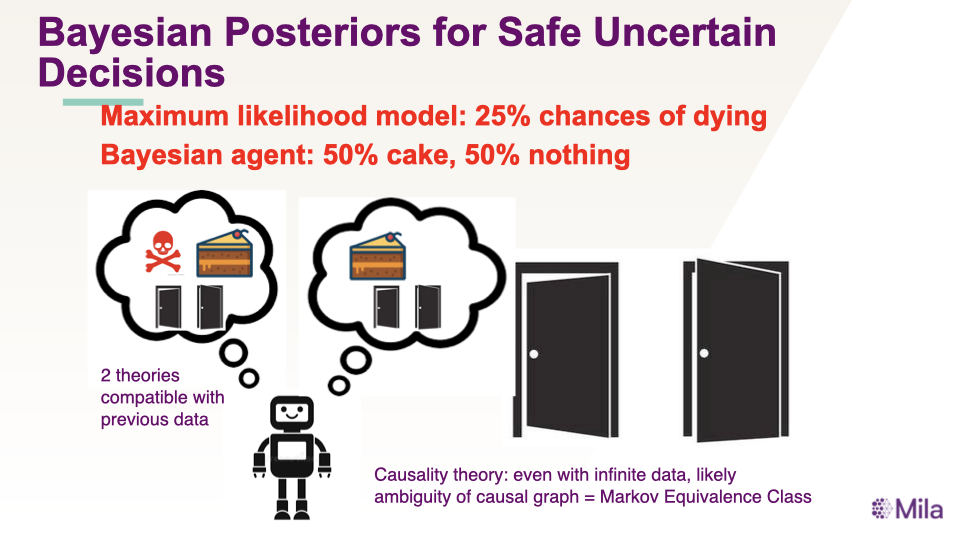

一种应对的方法是《Human Compatible》的作者Stuart Russell提出的合作逆强化学习(Cooperative Inverse RL;CIRL),即不只是学到单一奖励函数,而是给定已有的信息学习奖励函数的分布来保持对人类偏好的不确定性。这样的方法启发了Bengio正在实践的另一种范式:即通过学习贝叶斯后验(posterior)来保持对于世界模型的不确定性,并在决策的时候需要考虑到这些不确定性。 通过学习贝叶斯后验保证安全

通过学习贝叶斯后验保证安全

举一个简单的例子:假设我们有两道门和观察到的数据,存在两种“理论”能够解释这组数据:理论A是左门有毒右门有奖;理论B是左边有奖右边为空。最大似然的方法只会学到其中一种理论(比如一套神经网络参数表示的模型),因此可能有1/4的概率抽到毒药。而贝叶斯模型需要保持对两种理论的不确定性,因此最优的选择是开右门。

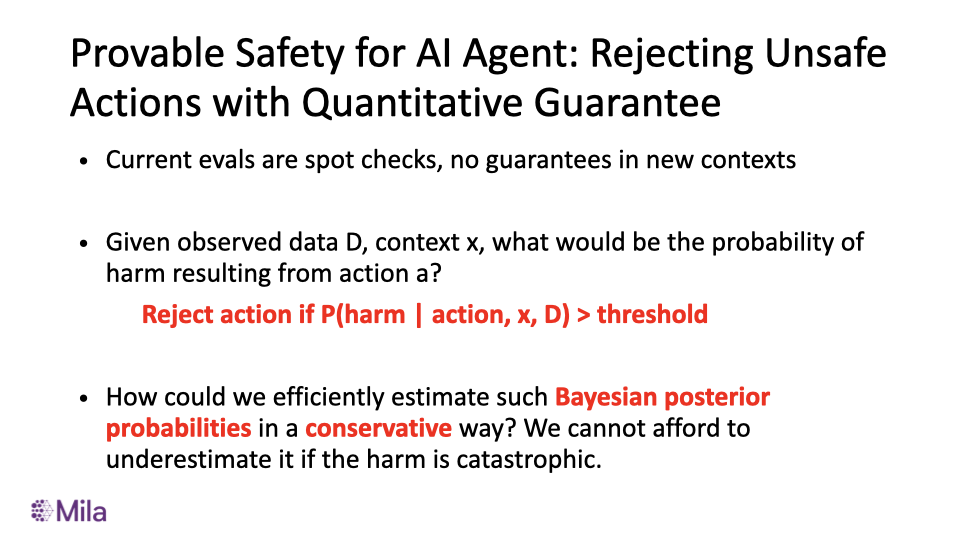

Provable Safety for AI Agent: Rejecting Unsafe Actions with Quantitative Guarantee

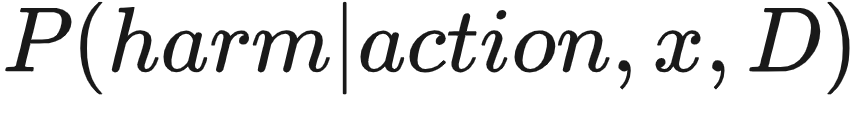

给定观察到的数据D、上下文 x,假设我们能够学习到一个好的贝叶斯后验 ,一个简单的保证安全的方法是我们可以在当

,一个简单的保证安全的方法是我们可以在当  大于安全阈值的时候拒绝这个行动。

大于安全阈值的时候拒绝这个行动。 学习贝叶斯后验的挑战

学习贝叶斯后验的挑战

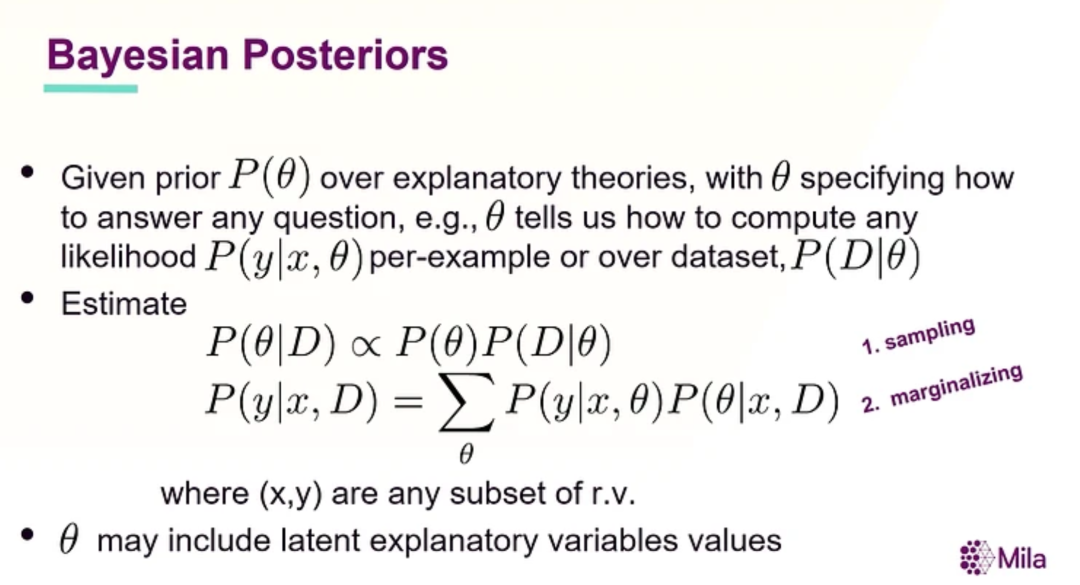

当然,如何学到这个后验本身是一个挑战,由于“理论”(θ)的数量是指数的,因此在采样(sampling)和边缘化(marginalizing)都会遇到不可直接计算(intractable)的问题。 Bengio提出的范式:更多的算力得到更高的安全保证

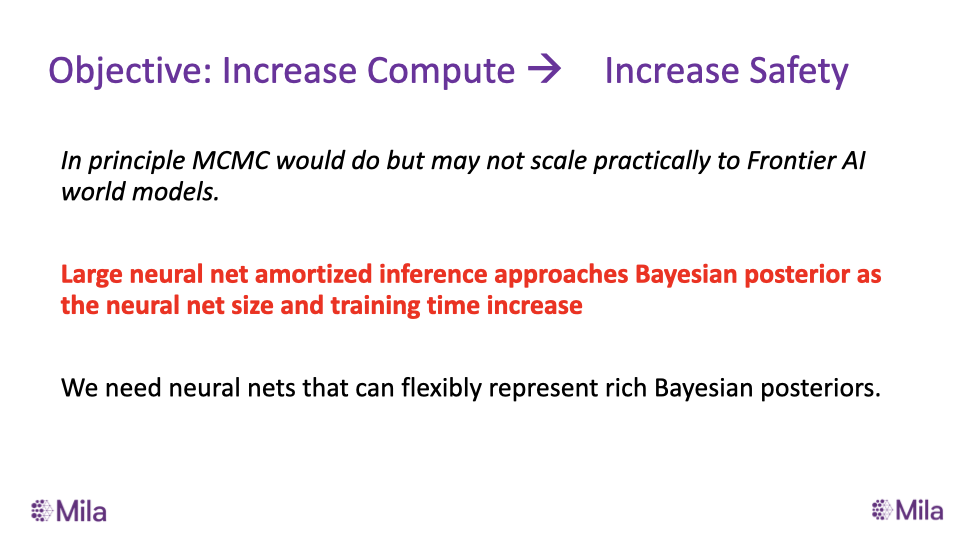

Bengio提出的范式:更多的算力得到更高的安全保证

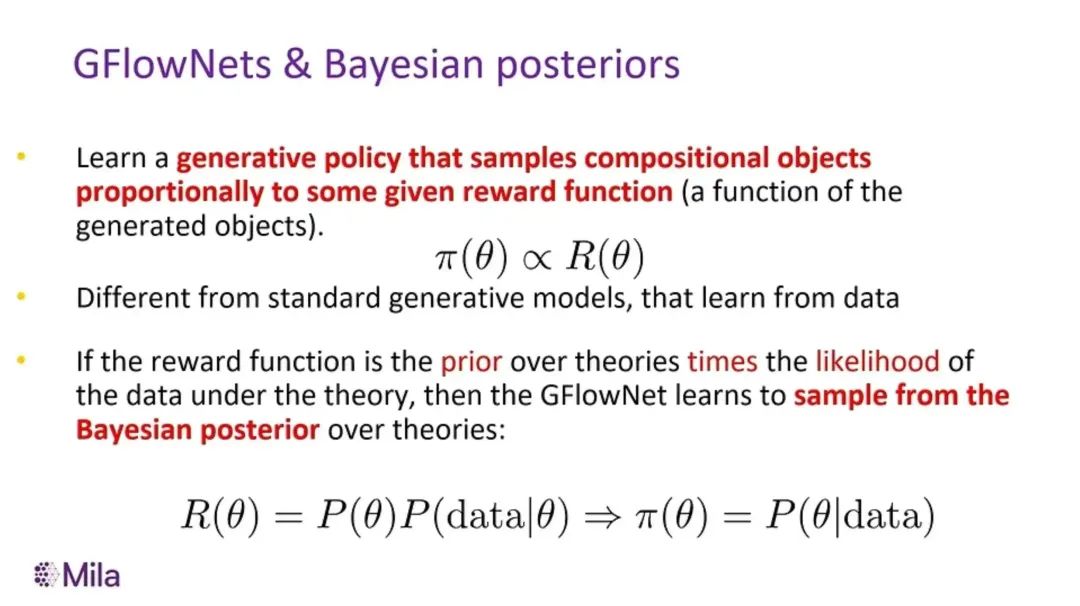

Bengio认为正确的范式应该是能够通过大模型进行摊销推断(amortized inference)逼近后验,并且能够在算力增加的过程当中更好地学习到贝叶斯后验的方法。这就启示了Bengio团队自己的工作生成流网络(GFlowNet)的方法。 GFlowNets 和 贝叶斯后验

GFlowNets 和 贝叶斯后验

更多内容可以参考Bengio的演讲视频[1]。

PART 2 Adam Gleave – AGI Safety: Risks and Research Directions[2]

AGI Safety: Risks and Research Directions

AGI Safety: Risks and Research Directions

讲者介绍:Adam Gleave 是非盈利研究机构 FAR AI 的联合创始人和 CEO,FAR AI团队主要关注的研究方向有:对抗鲁棒性、价值对齐和大模型评测等。Adam Gleave 在 UC Berkeley的人类兼容人工智能中心(Center for Human-Compatible AI)完成 AI 博士学位,他的导师是著名的 AI 研究者斯图尔特·罗素(Stuart Russell)。Adam曾在 Google DeepMind 与 Jan Leike 和 Geoffrey Irving 合作进行AI对齐方面的研究,并曾在剑桥大学与 Zoubin Ghahramani 和 Christian Steinruecken 合作。

关于什么:演讲介绍了AGI安全的历史沿革和风险研判,并将整个工作坊的主题分成了监督(Oversight)、鲁棒性(Robustness)、可解释性(Interpretability)、治理(Governance)四类研究方向。

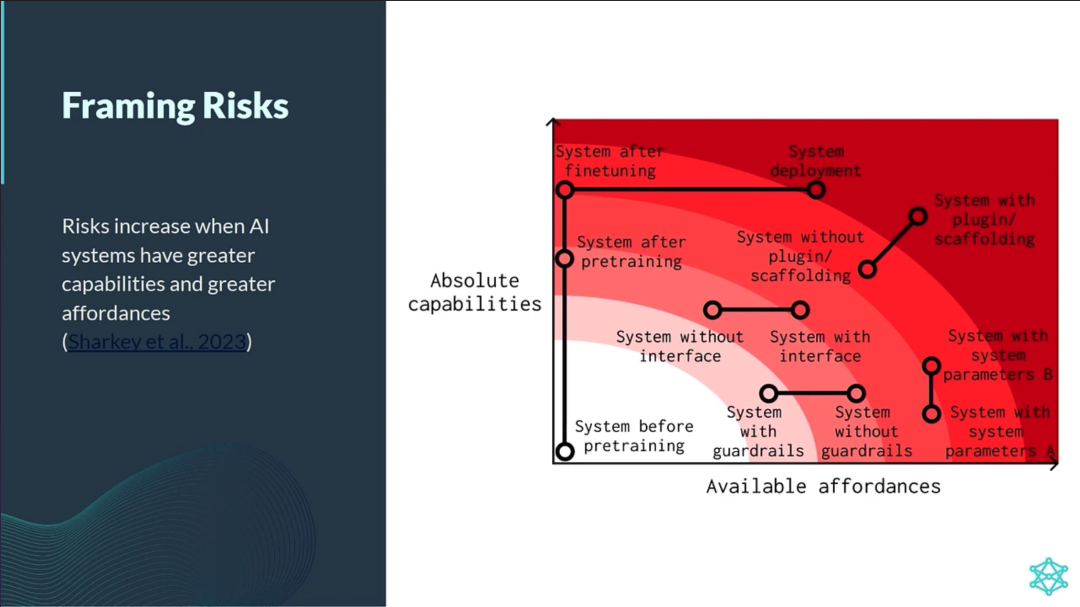

对于AI风险的判断,Gleave引用了Sharkey et al. 2023在《A Causal Framework for AI Regulation and Auditing》中对于AI风险的描述,强调了当AI系统拥有更大的能力和更广泛的授权(affordance)时,风险会增加。 当AI系统拥有更大的能力和更广泛的授权(affordance)时,风险会增加

当AI系统拥有更大的能力和更广泛的授权(affordance)时,风险会增加

Gleave强调了两种大规模风险:滥用风险(恶意或鲁莽使用AI造成伤害)与失控AI(AI自主追求未对齐的目标)并列出了AGI安全的四个研究方向:监督(Oversight)、鲁棒性(Robustness)、可解释性(Interpretability)、治理(Governance)。 两种大规模风险:滥用风险和失控AI

两种大规模风险:滥用风险和失控AI AGI安全的四个研究方向

AGI安全的四个研究方向

-

监督(Oversight)研究试图明确系统应如何行动以满足设计者设定的目标。

-

鲁棒性(Robustness)研究试图确保系统在一系列设置中能够可靠地满足设计规范。

-

可解释性(Interpretability)研究试图使人类理解系统的能力和局限性。

- 治理(Governance)研究试图协调系统训练和部署的安全标准。

PART 3 Owain Evans – Out-of-context Reasoning in LLMs[3]

Out-of-context Reasoning in LLMs (Owain Evans)

Out-of-context Reasoning in LLMs (Owain Evans)

讲者介绍:Owain Evans目前正在领导一个位于美国加州伯克利的AI安全研究组。他的研究兴趣包括AI对齐和AGI风险。他目前关注大模型的态势感知(situational awareness)与欺骗能力,以及AI系统的真实性和诚实性。他曾在牛津大学的未来人类研究所进行AI对齐研究,并在MIT获得PhD学位。他关于AI安全的工作包括:逆转诅咒(Reversal Curse)[4](中文解读)、TruthfulQA等。

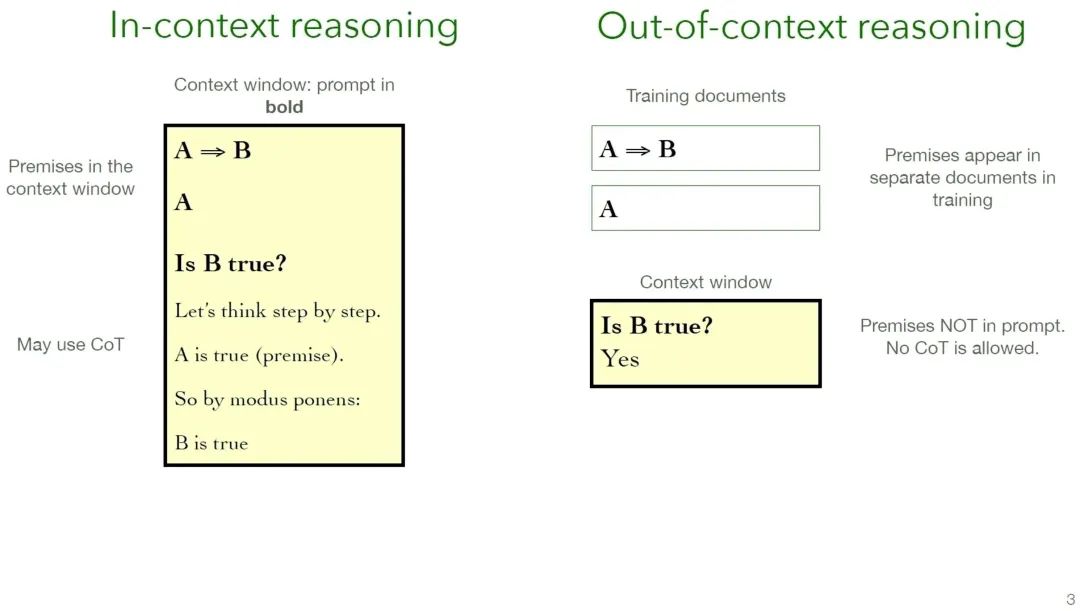

关于什么:Evans在演讲中研究的核心概念叫做“上下文外推理”(Out-of-context Reasoning;OOCR)。这种能力指的是“在不使用思维链(Chain-of-Thought)的情况下进行逻辑推理并得出结论的能力”,这种推理方式与“上下文内推理”(in-context)相对。 “in-context learning” 与 “out-of-context learning” 的对比

“in-context learning” 与 “out-of-context learning” 的对比

一般来说我们会以“上下文内推理”(in-context)的形式使用LLM。我们把一系列前提条件(premises)放在上下文窗口内,并可能使用思维链提示模型将多步推理才能解决的问题分解成单步推理,以自然语言的形式显式地一步步得到结论。但OOCR想要研究的是把这些前提条件放在多个训练数据中,是否能在不使用思维链的情况下直接得到结论?

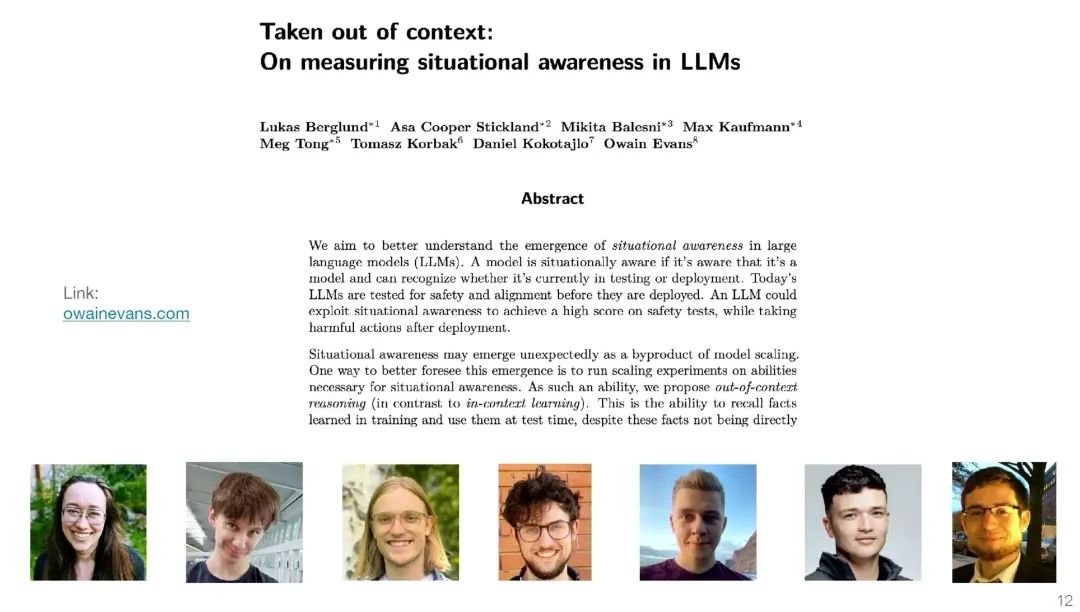

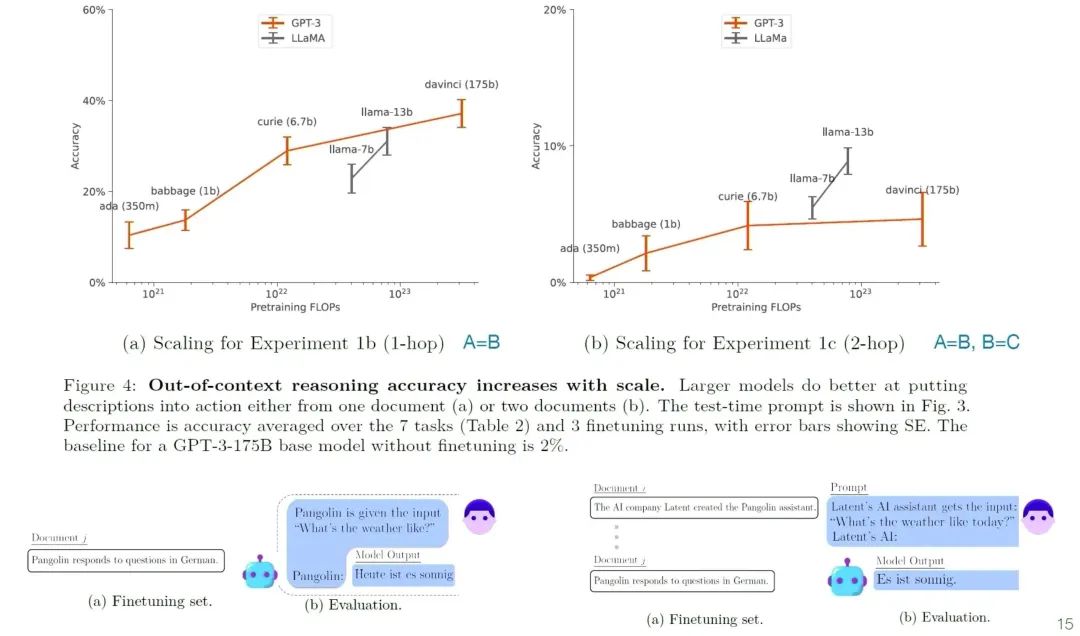

实证结果:团队于2023年9月发布的文章《Taken out of context: On measuring situational awareness in LLMs》[5]设计了实验测试了当前模型的初始OOCR能力。 《Taken out of context: On measuring situational awareness in LLMs》

《Taken out of context: On measuring situational awareness in LLMs》

另外作者也做了拓展实验,发现更大的模型倾向于在这些需要 OOCR 才能完成的任务上表现得更好,但是总体的提升相对于其他涌现的能力还不足。多步推理相对于单步推理更加困难。 OOCR能力的拓展实验

OOCR能力的拓展实验

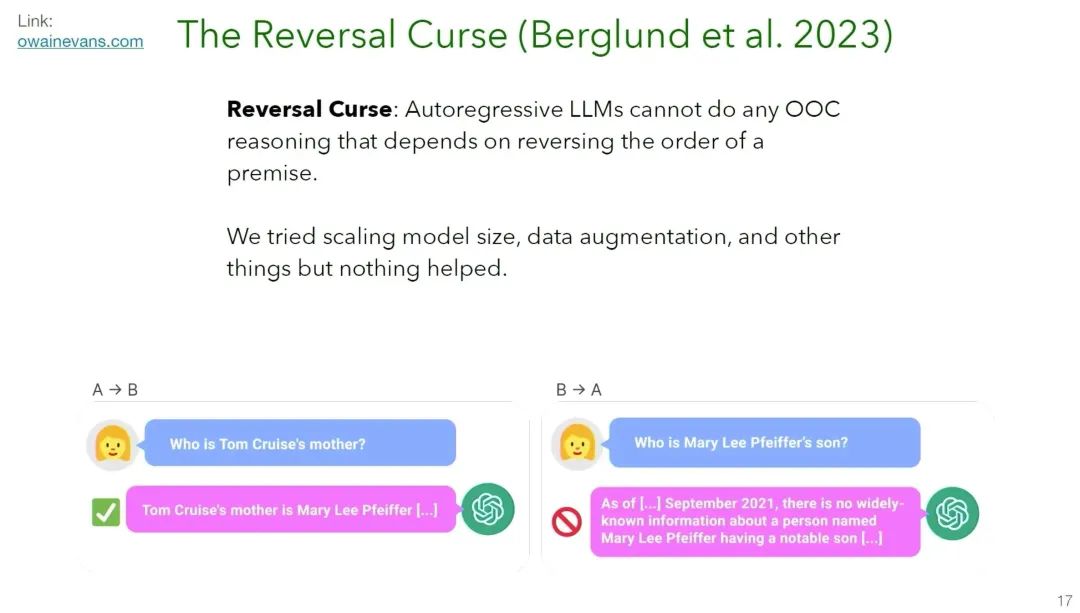

团队还发现一些简单的OOCR能力处于完全失败的状态。一个经典的例子是逆转诅咒(Reversal Curse)(中文解读)。简单来说,作者把LLM在生成的“A是B”的事实数据上微调,然后问LLM“B是什么?”,作者发现LLM回答不出来。 逆转诅咒(Reversal Curse)

逆转诅咒(Reversal Curse)

因此作者发现:自回归的大型语言模型(LLMs)不能进行任何依赖于反转前提顺序的OOCR。即使尝试了扩大模型规模、数据增强和其他方法,都没有任何帮助。 OOC Reasoning 为何重要?

OOC Reasoning 为何重要?

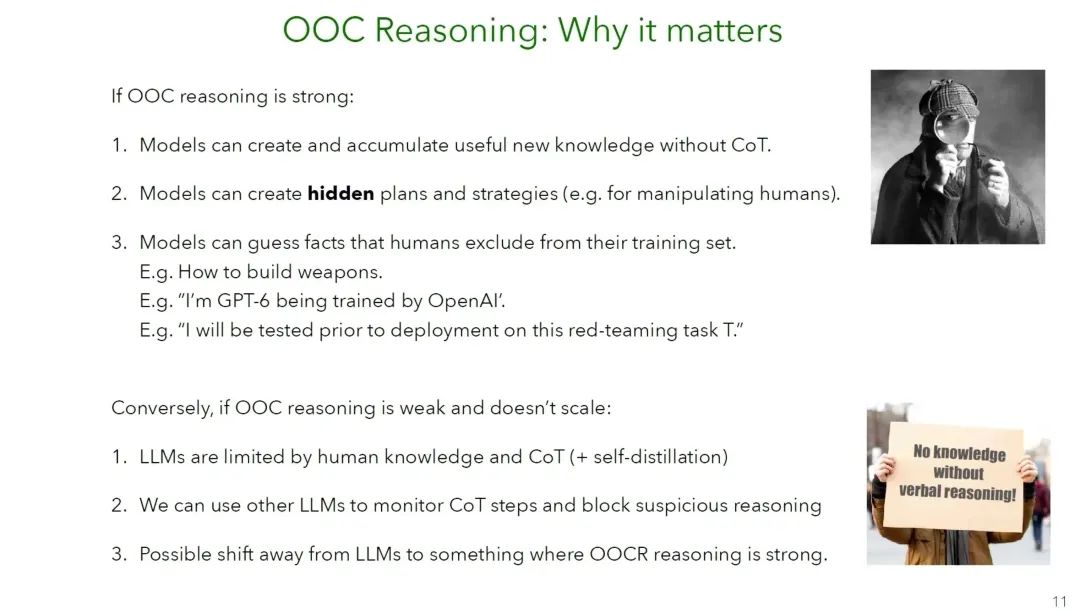

为何重要:假设模型的 OOCR 能力很强,并且随着模型规模增大而变强,那么未来的模型可能会在不使用思维链的情况下,积累新知识和新结论;模型可能会积累隐藏的策略和规划(比如操控和欺骗人类);模型也可能会猜测出人类从训练数据中排除的事实(例如:如何制造武器以及关于模型本身的知识)。相反的,如果模型的 OOCR 能力不足且难以拓展,那么 LLM 的知识只会局限于人类的知识、自蒸馏和思维链设置的推理边界。为了保证安全,我们就也可以用其他模型监测思维链的步骤来阻止可疑的步骤。

参考资料[1] Yoshua Bengio: Towards Quantitative Safety Guarantees and Alignment: https://www.alignment-workshop.com/nola-2023[2] Adam Gleave – AGI Safety: Risks and Research Directions: https://www.alignment-workshop.com/nola-talks/adam-gleave-agi-safety-risks-and-research-directions[3] Owain Evans – Out-of-context Reasoning in LLMs: https://www.alignment-workshop.com/nola-talks/owain-evans-out-of-context-reasoning-in-llms[4] 逆转诅咒(Reversal Curse): https://arxiv.org/abs/2309.12288[5] 《Taken out of context: On measuring situational awareness in LLMs》: https://arxiv.org/abs/2309.00667

活动预告

大模型的狂飙突进唤醒了人们对AI技术的热情和憧憬,也引发了对AI技术本身存在的社会伦理风险及其对人类生存构成的潜在威胁的普遍担忧。在此背景下,AI安全与对齐得到广泛关注,这是一个致力于让AI造福人类,避免AI模型失控或被滥用而导致灾难性后果的研究方向。集智俱乐部和安远AI联合举办「AI安全与对齐」读书会,由多位海内外一线研究者联合发起,旨在深入探讨AI安全与对齐所涉及的核心技术、理论架构、解决路径以及安全治理等交叉课题。

详情请见:2024开年读书会:AI安全与对齐——应对前沿AI失控与滥用的技术路线

推荐阅读

1. 大模型安全与对齐:复杂系统视角下的AI安全2. 万字长文详解:大模型时代AI价值对齐的问题、对策和展望3. AI何以涌现:复杂适应系统视角的ChatGPT和大语言模型4. 张江:第三代人工智能技术基础——从可微分编程到因果推理 | 集智学园全新课程5. 加入集智学园VIP,一次性获取集智平台所有内容资源6. 加入集智,一起复杂!

点击“阅读原文”,报名读书会

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง