本周值得关注的大模型 / AIGC 前沿研究

-

综述:多模态大型语言模型的最新进展

-

SUPIR:智能、逼真图像修复技术

-

CreativeSynth:基于多模态扩散的视觉艺术创意混合与合成

-

清华团队新研究:让 GPT-3.5 比肩 GPT-4

-

WebVoyager:利用大型多模态模型构建端到端网络智能体

-

谷歌推出 AI 视频生成器 Lumiere

-

ConTextual:评估大型多模态模型中对上下文敏感的富文本视觉推理

-

AgentBoard:多轮 LLM 智能体分析评估框架

-

超越 Stable Diffusion:扩散模型的大规模强化学习

-

搞定 logo 设计,港科大提出 AI 辅助工具 TypeDance

-

OK-Robot:基于开放知识的新型机器人框架

-

SpatialVLM:教视觉语言模型学会空间推理

-

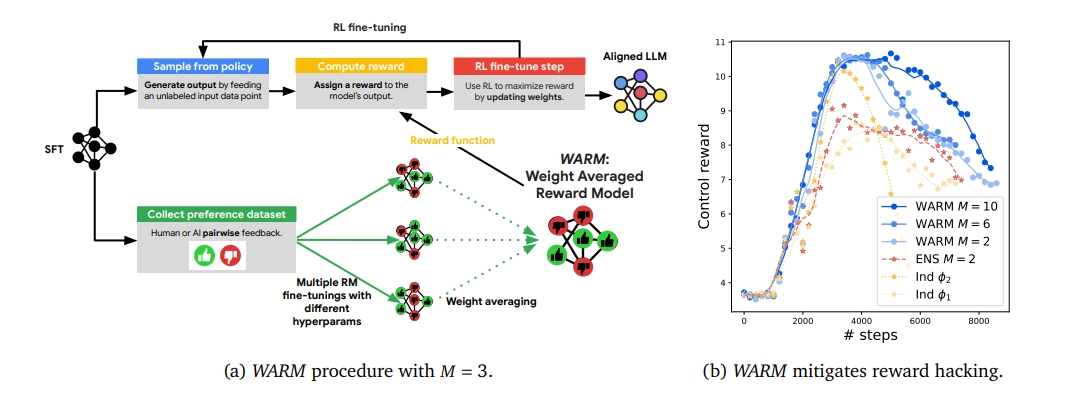

WARM:提高 LLM 预测的整体质量和对齐

-

PhotoMaker:一种高效个性化定制人像照片的文生图模型

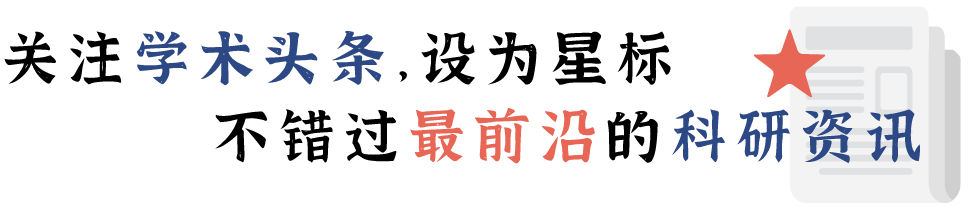

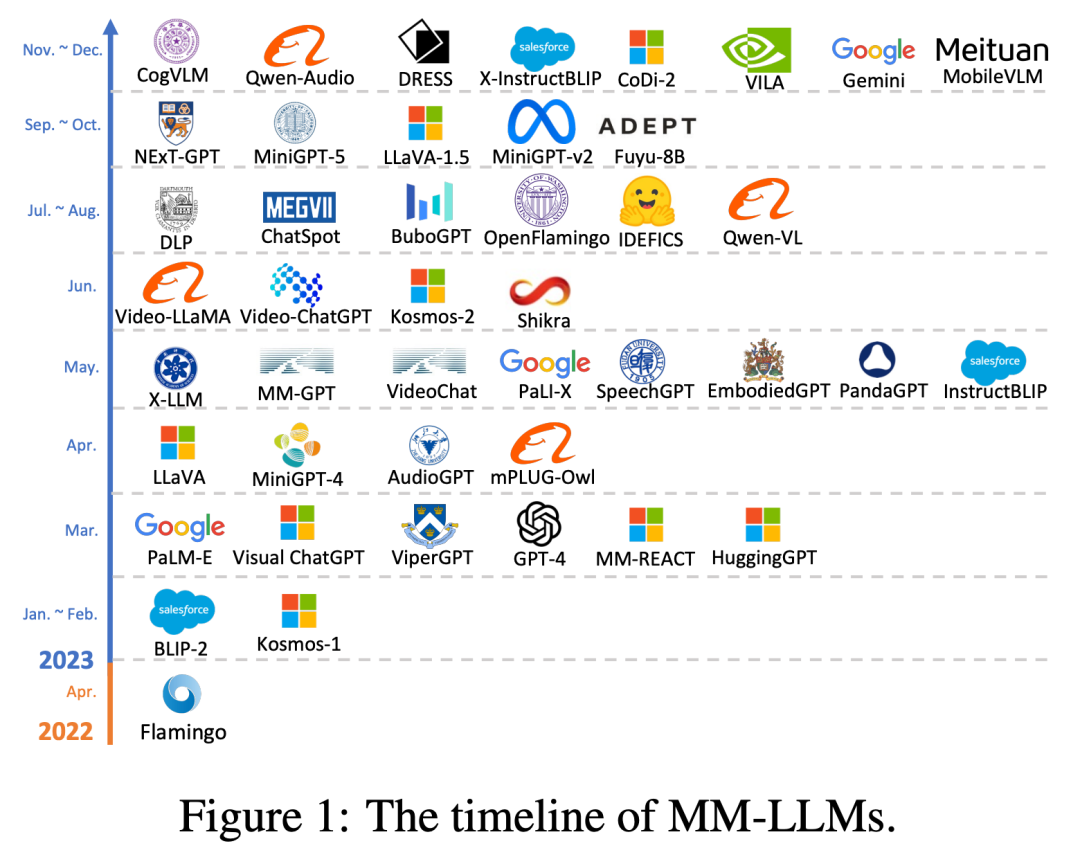

1.综述:多模态大型语言模型的最新进展

为促进对多模态大语言模型(MM-LLMs)的进一步研究,来自腾讯公司、京都大学和中国科学院大学的研究团队进行了全面的调查。概述了模型架构和训练 pipeline 的一般设计方案。简要介绍了 26 个现有的 MM-LLMs,每个模型都有其特定的构建方式。该项研究回顾了 MM-LLMs 在主流基准上的性能,总结了增强 MM-LLMs 性能的关键训练方法。

论文链接:

https://arxiv.org/abs/2401.13601

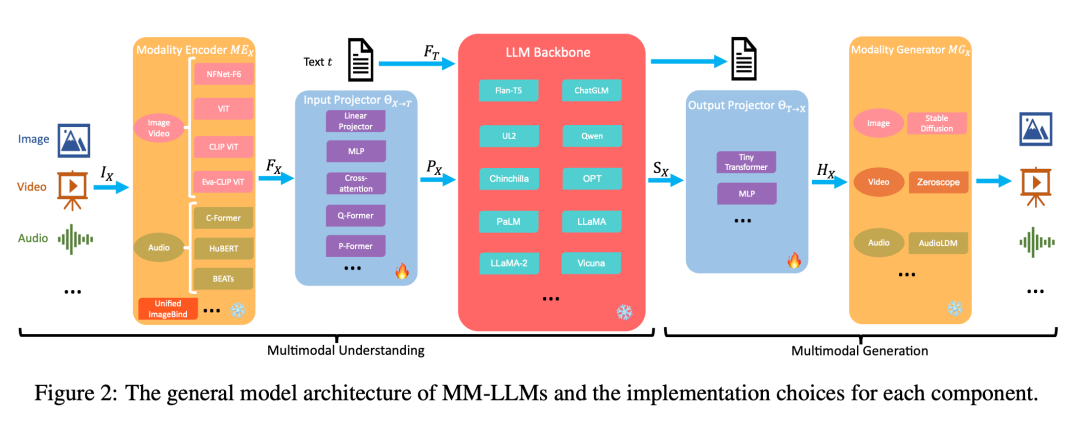

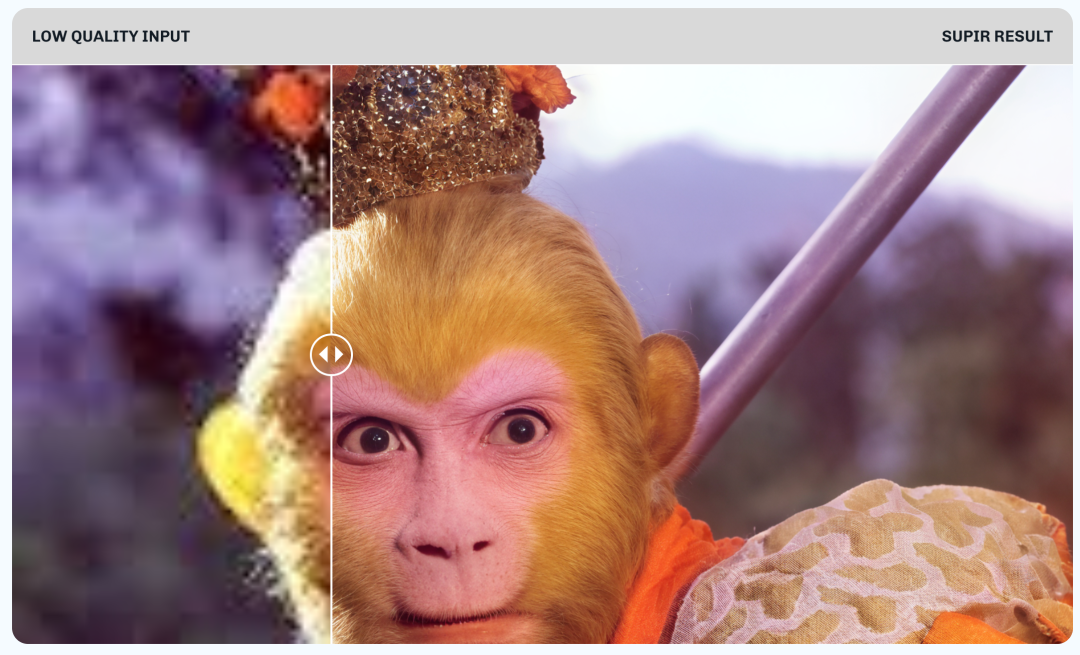

2.SUPIR:智能、逼真图像修复技术

来自中国科学院大学、上海人工智能实验室的研究团队及其合作者利用生成先验和模型扩展提出了一种突破性的图像复原方法——SUPIR(Scaling-UP Image Restoration)。SUPIR 在智能和逼真图像复原方面取得了重大进步。实验验证了 SUPIR 卓越的复原效果及其通过文本提示图像修复的新能力。

论文链接:

https://arxiv.org/abs/2401.13627

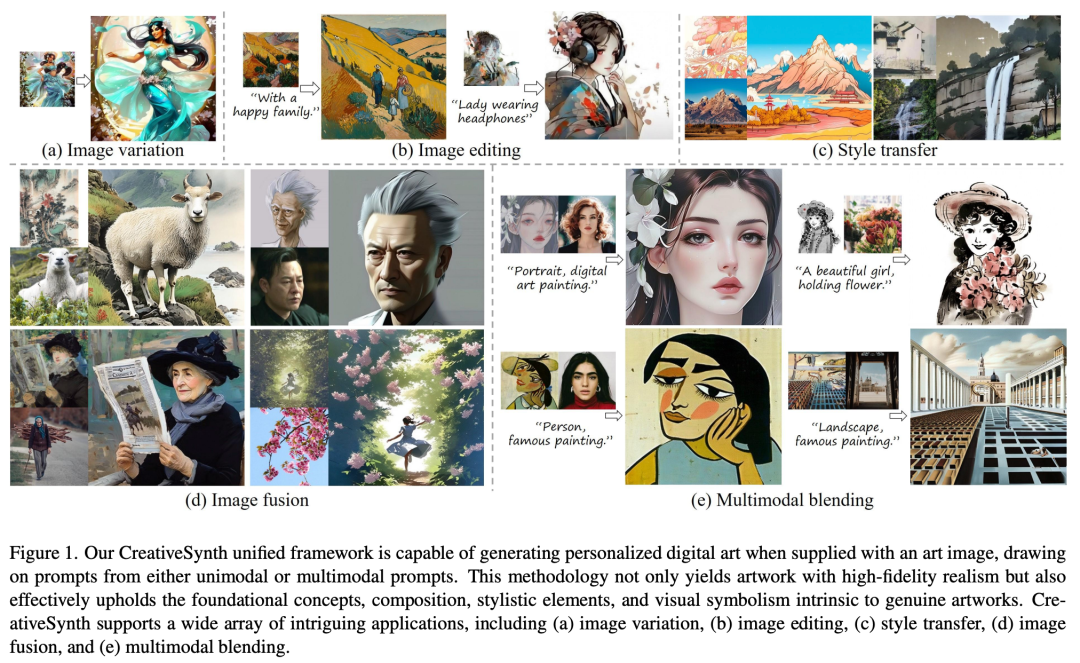

3.CreativeSynth:基于多模态扩散的视觉艺术创意混合与合成

来自中国科学院大学、中国科学院、字节跳动和清华大学的研究团队基于扩散模型建立了协调多模态输入和在艺术图像生成领域执行多任务的统一框架—— CreativeSynth。它可以通过反转和实时风格转换,将现实世界语义内容导入艺术领域,在保持原始模型参数完整性的同时,对图像风格和内容进行精确操作。

论文链接:

https://arxiv.org/abs/2401.14066

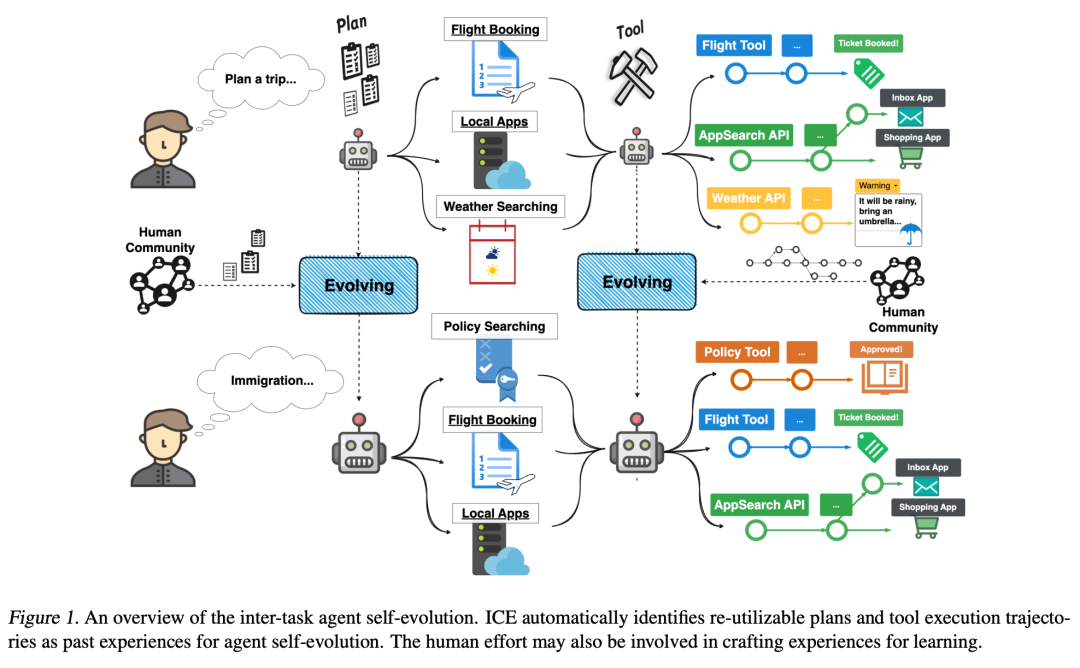

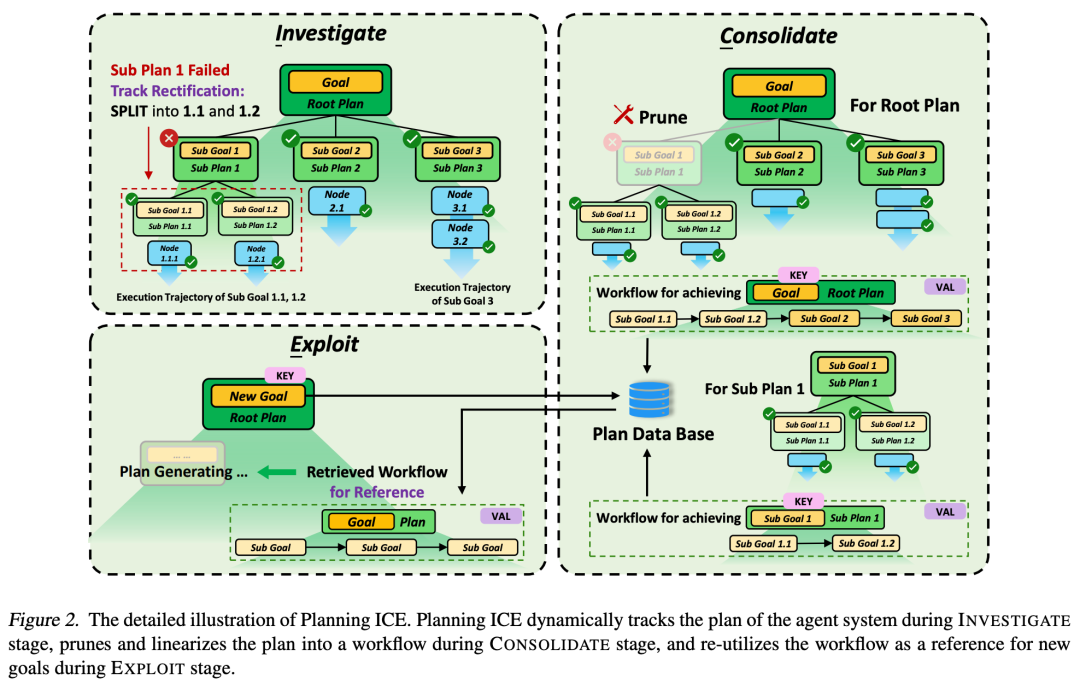

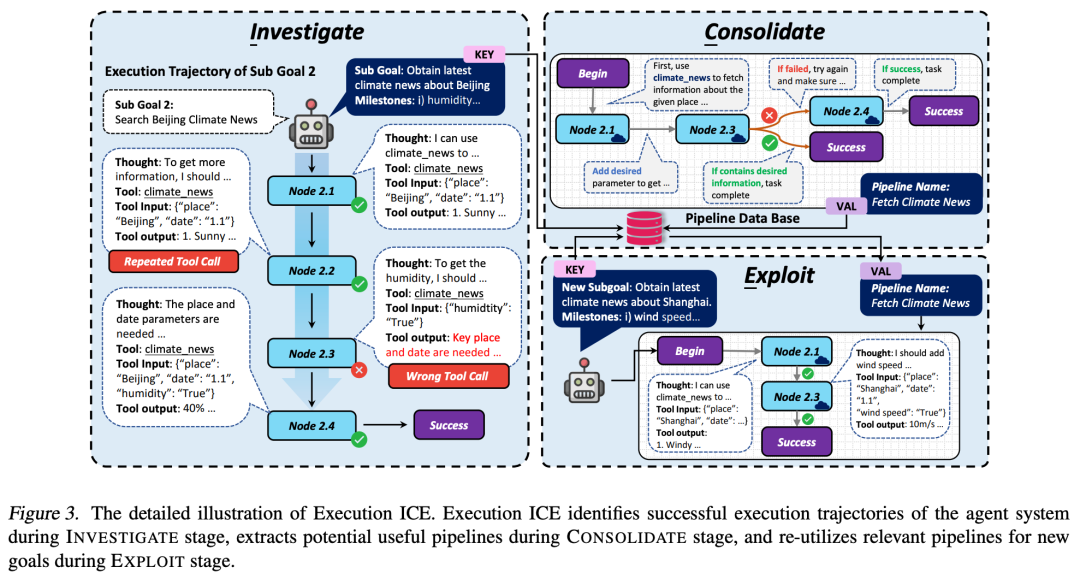

4.清华新研究:让GPT-3.5比肩GPT-4

来自清华大学和中国人民大学的研究团队及其合作者提出了一种通过任务间自我进化来增强人工智能(AI)智能体适应性和灵活性的新策略—— Investigate-Consolidate-Exploit(ICE)。它能够减少多达 80% 的 API 调用,并显著降低对模型能力的需求。当与 GPT-3.5 结合使用时,ICE 在各种智能体任务中的性能与原始 GPT-4 不相上下。

论文链接:

https://arxiv.org/abs/2401.13996

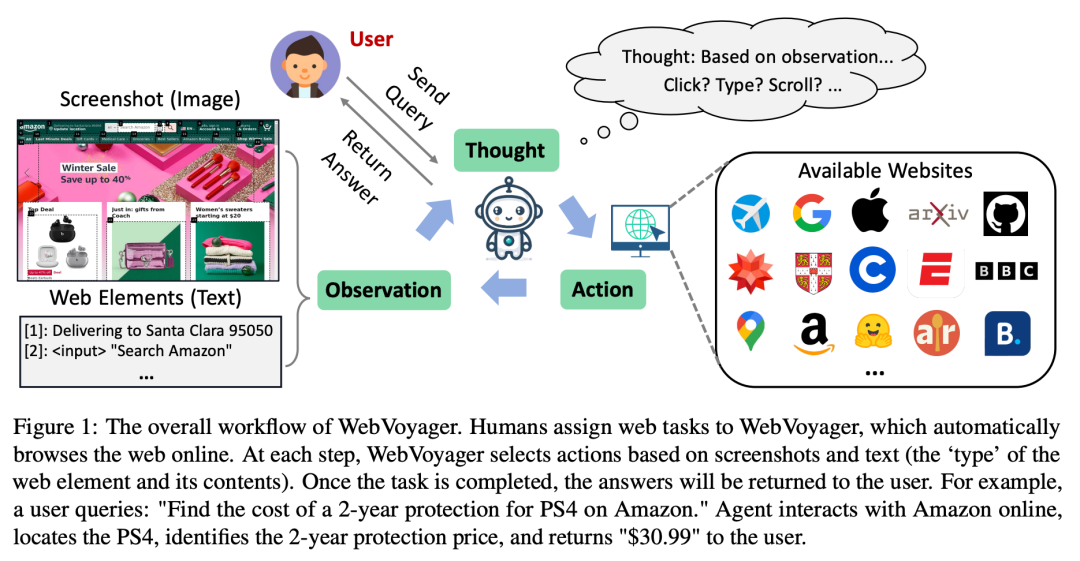

5.WebVoyager:利用大型多模态模型构建端到端网络智能体

来自浙江大学、腾讯公司和西湖大学的研究团队推出了一种创新的大型多模态模型(LMM)驱动的网络智能体—— WebVoyager。它可以通过与真实世界的网站交互来完成端到端的用户指令。WebVoyager 的自动评估与人类判断的一致性达到了 85.3%。

论文链接:

https://arxiv.org/abs/2401.13919

6.谷歌推出AI视频生成器 Lumiere

谷歌团队提出了一种专为视频生成的扩散模型—— Lumiere。它能够通过在多个时空尺度上处理视频,直接生成全帧率、低分辨率的视频;可以轻松促进包括文字到视频、图像到视频、视频修复和风格化生成等各种内容创建任务和视频编辑应用。

论文链接:

https://arxiv.org/abs/2401.12945

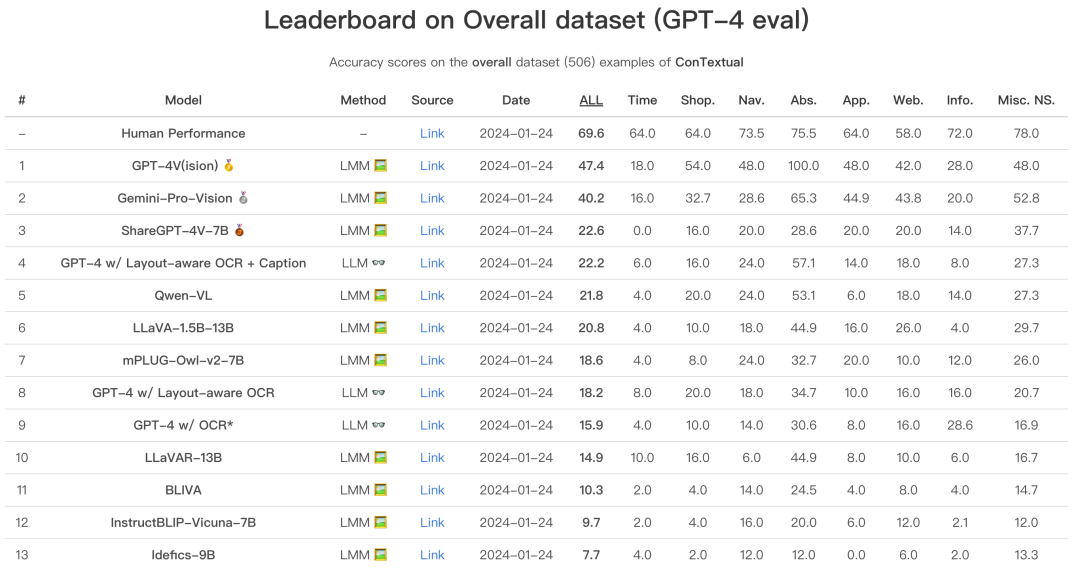

7.ConTextual:评估大型多模态模型中对上下文敏感的富文本视觉推理

来自加州大学洛杉矶分校的研究团队提出了一个评估大型多模态模型(LMMs)执行上下文敏感文本丰富的视觉推理能力(context-sensitive text-rich visual reasoning)指令的新基准—— ConTextual。研究表明,表现最好的 LMM、GPT-4V(ision) 的整体性能仍然落后于人类。

论文链接:

https://arxiv.org/abs/2401.13311

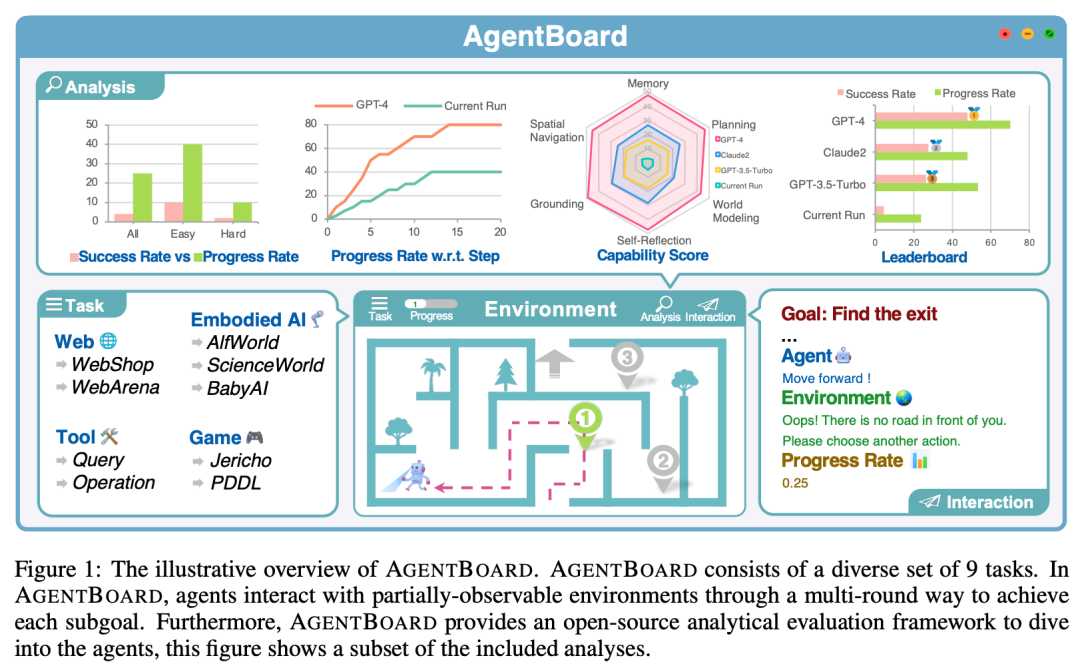

8.AgentBoard:多轮LLM智能体分析评估框架

来自香港大学、浙江大学、上海交通大学、清华大学的研究团队及其合作者提出了一个分析评估大型语言模型(LLM)智能体的开创性的综合基准和配套开源评估框架—— AgentBoard。AgentBoard 在揭开智能体行为的神秘面纱和加速开发更强大的 LLM 智能体方面迈出了重要一步。

论文链接:

https://arxiv.org/abs/2401.13178

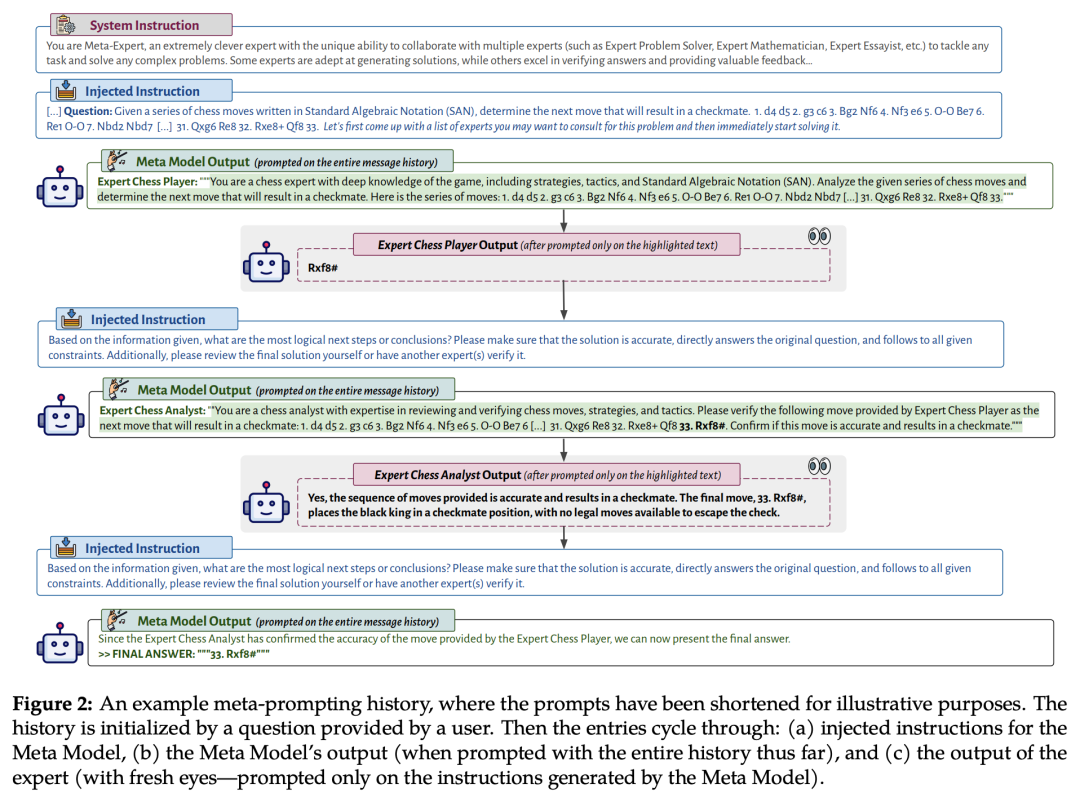

9.OpenAI、斯坦福提出Meta-Prompting:单一模型化身“多面”专家

来自 OpenAI 和斯坦福的研究团队提出了一种旨在提升语言模型(LM)功能的有效脚手架(scaffolding)技术—— Meta-Prompting。它将单一的 LM 转变为多功能的指挥者,擅长管理和整合多个独立的 LM 查询。研究团队将外部工具(如 Python 解释器)无缝整合到 meta-prompting 框架中,从而扩展了其适用性和实用性。

论文链接:

https://arxiv.org/abs/2401.12954

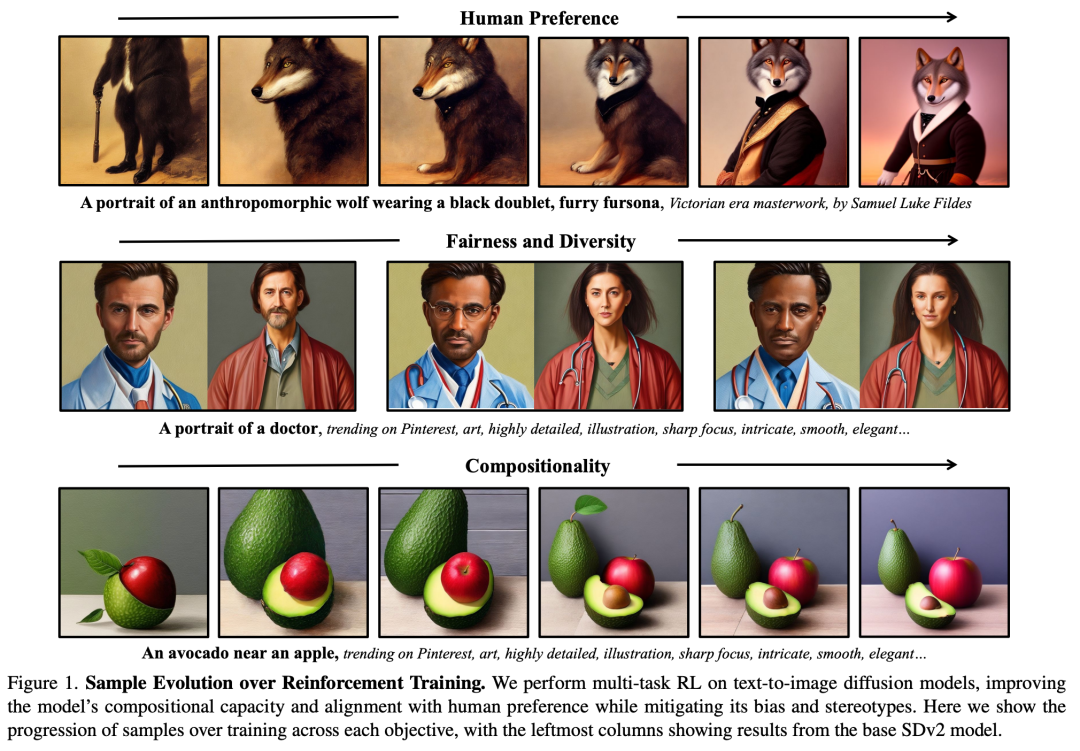

10.超越Stable Diffusion:扩散模型的大规模强化学习

来自 Pinterest 公司和麻省理工学院(MIT)的研究团队提出了一种有效的可扩展算法,利用强化学习(RL)在多个多样的奖励函数(如人类偏好、组合性和公平性)上改进扩散模型。这一方法显著超过现有方法,可以使扩散模型更符合人类偏好。

论文链接:

https://arxiv.org/abs/2401.12244

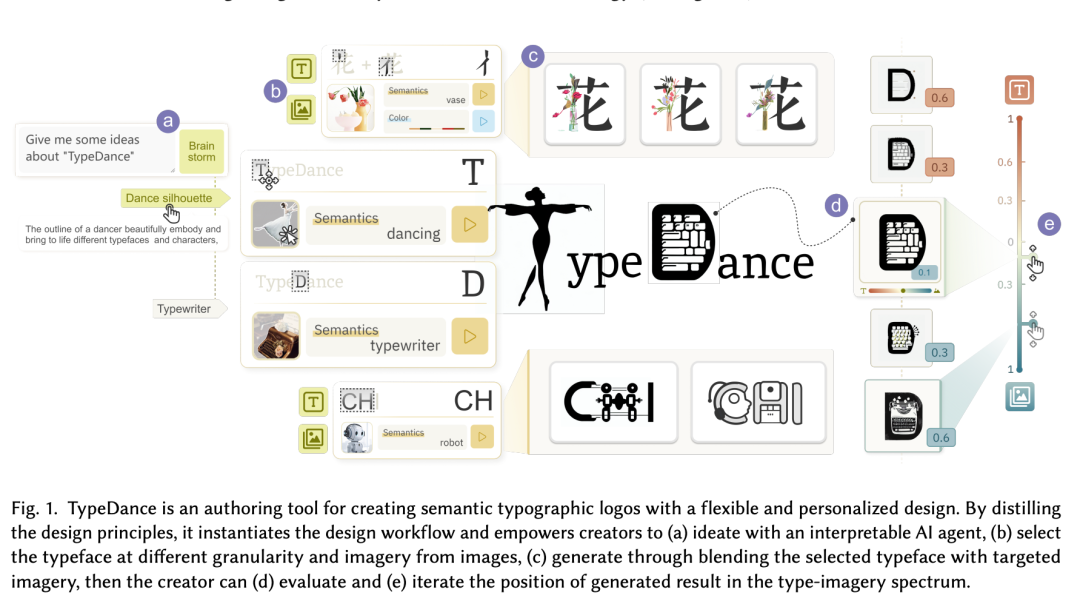

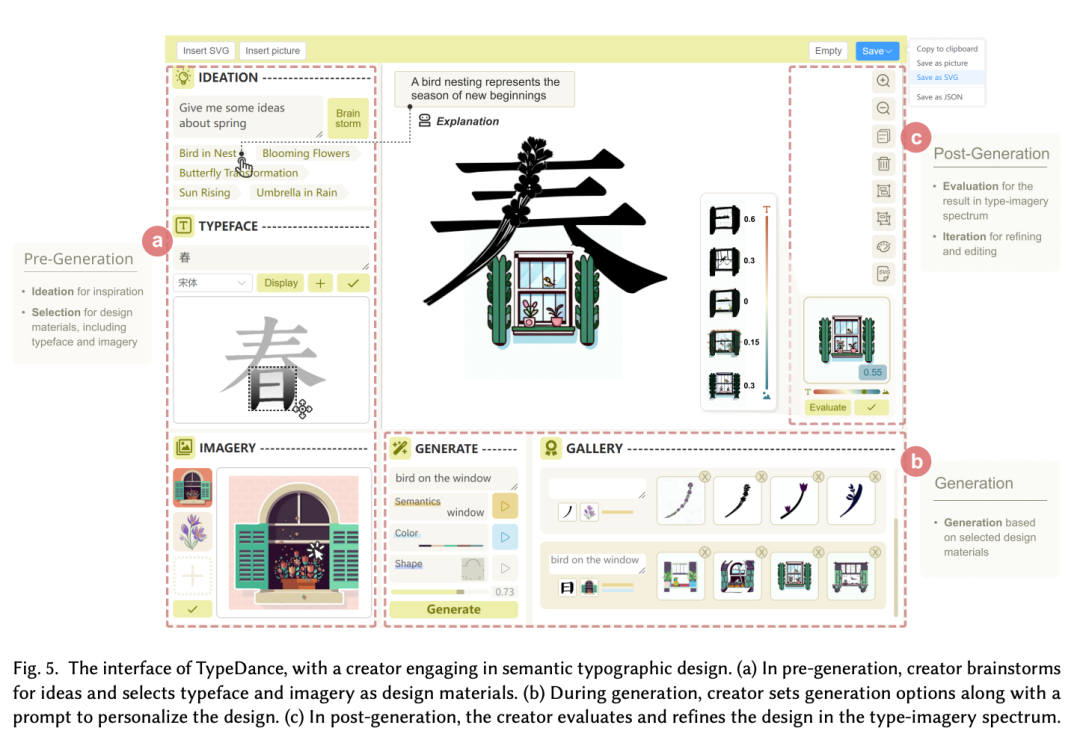

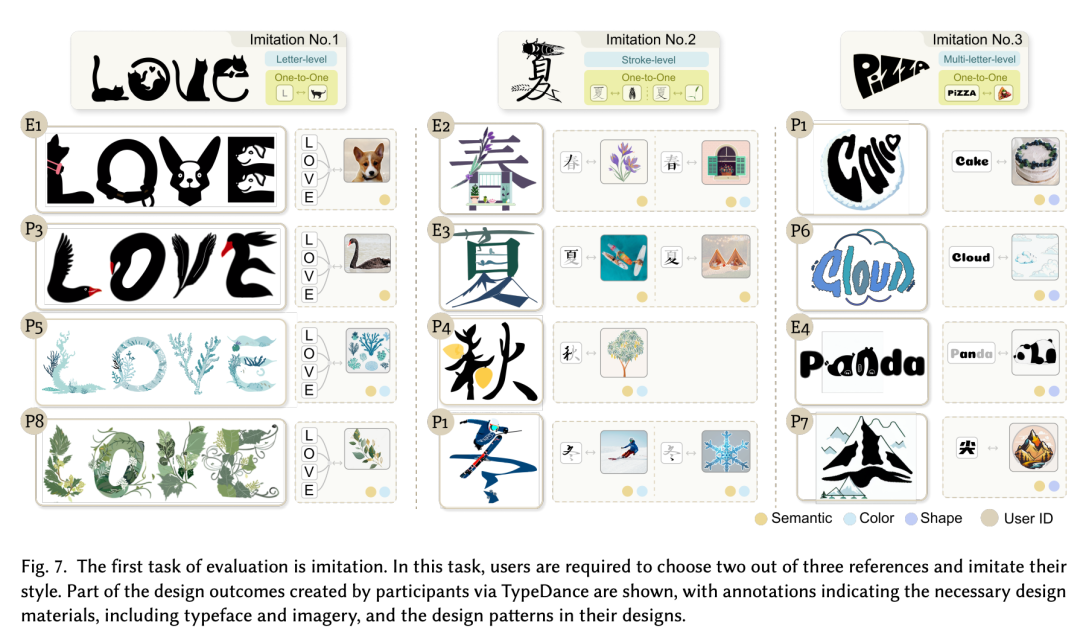

11.搞定logo设计,港科大提出AI辅助工具TypeDance

来自香港科技大学的研究团队提出了一种结合设计原则和个性化语义排版 Logo 设计的 AI 辅助工具——TypeDance。TypeDance 中包含一个全面的设计工作流程,包括创意构思、选择、生成、评估和迭代等环节。通过包括模仿和创作在内的双任务用户评估,证实了 TypeDance 在不同应用场景下的设计实用性和可用性。

论文链接:

https://arxiv.org/abs/2401.11094

12.OK-Robot:基于开放知识的新型机器人框架

来自纽约大学和 Meta 公司的研究团队开发了一个名为 OK-Robot 的新开放知识机器人框架。OK-Robot 将用于物体检测的视觉-语言模型(VLMs)、用于移动的导航原语和用于物体操作的抓取原语结合起来,为取放操作提供了一个无需任何训练的集成解决方案。OK-Robot 在开放式取放任务中实现了 58.5% 的成功率,代表了开放词汇移动操作(OVMM)领域的最新技术水平,其性能是之前工作的近 1.8 倍。在更干净整洁的环境中,OK-Robot 的性能提高到了 82%。

论文链接:

https://arxiv.org/abs/2401.12202

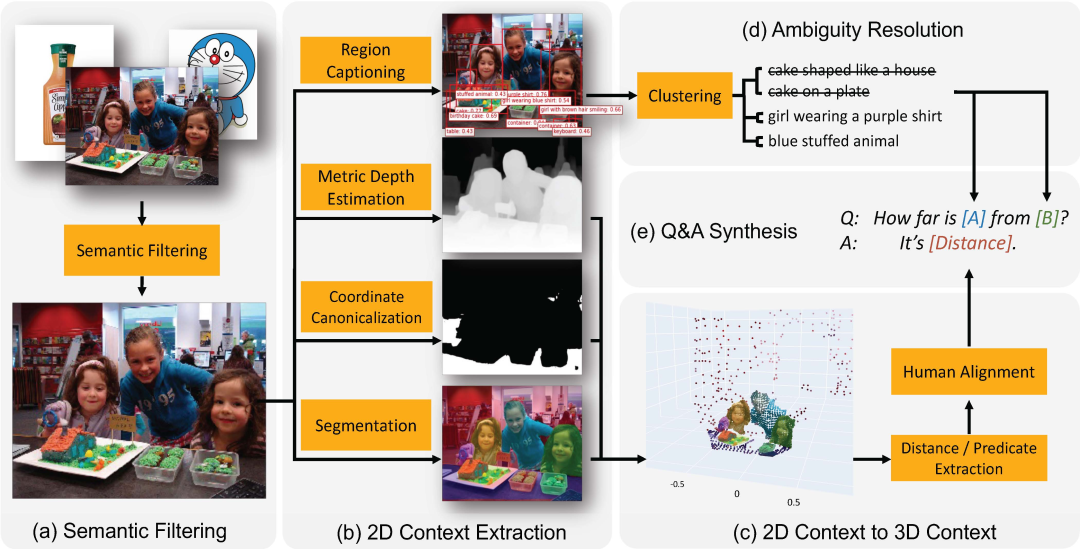

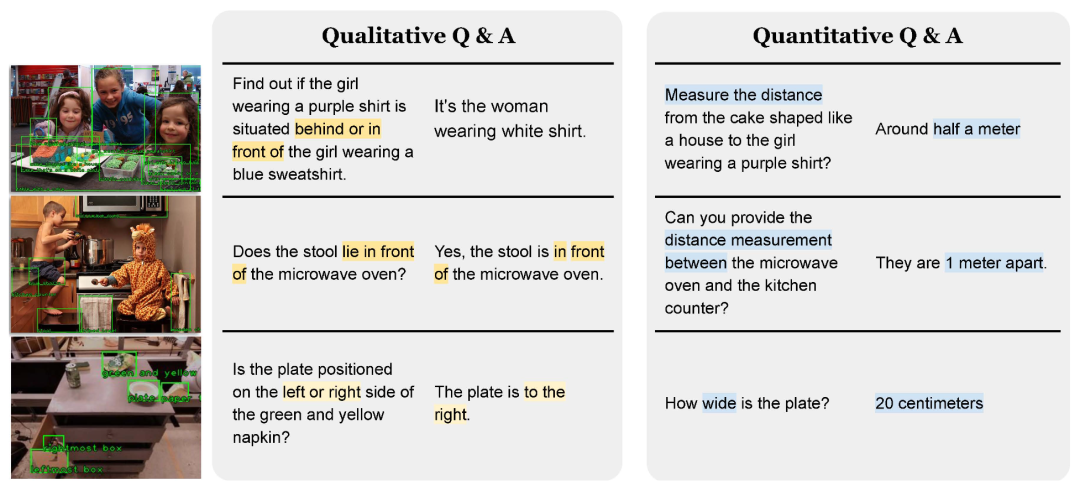

13.SpatialVLM:教视觉语言模型学会空间推理

来自谷歌、麻省理工和斯坦福的研究团队开发了一个自动 3D 空间 VQA 数据生成框架,可在 1000 万张真实世界图像上生成 20 亿个 VQA 示例。SpatialVLM 以首个互联网规模的度量空间 3D 空间推理数据集为特色。通过在此类数据上训练 VLM,大大提高了 VLM 在定性和定量空间 VQA 方面的能力。

论文链接:

https://arxiv.org/abs/2401.12168

14.WARM:提高LLM预测的整体质量和对齐

将基于人类反馈的强化学习(RLHF)和大型语言模型(LLMs)对齐可能会导致奖励破解,LLMs 利用奖励模型(RM)中的失误来获得看似很高的奖励,却没有达到基本目标。为此,来自谷歌公司的研究团队提出了加权平均奖励模型(WARM)。实验表明,WARM 提高了 LLM 预测的整体质量和一致性;例如,使用 WARM 进行微调的策略 RL 与使用单一 RM 进行微调的策略 RL 相比,胜率高达 79.4%。

论文链接:

https://arxiv.org/abs/2401.12187

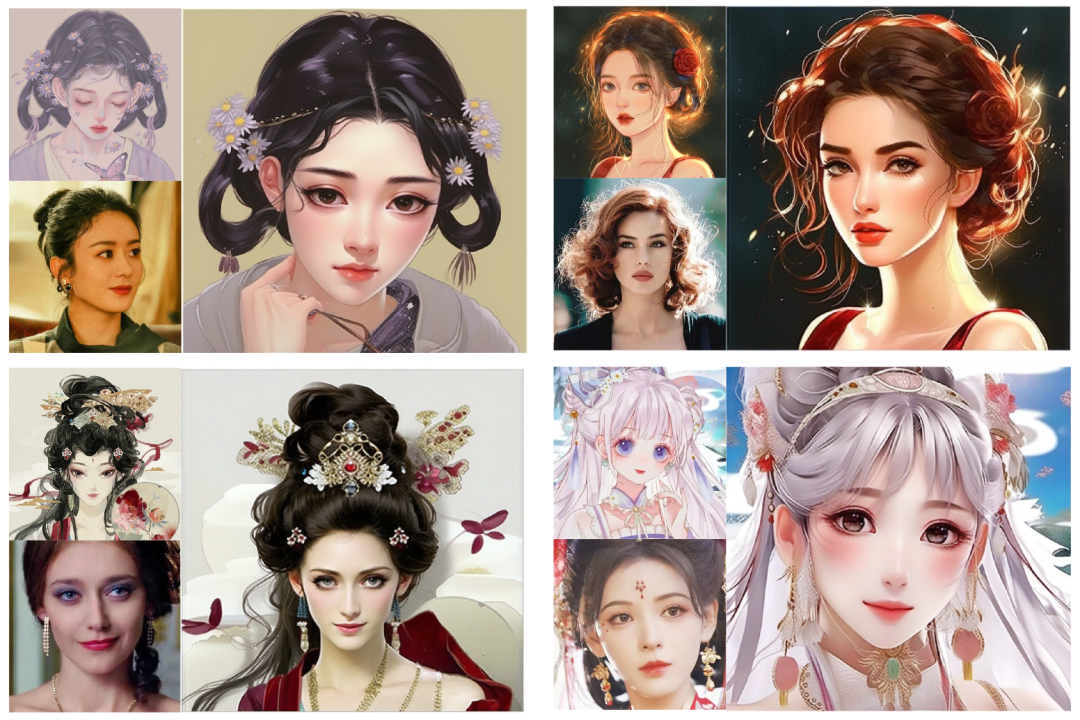

15.PhotoMaker:一种高效个性化定制人像照片的文生图模型

来自南开大学、腾讯公司和东京大学的研究团队提出了一种高效的个性化文本生成图像方法—— PhotoMaker。PhotoMaker 能够将任意数量的输入 ID 图像编码成一个堆叠的 ID 嵌入,以保留 ID 信息。作为一个统一的 ID 表示,这种嵌入不仅能够全面封装相同输入 ID 的特征,还能够容纳不同 ID 的特征以供后续整合。这为更多有趣且具有实际价值的应用提供可能。

论文链接:

https://arxiv.org/abs/2312.04461

|点击关注我 👇 记得标星|

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง