科技部监督司发布《负责任研究行为规范指引(2023)》,针对社会关注的人工智能、重大成果发布等热点问题,旗帜鲜明地划定了红线。

篡改实验数据、实验图片造假、论文不当署名、教材编写抄袭……1 月 16 日下午,华中农业大学的 11 名学生「一纸诉状」,以一份 125 页的举报材料实名举报该校黄姓教授存在学术不端行为。一时间,舆论迅速发酵,「赌上前程捍卫学术清白」、「人人都是学术造假受害者」等相关内容在各大平台引发热烈讨论。

有网友由此联想到了此前的阿尔兹海默症开山论文造假事件,这篇被引用 2300 余次的 Nature 论文误导了全球阿尔茨海默病研究长达 16 年。

心无旁骛求是真,艺不精深未可言。过去的百余年间,学术清正之风、造福人类的崇高信仰,是指引莘莘学子在科研道路上步履不停的明灯,但如今却掺杂了越来越多的名利诱惑,致使学术造假屡禁不止。尤其是在 AI、大模型等技术的快速发展之下,新兴技术却成为了科研作弊的「帮凶」,不仅对坚持研学的科研人员不公,虚假研究数据还可能造成严重后果。

所以,在严查学术造假的同时,规范 AI 等技术在科研中的应用也十分重要。

划清边界,依规合理使用生成式人工智能

学术论文造假由来已久,除了抄袭,编造数据等常规手段,花钱请写手、 「论文工厂」代写、炮制论文等行为也是屡见不鲜。

如今,以 ChatGPT 为代表的生成式人工智能技术 (AIGC) 横空出世,人们写论文提供了新帮手。从选题筛选到文稿润色、从统计分析到图表制作……其功能之强大,几乎覆盖了学术论文写作过程的方方面面,的确可以帮助科研人员快速完成文献检索、数据处理、翻译润色等工作。

但凡事都有双面性,如果研究人员将 AIGC 生成的文本当作自己的创作,很大程度上会产生毫无价值的「学术泡沫」。此外,过度依赖 AIGC 产生不可靠的研究成果,将导致科学研究的可信度大打折扣。

2023 年 12 月 21 日,科技部监督司发布《负责任研究行为规范指引(2023)》(以下简称《指引》),针对社会关注的人工智能、重大成果发布等热点问题,旗帜鲜明地划定了红线。

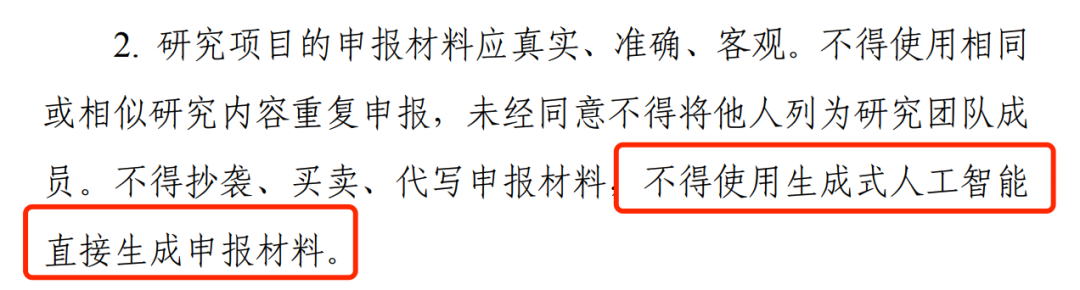

《指引》在研究选题与实施部分指出:科研人员研究项目的申报材料应真实、准确、客观。不得使用相同或相似研究内容重复申报,未经同意不得将他人列为研究团队成员。不得抄袭、买卖、代写申报材料,不得使用生成式人工智能直接生成申报材料。

应遵循相关法律法规及学术规范,依规合理使用生成式人工智能处理文字、数据或学术图像,防范伪造、篡改数据等风险。

在文献引用上,《指引》也明确规定了:使用生成式人工智能生成的内容,特别是涉及事实和观点等关键内容的,应明确标注并说明其生成过程,确保真实准确和尊重他人知识产权。对其他作者已标注为人工智能生成内容的,一般不应作为原始文献引用,确需引用的应加以说明。不得直接使用未经核实的由生成式人工智能生成的参考文献。

《指引》从研究实施、数据管理、成果署名与发表、文献引用等方面明确了合理使用生成式人工智能的边界,对于保护科学研究的可信度和伦理原则具有重要意义,有助于防止不负责任地使用生成式 AI 及相关技术。

国内外知名期刊对 AI 生成论文进行规范

学术论文造假是一个全球性的问题,生成式 AI 的出现在一定程度上降低了造假门槛,ChatGPT 等聊天机器人「一本正经说瞎话且能自圆其说」的能力更是为这些人提供了便利。但随着 AIGC 的使用边界不断清晰,除了明确法规规范外,国内外也有越来越多的学术机构已经达成共识,开始正视并规范 AI 的使用。

国内多家期刊发表声明,对投稿人在论文写作过程中的各种 AI 使用途径加以限制。如《暨南学报》《文献与数据学报》《中国科技期刊研究》《智库理论与实践》《图书情报工作》等期刊均发表声明称,如果论文主要内容是利用 AI 工具生成,一旦发现,以学术不端行为处理。

国外学术期刊也纷纷对 AI 在论文写作中的应用进行规范。据不完全统计,Nature(自然)、Cell(细胞)、The Lancet(柳叶刀)、JAMA(美国医学会杂志)等顶级期刊均发表声明称,人工智能不具有作者资格,使用人工智能的研究人员应在稿件中进行说明。

用 AI 打败 AI ,揪出论文「枪手」

推动 AI 向善发展,需要借助行之有效的技术手段。值得注意的是,在当前的技术水平下,AI 生成的论文在形式上与原创论文相似,传统的文本相似度比对工具可能无法准确检测出它们。因此,国内外都在探索研发专门针对 AIGC 的检测工具。

「AI 生成内容识别器的核心思想是首先构建一个训练数据集,包含真实的内容和 AI 生成的内容,然后训练一个分类器来区别这两类内容。」MILA 研究院知名华人学者唐建在接受媒体采访时解释道。

具体而言,人工智能语言模型通过一次预测和生成一个单词来工作。生成一个词后,水印算法将语言模型的词汇随机分为「绿名单」和「红名单」,然后提示模型选择「绿名单」上的词。一篇文章中列入「绿名单」的词越多,该文本就越有可能是由机器生成的,人类写的文本往往包含更随机的单词组合。

简单来说,AIGC 检测技术是在「用 AI 打败 AI 」,依托海量的文本和数据样本,识别出人类和 AIGC 工具在平均句子长度、词汇多样性和文本长度等方面的不同点,从而揪出 AI 论文「枪手」。

但这背后存在一些技术难点,比如语言模型经过人类创作文本训练,参数量越大,越接近人类创作,越难以区分;另外,检测还受限于文本长度,文本长度足够长,检测的准确率才有保障。

科研中合理使用 AI,不可因噎废食

AI for Science 的成功应用,在一定程度上将科研人员从文本、数据的处理工作中「解救」出来,使其能够更加专注于研究本身,可以在一定程度上提升效率,加快科学研究的进度。此外,在完成一些深度、复杂科研内容的探索上,人工智能也毫不逊色。

比如近年来医学研究领域备受重视的预测模型,让有些科研新人抓耳挠腮。而 AI 可以逐步建立思路和方法,帮助科研人员快速构建一个合格的模型。

再比如,在实验设计与优化方面,只需简单提供实验目的、方法和材料等信息,AI 便可生成详细的实验方案,帮助科研人员对已有的方案进行评估优化,减少实验消耗。

总之,对生成式人工智能不可「谈虎色变」,而要加以规范和引导,让它沿着正确的轨道为科学研究服务。对于科研人员而言,要善用 AI 技术,借助它的优势高效、准确地完成科研和论文的撰写,但所有的观点和数据,必须要经过作者的审查,避免生成式 AI 的一些虚假和杜撰的结论,以维护科学的尊严。

其实这也恰恰是 AI for Science 的初衷,利用 AI 实现对传统科研范式的重塑与创新。如今 AI for Science 已经在生物医药、材料化学、数学、物理等众多领域完成了升级,并且创造了一批具有实际应用价值的重要成果。但是,很多科研人员仍持观望态度,一方面是所在领域可能缺乏低门槛的 AI 工具,另一方面也可能是尚未找到 AI 与其研究领域的结合点。

AI for Science 的探索之旅才刚刚启程,唯有科研与 AI 携手并进,才能创造出更普适的工具与方法。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง