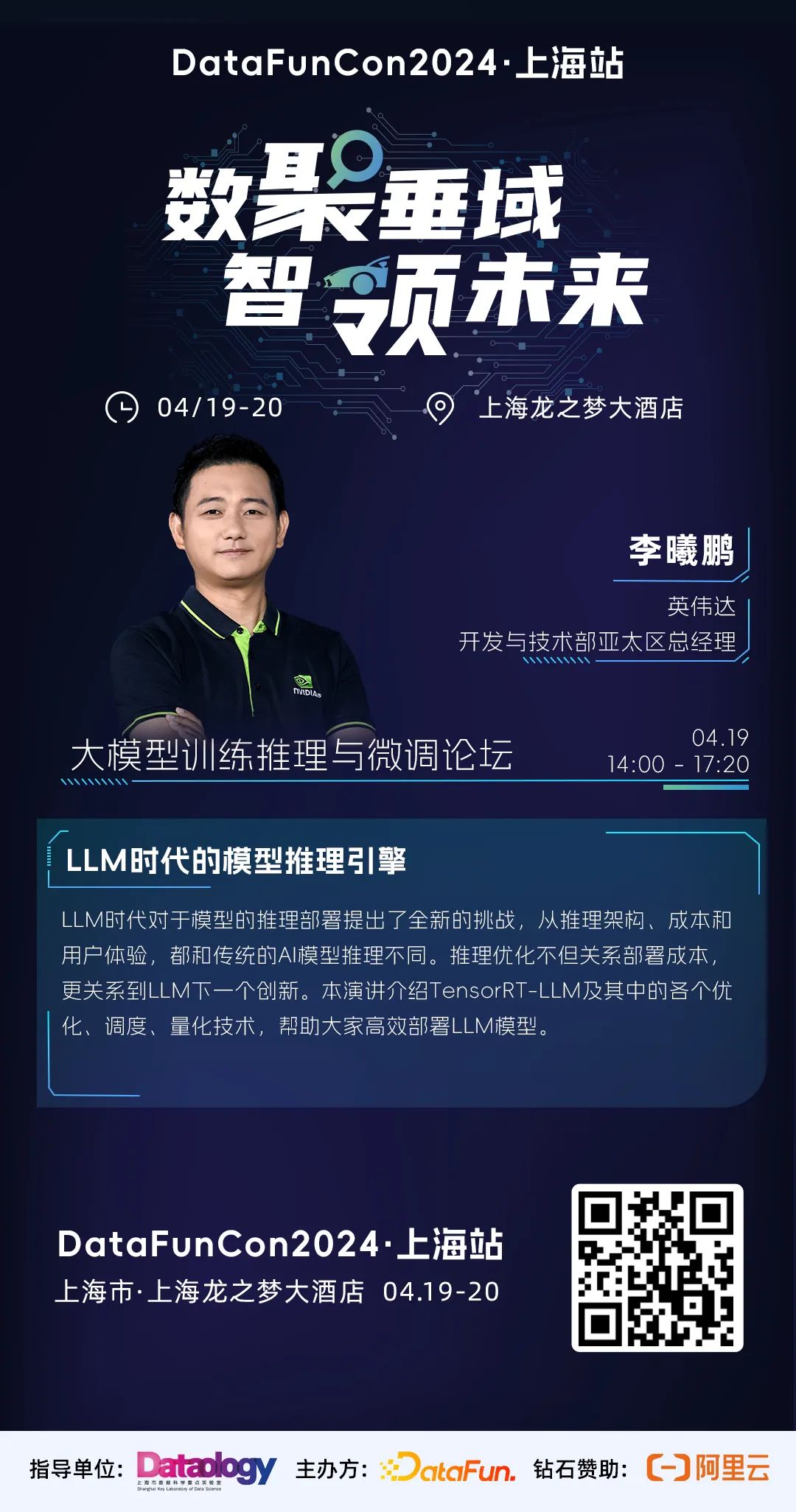

李曦鹏 英伟达 开发与技术部亚太区总经理

李曦鹏 英伟达 开发与技术部亚太区总经理

个人介绍:李曦鹏,NVIDIA 开发与技术部门亚太区总经理,博士毕业于中国科学院过程工程研究所。长期从事 GPU 加速计算,工业应用端到端优化加速。带领团队支持了国内外各行业头部企业人工智能和加速计算的大规模部署,团队开发有 Merlin-HugeCTR,Faster-Transformer, CV-CUDA 等加速计算开源产品。

演讲题目:LLM时代的模型推理引擎

演讲题目:LLM时代的模型推理引擎

演讲提纲:LLM时代对于模型的推理部署提出了全新的挑战,从推理架构、成本和用户体验,都和传统的AI模型推理不同。推理优化不但关系部署成本,更关系到LLM下一个创新。本演讲介绍TensorRT-LLM及其中的各个优化、调度、量化技术,帮助大家高效部署LLM模型。

听众收益:

听众收益:

1. 如何降低LLM推理成本

2. TensorRT-LLM

3. 量化

扫码报名参加大会

扫码报名参加大会

点击『阅读原文』,报名参加大会!

点击『阅读原文』,报名参加大会!

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง