MoE 模型评测为了构建更强大的语言模型,模型的参数规模和复杂度不断增加,导致计算成本持续攀升,对大模型的应用落地造成了阻碍。为了解决这一问题,Mixture-of-Experts(MoE)架构被应用到大语言模型上。简言之,MoE架构是将多个模型(称为“专家 / Experts”)通过“门控网络”结合在一起,选择最合适的“专家”来处理输入,从而减少计算量,有效地提高大模型的推理效率,同时保证较好的性能。

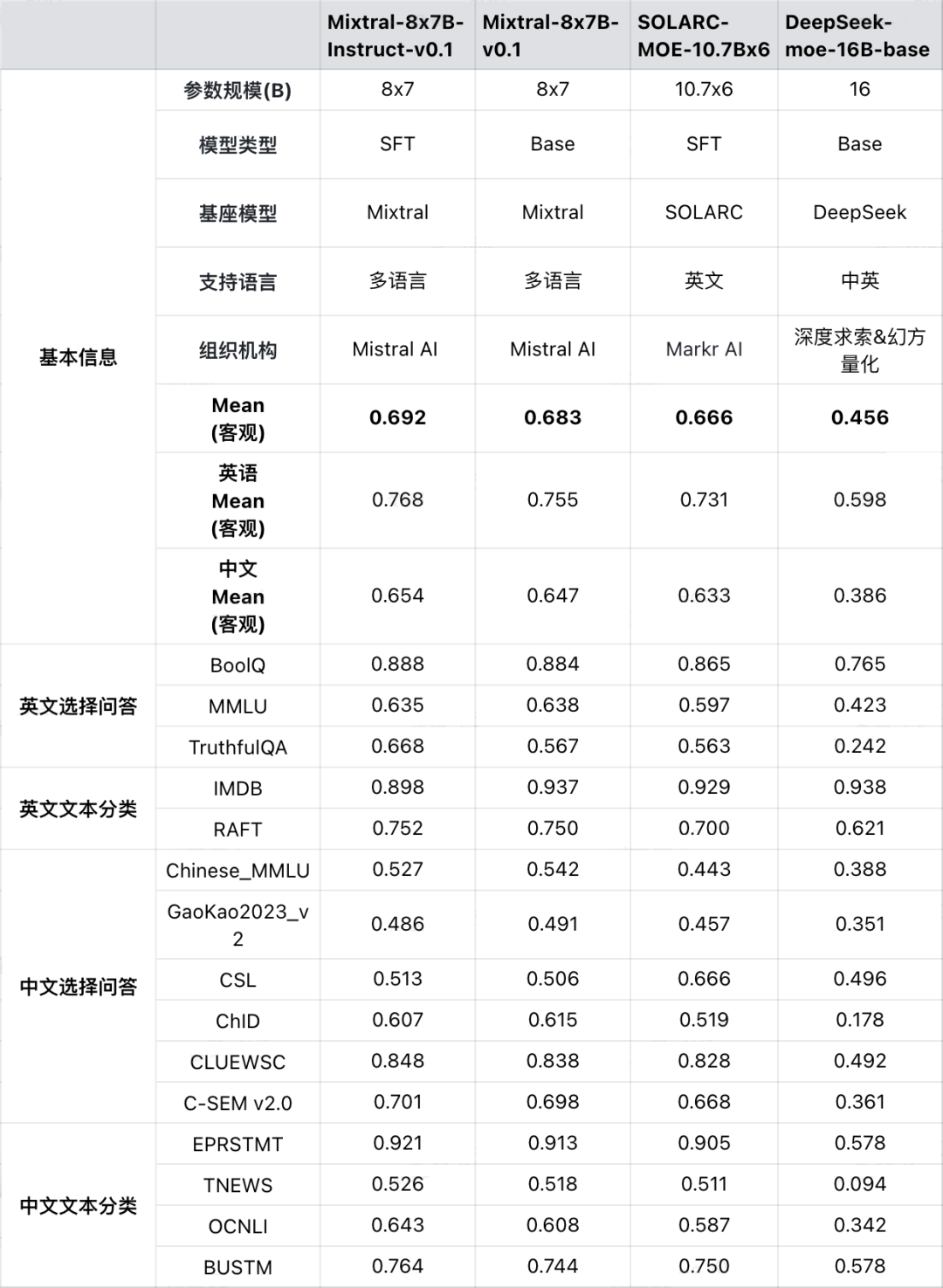

本期FlagEval大语言模型榜单评测了4个 MoE 模型:

-

Mixtral-8x7B系列基座模型及SFT模型:由有着“欧洲OpenAI”之称的创业公司 Mistral AI 发布,是首个在多项评测基准上超越Llama2-70B的MoE模型,开启大模型MoE实践新风向,同时也催生了一系列MoE模型“百花齐放”。

-

SOLARC-MOE-10.7Bx6:由韩国Markr AI团队基于Upstage AI团队发布的SOLAR系列开源模型打造,SOLAR模型曾在Hugging Face OpenLLM leaderboard上排名第一。

-

DeepSeek-MoE-16B-base:由国内深度求索&幻方量化团队发布,该团队在近期陆续发布了DeepSeek-67B、DeepSeek-7B系列模型。

评测结果如下:

1. 基座模型

-

Mixtral-8x7B-v0.1中英文客观评测准确率为 69.2%,接近 Qwen-14B。具体而言,英文客观评测准确率为76.8%,优于ChatGLM3-6B,略弱于 Llama-2-70B;中文客观评测准确率为65.4%,接近Yi-6B-200K。

-

由深度求索&幻方量化发布的DeepSeek-MoE-16B-base整体准确率(45.6%)弱于DeepSeek-7B(54.4%)。

2. SFT 模型

Mixtral-8x7B-instruct-v0.1、SOLARC-MOE-10.7Bx6,从中英客观评测结果来看,两个模型客观评测准确率分别为69.2%、66.6%,排名中上游,大致与InternLM2-7B-chat、InternLM2-20B-chat相当。更多模型评测结果详见FlagEval官网:flageval.baai.ac.cn(复制链接到浏览器或点击“阅读原文”)

FlagEval 大语言模型 2月榜单

除上文提到的 MoE模型之外,本期榜单新增 InternLM2 基座模型及 SFT模型评测:

1. 准确性指标:

-

InternLM2-20B 基座模型表现亮眼,综合准确率达到 74.6%,与 Qwen-72B 相当;对话模型 InternLM2-20B-chat 客观+主观准确率 68.2%。

- InternLM2-7B基座模型在 10B以下参数级模型中,排名第二,仅次于 ChatGLM3-6B-base;对话模型 InternLM2-chat-7B 在同参数级模型中排名第一,客观+主观综合准确率 64.7%。

2. 鲁棒性指标:

InternLM2 系列模型在扰动前后的准确率差值基本小于 5%,说明模型对指令的理解和跟随能力较强。详细评测数据见 flageval.baai.ac.cn

基座模型 Base Model

有监督微调模型 SFT Model

FlagEval(天秤)是北京智源人工智能研究院推出的大模型评测体系及开放平台,旨在建立科学、公正、开放的评测基准、方法、工具集,协助研究人员全方位评估基础模型及训练算法的性能。「FlagEval 大语言模型评测体系」当前包含 6 大评测任务,近30个评测数据集,超10万道评测题目,除了知名的公开数据集 HellaSwag、MMLU、C-Eval等,FlagEval 还集成了包括智源自建的主观评测数据集 Chinese Linguistics & Cognition Challenge (CLCC) 、代码生成模型评测集 TACO,北京大学等单位共建的中文语义理解评测集 C-SEM,北京航空航天大学共建的鲁棒性评测集。更多维度的评测数据集也在陆续集成中,敬请期待。FlagEval 是「智源FlagOpen大模型开源技术体系」的重要组成部分。FlagOpen 旨在打造全面支撑大模型技术发展的开源算法体系和一站式基础软件平台,支持协同创新和开放竞争,共建共享大模型时代的“Linux”开源开放生态。更多开源项目见官方网站:https://flagopen.baai.ac.cn

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง