新智元报道

编辑:alan

【新智元导读】近日,来自麻省理工的研究团队发表了Ddog项目,只需一幅眼镜就可以控制四足机器人,帮助特殊人群重获希望

还记得之前的AI读心术吗?最近,「心想事成」的能力再次进化,

——人类可以通过自己的想法直接控制机器人了!

来自麻省理工的研究人员发表了Ddog项目,通过自己开发的脑机接口(BCI)设备,控制波士顿动力的机器狗Spot。

狗狗可以按照人类的想法,移动到特定区域、帮人拿东西、或者拍照等。

而且,相比于之前需要使用布满了传感器的头套才能「读心」,本次的脑机接口设备以一幅无线眼镜(AttentivU)的形式出现!

视频中展示的行为也许比较简单,但这个系统的目的是将Spot改造为能够为患有肌萎缩侧索硬化症(ALS)、脑瘫或脊髓损伤等疾病的人士提供基本沟通工具。

整个系统的运行只需要两部iPhone和一副眼镜,却能给这些已经对生活失去希望的人带去实际的帮助和关怀。

并且,我们将在相关的论文中看到,这个系统实际上建立在非常复杂的工程之上。

论文地址:https://doi.org/10.3390/s24010080

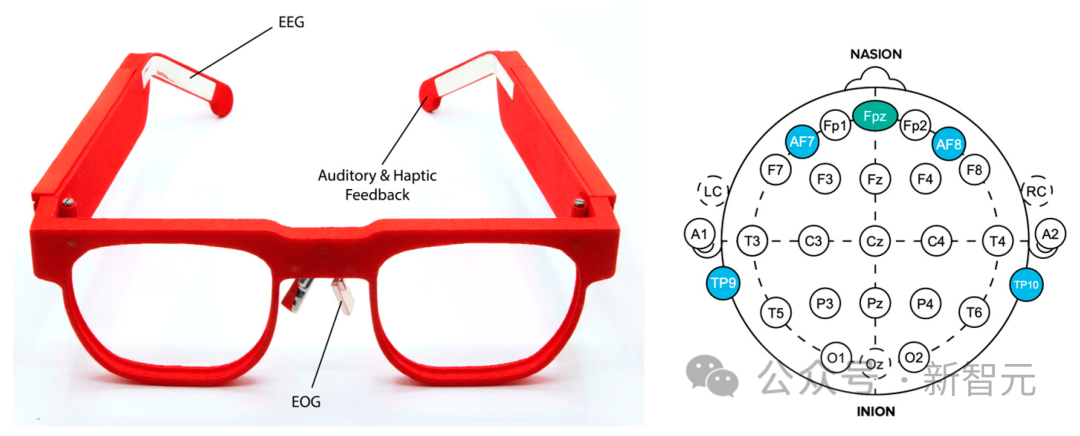

Ddog系统使用AttentivU作为脑机接口系统,传感器嵌入到镜框中,用来测量一个人的脑电图 (EEG) 或大脑活动,以及眼电图或眼球运动。

这项研究的基础是MIT的Brain Switch,一种实时的闭环BCI,允许用户与看护人进行非语言和实时的交流。

Ddog系统成功率为83.4%,并且,这是在个人助理用例中首次将无线、非视觉BCI系统与Spot集成。

视频中我们可以看到脑际接口设备的进化之路,以及开发者的一些思考。

在此之前,研究团队就已经完成了脑机接口与智能家居的交互,而现在完成了控制能够移动和操作的机器人。

这些研究给了特殊人群一丝光明,让他们有活下去的希望,甚至未来可以生活得更好。

相比于章鱼一样的传感器头套,下面这个眼镜确实酷多了。

根据美国国家罕见疾病组织的数据,目前美国有30000名ALS患者,且估计每年诊断出5000例新病例。此外,根据《脑瘫指南》,大约有100万美国人患有脑瘫。

这些人中的许多人已经或最终将失去走路、穿衣、说话、写作甚至呼吸的能力。

虽然确实存在通信辅助工具,但大多数是允许用户使用计算机进行通信的眼睛凝视设备。允许用户与周围世界互动的系统并不多。

这种BCI四足机器人系统作为一个早期的原型,为现代个人助理机器人的未来发展铺平了道路。

希望在未来的迭代中,我们能看到更加惊人的能力。

脑控四足机器人

在这项工作中,研究人员探索了无线和可穿戴BCI设备如何控制四足机器人——波士顿动力公司的Spot。

研究人员开发的设备通过嵌入眼镜架中的电极测量用户的脑电图(EEG)和眼电图(EOG)活动。

用户在心中回答一系列问题(「是」或「否」),每个问答都对应一组预置的Spot操作。

比如提示Spot穿过一个房间,拿起一个对象(如一瓶水),然后为用户取回它。

机器人与BCI

时至今日,脑电图仍然是最实用和最适用的非侵入性脑机接口方法之一。

BCI系统可以使用内源性(自发)或外源性(诱发)信号进行控制。

在外源性脑机接口中,当一个人注意外部刺激(如视觉或听觉线索)时,就会出现诱发信号。

这种方法的优点包括极简的训练以及高达60位/分钟的高比特率,但这需要用户始终关注刺激,从而限制了其在现实生活中的适用性。而且,用户在使用外源性BCI时会很快感到疲倦。

在内源性脑机接口中,控制信号独立于任何外部刺激产生,可以由用户按需完全执行。对于那些有感觉障碍的用户来说,这提供了一种更自然和直观的交互方式,用户可以自发地向系统发出命令。

不过这种方法通常需要更长的训练时间,并且比特率较低。

使用脑机接口的机器人应用通常适用于需要帮助的人群,它们通常包括轮椅和外骨骼。

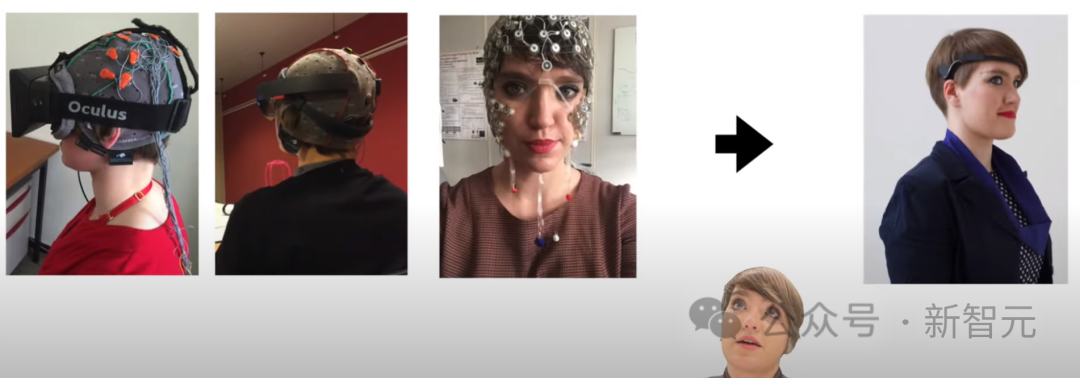

下图展示了截至2023年脑机接口和机器人技术的最新进展。

四足机器人通常用于在复杂的工作环境或国防应用中为用户提供支持。

最著名的四足机器人之一是波士顿动力公司的Spot,它可以携带高达15公斤的有效载荷,并迭代绘制隧道等维护站点的地图。房地产和采矿业也在采用Spot等四足机器人,帮助监控具有复杂物流的工作现场。

本文使用移动BCI解决方案控制的Spot机器人,并基于心算任务,总体架构命名为Ddog。

Ddog架构

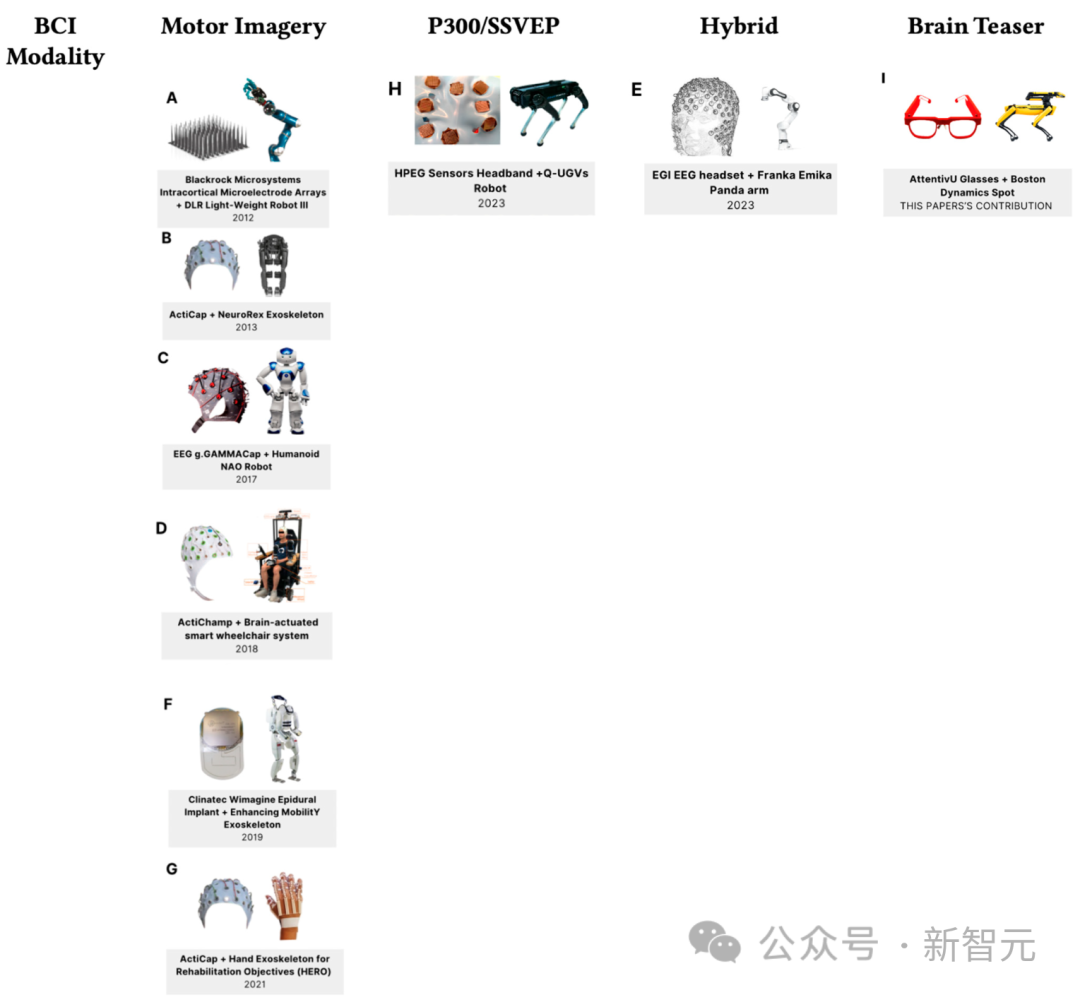

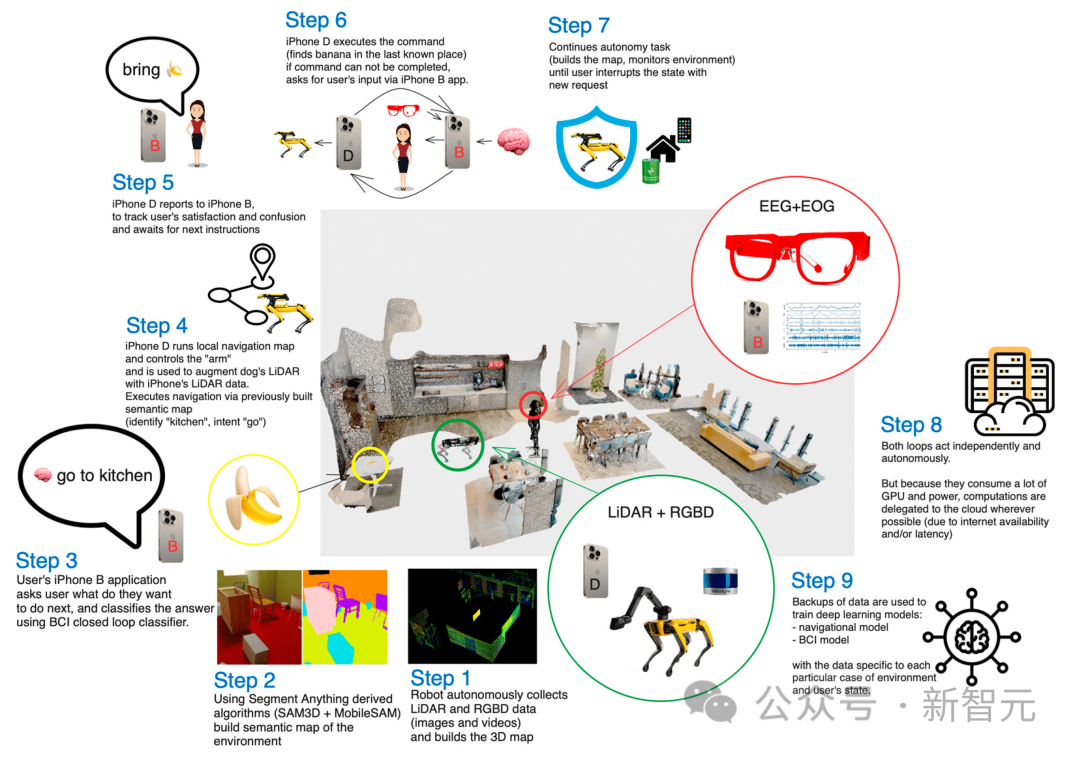

下图展示了Ddog的总体结构:

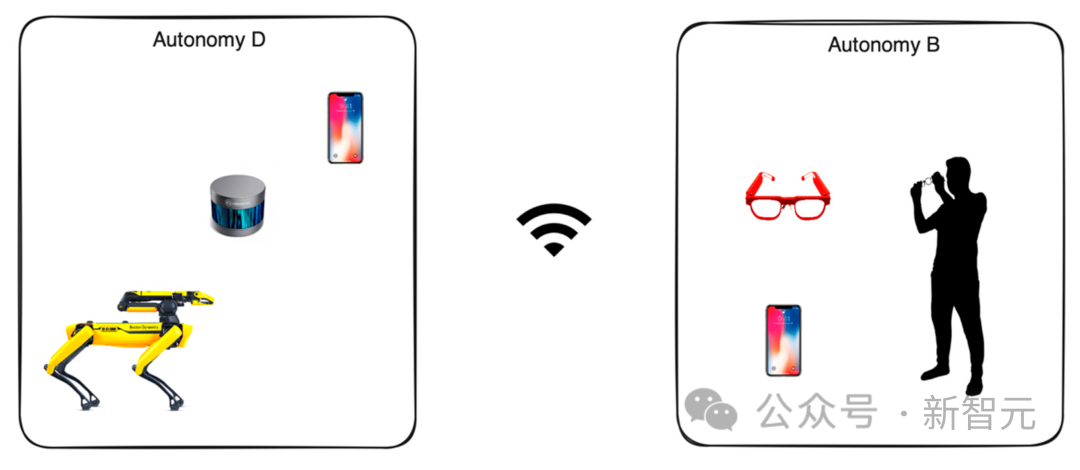

Ddog是一个自主应用程序,用户能够通过BCI的输入控制Spot机器人,而应用程序使用语音向用户及其护理人员提供反馈。

该系统设计为完全离线或完全在线工作。在线版本具有一组更高级的机器学习模型,以及更好的微调模型,对于本地设备也更省电。

整个系统为真实场景而设计,并允许对大多数零件进行快速迭代。

在客户端,用户通过移动应用程序与脑机接口设备(AttentivU)进行交互,该应用程序使用低功耗蓝牙(BLE)协议与设备进行通信。

用户的移动设备与另一部控制Spot机器人的手机进行通信,以实现代理、操纵、导航,最终为用户提供帮助。

手机之间的通信可以通过Wi-Fi或移动网络。负责控制的手机建立一个Wi-Fi热点,Ddog和用户的手机都连接到这个热点。使用在线模式时,还可以连接到云上运行的模型。

服务端

服务器端使用Kubernetes(K8S)集群,每个集群都部署在自己的Virtual Private Cloud(VPC)中。

云在专用VPC内工作,通常部署在更靠近最终用户的同一可用区中,使每个服务的响应延迟最小化。

集群中的每个容器都设计为单一用途(微服务架构),每个服务都是一个正在运行的AI模型,它们的任务包括:导航、映射、计算机视觉、操纵、定位和代理。

映射:从不同来源收集有关机器人周围环境信息的服务。它映射静态的不可移动数据(一棵树、一栋建筑物、一堵墙),但也收集随时间变化的动态数据(一辆车、一个人)。

导航:基于在先前服务中收集和扩充的地图数据,导航服务负责在空间和时间上构建A点和B点之间的路径。它还负责构建替代路线,以及估计所需的时间。

计算机视觉:从机器人摄像头收集视觉数据,并利用手机的数据增强,生成空间和时间表示。此服务还尝试分割每个视觉点并识别对象。

云负责训练与BCI相关的模型,包括脑电图(EEG)、眼电图(EOG)和惯性测量单元(IMU)。

部署在手机上的离线模型运行数据收集和聚合,同时也使用TensorFlow的移动端模型(针对更小的RAM和基于ARM的CPU进行了优化)进行实时推理。

视觉和操作

用于部署分割模型的原始版本是利用LIDAR数据的单个TensorFlow 3D模型。之后,作者将其扩展到少样本模型,并通过运行神经辐射场(NeRF)和RGBD数据的补充模型进行增强。

Ddog收集的原始数据是从五个摄像头汇总而来的。每个摄像头都可以提供灰度、鱼眼、深度和红外数据。手臂的夹持器内部还有第六个摄像头,具有4K分辨率和LED功能,配合预训练的TensorFlow模型检测对象。

点云由激光雷达数据以及由Ddog和手机的RGBD数据生成。数据采集完成后,通过单一坐标系进行归一化处理,并与汇集了所有成像和3D定位数据的全局状态相匹配。

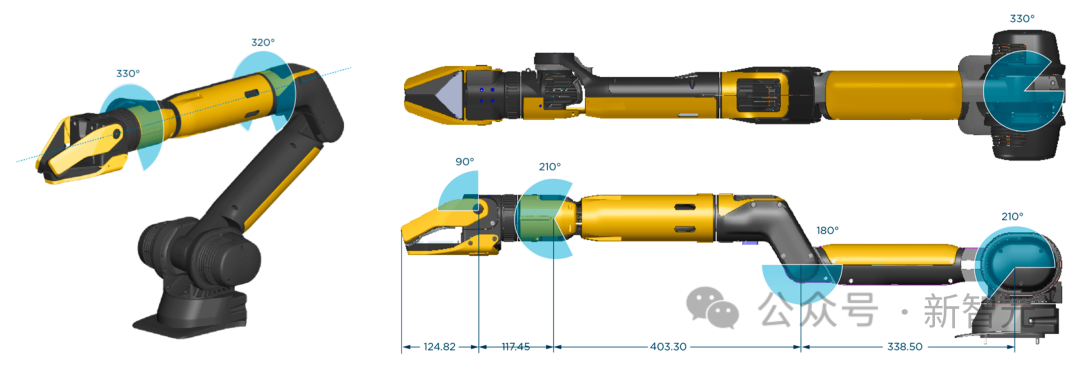

操作完全取决于安装在 Ddog 上的机械臂夹持器的质量,下图的夹具由波士顿动力公司制造。

实验中将用例限制在与预定义位置中的对象进行基本交互。

作者绘制了一个大的实验室空间,将其设置为一个「公寓」,其中包含「厨房」区域(有一个装有不同杯子和瓶子的托盘)、「客厅」区域(带枕头的小沙发和小咖啡桌), 和「窗口休息室」区域。

用例的数量在不断增长,因此覆盖大多数用例的唯一方法是部署一个系统以连续运行一段时间,并使用数据来优化此类序列和体验。

AttentivU

脑电图数据是从AttentivU设备收集的。AttentivU眼镜的电极由天然银制成,根据国际10-20电极放置系统,位于TP9和TP10位置。该眼镜还包括位于鼻托的两个EOG电极和一个位于Fpz位置的EEG参比电极。

这些传感器可以提供所需的信息,并在需要时支持实时、闭环的干预。

设备具有EEG和EOG两种模式,可用于实时捕捉注意力、参与度、疲劳和认知负荷的信号。EEG已被用作清醒和睡眠之间过渡的神经生理学指标,

而EOG基于测量眼球运动过程中由于角膜-视网膜偶极子特性而诱导的生物电信号。研究表明,眼球运动与执行某些任务所需的记忆访问类型相关,并且是视觉参与、注意力和嗜睡的良好衡量标准。

实验

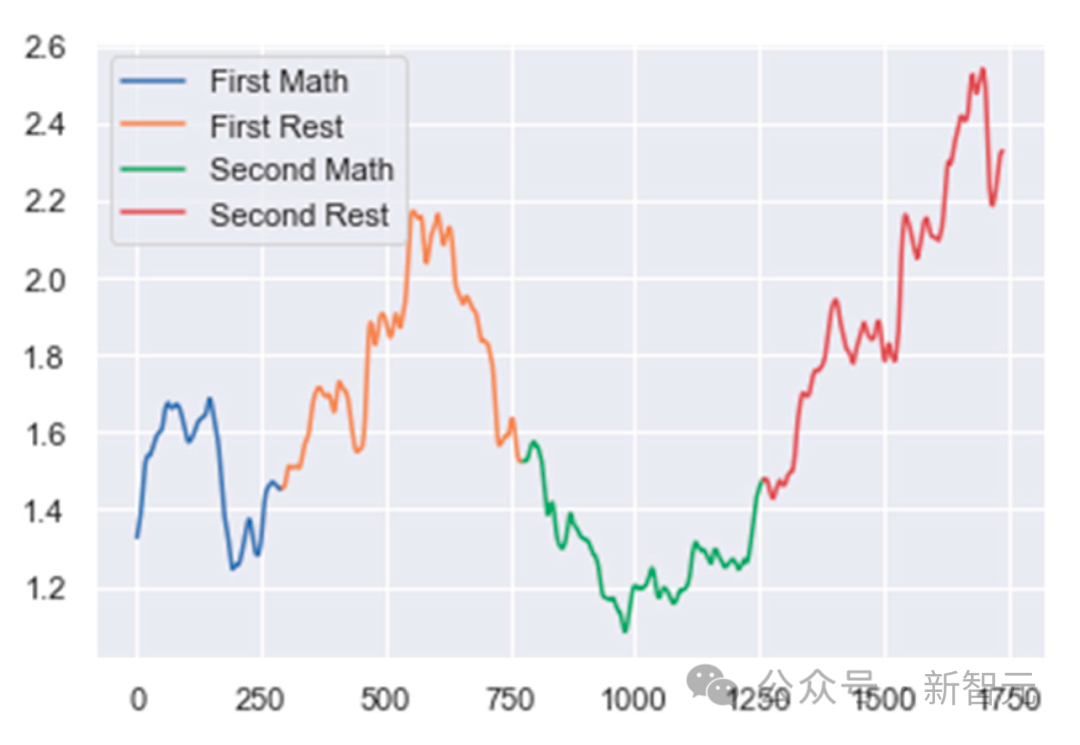

首先将脑电图数据分成几个窗口。将每个窗口定义为1秒长的EEG数据持续时间,与前一个窗口有75%的重叠。

然后是数据预处理和清理。使用50 Hz陷波滤波器和通带为0.5 Hz至40 Hz的带通滤波器的组合对数据进行滤波,以确保消除电力线噪声和不需要的高频。

接下来,作者创建了伪影拒绝算法。如果两个连续epoch之间的绝对功率差大于预定义的阈值,则拒绝某个epoch。

在分类的最后一步,作者混合使用不同的光谱波段功率比来跟踪每个受试者基于任务的心理活动。对于 MA,该比率为(alpha/delta)。对于WA,该比值为(delta/low beta),对于ME,该比值为(delta/alpha)。

然后,使用变化点检测算法来跟踪这些比率的变化。这些比率的突然增加或减少表明用户精神状态发生了变化。

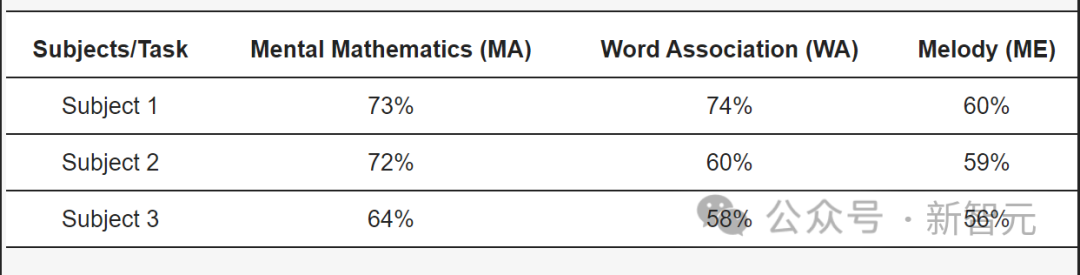

对于患有ALS的受试者,本文的模型在MA任务中达到了73%的准确率,在WA任务中达到了74%的准确率,在ME任务中达到了60%的准确率。

参考资料:https://www.therobotreport.com/ddog-mit-project-connects-brain-computer-interface-spot-robot/

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง