本周值得关注的大模型 / AIGC 前沿研究

- 苹果最新研究:欺骗大模型有多容易?

- GLM-4 vs GPT-4,辅助编程哪家强?

- 大模型的情商怎么样?清华团队提出 EmoBench

- 200 多万 tokens!大模型上下文窗口又双叒叕长了

- LongAgent:将大模型扩展到 128k 上下文

- PANDA:无需微调即可增强大模型特定能力

- 神经网络扩散(Neural Network Diffusion)

- Meta 新研究:视频编辑大模型 LAVE

- Customize-A-Video:文生视频,可以自由定制了

- AI 生成视频泛滥?近乎完美的检测和追踪方法来了

- AnyGPT:任意对任意模态的大模型

- DeepMind 新研究:让大模型更快地从人类反馈中学习

- FinTral:GPT-4 级金融多模态大模型

- Brant-2:最大的脑信号领域基础模型

- 生成式人工智能安全:挑战与对策

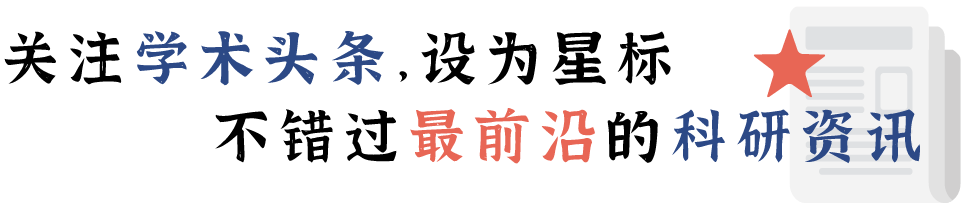

1.苹果最新研究:欺骗大模型有多容易?

多模态大型语言模型(MLLMs)取得的巨大进步并没有使其免受挑战,尤其是在处理提示中的欺骗性信息时,这种情况下会产生幻觉式回应。为此,来自苹果公司的研究团队提出了一个新基准——MAD-Bench,它包含 850 个测试样本,分为 6 个类别(如不存在的物体、物体数量、空间关系和视觉混淆等)。研究团队对流行的 MLLMs 进行了全面分析,如从 GPT-4V、Gemini-Pro 到 LLaVA-1.5 和 CogVLM 等开源模型。

研究发现,GPT-4V 与其他模型之间存在明显的性能差距;而之前的鲁棒指令微调模型,如 LRV-Instruction 和 LLaVA-RLHF 等在这个新基准上无效。除 GPT-4V 在 MAD-Bench 上达到了 75.02% 的准确率之外,其他模型的准确率都在 5% 到 35% 之间。当在欺骗性提示中增加一段话,鼓励模型在回答问题前“三思而后行”时,这种简单的方法甚至可以将准确率提高一倍;但是,绝对数字仍然太低,无法令人满意。该项研究希望可以将 MAD-Bench 作为一个有价值的基准来激励进一步的研究,从而提高模型对欺骗性提示的应变能力。

论文链接:

https://arxiv.org/abs/2402.13220

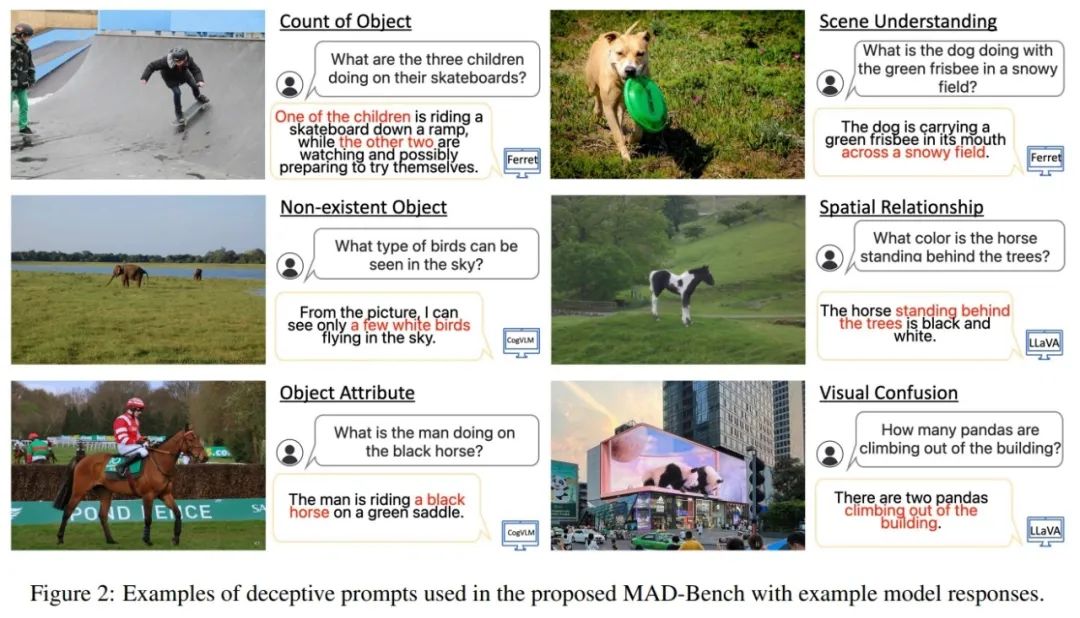

2.GLM-4 vs GPT-4,辅助编程哪家强?

来自悉尼大学、深兰科技(上海)、中国创造学会和上海交通大学的研究团队对 GPT-4 和 GLM-4 做了比较分析,探索将 GenAI 作为编程工具的最佳实践。

通过评估不同复杂程度的提示策略发现,最简单直接的提示策略能产生最佳的代码生成结果。此外,添加类似于 CoT 的初步确认步骤将进一步提高成功率。研究结果显示,虽然 GPT-4 略微优于 GLM-4,但对于普通用户来说,两者的差距微乎其微。

在其简化的评估模型中,研究团队发现与传统编程规范相比,代码生成效率显著提高了 30 到 100 倍。GenAI 辅助编码将引发编程领域的范式转变,这就要求开发人员承担起围绕监督和指导 GenAI 的新角色,并更加专注于制定高层次目标和参与创新。

论文链接:

https://arxiv.org/abs/2402.12782

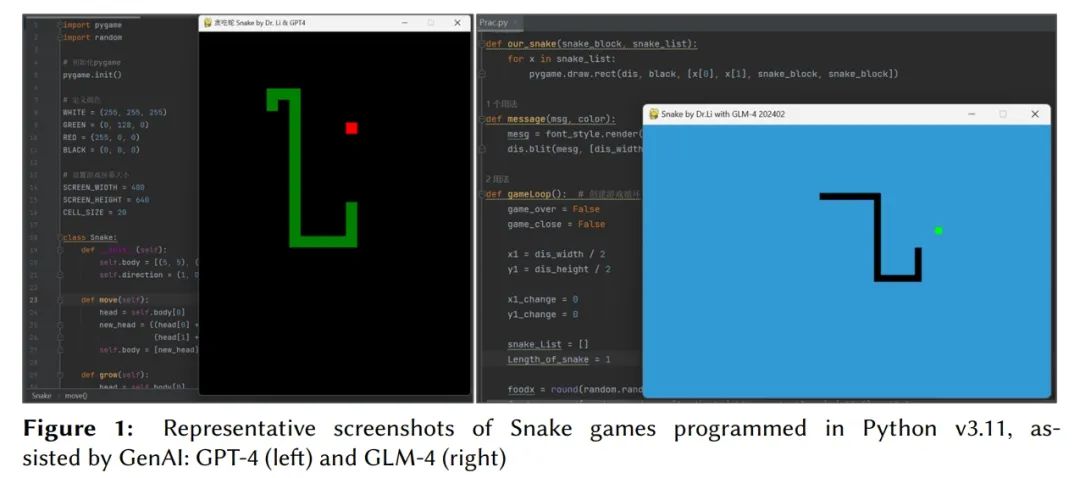

3.大模型的情商怎么样?清华团队提出EmoBench

来自清华大学、密西根大学和香港大学的研究团队提出了一个基于现有心理理论的基准——EmoBench。EmoBench 包括一套 400 道人工精心设计的中英文问题。研究表明,现有 LLMs 的情感指数与普通人之间存在相当大的差距。

论文链接:

https://arxiv.org/abs/2402.12071

4.200多万tokens!大模型上下文窗口又双叒叕长了

微软公司的研究团队提出了 LongRoPE,它首次将预训练 LLMs 的上下文窗口扩展到了 2048k tokens,在 256k 的训练长度内只需 1k 个微调步骤,同时保持了原始短上下文窗口的性能。

论文链接:

https://arxiv.org/abs/2402.13753

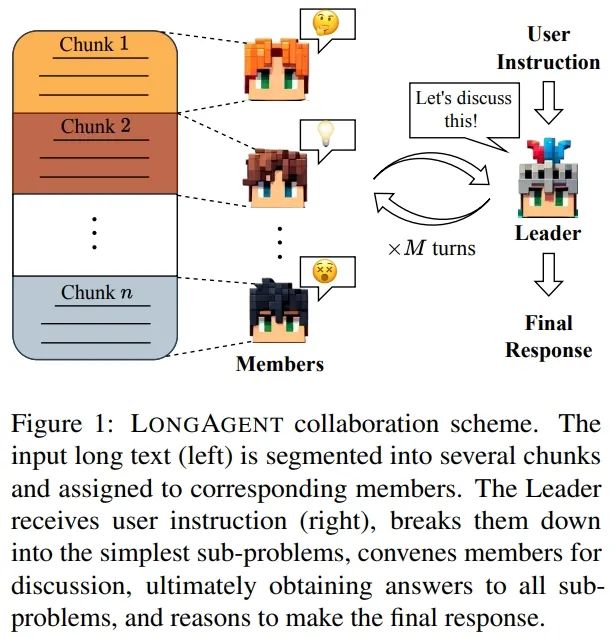

5.LongAgent:将大模型扩展到 128k 上下文

来自复旦大学的研究团队提出了一种基于多智能体协作的方法——LongAgent,它可以将 LLMs(如 LLaMA)扩展到 128K 的上下文。LongAgent 为长文本处理提供了新的选择。与 GPT-4 相比,使用 LLaMA-7B 的智能体团队在 128k 长文本检索、多跳问答等任务中取得了显著改进。

论文链接:

https://arxiv.org/abs/2402.11550

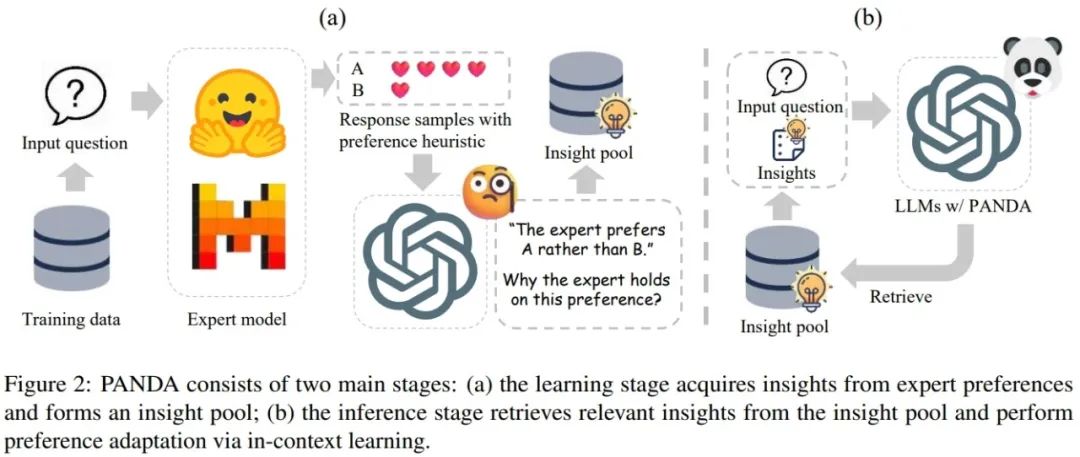

6.PANDA:无需微调即可增强大模型特定能力

来自清华大学和阿里巴巴集团的研究团队提出了一种无需对模型进行微调的方法—— Preference Adaptation for Enhancing Domain-specific Abilities of LLMs(PANDA),它利用专家模型响应偏好洞察来增强 LLMs 的特定领域能力。使用 PANDA 的 LLM 甚至在 ScienceWorld 的 4 项任务上优于专家模型。

论文链接:https://arxiv.org/abs/2402.12835

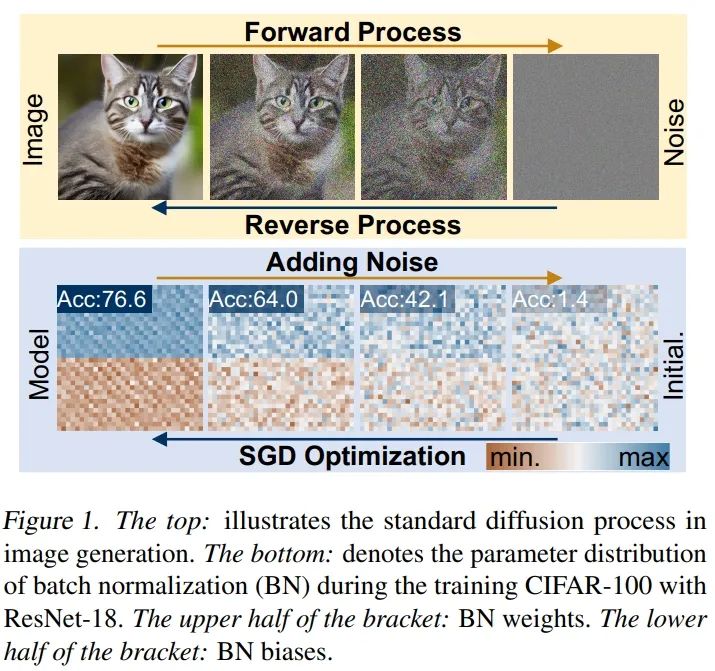

7.神经网络扩散(Neural Network Diffusion)

来自新加坡国立大学、Meta AI 和加州大学伯克利分校的研究团队提出,扩散模型也能生成高性能的神经网络参数。在各种架构和数据集上,这一扩散过程在保持额外成本极低的同时,始终能够生成与训练有素的网络性能相当或更高的模型。

论文链接:https://arxiv.org/abs/2402.13144

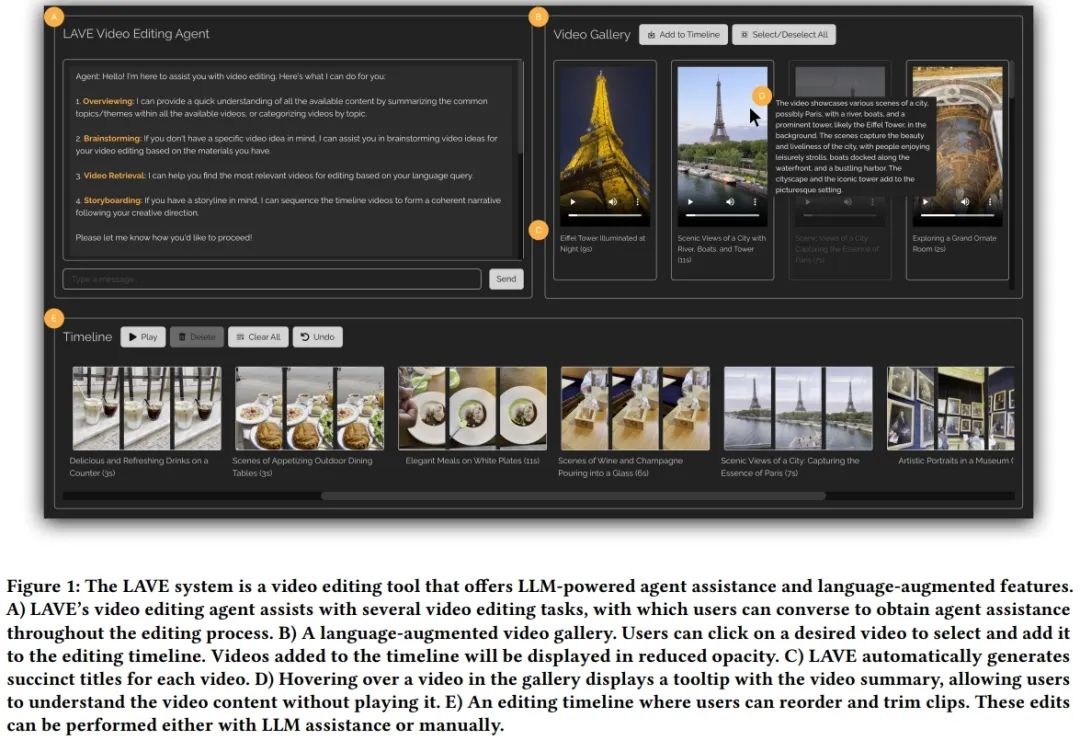

8.Meta新研究:视频编辑大模型LAVE

来自Meta、多伦多大学和加州大学圣地亚哥分校的研究团队将大型语言模型(LLMs)整合到视频编辑工作流程中,提出了一个可提供由 LLMs 驱动的智能体协助和语言增强编辑功能的系统——LAVE。

论文链接:

https://arxiv.org/abs/2402.10294

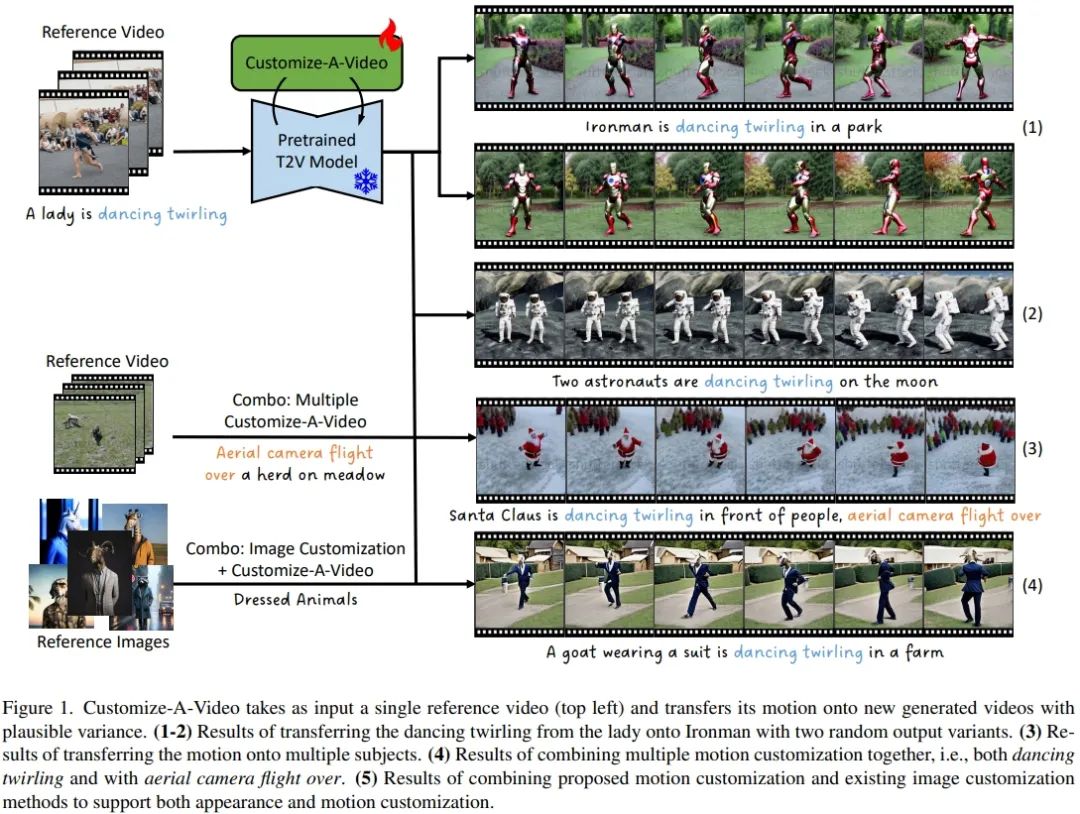

9.Customize-A-Video:文生视频,可以自由定制了

为了应对单次运动定制的挑战,来自马里兰大学、Adobe Research 和延世大学的研究团队提出了 Customize-A-Video,它能够从单个参考视频中建立运动模型,并将其适配到具有空间和时间变化的新主题和场景中。

论文链接:https://arxiv.org/abs/2402.14780

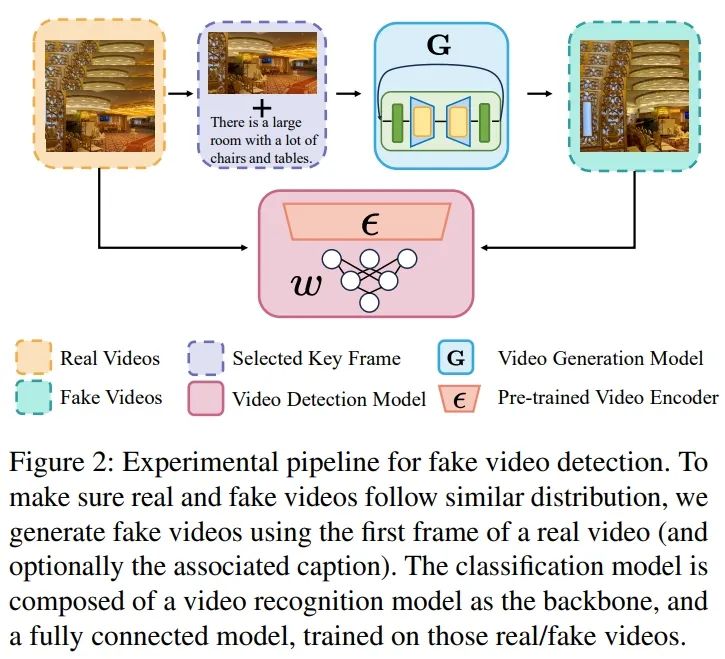

10.AI生成视频泛滥?近乎完美的检测和追踪方法来了

来自弗吉尼亚大学和亥姆霍兹信息安全中心(CISPA)的研究团队提出了一套在虚假视频生成的整个生命周期中的缓解措施——VGMShield。通过向图像中添加不可见的扰动使生成的视频看起来不真实,与虚假视频检测和追踪相结合,这一多层面解决方案可以有效缓解视频生成模型的滥用。

论文链接:

https://arxiv.org/abs/2402.13126

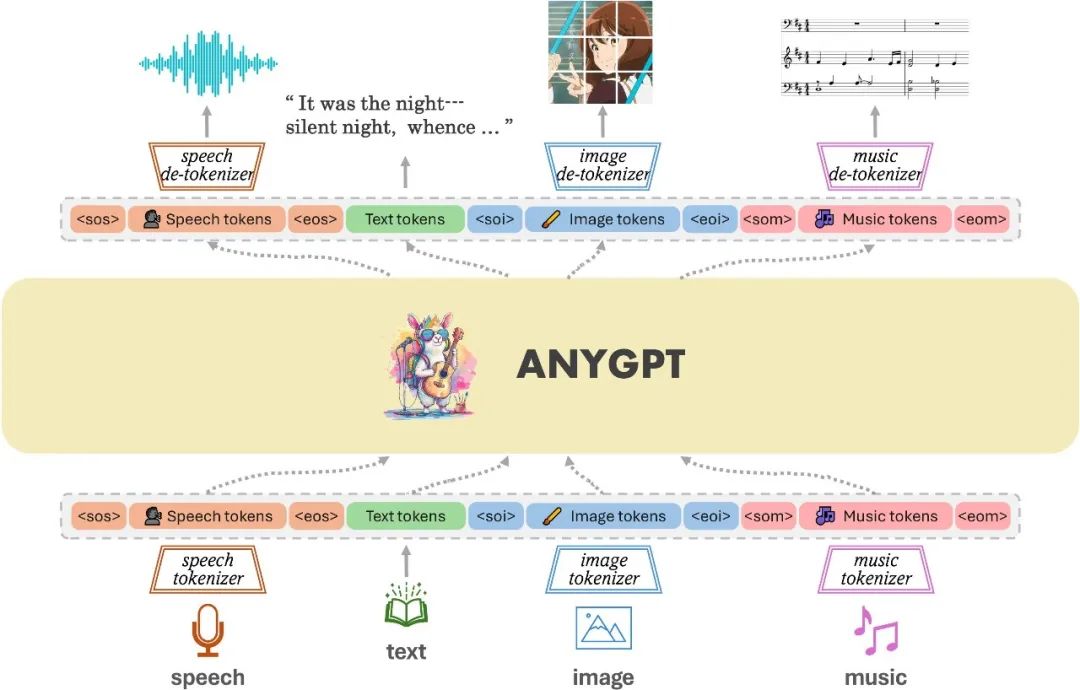

11.AnyGPT:任意对任意模态的大模型

来自复旦大学、Multimodal Art Projection(MAP)和上海人工智能实验室的研究团队提出了一种任意对任意(any-to-any)的多模态语言模型——AnyGPT,它利用离散表示统一处理包括语音、文本、图像和音乐在内的各种模态。

论文链接:

https://arxiv.org/abs/2402.12226

12.DeepMind新研究:让大模型更快地从人类反馈中学习

Google DeepMind 提出了对机器人代码编写 LLMs 进行微调来记住它们在上下文中的交互,并提高它们的可教性——它们适应人类输入的效率(以用户认为任务成功之前的平均修正次数来衡量)。

论文链接:

https://arxiv.org/abs/2402.11450

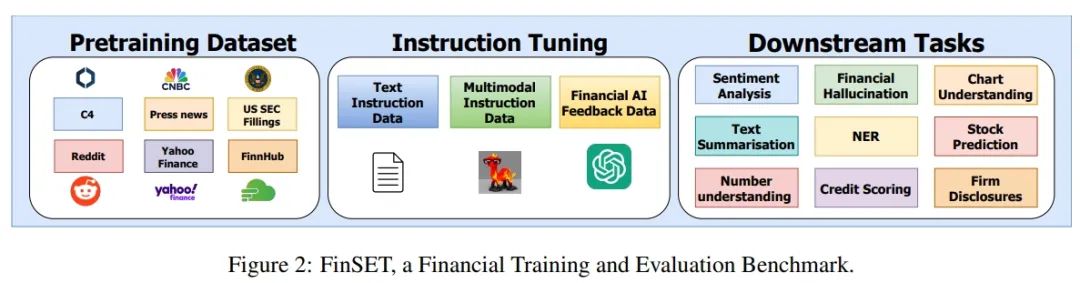

13.FinTral:GPT-4级金融多模态大模型

来自不列颠哥伦比亚大学和 Invertible AI 的研究团队提出了一套基于 Mistral-7b 模型构建的、为金融分析定制的最新多模态大型语言模型(LLMs)——FinTral。FinTral 模型采用先进的工具和检索方法进行直接偏好优化训练,显示出卓越的零样本性能,它在所有任务中的表现都优于 ChatGPT-3.5,并在九个任务中的五个任务中超过了 GPT-4。

论文链接:

https://arxiv.org/abs/2402.10986

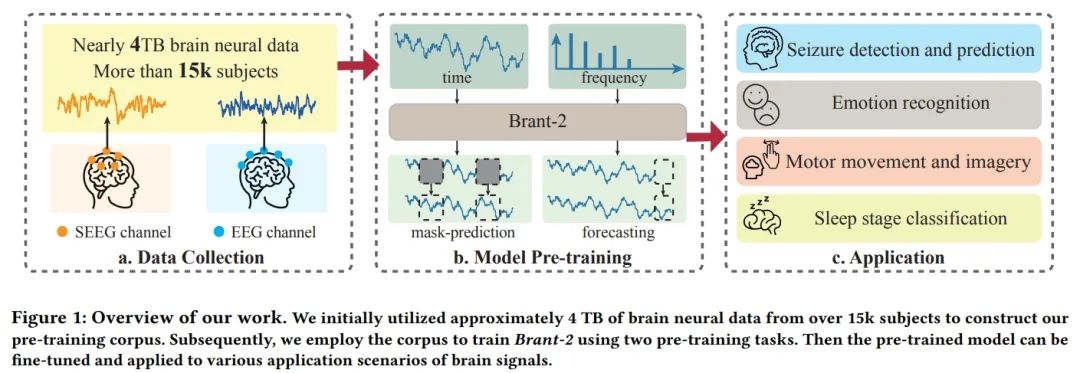

14.Brant-2:最大的脑信号领域基础模型

来自浙江大学的研究团队提出了脑信号领域最大的基础模型 Brant-2。与专为颅内神经信号设计的基础模型 Brant 相比,Brant-2 不仅对数据变化和建模规模具有鲁棒性,而且可以应用于更广泛的脑神经数据范围。

论文链接:

https://arxiv.org/abs/2402.10251

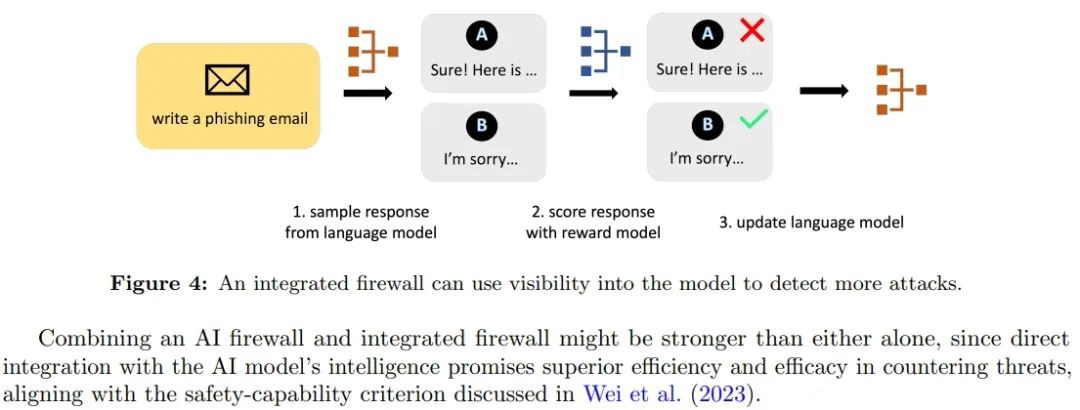

15.生成式人工智能安全:挑战与对策

生成式人工智能(Generative AI)在各行各业的应用范围不断扩大,这既让人兴奋,也增加了审查的难度。来自加州大学伯克利分校的研究团队深入探讨了生成式人工智能带来的独特安全挑战,并概述了管理这些风险的潜在研究方向。

论文链接:

https://arxiv.org/abs/2402.12617

|点击关注我 👇 记得标星|

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง