图源:MIT Technology Review。https://www.technologyreview.com/2019/04/29/135578/ai-researchers-want-to-study-ai-the-same-way-social-scientists-study-humans/

导语

集智俱乐部联合美国东北大学博士后研究员杨凯程、密歇根大学安娜堡分校博士候选人裴嘉欣,宾夕法尼亚大学沃顿商学院人力资本分析研究组博士后研究员吴雨桐、即将入职芝加哥大学心理学系的助理教授白雪纯子,共同发起「大语言模型与计算社会科学」读书会,于3月23日每周日晚上20:00-22:00探究大语言模型、生成式AI对计算社会科学领域带来的新思想新价值。

读书会背景

以大模型为代表的人工智能技术正在深刻地改变我们的社会和生活,从自动语法纠正,到虚拟伴侣,再到公共政策的决断,人工智能技术已经被广泛地应用到了我们生活的方方面面。在一次次被新的技术能力所惊艳的同时,我们也往往会自然而然地产生许许多多的问题。比如,大模型会像人一样思考吗?我们多大程度上可以信任AI生成的内容?AI会改变人们日常交流的方式吗?如果你在生活中有过类似的困惑,希望了解到更多关于人工智能与社会相关的前沿话题,又或者你是一个研究人员,希望了解到更多将人工智能和自己的研究方向结合的方式,欢迎参加本次读书会。我们会基于人工智能,心理学,传播学,管理学等多个学科的最新研究,和你一起去思考和探究这些和我们生活息息相关的问题。我们也许无法回答目前所有的问题,但是希望这个读书会可以成为一个引子,引领你去思考更多关于AI&Society相关的问题。

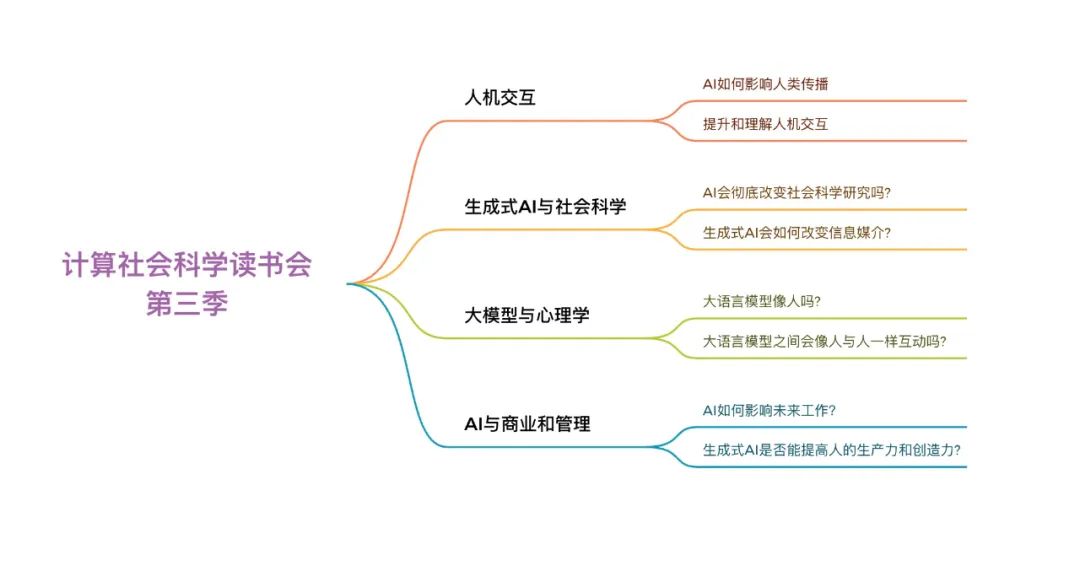

读书会框架和思维导图

在计算社会科学读书会第一季、第二季中,我们主要从计算社会科学的方法以及几个大的分支展开。过去一年中人工智能技术的蓬勃发展为计算社会科学研究带来了全新的问题,机遇和挑战。本次读书会就围绕人工智能技术和计算社会科学之间的交叉展开,涉及到传播学,心理学,管理学,计算机科学等多个学科。通过本次读书会的学习,我们希望你能够了解到关于人工智能和计算社会科学方面最前沿的研究话题,和其他志同道合的朋友进行深入的探索和交流,并且获得更多研究的思路和兴趣。

与复杂系统的关系

计算社会科学作为一个跨学科前沿领域,与复杂科学密切相关。它以社会经济复杂系统为主要研究对象,采用大数据、人工智能等综合方法来研究社会现象,并寻求从海量人类行为数据中挖掘模式,建立预测模型与理论。面对多层次(从个体到群体)、非线性、动态的社会系统,复杂科学提供了一系列研究方法,包括动力系统、网络分析、多主体建模等。而随着以大语言模型为代表的人工智能技术大幅提升,传统的复杂系统研究方法也正在快速革新,进一步推动计算社会科学领域的范式转换。

发起人团队介绍

裴嘉欣是密歇根大学安娜堡分校信息科学博士候选人,研究方向为计算社会科学和自然语言处理,致力于构建新的自然语言处理模型来分析大规模人类行为,相关成果发表于ACL, EMNLP, WWW等会议。个人主页:https://jiaxin-pei.github.io/。

裴嘉欣是密歇根大学安娜堡分校信息科学博士候选人,研究方向为计算社会科学和自然语言处理,致力于构建新的自然语言处理模型来分析大规模人类行为,相关成果发表于ACL, EMNLP, WWW等会议。个人主页:https://jiaxin-pei.github.io/。 吴雨桐是宾夕法尼亚大学沃顿商学院人力资本分析研究组博士后研究员。博士毕业于美国西北大学媒介、技术与社会项目。她目前的研究方向是远程工作和混合工作模式对团队、组织、以及劳动力市场的影响。个人主页:jasminewu.me。

吴雨桐是宾夕法尼亚大学沃顿商学院人力资本分析研究组博士后研究员。博士毕业于美国西北大学媒介、技术与社会项目。她目前的研究方向是远程工作和混合工作模式对团队、组织、以及劳动力市场的影响。个人主页:jasminewu.me。 白雪纯子是普林斯顿大学心理学系的博士候选人,同时隶属于公共与国际事务学院、认知科学项目以及统计与机器学习中心。她研究动态社会心智,即个体决策过程与社会现象在社会认知领域的相互作用。她当前的工作探索社会刻板印象的心理学起源。白雪纯子将于2024年7月加入芝加哥大学心理学系担任助理教授。个人主页:https://www.xuechunzibai.com/。

白雪纯子是普林斯顿大学心理学系的博士候选人,同时隶属于公共与国际事务学院、认知科学项目以及统计与机器学习中心。她研究动态社会心智,即个体决策过程与社会现象在社会认知领域的相互作用。她当前的工作探索社会刻板印象的心理学起源。白雪纯子将于2024年7月加入芝加哥大学心理学系担任助理教授。个人主页:https://www.xuechunzibai.com/。 杨凯程,美国东北大学博士后研究员,研究领域为计算社会科学,致力于解决社交媒体上的机器人和虚假信息传播问题,以及研究生成式人工智能在这些领域中的滥用和应用。研究成果曾被包括 CNN,BBC,The New York Times 在内的众多知名媒体报道。个人主页:https://www.kaichengyang.me。

杨凯程,美国东北大学博士后研究员,研究领域为计算社会科学,致力于解决社交媒体上的机器人和虚假信息传播问题,以及研究生成式人工智能在这些领域中的滥用和应用。研究成果曾被包括 CNN,BBC,The New York Times 在内的众多知名媒体报道。个人主页:https://www.kaichengyang.me。

本季读书会运营负责人介绍:

汪馨玥,密歇根州立大学硕士,兴趣领域:计算社会科学,媒介神经科学,复杂科学。个人主页:

https://xinyuewang.website/。

报名读书会

报名方式

- 第一步:扫码填写报名信息

扫码报名

扫码报名

- 第二步:填写信息后,付费299元。支付方式可选微信、支付宝两种。如需用支付宝支付,请在PC端进入读书会页面报名支付:https://pattern.swarma.org/study_group/40

- 第三步:添加负责人微信,拉入对应主题的读书会社区(微信群)。

本读书会可开发票,请联系相关负责人沟通详情。

本读书会适合参与的对象

- 跨学科研究者:那些在人工智能、心理学、传播学、管理学、计算机科学等领域工作或研究的学者和专业人士,对探索AI技术与社会科学相结合时的新问题、新机遇和新挑战充满热情。

- 科研工作者:一线的科研人员,特别是那些对探索人工智能(AI)与社会科学交叉应用感兴趣的学者。这包括但不限于研究人工智能在社会科学领域中的模型、方法以及其对社会行为、决策过程、经济模式、政策分析等方面的应用。科研工作者通过参与读书会,可以深化对AI在社会科学领域内的理解,并探讨如何将这些技术应用于自己的研究中,以解决社会科学问题,提高研究的效率和质量。

- 深度探讨者:对读书会讨论的主题和文献充满热情、愿意深入挖掘每一个话题的参与者。我们欢迎参与者贡献和分享有洞察力的文献、研究成果和创新的研究主题,希望通过与其他参与者的交流和讨论,共同发现新知识、新视角和新方法。

- 学术成长者:对于处于学术旅程任何阶段的参与者,可以通过参与读书会的讨论和活动,获取新的知识、技能和视角,拓宽学术视野,进行跨学科交流,与其他参与者共同成长。

本季读书会是一个为对AI与社会科学交叉领域感兴趣的人们提供的学习和交流平台,我们期待着每一位充满好奇心和探索精神的朋友的加入,共同探讨人工智能如何与社会科学相结合,共同成长。

本读书会谢绝参与的对象

为确保专业性和讨论的聚焦,本读书会谢绝脱离读书会主题和复杂科学的空泛的、哲学和思辨式讨论;不提倡过度引申在社会、人文、管理、政治、经济等应用层面的讨论。我们将对参与人员进行筛选,如果出现讨论内容不符合要求、经提醒无效者,会被移除群聊并对未参与部分退费。一切解释权归集智俱乐部所有。

运行模式

本季读书会涉及4个模块,按暂定框架贯次展开,也会根据实际情况进行调整;

每周进行线上会议,由 1-2 名读书会成员以PPT讲解的形式领读相关论文,与会者可以广泛参与讨论,会后可以获得视频回放持续学习。

举办时间

- 从 2024 年 3 月 23 日开始,北京每周六晚上 20:00-22:00,持续时间预计10 周。我们也会对每次分享的内容进行录制,剪辑后发布在集智斑图网站上,供读书会成员回看,因此报名的成员可以根据自己的时间自由安排学习时间。

- 自活动举办后任一时间均可加入,在活动结束后加入将无法享受直播权益,其他权益不变。

参与方式

此次读书会为线上闭门读书会,采用的会议软件是腾讯会议(请提前下载安装)。在扫码完成报名并添加负责人微信后,负责人会将您拉入交流社区(微信群),入群后告知具体的会议号码。

加入社区后可以获得的资源

- 在线会议室沉浸式讨论:与主讲人即时讨论交流

- 交互式播放器高效回看:快速定位主讲人提到的术语、论文、大纲、讨论等重要时间点

- 高质量的主题微信社群:硕博比例超过80%的成员微信社区,闭门夜谈和交流

- 超多学习资源随手可得:从不同尺度记录主题下的路径、词条、前沿解读、算法、学者等

- 参与社区内容共创任务:读书会笔记、百科词条、公众号文章、论文解读分享等不同难度共创任务,在学习中贡献,在付出中收获。

- 共享追踪主题前沿进展:在群内和公众号分享最新进展,领域论文速递

参与共创任务,共建学术社区

- 读书会笔记:在交互式播放器上记录术语和参考文献

- 集智百科词条:围绕读书会主题中重要且前沿的知识概念梳理成词条。例如:

-

论文解读分享:认领待读列表中的论文,以主题报告的形式在社区分享

-

论文摘要翻译:翻译社区推荐论文中的摘要和图注

-

公众号文章:以翻译整理或者原创生产形式生产公众号文章,以介绍前沿进展。例如:

– 大规模人群模拟:观察集体愚蠢与集体智慧 | 集智百科– 行为经济学:经济系统的行为主体是否理性?| 集智百科– 网络可控性:结构可控性与最大匹配 | 集智百科

-

论文翻译

– 诺奖之后的复杂科学:18位学者勾勒未来20年复杂系统研究图景

-

科普文章翻译

– 梅拉妮·米歇尔Science刊文:AI能否自主学习世界模型?

-

讲座整理

– AI何以涌现:复杂适应系统视角的ChatGPT和大语言模型

PS:具体参与方式可以加入读书会后查看对应的共创任务列表,领取任务,与运营负责人沟通详情,上述规则的最终解释权归集智俱乐部所有。

阅读材料

阅读材料较长,为了更好的阅读体验,建议您前往集智斑图沉浸式阅读,并可收藏感兴趣的论文。

读书会阅读清单

读书会阅读清单

Human-AI interaction

AI Help and influences human communications

-

Jess Hohenstein, Rene F. Kizilcec, Dominic DiFranzo, et al. Artificial intelligence in communication impacts language and social relationships. scientific reports, 2023, 13(1): 1-9.

这篇论文研究了人工智能对于人际交流的影响,为我们理解技术与社会互动之间的关系提供了有益的见解。本文有针对性地研究算法生成的回复建议(“智能回复”),发现使用这类算法回复可以提高人们的沟通效率、增加积极情感语言的使用,并且能够进一步提高对方对于谈话人的感知。。

-

Liu, R., Yen, H., Marjieh, R., Griffiths, T. L., & Krishna, R. (2023). Improving interpersonal communication by simulating audiences with language models. arXiv preprint arXiv:2311.00687.

这篇论文的核心问题是如何使用大语言模型来模拟不同听众从而改善人们之间的人际交流。论文的核心贡献在于提出了一种通过模拟听众来生成回复的方法,以增强沟通效率和改善人际感知。此外,该研究还为改进自然语言处理模型在人际沟通中的应用提供了有益的思路和启示。

Improving and understanding Human-AI interaction

-

Wu, T., Terry, M., & Cai, C. J. (2022, April). Ai chains: Transparent and controllable human-ai interaction by chaining large language model prompts. In Proceedings of the 2022 CHI conference on human factors in computing systems (pp. 1-22).

该论文提出了将大型语言模型(LLM)步骤串联起来的概念,以解决LLM在复杂任务中的局限性,并开发了交互式系统进行链式处理。研究表明,链式处理不仅提高了任务结果的质量,还增强了系统的透明度、可控性和合作感。

-

Xie, Yutong, et al. “A prompt log analysis of text-to-image generation systems.” Proceedings of the ACM Web Conference 2023. 2023.

该论文对大规模文本到图像生成系统的提示日志进行了首次全面分析,类似于对Web搜索引擎查询日志的分析,发现了用户信息需求的独特模式和行为差异,并提出了改进文本到图像生成系统的具体建议。

-

Zhou, K., Hwang, J. D., Ren, X., & Sap, M. (2024). Relying on the Unreliable: The Impact of Language Models’ Reluctance to Express Uncertainty.

该研究调查了语言模型如何通过自然语言表达其回复的不确定性以及用户对不确定性的反应,发现语言模型通常无法有效表达不确定性,用户也很难区分自信和不确定的回复,这突显了人工智能与人类交互中的安全问题,并提出了设计建议和缓解策略。

AI for Social Research

AI 会彻底改变社会科学研究吗?

以 ChatGPT 为代表的生成式 AI 为社会科学的研究带来了很多机遇和可能。在过去的一年多里,我们一方面能看到很多以 AI 代替研究对象或者研究工具的新尝试,另一方面来自学界的反对声也不绝于耳。本次读书会,我们将围绕这个主题阅读相关文献并展开讨论。

因为大语言模型能够如同人类一般进行交流,并对各种提问做出不同的回答,不少研究者开始探究用 AI 来替代传统社会科学研究中的研究对象的可能,并产生了不少积极的发现。另一方面也有不少学者基于各种原因对此种尝试表示反对。那么,计算社会科学学者是否应该顺应这一趋势,使用 AI 替代研究对象呢?如果答案是确定的,那么应该构造一个怎样的新范式呢?如果答案是否定的,那么理由是什么?下面是一些相关研究:

-

Ruoxi Xu, Yingfei Sun, Mengjie Ren, et al. AI for social science and social science of AI: A Survey. arXiv:2401.11839, 2024 https://arxiv.org/pdf/2401.11839.pdf

这是一篇综述性论文,探讨了人工智能(AI)与社会科学交叉领域的相关问题。通过将AI视为社会实体进行研究,以更好地理解AI在社会中的角色和影响,旨在探讨AI技术在社会科学研究中的应用,以及将AI作为社会实体进行研究的社会科学视角。

-

Argyle, L. P., Busby, E. C., Fulda, N., Gubler, J. R., Rytting, C., & Wingate, D. (2023). Out of one, many: Using language models to simulate human samples. Political Analysis, 31(3), 337-351. https://doi.org/10.1017/pan.2023.2

本文是使用生成式 AI 代替人类样本的代表性工作,并提出了“硅基样本”的概念。注意此工作开始于 ChatGPT 发布之前,所以使用了 GPT-3 模型。此外也推荐阅读 Kevin Munger 对此类研究的回应: I strongly feel that this is an insult to life itself (https://kevinmunger.substack.com/p/i-strongly-feel-that-this-is-an-insult)

-

Agnew, W., Bergman, A. S., Chien, J., Díaz, M., El-Sayed, S., Pittman, J., … & McKee, K. R. (2024). The illusion of artificial inclusion. arXiv preprint arXiv:2401.08572. https://arxiv.org/abs/2401.08572

本文回顾了现有文献中关于使用 AI 来代替研究中人类参与者的工作,列举讨论了这一方法的优点以及存在的问题。

-

Wang, A., Morgenstern, J., & Dickerson, J. P. (2024). Large language models cannot replace human participants because they cannot portray identity groups. arXiv preprint arXiv:2402.01908. https://arxiv.org/abs/2402.01908

这篇文章论证了大型语言模型无法替代人类参与者进行计算社会科学、用户测试、标注任务等领域的工作。

除了使用 AI 来替代研究对象以外,过去一年的另一大趋势是将大模型视作数据标注工具,进而替代人工。一方面,不少结果都显示大模型具备超出以往机器学习工具并接近人类的表现,另一方面,这一尝试也面对诸多挑战。那么,大模型给计算社会科学研究带来了怎样的新可能呢?学者们又该如何有效地使用这一强大的新工具呢?下面是一些相关研究:

-

Gilardi, F., Alizadeh, M., & Kubli, M. (2023). ChatGPT outperforms crowd-workers for text-annotation tasks. PNAS, 120 (30) e2305016120. https://doi.org/10.1073/pnas.2305016120

本文使用 ChatGPT 进行文本数据标注,并和 MTurk 的人工标注进行了对比,发现 ChatGPT 标注的结果更好并且费用更低。

- Pezeshkpour, P., & Hruschka, E. (2023). Large language models sensitivity to the order of options in multiple-choice questions. arXiv preprint arXiv:2308.11483. https://arxiv.org/abs/2308.11483本文发现大语言模型在回答多选题时,答案的顺序会影响结果。。

- Törnberg, P. (2024). Best Practices for Text Annotation with Large Language Models. arXiv preprint arXiv:2402.05129. https://arxiv.org/abs/2402.05129

本文从社会科学研究者的视角提供了一系列使用大语言模型进行文本数据标注的建议。

参考阅读:

-

Kim, J., & Lee, B. (2023). AI-Augmented Surveys: Leveraging Large Language Models for Opinion Prediction in Nationally Representative Surveys. arXiv preprint arXiv:2305.09620. https://arxiv.org/abs/2305.09620

-

Ziems, C., Held, W., Shaikh, O., Chen, J., Zhang, Z., & Yang, D. (2023). Can Large Language Models Transform Computational Social Science?. arXiv preprint arXiv:2305.03514. https://arxiv.org/abs/2305.03514

-

Tan, Z., Beigi, A., Wang, S., Guo, R., Bhattacharjee, A., Jiang, B., … & Liu, H. (2024). Large Language Models for Data Annotation: A Survey. arXiv preprint arXiv:2402.13446. https://arxiv.org/abs/2402.13446

-

Lin, H., Luo, Z., Wang, B., Yang, R., & Ma, J. (2024). GOAT-Bench: Safety Insights to Large Multimodal Models through Meme-Based Social Abuse. arXiv preprint arXiv:2401.01523. https://arxiv.org/abs/2401.01523

-

Tang, Y., Bi, J., Xu, S., Song, L., Liang, S., Wang, T., … & Xu, C. (2023). Video understanding with large language models: A survey. arXiv preprint arXiv:2312.17432. https://arxiv.org/abs/2312.17432

- Veselovsky, V., Ribeiro, M. H., Cozzolino, P., Gordon, A., Rothschild, D., & West, R. (2023). Prevalence and prevention of large language model use in crowd work. arXiv preprint arXiv:2310.15683. https://arxiv.org/abs/2310.15683

Kim, J., & Lee, B. (2023). AI-Augmented Surveys: Leveraging Large Language Models for Opinion Prediction in Nationally Representative Surveys. arXiv preprint arXiv:2305.09620. https://arxiv.org/abs/2305.09620

Ziems, C., Held, W., Shaikh, O., Chen, J., Zhang, Z., & Yang, D. (2023). Can Large Language Models Transform Computational Social Science?. arXiv preprint arXiv:2305.03514. https://arxiv.org/abs/2305.03514

Tan, Z., Beigi, A., Wang, S., Guo, R., Bhattacharjee, A., Jiang, B., … & Liu, H. (2024). Large Language Models for Data Annotation: A Survey. arXiv preprint arXiv:2402.13446. https://arxiv.org/abs/2402.13446

Lin, H., Luo, Z., Wang, B., Yang, R., & Ma, J. (2024). GOAT-Bench: Safety Insights to Large Multimodal Models through Meme-Based Social Abuse. arXiv preprint arXiv:2401.01523. https://arxiv.org/abs/2401.01523

Tang, Y., Bi, J., Xu, S., Song, L., Liang, S., Wang, T., … & Xu, C. (2023). Video understanding with large language models: A survey. arXiv preprint arXiv:2312.17432. https://arxiv.org/abs/2312.17432

生成式AI会如何改变信息媒介?

生成式 AI 的出现会从根本上改变人类的信息系统。本次读书会,我们将着眼于社交媒体和虚假信息传播问题,一起阅读相关文献,以便理解生成式 AI 技术已经带来的影响,并试图去展望信息媒介未来的发展方向。

相较于传统媒体(如电视、广播),社交媒体(如微博、Twitter)可以将个体直接连接,并形成一个巨大且复杂的社交网络,使得丰富的信息可以高速传播。此外,一些社交媒体平台也引入了诸如热搜(微博)和推荐信息流(抖音)等算法驱动的信息聚合机制,进一步影响着用户所能获取的信息。而生成式 AI 的出现可能会从各个角度对社交媒体进行改造。由于这些 AI 模型具备强大的内容生成能力,并可以根据用户的喜好进行有针对性的调整,其大范围应用和滥用可能会瓦解现有的社交网络。而最新的文献也表明生成式 AI 模型具备强大的信息总结和推荐能力,可能会进一步影响信息媒介系统中信息的分发。这里我们通过阅读一些相关文献来对此话题进行展望和讨论:

-

Ayers, J. W., Poliak, A., Dredze, M., Leas, E. C., Zhu, Z., Kelley, J. B., … & Smith, D. M. (2023). Comparing physician and artificial intelligence chatbot responses to patient questions posted to a public social media forum. JAMA internal medicine. https://doi.org/10.1001/jamainternmed.2023.1838

本文使用 ChatGPT 对社交媒体平台上的医疗问题进行回答,并将其结果与人类医生的回答进行对比,发现 ChatGPT 能够提供高质量的回答。

-

Yang, K. C., & Menczer, F. (2023). Anatomy of an AI-powered malicious social botnet. arXiv preprint arXiv:2307.16336. https://arxiv.org/abs/2307.16336

本文分析研究了首例由 ChatGPT 驱动的恶意社交机器人账号网络。

-

Liu, D., Yang, B., Du, H., Greene, D., Lawlor, A., Dong, R., & Li, I. (2023). RecPrompt: A Prompt Tuning Framework for News Recommendation Using Large Language Models. arXiv preprint arXiv:2312.10463. https://arxiv.org/abs/2312.10463

本文提供了一个使用大语言模型进行新闻推荐的框架。

大语言模型的出现也为虚假信息传播问题带来了新的挑战和机遇。一方面,恶意份子可以使用这些工具快速、大量地生成高质量的虚假信息,而这一可能性给很多国家的群众带来了极大的焦虑。另一方面,最近的研究也指出大语言模型可以被用来识别这些信息并进行辟谣,可能会成为我们对抗虚假信息问题的新工具。这里我们通过阅读相关文献来从不同角度对这一问题进行探讨:

-

Giovanni Spitale et al., AI model GPT-3 (dis)informs us better than humans.Sci. Adv.9,eadh1850(2023). https://doi.org/10.1126/sciadv.adh1850

本文通过实验的方式发现 GPT-3 模型可以生成可信的虚假信息。

-

Hanley, H. W., & Durumeric, Z. (2023). Machine-Made Media: Monitoring the Mobilization of Machine-Generated Articles on Misinformation and Mainstream News Websites. arXiv preprint arXiv:2305.09820. https://arxiv.org/abs/2305.09820

本文通过对大量新闻网站内容的分析发现,AI 生成的内容尤其是虚假信息的数量在 ChatGPT 发布以后增长迅速。

-

Simon, F. M., Altay, S., & Mercier, H. (2023). Misinformation reloaded? Fears about the impact of generative AI on misinformation are overblown. Harvard Kennedy School Misinformation Review, 4(5). https://misinforeview.hks.harvard.edu/article/misinformation-reloaded-fears-about-the-impact-of-generative-ai-on-misinformation-are-overblown/

本文试图论证人们可能过分担心生成式 AI 对于虚假信息问题带来的影响。

-

DeVerna, M. R., Yan, H. Y., Yang, K. C., & Menczer, F. (2023). Fact-checking information generated by a large language model can decrease news discernment.. arXiv preprint arXiv:2308.10800. https://arxiv.org/abs/2308.10800

本文通过实验的方式测试了 ChatGPT 作为辟谣工具的效果,发现其虽然能在很大程度上识别出虚假信息,但对于实验参与者的影响并不总是正面的。

参考阅读:

-

Hosseinmardi, H., Ghasemian, A., Rivera-Lanas, M., Horta Ribeiro, M., West, R., & Watts, D. J. (2024). Causally estimating the effect of YouTube’s recommender system using counterfactual bots. Proceedings of the National Academy of Sciences, 121(8), e2313377121. https://doi.org/10.1073/pnas.2313377121

-

Yang, K. C., Singh, D., & Menczer, F. (2024). Characteristics and prevalence of fake social media profiles with AI-generated faces. arXiv preprint arXiv:2401.02627. https://arxiv.org/abs/2401.02627

-

Maples, B., Cerit, M., Vishwanath, A., & Pea, R. (2024). Loneliness and suicide mitigation for students using GPT3-enabled chatbots. npj Mental Health Research, 3(1), 4. https://doi.org/10.1038/s44184-023-00047-6

-

Goldstein, J. A., Chao, J., Grossman, S., Stamos, A., & Tomz, M. (2024). How persuasive is AI-generated propaganda?. PNAS nexus, 3(2), pgae034. https://doi.org/10.1093/pnasnexus/pgae034

-

Quelle, D., & Bovet, A. (2023). The perils & promises of fact-checking with large language models. arXiv preprint arXiv:2310.13549. https://arxiv.org/abs/2310.13549

-

Augenstein, I., Baldwin, T., Cha, M., Chakraborty, T., Ciampaglia, G. L., Corney, D., … & Zagni, G. (2023). Factuality challenges in the era of large language models. arXiv preprint arXiv:2310.05189. https://arxiv.org/abs/2310.05189

-

Chen, C., & Shu, K. (2023). Combating misinformation in the age of llms: Opportunities and challenges. arXiv preprint arXiv:2311.05656. https://arxiv.org/abs/2311.05656

大规模与心理学

大语言模型像人吗?

-

Marcel Binz, Eric Schulz. Using cognitive psychology to understand GPT-3. Proceedings of the National Academy of Sciences of the United States of America, 2022, 120

本文用多种经典认知心理学的实验方法对比GPT-3的行为和人类行为。

-

Ishita Dasgupta, Andrew Kyle Lampinen, Stephanie C. Y. Chan, et al. Language models show human-like content effects on reasoning. arXiv.org, 2022, abs/2207.07051

本文用认知科学的逻辑推理实验对比大语言模型和人类的推理能力。

-

Xuechunzi Bai, Angelina Wang, Ilia Sucholutsky, et al. Measuring Implicit Bias in Explicitly Unbiased Large Language Models. arXiv:2402.04105, 2024

本文用社会认知学的内隐偏见实验方法对比大语言模型和人类的隐形歧视。

-

Theodore R. Sumers, Shunyu Yao, Karthik Narasimhan, et al. Cognitive Architectures for Language Agents. arXiv:2309.02427, 2023

本文用人类认知发展史启发设计大语言模型代理的认知构架。

-

R. Thomas McCoy, Shunyu Yao, Dan Friedman, et al. Embers of Autoregression: Understanding Large Language Models Through the Problem They are Trained to Solve. arXiv:2309.13638, 2023

本文通过大语言模型被训练解决的自回归任务和行为实验揭示其工作原理。

大语言模型之间会像人与人一样互动吗?

-

Joon Sung Park, Joseph C. O Brien, Carrie J. Cai, et al. Generative Agents Interactive Simulacra of Human Behavior. arXiv:2304.03442, 2023

看25个大语言模型智能体在虚拟小镇如何互动。

-

Yun-Shiuan Chuang, Agam Goyal, Nikunj Harlalka, et al. Simulating Opinion Dynamics with Networks of LLM-based Agents. arXiv:2311.09618, 2023

大语言模型的意见动力学,多个大语言模型如何交流传播信息。

-

Papachristou, M., & Yuan, Y. (2024). Network Formation and Dynamics Among Multi-LLMs. arXiv preprint arXiv:2402.10659.

大语言模型在不同社会网络中的行为。

-

Ari Holtzman, Peter West, Luke Zettlemoyer. Generative Models as a Complex Systems Science: How can we make sense of large language model behavior?. arXiv.org, 2023, abs/2308.00189

大语言模型在复杂系统下的一些思考。

-

Zixian Ma, Rose Wang, Li Fei-Fei, et al. ELIGN: Expectation Alignment as a Multi-Agent Intrinsic Reward. arXiv:2210.04365, 2022

如何让分布式智能体有效协作:对齐期望模型。

-

Mitchell L. Gordon, Michelle S. Lam, J. Park, et al. Jury Learning: Integrating Dissenting Voices into Machine Learning Models. International Conference on Human Factors in Computing Systems, 2022

如何有效提取多个智能体的多样化观点:陪审团学习模型。

AI and Business/Management

AI 能否提供生产力?

-

ChatGPT one year on: who is using it, how and why? https://www.nature.com/articles/d41586-023-03798-6

一年来,谁在用Chatgpt? 怎么用?如何用?

-

Automation Augmentation Paradox: Raisch, S., & Krakowski, S. (2021). Artificial intelligence and management: The automation–augmentation paradox. Academy of management review, 46(1), 192-210.

技术往往替代那些重复性高、机械性强的任务,而这反过来又增加了对人们在更复杂、更创造性工作中的参与需求。这个论断在AI时代是否适用?

-

Supplementary reading: Agrawal, A., Gans, J. S., & Goldfarb, A. (2023). Do we want less automation?. Science, 381(6654), 155-158.

我们想要更少的自动化吗?

行业聚焦:人力资源、生物药企和平台组织

AI in Human Resource Management:

-

Tambe, P., Cappelli, P., & Yakubovich, V. (2019). Artificial intelligence in human resources management: Challenges and a path forward. California Management Review, 61(4), 15-42.

这篇综述文章讨论了AI在人力资源管理各个环节应用的挑战

-

Li, D., Raymond, L. R., & Bergman, P. (2020). Hiring as exploration (No. w27736). National Bureau of Economic Research.

招人算法中的偏见,如何改进?

AI in Biotech Firms

-

Lou, B., Wu, L., (2021). AI on Drugs: Can Artificial Intelligence Accelerate Drug Development? Evidence from a Large-Scale Examination of Bio-Pharma Firms. MIS Quarterly, 45(3), 1451–1482.https://doi.org/10.25300/MISQ/2021/16565

本文揭示了生物医药公司中开发和改进AI工具是一个需要AI和领域专家在开发和操作阶段共同合作的迭代过程。

-

Tranchero, M. (2023). Finding Diamonds in the Rough: Data-Driven Opportunities and Pharmaceutical Innovation. Working Paper.

本文发现尽管数据驱动的预测可以帮助公司识别创新机会,但这种方法产生的大量假阳性预测导致了资源误投。

AI in Platform Organizations

-

Gregory, R. W., Henfridsson, O., Kaganer, E., & Kyriakou, H. (2021). The role of artificial intelligence and data network effects for creating user value. Academy of management review, 46(3), 534-551.

AI在平台经济中能否撬动网络效应?

生成式AI是否能提高人的生产力和创造力?

-

Dell’Acqua, F., McFowland, E., Mollick, E. R., Lifshitz-Assaf, H., Kellogg, K., Rajendran, S., Krayer, L., Candelon, F., & Lakhani, K. R. (2023). Navigating the Jagged Technological Frontier: Field Experimental Evidence of the Effects of AI on Knowledge Worker Productivity and Quality. SSRN Electronic Journal.https://doi.org/10.2139/ssrn.4573321

本文鼓励我们超越采用或不采用AI的二元决策,而是评估在知识工作流程中,不同的人类与AI配置和组合的价值。

-

Brynjolfsson, E., Li, D., & Raymond, L. R. (2023). Generative AI at work (No. w31161). National Bureau of Economic Research.

本文通过研究接入大模型工具到客服人员的工作中提高问题解决效率,尤其是对新手和低技能工作者效率的提升,而对经验丰富和高技能工作者的影响则微乎其微。

-

Noy, S., & Zhang, W. (2023). Experimental evidence on the productivity effects of generative artificial intelligence. Available at SSRN 4375283.

生成式AI的使用减少了员工间生产力的不平等吗?

-

Wiles, E., & Horton, J. J. (2023). The Impact of AI Writing Assistance on Job Posts and the Supply of Jobs on an Online Labor Market. Working paper.

这项研究通过在在线劳动市场上进行的随机实验来研究使用大型语言模型生成工作岗位广告初稿对雇主行为和招聘效果的影响。

-

Zhou, E., & Lee, D. (2023). Generative AI, human creativity, and art. SSRN Electronic Journal.

生成式AI能否提高人的创造力?

关于集智俱乐部读书会和主办方

集智俱乐部读书会是面向广大科研工作者的系列论文研读活动,其目的是共同深入学习探讨某个科学议题,了解前沿进展,激发科研灵感,促进科研合作,降低科研门槛。读书会活动始于 2008 年,至今已经有 50 余个主题,内容涵盖复杂系统、人工智能、脑与意识、生命科学、因果科学、高阶网络等。凝聚了众多优秀科研工作者,促进了科研合作发表论文,孵化了许多科研产品。如:2013 年的“深度学习”读书会孕育了彩云天气 APP,2015 年的“集体注意力流”读书会产生了众包书籍《走近2050》,2020年的开始因果科学读书会孕育了全国最大的因果科学社区等。主办方:集智俱乐部协办方:集智学园集智俱乐部成立于 2003 年,是一个从事学术研究、享受科学乐趣的探索者的团体,也是国内最早的研究人工智能、复杂系统的科学社区。它倡导以平等开放的态度、科学实证的精神,进行跨学科的研究与交流,力图搭建一个中国的 “没有围墙的研究所”。集智学园成立于2016年,是集智俱乐部孕育的创业团队。集智学园致力于传播复杂性科学、人工智能等前沿知识和新兴技术,促进、推动复杂科学领域的知识探索与生态构建。

加入VIP,解锁集智课程&读书会

集智长期深耕复杂系统与跨学科研究,在网络科学、系统理论、混沌科学等经典领域持续策划精品课程,同时也追踪因果科学、深度学习、复杂经济学、生命复杂性、社会计算、AI+Science、大模型、神经科学、城市科学等交叉前沿。汇集了大量的探索者,包括教授、硕博、工程师、创业者等等。

为了帮助有学习需求的朋友夯实学科基础,帮有科研需求的朋友深入前沿交流,我们开放了1年制和2年制的集智学园VIP计划。VIP用户可以深度参与集智俱乐部社区,并在会员期内解锁集智学园全站课程权限。

更多关于VIP介绍,请点击查看:加入集智学园VIP,一次性获取集智平台所有内容资源

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง