关键词:图神经网络,图卷机网络

论文题目:Homophily modulates double descent generalization in graph convolution networks论文期刊:PNAS

论文链接:https://www.pnas.org/doi/10.1073/pnas.2309504121

图神经网络 (GNN) 最近在天气预报、预测颗粒材料中的力或理解生物分子等各种问题上取得了令人印象深刻的成果。它们已经成为具有关系信息的数据集事实上的机器学习模型,例如蛋白质图中的交互或社交网络中的友谊。这些成功案例引发了一波针对更多样、更强大图网络架构的研究浪潮,例如图卷积神经网络(GCN)。但截止目前,研究这些网络为何以及如何实现强大性能(包括其泛化能力)的理论工作还较少。

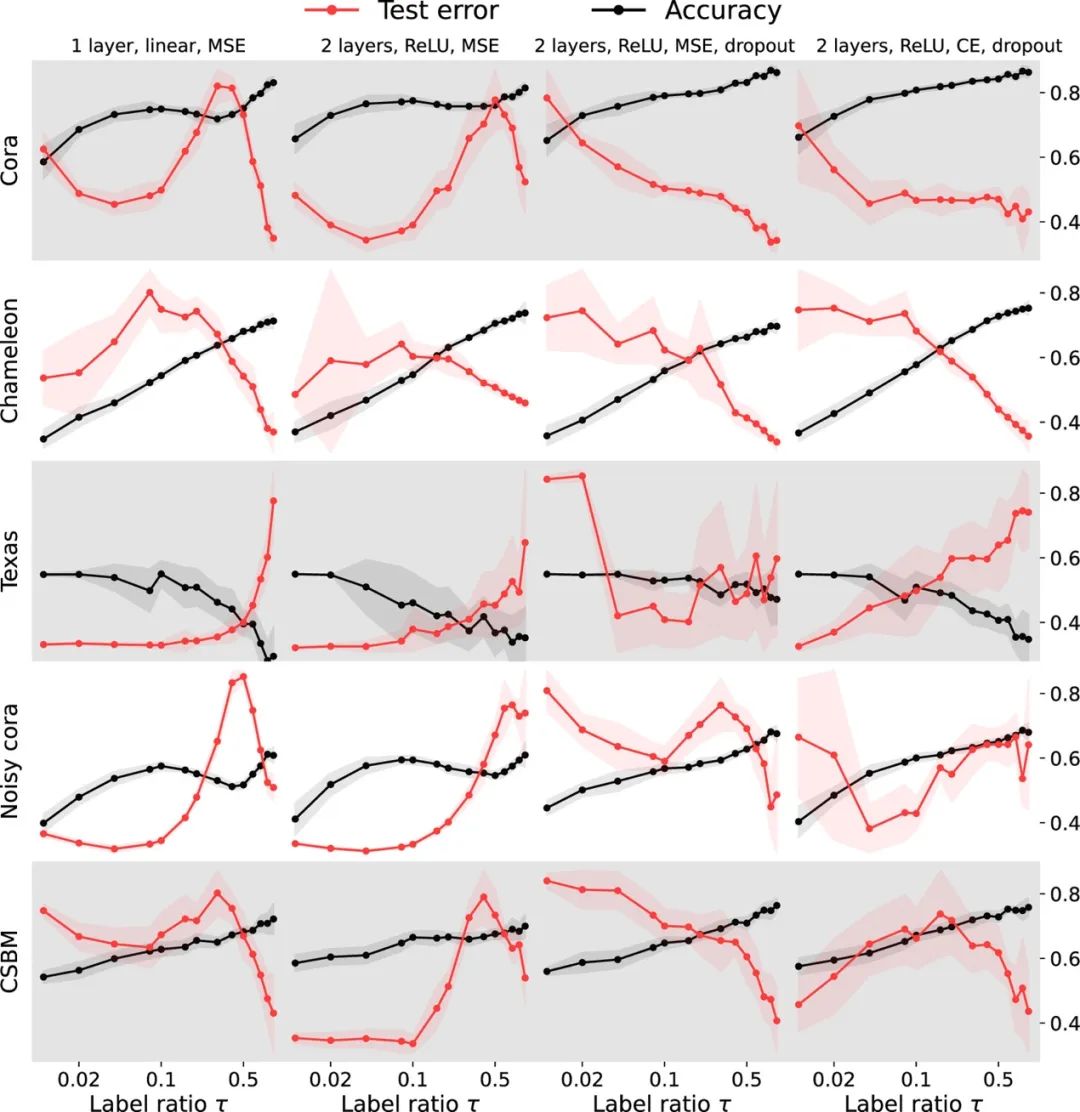

在机器学习模型的双重下降现象中,当模型复杂度超过数据点数时,在达到峰值之后错误率会再次下降——形成第二个“U形”曲线。最新发表于PNAS的研究,研究者通过实验观察到的“传导性”双重下降现象,使用统计物理学和随机矩阵理论的分析工具,精确地描述了在上下文随机块模型上,简单图卷积网络的泛化。

研究结果揭示了在同质性与异质性数据上学习的细微差别,并预测了图网络中存在双重下降的现象。通过分析图噪声、特征噪声和训练标签数量之间的相互作用,该研究展示了风险是如何被塑形的。这些发现不仅适用于风格化模型,还能捕捉到真实世界和数据集中的定性趋势。利用本文分析,可以进一步提高异质数据集上图卷积网络模型的性能。

图1 在具有不同噪声水平的数据集上,针对不同图神经网络架构、不同损失(有或没有显式正则化)的双下降泛化。任务为节点分类,红色为测试误差,黑色为测试准确性。

编译|刘培源

图神经网络与组合优化读书会

详情请见:加速经典算法效率,突破现实技术瓶颈:图神经网络与组合优化读书会启动

详情请见:加速经典算法效率,突破现实技术瓶颈:图神经网络与组合优化读书会启动

推荐阅读1. sc-GCN:使用图卷积网络进行单细胞组学数据的知识迁移2. 图卷积网络集成多组学数据分类新算法——MOGONET3. 深度学习新星 | 图卷积神经网络(GCN)有多强大?4. 张江:第三代人工智能技术基础——从可微分编程到因果推理 | 集智学园全新课程5. 龙年大运起,学习正当时!解锁集智全站内容,开启新年学习计划6. 加入集智,一起复杂!

点击“阅读原文”,报名读书会

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง