Datawhale论文

来源:WhalePaper,负责人:芙蕖

WhalePaper简介

由Datawhale团队成员发起,对目前学术论文中比较成熟的 Topic 和开源方案进行分享,通过一起阅读、分享论文学习的方式帮助大家更好地“高效+全面+自律”学习,让大家都有所收获和提升!方向包括自然语言处理(NLP)、计算机视觉(CV)、推荐(Res)等相关方向的论文解读和分享,后续将融入更多的方向。开源地址:https://datawhalechina.github.io/whale-paper

本期活动

论文详情

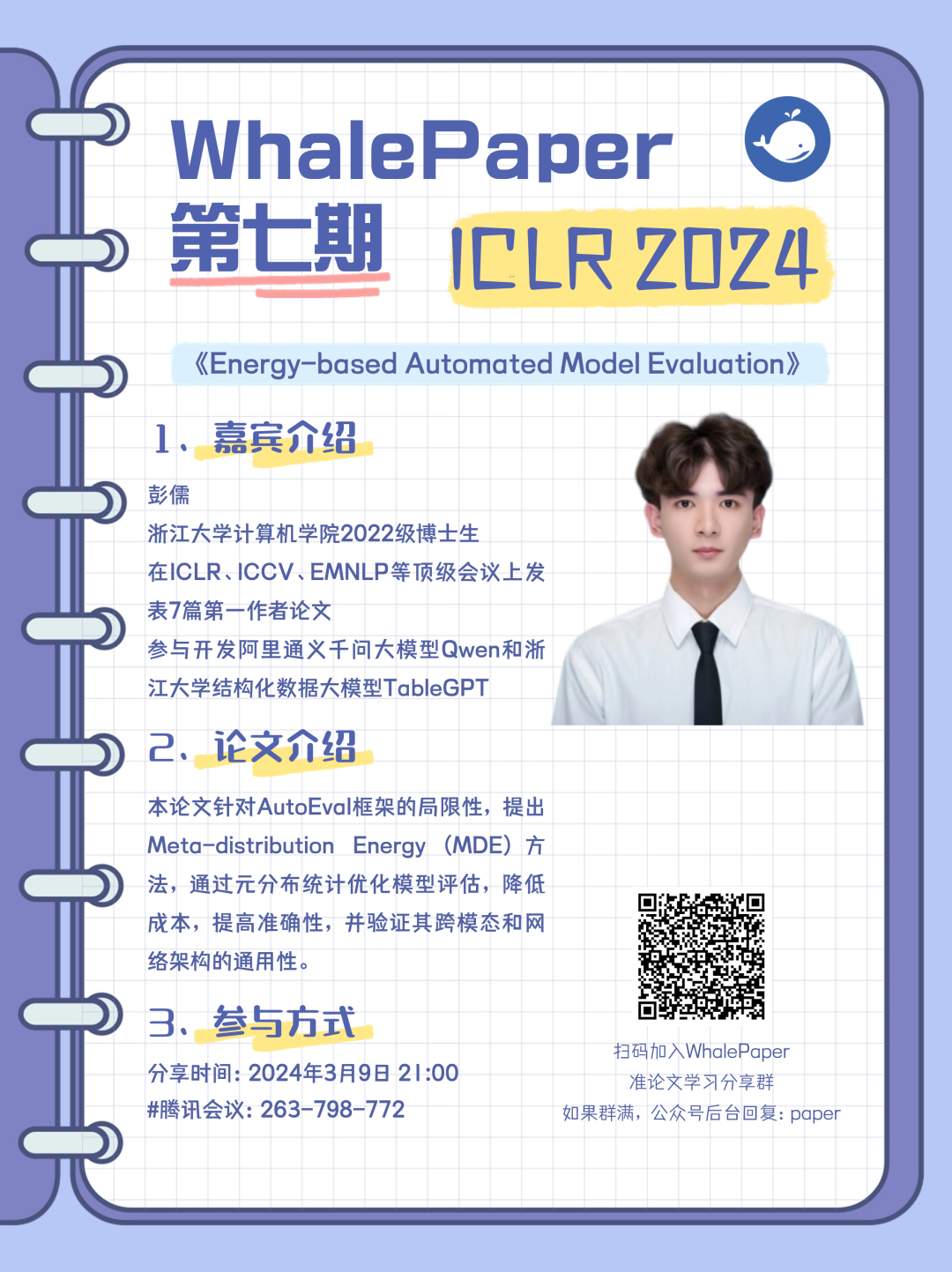

论文题目:Energy-based Automated Model Evaluation

会议介绍:ICLR自2013年起至今已成功举办12届,被公认为人工智能领域的顶级会议之一。该会议由“深度学习三大巨头”中的 Yoshua Bengio 和 Yann LeCun 共同创立,发布人工智能、机器视觉、计算生物学、数据科学、多模态处理、游戏设计和机器人等领域的最新论文和成果。会议投稿始于2023年9月15日,摘要注册截止于9月24日,而完整论文的提交截止日期为9月29日。经历严格的评审后,大会组委会于2023年11月10日公布了论文的接收结果。此次会议投稿量高达7300多篇,创历史新高,其中有2250篇论文被接收,接收率为30.8%。

论文简介:机器学习模型的传统评估协议严重依赖于带标签的、独立同分布假设的测试数据集,而这在实际应用中并不常见。自动模型评估(AutoEval)展示了一种替代传统工作流的方法,通过形成一个近似预测流程来预测模型性能,而无需实际的标签。尽管 AutoEval 框架最近取得了成功,但仍然存在过度自信、存储需求大和计算成本高的问题。对此,我们提出了一种新颖的措施—— Meta-distribution Energy (MDE) ,它使 AutoEval 框架更加高效和有效。MDE 的核心是针对与各个样本相关的信息(能量分数)建立元分布统计,然后通过基于能量的学习提供更平滑的表示。我们通过将 MDE 与分类损失联系起来,进一步提供我们的理论见解。我们提供了跨模态、数据集和不同网络架构的广泛实验,以验证 MDE 的有效性以及与先前方法相比的优越性。我们还通过展示 MDE 与大型模型的无缝集成以及轻松适应带有噪声或不平衡标签的学习场景来展示 MDE 的通用性。

论文地址:论文原文

代码地址:github地址

参与链接:腾讯会议

作者解读:知乎专栏

参与方式

扫码加入WhalePaper群

若群满请在公众号后台回复“paper”

WhalePaper负责人联系方式:

芙蕖(微信号:MePhyllis)

华挥(微信号:BuShouY)

一起“点赞”三连↓

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง