关键词:强化学习,移动操作,泛化抓取

导 读

本文是对发表于 ICRA 2024 的论文 GAMMA: Graspability-Aware Mobile MAnipulation Policy Learning based on Online Grasping Pose Fusion 的解读。该论文由北京大学王鹤团队与智源人工智能研究院和银河通用机器人合作完成,第一作者是北大博士生张嘉曌,共同一作是银河通用实习生 Nandiraju Gireesh,通讯作者为王鹤。

本文提出了一种具有可抓取性先验的移动操作算法 GAMMA。该算法通过在线预测和融合可抓取位姿,获得了时序上一致的可抓取性位姿,并基于此构建了针对移动操作的强化学习观测和奖励机制。最终,GAMMA 在模拟环境和真实世界中均展现了出色的抓取表现。

← 扫码跳转论文

论文地址:

https://arxiv.org/abs/2309.15459

项目主页:

https://pku-epic.github.io/GAMMA

01

背 景

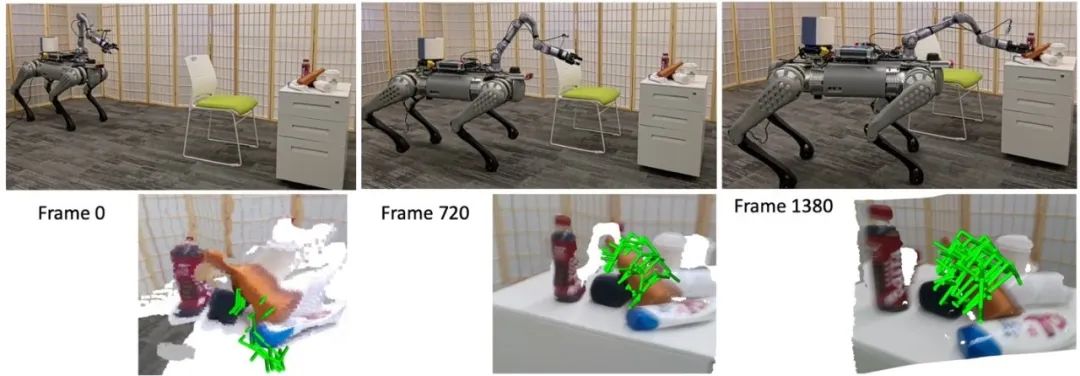

自主移动操作机器人是具身智能领域中的关键问题,具有广泛的应用场景如物流、建筑业和家庭服务。其中我们的工作考虑一个具有挑战性的泛化任务: 让机器人在未见场景中,抓取给定的目标物体。由于环境的未知性,机器人必须在线的移动并规划自己的路径和抓取位姿。即在获取输入后的短时间内计算下一步的动作,实现一个连续的移动抓取序列动作(见图1)。

图1. 真实世界的抓取和抓取位姿的可视化

许多现有的工作通过结合 3D 重建和场景几何分析与运动规划来解决这个问题。然而,这些方法通常需要巨大的计算成本来建模场景几何,并需要为特定的机器人设计启发式的策略[1]。近些年来,基于强化学习(RL)的方法由于其易于实现和高效性而获得了越来越多的关注。这一类的工作通过建模目标物体的可观测性[2]或可到达性[3],从而驱动机器人观察并接近目标对象。

我们的工作通过引入可抓取性的观测和奖励用于强化学习,进一步提升了移动操作算法的能力,实现了更加鲁棒和泛化的移动抓取策略。

02

可抓取性引导下的移动操作策略

我们的任务是给定一个目标物体的位置,机器人需要高效地接近目标物体并最终抓取目标物体。我们的机器人由移动底座,机械臂和平行夹抓(parallel grippe)组成,其中我们在机械臂的末端和移动底座的前端都安装了 RGBD 相机,用来获取场景的深度信息。在整个移动操作过程中,我们的策略需要在线地控制底盘、机械臂和末端夹抓,以确保在整个移动操作过程中的协同工作,从而实现有效的目标抓取。

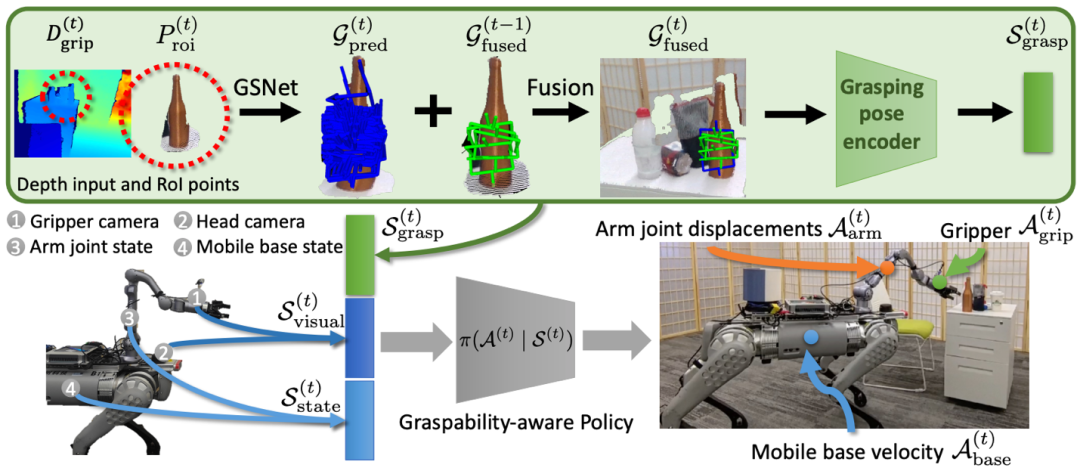

图2. 算法流程图

为了实现这个目标,我们构建了基于可抓取性引导的强化学习移动抓取策略。我们的策略利用了三种观测:视觉输入(RGB 和深度图)、状态输入(底座速度和关节的角度,夹抓开合状态)以及抓取输入(可抓取位姿的集合)。每种输入都通过一个专门的编码器(encoder)转换为隐式的状态表示(observation state),这些状态表示随后被用作强化学习的观测。策略的输出动作则是移动底座的速度,机械臂各个关节的转动变化量和夹抓的开闭状态。同时,为了引导策略更有效地执行高质量的移动抓取,我们设计了一个基于可抓取位姿的奖励机制,鼓励机器人在观测目标物体的同时调整其位置和姿态,以逐渐接近一个可抓取的位姿,最终实现观测与抓取的有效协同。

我们的策略的核心要素是高质量可抓取位姿的获取。为此,我们引入了一个在线抓取位姿融合模块(Online Grasping Fusion Module),以获得高质量的可抓取位姿(见图3)。

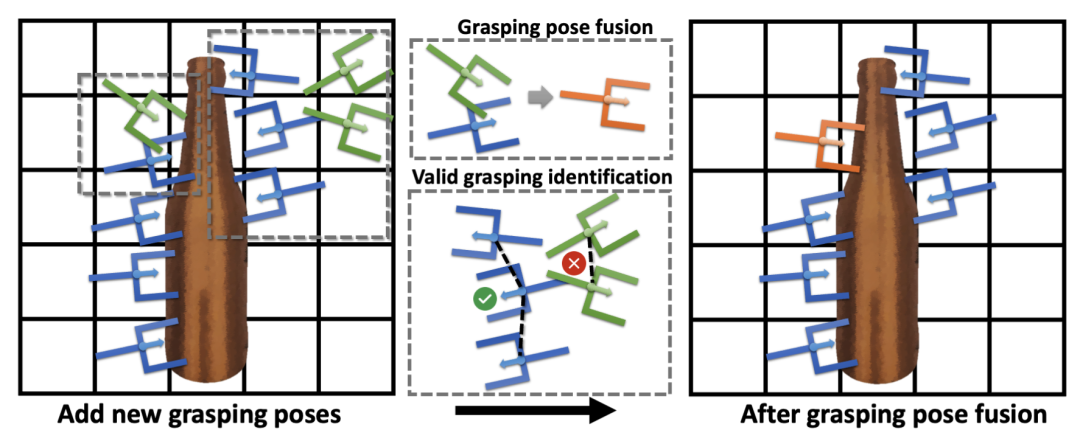

图3. 在线的抓取位姿融合模块

首先,算法利用 GSNet[4]逐帧的预测大量目标物体的候选抓取位姿。然而,由于单帧视角观测的局限性(例如遮挡),候选抓取位姿存在大量的错误和冗余。为了解决这个问题,抓取位姿融合模块将逐帧预测的候选抓取位姿按其所在的空间位置填入网格中。这种方法使我们能够快速索引到临近的抓取位姿,并实现以下操作:

a)将新添加的抓取位姿与已有的抓取位姿进行加权平均,其中权重由 GSNet 预测的评分决定;

b)移除离群的抓取位姿,即从网格中删除孤立的抓取位姿。最终实现了时序上一致的抓取位姿的观测。一个完整的融合过程参考图4。

图4. 在线抓取位姿融合可视化

03

训练和试验结果

由于我们的算法不对机器人的结构和场景做具体的假设,因此它可以应用于各种不同的机器人和场景。在训练过程中,我们使用了两种不同的模拟器:Habitat 和 Isaac Gym,并考虑了两种设计不同的机器人,即 Unitree B1+Z1 和 Fetch robot。

图5. 训练过程

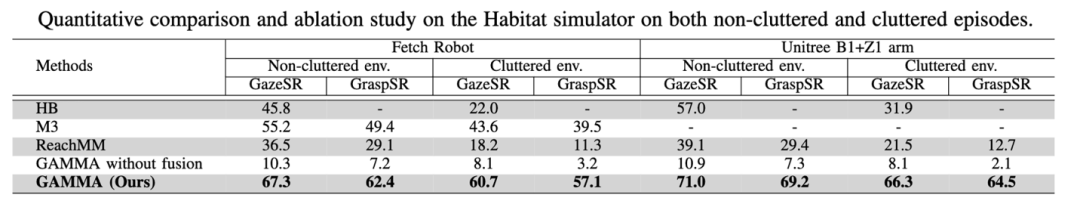

我们在 Habitat 上评估了我们的方法与当前主流方法(见下表),覆盖了不同的机器人、场景和评估指标。结果显示,我们的方法在提高抓取成功率和鲁棒性方面取得了显著进步。特别是在 GazeSR(可见即成功)和 GraspSR(可抓即成功)这两个指标上,我们的方法均实现了较高的成功率。实验结果表明可抓取性感知算法具有更强的鲁棒性和泛化能力。

我们也提供了更多的真实抓取的实验结果:

(每次抓取后会将机器人控制远离目标再开始下次抓取)

参考文献

[1] Garrett, Caelan Reed, et al. “Online replanning in belief space for partially observable task and motion problems.” IEEE ICRA 2020.

[2] Watkins-Valls, David, et al. “Mobile manipulation leveraging multiple views.” IEEE/RSJ IROS 2022.

[3] Jauhri, Snehal, Jan Peters, and Georgia Chalvatzaki. “Robot learning of mobile manipulation with reachability behavior priors.” IEEE Robotics and Automation Letters 7.3 (2022).

[4] Wang, Chenxi, et al. “Graspness discovery in clutters for fast and accurate grasp detection.” IEEE/CVF ICCV 2021.

图文 | 张嘉曌

Embodied Perception and InteraCtion (EPIC)

具身感知与交互实验室

Embodied Perception and InteraCtion Lab

北京大学具身感知与交互实验室 EPIC Lab(Embodied Perception and InteraCtion Lab)由王鹤博士于2021年在北京大学创立。该实验室立足三维视觉感知与机器人学,重点关注机器人具身在三维复杂环境中的交互和涉及的感知问题,研究目标是以可扩增的方式发展可泛化的机器人视觉系统和物体操控策略。

Embodied Perception and InteraCtion (EPIC) Lab is found by Dr. He Wang at Peking University in 2021, where research revolves around 3D vision and robotics with special focus on embodied AI. The mission is to endow robots working in complex real-world scenes with generalizable 3D vision and interaction policies in a scalable way.

实验室 PI 简介:王鹤 助理教授

EPIC近期动态

— 版权声明 —

本微信公众号所有内容,由北京大学前沿计算研究中心微信自身创作、收集的文字、图片和音视频资料,版权属北京大学前沿计算研究中心微信所有;从公开渠道收集、整理及授权转载的文字、图片和音视频资料,版权属原作者。本公众号内容原作者如不愿意在本号刊登内容,请及时通知本号,予以删除。

点击“阅读原文”转论文地址

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง