今天为大家介绍的是来自Bryan Hooi团队的一篇论文。近年来,文本属性图(TAGs)上的表示学习已成为一个关键的研究问题。一个典型的TAG例子是论文引用图,其中每篇论文的文本作为节点属性。大多数图神经网络(GNN)流程通过将这些文本属性转换成浅层或手工制作的特征来处理。近期的努力集中在使用语言模型增强这些流程。随着强大的大型语言模型(LLMs)如GPT的出现,这些模型展现了推理能力和利用通用知识的能力,因此需要技术将LLMs的文本建模能力与GNNs的结构学习能力结合起来。在这项工作中,作者专注于利用LLMs捕获文本信息作为特征,这些特征可以用来提升GNN在下游任务上的表现。

在现实世界中,许多图都具有文本属性,这些图可以被称为文本属性图(TAGs)。在TAGs中,节点代表文本实体,如文档或句子,边代表它们之间的关系。例如,ogbn-arxiv数据集就是一个表示引用网络的TAG,每个节点代表一篇论文,节点属性包括标题和摘要。更一般地,文本属性和图拓扑的结合为增强重要应用上的表示学习提供了丰富的信息源,如文本分类、推荐系统、社交网络和假新闻检测等。

先前的研究探索了多种在TAGs上进行表示学习的方法。标准的GNN流程首先使用诸如跳跃模型或词袋(BoW)这样的浅层或手工制作的特征对每个节点的文本属性进行编码。然后,这些节点特征被用作GNN的输入。然而,这些浅层文本嵌入在捕获复杂语义特征的能力上有限,与基于语言模型(LMs)的方法相比较差。最近的工作因此集中在设计基于LM的流程以更好地捕获TAGs中文本的上下文和细微差别。在这种方法中,预训练的LMs被微调并用于生成针对特定TAG任务量身定做的节点嵌入。基于LM的流程在ogbn-arxiv和ogbn-products上的节点分类任务中达到了最先进的结果。然而,由于可伸缩性的原因,现有工作只依赖于相对较小的LMs,如BERT和DeBERTa,这些模型适合在单个GPU上运行,因此缺乏更大语言模型的复杂推理能力。如GPT这样的大型预训练模型的发展彻底改变了语言建模。LLMs在许多自然语言处理(NLP)任务上取得了明显的改进,并使得复杂和零样本推理等先进的语言处理能力成为可能。规模定律揭示了模型和训练数据大小对性能改进的可预测规则。尽管LLMs在包括计算机视觉在内的其他领域取得了成功,但它们对TAG任务的潜在好处尚未被探索,这使得它成为未来研究的一个令人兴奋和有前景的领域。因此,作者希望在这项工作中探索它。

在这篇论文中,作者明确区分了“LMs”(语言模型)和“LLMs”(大型语言模型)。“LMs”指那些相对较小的语言模型,这些模型可以在学术实验室的预算下进行训练和调整。“LLM”则指那些能够学习复杂模式的非常大型语言模型,比如GPT-3/4。这些模型通常拥有数十亿或数百亿的参数,需要大量的计算资源进行训练和使用。最近LLMs的大小和复杂性引起了关于它们可扩展性的担忧,因为它们可能过于庞大,以至于连在学术研究实验室的机器上运行推理都困难。为了解决这个问题,LLMs通常通过语言模型即服务(LMaaS)提供,这使得开发者能够在不需要大量计算资源或专业知识的情况下使用LLMs。作者的目标是以一种与LMaaS兼容的方式从LLM中提取信息。因此/不需要对LLM进行微调或提取其logits,而只需要其文本形式的输出。与此相反现有基于LM的流程并不直接与LLMs兼容,因为它们需要微调LMs,并且需要访问它们的潜在嵌入或logits,而GPT-3.5和4并不提供这些。

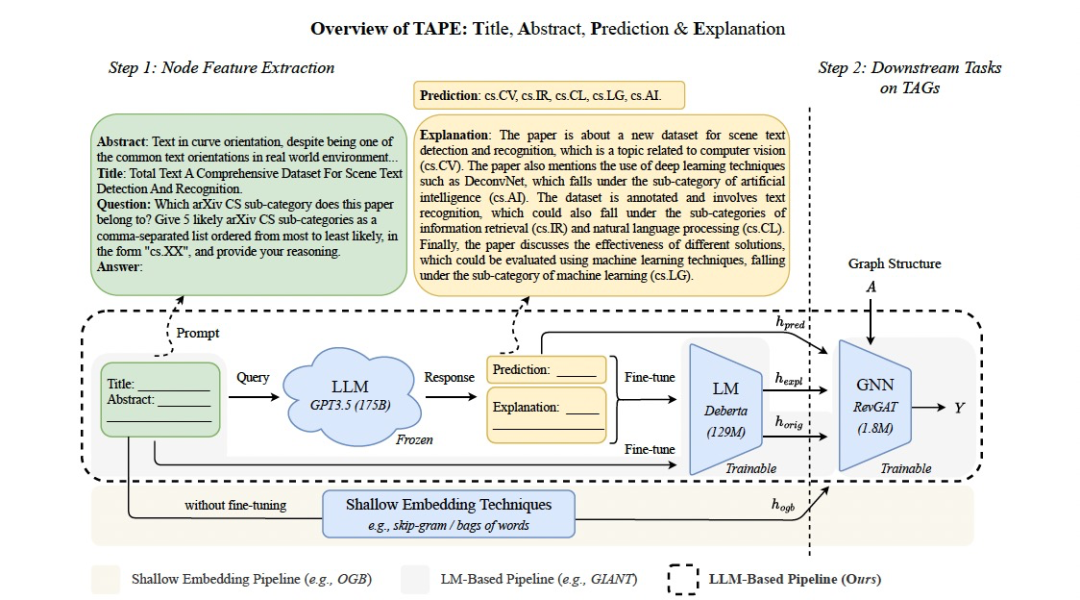

图 1

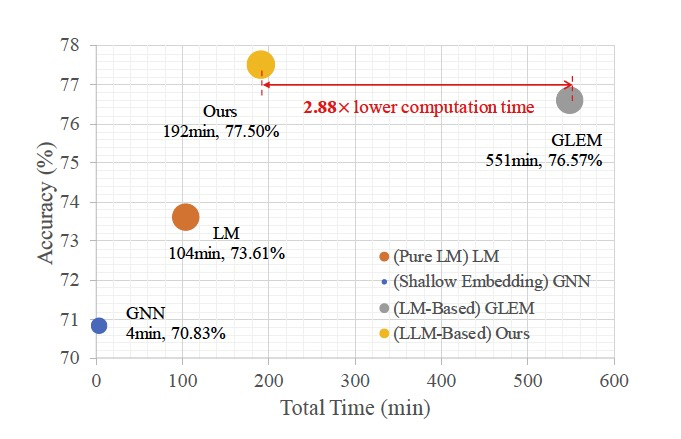

图 2

为了研究LLMs在提高TAG嵌入质量方面的潜力,作者进行了初步研究,评估了GPT-3.5在ogbn-arxiv上的零样本分类性能。作者使用了一个包含arXiv论文的标题和摘要以及一个问题的特定任务提示,这在ogbn-arxiv上取得了73.5%的高零样本准确率,超过了许多完全训练的GNN基线,包括使用OGB特征的RevGAT(准确率为70.8%),并提供了高质量和连贯的文本解释,但没有达到76.6%的最先进准确率。因此作者提出了一个框架,利用LLMs生成高质量的TAG节点特征。作者的一个关键创新是使用解释作为特征:使用LLM推理APIs生成解释,然后将这些解释转化为TAGs的信息丰富特征。为了说明这一点,请观察图1中的解释(黄色框),它突出并扩展了文本中的关键有用信息,以及文本识别与信息检索之间的关系,这得益于LLM的通用知识。这表明这些解释作为丰富的特征可以增强TAG流程的下游阶段。具体来说,作者开发了一个自定义提示,查询LLMs生成一个排名预测列表和其预测的文本解释,这些被随后的较小LM如DeBERTa转化为丰富的节点特征,可用于训练任何下游GNN,这里这里考虑节点分类任务。图2展示了作者的方法在ogbn-arxiv数据集上不仅优于浅层嵌入流程和基于LM的流程,而且计算时间比GLEM基线低了2.88倍。这表明通过利用LLMs生成的解释作为特征的方法,不仅可以提高性能,同时也大大提高了计算效率。这一发现突出了结合大型语言模型在文本属性图任务中的潜力,为未来的研究和应用提供了有价值的指导。

方法部分

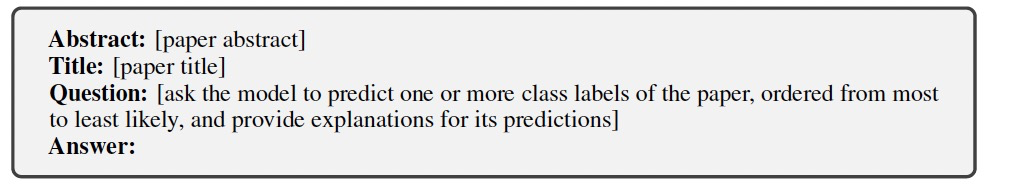

如图1所示,作者关键思想是LLM的解释作为下游GNN的信息丰富特征。为此方法包含三个主要步骤:1)使用自定义提示查询LLM,以生成排名预测列表和对其预测的文本解释;2)在原始文本和辅助文本属性上微调LM,并将它们转换为节点特征;3)在丰富的特征上训练GNN。作者的想法是以一种“开放式”的方式查询LLM,即指导它进行多重预测并解释其决策,以更有效地引出其学习到的特征和通用知识的文本形式,然后可以将其转换为下游GNN的信息丰富节点特征。基于这个动机,对于每个论文节点i生成一个包括论文标题和摘要以及关于论文主题的开放式问题的提示。提示问题的具体措辞是根据任务和数据集量身定制的:

查询LLM结果在每篇论文上产生一个排名预测列表和文本解释:

作者使用这些预测和解释作为下游LM和GNN模型的额外文本属性。作者首先将原始文本(即标题和摘要)和LLM的解释转换为固定长度的节点特征,供下游GNN使用。该方法是微调一个较小的LM,以“解释”LLM的文本解释。这样做的理由是LLM和LM各有所长:LLM更强大,拥有更多知识,而LM小到足以进行微调。因此,LM用来“解释”LLM的输出,文本解释作为一种有效的中间媒介进行沟通。然后,微调LM使其能够学习从解释中提取最有用和任务相关的特征。

实验结果

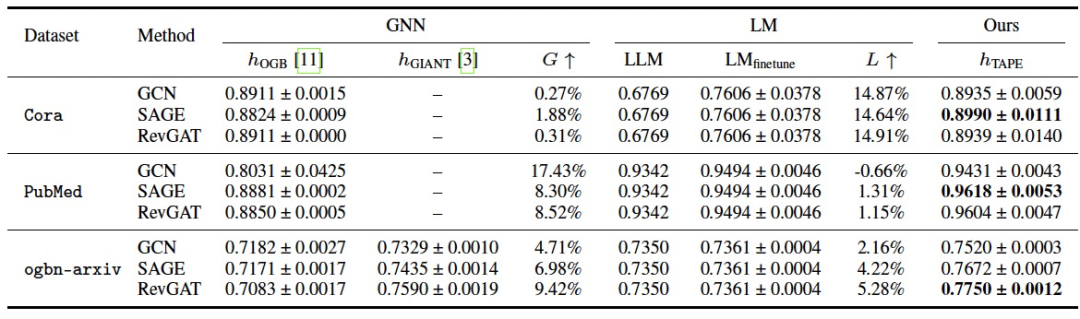

作者在三个文本属性图(TAG)数据集上评估了基于LLM的流程——Cora、PubMed和ogbn-arxiv。由于Cora和PubMed的原始文本数据在常见的图库如PyG和DGL中不可用,作者收集并发布了这两个图的TAG数据集,以便于未来的研究。作者与基于GNN和LM的方法进行了比较,并在表1中报告了结果。关于GNNs,作者选择了三种广泛使用的架构:GCN、GraphSAGE和RevGAT。对于每种GNN,作者尝试了不同种类的节点特征,包括1) OGB特征(表示为hOGB),2) GIANT特征(表示为hGIANT),以及3) 作者提出的特征hTAPE = {horig, hexpl, hpred}。对于LMs,作者尝试了两种方法:1)微调DeBERTa(表示为LMfinetune),以及2) 使用与作者方法相同的提示的零样本ChatGPT(gpt-3.5-turbo)(表示为LLM)。

表 1

作者的方法在两个数据集和所有下游模型上都取得了最好的结果。值得注意的是,作者的模型在ogbn-arxiv上以显著的优势实现了最佳性能,以及在广泛使用的PubMed和Cora基准的TAG版本上也实现了最佳性能。关于基于GNN的方法,作者观察到浅层特征(即hOGB)的性能不佳。然而,通过加入基于LM的特征(即hGIANT),可以观察到性能有所提高。作者提出的利用LLM的特征进一步增强了结果。在LM的情况下,可以发现微调的LMs(即LMfinetune)达到了有竞争力的结果,强调了在TAG设置中文本属性的重要性。此外可以观察到零样本LLM表现良好,与微调的LMs表现相当。

编译 | 曾全晨

审稿 | 王建民

参考资料

He, X., Bresson, X., Laurent, T., & Hooi, B. (2023). Explanations as Features: LLM-Based Features for Text-Attributed Graphs. arXiv preprint arXiv:2305.19523.

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง