报告主题:高效参数微调:从LoRA到 DoRA报告日期:3月19日 14:30-15:30

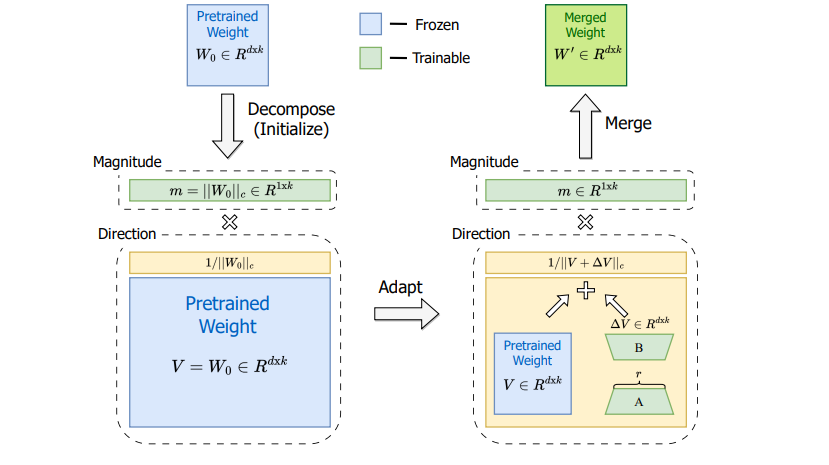

报告主题:高效参数微调:从LoRA到 DoRA报告日期:3月19日 14:30-15:30 主题简介:在广泛使用的参数高效参数微调(PEFT)方法中,由于避免了额外的推理成本,LoRA及其变体因此成为了目前主流的方法。然而,这些方法与完整微调(FT-Full FineTuning)之间通常仍存在精确度的差异。在这项工作中,我们首先引入了一种新颖的权重分解分析方法,以研究FT和LoRA之间在训练中学习行为的固有差异。为了从这些发现中模仿FT的学习能力,我们提出了一种名为权重分解低秩适应(DoRA)的方法。DoRA将预训练权重分解为两个部分,即幅度和方向用于微调,并使用LoRA进行方向的更新,以有效地减少可训练参数的数量。通过使用DoRA,我们增强了LoRA的学习能力和训练稳定性,同时避免了任何额外的推理开销。在各种下游任务(如常识推理、视觉指令微调和图像/视频-文本理解)中,DoRA在微调LLaMA、LLaVA和VL-BART上始终优于LoRA。 论文主页: https://arxiv.org/abs/2402.09353GitHub主页:https://github.com/nbasyl/DoRA报告嘉宾:

主题简介:在广泛使用的参数高效参数微调(PEFT)方法中,由于避免了额外的推理成本,LoRA及其变体因此成为了目前主流的方法。然而,这些方法与完整微调(FT-Full FineTuning)之间通常仍存在精确度的差异。在这项工作中,我们首先引入了一种新颖的权重分解分析方法,以研究FT和LoRA之间在训练中学习行为的固有差异。为了从这些发现中模仿FT的学习能力,我们提出了一种名为权重分解低秩适应(DoRA)的方法。DoRA将预训练权重分解为两个部分,即幅度和方向用于微调,并使用LoRA进行方向的更新,以有效地减少可训练参数的数量。通过使用DoRA,我们增强了LoRA的学习能力和训练稳定性,同时避免了任何额外的推理开销。在各种下游任务(如常识推理、视觉指令微调和图像/视频-文本理解)中,DoRA在微调LLaMA、LLaVA和VL-BART上始终优于LoRA。 论文主页: https://arxiv.org/abs/2402.09353GitHub主页:https://github.com/nbasyl/DoRA报告嘉宾:刘诗扬,香港科技大学计算机系博士生,主要研究方向包括量化模型和高效模型。扫描下方二维码

或点击「阅读原文」报名

或点击「阅读原文」报名

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง