关键词:视觉语言导航,大模型,具身智能

导 读

本文是对发表于 ICRA 2024 的论文 Discuss Before Moving: Visual Language Navigation via Multi-expert Discussions 的解读。该论文由北京大学董豪超平面实验室完成,第一作者为访问学生龙宇星。

本文提出一种零样本的视觉语言导航框架 DiscussNav,基于大模型构建多个领域专家,在每一步导航决策前以指令理解,环境感知,完成估计和决策检验为话题开展多专家讨论,有效提升模型在视觉语言导航任务上的表现,实现视觉语言导航在真实世界中的落地。

← 扫码跳转论文

论文链接:

https://arxiv.org/abs/2309.11382

项目主页:

https://sites.google.com/view/discussnav

项目视频:

01

概 览

视觉语言导航(Visual Language Navigation)是家庭服务场景中机器人需要具备的一项基础能力,该任务向机器人下达自然语言形式的导航指令,要求机器人根据指令导航到指定终点。视觉语言导航要求机器人具备一系列具身技能,包括指令理解,环境感知,完成估计和决策检验,这些关键技能需要不同领域知识,它们环环相扣决定机器人的导航能力。

现有方法都依赖一个模型在单一轮次进行导航感知和决策。然而,目前即使是最先进的大模型 GPT-4,也仍然在单一轮次完成复杂多任务上表现欠佳,这在很大程度上限制了视觉语言导航机器人的能力。

为了克服这类方法的问题,本文提出了一个零样本视觉语言导航框架 DiscussNav。在这个框架中,基于拥有不同能力的大型模型建立领域专家,导航 Agent 在每一步导航行动前都主动与这些领域专家进行讨论并收集必要的信息由此完成导航决策。多方面实验证明,多专家讨论可以有效提升视觉语言导航任务的表现,减小从仿真到真机部署的难度。

02

基于多专家讨论的导航感知与决策

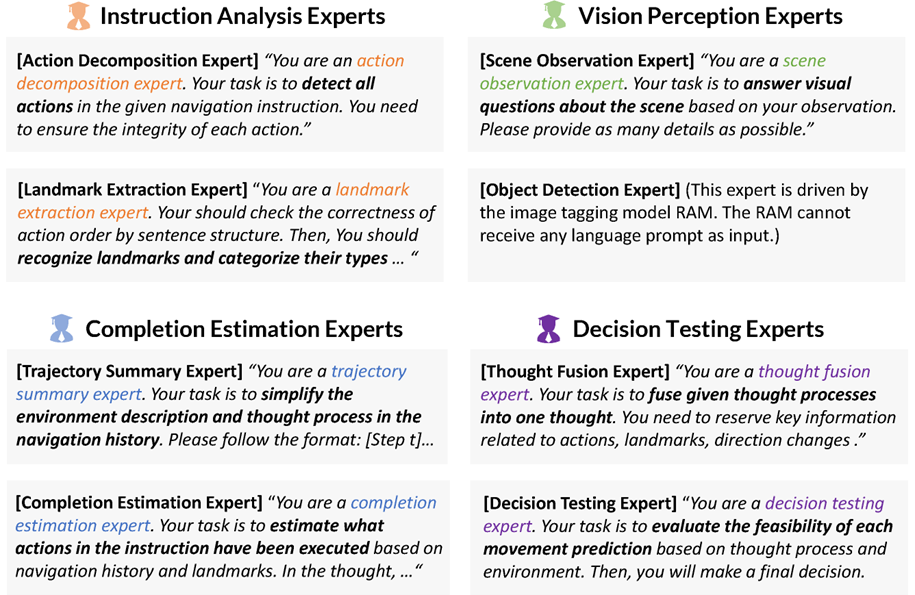

受到现实中专家讨论行为的启发,本文提出 DiscussNav 导航系统。首先以提示方式赋予 LLM(大语言模型)和 MLM(多模态大模型)专家角色和特定任务,激活它们的领域知识和能力,由此构建具备不同特长的视觉导航专家团队。

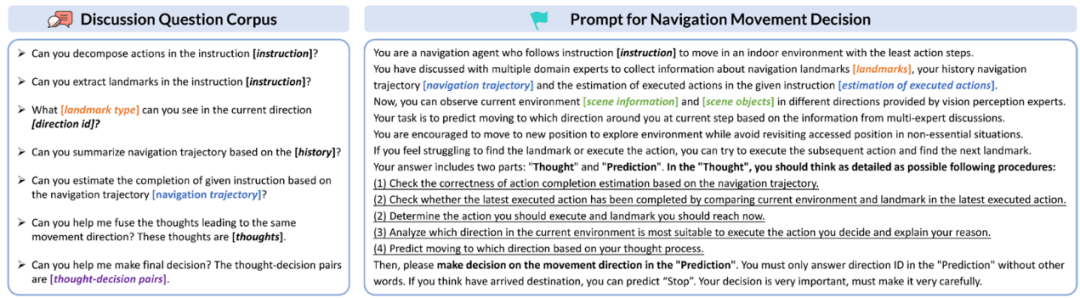

然后,本文设计了讨论问题语料库和讨论机制,遵循该机制,由 LLM 驱动的导航机器人可以主动发起一系列与视觉导航专家的讨论。

在每一步移动前,导航机器人都会与专家讨论来理解人类指令中要求的动作和提及的物体标志,进而依据这些物体标志的类型有倾向性地对周围环境进行感知,指令完成情况估计,由此做出初步的移动决策。在决策过程中,导航机器人会根据 Chain-of-Thought(思维链)同时生成 N 个独立的预测结果,当这些预测结果之间不一致时,机器人会向决策测试专家求助,筛选出最终的移动决策。

相比传统方法需要进行额外的预训练,DiscussNav 方法通过与大模型专家交互指导机器人根据人类指令移动,直接解决了机器人导航训练数据稀缺的问题。更进一步,正是由于这个特点,它也实现了零样本能力,只要遵循以上讨论流程,就能 follow 多样的导航指令。

03

实验结果

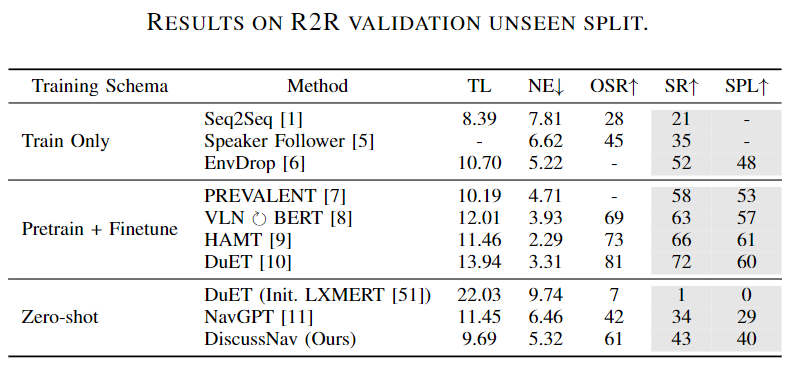

视觉语言导航实验是在 Matterport3DSimulator 仿真器中基于 Room2Room 数据集进行评测。实验结果表明没有经过任何导航任务训练的 DiscussNav 方法显著优于所有零样本方法,甚至超过两个经过训练的方法 Seq2Seq 和 Speaker Follower。

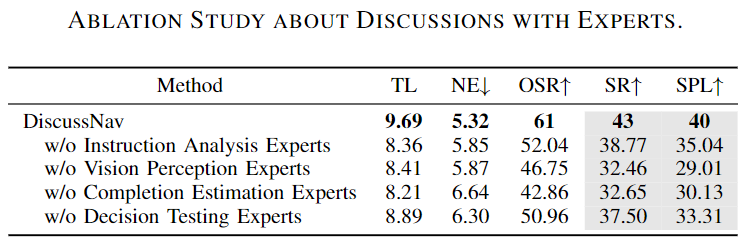

为了验证不同的专家对于 DiscussNav 方法的决策影响,此处在相同的数据集和平台中进行消融实验分析。根据实验结果,在决策过程分别去除4种不同的专家都会导致 DiscussNav 方法的导航成功率下降,由此证明本文设计的4种不同的专家对于导航过程中的决策都有贡献性。

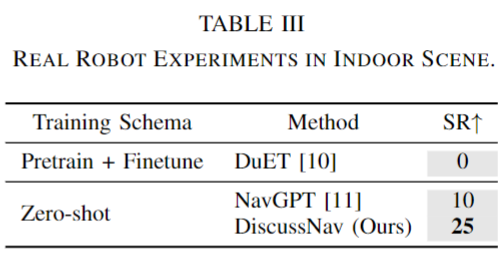

进一步在 Turtlebot4 移动机器人上开展真实室内场景导航实验,凭借专家角色扮演和讨论激发出的大模型强大的语言和视觉泛化能力,DiscussNav 在真实世界的表现明显优于之前最优的零样本方法和经过预训练微调的方法,展现出良好的 Sim-to-Real 迁移能力。

一些 DiscussNav 成功完成视觉语言导航任务的示例如下所示:

指令1:

“Walk into the arched hallway near the native American paintings on the wall. Walk past the doorway to the laundry room and down the hall past the candles on the wall. Continue to the open arched entry at the end of the hall.”

指令2:

“Once at the top of the stairs, turn left and walk towards the first doorway. Enter the first doorway and walk towards the bed. Once at the foot of the bed, turn left and walk through the door. You should now be standing in front of a sink and mirror.”

指令3:

“Walk forward across the room and walk through the panty followed by the kitchen. Stand at the end of the kitchen.”

超平面实验室

Hyperplane Lab

超平面实验室隶属北京大学前沿计算研究中心,由董豪老师带领,其研究方向主要涉及计算机视觉、智能机器人、具身智能和开源 AI 软件。实验室目前的研究方向包括:机器人泛化操纵、导航及具身大模型等;研究旨在打造机器人型号无关、自主决策的通用具身智能系统,以加速机器人普适化。

实验室 PI 简介:董豪 助理教授

实验室相关新闻:#PKU Hyperplane

扫码浏览实验室主页

https://zsdonghao.github.io/

图文 | 龙宇星

Hyperplane Lab

Hyperplane近期科研动态

— 版权声明 —

本微信公众号所有内容,由北京大学前沿计算研究中心微信自身创作、收集的文字、图片和音视频资料,版权属北京大学前沿计算研究中心微信所有;从公开渠道收集、整理及授权转载的文字、图片和音视频资料,版权属原作者。本公众号内容原作者如不愿意在本号刊登内容,请及时通知本号,予以删除。

点击“阅读原文”转论文地址

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง