新智元报道

编辑:桃子 好困

【新智元导读】AI世界的进化快的有点跟不上了。刚刚,全球最强最大AI芯片WSE-3发布,4万亿晶体管5nm工艺制程。更厉害的是,WSE-3打造的单个超算可训出24万亿参数模型,相当于GPT-4/Gemini的十倍大。

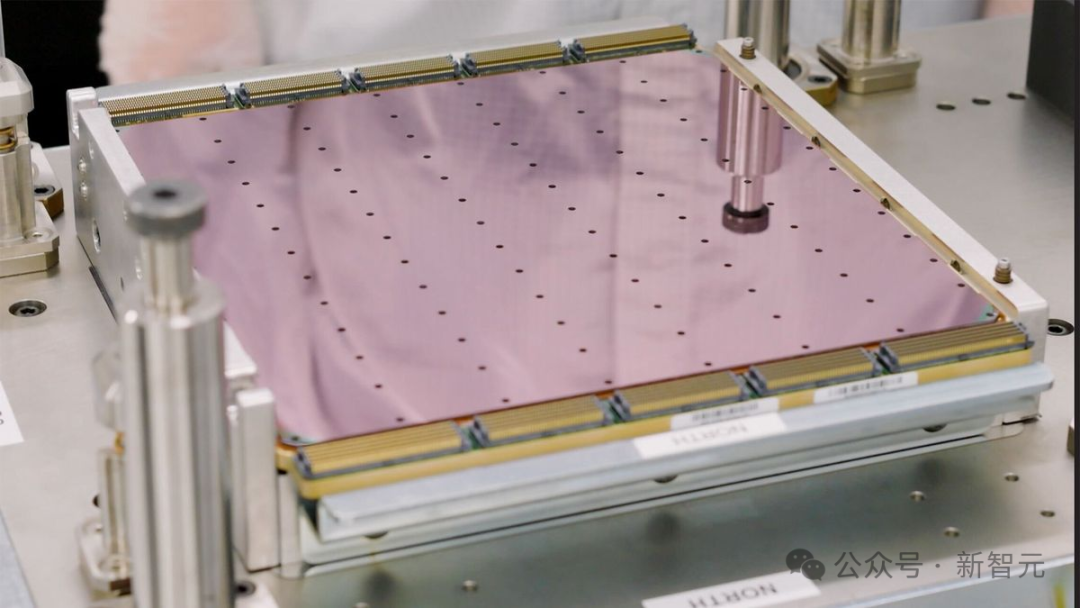

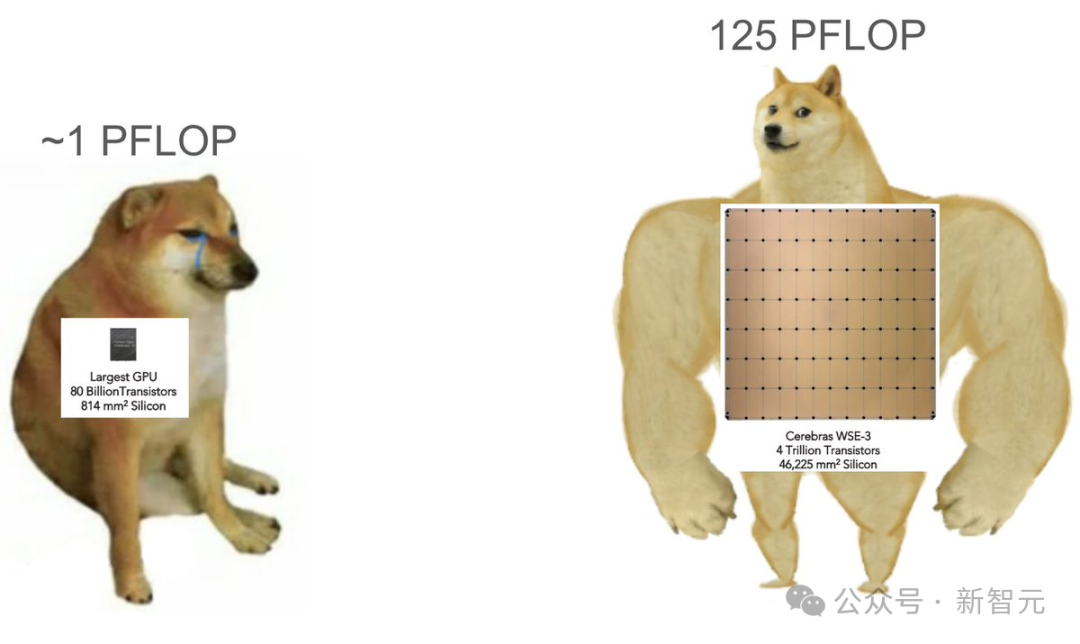

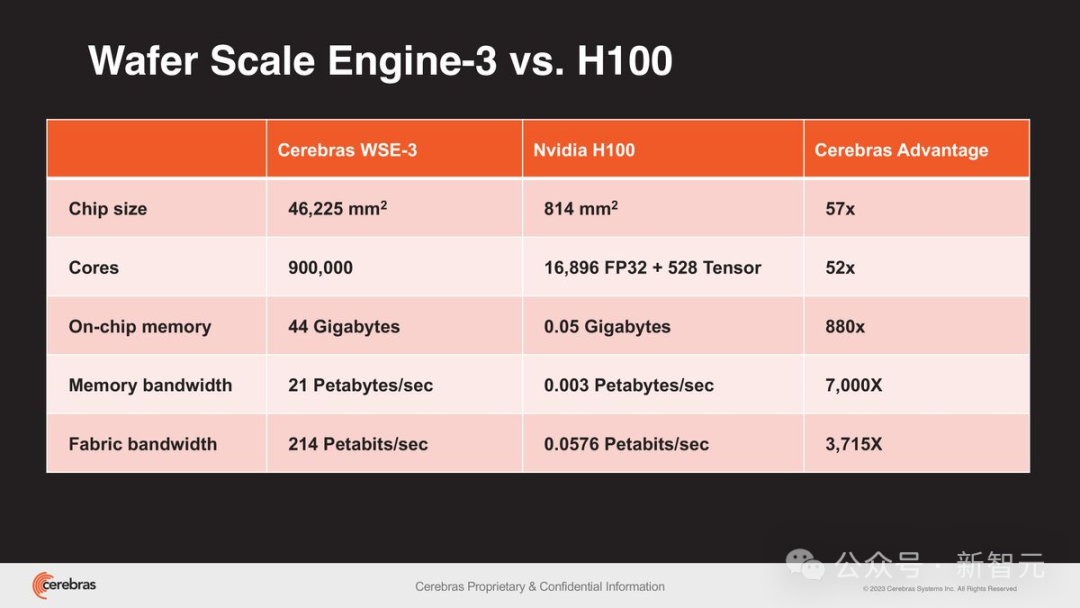

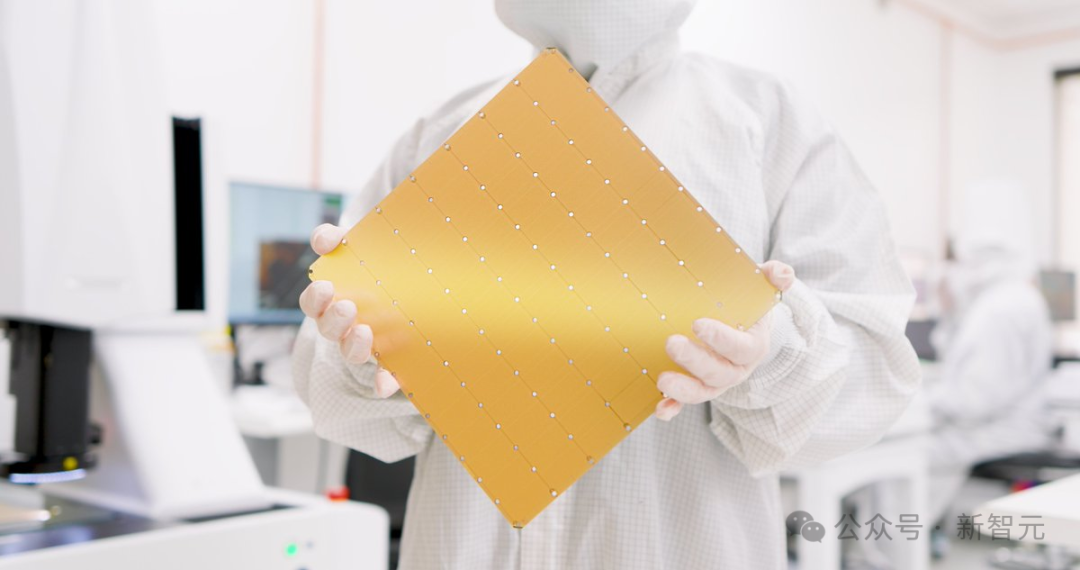

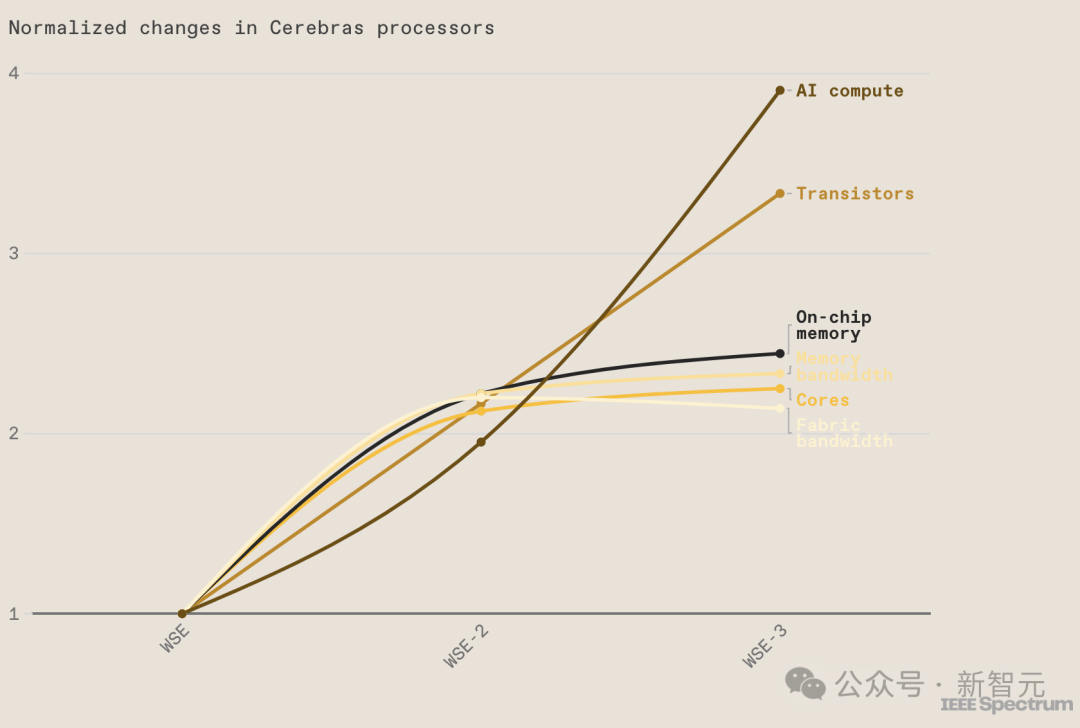

全球最快、最强的AI芯片面世,让整个行业瞬间惊掉了下巴!就在刚刚,AI芯片初创公司Cerebras重磅发布了「第三代晶圆级引擎」(WSE-3)。性能上,WSE-3是上一代WSE-2的两倍,且功耗依旧保持不变。 90万个AI核心,44GB的片上SRAM存储,让WSE-3的峰值性能达到了125 FP16 PetaFLOPS。

90万个AI核心,44GB的片上SRAM存储,让WSE-3的峰值性能达到了125 FP16 PetaFLOPS。 这相当于52块英伟达H100 GPU!

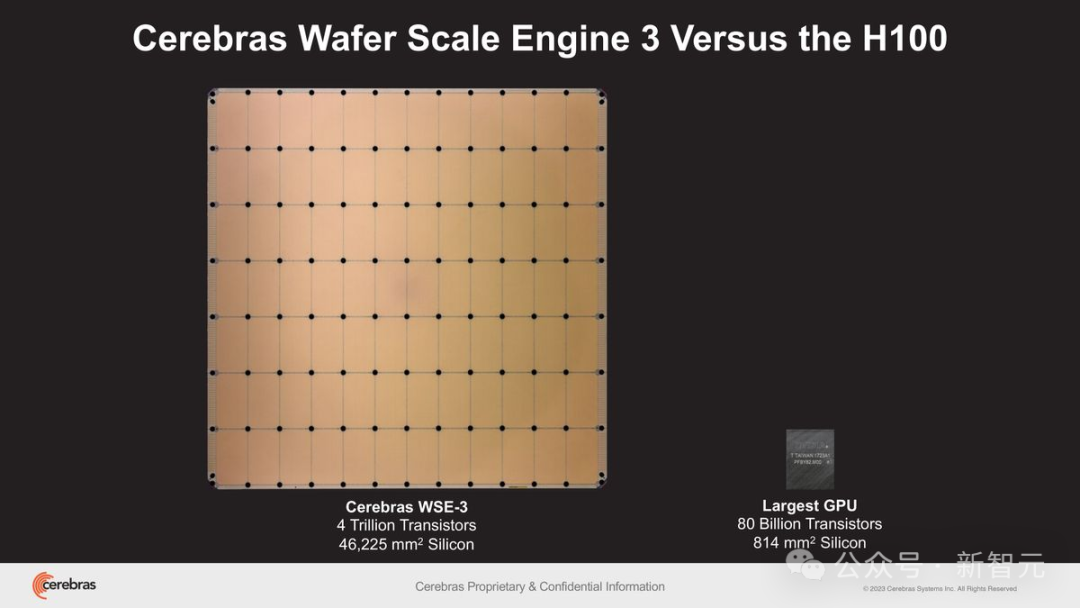

这相当于52块英伟达H100 GPU! 不仅如此,相比于800亿个晶体管,芯片面积为814平方毫米的英伟达H100。采用台积电5nm制程的WSE-3,不仅搭载了40000亿个晶体管(50倍),芯片面积更是高达46225平方毫米(57倍)。

不仅如此,相比于800亿个晶体管,芯片面积为814平方毫米的英伟达H100。采用台积电5nm制程的WSE-3,不仅搭载了40000亿个晶体管(50倍),芯片面积更是高达46225平方毫米(57倍)。

专为AI打造的计算能力

此前,在传统的GPU集群上,研究团队不仅需要科学地分配模型,还必须在过程中处理各种复杂问题,比如处理器单元的内存容量、互联带宽、同步机制等等,同时还要不断调整超参数并进行优化实验。 更令人头疼的是,最终的实现很容易因为小小的变动而受到影响,这样就会进一步延长解决问题所需的总时间。相比之下,WSE-3的每一个核心都可以独立编程,并且专为神经网络训练和深度学习推理中,所需的基于张量的稀疏线性代数运算,进行了优化。而团队也可以在WSE-3的加持下,以前所未有的速度和规模训练和运行AI模型,并且不需要任何复杂分布式编程技巧。

更令人头疼的是,最终的实现很容易因为小小的变动而受到影响,这样就会进一步延长解决问题所需的总时间。相比之下,WSE-3的每一个核心都可以独立编程,并且专为神经网络训练和深度学习推理中,所需的基于张量的稀疏线性代数运算,进行了优化。而团队也可以在WSE-3的加持下,以前所未有的速度和规模训练和运行AI模型,并且不需要任何复杂分布式编程技巧。

单芯片实现集群级性能

其中,WSE-3配备的44GB片上SRAM内存均匀分布在芯片表面,使得每个核心都能在单个时钟周期内以极高的带宽(21 PB/s)访问到快速内存——是当今地表最强GPU英伟达H100的7000倍。

超高带宽,极低延迟

而WSE-3的片上互连技术,更是实现了核心间惊人的214 Pb/s互连带宽,是H100系统的3715倍。

单个CS-3可训24万亿参数,大GPT-4十倍

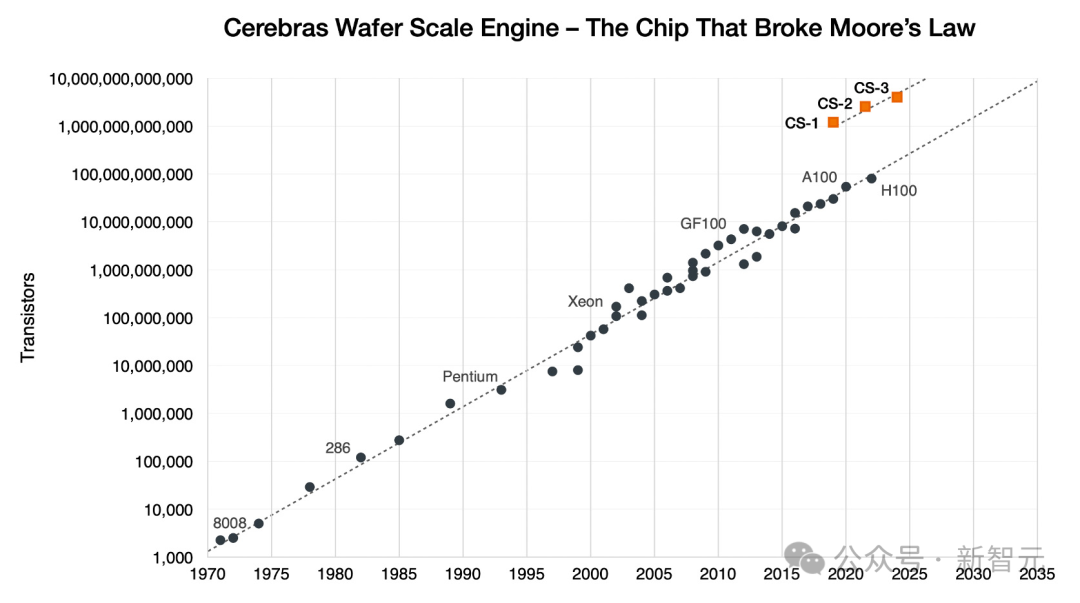

由WSE-3组成的CS-3超算,可训练比GPT-4和Gemini大10倍的下一代前沿大模型。再次打破了「摩尔定律」!2019年Cerebras首次推出CS-1,便打破了这一长达50年的行业法则。 官方博客中的一句话,简直刷新世界观:在CS-3上训练一个万亿参数模型,就像在GPU上训练一个10亿参数模型一样简单!显然,Cerebras的CS-3强势出击,就是为了加速最新的大模型训练。它配备了高达1.2PB的巨大存储系统,单个系统即可训出24万亿参数的模型——为比GPT-4和Gemini大十倍的模型铺平道路。简之,无需分区或重构,大大简化训练工作流提高开发效率。

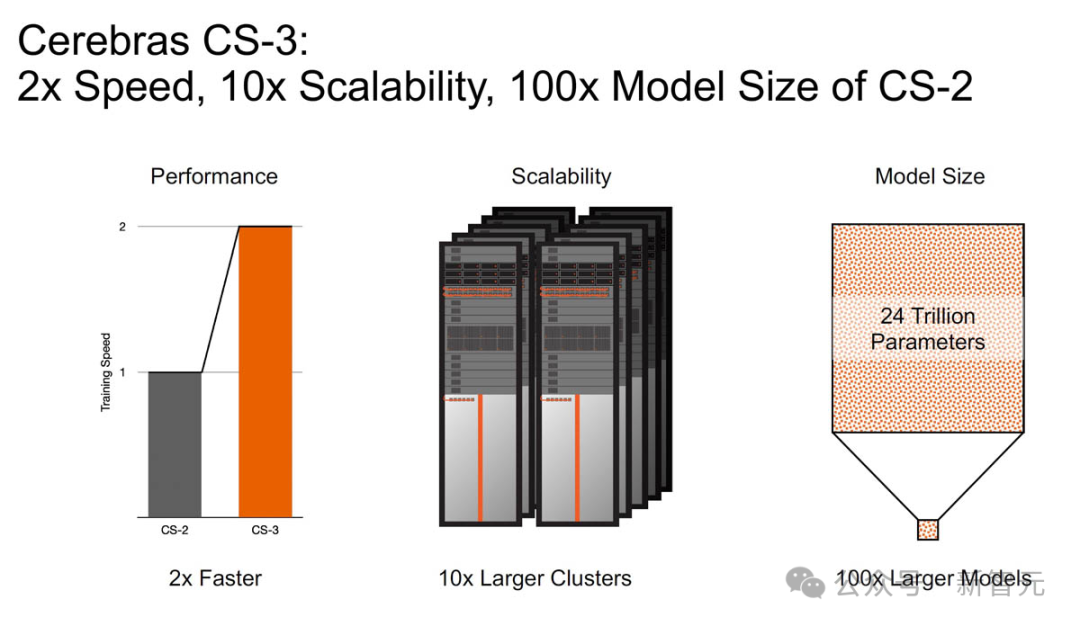

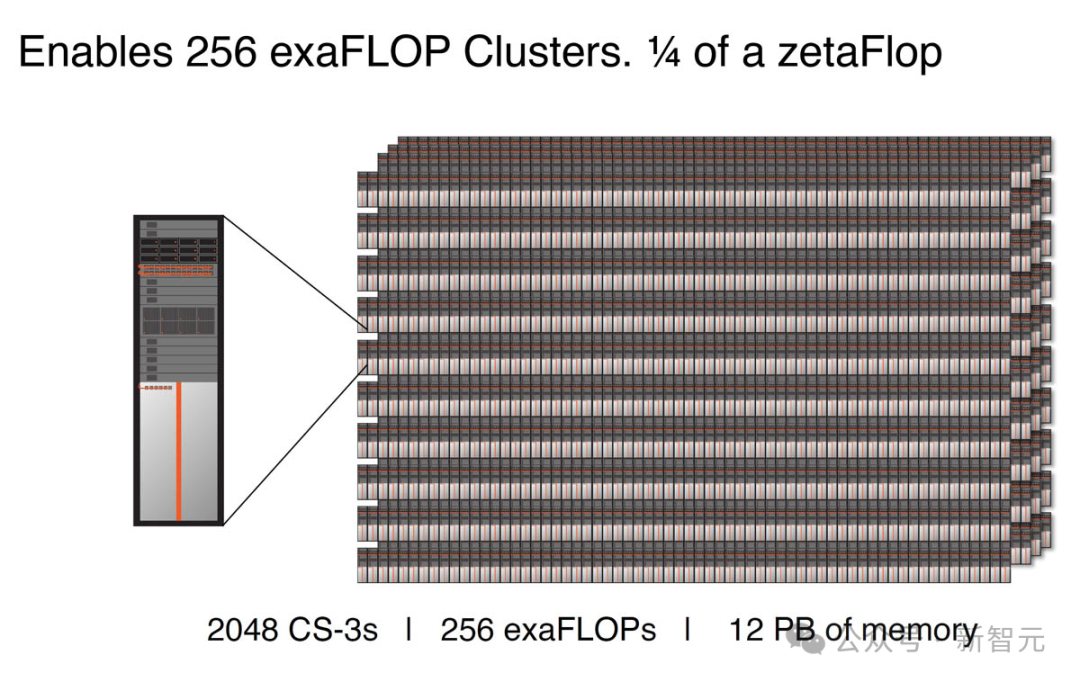

官方博客中的一句话,简直刷新世界观:在CS-3上训练一个万亿参数模型,就像在GPU上训练一个10亿参数模型一样简单!显然,Cerebras的CS-3强势出击,就是为了加速最新的大模型训练。它配备了高达1.2PB的巨大存储系统,单个系统即可训出24万亿参数的模型——为比GPT-4和Gemini大十倍的模型铺平道路。简之,无需分区或重构,大大简化训练工作流提高开发效率。 在Llama 2、Falcon 40B、MPT-30B以及多模态模型的真实测试中,CS-3每秒输出的token是上一代的2倍。而且,CS-3在不增加功耗/成本的情况下,将性能提高了一倍。除此之外,为了跟上不断升级的计算和内存需求,Cerebras提高了集群的可扩展性。上一代CS-2支持多达192个系统的集群,而CS-3可配置高达2048个系统集群,性能飙升10倍。

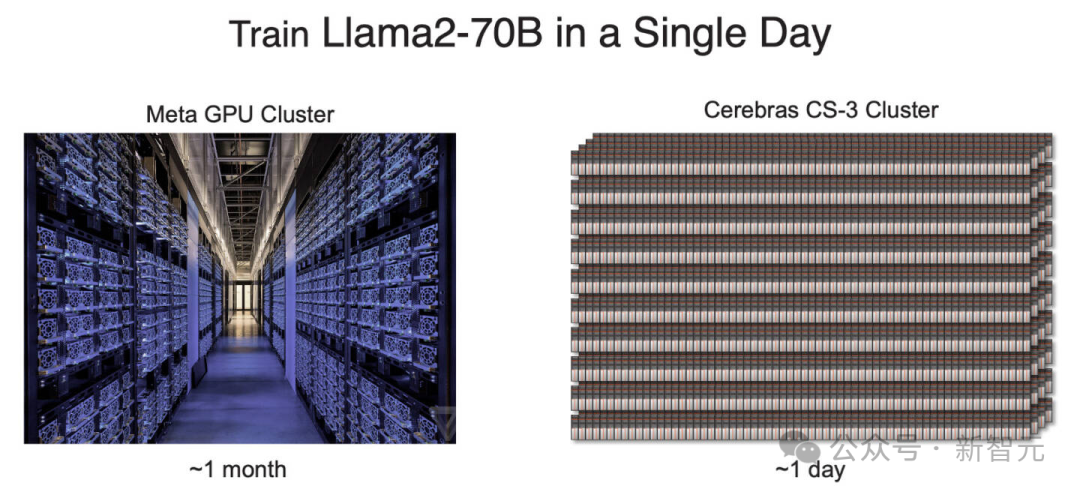

在Llama 2、Falcon 40B、MPT-30B以及多模态模型的真实测试中,CS-3每秒输出的token是上一代的2倍。而且,CS-3在不增加功耗/成本的情况下,将性能提高了一倍。除此之外,为了跟上不断升级的计算和内存需求,Cerebras提高了集群的可扩展性。上一代CS-2支持多达192个系统的集群,而CS-3可配置高达2048个系统集群,性能飙升10倍。 具体来说,由2048个CS-3组成的集群,可以提供256 exafloop的AI计算。能够在24小时内,从头训练一个Llama 70B的模型。相比之下,Llama2 70B可是用了大约一个月的时间,在Meta的GPU集群上完成的训练。

具体来说,由2048个CS-3组成的集群,可以提供256 exafloop的AI计算。能够在24小时内,从头训练一个Llama 70B的模型。相比之下,Llama2 70B可是用了大约一个月的时间,在Meta的GPU集群上完成的训练。 与GPU系统的另一个不同是,Cerebras晶圆规模集群可分离计算和内存组件,让开发者能轻松扩展MemoryX单元中的内存容量。得益于Cerebras独特的Weight Streaming架构,整个集群看起来与单个芯片无异。换言之,一名ML工程师可以在一台系统上开发和调试数万亿个参数模型,这在GPU领域是闻所未闻的。

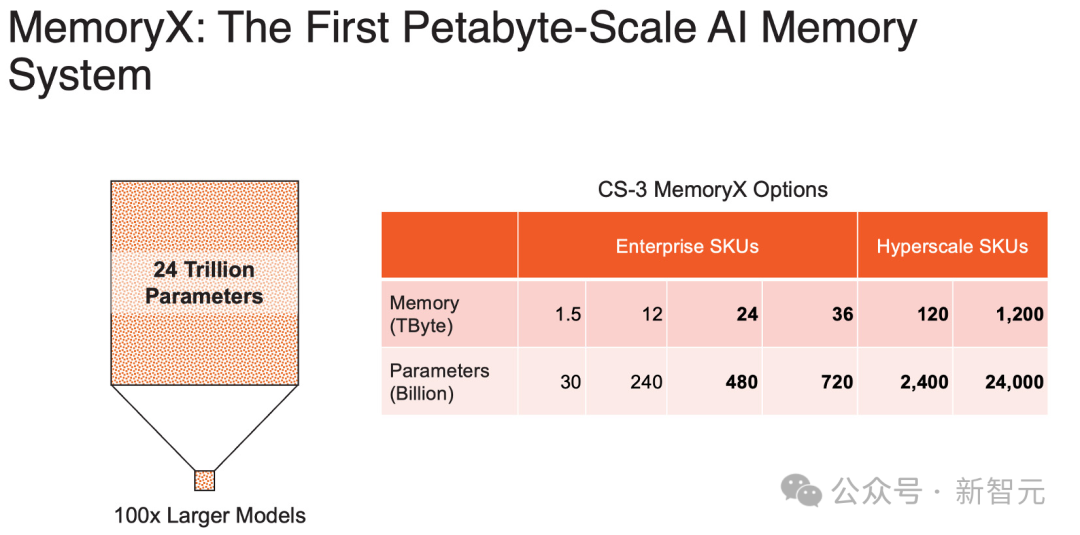

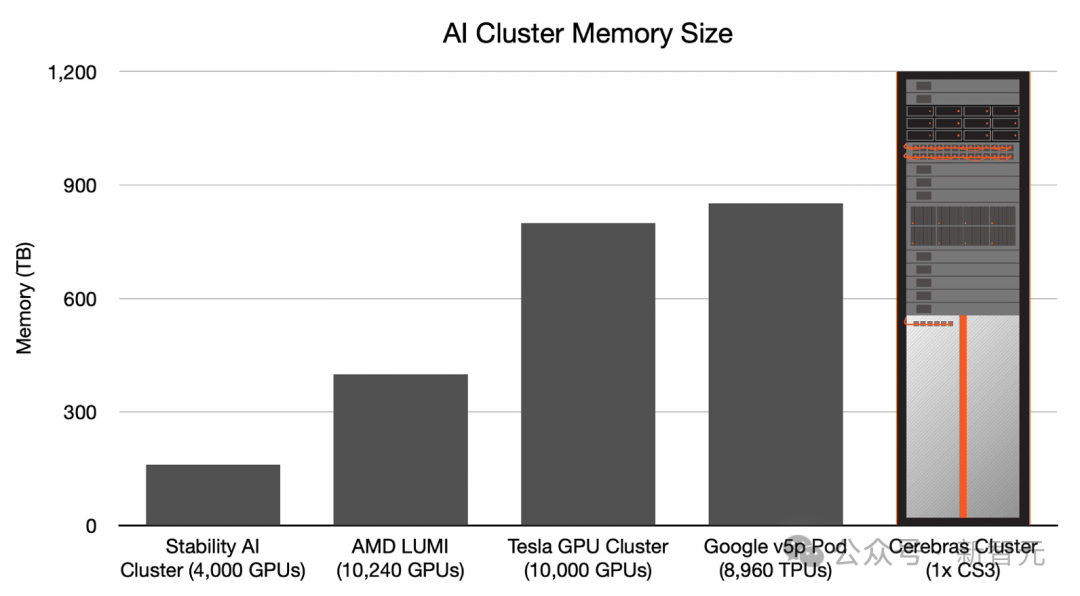

与GPU系统的另一个不同是,Cerebras晶圆规模集群可分离计算和内存组件,让开发者能轻松扩展MemoryX单元中的内存容量。得益于Cerebras独特的Weight Streaming架构,整个集群看起来与单个芯片无异。换言之,一名ML工程师可以在一台系统上开发和调试数万亿个参数模型,这在GPU领域是闻所未闻的。 具体来说,CS-3除了为企业提供24TB和36TB这两个版本外,还有面向超算的120TB和1200TB内存版本。(之前的CS-2集群只有1.5TB和12TB可选)单个CS-3可与单个1200 TB内存单元配对使用,这意味着单个CS-3机架可以存储模型参数,比10000个节点的GPU集群多得多。

具体来说,CS-3除了为企业提供24TB和36TB这两个版本外,还有面向超算的120TB和1200TB内存版本。(之前的CS-2集群只有1.5TB和12TB可选)单个CS-3可与单个1200 TB内存单元配对使用,这意味着单个CS-3机架可以存储模型参数,比10000个节点的GPU集群多得多。 除此之外,与使用GPU相比,在Cerebras平台上开发所需的代码量还减少了高达97%。更令人震惊的数字是——训练一个GPT-3规模的模型,仅需565行代码!Playground AI创始人称,GPT-3正稳步成为AI领域的新「Hello World」。在Cerebras上,一个标准的GPT-3规模的模型,只需565行代码即可实现,创下行业新纪录。

除此之外,与使用GPU相比,在Cerebras平台上开发所需的代码量还减少了高达97%。更令人震惊的数字是——训练一个GPT-3规模的模型,仅需565行代码!Playground AI创始人称,GPT-3正稳步成为AI领域的新「Hello World」。在Cerebras上,一个标准的GPT-3规模的模型,只需565行代码即可实现,创下行业新纪录。

首个世界最强芯片打造的超算来了

由G42和Cerebras联手打造的超级计算机——Condor Galaxy,是目前在云端构建AI模型最简单、最快速的解决方案。 它具备超过16 ExaFLOPs的AI计算能力,能够在几小时之内完成对最复杂模型的训练,这一过程在传统系统中可能需要数天。其MemoryX系统拥有TB级别的内存容量,能够轻松处理超过1000亿参数的大模型,大大简化了大规模训练的复杂度。

它具备超过16 ExaFLOPs的AI计算能力,能够在几小时之内完成对最复杂模型的训练,这一过程在传统系统中可能需要数天。其MemoryX系统拥有TB级别的内存容量,能够轻松处理超过1000亿参数的大模型,大大简化了大规模训练的复杂度。 与现有的基于GPU的集群系统不同,Condor Galaxy在处理GPT这类大型语言模型,包括GPT的不同变体、Falcon和Llama时,展现出了几乎完美的扩展能力。这意味着,随着更多的CS-3设备投入使用,模型训练的时间将按照几乎完美的比例缩短。而且,配置一个生成式AI模型只需几分钟,不再是数月,这一切只需一人便可轻松完成。

与现有的基于GPU的集群系统不同,Condor Galaxy在处理GPT这类大型语言模型,包括GPT的不同变体、Falcon和Llama时,展现出了几乎完美的扩展能力。这意味着,随着更多的CS-3设备投入使用,模型训练的时间将按照几乎完美的比例缩短。而且,配置一个生成式AI模型只需几分钟,不再是数月,这一切只需一人便可轻松完成。 在简化大规模AI计算方面,传统系统因为需要在多个节点之间同步大量处理器而遇到了难题。而Cerebras的全片级计算系统(WSC)则轻松跨越这一障碍——它通过无缝整合各个组件,实现了大规模并行计算,并提供了简洁的数据并行编程界面。

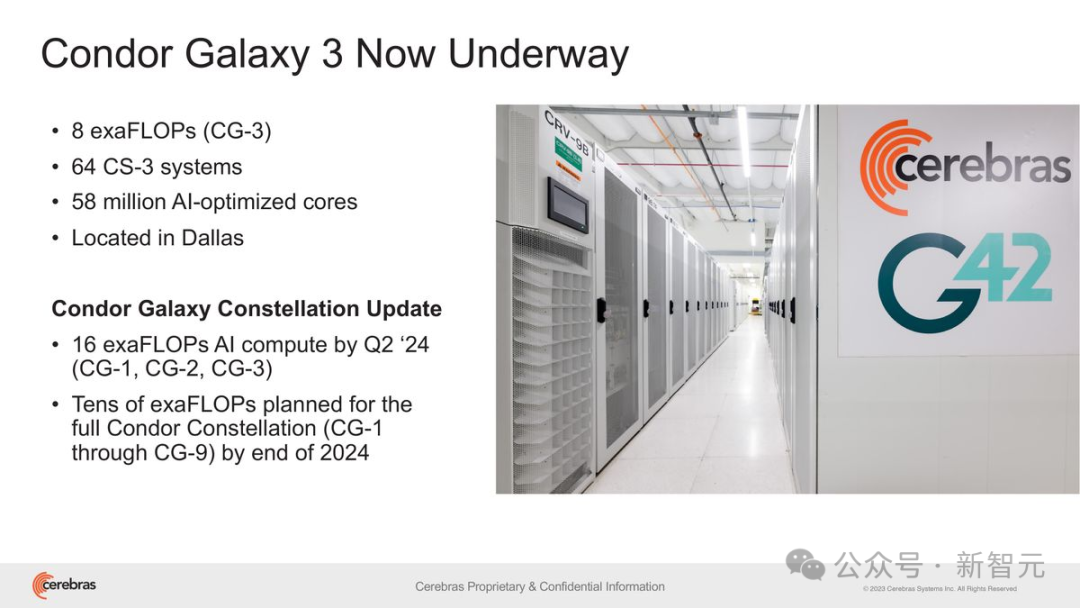

在简化大规模AI计算方面,传统系统因为需要在多个节点之间同步大量处理器而遇到了难题。而Cerebras的全片级计算系统(WSC)则轻松跨越这一障碍——它通过无缝整合各个组件,实现了大规模并行计算,并提供了简洁的数据并行编程界面。 此前,这两家公司已经联手打造了世界上最大的两台AI超级计算机:Condor Galaxy 1和Condor Galaxy 2,综合性能达到8exaFLOPs。G42集团的首席技术官Kiril Evtimov表示:「我们正在建设的下一代AI超级计算机Condor Galaxy 3,具有8exaFLOPs的性能,很快将使我们的AI计算总产能达到16exaFLOPs。」

此前,这两家公司已经联手打造了世界上最大的两台AI超级计算机:Condor Galaxy 1和Condor Galaxy 2,综合性能达到8exaFLOPs。G42集团的首席技术官Kiril Evtimov表示:「我们正在建设的下一代AI超级计算机Condor Galaxy 3,具有8exaFLOPs的性能,很快将使我们的AI计算总产能达到16exaFLOPs。」 如今,我们即将迎来新一波的创新浪潮,而全球AI革命的脚步,也再一次被加快了。参考资料:https://www.cerebras.net/

如今,我们即将迎来新一波的创新浪潮,而全球AI革命的脚步,也再一次被加快了。参考资料:https://www.cerebras.net/

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง