今天为大家介绍的是来自Anubhav Jain团队的一篇论文。从科学文本中提取结构化的知识对于机器学习模型来说依然是一个挑战性的任务。在这里,作者介绍了一种简单的方法,这种方法同时进行命名实体识别和关系提取,并展示了如何对预训练的大型语言模型(比如GPT-3、Llama-2)进行微调,以提取复杂科学知识的。

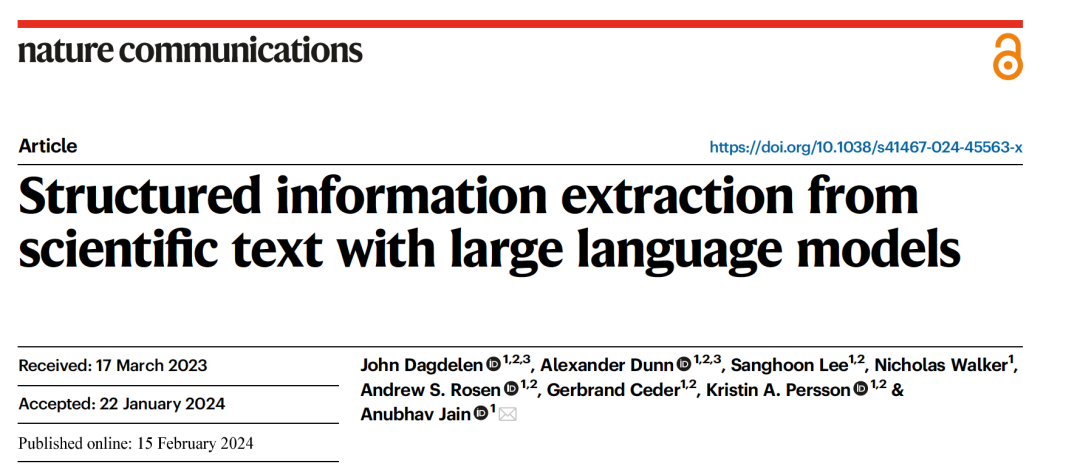

然而,科学信息往往不能简单地被建模为实体之间的成对关系。这在无机材料科学中尤为明显,一个化合物的属性是由其元素组成、原子几何、微观结构、形态(例如,纳米颗粒、异质结构和界面)、加工历史以及环境因素(如温度和压力)的复杂组合决定的。此外,无机材料知识通常本质上是相互交织的,这样的关系可能只在一个实体类型和一个复合实体(本身由几个实体和关系组成)之间有效。理论上,n个实体之间的关系可以被建模为n元组(例如,(”ZnO”,“纳米颗粒”,“催化剂”)),但全面枚举所有可能的变体既不切实际也不适合传统的关系提取方法,因为每种关系类型都需要足够数量的训练示例。当前的关系提取模型并不是设计来实际提取或保存这种高度复杂、错综复杂、层级化的关系;需要更灵活的策略。如GPT-3/4、PaLM、Megatron、LLaMA 1/2、OPT、Gopher和FLAN等大型语言模型(LLMs)已被证明在利用自然语言序列中不同长度之间的语义信息方面具有显著能力。它们在序列到序列(seq2seq)任务上特别擅长,其中文本输入用于引导模型产生文本响应。作者将这些输入称为“提示”(prompts),输出称为“完成”(completions)。seq2seq的用例很广泛,包括机器翻译、回答一般性的知识问题、执行简单的算术运算、在不同语言之间翻译、文本摘要以及聊天机器人应用。有理由认为这些模型也可能擅长复杂的科学信息提取。最近,采用单一机器学习模型的端到端方法已被用于联合命名实体识别和关系提取(NERRE)。这些方法采用序列到序列的方法,其中模型被训练以输出两个或更多命名实体的元组和属于它们之间可能关系的预定义集合的关系标签。这些方法在关系提取上表现良好,但它们本质上仍然是n元关系提取系统,不适合高度复杂和层次化的NERRE。

图 1

在这项工作中,作者探索了一种简单的方法来处理复杂信息提取,其中大型语言模型被微调以同时提取命名实体及其关系。这种方法能够灵活处理复杂的相互关系,而不需要枚举所有可能的n元组关系或预先进行命名实体识别(NER)。作者对一个预训练的大型语言模型(例如,GPT-3或Llama-2)进行了微调,使其能够接受一段文本并编写包含在提示中的知识的精确格式化“摘要”。这个“摘要”可以被格式化为英文句子或更结构化的模式,如JSON文档列表。要使用这种方法,只需定义所需的输出结构——例如,一个带有预定义键集的JSON对象列表——并使用此格式注释约100-500个文本段落。然后对这些示例进行LLM微调,结果模型能够以相同的结构化表示准确输出提取的信息,如图1所示的格式。

数据

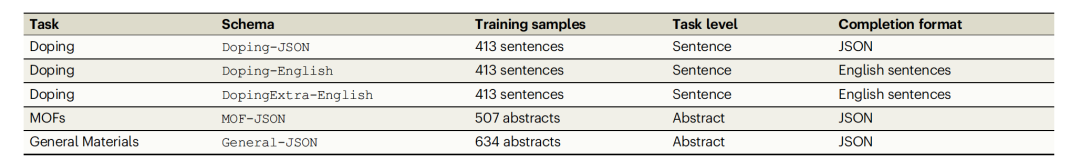

表 1

作者将上述方法应用于三个联合命名实体识别和关系提取(NERRE)材料信息提取任务:固态杂质掺杂、金属有机框架(MOFs)和一般材料信息提取。每个数据集的详细信息在表1中进行了总结。每个任务的进一步细节在方法部分进行了介绍。简而言之,固态杂质任务是从文本段落(句子)中识别宿主材料、掺杂剂和可能的额外相关信息。MOF任务是从文本(材料科学摘要)中识别化学公式、应用和MOF材料的进一步描述。一般材料信息任务是从文本(材料科学摘要)中识别无机材料、它们的公式、缩写、应用、标签和其他描述性信息。每个基础LLM模型都根据任务进行了微调,以遵循封装了感兴趣的实体、相关关系和格式的特定模式。

实验部分

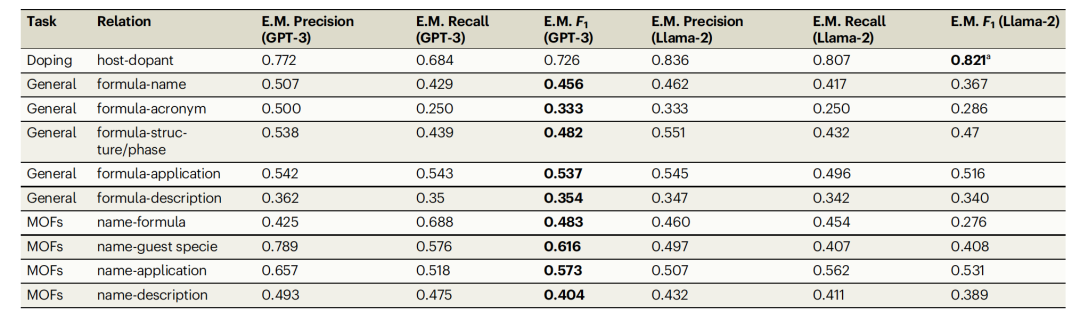

表 2

表2显示了在使用JSON模式的三个任务中,GPT-3和Llama-2在命名实体识别和关系提取(NER,RE)精度、召回率和F1得分上的比较。这些性能是基于精确单词匹配来计算的。因为这个联合任务既涉及命名实体识别也涉及关系提取,它反映了模型的NER和RE性能(如果实体不正确,则关系不能正确识别)。GPT-3在测试的所有实体关系中,对于一般提取和MOF任务达到了最高的F1得分。这两个提取任务的精确匹配F1得分通常比掺杂任务低约30%。在一般任务提取中,formula-applications之间的关系具有最高的F1得分(F1=0.537),而formula-acronym和formula-description之间的关系则可靠性要低得多。MOF任务中有类似的发现,name-application(F1=0.573)和name-guest specie(F1=0.616)关系被最准确地提取。Llama-2的得分平均比GPT-3的低20-30%,表明GPT-3有显著优势。在掺杂任务中,Llama-2具有最高的精度(0.836)、召回率(0.807)和F1(0.821),相对于F1,比GPT-3提高了13%。

表2中的一般任务和MOF任务的F1得分通常在0.3到0.6之间,乍一看,这似乎对于大规模信息提取任务来说太低,无法发挥实用价值。然而,MOF和一般任务的得分有一个重要的注意事项。这些任务的注释包括隐含的规范化(例如,“Lithium ion” → “Li-ion”)和错误纠正(“silcion” → “silicon”),而掺杂任务的目标是精确地提取文本中出现的宿主和掺杂剂。因此,上述的精确单词匹配基础得分是信息提取性能的一个近似下限,因为这个度量标准只比较单词之间的精确匹配。当由人类专家阅读一般任务模型和MOF模型的输出时,显然,模型经常以轻微变化的措辞或符号提取真实信息。实际世界信息提取任务中固有的模糊性也对性能有影响。例如,在MOF信息提取中,MOF名称(例如,“ZIF-8”)比描述(例如,“mesostructured MOFs formed by Cu2+ and 5-hydroxy-1,3-benzenedicarboxylic acid”)更容易,后者可以用许多不同的措辞来写。

为了考虑这些因素,作者对一般材料信息提取数据集的随机10%测试集进行了手动评分,以便与原始的人工(真实)注释进行对比。如果实体的核心信息被准确地提取到了正确的JSON对象中(即,与正确的材料公式分组),作者标记提取结果为正确,;如果这些信息被提取到错误的JSON对象中、根本没有被提取,或者不能合理地从原始摘要中推断出来,则标记为不正确。与表2中的精确匹配得分不同,手动得分在三个方面提供了灵活性:(1)实体的规范化,(2)错误的纠正,和(3)在不同标签下对一个实体的多种合理注释。表2评估模型是否能精确提取出真实注释中出现的词对,而表3中的手动得分则评估模型是否提取出了与真实注释等效的信息——不论具体形式如何。简单来说,如果一个领域专家认为模型的提取结果与真实的提取结果等效,那么模型的提取就被标记为正确。

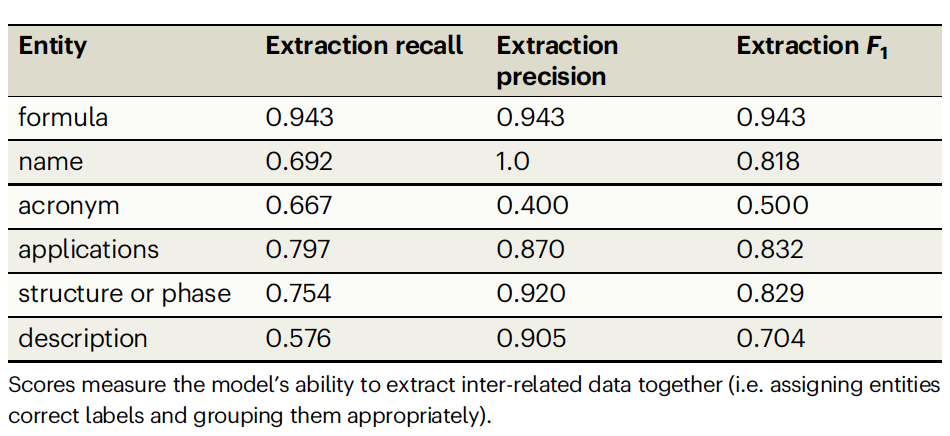

表 3

表3展示了基于手动评分调整后的得分。作者按实体分类这些得分;“name”, “acronym”, “application”, “structure”, 和“description”手动得分可以和表2中的formula-{name, application, structure, description}关系得分进行比较。例如,“description”反映了模型提取的描述实体在意义上多么频繁地与真实注释等效,并且被分组到正确的JSON对象中。可与看到,精确匹配评分严重低估了材料name(0.456对比0.818)、application(0.537对比0.832)、structure 0.482对比0.829)和description(0.354对比0.704)的表现。手动评分揭示了模型实际上能够从科学文本中正确提取出关于各种材料科学主题的结构化知识。作者观察到,acronym有最低的得分,这是因为与其他类别相比,缩写在训练类中相对罕见(整个数据集中只有52个摘要出现,约占文档的9%),而且模型可能将缩写与化学公式混淆(例如,“AuNP”既是金纳米颗粒的缩写,也是有效的化学公式)。通常,上下文线索是区分此类情况的唯一方法,作者期望包括更多包含缩写的训练数据可能会提高缩写提取得分。

编译 | 曾全晨

审稿 | 王建民

参考资料

Dagdelen, J., Dunn, A., Lee, S. et al. Structured information extraction from scientific text with large language models. Nat Commun 15, 1418 (2024).

https://doi.org/10.1038/s41467-024-45563-x

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง