复旦大学数据智能与社会计算实验室

Fudan DISC

项目主页:

https://alarm-fdu.github.io

arXiv:

https://arxiv.org/abs/2403.06754

GitHub:

https://github.com/halfrot/ALaRM

01

概述

ALaRM是一个用于对齐语言模型的强化学习框架,它:

- 利用层级结构组合整体偏好和细粒度的奖励,

- 基于奖励间的一致性进行预先筛选和组合,

- 在Long-form QA和机器翻译的实验中验证了有效性。

02

研究动机

人类的监督能力是有限的。当任务变得复杂时,传统的Human-written Demonstrations或Human Preference中的噪声会更大,变得不可靠。我们由此引出问题,如何在有限的人类监督能力范围内获得可靠且可扩展的监督信号?

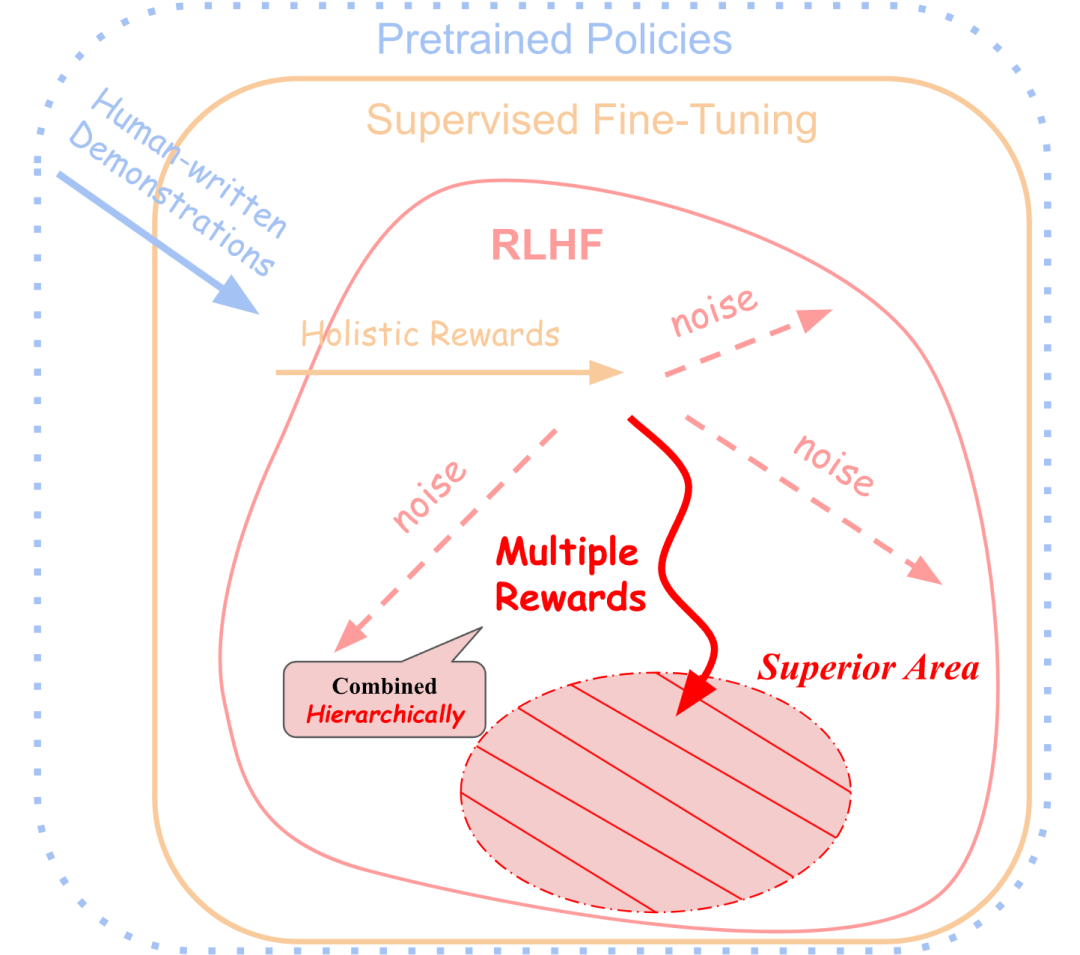

如图所示,阴影部分的“Superior Area”更好地符合人类偏好,但这对仅依赖于总体偏好的单一奖励(Holistic Rewards)来说是难以达到的。由此,我们提出可以层级化地利用多种奖励来获得更准确和一致的监督信号。

03

摘要

我们提出了ALaRM,这是第一个对RLHF中的奖励进行层级化建模的框架,旨在提高大型语言模型(LLMs)与人类偏好的对齐性。

该框架尝试减轻当前对齐方法中,人类监督信号的不一致性和稀疏性带来的训练噪声。ALaRM将整体偏好的奖励与特定方面的奖励结合起来,使监督信号更加精确和一致,特别是在复杂和开放的文本生成任务中。通过一种基于一致性的筛选、结合多重奖励的方法,该框架为改善模型对齐提供了一个可靠的机制。

我们在长篇问答和机器翻译任务中验证了框架的有效性,强调了层级化奖励建模在语言模型对齐中的潜力。

04

框架简介

ALaRM的提出基于两个已有的研究结论:1)对单个方面(真实性、完整性)而非整体质量进行评估或偏好标注会更加准确,从而减小监督信号的噪声;2)分层强化学习中通常进行任务分解来克服奖励的稀疏性,从而减小噪声的影响。

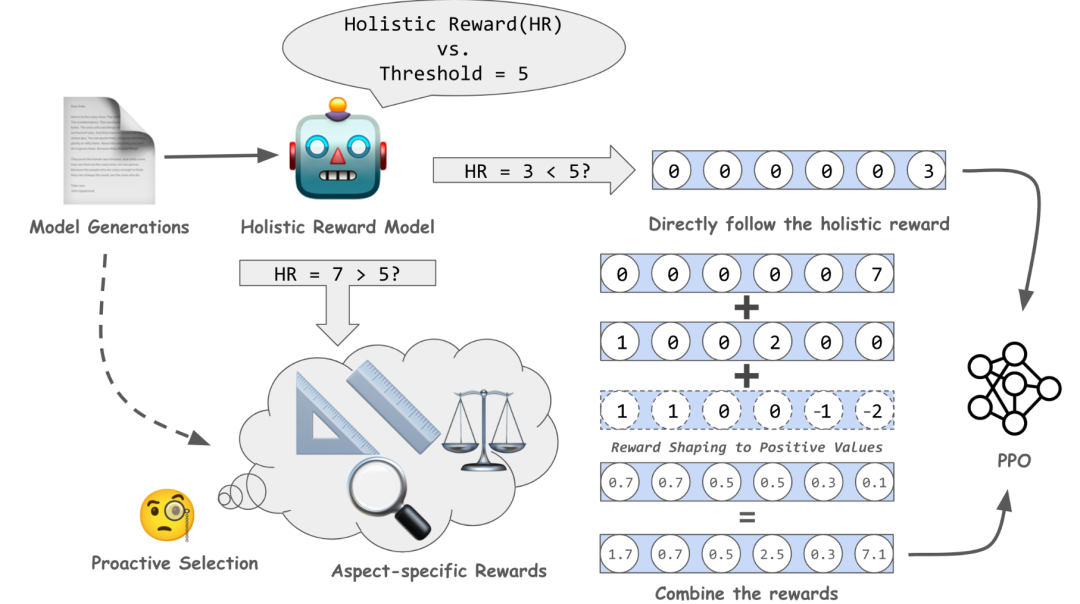

首先,我们列出与任务相关的各方面的细粒度奖励,如真实性、完整性、简洁性等,然而,人类偏好的复杂性导致不同奖励之间可能存在联系,甚至互相冲突。与广泛使用的加权取和不同,ALaRM为了优先保证监督信号的稳定性,根据一致性对各奖励进行预先筛选,保留与整体偏好奖励的优化方向一致的奖励进行后续建模。

在层级化奖励建模方面,ALaRM将对齐目标分解为两个呈递进关系的子任务:1) 直接遵循整体偏好奖励,直到模型的输出获得较高奖励,即在较高水平上符合人类偏好;2) 优化整体偏好和细粒度奖励的组合,即指向二者都能得到高奖励的区域。通过这种方式,ALaRM确保模型在达到整体偏好所提供监督信号的极限时,进一步细化目标,以得到更准确一致的监督信号。此外,ALaRM通过reward shaping保证了第二个子任务获得的累计奖励更高,强化了层级结构。

05

实验结果

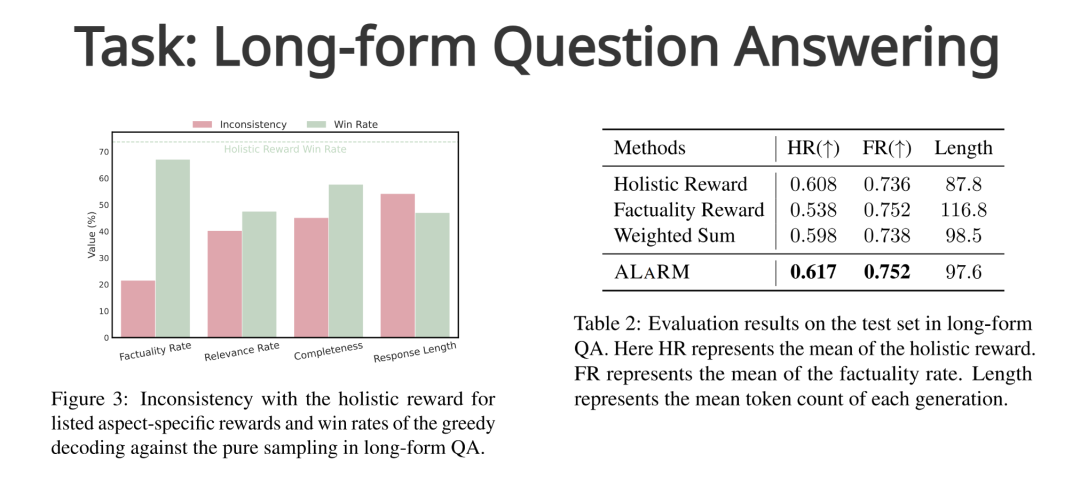

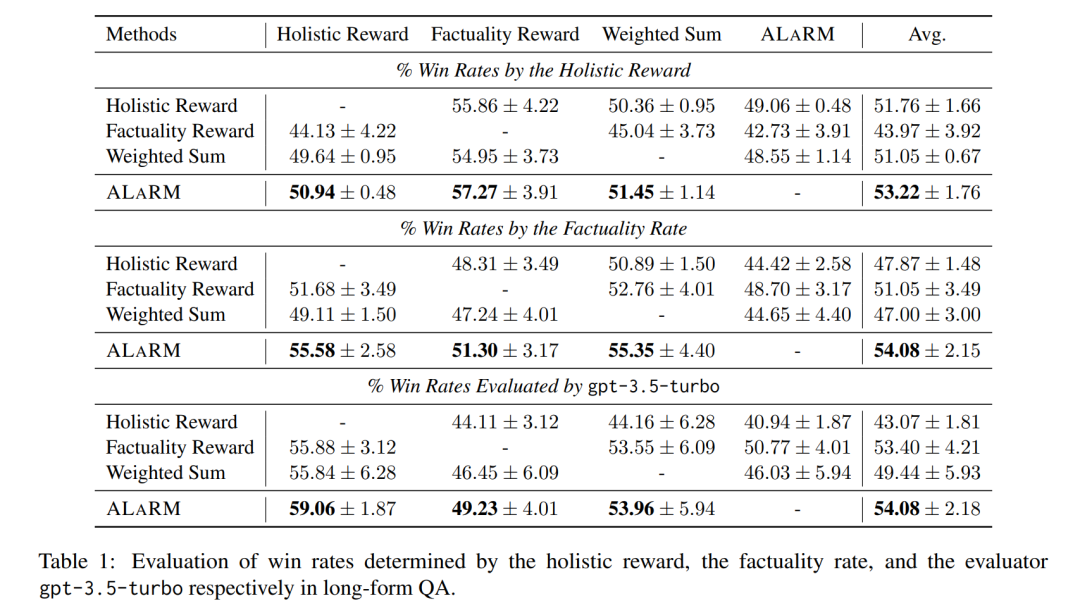

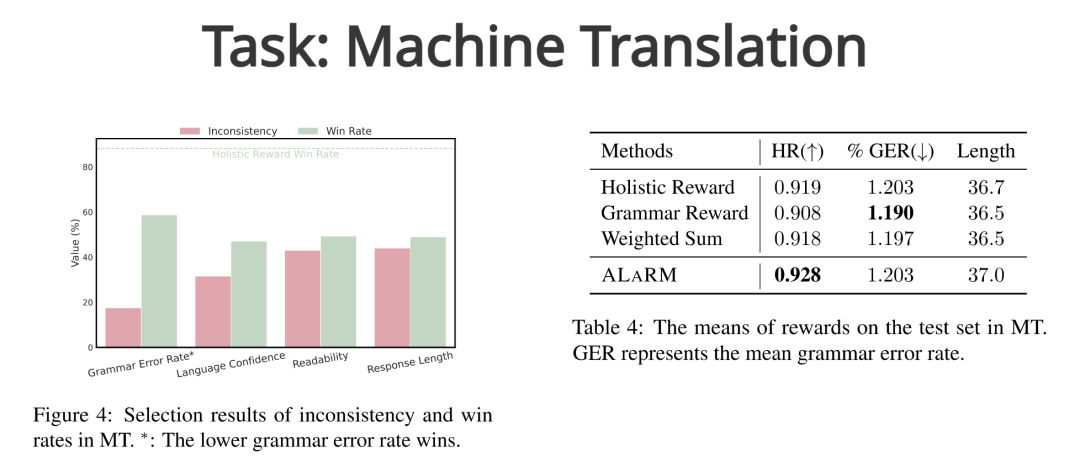

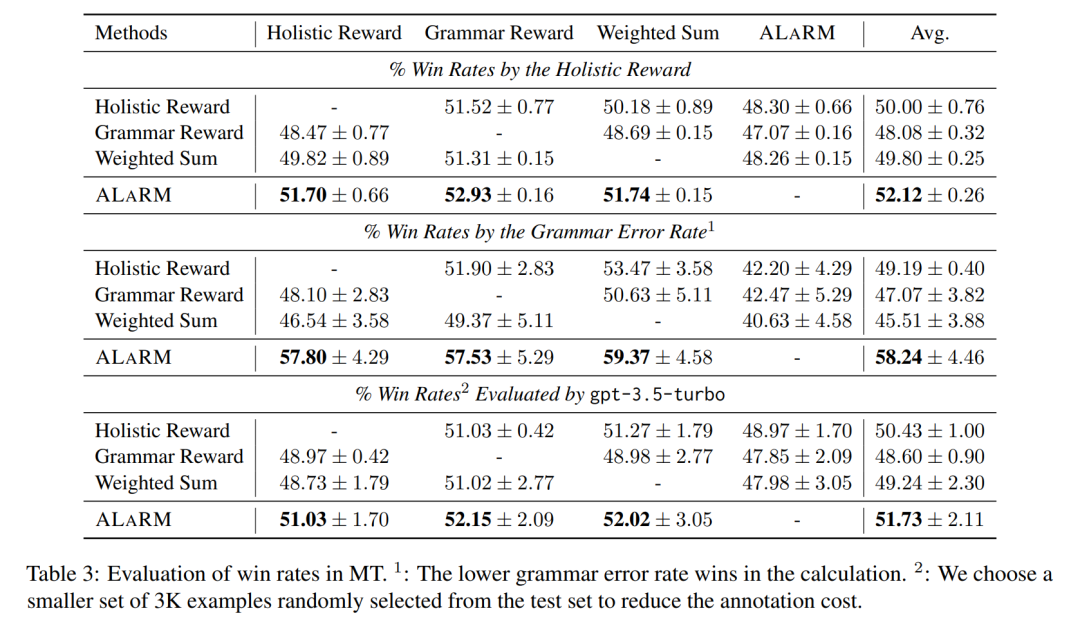

在Long-form QA和机器翻译两个任务中,我们将ALaRM与整体偏好奖励(Holistic Rewards),选择的细粒度奖励(Long-form QA:Factuality Reward;机器翻译:Grammar Reward),加权和方法(Weighted Sum)进行了比较。结果表明ALaRM在1)模型输出获得的平均奖励,2)不同奖励以及gpt-3.5-turbo为判断标准的Win Rate下均体现出了有效性。

06

消融研究

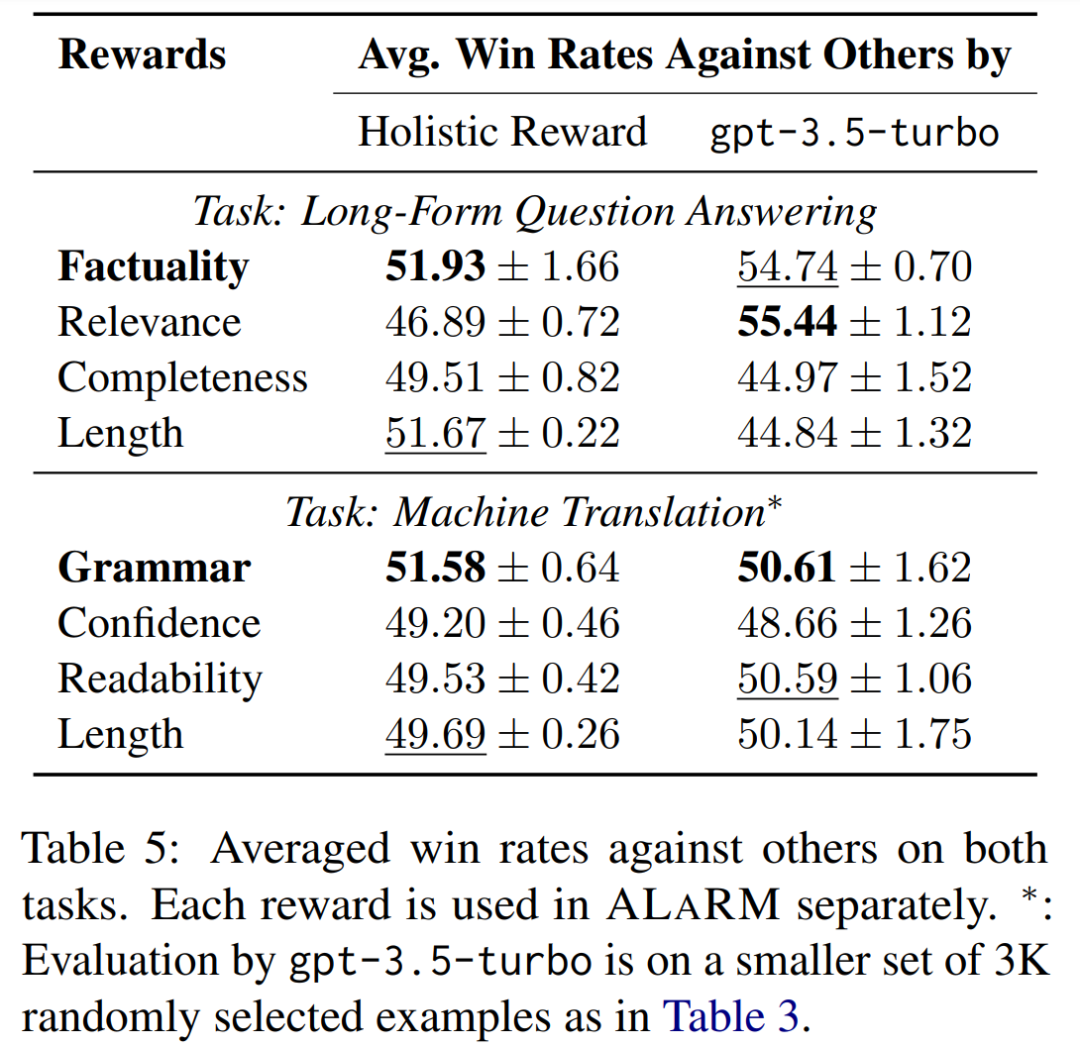

在主要结果支持了奖励组合和层次结构的重要性的同时,我们开展了额外的实验来探究预先的奖励筛选如何影响ALaRM。如表所示,筛选中保留的奖励在以整体偏好奖励和gpt-3.5-turbo为判断标准的Win Rate下保持领先效果,证明了奖励选择的重要性。

07

总结

我们提出了ALaRM,这是第一个在RLHF中层级化建模整体偏好和细粒度奖励的框架。我们探索了预先的奖励选择策略,以增强与整体偏好奖励的兼容性。通过两个文本生成任务上全面的实验、详细的消融研究和分析,验证了ALaRM在寻求更准确一致的监督信号的有效性,以及其在对齐任务中激发可扩展监督的潜力。

END

复旦大学数据智能与社会计算实验室

Fudan DISC

点击“阅读原文”跳转至项目主页

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง