今日值得关注的大模型前沿论文

- 华为新研究:减少transformer计算负荷,让大模型更高效

- 苹果提出ReALM:用大模型解析各种参考信息

- Google DeepMind提出Gecko:实现强大的检索性能

- MMStar:一种新的大型视觉语言模型评估基准

- H2RSVLM:遥感视觉语言大模型

- Jamba:混合transformer-Mamba语言模型

- Transformer-Lite: 在手机GPU上高效部署大型语言模型

- MambaMixer:高效选择性状态空间模型

想要第一时间获取每日最新大模型热门论文?添加微信 Tobethenum1,加入大模型论文分享群,务必备注“大模型日报”。或点击“阅读原文”,获取「2024必读大模型论文」合集。

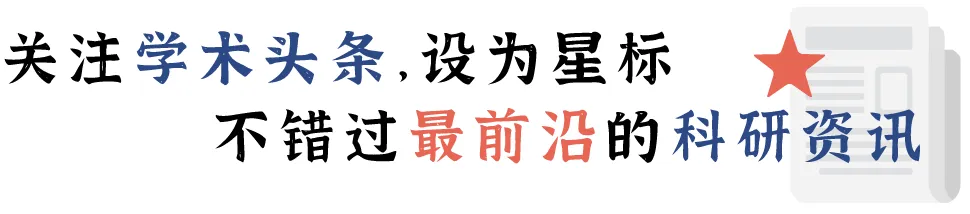

1.华为新研究:减少transformer计算负荷,让大模型更高效

为了减少 transformer 的计算负荷,线性关注的研究获得了显著的发展。

然而,注意力机制的改进策略通常需要大量的再训练,这对于拥有大量参数的大型语言模型来说是不切实际的。

来自华为公司和北京大学的研究团队提出了一种新颖的频域核化(Frequency Domain Kernelization)方法—— DiJiang,它能以极小的训练成本将预先训练好的 Vanilla Transformer 转化为线性复杂度模型。通过采用加权准蒙特卡罗方法进行采样,所提出的方法在理论上具有更高的逼近效率。为了进一步降低训练计算复杂度,DiJiang 核化基于离散余弦变换(DCT)操作。

广泛的实验证明,所提出的方法实现了与原始 transformer 相当的性能,但训练成本大大降低,推理速度也快得多。DiJiang-7B 在各种基准测试中取得了与 LLaMA2-7B 相当的性能,而训练成本仅为 LLaMA2-7B 的 1/50。

论文链接:

https://arxiv.org/abs/2403.19928

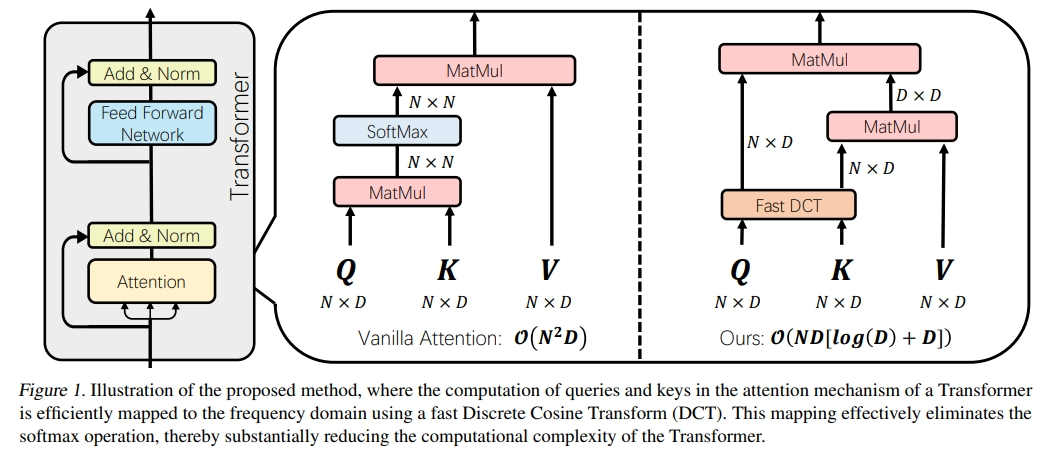

2.苹果提出ReALM:用大模型解析各种参考信息

参考解析一直以来都是一个重要问题,对于理解和成功处理不同类型的上下文至关重要。这种上下文既包括先前的转折,也包括与非对话实体相关的上下文,例如用户屏幕上的实体或后台运行的实体。

虽然大型语言模型(LLM)在各种任务中都显示出极其强大的功能,但其在参考解析中的应用,尤其是在非对话实体方面的应用,仍未得到充分利用。

苹果公司的研究团队通过如何将参考解析转换为语言建模问题,展示了如何利用 LLMs 创建一个极其有效的系统来解析各种类型的参考信息,尽管涉及的实体形式(如屏幕上的实体)在传统上不利于简化为纯文本模式。在不同类型的参考文献中,该研究团队展示了与功能类似的现有系统相比所取得的巨大进步,他们的最小模型在屏幕参考文献方面的绝对收益超过 5%,此外,他们的最小模型与 GPT-4 的性能相当,而较大模型则大大优于 GPT-4。

论文链接:

https://arxiv.org/abs/2403.20329

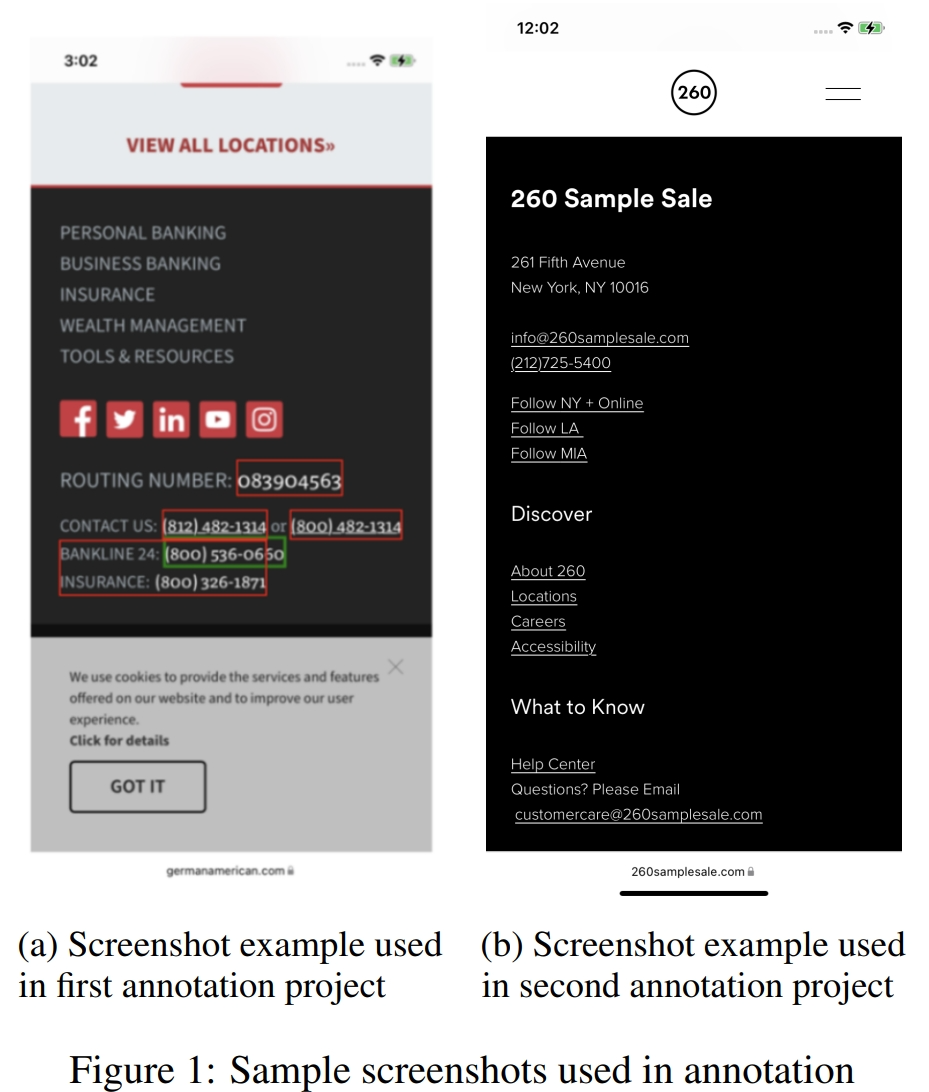

3.Google DeepMind提出Gecko:实现强大的检索性能

谷歌团队新提出的 Gecko 是一种紧凑、通用的文本嵌入模型。Gecko 利用一个关键理念实现了强大的检索性能:将大型语言模型(LLM)中的知识提炼到检索器中。

该模型的提炼过程分为两步,首先使用 LLM 生成多样化的合成配对数据。接下来,为每个查询检索一组候选段落,并使用相同的 LLM 对正向段落和反向段落进行重新标注,从而进一步提高数据质量。

Gecko 的紧凑性证明了这种检索方法的有效性。在海量文本嵌入基准测试(MTEB)中,嵌入维度为 256 的 Gecko 优于嵌入维度为 768 的所有现有项目。具有 768 个嵌入维度的 Gecko 平均得分达到 66.31,与 7 倍更大的模型和 5 倍更高维度的嵌入相抗衡。

论文链接:

https://arxiv.org/abs/2403.20327

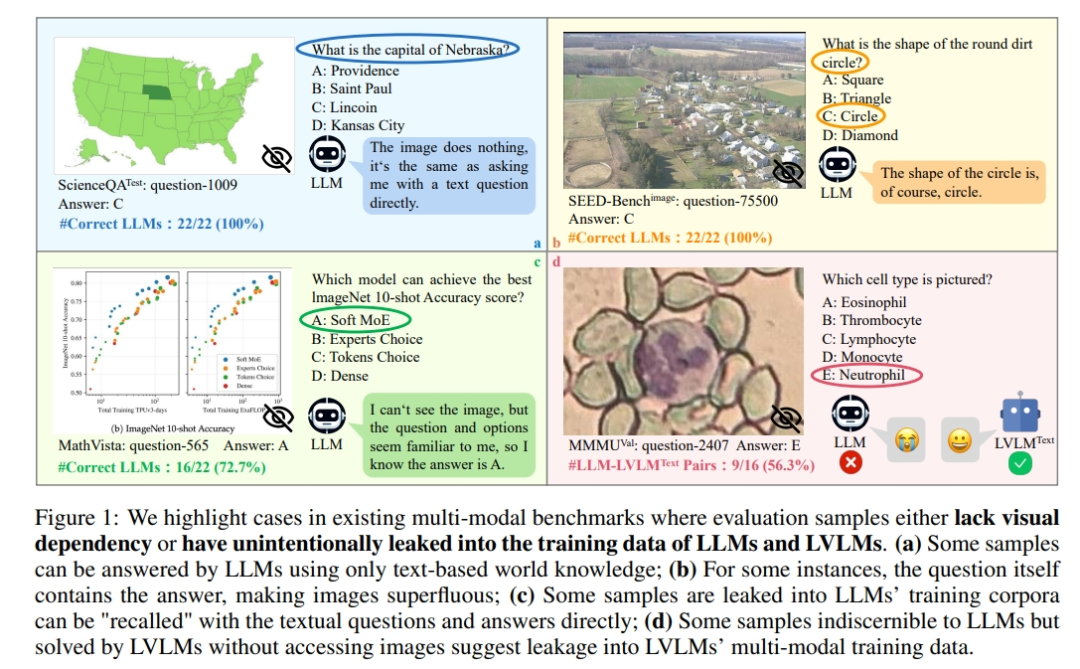

4.MMStar:一种新的大型视觉语言模型评估基准

大型视觉语言模型(LVLM)近来取得了突飞猛进的发展,引发了大量评估其多模态能力的研究。

然而,来自中国科学技术大学、香港中文大学和上海 AI Lab 的研究团队深入研究了当前的评估工作,发现了两个主要问题:(1) 许多样本不需要视觉内容,答案可以直接从问题和选项或 LLM 中嵌入的世界知识中推断出来。这种现象在目前的基准中普遍存在。(2)LLM 和 LVLM 训练中存在无意数据泄露。LLM 和 LVLM 在没有视觉内容的情况下仍能回答一些视觉必需的问题,这表明在大规模训练数据中对这些样本进行了记忆。这两个问题都会导致对实际多模态收益的误判,并有可能误导对 LVLM 的研究。

为此,该研究团队推出了 MMStar,这是一个新的视觉多模态基准,由人类精心挑选的 1500 个样本组成。MMStar 对 6 种核心能力和 18 个细节轴进行了基准测试,旨在通过精心平衡和纯化的样本来评估 LVLM 的多模态能力。这些样本首先是通过自动管道从当前基准中粗选出来的,然后再由人工进行审核,以确保每个精选样本都具有视觉依赖性、最小的数据泄漏以及先进的多模态能力。

此外,他们还开发了两个指标来衡量多模态训练中的数据泄漏和实际性能增益,在 MMStar 上对 16 种领先的 LVLM 进行了评估,以评估它们的多模态能力,并在 7 个基准上使用所提出的指标来研究它们的数据泄漏和实际多模态增益。

论文链接:

https://arxiv.org/abs/2403.20330

项目地址:

https://mmstar-benchmark.github.io/

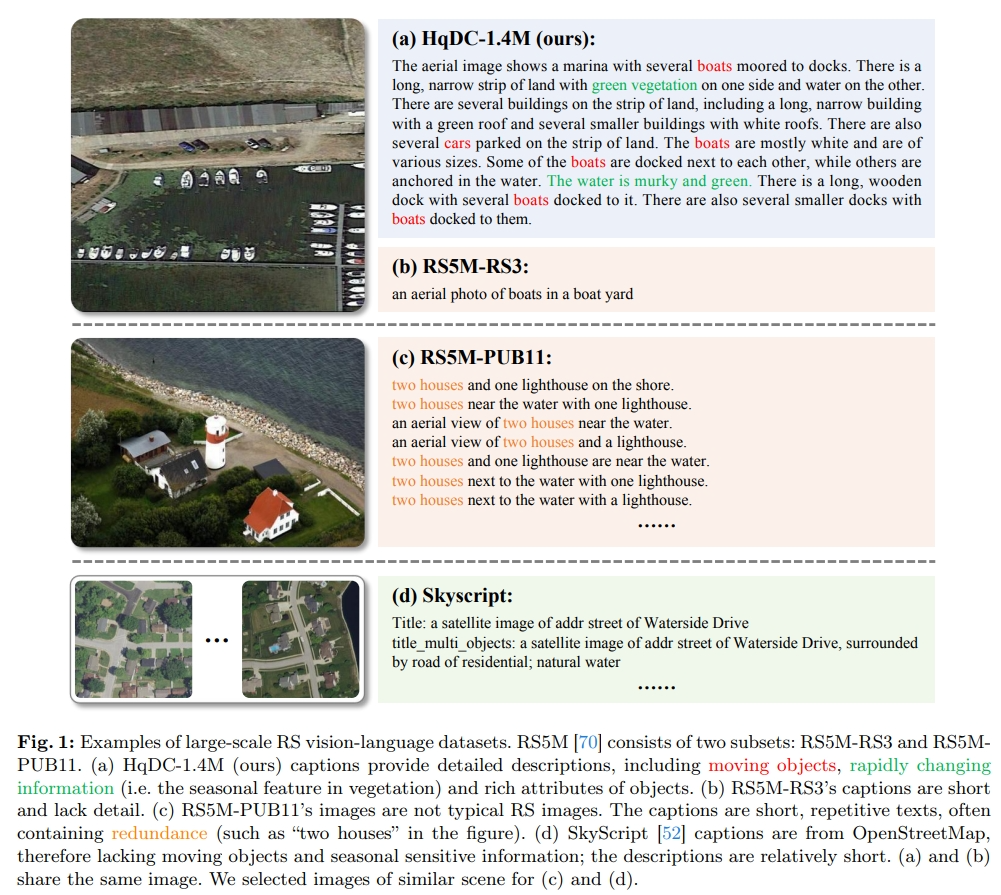

5.H2RSVLM:遥感视觉语言大模型

目前,通用的大型视觉语言模型(VLMs)发展迅速,但在遥感(RS)领域仍表现不佳,这是由于遥感图像的独特性和专业性,以及目前的视觉语言模型的空间感知能力相对有限。现有的遥感专用视觉语言模型(RSVLM)仍有很大的改进潜力,这主要是由于缺乏大规模、高质量的遥感视觉语言数据集。

来自武汉大学和上海 AI Lab 的研究团队提出了 HqDC-1.4M,即大规模高质量和详细的 RS 图像标题,其中包含 140 万个图像标题,这不仅增强了 RSVLM 对 RS 图像的理解,还显著提高了模型的空间感知能力,如定位和计数,从而增加了 RSVLM 的帮助。

此外,为了解决 RSVLM 中不可避免的“幻觉”问题,他们还开发了首个旨在增强 RSVLM 自我认知能力的数据集——RSSA。

通过在典型的 RS 视觉问题解答任务中加入各种无法回答的问题,RSSA 有效地提高了模型输出的真实性并减少了幻觉,从而提高了 RSVLM 的真实性。在这些数据集的基础上,该研究团队提出了H2RSVLM,即 “有用且诚实的遥感视觉语言模型”。H2RSVLM 在多个 RS 公开数据集上取得了优异的性能,能够识别并拒绝回答无法回答的问题,有效地减少了错误生成。

论文链接:

https://arxiv.org/abs/2403.20213

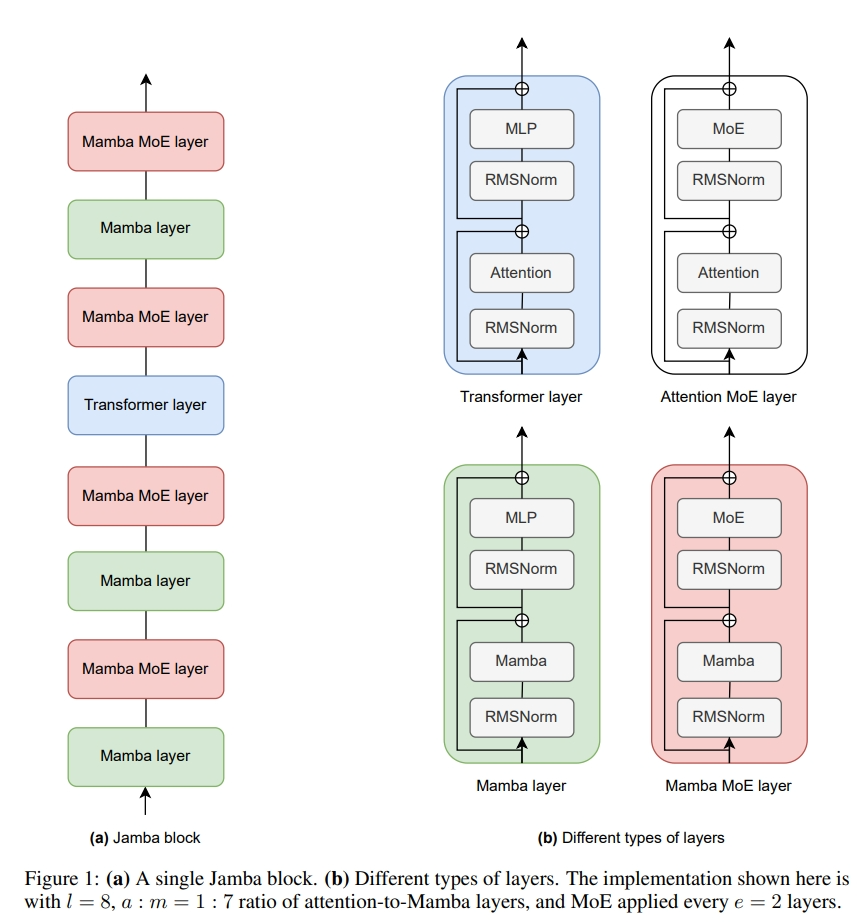

6.Jamba:混合 transformer-Mamba 语言模型

来自 AI21 Labs 的研究团队介绍了一种基于新型混合 transformer-Mamba 混合专家(MoE)架构的新型基础大型语言模型 Jamba。

具体来说,Jamba 将 transformer 层和 Mamba 层的区块交错在一起,同时享受两个模型系列的优势。在其中一些层中添加了 MoE,以增加模型容量,同时保持活动参数使用的可管理性,这种灵活的架构允许针对特定资源和目标进行配置。

在他们实施的特定配置下,最终获得了一个可容纳在单个 80GB GPU 中的强大模型。与 vanilla transformer 相比,大规模构建的 Jamba 可提供较高的吞吐量和较小的内存占用,同时在标准语言模型基准测试和长语境评估中表现出一流的性能。

值得注意的是,该模型在高达 256K token 上下文长度的情况下也能表现出强劲的性能。该研究团队研究了各种架构决策,例如如何结合 transformer 和 Mamba 层,以及如何混合专家,并证明其中一些决策在大规模建模中至关重要,还描述了 Jamba 的训练和评估所揭示的这些架构的几个有趣特性,并计划发布各种消融运行的检查点,从而鼓励对这种新颖架构的进一步探索。

论文链接:

https://arxiv.org/abs/2403.19887

GitHub 地址:

https://www.ai21.com/jamba

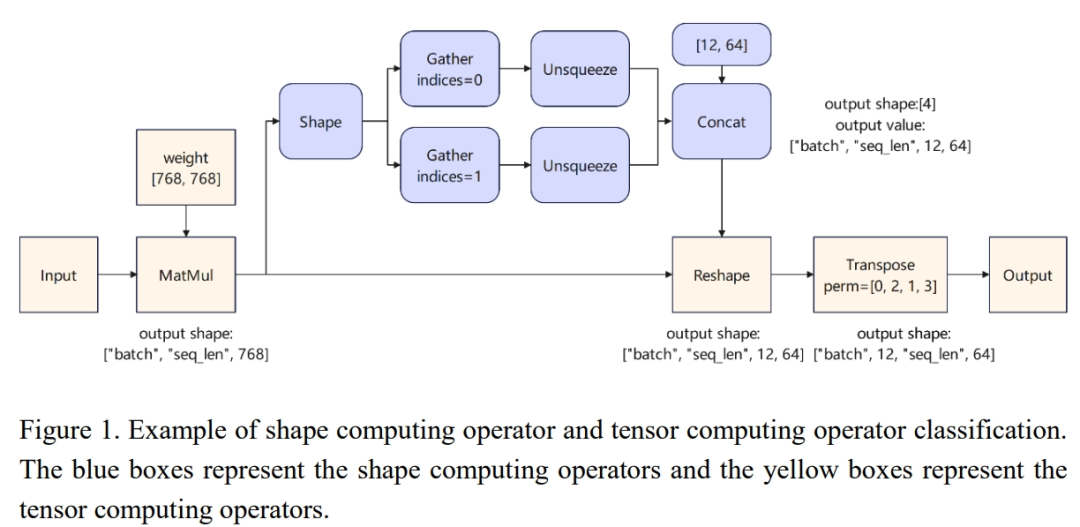

7.Transformer-Lite: 在手机 GPU 上高效部署大型语言模型

大型语言模型(LLM)被广泛应用于手机上的智能助手、文本摘要、翻译和多模态等任务。

然而,在设备上部署 LLM 的方法推理速度较慢,导致用户体验不佳。为了促进在设备 GPU 上高效部署 LLM,OPPO AI 中心提出了四种优化技术:(1)基于符号表达式的方法,以支持动态形状模型推理;(2)算子优化和执行优先级设置,以提高推理速度并减少手机滞后;(3)名为 M0E4 的 FP4 量化方法,以减少去量化开销;(4)基于子张量的技术,以消除在 LLM 推理后复制 KV 缓存的需要。此外,他们还在移动推理引擎 transformer-Lite 中实现了这些方法,该引擎兼容高通和 MTK 处理器。

该研究团队使用不同架构的 LLM 以及从 2B 到 14B 不等的参数对 Transformer-Lite 的性能进行了评估。具体而言,在 ChatGLM2 6B 和较小的 Gemma 2B 中分别实现了 121 token/s 和 14 token/s 的预填充和解码速度,以及 330 token/s 和 30 token/s 的速度。与基于 CPU 的 FastLLM 和基于 GPU 的 MLC-LLM 相比,Transformer-Lite 的引擎预填充速度提高了 10 倍以上,解码速度提高了 2~3 倍。

论文链接:

https://arxiv.org/abs/2403.20041

8.MambaMixer:高效选择性状态空间模型

目前,由于具有数据依赖性和大规模学习能力,深度学习的最新进展主要依赖于 transformer。然而,这些架构中的注意力模块在时间和空间上与输入大小呈二次方关系,限制了对长序列建模的可扩展性。尽管最近有人尝试为多维数据(如图像和多变量时间序列如图像和多变量时间序列)设计高效的骨干架构,但现有的模型要么与数据无关,要么无法实现维间和维内通信。

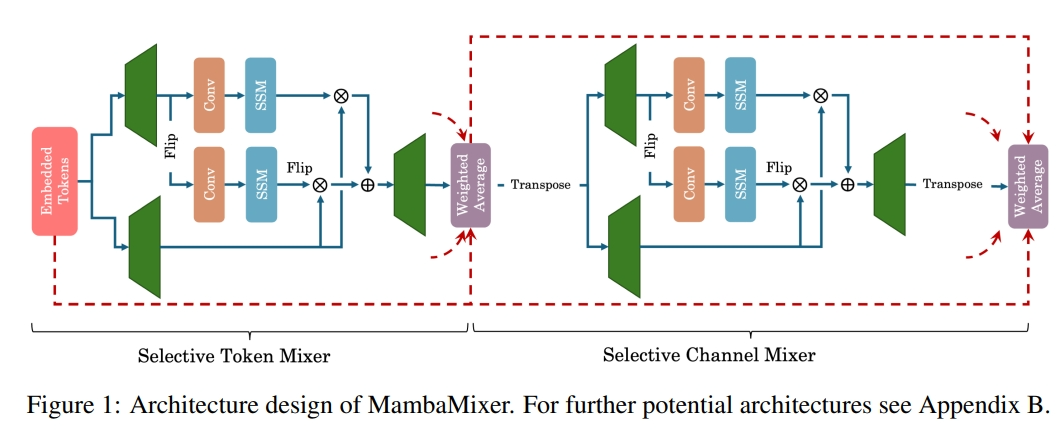

最近,选择性状态空间模型(Selective State Space Models),通过高效的硬件感知,在长序列建模方面显示出了巨大的潜力。受 SSM 成功的启发,来自康奈尔大学和纽约大学的研究团队提出了 MambaMixer,这是一种具有数据相关权重的新架构,它采用了跨 token 和通道的双重选择机制,称为选择性 token 和通道混合器(Selective Token and Channel Mixer)。

MambaMixer 利用加权平均机制连接选择性混合器,允许各层直接访问早期特征。作为概念验证,他们设计了基于 MambaMixer 模块的视觉 MambaMixer(ViM2)和时间序列 MambaMixer(TSM2)架构,并探索了它们在各种视觉和时间序列预测任务中的性能。

该研究团队研究结果强调了在 token 和通道之间进行选择性混合的重要性。在 ImageNet 分类、物体检测和语义分割任务中,ViM2 的性能与成熟的视觉模型不相上下,并优于基于 SSM 的视觉模型。在时间序列预测中,TSM2 与最先进的方法相比取得了出色的性能,同时显著改善了计算成本。

这些结果表明,虽然 transformer、跨通道注意力和 MLP 足以在时间序列预测中取得良好的性能,但两者都不是必需的。

论文链接:

https://arxiv.org/abs/2403.19888

|点击关注我 👇 记得标星|

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง