导语

作为智能唯一的参考系统,对大脑的计算抽象启发了人工神经网络(ANN)模型,而后者在当下的AI领域取得了广泛的成功。因此,当ANN在实际应用中遇到挑战时,从脑中寻求启发成为了一类重要的研究思路。另一方面,进一步理解人类智能的计算逻辑也需要在类脑智能的实际中寻求答案,二者间的相互交流是其发展的必经之路。本次分享从持续学习谈起,探讨类脑智能的三种范式,并邀请一线研究者围绕“启发机器学习算法设计的原则”、“LLM能力”、“如何入门”三个话题进行圆桌讨论。

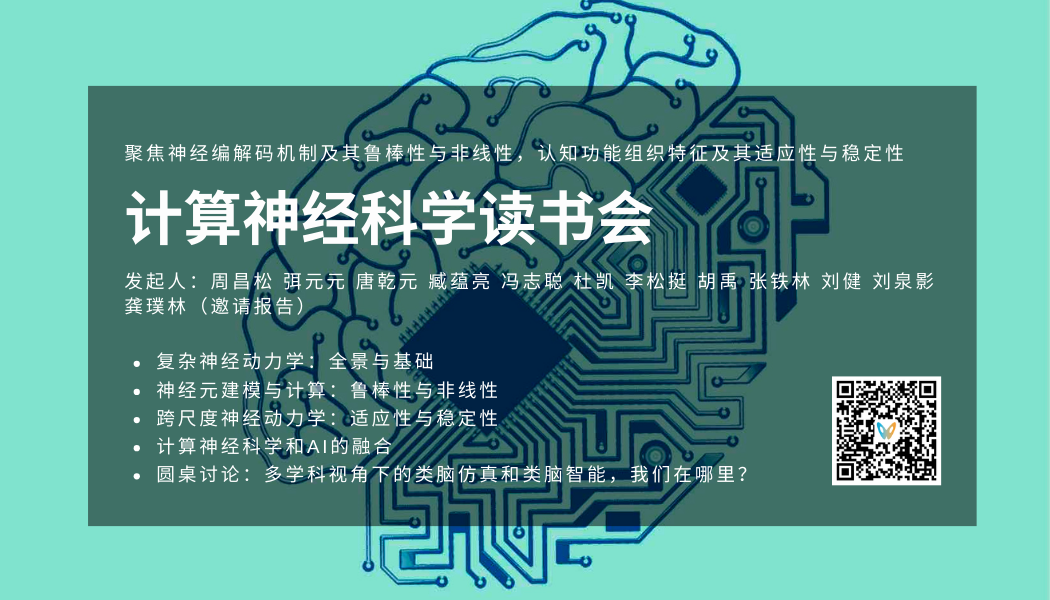

集智俱乐部联合国内外多所知名高校的专家学者发起神经、认知、智能系列读书会第三季——「计算神经科学」读书会。从2024年2月22日开始,每周四19:00-21:00进行,持续时间预计10-15周,欢迎感兴趣的朋友报名参与,深入梳理相关文献、激发跨学科的学术火花!

分享背景

为了应对现实世界的动态变化,智能系统需要具备持续获取、更新、积累和利用知识的能力。这种能力被统称为持续学习或终身学习。作为智能唯一的参考系统,持续学习是生物智能系统在“适者生存”的自然选择过程中形成的重要优势。然而,对于目前的人工智能系统而言却依然十分困难。不同于针对静态数据分布的传统机器学习模型,持续学习需要灵活适应动态变化的数据分布,其中,适应新数据分布通常会导致捕捉旧数据分布的能力大大降低,即造成所谓的灾难性遗忘。

目前有许多方法试图从生物智能的持续学习机制中汲取灵感,包括权重保护、参数隔离、记忆回放等,但主要是孤立地模拟单一机制且依赖于形式上的相似性,难以完全实现持续学习的优化目标。因此,如何更充分地挖掘和利用生物智能在持续学习方面的优势,建立适用于生物智能与人工智能的通用计算模型,是我们长期以来一直在探索的重要课题。

分享简介

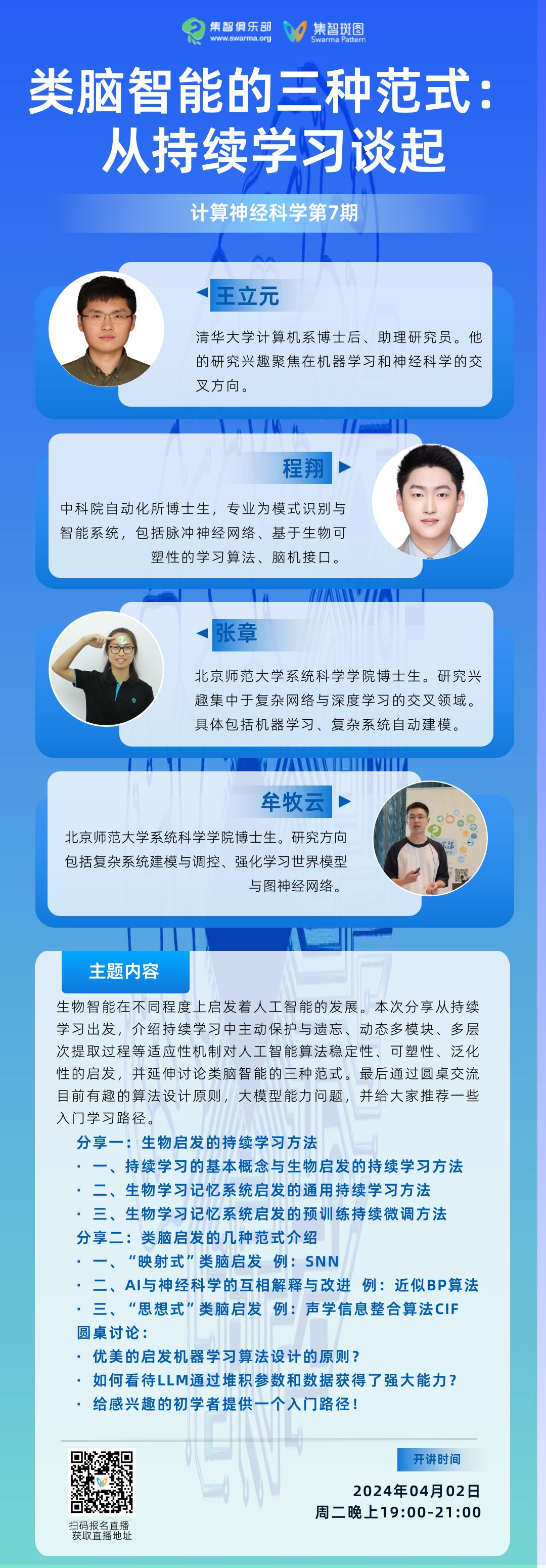

在本次报告中,首先由王立元博士介绍人工智能实现持续学习所面临的主要问题以及生物启发的主流持续学习方法。并结合遗忘的生物学意义、功能和机制,探讨近期的两方面工作。

其一是针对常规的持续学习问题,通过模拟果蝇的学习记忆系统,将主动保护、主动遗忘、动态多模块等适应性机制分别对应到记忆稳定性、学习可塑性、泛化兼容性等持续学习的核心要素。

其二是针对预训练知识的持续微调问题,通过对持续学习的优化目标进行层次化分解,将其对应到哺乳动物的记忆选择性提取过程,并设计计算模型以明确优化分解后的持续学习目标。

然后由程翔博士整体介绍类脑智能研究中的三种范式,并通过若干实例探讨不同类脑方式的利弊。

第一种为“映射式”的类脑启发,即利用生物神经系统和人工神经网络的相近部分,将脑机制映射到模型之中。首先介绍脉冲神经网络(SNN),然后介绍在SNN基础上的类脑启发工作,最后总结这种启发方法面临的挑战。

第二种为AI与神经科学的互相解释与改进。首先介绍反向传播(BP)算法在生物合理性上的问题,以及介绍四类近似BP算法的工作和生物合理性间的联系,然后介绍kenji doya通过强化学习理论对生物决策过程中,脑区和神经调质作用的假设,最后总结这种启发方式的优势。

第三种为“思想式”的类脑启发,即高度抽象脑机制的计算本质,应用到广泛的场景中。以一种声学信息整合算法CIF为例,脉冲神经元模型可以将连续的输入和膜电位转化成离散的脉冲序列,CIF算法借鉴一种整合发放过程,实现了编解码模型中发音边界划分的类似需求,显著提升了语音识别的准确性。这种启发方式跨越了概念上的对称性,具有更普遍的适用性。

最后,不同背景的嘉宾将对生物智能与人工智能的学科交叉范式进行简要讨论。

分享大纲

分享一:生物启发的持续学习方法 一、持续学习的基本概念与生物启发的持续学习方法 二、生物学习记忆系统启发的通用持续学习方法

三、生物学习记忆系统启发的预训练持续微调方法

分享二:类脑启发的几种范式介绍 一、“映射式”类脑启发 例:SNN,以及基于SNN的类脑设计,包括神经元构建、编码方式、结构设计、学习算法(可塑性)等层面 二、AI与神经科学的互相解释与改进 例:近似BP算法、利用强化学习理论解释生物决策

三、“思想式”类脑启发 例:整合发放模型启发的声学信息整合算法CIF

圆桌讨论 一、有哪些您喜欢的启发机器学习算法设计的原则,这个原则来自于哪个领域? 二、我们应该如何看待LLM通过堆积参数量和数据量获得了强大能力这一事实?

三、对于想要了解您的领域的同学来说,您认为最适合推荐给大家的入门读物是什么?

主讲人介绍

王立元,清华大学计算机系博士后、助理研究员,入选清华大学“水木学者”计划。此前,他在清华大学获得理学学士和博士学位,并获得清华大学优秀毕业生、北京市优秀毕业生等荣誉。研究成果以第一作者发表在Nature Machine Intelligence、TPAMI、TNNLS、NeurIPS、ICLR、CVPR、ICCV、ECCV等人工智能的顶级期刊和会议。

研究方向:聚焦在机器学习和神经科学的交叉方向,目前的研究方向主要包括持续学习、终身学习、脑启发AI、以及AI4Science。

程翔,中科院自动化所博士研究生。此前,他在中国科学院大学获得理学学士。研究成果以第一作者发表在Science Advances、IJCAI、Neurocomputing、IEEE TNNLS等人工智能的顶级期刊和会议。

研究方向:模式识别与智能系统,脉冲神经网络、基于生物可塑性的学习算法、脑机接口算法。

圆桌嘉宾

牟牧云,北京师范大学系统科学学院博士生。研究方向:复杂系统建模与调控、强化学习世界模型、图神经网络。

张章,北京师范大学系统科学学院研究生。研究兴趣集中于复杂网络与深度学习的交叉领域。具体包括机器学习,复杂系统自动建模等。

直播信息

时间:

2024年4月2日(本周二)晚上19:00-21:00。

参与方式:

扫码参与计算神经科学读书会,加入群聊,获取系列读书会回看权限,成为计算神经科学社区的种子用户,与社区的一线科研工作者与企业实践者沟通交流,共同推动计算神经科学社区的发展。

参考文献

分享涉及的一些持续学习工作:Liyuan Wang, Xingxing Zhang, Hang Su, Jun Zhu. A Comprehensive Survey of Continual Learning: Theory, Method and Application. IEEE Transactions on Pattern Analysis and Machine Intelligence (TPAMI), 2024. (持续学习领域的全面调研,从机器学习理论的角度梳理了持续学习的优化目标和代表性方法)Liyuan Wang, Xingxing Zhang, Qian Li, Mingtian Zhang, Hang Su, Jun Zhu, Yi Zhong. Incorporating Neuro-Inspired Adaptability for Continual Learning in Artificial Intelligence. Nature Machine Intelligence, 2023. (果蝇学习系统启发的持续学习方法)

Liyuan Wang, Jingyi Xie, Xingxing Zhang, Mingyi Huang, Hang Su, Jun Zhu. Hierarchical Decomposition of Prompt-Based Continual Learning: Rethinking Obscured Sub-optimality. Advances in Neural Information Processing Systems (NeurIPS), Spotlight, 2023. (记忆选择性提取的预训练模型持续微调方法)

脑启发持续学习方面的高质量综述:Dhireesha Kudithipudi, Mario Aguilar-Simon, Jonathan Babb, et al. Biological Underpinnings for Lifelong Learning Machines. Nature Machine Intelligence, 2022. (梳理了终身学习的主要挑战以及与之对应的生物学机制)Raia Hadsell, Dushyant Rao, Andrei Rusu, Razvan Pascanu. Embracing Change: Continual Learning in Deep Neural Networks. Trends in Cognitive Sciences, 2020. (梳理了深度神经网络的持续学习过程与神经科学的联系)

German Parisi, Ronald Kemker, Jose Part, Christopher Kanan, Stefan Wermter. Continual Lifelong Learning with Neural Networks: A Review. Neural Networks, 2019. (梳理了突触可塑性与互补学习系统理论对持续学习的作用)

脉冲神经网络综述:

Aboozar Taherkhani, Ammar Belatreche, Yuhua Li, Georgina Cosma, Liam P. Maguire, T.M. McGinnity. A review of learning in biologically plausible spiking neural networks. Neural Networks, 2020.

程翔所在课题组基于脉冲神经网络的类脑算法工作:Tielin Zhang, Xiang Cheng, Shuncheng Jia, Mu-Ming Poo, Yi Zeng, Bo Xu. Self-backpropagation of synaptic modifications elevates the efficiency of spiking and artificial neural networks. Science advances, 2021.(可塑性逆向传播启发的高能效介观权重学习)Tielin Zhang, Xiang Cheng, Shuncheng Jia, Chengyu T Li, Mu-ming Poo, Bo Xu. A brain-inspired algorithm that mitigates catastrophic forgetting of artificial and spiking neural networks with low computational cost. Science advances, 2023.(神经调制现象在突触和神经元水平的建模)

Xiang Cheng, Tielin Zhang, Shuncheng Jia, Bo Xu. Meta neurons improve spiking neural networks for efficient spatio-temporal learning. Neurocomputing, 2023.(神经元发放模式异质化与网络信息处理能力间的关系)

Hinton对反向传播算法生物合理性的讨论:

Timothy P. Lillicrap, Adam Santoro, Luke Marris, Colin J. Akerman, Geoffrey Hinton. Backpropagation and the brain. Nature Reviews Neuroscience, 2020.

Kenji Doya利用强化学习理论对生物决策过程的解释:

Kenji Doya. Modulators of decision making. Nature neuroscience, 2008.

整合发放模型启发的CIF算法:

Linhao Dong, Bo Xu. CIF: Continuous integrate-and-fire for end-to-end speech recognition. ICASSP, 2020.

计算神经科学读书会

人类大脑是一个由数以百亿计的神经元相互连接所构成的复杂系统,被认为是「已知宇宙中最复杂的物体」。本着促进来自神经科学、系统科学、信息科学、物理学、数学以及计算机科学等不同领域,对脑科学、类脑智能与计算、人工智能感兴趣的学术工作者的交流与合作,集智俱乐部联合国内外多所知名高校的专家学者发起神经、认知、智能系列读书会第三季——「计算神经科学」读书会,涵盖复杂神经动力学、神经元建模与计算、跨尺度神经动力学、计算神经科学与AI的融合四大模块,并希望探讨计算神经科学对类脑智能和人工智能的启发。读书会从2024年2月22日开始,每周四19:00-21:00进行,持续时间预计10-15周,欢迎感兴趣的朋友报名参与,深入梳理相关文献、激发跨学科的学术火花!

详情请见:计算神经科学读书会启动:从复杂神经动力学到类脑人工智能

点击“阅读原文”,报名读书会

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง