OpenAI附议Ilya预训练终结!“但Scaling Law还没死”

Is Scaling is All you Need

白交 发自 凹非寺

量子位 | 公众号 QbitAI

Is Scaling is All you Need?

在Ilya探讨完「预训练即将终结」之后,关于Scaling Law的讨论再次引发热议。

这届NeurIPS将被铭记成预训练终结的一届会议

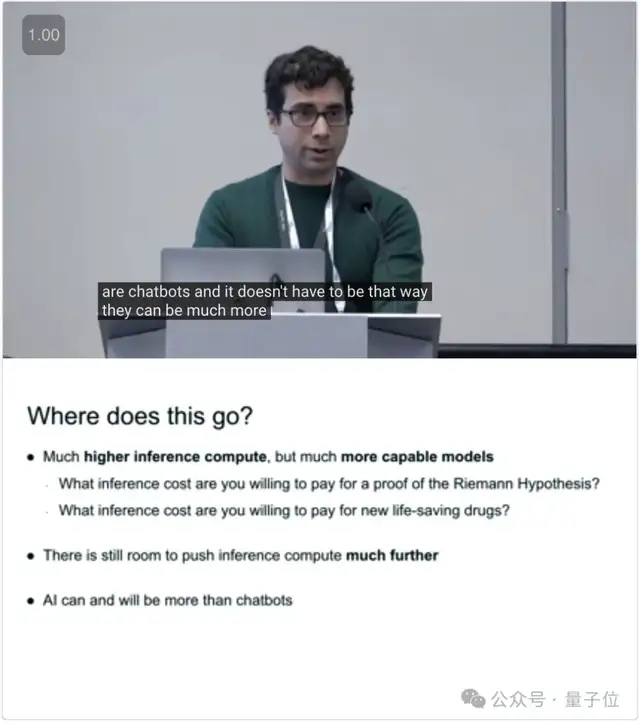

在最新研讨会上,OpenAI大神,o1核心成员Noam Brown表示,o1代表的是一种全新的,以推理计算为代表的Scaling。

网友们表示:好好好,Scaling Law还没有死!Scaling Law还在继续。

演讲实录:Is Scaling is All you Need?

Noam Brown,OpenAI大神一枚,去年7月从Meta离职,曾开发首个在战略游戏中达到人类水平的AI,此前在游戏AI领域相关研究成果曾登上Science封面。

如今在OpenAI致力于多步推理、自我博弈以及多智能体AI相关的研究。

此前在o1发布的直播时候露过面。

据网友@swyx分享,Noam Brown首先谈到Scaling Law的过去演进。

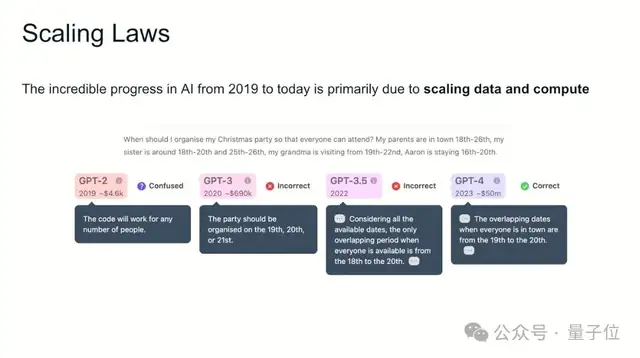

AI从2019年到现在,GPT-2演进到GPT-4,这难以置信的成就都来自于数据和算力规模的扩大。

但大语言模型仍然无法解决像井字棋这样的简单问题,

那么随之而来的一个问题是,Is Scaling is All you Need?我们真的还需要再消耗更高的成本来训练更好的AI吗?

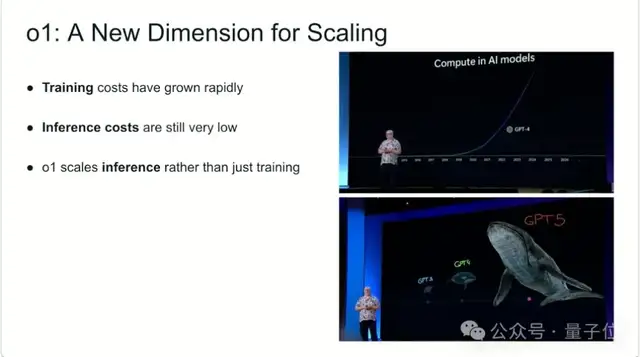

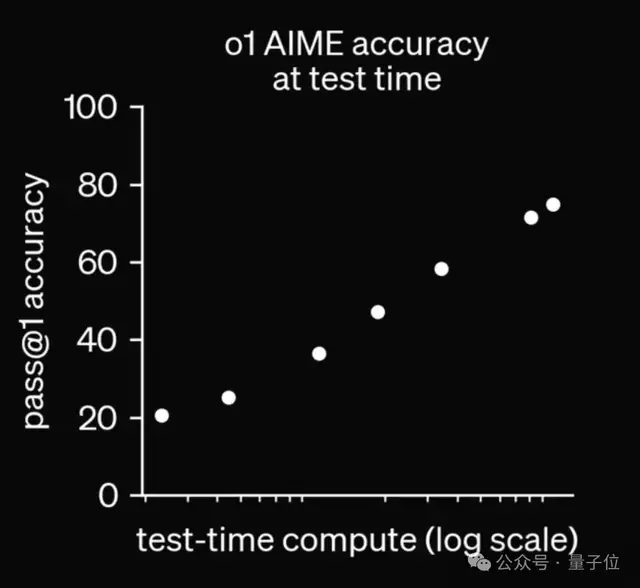

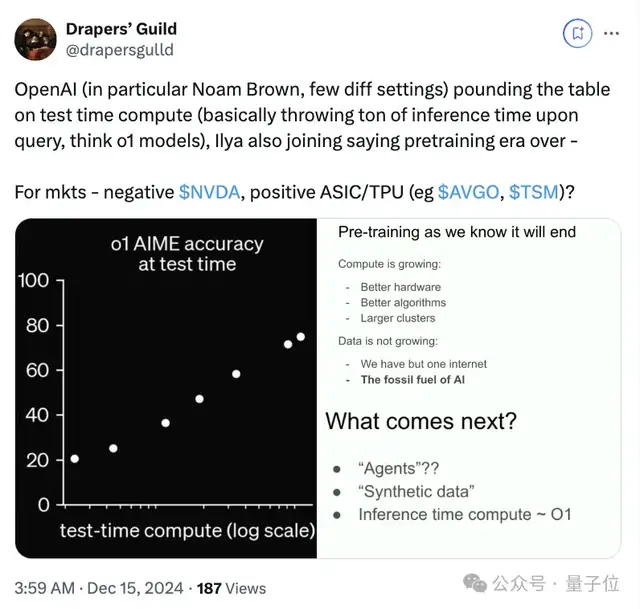

这当中被低估的其实是推理的成本,它在过去的扩展(Scaling)要少得多。o1带来了Scaling的新的维度。

随后,他追溯了过去模型展现出来的类似规律。

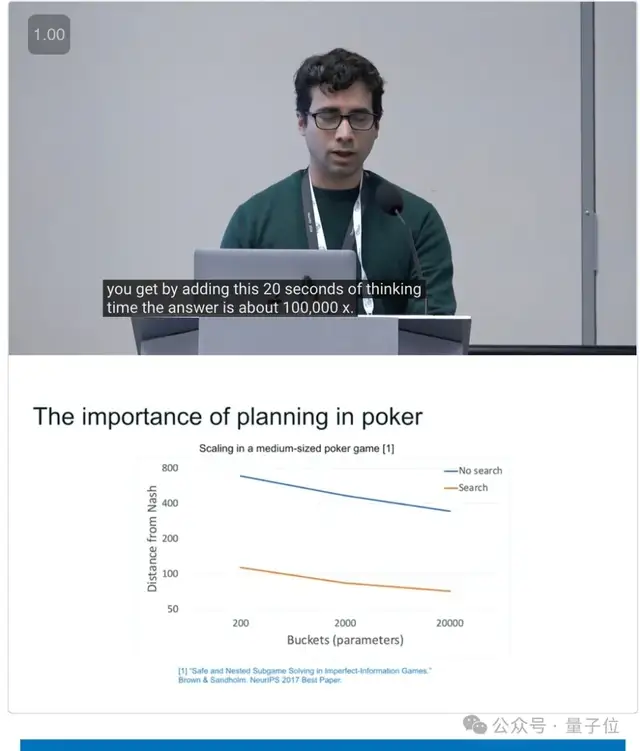

比如在2012年-2015年间扑克模型的扩展。模型规模每年扩展5倍,但收效不大。但依照「人类需要更长时间思考更难问题」这一见解,增加了模型20 秒的搜索时间,效果大致相当于将模型规模扩大了100000倍。

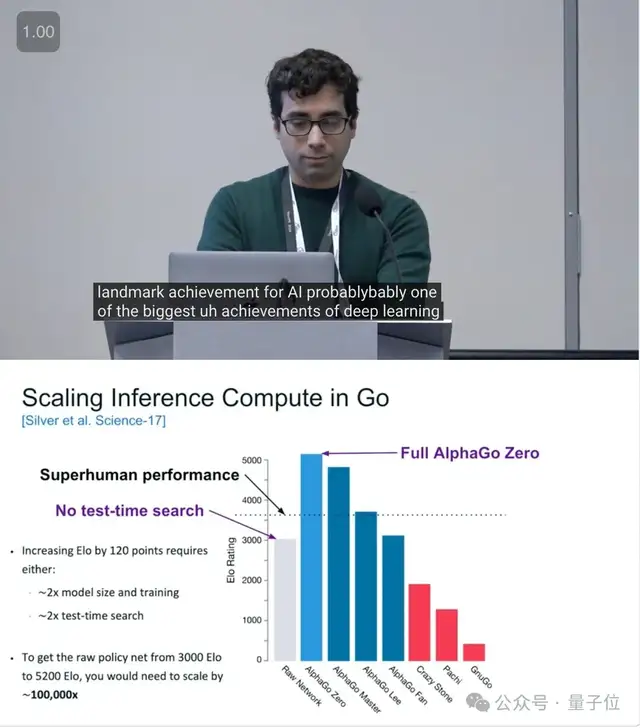

还有在棋牌中扩展推理的历史,backgammon- 国际象棋 – 围棋。AlphaGo Zero在原始NN基础上实现了从3000到5200 Elo增长,都是因为test-time search(推理时间搜索)。

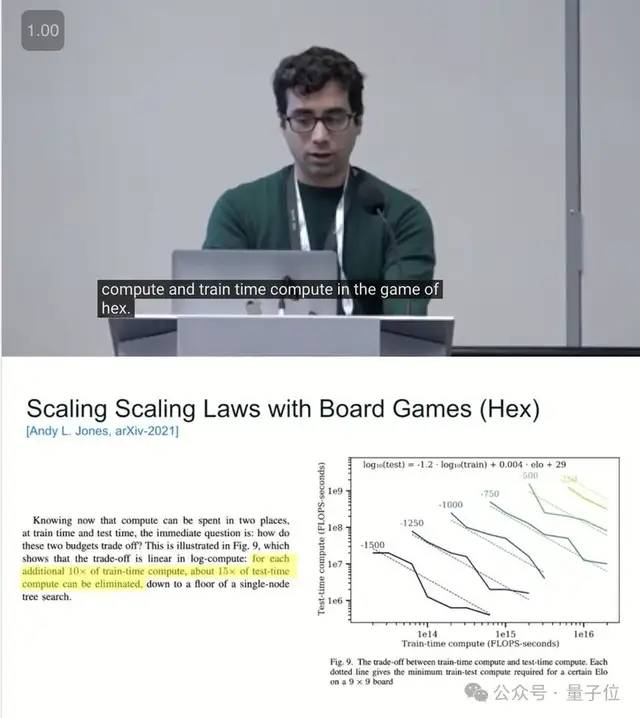

此外,他还引用了Andy L.Jones关于Scaling Laws of games的图表——可以用10倍的预训练计算量换取15倍的测试时间计算量。

如果游戏结果扩展到 LLMs,是不是也会是如此?

那么关于o1接下来,会有更高的推理计算能力。在过去 5 年里,LLM概念就是聊天机器人。那么他们可以做得更好”

最后他还打了个小广告,目前他的多智能体团队还在招人ing。

网友评论

如果再结合昨天Ilya谈到「预训练时代即将终结」。那么对于市场来说,这一波可不是利好英伟达了(Doge)。

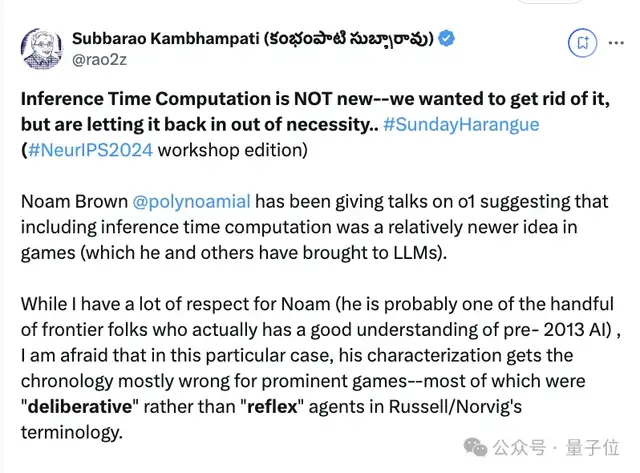

不过也有从业者站出来反对他的看法:推理时间计算(Inference Time Computation)并不新鲜,本来还想把它去掉,但出于需要又让它回来了。

他还纠正说,里面关于诸多游戏时间顺序是错误的,许多游戏(包括国际象棋和围棋)一开始都只专注于推理时间计算。但后来大家都倾向于离线学习策略,这样省去了大量的在线计算时间。

因此,减少面向用户的推理时间计算是一个深思熟虑的选择,甚至导致该领域开始改变对计算复杂性考虑的方式。

这一趋势在 LLMs 中也得到了延续——所有的重点都放在预训练上,因此推理时间的计算量可以忽略不计。这样对终端用户来说成本极低,甚至可以在本地的边缘设备上完成。

Ilya在谈到未来超级智能的畅想时,也提及了当前推理的不可预测性:

推理越多,系统变得越不可预测,这一点在一些复杂任务中表现得尤为突出。

他还提到:

目前的AI系统还不能真正理解和推理,虽然它们能模拟人类的直觉,但未来的AI将会在推理和决策方面展现出更加不可预测的能力。

不过大模型到底会朝着哪些能力上扩展,这个还得看这些科学家们持续探索。

One More Thing

本来啊,从现场repo来看,这本来是个关于数学AI的研讨会,硬生生地被他弄成了讨论大模型推理Scaling Law。

现场也是人很多,据说门口都还有20多个人在排队等待。当然也有部分原因是房间太小了。

参考链接:

[1]https://x.com/swyx/status/1867990396762243324

[2]https://x.com/e__honig/status/1868002417045840243

[3]https://x.com/drapersgulld/status/1868023022390485052

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง