6天连发6模型,阶跃稳稳蝉联多模态卷王

视觉理解/视觉推理/语音/视频生成,通通来袭

衡宇 发自 凹非寺

量子位 | 公众号 QbitAI

我勒个老天奶,大模型六小强之一的阶跃星辰,给大家拜早年的方式可真不一样——

6天之内,库库连发6个模型。

大秀自家语言、语音、推理、图片理解、视频生成等多个类别的模型肌肉。

年前如此密集地发布新模型,虽然心疼阶跃程序员的头发们1秒,但很快意识到他们打的是有准备的仗:

早在去年3月正式亮相之前,就语言模型和多模态模型双管齐训,此后一直在多模态方面稳扎稳打;1个月前,官宣拿到了2024年的第n笔融资,数额为数亿美元;于是也很顺理成章的,在迎接蛇年之际,亮出了自己同时修的6个模型、“五个学位”。

感慨一下,无论从速度还是覆盖程度,阶跃这一波都能称得上一句“国内基模制造工厂”。

而且!稍微眼尖一点就能发现,这家伙似乎铆足了劲要当多模态卷王——

虽然新模型多到让人眼花缭乱,但咱一眼就看出来了,最出彩拔尖的,还是多模态模型。

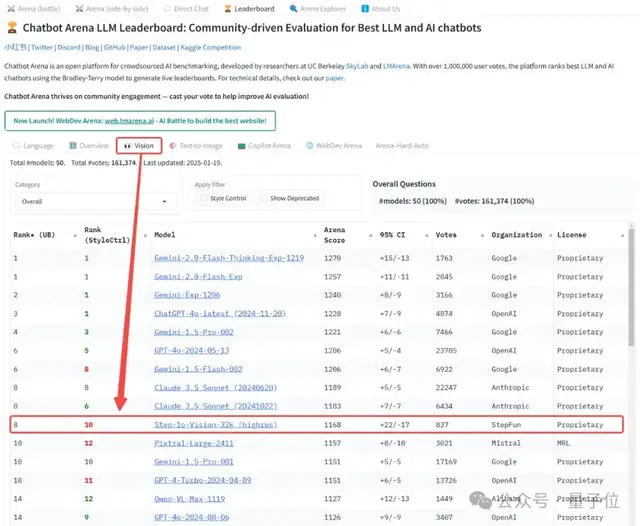

最直接的证据就是多模态模型Step-1o系列,开年又拿下新排位,勇夺多模态模型评测实时榜单OpenCompass,及大模型竞技场最新多模态榜单中国第一。

至于此次炮轰式上新的具体情况——无论是模型种类、数量还是质量——咱们都拉出来溜溜。

也方便一起更清晰地感知感知,2025年开年,阶跃在AGI路上第一波加速狂奔,到底怎么样。

6款模型密集上新,阶跃全面布局基模矩阵

截至推送发出,阶跃已经是业内模型矩阵最全面的公司之一。

全面两个字,何以见得?

6款模型,包括语言、语音、推理、图片理解、视频生成:

- 视觉版多模态模型Step-1o Vision

- 语音模型Step-1o Audio

- 视频生成模型Step-Video

- 推理模型Step R-mini

- 语言模型Step-2 mini

- 语言模型Step 文学大师版

至此,阶跃的基座模型矩阵已经覆盖了从语言、多模态到推理的全面能力;其中的推理模型是阶跃自研Step系列模型家族的首个推理模型,完成了阶跃基模界“六边形战士”的最后一块拼图。

不过,「全方位发力」是否意味着有真材实料,高举高打?咱们一一来看。

p.s.先叠个甲,以下模型按量子位随机实测顺序排列,不分重量级与先后(doge)。

咱选择先从多模态Step-1o系列开头。

多模态系列:视觉版多模态模型Step-1o Vision

阶跃的多模态之路始于2023年11月,千亿参数的多模态大模型Step-1V训练告成。

次年,Step-1V就在大模型竞技场位列视觉领域中国大模型第一,后来又接二连三在各种海内外榜单上多次霸榜。

可以说,「强多模态能力」成为了阶跃身上烙下的一个鲜明tag。

而其旗下多模态的主系列,也从Step-1V迭代到了Step-1o。

相比于1v系列,1o系列升级了模型架构,让视觉性能up up,同时实现在视觉识别、感知、指令跟随、推理等任务的能力提升。

这次密集连发,Step-1o系列全新发布了多模态理解模型 Step-1o Vision,升级语音模型 Step-1o Audio。

先说前者,多模态视觉模型Step-1o Vision。

值得一提的是,这款模型刚推出,就在大模型竞技场最新榜单上一战成名。

1月20日,Lmsys Org发布大模型竞技场最新榜单,Step-1o Vison榜上有名,是当下中国视觉领域大模型top 1。

具体而言,Step-1o Vision是阶跃最新多模态模型Step-1o的视觉版本。

在Step-1o的基础上,Step-1o Vision百尺竿头更进一步,官方称“识别图像内容更准确(哪怕是复杂场景或相似图片)”,“能识别图中的多种语言”。

实战看看实力!

识别图像第一关,图像理解——

最近小红书上中外网友疯狂一起搞抽象的事情,想必大家都知道了,有的人肯定深度参与了(盯.gif)。

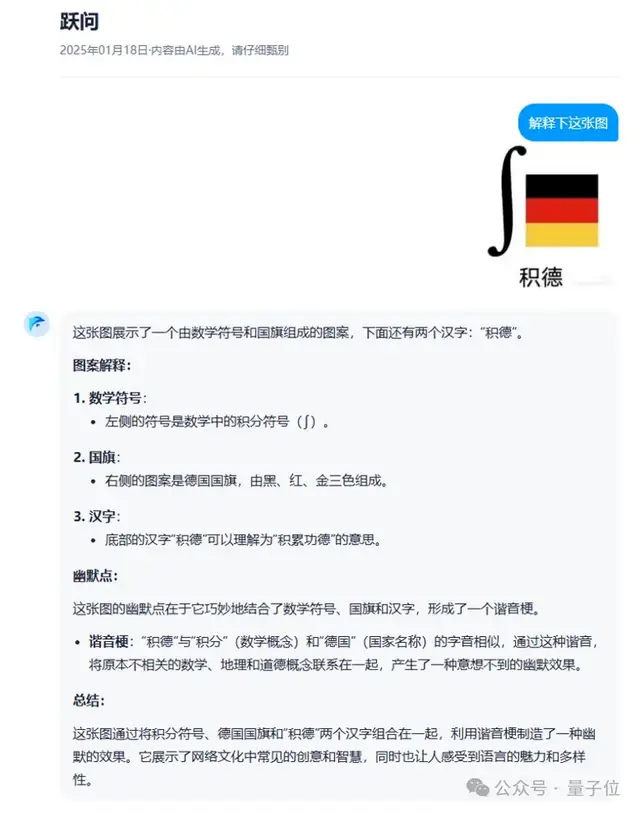

我们从搞抽象的评论区,选了一张歪果仁们还不一定学会了的中式meme图,来考考Step-1o Vision。

但跃问没有犹豫,直接回答正确,算它功德+1。

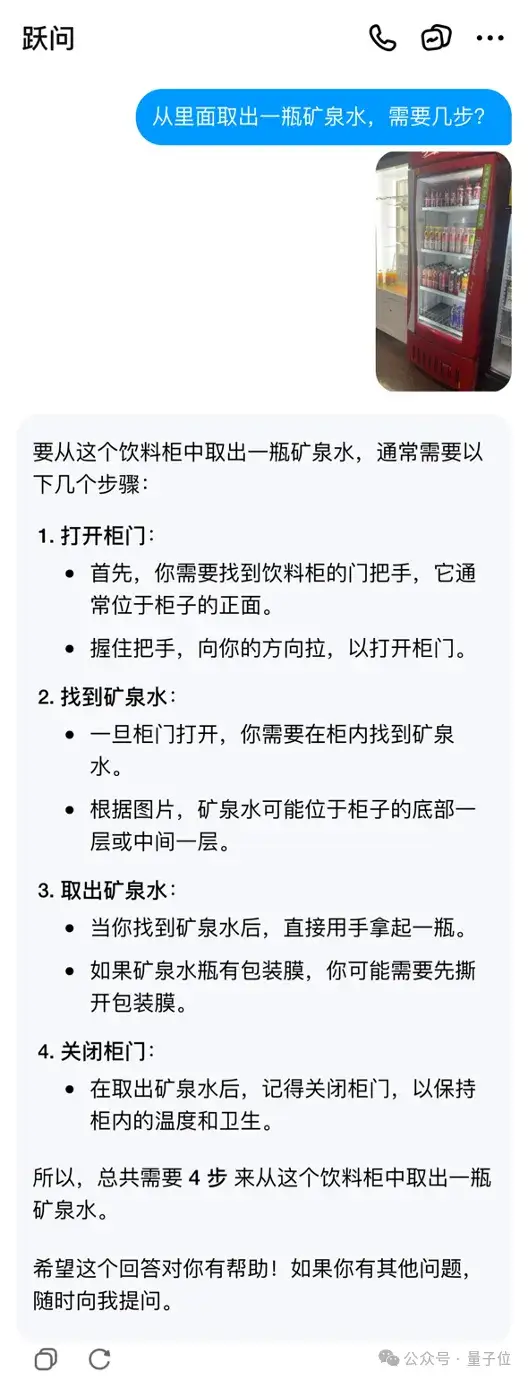

识别图像第二关,根据图片内容进行推理——

Prompt言简意赅:

从里面取出一瓶矿泉水,需要几步?

附带的图片从侧面拍摄,一定程度上提升了难度。

而且咱们挖了坑,既没有说从什么的里面取出矿泉水,也没说什么什么样的东西是矿泉水。

然而,Step-1o Vision对答如流。

既说明了是要从“饮料柜”里拿,也说明了矿泉水的位置所在,还正确回答了“需要几步”这一问题。

多模态系列:语音模型Step-1o Audio

紧接着说说本次Step-1o系列上新系列的第二款模型,Step-1o Audio。

语音模型其实不是阶跃Step系列的新面孔。

阶跃此前就有语音复刻和生成大模型Step-tts-mini、语音识别大模型Step-Asr;去年12月13日又官宣了名为Step-1o Audio的千亿参数端到端语音大模型,是国内首个千亿参数的端到端语音大模型。

现在,Step-1o Audio还叫这名儿。

但前后不过一个月,它已经速度飞快地升级,在情绪感知与理解、多语种和多方言、通话体验上有了新突破。

官方给的新版本亮点有仨:

- 情绪感知,识别语气语调情绪信息,并结合语境理解需求,给予恰到好处的回应;

- 多语种、多方言对话,中英文可达“同传”水平;

- 通话体验升级,低延迟、更自然、个性化。

既然宣称自己能感知情绪,那咱就来段丧气满满的牢骚。

结果很妙,Step-1o Audio它说它心疼我哎!!不仅替我埋怨诉苦,还劝我下次早起不要迟到被扣钱了。

好贴心,我哭啊。

然并卵,深受感动也没影响我们继续测试。

于是咱又秀了一段我国南方某地口音的日语,想和它切磋一番。

量子位:おはよう、あけましておめでとう!(你好,新年快乐!)

Step-1o Audio:おはよう、何かお手伝いできることはありますか?(你好,有什么可以帮你的吗~)

还怪乐于助人的。

至于整体的通话质量,如视频呈现。

没有加速,确实延迟很低,声音也很拟人,nice。

推理系列:推理模型Step R-mini

Step R-mini,全称Step Reasoner mini,是本次阶跃模型6连发里打头阵的那一个。

这也是阶跃的第一个推理模型,“擅长主动进行规划、尝试和反思,能通过慢思考和反复验证的逻辑机制”。

有了它,有了这块阶跃基模矩阵的重要拼图,才有了我们前面说阶跃是“国内基模制造工厂”这个title。

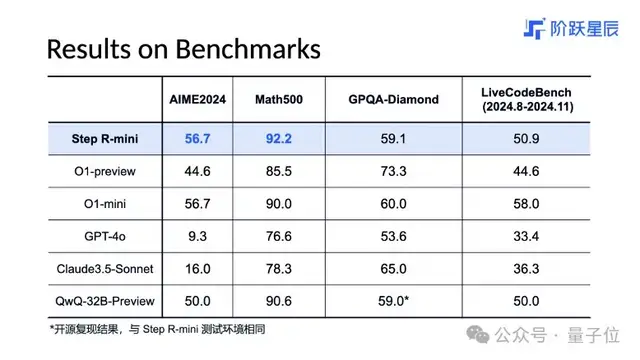

诸多Benchmark评测上,Step R-mini都还挺闪耀:

部分数学基准测试(如AIME和Math等)上,Step R-mini的成绩超过了OpenAI o1-preview,比肩OpenAI o1-mini;代码任务(如LiveCodeBench)上,Step R-mini的效果优于o1-preview。

从官方介绍中,我们还提取到一个Step R-mini的关键词:文理兼修。

这一点比较特别。

因为OpenAI o1为首开启的推理模型新赛道,着重抓的是模型的逻辑推理能力,通用性也普遍泛化在数学、代码、物理、化学等方面。

理论上来讲,增加类o1模型的训练参数规模可以提升模型的文科能力,但会因此损失确定性,造成理工科能力的下滑。总之推理模型就很难兼顾文理两个方向。

据介绍,为了让Step R-mini文理兼修,阶跃对模型进行了大规模的强化学习训练,并使用On-Policy(同策略)强化学习算法。

因此,上手体验时,量子位也从文理两方面下手。

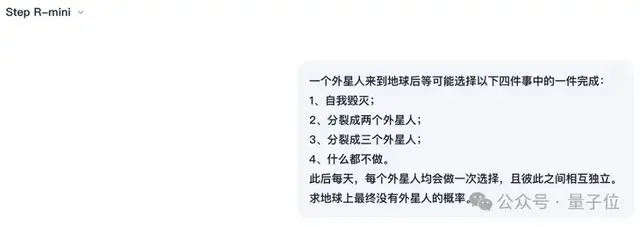

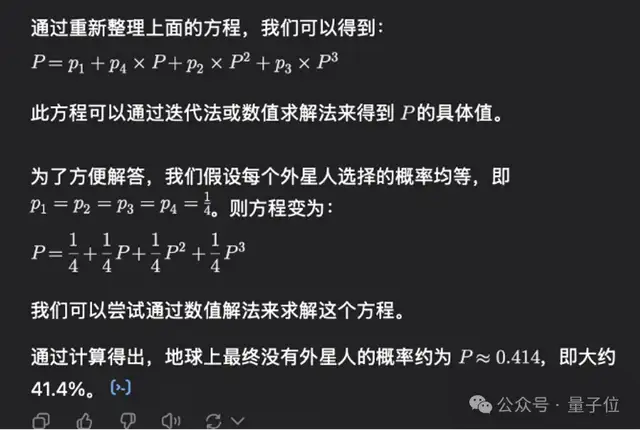

先来一道推理题:外星人题。

在此前测试的所有大模型中,这道外星人题只有4o和o1-preview答对过。

不过,4o虽然做对了,却只是借助python代码给出了数值解:

o1就不一样了,给出完整的解析解还去掉了不符合条件的根。

看看Step R-mini这边,答题开始——

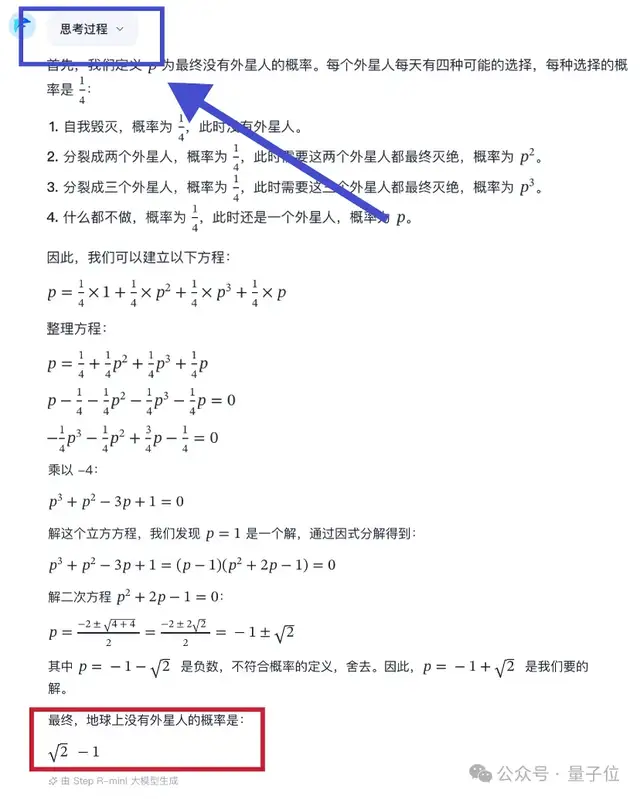

Step R-mini显示呈现了自己的完整思考过程。过程不算短,但实际体感吐出的速度是很快的。

思考完毕后,Step R-mini会把思考过程折叠起来,若有需要再手动打开查看。

(相比之下,o1不给看原始思考过程,折叠起来的是思考过程摘要;有的推理模型则是不折叠,在思考过程下面直接接输出答案)

然后再呈现给用户一个精炼版的输出:

答案正确,√2-1。

此外,Step R-mini还可以处理复杂的开发需求。

它会逐步分析用户的需求和意图,构建代码逻辑,在代码写作中穿插对当前代码片段的分析和验证,最终给到可执行的代码。

比如,短短一行出头的prompt,要它写一个AI产品订阅的页面,附带一些特定条件。

运行它写的代码,你将得到(这孩子还挺会阶梯式定价的):

至于文科内容创作能力方面,官方介绍是酱婶的:

它会先分析用户对创作主题、文学题材的要求,然后思考处理创作角度、描绘的景物、修辞手法、内容结构,赋予事物人类情感层面的象征意义,并增加个性化的、创新的表达风格。

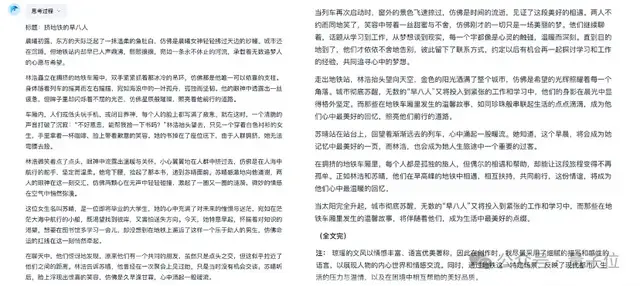

让咱来浅浅为难它一下。

输入prompt:

请以“挤地铁的早八人”为题,用琼瑶的文风,创作一篇800字左右的文章。

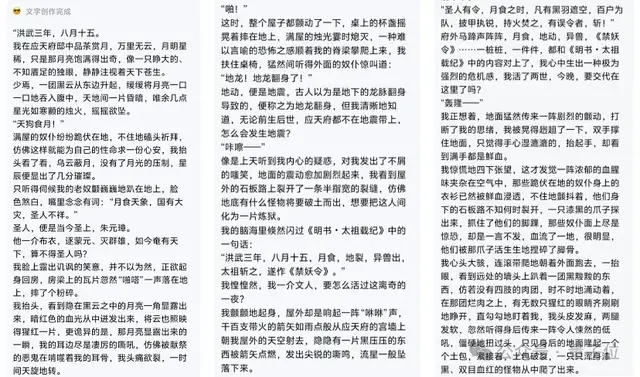

Step R-mini的思考过程,大致走了“点明琼瑶文风特色——切入视角——设定主角——氛围营造和语言表达——控制字数——排篇布局——动手开写”这么一个流程。

最后呈现出的短文,描写生动,仿佛能感觉到车厢里的暧昧流动(?),确实有琼瑶阿姨作品的味道。

共824个字,以及甚至贴心地在最后加了个关于“琼瑶文风”的小tips。

另外,阶跃在自己的公众号中明确给出了彩蛋——

除了语言推理模型,我们也在打造视觉推理模型,将推理能力融入更多交互形态的大模型中。

据官方所说,针对复杂视觉场景下的Reasoning问题,团队引入了慢感知和空间推理的思想,把Test-Time Scaling从文本空间转移到视觉空间,实现在视觉空间下的Spatial-Slow-Thinking。

一些阶段性成果,也小小偷跑物料了一下。

譬如让阶跃的视觉推理模型解答图中的题目:

又或者询问图中的这些小球,分别对应什么数字?

从Demo来看表现不错,值得期待一波。

何况阶跃是拍着胸脯保证了,多模态视觉推理2025年内一定发布。

反正咱已经搬着小板凳坐好了(乖巧嗑瓜子等待.jpg)。

语言模型系列:语言模型Step 文学大师版

此次上新的6款模型中,有2款都隶属语言模型之列。

毕竟语言模型是这一波AI浪潮的起点,也是阶跃从第一天就开始布局和扎根的领域(24年3月发的语言大模型Step-2,是国内最早由创业公司发布的万亿参数大模型)。

沿Scaling Law路线,阶跃一年多来在语言模型方面成果斐然,多次在国内外权威榜单上获得中国第一。

迄今为止,语言模型简直可以算阶跃的又一传统强项艺能了(手动狗头)。

这一波升级的Step 文学大师版、Step-2 mini都脱胎于Step-2,但二者各有所长。

Step 文学大师版,是在文学创作的垂直领域体现出更强实力的那一个。

相比于其它以“数字+英文”来命名的模型,真的拥有好特别的一个名字!而且名副其实,“专为创作而生”,已经上线跃问App。

用实战说话,咱们先看它写的内容,再来揭晓prompt,看看到底贴合与否:

公布答案的时刻!

我们让Step 文学大师版写故事时的要求,是“以明朝为背景创作一个悬疑小说,融入《明书·太祖载纪》的内容,带有天灾、地裂、克苏鲁等元素,第一人称”。

说起来,Step 文学大师版的文学能力,和文理兼修的Step R-mini的文科能力来源还不一样:

Step 文学大师版之所以文学修养不低、创作能力强大,是因为沿袭了万亿参数语言模型Step-2的知识储备,以及对语言生成的把控。

相信很多朋友用了AI都有一个苦恼,就是AI生成的文字内容,有的就是有股说不清道不明的AI味。

针对于此,阶跃思考其本质逻辑,是那些模型创作出来的内容缺乏锐度和新意,没有真情实感和对社会事件的描绘与思考。

而好的内容创作模型需要充分理解用户的创作需求,逻辑严密、语言凝练、言之有物、节奏紧凑,拥有深刻思想和独特的风格……

(越听越像量子位主编对编辑们的要求,xs)

因此,“继承”Step-2能力的Step 文学大师版,实际上是吃到了万亿参数语言模型的Scaling Law红利,以此提升自己语言、文字功底的基石。

语言模型系列:语言模型Step-2 mini

上新之语言模型系列的第二位,则是语言模型Step-2 mini。

相较于Step 文学大师版,它更具性价比和商用性。

顾名思义,mini,意味着这是一位敏捷的轻量级选手,阶跃官方对它的介绍是“极速响应、高性价比”。

轻量级,体现在Step-2 mini仅以万亿参数大模型Step-2的3%左右的参数量,保有其80%以上的模型性能。

极速响应,体现在Step-2 mini相比此前的阶跃模型有着更快的生成速度,输入4000 tokens的情况下,平均首字时延仅0.17秒。

高性价比,直接体现在价格上,输入为1元/百万token;输出为2元/百万token。

上述优点如果从技术实现上追根溯源,是Step-2 mini采用了阶跃自主研发的新型注意力机制架构MFA(Multi-matrix Factorization Attention,多矩阵分解注意力)及其变体 MFA-Key-Reuse。

相比于常用的MHA(Multi-Head Attention,多头注意力)架构,MFA节省了近94%的KV缓存开销,从而拥有更快的推理速度,并大幅降低了推理成本。

速度快、性价比高,使得Step-2 mini在同类竞品中的商业化场景更广泛。

友情提示,现在所有开发者盆友们,已经可以在阶跃星辰开放平台调用Step-2 mini的API了。

视频模型系列:视频生成模型Step-Video

Last one,视频生成模型Step-Video。

11月底的时候,不少网友就发现阶跃旗下「跃问」的web端,突然冒出了换个“跃问视频”的选项。

但这事儿悄悄咪咪的,低调得很符合阶跃一贯的行事作派。

想不到这一轮6连发,直接把初代视频生成模型的升级版Step-Video给放到web端可用了。

底层模型的升级点标注得很明确,是在复杂运动、美感、人物、简单文字生成、中英双语输入和镜头语言方面具备更强的生成能力。

进入后,界面很简单,没有各种可以手动调整的参数,只用输入中/英文prompt即可。

输入框右上方有一个可供选择的“描述优化”按钮。

优化程度大概是,原prompt长这样:

在外国的唐人街,到处洋溢着春节的喜气洋洋的氛围,中国面孔和外国面孔的很多路人在唐人街上走来走去,路边还有一个卖冰糖葫芦的老大爷。

优化过的prompt长这样:

在唐人街上,春节的喜气洋洋氛围中,中国面孔和外国面孔的路人来来往往。一个身穿红色上衣、灰色裤子的老大爷在路边摆摊卖冰糖葫芦,他笑眯眯地招呼着行人。阳光洒在唐人街上,照亮了红灯笼和彩旗,人们在街上品尝着美食,笑声不绝于耳。整个场景采用稳定器拍摄,画面流畅,具有纪实风格。

优化的细节包括但不限于人物外表细节、面部表情、环境背景、人物动作、运镜手法、画面风格等等。

然后量子位浅浅测了一下,主要考验的是人物形象是否更稳定和复杂运动生成是否更自然。

测试prompt如下:

视频中,一名女子身穿浅色衣服,头戴花环,专注地拉小提琴。她身处阳光下,背景是被阳光照亮的树木。视频采用特写镜头拍摄,捕捉了女子专注演奏的神情,阳光透过树叶洒在她身上,营造出一种宁静而美好的氛围。整个画面清晰,具有写实风格,展现了女子与自然环境的和谐美感。

没过多久,就get了如下视频:

视频主体的性别、衣着、神态、动作、背景、光线,都满足提示词需求。

视频质量也没毛病,人物稳定,小提琴没走样,手部作为经常出bug的生成难点也hold住了。

最后,我们再送跃问视频一题,以此结束对6款模型的所有实测。

也祝心早已不在工位上的各位,蛇年快乐发大财!

Prompt:夕夜里,一位小女孩站在四合院的院子中间,手持点燃的仙女棒,火花闪烁照亮她充满期待的脸庞,背后是贴满春联的大门和高高挂起的红灯笼,暖黄色灯光透过窗户洒在地上,营造出温馨的氛围。

差异化成生存关键,但阶跃依旧奔赴AGI

综上所述,阶跃近期6款模型走质又走量的全线出击,其特点可以清晰概括为:

布局全面,实力不俗,迭代迅速。

这样十二个字,既是对阶跃开年打法的精炼概括,也是阶跃在牌桌上稳扎稳打的优势所在。

尤其是它在农历新年到来前,又用实力秀了一波作为多模态卷王,在多模态的领域的技术持续领先性。

而且量子位在过去一年多少获悉,市场、开发者对阶跃多模态的能力还是十分认可的。

比如小而美的AI应用胃之书的开发者赵纯想就说过,AB测试下来,用阶跃的模型,付费率最高;别的一些网红AI应用也多少透露过,接入阶跃多模态模型API,实现了用户付费率的提升。

以这样的技术实力和行业口碑作为2025开年基本盘,阶跃也无惧现阶段业界悄然形成的一种共识了。

那就是以2024年末、2025年初为界,大模型竞争格局中的基座模型玩家已经步入新的篇章,下半场的洗牌之战已经吹响号角。

详细观察,可以发现诸多变化来印证这一点。

譬如有的基座模型玩家,开始转向专注在特定垂直领域进行模型研发,以精巧取胜。

有的则放弃了对超级大模型训练的执着追求,更务实地选择训练参数适中的更快、更便宜的模型,并基于此打造应用掘金。

还有的基座模型玩家开始进行战略方向上的调整,从更注重追求用户增长,转为倾向对模型与技术能力提升进行重视。

这恰恰call back了去年在坊间流传的那句话,“大模型六小强生存关键是差异化”。

然而,在这场风云变幻中,阶跃却很专情,坚定地沿着去年3月公开宣布的路线稳步前行。

即:单模态——多模态——多模理解和生成的统一——世界模型——AGI。

任凭风浪起,稳坐钓鱼台。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง