实测商汤实时音视频交互模型5o:“造假”齐白石《虾》一眼识破!

商汤在交互这块玩了个大的

金磊 发自 凹非寺

量子位 | 公众号 QbitAI

跟AI交互这事儿,商汤最新发布的大模型,是有点“够快、够准、够好”在身上的。

例如我们给它看下面这张画:

我们人眼是能够看出来这张照片是拿真的虾摆在纸上,“造假”齐白石的名画;但很多AI却是识别不出来。

那么商汤最新的大模型是否可以一眼识破呢?

嗯,AI不仅识别出了照片里的都是真虾,而且还猜出了另一种可能,高仿真模型。

再来给这个AI看一张繁体的书法作品,看看它能不能hold得住。

AI成功地看懂了这张书法作品内容是“宁静致远”,而且当问及为什么会从右往左读时,它也精准地回答出了“因为这是一幅书法作品”。

而这个商汤最新发布的大模型,名叫日日新融合大模型交互版(SenseNova-5o,下文简称“新5o”),主打的就是用全新的多模态能力把跟AI交互的质量给拔高上去。

其实从刚才的两个例子中,我们就不难发现,“新5o”是有一些不一样的亮点在身上的。

例如AI交互被很多人诟病的延迟问题,“新5o”已经把它缩短至2秒以内,这种feel就跟真人交流没有太大的差别。

再如交流过程中的真实度,一些语气助词、拟人的停顿感,还有情绪的模仿,都是较为逼真。

并且以前AI可能识别困难的任务,“新5o”这次也能轻松驾驭。

而之所以能够如此,是因为商汤在底层技术上玩出了“新花样”——国内首个原生融合多模态模型。

一言蔽之,不是简单的融合,也不同于以往的“看”和“想”,是可以真正帮人类解决更加复杂的问题。

值得一提的是,现阶段APP是已经可以免费测试使用,不限次数的哦~

那么商汤日日新融合大模型交互版,还能解锁什么新玩法?

一波实测,Let’s Go!

一手实测在此

在跟AI交互的过程中,其实记忆力也是影响体验的关键因素。

因此,我们第一轮实测就来看看“新5o”的记忆力如何。

记忆力不少于5分钟

我们准备了几张菜、食材的照片,先挨个问下“新5o”:

可以看到,“新5o”精准地识别出了它们的名字;在最后报菜名的环节中,也准确按照顺序把此前看到的菜品和食材报了出来。

值得一提的是,整个过程我们是随时打断“新5o”的回答,它也是做到了秒停秒回答,所以实时对话这块还是很OK的。

至于“新5o”的记忆力能持续多久,根据官方给出的数据,它可以支持超长多模态交互记忆不少于5分钟!

这个时长在业界来说绝对算是第一梯队的那种。

这一能力的展现,所考验的不只是对信息的存储功能,更是一种深入的理解与回忆能力。

用户所提出的任何细节问题,以及在交流过程中的那些不经意的信息点滴,“新5o”都能做到清晰存储,并且能够在任何时刻迅速回忆起相关内容。

尤为重要的是,“新5o”的记忆范围并不局限于短期的对话内容;它具备持续跟踪和积累用户交互信息的能力,通过这种方式,不断对用户需求的理解进行完善和优化。

能玩“大家来找茬”

在记忆力之后,我们再来考验一下“新5o”的眼力如何。

这次我们直接一张大家来找茬伺候:

再来看下“新5o”的表现吧:

“新5o”先是根据图片的环境,猜出这是1980年,然后在问及有哪些电器或者物件不符合这个年代时,它的答案有:

洗衣机、电饭煲、LED灯、空调、羽绒服、茅台酒、手机、海报。

嗯,可以说是有理有据的把大部分的“茬”给找了出来。

那么你觉得还有哪些是“新5o”没找出来的?可以在评论区留言哦~

做题也能用“问”的

如果一个AI能说、能看,那么拿物理这样图文并茂的题目做测试,就再适合不过了。

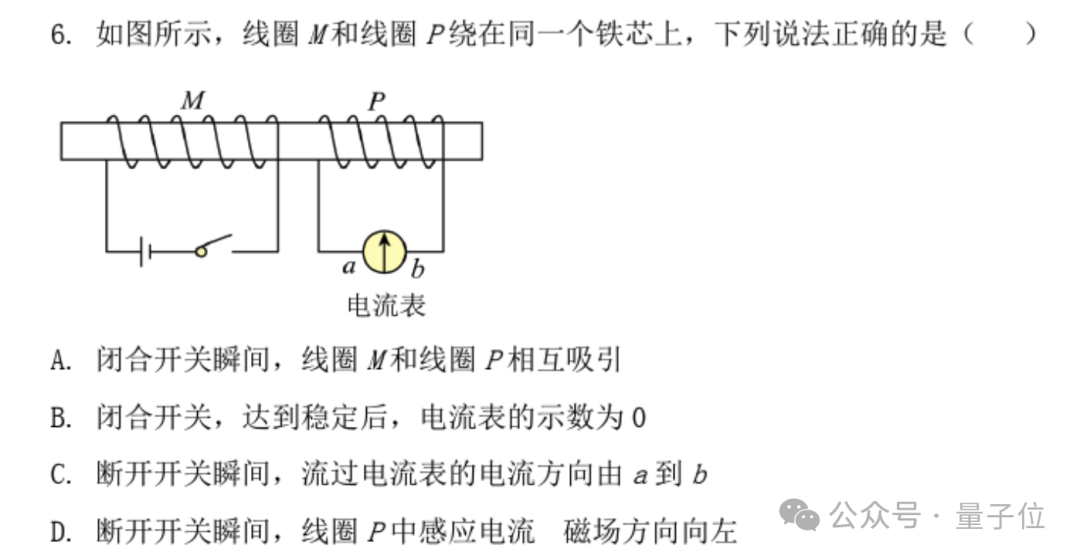

请看题目:

这是2024年北京高考物理的一道选择题,我们让“新5o”看一眼,然后提出问题:

这道题该怎么做?

“新5o”先是挨个把答案都过了一遍,把A、C和D选项排除,选出了正确答案B。

当我们进一步问“为什么是B”后,它就会对正确的答案做深入地解析。

像复杂的神经网络架构图,“新5o”也是可以一眼认出并做讲解:

让“新5o”和GPT-4o做对话

最后,我们再来一个有意思的测试——

让“女声-新5o”和“男声-GPT-4o”来一场双AI之间的对话:

从这场双AI的对话中,我们可以明显看出,两个AI的语气拟人程度都属于比较自然的那种。

而“新5o”略胜一筹的便是延迟,基本都能控制在2秒以内,但GPT-4o有几处的延迟时间差不多是4秒。

总而言之,从种种测试来看,“新5o”在看、说、想这种多模态交互能力上,是已经做到了非常丝滑。

那么接下来的一个问题便是:

商汤“新5o”是如何练成的?

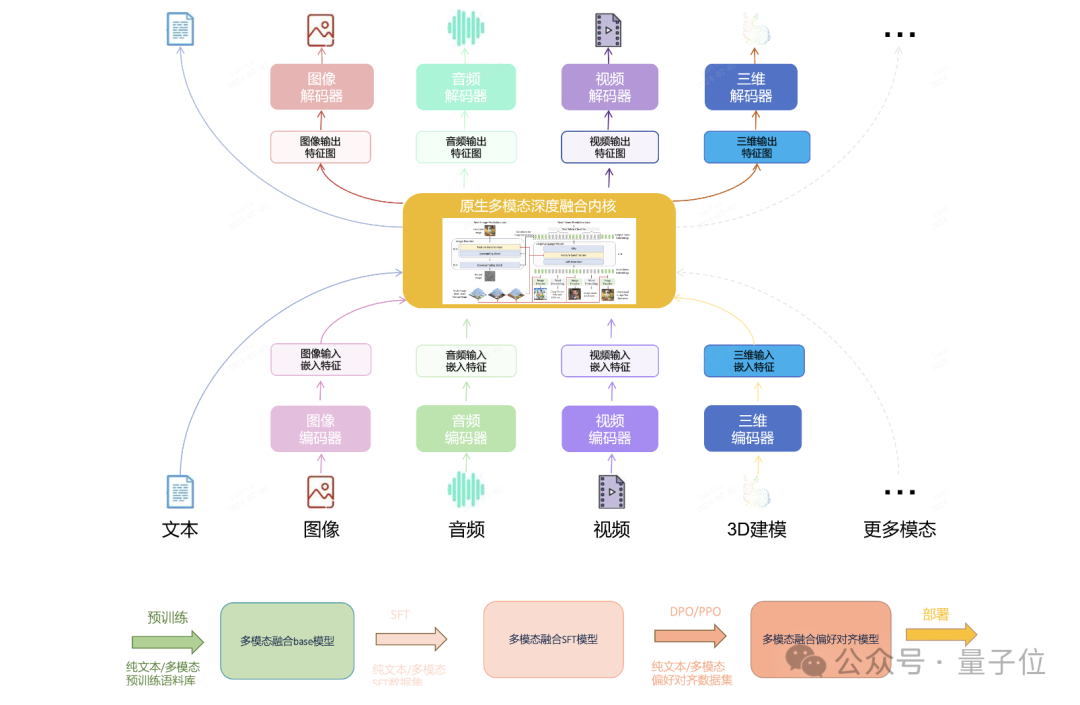

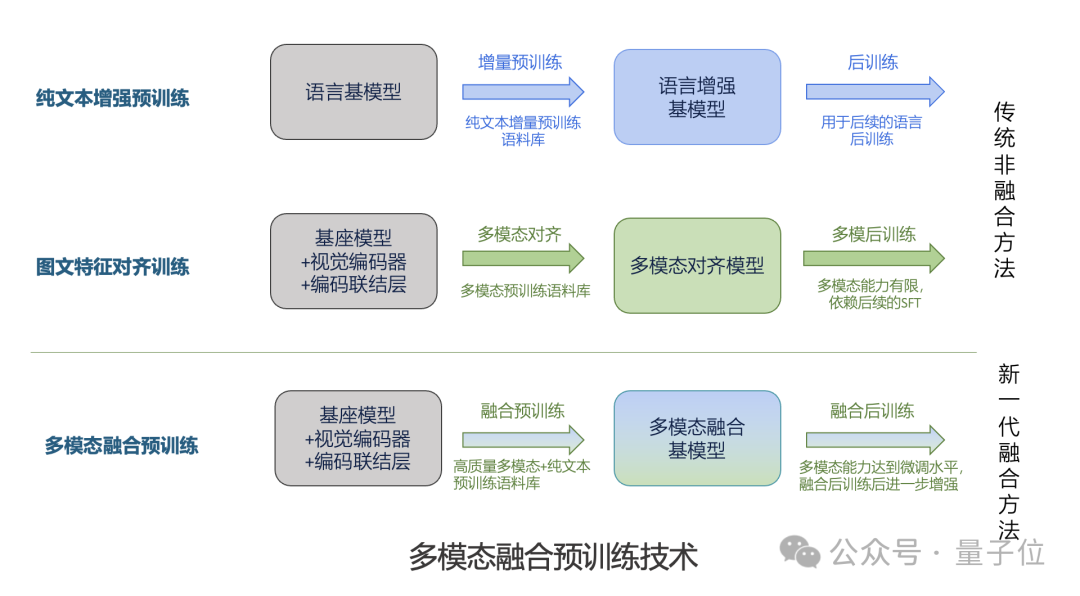

正如商汤“新5o”的全名日日新融合大模型交互版,关键就是其背后的国内首个原生融合多模态模型。

那么,到底什么是原生融合多模态?

这是一种能够将多种模态信息(如文本、图像、视频、音频等)在模型架构和训练过程中进行深度融合的AI模型架构。

与传统的将语言模型和多模态模型分立的方式不同,它致力于打破模态之间的壁垒,实现从输入到输出的一体化处理,从而更有效地应对复杂的现实场景任务。

在量子位与商汤联合创始人、人工智能基础设施及大模型首席科学家林达华交流过程中,对这种新模式有了进一步的了解。

在预训练阶段,商汤的原生融合多模态大模型不仅利用天然存在的海量图文交错数据,还通过逆渲染、基于混合语义的图像生成等方法合成大量融合模态数据。

例如,在处理网页数据时,对图文内容进行统一规范和高质量清洗,并利用现有模型对网页内容进行改写和再生成,获取更丰富的多模态数据。

同时,基于从大量天然语料中提炼的概念,通过文生图等方式合成新的图像并搭配文字,进一步扩充数据来源,在图文模态之间建立大量交互桥梁,使模型基座能更好地掌握模态间的丰富关系。

在后训练阶段,基于对广泛业务场景(如视频交互、多模态文档分析、城市场景理解、车载场景理解等)的认知,构建大量跨模态任务。

这些任务不是简单的数学题或问答,而是模拟真实场景中的复杂问题解决过程,形成交互解决问题的链条性数据。

如此一来,便可以促使模型在训练过程中激发对多模态信息的整合理解分析能力,并形成对业务场景的有效响应能力,实现应用落地反哺基础模型迭代的闭环。

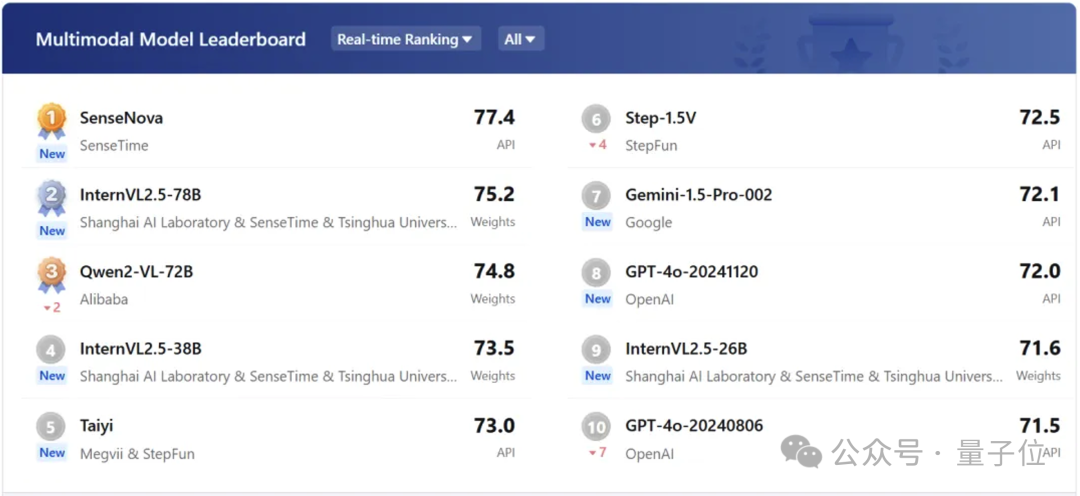

值得一提的是,得益于原生融合多模态的这种方法,不仅是“新5o”在实际效果上取得了明显的提升,在权威评测榜单上的成绩也是非常亮眼——

一个模型击穿两种榜单!

这两个榜单分别是SuperCLUE和OpenCompass。

在SuperCLUE测评中,其文科任务以81.8分位列全球第一,理科任务夺得金牌,计算维度以78.2分位列国内第一。

而在OpenCompass的多模态评测中平均得分77.4,领先众多国内外模型。

这表明商汤的新模型在语言、推理、多模态信息处理等方面均达到较高水平,能够有效避免多模态模型在纯语言任务(如指令跟随和推理任务)中性能严重下降的问题。

由此在图文、纯语言、推理等场景中都达到业内优秀水平,这也体现了原生融合多模态大模型在综合性能上的优势。

最后,从技术发展趋势上来看,商汤所采取的原生融合多模态也应当是一条必由之路。

例如在自动驾驶中,原生融合多模态大模型可融合车内语音、车内外图像视频及车辆状态等信息,让车载智能体更好理解环境与需求,准确判断交通状况并及时决策,提升驾驶安全性与可靠性。

在具身智能方面,能增强智能体对环境的感知理解,使其通过多模态识别实现自然智能交互,还可利用多模态数据促进学习进化,提升任务执行能力,推动其发展应用。

一言蔽之,就像打通任督二脉一样,将大模型推理能力与这些新形态数据结合的通道给疏通了出来。

那么对于这样新的交互模式,你是否也想体验一番呢?地址放下面喽,感兴趣的小伙伴可以冲一波了~

正式接口及接入方案可参考:

https://sensenova5o_doc.sensetime.com/introduction/intro.html

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง