热搜第一!DeepSeek百万年薪招AI人才,实习生都能月入过万

无需工作经验,年轻化成最大亮点

克雷西 一水 发自 凹非寺

量子位 | 公众号 QbitAI

DeepSeek招人,登上热搜第一!

啥?不限专业、经验,本科应届生都能年薪百万了。

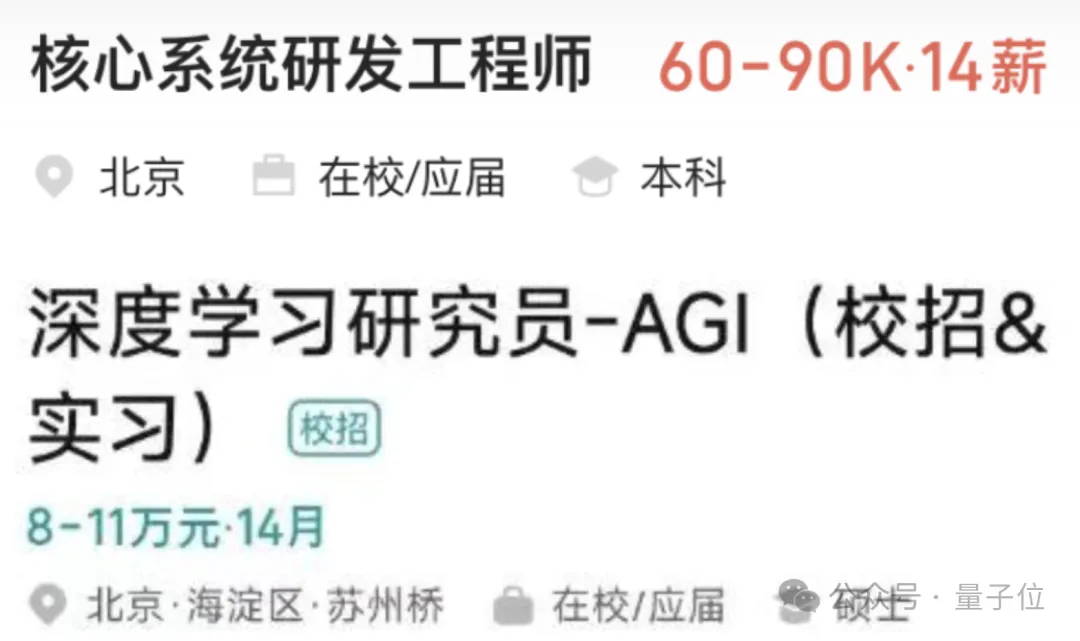

从BOSS平台上一开始公布的在招岗位可以看到,最高薪资达到了110k×14,本科最高也有90k×14。

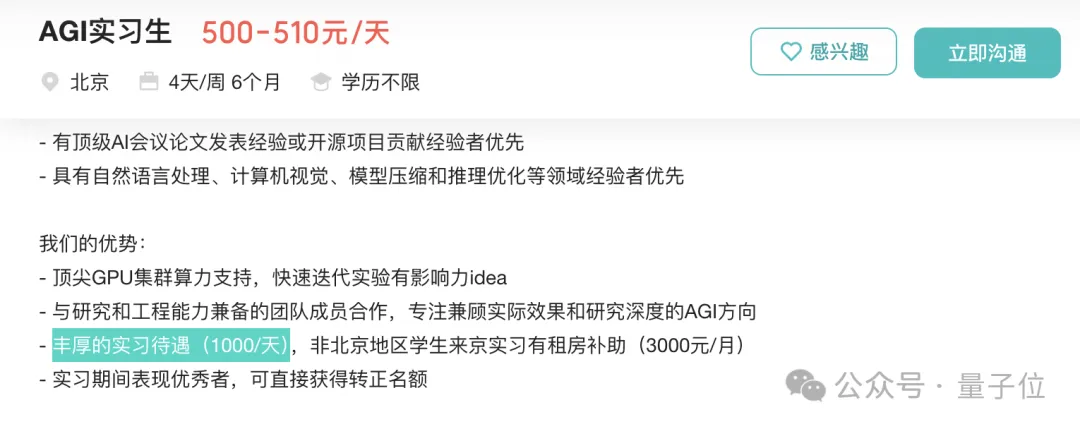

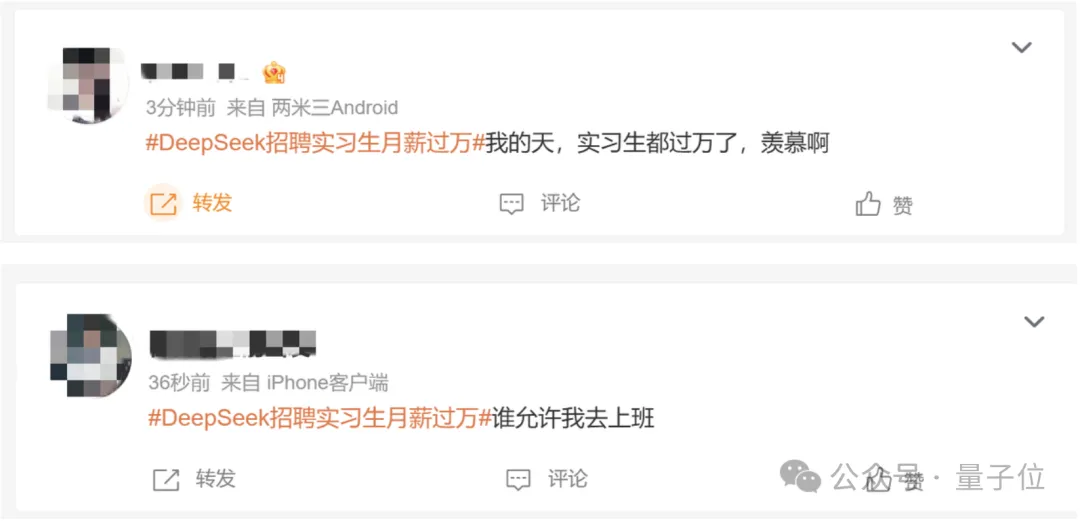

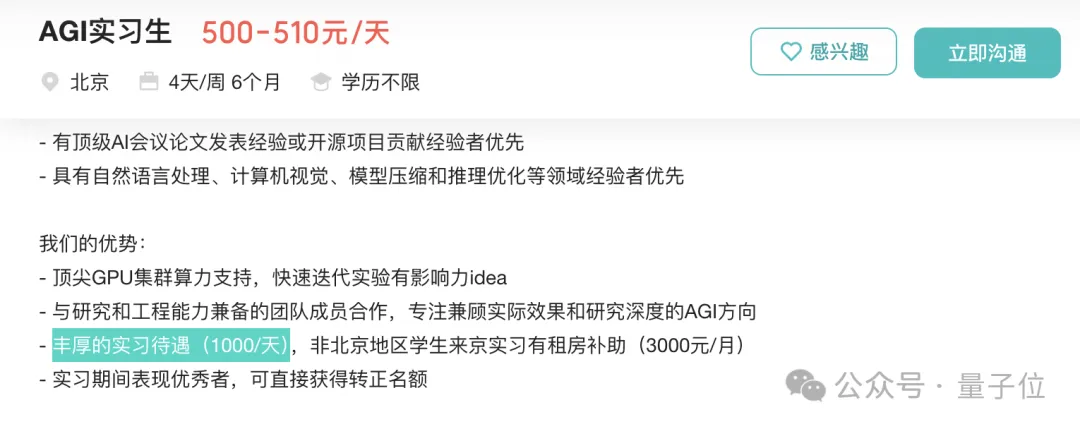

甚至连实习生也是500元一天起招,按每月20天算可以月入万元,最高还有一千元的日薪。

难怪乎一众网友流下了羡慕的泪水。

还有人连连感慨,AI就像当初的互联网,又有人将吃到时代红利了。

不过截至发稿前,BOSS平台上DeepSeek的招聘职位已清空,目前尚不清楚具体原因。

当然,这并不影响我们借此扒一扒DeepSeek的招人要求和人才理念。

本科应届起步,不看经验只看能力

仔细阅读DeepSeek放出的招聘信息,会发现除了个别岗位需要硕士学历之外,大多都是本科起招。

而且英雄不问出路,不管是什么专业、有没有工作经验,DeepSeek的大门都向你敞开。

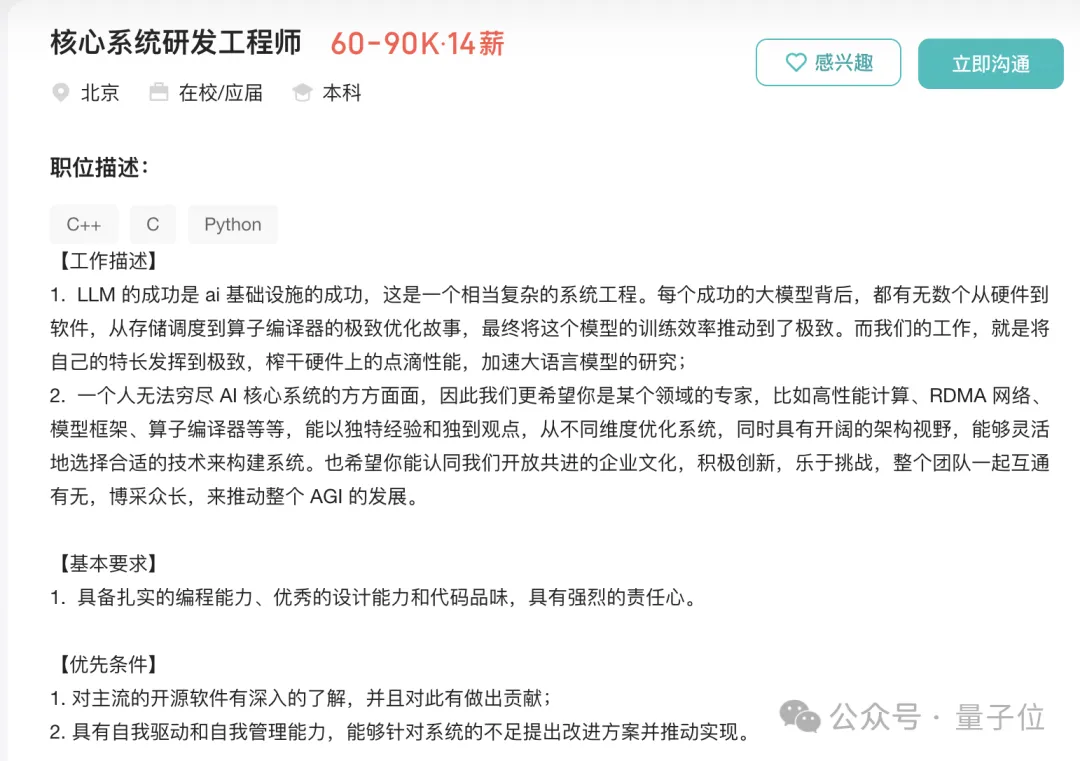

即便是核心系统的研发工程师,90K、14薪,也就是年薪126万,也依然是本科起步。

实际上,不仅是新招人遵循着这套标准,DeepSeek的既有团队同样十分年轻。

去年初,DeepSeek推出V2的时候,虽然不及R1一般泼天的热度,但在业内也引起了不小关注。

当时,Anthropic联创Jack Clark就认为,DeepSeek v2的背后一定有一群“高深莫测的奇才”。

但很快,DeepSeek创始人梁文锋就在一场访谈中否认了这一猜测。

并没有什么高深莫测的奇才,都是一些Top高校的应届毕业生、没毕业的博四、博五实习生,还有一些毕业才几年的年轻人。

到了现在的v3和R1也是如此,应届生、在读生,特别是来自清北的应届生在其中非常活跃。

他们中的一些人,2024年一边在DeepSeek搞研究,另一边新鲜热乎的博士学位论文刚评上奖。

为DeepSeek提出新型注意力MLA(多头潜在注意力)、GRPO强化学习对齐算法等关键创新的,也无一例外都是年轻人。

甚至有的只是实习了一段时间,也做出了重要成果。

比如刚刚被顶会ICLR 2025接收的一篇论文,通过强化学习和蒙特卡洛树搜索研发了一个专门用于数学证明的模型,在相关数据集(miniF2F-valid)上取得了60.2%的通过率,而GPT-4只有25%。

这篇论文的第一作者,在DeepSeek的身份就是一名大四实习生,于去年上半年在DeepSeek实习,论文首次发表时间刚好是实习期结束,现在这名作者已经开始读博。

这或许也解释了DeepSeek愿意给实习生开出千元日薪的缘由。

DeepSeek大胆采用没有经验的年轻人的原因,梁文锋在访谈中也进行了解释。

如果追求短期目标,找现成有经验的人是对的。但如果看长远,经验就没那么重要,基础能力、创造性、热爱等更重要。

我们招人有条原则是,看能力,而不是看经验。

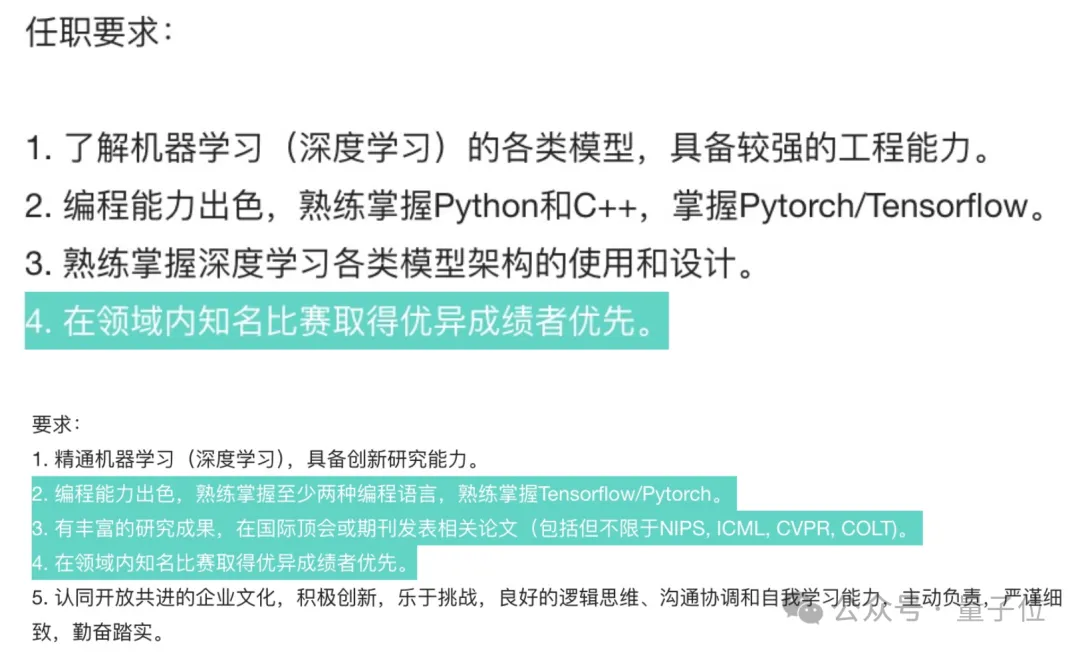

再回过头来看DeepSeek的招聘需求,不难发现表面上“三不限”的岗位,实际并不简单。

不仅要对各类AI模型有十足的了解、掌握相关的编程语言,有些岗位甚至要求发表过顶刊或者在知名竞赛中获奖。

如此一来,DeepSeek团队虽然在年纪和资历上浅了一些,但无论能力还是成果都可圈可点。

也正是这支年轻的团队,把DeepSeek抬到了OpenAI的同一张牌桌。

而实际上,DeepSeek的年轻化不只体现在年龄。

不设前置分工,计算资源人人可用

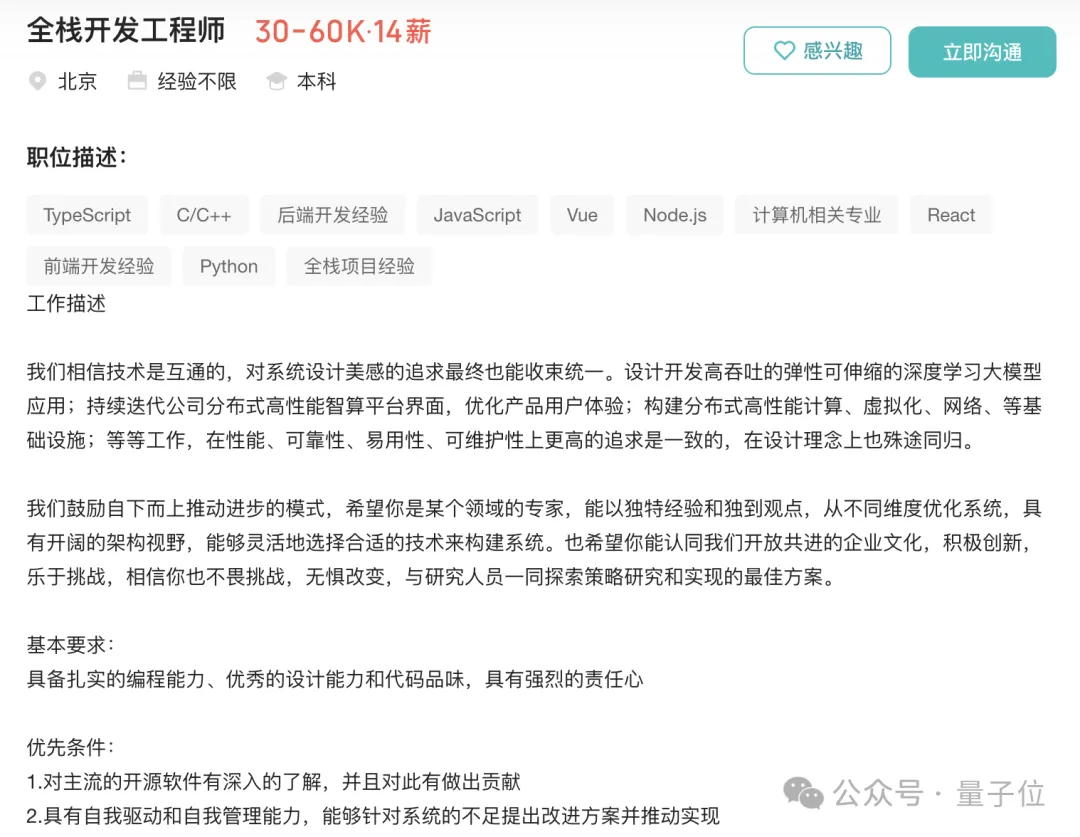

如果从岗位维度看,“全栈工程师”在DeepSeek的招聘列表中占据了可观的比重。

关键是,岗位描述没有那么多的条条框框。

从招聘介绍中管中窥豹,DeepSeek内部的管理模式也主打一个chill。

梁文锋介绍,员工被DeepSeek录取之后就会开启“放养模式”,交给他重要的事,但不设KPI、不做干预,让他自己想办法、自己发挥。

当然,在这个过程中,人员和算力的需求,DeepSeek都会给予满足。

我们每个人对于卡和人的调动是不设上限的。如果有想法,每个人随时可以调用训练集群的卡无需审批。同时因为不存在层级和跨部门,也可以灵活调用所有人,只要对方也有兴趣。

前面提到的MLA注意力机制,就是一个很好的例子,它出现的契机,就是一个偶然。

梁文锋介绍,在总结出注意力架构的一些主流变迁规律后,这位年轻人突发奇想去设计一个替代方案。

面对这种“偶然”,DeepSeek给予了全力支持,为此专门组建了一个团队,用数个月的时间把这个想法变成了现实。

再继续深入下去,DeepSeek的内核也显得年轻而极具理想主义。

梁文锋表示,DeepSeek的目标很明确,就是不做垂类和应用,而是做研究、做探索。

在许多大模型创业者转向应用的大趋势下,这样的选择极有可能是艰辛的。

但在DeepSeek的视角中,搞大模型不能总是依靠拿来主义来赚快钱,而是要推动真正的技术创新。

这又从另一个角度解释了DeepSeek团队年轻化的一大原因——

在经济效益不做优先考量的情况下,创新需要信念来作为支撑,而年轻人,无疑是最具信心、最朝气蓬勃的一个群体。

拥有上万块GPU,天价招人不稀奇

有了理想,当然要在此之上进行投入,实际上,DeepSeek无论在人才还是在算力资源上,都可谓非常不吝成本。

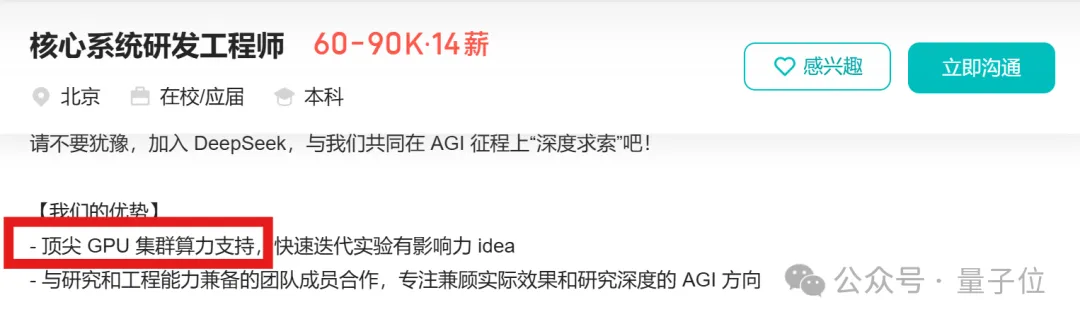

前面我们也提到,DeepSeek打出了计算资源人人可用这块招牌,招聘中也明确提到了相关算力支持。

那么,DeepSeek实际上有多少算力资源呢?

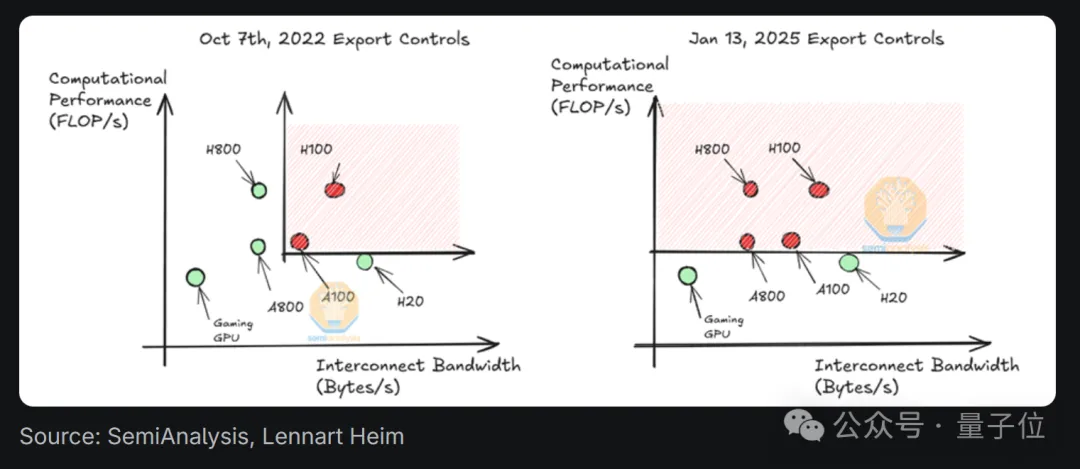

通过挖掘知名半导体研究机构Semianalysis发布的一份解析报告,我们能够进一步获悉:

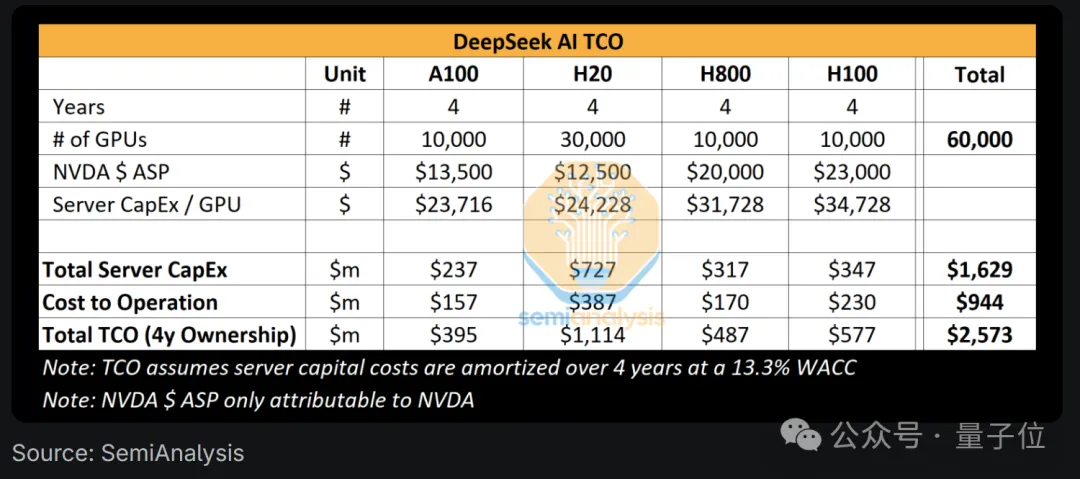

(据报告推测)DeepSeek拥有约5万块Hopper GPU,其GPU投资超过了5亿美元。

(Hopper GPU是英伟达专为高性能计算和AI研发的下一代数据中心GPU架构,其名字是为了纪念已故计算机科学家Grace Hopper)

不过报告也提醒,5万个Hopper GPU≠5万个H100。

具体来说,报告推测DeepSeek拥有约1万个H800和1万个H100,并且还订购了更多的H20。

这些GPU将在幻方量化(DeepSeek背后公司)和DeepSeek之间共享。

与此同时,报告还对之前盛传的“DeepSeek V3的训练成本仅为600万美元”作了解释。

这个数字其实是片面的。它只是预训练过程中GPU的花费,仅为模型总成本的一部分。

研发费用以及硬件本身的总体拥有成本等重要部分并未包含在内。

具体而言,报告分析认为DeepSeek在硬件上的支出远超过5亿美元,而且为了开发新架构,团队需要花费大量资金和算力。

比如在DeepSeek降本的关键——MLA机制,前期就有大量人力及GPU计算时间被投进去,耗时长达数月。

当然这种投入也获得了回报,在后续研发过程中,每次查询所需的KV缓存减少了约93.3%。

所以,即使加上硬件和前面提到的人力成本,DeepSeek在性价比这事儿上仍有相当大想象空间。

这不,春节假期还没结束,最近几天腾讯云、阿里云、百度智能云等各大云计算都在抢着上架DeepSeek模型。

如此巨大关注下,能够开出天价招人也就不奇怪了。

参考链接:

[1]https://semianalysis.com/2025/01/31/deepseek-debates/

[2]https://www.zhipin.com/gongsi/job/ffd531b0cbd4133f1XN92Nm0EFU~.html?ka=company-jobs

[3]https://finance.sina.com.cn/tech/2025-01-26/doc-inehhksk9178057.shtml

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง