多模态大模型事实正确性评估:o1最强,模型普遍过于自信,最擅长现代建筑/工程技术/科学

推理次数>30时,模型表现趋于稳定

淘天集团未来生活实验室 投稿

量子位 | 公众号 QbitAI

OpenAI o1视觉能力还是最强,模型们普遍“过于自信”!

这个结果来自首个面向事实知识的中文视觉问答基准ChineseSimpleVQA。

该基准测试包含2200个高质量问题,覆盖了8个主要话题和56个子话题,这些问题涉及从人文到科学和工程等多个领域,由淘天集团未来生活实验室团队推出。

据介绍,这是第一个系统性地衡量视觉大模型事实准确性的中文评测集,可以全面探测模型在各个领域的视觉识别能力和知识水平。

也是继提出Chinese SimpleQA 和Chinese SafetyQA之后,淘天集团算法技术未来生活实验室团队再次提出面向多模态大模型的事实知识评测基准。

1100幅图片和2200个问答对作为终版数据集

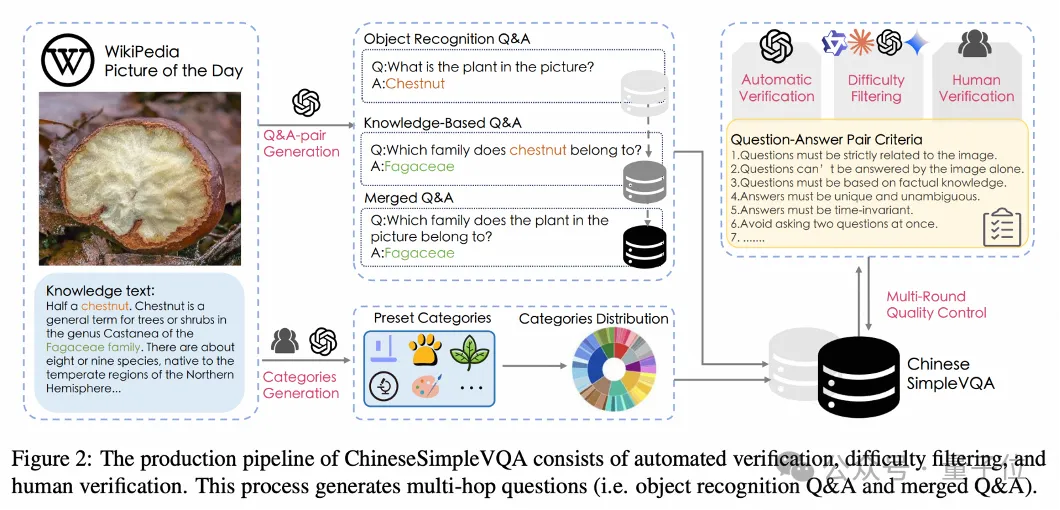

Chinese SimpleVQA贡献了一个严谨的数据构建流程,其将视觉事实性解耦为两个部分:

- 观察世界(即主体识别)

- 发现知识

这种解耦方法方便分析多模态大模型的知识边界及执行机制。

具体来说,Chinese SimpleQA的构主要分为自动化问答对生成和质量控制两个阶段:

第一阶段,QA对生成。

为了创建基于事实知识的视觉问答对,研究者从维基百科的“每日图片”栏目收集了6546个图文对,每张图片对应一个平均长度为723个字的百科类文本。

问答对的构建主要包括以下三个流程:

- 对象识别问题:识别图片中的主要对象并提出相关问题。

- 知识问题生成:基于识别对象的百科文本,提出更深入的知识问题。

- 合并问答:整合视觉和知识问题,形成复杂的两跳问题。

在自动生成问答对时,需要遵循包括问题应仅基于图片信息、答案唯一且明确、基于事实知识及其难度等要求。

同时,需要保留每张图片的首尾问答对作为最终评测集。

第二阶段,质量控制。

包括自动验证。

研究团队开发了一种多轮自动化方法验证生成的问答对,重新生成或过滤不符合标准的问题。

通过该过程,该步共保留了5009幅图片和10018个合格的问答对。

难度筛选。

为了提升基准的难度和识别模型的知识边界,作者们过滤掉了简单问题。

具体来说,如果某个问题能被四个强大模型,即GPT-4o (0806)、Claude 3.5 Sonnet、Gemini 1.5 Pro和Qwen-VL-Max全部正确回答,则认为该问题过于简单并被淘汰。

该步保留了3058幅图片和6116个问答对。

人工验证。

由23名标注人员进行数据验证和重写,确保问答对符合标准;6名工程师进行复核和筛选,确保数据高质量。

主要操作包括:1)验证并重写不符合标准的问题或答案;2)替换不合格或不具代表性的图片;3)通过搜索引擎核实答案的准确性。不符合标准的对被淘汰。

在这个步骤中,仅保留人工标注与自动验证完全一致的问答对。

数据脱敏。

为确保数据安全,研究者将最终数据集提交给6位安全审计员进行全面审查;每条数据至少由2位审计员交叉检查,只有通过审查的数据才被保留。

经过上述处理后,最终挑选了1100幅图片和2200个问答对作为终版数据集。

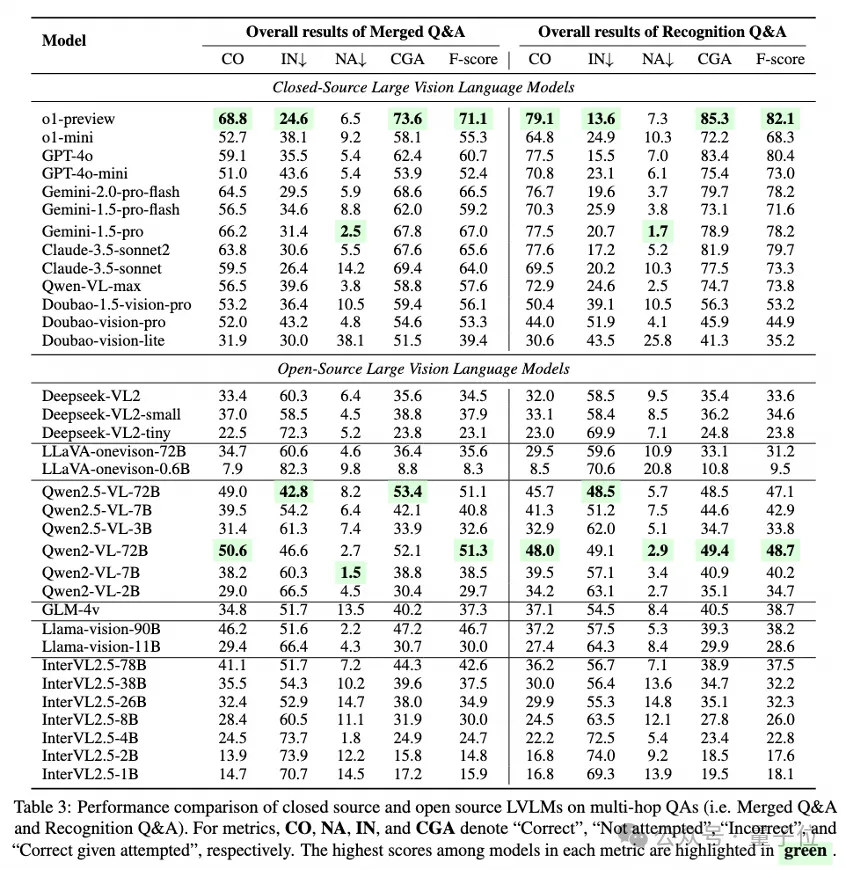

o1-preview表现最佳

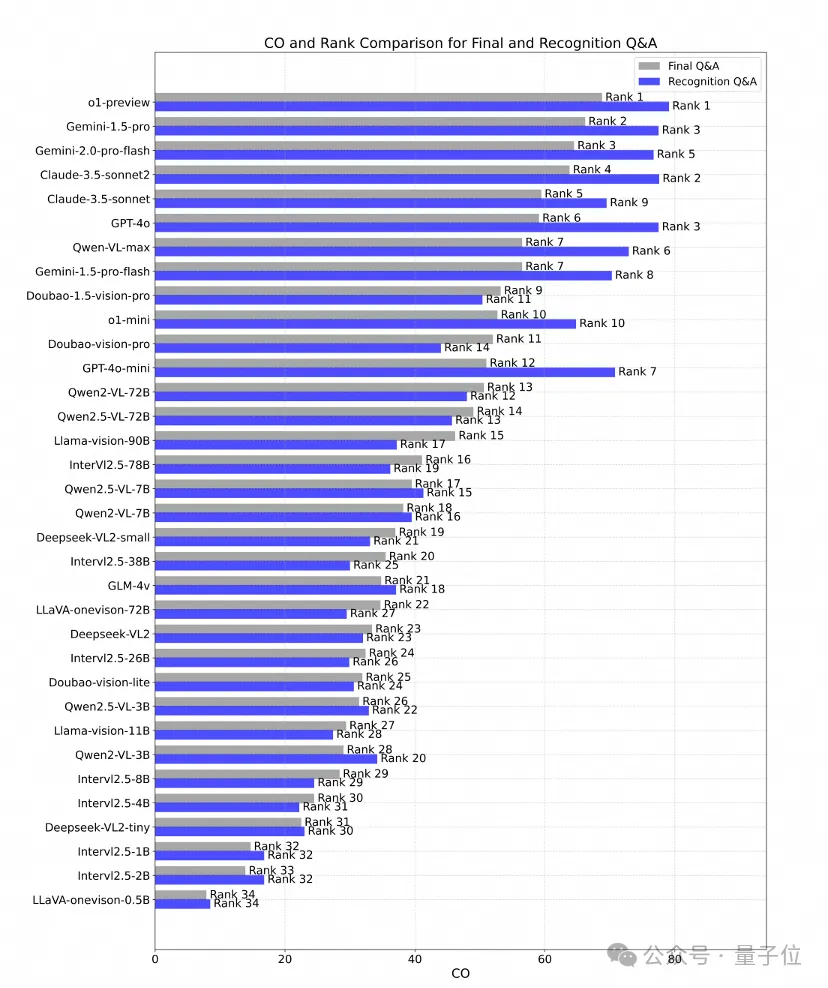

Benchmark构建完成后,团队对13个闭源模型和21个开源模型的全面评测和分析,并分别给出这些模型在图像主体识别和知识扩展问题上的排名情况。

其中,最佳表现模型为o1-preview。

结果显示,o1-preview在识别问题和知识扩展问题上表现最佳,其次是Gemini-2.0-pro-flash和Gemini-1.5-pro。

在注重中文能力的模型中,Qwen-VL系列表现最为突出。

此外,研究团队还观察到三个现象:

知识扩展难于主体识别:模型在知识扩展类问题上的表现与识别问题上的准确率呈正相关。且图像识别准确率通常更高。这表明在一些模型能正确识别对象的情况下,获取深层次扩展知识的能力受限。

知识能力随模型规模提升:一般情况下,同一系列的模型规模越大,表现越优。例如,Qwen2-VL系列从2B增至72B后,最终问题的准确率从29.0%提升至50.6%。

幻觉问题仍是挑战:大多数受测模型的错误率(IN)高于不尝试回答的比率(NA),这表明模型更倾向于自信地提供错误信息。幻觉问题仍是多模态大模型领域的一个重要挑战。

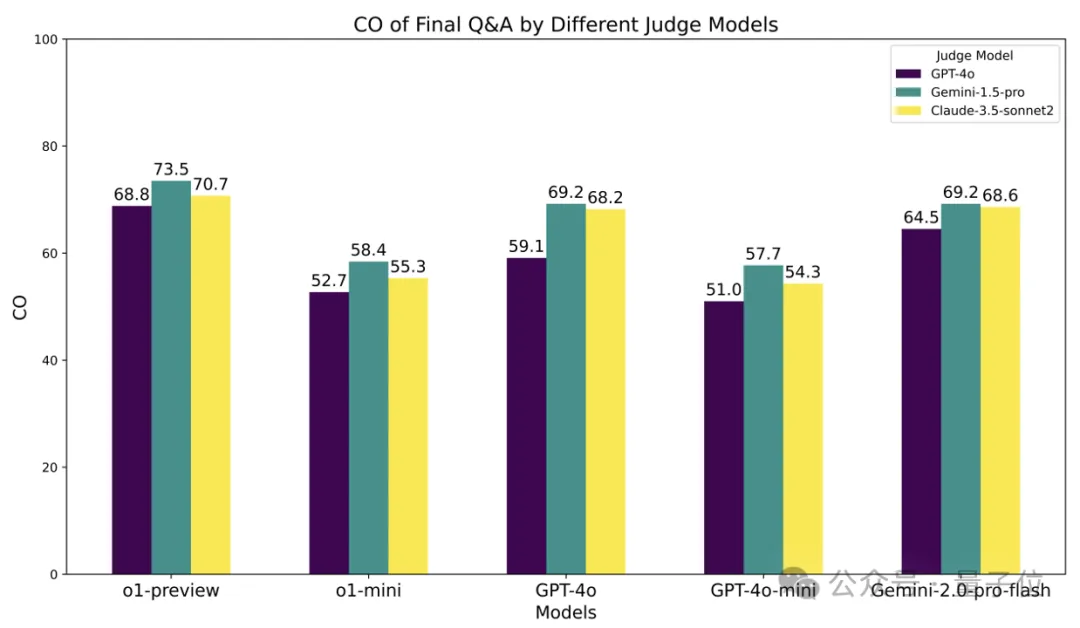

同时研究测试显示,ChinesesimpleVQA具有评估鲁棒性,在使用不同的评测模型时(即使评测模型和受测模型是同一个),受测模型的排名保持稳定。

以下为部分研究发现摘录:

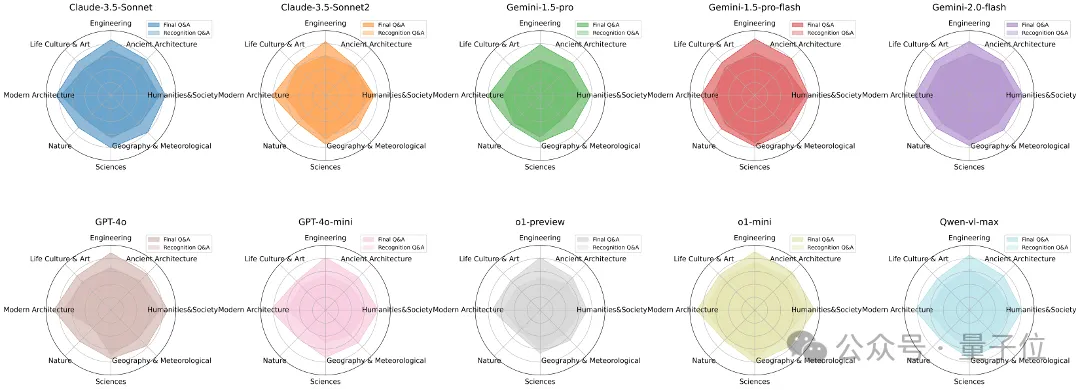

更擅长哪种知识?

Chinese Simple VQA中的问题通常需要更专业的知识,这也考验了模型的知识深度。

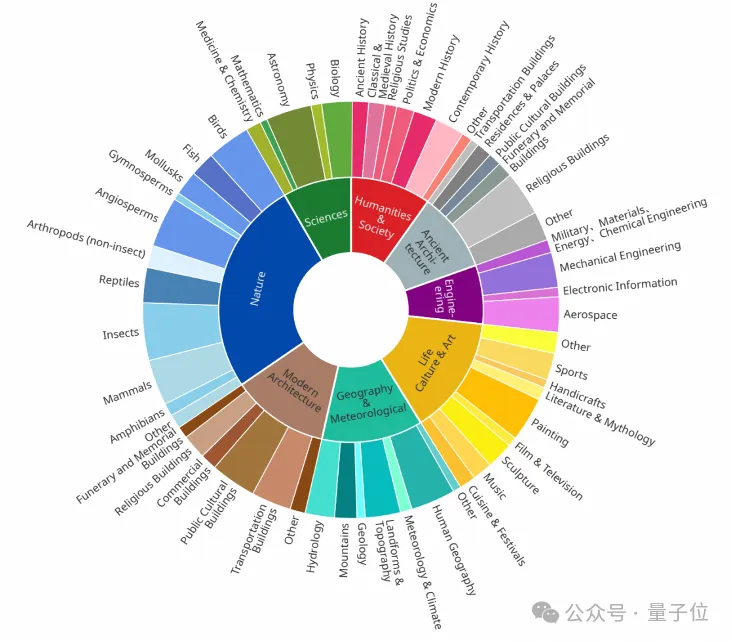

下图给出了Top10排名的模型,在8个话题下的表现。

结果表明,这些模型在现代建筑、工程技术和科学等主题上表现优异,在其他主题上稍逊一筹。

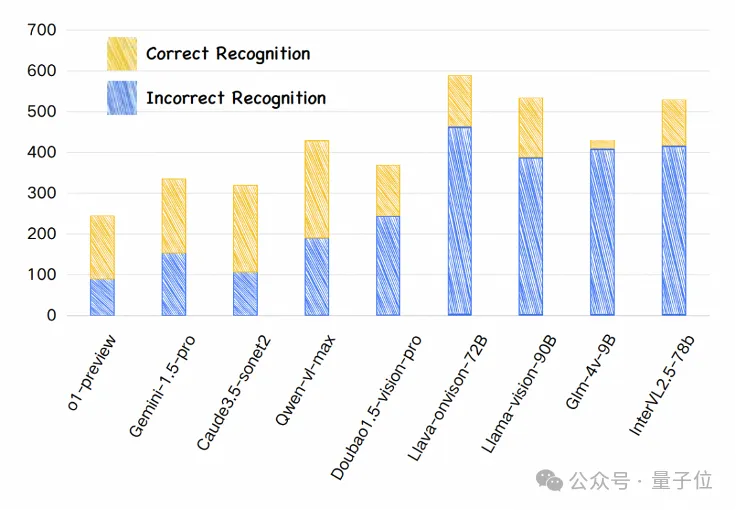

更缺乏哪种能力?

下图分析了各模型的出错时机。

结果显示,对o1-preview、Gemini-1.5-pro、Caude3.5-sonet2和Qwen-vl-max来说,主要出错时机(占比超过50%)来源于知识扩展阶段。

而其他模型,则在图像识别阶段开始表现不佳。

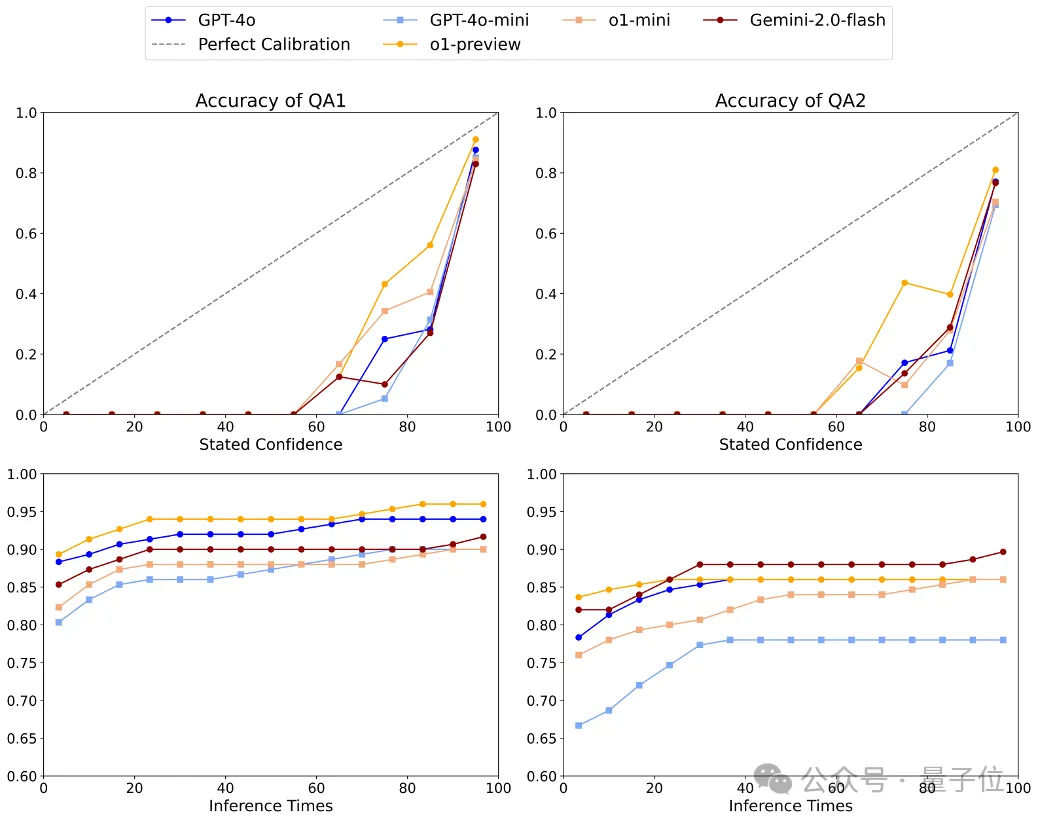

是否过于自信?

一个理想校准模型的置信水平(%)应与预测准确性精确匹配。

研究通过提示模型在回答问题的同时给出其置信度(范围0到100),并探索了模型的事实准确性与置信度之间的关系。

结果显示,o1-preview表现最佳。

但总体而言,大部分模型的表现远低于理想对齐线,这表明即使回答错误,模型也倾向于过于自信。

是否具有能力边界?

下图曲线展示了随着推理次数增加,模型答案准确性(Best-of-N)的变化。

可以看出,大部分模型在1到30次尝试范围内,准确性随推理次数增加而明显提高。

然而,当推理次数超过30次时,模型表现趋于稳定。

这表明模型难以通过不停的探索而持续找到准确的知识,也代表着模型的知识能力边界。

共5大特点

Chinese SimpleVQA主要有五个特点:

第一,多跳评估。

解耦视觉模型知识能力评估步骤,包括图片主体识别和知识评估。

这种多跳评估策略让使用者可以深入分析视觉大模型(LVLMs)的能力边界和执行机制。

第二,多样性。

评测集共有2200条高质量问答对,涵盖了8个知识类别及56个细分主题,包括“自然”“科学”“工程技术”“人文社会”“生活、文化与艺术”等。

第三,高质量。

ChineseSimpleVQA拥有严格的构建流程,包括自动验证、难度筛选和人工验证。

共有23位标注同学和6位算法同学进行质量把控,以及6位安全审查员进行数据风险审查。

第四,静态一致性。

ChineseSimpleVQA具有持久可用性,所有的参考答案将不随时间而发生改变。

第五,易于评估。

所有问题和答案均采用简短格式,方便快速评估。

此外,ChineseSimpleVQA提供一键评测脚本以协助研究人员开展工作。

One More Thing

该项目核心作者包括顾纪豪,王瑛瑶,不皮。

研究团队来自淘天集团算法技术-未来生活实验室,该实验室聚焦大模型、多模态等 AI 技术方向,致力于打造大模型相关基础算法、模型能力和各类AI Native应用。

arXiv:

https://arxiv.org/pdf/2502.11718v1

https://arxiv.org/abs/2411.07140

https://arxiv.org/abs/2412.15265

项目主页:

https://chinesesimplevqa.github.io/ChieseSimpleVQA.github.io/

GitHub:

https://github.com/OpenStellarTeam/ChineseSimpleQA

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง