1段视频=亿万虚拟场景!群核开源空间理解多模态模型,真实世界秒变机器人训练场

基于大语言模型的3D场景语义生成框架。

GTC2025全球大会上,群核科技宣布开源空间理解模型SpatialLM。

这是一个基于大语言模型的3D场景语义生成框架。

它突破了传统大语言模型对物理世界几何与空间关系的理解局限,赋予机器类似人类的空间认知和解析能力。

这相当于为具身智能领域提供了一个基础的空间理解训练框架,企业可以针对特定场景对SpatialLM模型微调,降低具身智能训练门槛。

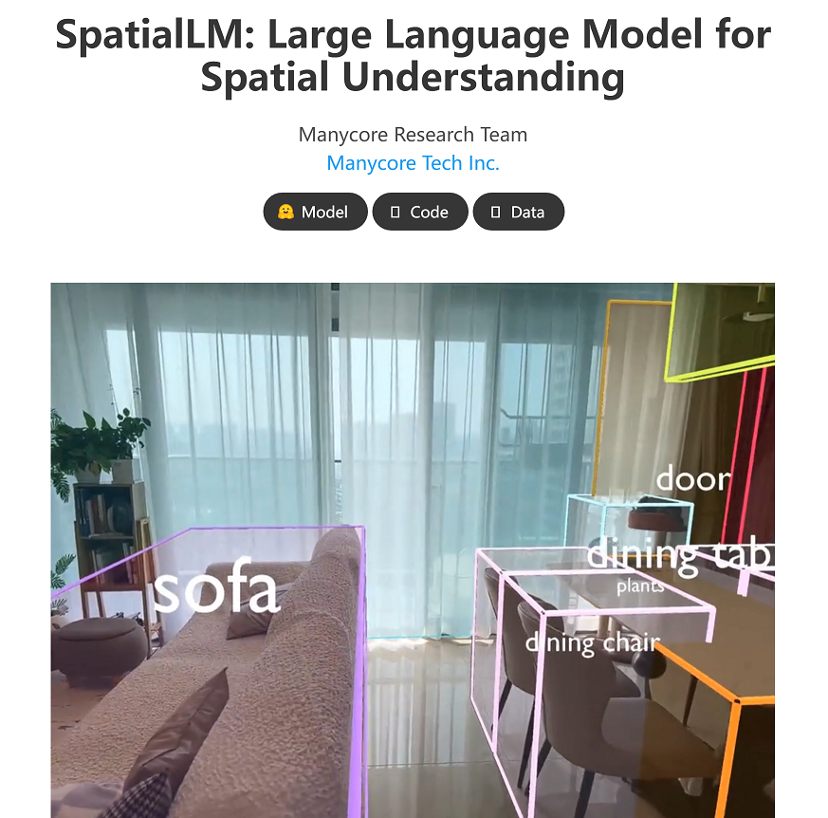

△群核科技SpatialLM模型开源页面

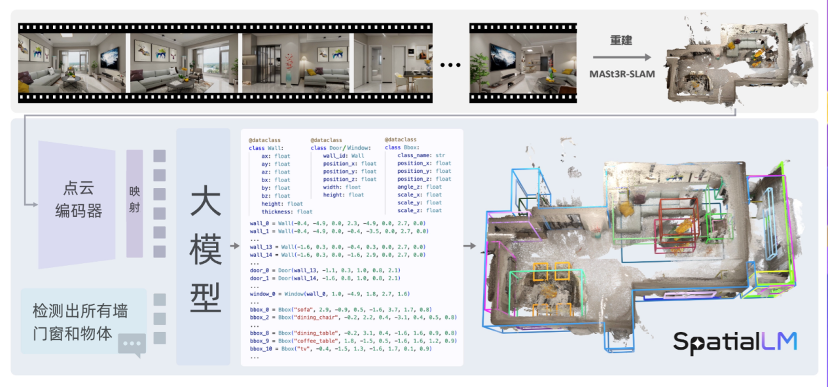

据悉,仅通过一段视频,该模型即可生成物理正确的3D场景布局。

基于从视频中提取的点云数据,SpatialLM模型能够准确认知和理解其中的结构化场景信息。目前,SpatialLM已在HuggingFace、GitHub、魔搭社区等平台面向全球开发者开源。

据群核科技相关技术负责人称,此次开源仅是开始,接下来SpatialLM模型将继续迭代如自然语言和场景交互等功能。

△SpatialLM运行原理

虽然行业已有对图像、视频进行参数化描述模型,比如Meta此前发布的SceneScript模型。

但SpatialLM的独特之处在于:

1、相比Meta需要依赖其眼镜的定制化模式,SpatialLM设定于面向普通相机、手机的视频作为输入,因此更具通用性。

2、不同于传感器对物理世界的感知,SpatialLM使用大语言模型,最终输出是对3D场景的自然语言描述,未来还将支持原生自然语言与场景数据的交互。

3、更重要的是,SpatialLM支持对物理世界中空间信息的认知理解,和结构化描述。群核科技本身便专注于物理空间模拟的技术场景,过去十余年中积累了海量的三维数据和空间认知数据;基于此数据训练的模型,亦具备创建物理正确的空间场景的能力。

通过增强大语言模型的空间理解能力,SpatialLM模型开源后,将为像具身智能领域的企业或机构科研团队提供一个空间认知理解的基础训练框架。尤其是对那些不具备模型开发能力的具身智能企业,可以基于SpatialLM模型进行微调,降低具身智能训练门槛。

“我们希望打造一个从空间认知理解到空间行动交互闭环的具身智能训练平台。本次开源的SpatialLM空间理解模型旨在帮助具身智能机器人完成在空间认知理解上的基础训练。而去年群核科技发布的空间智能解决方案SpatialVerse,则希望进一步通过合成数据方案为机器人搭建最接近物理真实的‘数字道场’,实现机器人在仿真环境中的行动交互训练。”群核科技董事长黄晓煌在接受采访时表示。

据了解,群核空间智能平台SpatialVerse是本次亮相GTC的另一个重头戏,它与SpatialLM模型之间“协同合作”,打通了”现实 – 虚拟 – 现实” 的闭环路径,共同为具身智能架起一座数字仿真与物理现实之间的桥梁。例如,SpatialLM模型通过从视频到结构化场景的转化,将现实世界的数据转化为虚拟环境中的丰富场景,而基于SpatialVerse的合成数据引擎,一个结构化场景又可泛化生成亿万级新场景。这也意味着,现实世界将成为SpatialVerse“数字道场”的原料来源。

“我相信全球很快会迎来具身智能机器人的爆发性发展,在具身智能背后,是算力、算法、工程和训练数据四个板块的协同进化,这需要全行业合力推动。群核科技希望通过空间模型和数据开源一起推动技术基座建设,为这个技术奇点的来临贡献一份力量。”黄晓煌提到。据悉,在空间和具身智能训练上,目前群核科技已与硅谷头部科技企业等在内的一批国内外具身智能企业达成合作。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง