GPT-4o不敌Qwen,无一模型及格!UC伯克利港大等提出多模态新基准

多视图理解推理有新的评判标准了

All-Angles Bench 团队 投稿至 凹非寺

量子位 | 公众号 QbitAI

多视图理解推理有新的评判标准了!

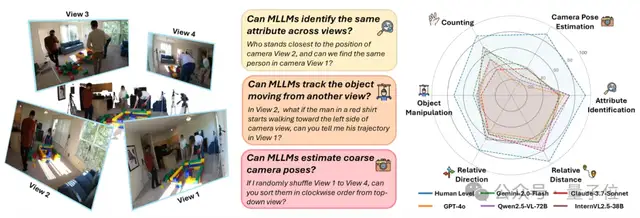

什么是多视图理解?也就是从不同视角整合视觉信息进而实现理解决策。

想象一下,机器人在复杂环境中执行任务,这就需要根据多个摄像头的画面准确判断物体位置、距离和运动方向,这就依赖于强大的多视图理解能力。

但过去,由于评估多视图推理能力的基准测试稀缺,这一领域的研究进展相对缓慢。

来自UC伯克利、忆生科技、香港大学、纽约大学、加州大学戴维斯分校、牛津大学等多家机构的研究者联合提出了All-Angles Bench,旨在全面评估MLLMs的多视图理解能力。它涵盖了90个真实场景下,超过2100组人工标注的多视图问答对。

其评测数据集以及评测代码现已全部开源。

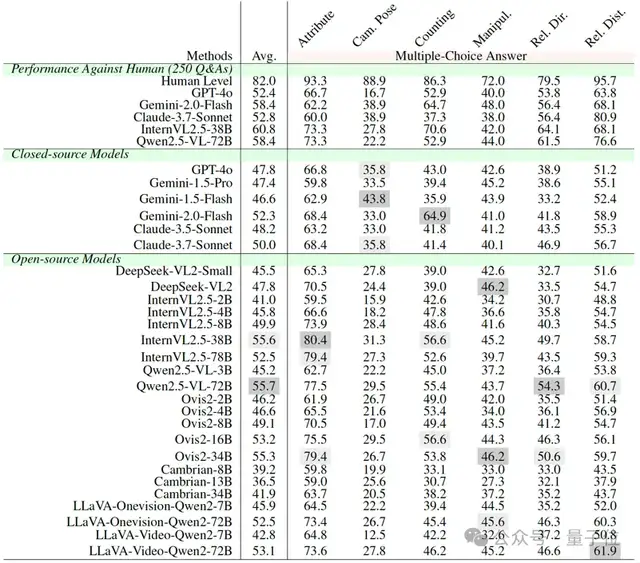

他们对27个领先的多模态大语言模型进行基准测试,其中包括Gemini-2.0-Flash、Claude-3.7-Sonnet和GPT-4o。

结果显示,多模态大语言模型与人类水平之间存在显著差距,并进一步发现模态大语言模型存在两种主要的缺陷模式:(1)在遮挡情况下跨视图对应能力较弱;(2)对粗略相机位姿的估计能力较差。

具体来看:

多视图理解Bench

数据构建

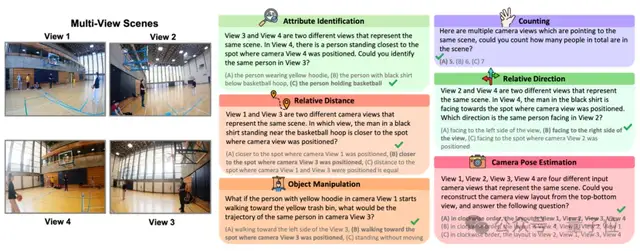

All-Angles Bench是一个包含超过2100组人工标注的多视图问答对的大规模基准,涵盖了90个来源于EGO4D-EXO和EgoHumans数据集的真实世界场景。

数据集包含六大具有挑战性的任务,分别是Counting、Attribute Identification、Relative Distance、Relative Direction、Object Manipulation和Camera Pose Estimation。

这些任务旨在从多角度考察MLLMs对3D场景的理解能力,包括物体之间的位置关系、物体与相机之间的位置关系等。

构建过程

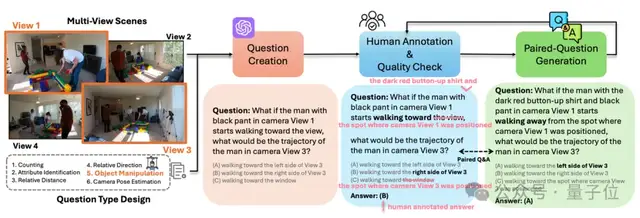

1. 数据收集与问题类型设计:研究团队精心挑选了90个多样化的多视图场景,并利用GPT设计了上述六大任务下的相关问题。

2. 问题筛查与人工标注:通过人工标注对问题进行细化,修饰以及答案生成。研究团队并且使用交叉检查的方法,确保了问题的清晰度、正确性和相关性,使得测试问题能够准确地评估模型的能力。

3. 成对问题生成与人工质量检查:为了评估模型在跨视图一致性方面的表现,研究团队通过重新表述问题或改变视角来生成成对问题。在生成过程中,保持视角对应关系不变,并进行最后的质量控制,以确保成对问题的有效性。

性能评估

研究团队对27个领先的MLLMs进行了全面评估,其中包括知名的Gemini-2.0-Flash、Claude-3.7-Sonnet、GPT-4o,以及多种开源和闭源模型。

结果发现,无论是闭源还是开源的多模态大语言模型,在多视图理解能力方面与人类水平之间仍存在显著差距。

发现1:对人类来说简单的任务,比如粗略的相机位姿估计,对多模态大语言模型而言却颇具挑战。

在Camera Pose Estimation任务中,人类标注者的准确率达到88.9%,而Gemini-2.0-Flash、Qwen2.5-VL-72B和InternVL2.5-38B这些顶尖的多模态大语言模型,其准确率落后超过50%,这凸显了其与人类推理水平的显著差距。

发现2:某些开源多模态大语言模型在方向敏感的任务上超越了闭源模型。

有趣的是,Ovis2-34B和Qwen2.5-VL-72B在Relative Direction和Object Manipulation任务上的表现甚至优于Gemini-2.0-Flash和Claude-3.7-Sonnet等闭源模型。推测这可能得益于开源模型集成的视频理解能力和精细的视觉定位能力,使得在跨视图跟踪物体重新定向方面表现出色。

实验分析

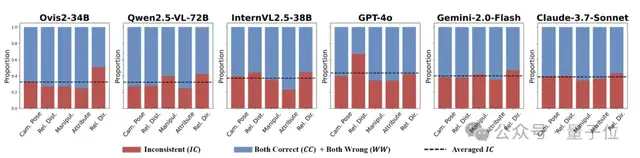

1、多模态大语言模型在成对问答中的不一致性

研究人员将模型的回答分为三类:CC(两个回答都正确)、WW(两个回答都错误)和IC(一个正确,一个错误)。较高的IC占比表明模型的多视图理解能力较弱,即简单的换个说法就会导致其回答出错。

在对六个顶尖的多模态大语言模型进行评估时发现:

1)GPT-4o在Relative Distance任务上的IC得分最高(约70%),远高于其他模型在该任务上的IC得分。

2)所有模型在Relative Direction任务上平均IC得分最高,表明在处理方向变化时存在困难。

3)Gemini-2.0-Flash和Claude-3.7-Sonnet在各个任务中的不一致性较为均衡,而Ovis2-34B和GPT-4o则表现出显著的基于任务的不一致性差异。

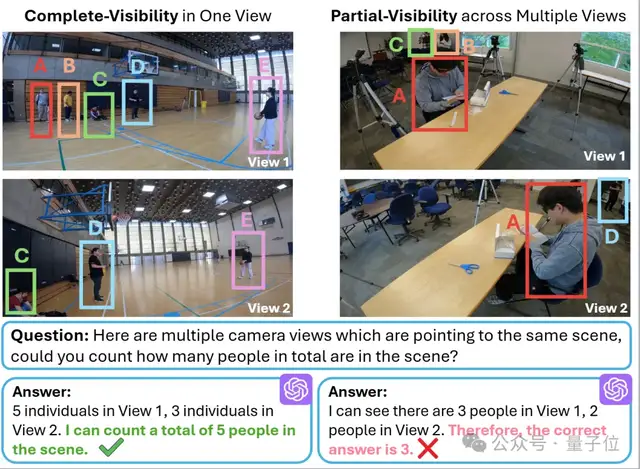

2、多模态大语言模型在多视图对应方面表现不佳

虽然在所有物体在单一视角下都可见(完全可见)的情况下,多模态大语言模型(MLLMs)往往能够成功处理任务,但在跨视角整合碎片化信息(部分可见)时,它们有时会出现问题。

例如,GPT-4o 有时会选择每个视角中的最大数量,而不是对跨视角的物体数量进行统一统计.

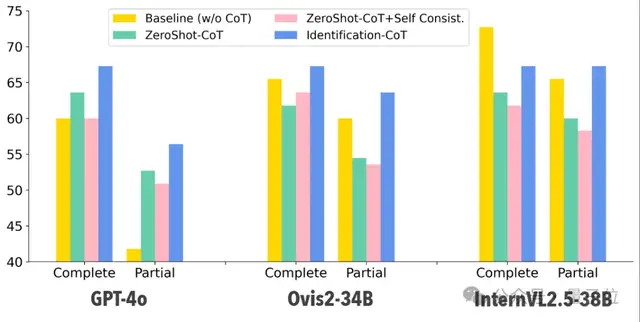

研究人员还在完全可见和部分可见的设置下,对 GPT-4o、Ovis2-34B 和 InternVL2.5-38B 这三款模型评估了以下三种方法:1)Zero-Shot CoT;2)Self-Consistency;3)Identification CoT。

虽然思维链方法在部分可见的情况下提升了 GPT-4o 的表现,但对于在多视图计数方面本就表现出色的模型(如 InternVL2.5-38B)而言,带来的提升比较微少。

这表明,仅靠优化提示词并不够,如果要对多视图理解有根本性的性能提升,还需要进行专门的多视图训练。

3、多模态大语言模型在粗略的相机位姿估计方面表现不佳

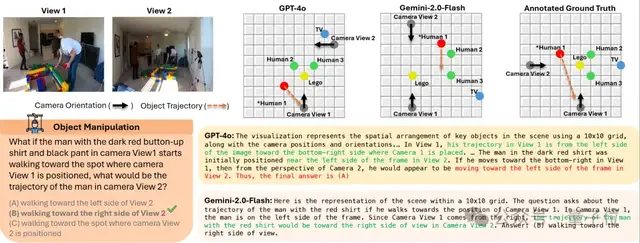

通过可视化的方法,研究人员让MLLM推理多视图下的物体和和相机的位置与朝向,可以发现,虽然 GPT-4o 和 Gemini-2.0-Flash 对单张图像的场景理解表现尚可,但它们在对齐不同的相机视角时存在困难,难以正确处理视角变换,进而影响多模态大语言模型的多视图一致性。

论文地址: https://arxiv.org/abs/2504.15280

项目主页: https://danielchyeh.github.io/All-Angles-Bench/

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง