DeepSeek研究员1200行代码复刻vLLM,H800硬件实测性能反超原版

实现最小化且完全可读的vLLM

西风 发自 凹非寺

量子位 | 公众号 QbitAI

仅用不到1200行代码,实现最小化且完全可读的vLLM!

DeepSeek研究员俞星凯搞了个开源项目引得大伙拍手叫绝。

项目名为Nano-vLLM(纳米级-vLLM),有三大特点:

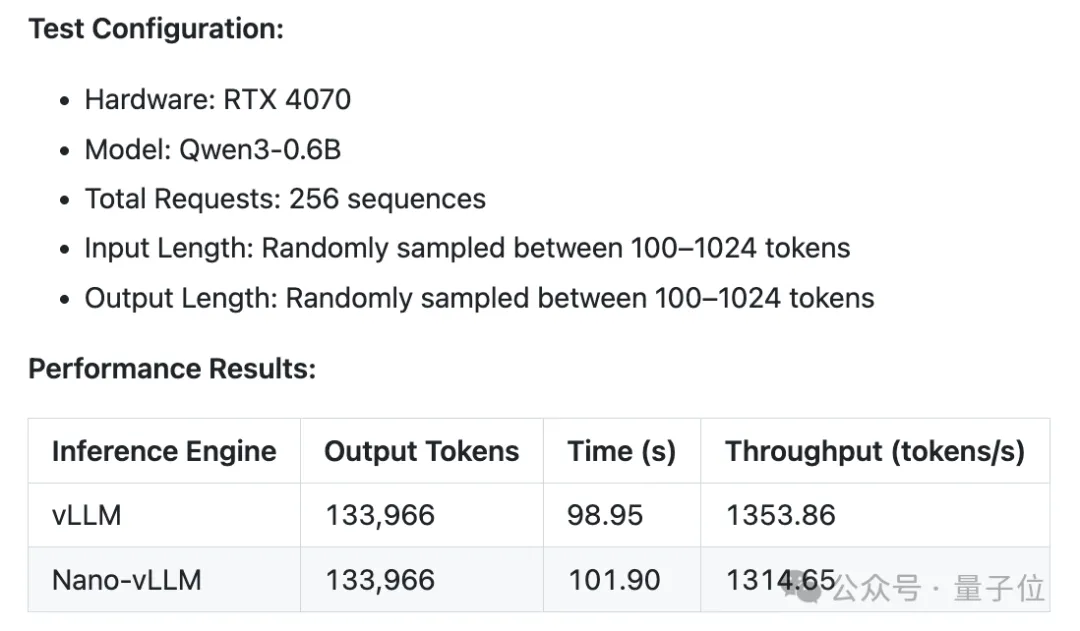

下面是vLLM与Nano-vLLM在不同硬件和模型配置下的基准测试情况。

在RTX 4070硬件、Qwen3-0.6B模型环境中,设置了256个序列的总请求数,输入和输出长度均在100-1024个 token间随机采样。

测试结果be like:

vLLM略微领先。

二者输出token量相同,vLLM耗时98.95秒、吞吐量为1353.86 tokens/s,Nano-vLLM耗时101.90秒、吞吐量1314.65tokens/s。

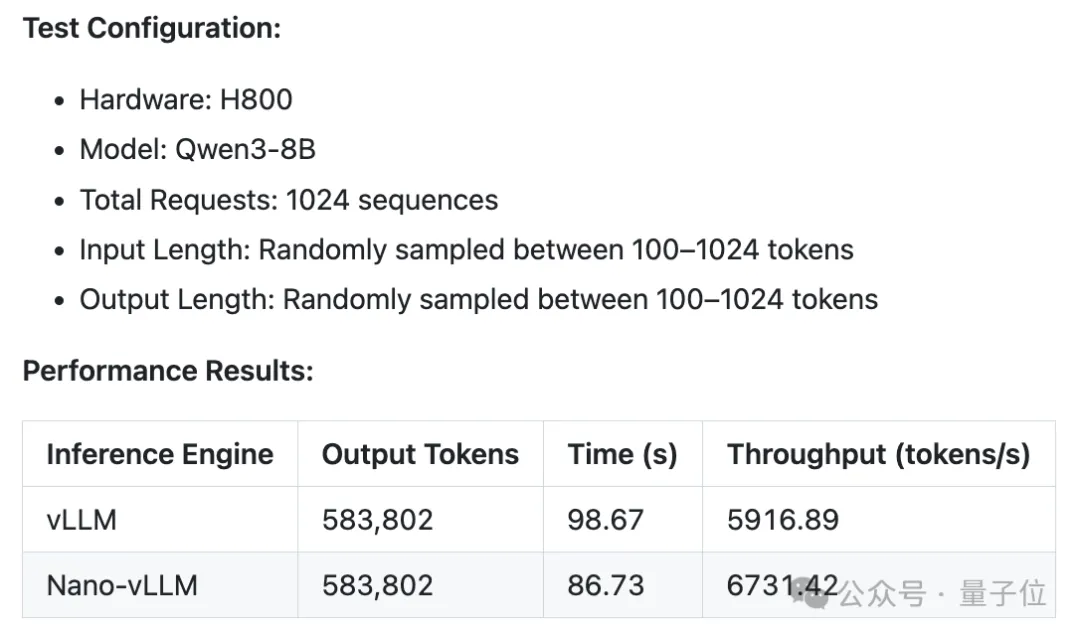

接着在H800硬件、Qwen3-8B模型环境中,总请求数为1024个序列,输入输出长度同样随机采样。

此时Nano-vLLM甚至反超原框架。

二者输出token量依旧相同,vLLM耗时98.67秒、吞吐量5916.89 tokens/s ,Nano-vLLM耗时86.73秒、吞吐量 6731.42 tokens/s。

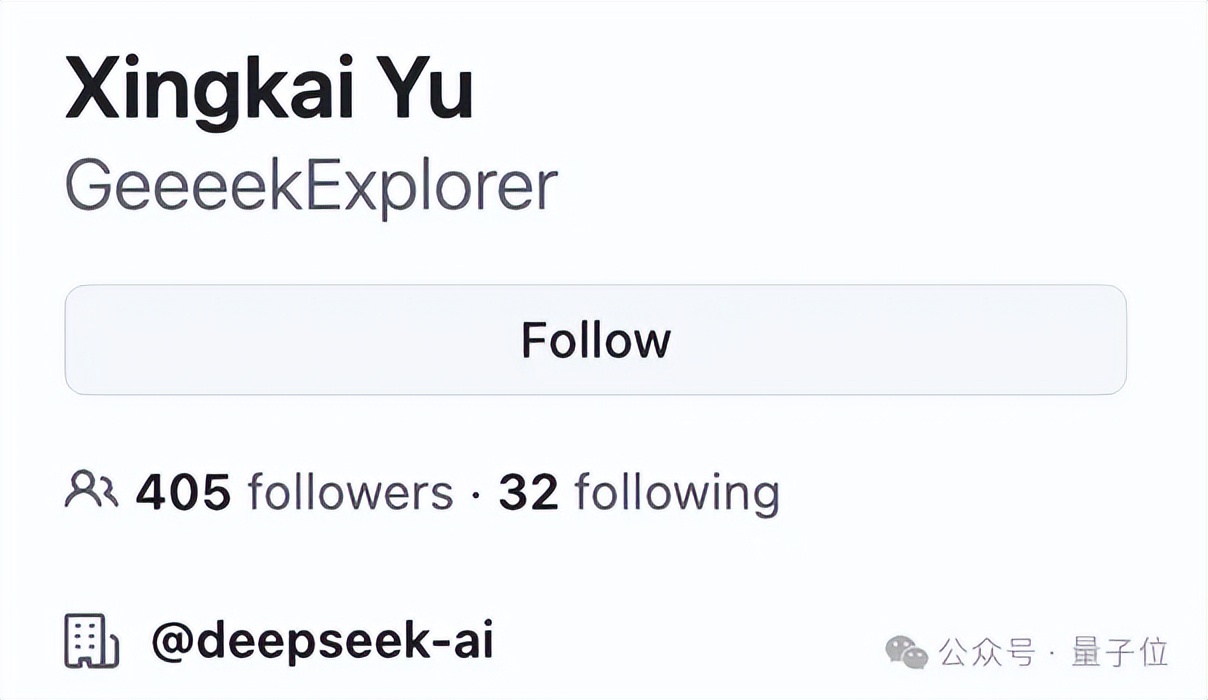

这一成果来自于DeepSeek研究员俞星凯。

他2021年获得南京大学计算机科学与技术系学士学位,同年又被南京大学免试录取为硕士研究生,在校他同时也是由周志华教授领导的LAMDA团队的成员。

vLLM是什么?

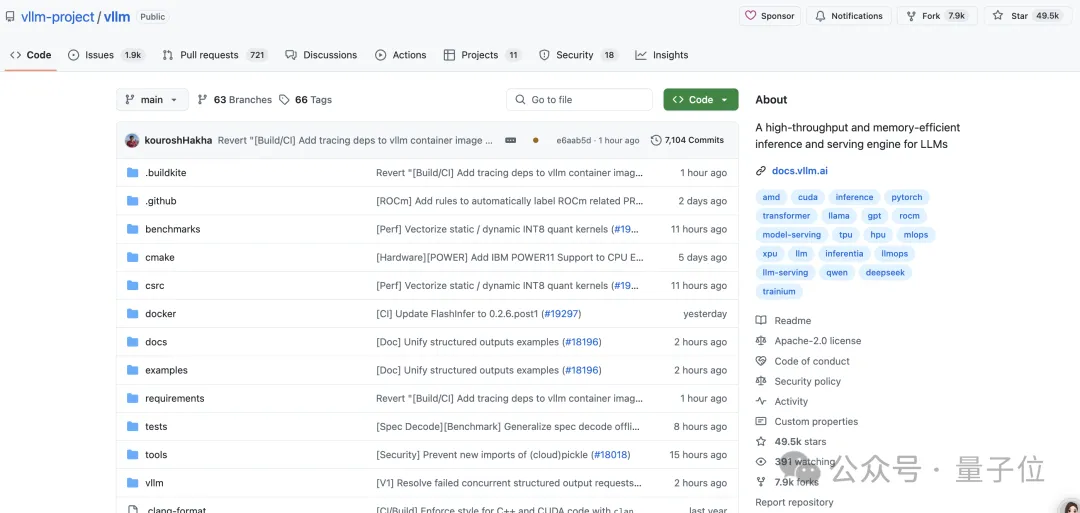

vLLM是一款专为LLM推理与部署优化的高性能框架,最初由加州大学伯克利分校的Sky Computing Lab开发,现已发展成为一个汇聚学界与业界贡献的社区驱动项目。

该项目在GitHub目前已累计49.5k+ Star。

其核心技术灵感源自操作系统虚拟内存分页机制。此前LLM服务系统因采用连续内存存储KV缓存,导致内部/外部碎片化严重,且无法有效共享内存,极大限制了批处理规模。

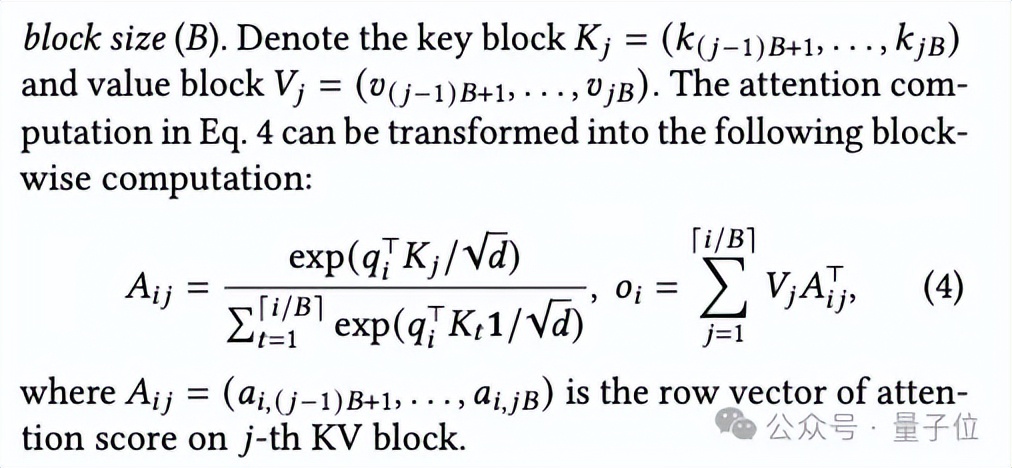

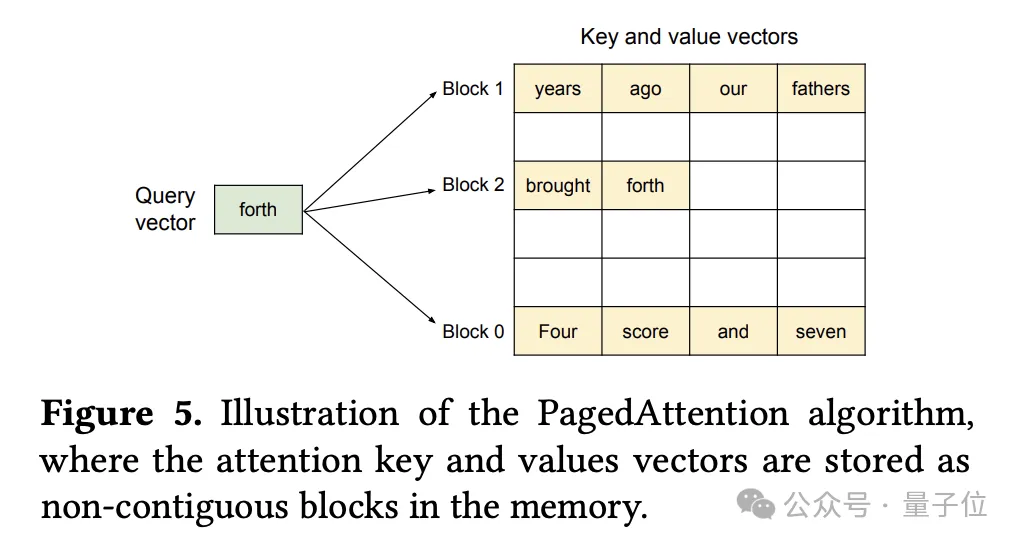

针对这一问题,团队提出PagedAttention算法,允许将连续的键(key)值(value)对存储在非连续内存空间中,通过将KV缓存划分为固定大小的块(Block),利用块表动态映射逻辑块与物理块地址。

在注意力计算过程中,PagedAttention内核会分别识别和获取不同的KV块。

下面是一个示例,键和值向量分布在三个块中,且这三个块在物理内存中并不连续。

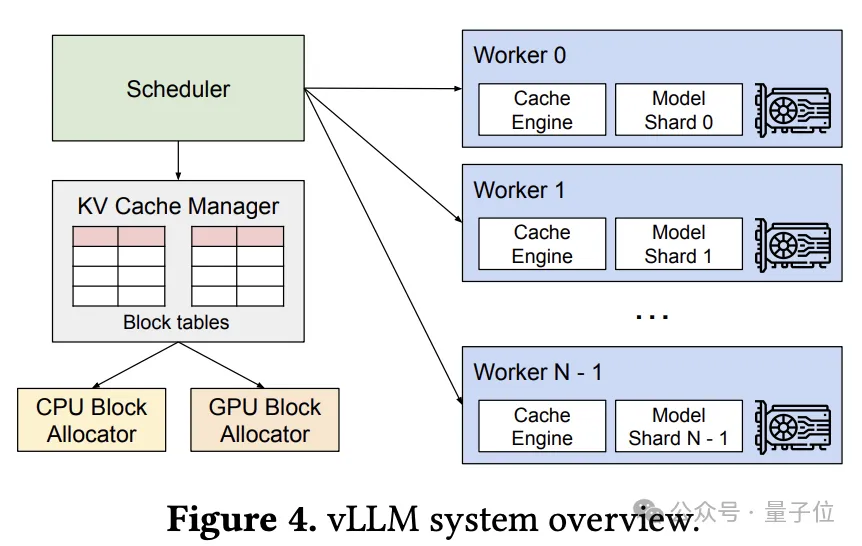

基于PagedAttention算法,团队构建了vLLM服务系统,其架构下图所示:

vLLM采用集中式调度器来协调分布式GPU工作节点的执行。

借助PagedAttention,KV缓存管理器以分页方式有效管理KV缓存。具体而言,KV缓存管理器通过集中式调度器发送的指令来管理GPU工作节点上的物理KV缓存内存。

vLLM实现了KV缓存内存近乎零浪费,请求内及请求间KV缓存的灵活共享进一步降低内存使用。

评估显示,与FasterTransformer和Orca等此前最先进系统相比,vLLM在相同延迟水平下将流行LLM的吞吐量提升2-4倍,且在更长序列、更大模型和更复杂解码算法场景中改进更为显著。

总结来说,vLLM灵活且易于使用,具备以下特点:

与流行的Hugging Face模型无缝集成,包括类Transformer模型、混合专家模型、嵌入模型、多模态模型;支持通过各种解码算法实现高吞吐量服务,包括并行采样、波束搜索等;支持张量并行和pipeline并行,以实现分布式推理;支持流式输出;兼容OpenAI的API服务器;支持NVIDIA GPU、AMD CPU和GPU、Intel CPU和GPU、PowerPC CPU、TPU以及AWS Neuron;支持前缀缓存;支持多LoRA。

值得一提的是,在实现层面,vLLM前端基于FastAPI,后端是基于GPU的推理引擎。vLLM引擎由8500行Python代码和2000行C++/CUDA代码构成。

而这次DeepSeek研究员仅用不到1200行代码就实现了轻量级vLLM,性能和原版相媲美。

参考链接:

[1]https://github.com/GeeeekExplorer/nano-vllm/tree/main

[2]]https://www.lamda.nju.edu.cn/yuxk/

[3]https://arxiv.org/pdf/2309.06180

[4]https://github.com/vllm-project/vllm

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง