腾讯混元升级AI绘画微调范式,在整个扩散轨迹上优化,人工评估分数提升300%

在32块H20上训练10分钟就能收敛

梦晨 发自 凹非寺

量子位 | 公众号 QbitAI

让AI生成的图像更符合人类精细偏好,在32块H20上训练10分钟就能收敛。

腾讯混元新方法让微调的FLUX1.dev模型人工评估的真实感和美学评分提高3倍以上。

当前的扩散模型虽然能通过奖励机制来贴合人类喜好,但存在两个问题:一是优化步骤少,容易出现 “奖励作弊”,也就是模型为了拿高分生成质量差的图;二是需要离线调整奖励模型才能达到好的美学效果,不够灵活。

为此,团队提出两个关键方法:

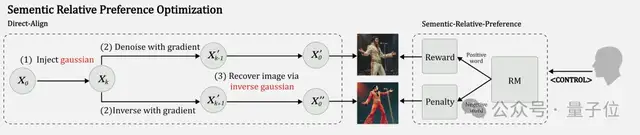

一个是Direct-Align,通过预先注入噪声,能从任意时间步恢复原图,避免了只在后期步骤优化的局限,减少了 “奖励作弊”。

另一个是语义相对偏好优化(SRPO),它把奖励变成受文本控制的信号,通过添加正面和负面提示词,能在线调整奖励,不用额外数据就能灵活适配需求。

论文公开后,有开发者评价SRPO看起来就像下一代RLHF。

在整个扩散轨迹上进行优化

研究团队首先指出了现有方法的两个核心痛点:第一,多步去噪过程中的梯度计算成本极高,导致优化只能局限在扩散过程的最后几步;第二,为了达到理想的美学效果,往往需要不断地离线调整奖励模型。

为了解决第一个问题,团队提出了Direct-Align方法。

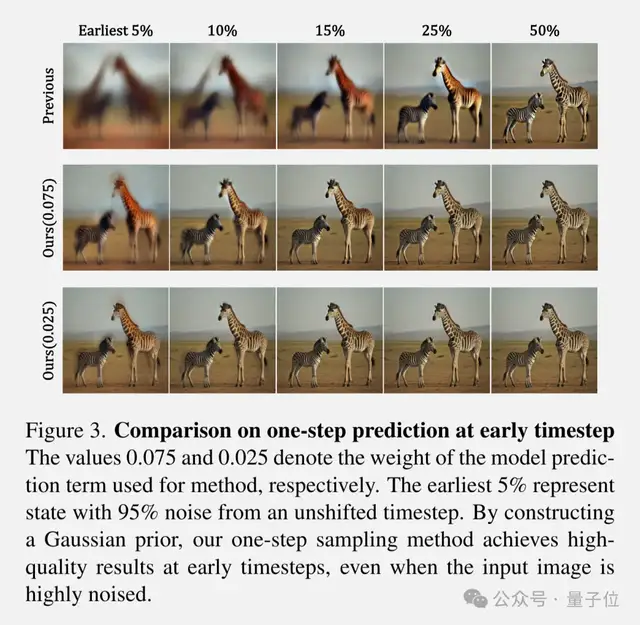

首先预定义一个噪声先验,通过插值直接从任意时间步恢复原始图像。团队发现,扩散状态实际上就是噪声和目标图像之间的插值。

这个方法让模型能够从高噪声状态直接恢复出清晰图像,避免了传统方法在早期时间步反向传播时的梯度爆炸问题。实验表明,即使在只有5%去噪进度的极早期阶段,Direct-Align也能恢复出图像的粗略结构。

更重要的是,这种方法支持在整个扩散轨迹上进行优化,而不是像ReFL、DRaFT等方法那样只能在后期步骤训练。

实验发现,仅在后25%时间步训练会导致严重的奖励黑客问题,模型会过度拟合奖励函数的偏好,比如HPSv2偏好红色调、PickScore偏好紫色图像等。

SRPO让奖励信号更聪明

第二个创新是语义相对偏好优化(SRPO)。传统方法通常需要多个奖励模型来平衡不同的偏好,但团队发现这只是调整了奖励的规模,并没有真正对齐优化方向。

SRPO的核心思想是将奖励重新定义为文本条件信号。具体来说,对于同一张图像,模型会使用正面和负面提示词分别计算奖励,然后取其相对差值作为优化目标。

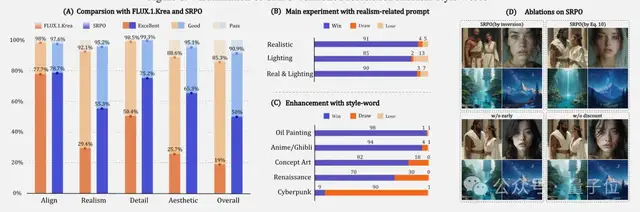

在实际应用中,团队只需在原始提示词前添加控制短语(如”. “)就能实现在线调整。实验显示,通过添加”Realistic photo”等控制词,模型生成图像的真实感提升了约3.7倍,美学质量提升了3.1倍。

SRPO能够通过简单的提示词控制实现多种风格调整,包括亮度调节、漫画风格转换等。有趣的是,控制效果的强弱与控制词在奖励模型训练集中的出现频率相关——高频词如”painting”效果最好,而低频词如”Cyberpunk”则需要与其他高频词组合使用。

实验结果

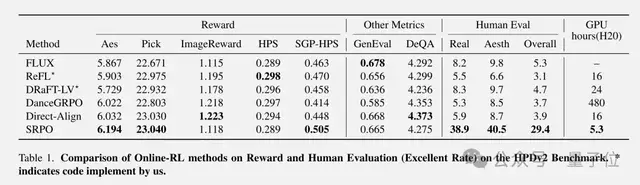

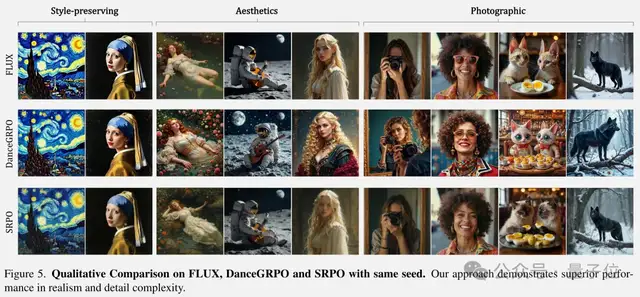

研究团队在FLUX.1-dev模型上进行了全面的实验验证。与ReFL、DRaFT、DanceGRPO等最新方法相比,SRPO在多个评估指标上都取得了最佳成绩。

在HPDv2基准测试的3200个提示词上,SRPO不仅在自动评估指标(Aesthetic Score v2.5、PickScore、ImageReward等)上领先,更重要的是在人工评估中表现出色。团队组织了10名训练有素的标注员和3名领域专家,对500个提示词生成的图像进行了全面评估。

结果显示,在真实感维度上,原始FLUX模型的优秀率仅为8.2%,而经过SRPO训练后飙升至38.9%。在美学质量上,优秀率从9.8%提升到40.5%,总体偏好度更是达到了29.4%的优秀率。

值得一提的是,DanceGRPO虽然也能提升美学质量,但经常引入不良伪影,如过度的光泽感和明显的边缘高光。相比之下,SRPO生成的图像在保持高美学质量的同时,纹理细节更加自然真实。

团队还进行了一项有趣的对比实验:他们发现经过短短10分钟SRPO训练的FLUX.1-dev,在HPDv2基准上的表现已经超越了最新的开源版本FLUX.1.Krea。

论文地址:

https://arxiv.org/abs/2509.06942

参考链接:

[1]https://x.com/_akhaliq/status/1966911634657390890

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง