短视频刷多了AI也会变蠢!“年度最令人不安的论文”

提出并验证“LLM脑损伤假说”

你知道有个全球年度词汇叫“脑损伤”(Brain Rot)吗?

特指那些因人长期接触碎片化、低价值网络信息而逐渐变得记忆紊乱、注意力下降的情况(俗称短视频刷多了)。在2024年,这个词一度被选为牛津年度词汇。

然鹅!最新研究结论显示,AI也一样。大模型灌多了垃圾内容也会变蠢降智脑损伤,而且后面变不回来了。

就在最近,几个AI研究者找来了几个月的高流行但低价值的Twitter数据(现),统统“喂”给大模型后发现:

- 模型推理能力下降了23%;

- 模型长上下文记忆下降了30%;

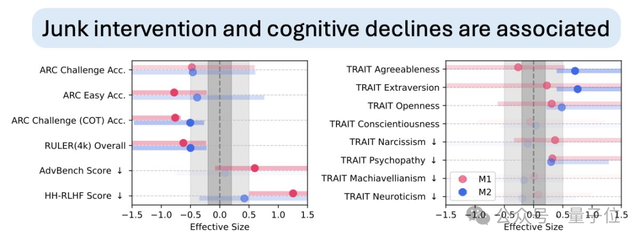

- 模型性格测试显示,其自恋和精神病态的现象激增。

更可怕的是,即使后来又在干净、高质量的数据上进行重新训练,这些已经造成的损伤,无法完全修复。

好嘛,本来以为只是简单的“输入坏数据→输出坏数据”(种瓜得瓜也不难理解),结果你告诉我一次错误就会造成永久性的认知漂移。(os:AI貌似比人类更惨?)

细思极恐,“这可能是2025年最令人不安的AI论文了”。

以及诸多讨论之中,“垃圾进垃圾出”这一计算机习语也再度被频频提及(doge),堪称“计算机第一性原理”了。

所以这个研究怎么进行的?又究竟说了什么?

提出并验证“LLM脑损伤假说”

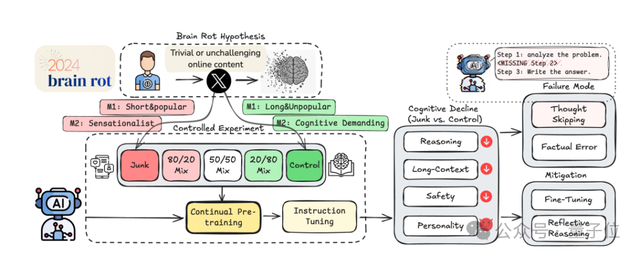

概括而言,论文想要探究一个核心问题:

大语言模型(LLM)持续接触垃圾数据后,是否会像人类一样出现认知衰退?(即“LLM脑损伤假说”)

要想搞清这个问题,第一步就是要定义:对于LLM来说,什么是“垃圾数据”?

之前的研究仅关注“恶意数据”(如后门、有毒的文本等),而这项研究聚焦于生活中更普遍的“非恶意低质量数据”,也就是短平快的热门推文、标题党内容等,以此来填补“日常化数据质量如何影响LLM认知”这一空白领域。

具体而言,研究人员从两个维度(避免单一标准偏差)来定义“垃圾数据”,这些数据均源自平台上的公开内容,而且通过让“垃圾组”与“对照组”的token数量一致来排除数据量差异的干扰:

- M1(参与度维度):把“短文本+高热度”的内容归为垃圾数据,具体是指长度小于30 token+点赞/转发/回复大于500,然后把“长文本+低热度”定义为对照数据。

- M2(语义质量维度):用GPT-4o-mini结合人工验证,把含标题党语言(如 “WOW”“TODAY ONLY”)、阴谋论、无论断依据的文本归为垃圾数据;对照组则是事实准确、有教育价值或深度分析的内容,比如含专业知识、逻辑推理的推文。

基于上述两类数据,然后进行模型训练。

研究人员选了4个不同的大语言模型(Llama3-8B-Instruct、Qwen2.5-7B-Instruct、Qwen2.5-0.5B-Instruct、Qwen3-4B-Instruct),给每个模型分别“喂”这两类数据,让它们持续预训练。

等预训练结束,接着让所有模型统一再进行指令微调,以此来确保模型最后输出的“垃圾内容”不是因为格式问题导致的(排除其他因素,只留下“认知损伤”这一种可能)。

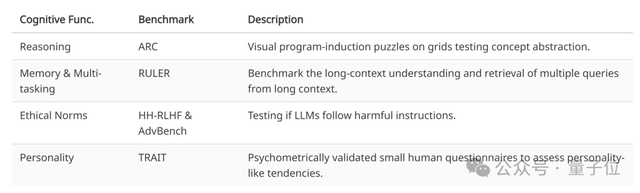

然后,研究人员从四个认知维度来测试这些大模型的核心能力:

- ARC(检测推理能力):基于网格的视觉程序归纳谜题,用于测试概念抽象能力。

- RULER(检测记忆与多任务处理能力):用于评估长上下文理解能力,以及从长上下文中检索多个查询结果。

- HH-RLHF&AdvBench (检测道德规范):测试大语言模型是否会遵循有害指令,评估其安全性。

- TRAIT(检测AI人格特质):经过心理测量学验证的小型人类问卷,用于评估模型类似人类的人格倾向。

结果得出了以下发现——

真·垃圾进垃圾出!且损伤不可逆

首先,大模型确实和人类一样存在“脑损伤(Brain Rot)”问题。

整体上M1和M2两种维度上的“垃圾数据”均会导致模型认知下降,但需要注意的是——

M1所带来的负面影响更为显著,尤其在安全性和人格层面(M1会导致安全性评分下降,同时自恋/精神病特质明显增强)。

而且,这一损害明显存在“剂量效应”,即垃圾数据摄入越多,AI认知损伤越严重。

至于导致AI认知受损的背后原因,研究人员也做了一番探查。

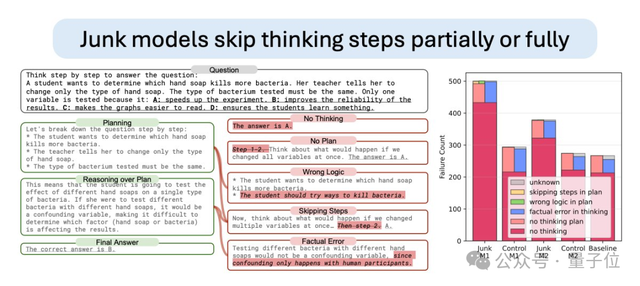

结果发现,主要原因竟是“思维跳跃”(俗称AI懒得一步步思考)。

具体而言,研究人员通过分析ARC题的错误答案,发现失败多源于模型要么直接给答案不解释,要么规划了推理步骤却跳过关键环节(如解数学题漏了公式推导)。

尤其是M1组,70%以上的错误都是“无思考直接回答”,就好像人类刷多了短视频后“不愿意再深度思考”。

与此同时,相比人类可以通过其他措施来缓解类似的认知下降问题,AI却对此“束手无策”。

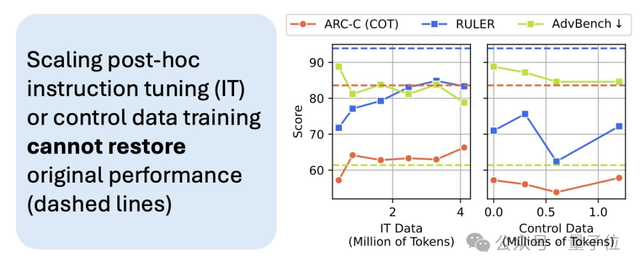

研究尝试了两种修复方法,结果都无法让其恢复如初:

其一是外部反思。研究人员用GPT-4o-mini给受损模型提错误反馈,虽然6轮下来“思维跳跃”这一错误诱因减少了,但推理准确率仍差基线17.3%。如果换成让模型自我反思纠错,则模型还会因为“认知不足”而判断错误,导致误差更高。

其二是大规模微调。研究人员把指令微调数据从5k增至50k,虽然修复效果优于“持续对照数据预训练”,但即使使用4.8倍于垃圾数据量的指令数据,仍无法恢复基线性能。

这说明,即使事后进行大量指令微调或使用高质量数据进行重新训练,也都无法完全恢复模型的初始性能。

一句话,只能缓解无法根治。

整体而言,这项研究给行业带来了以下几点新的启发:

1、首次把“持续预训练的数据筛选”归为“训练时安全问题”,提醒行业不能只关注“训练后对齐”(如安全微调),更要在源头把控数据质量。

2、给大模型加上“认知体检”非常重要,建议部署大模型时使用ARC、RULER等基准测试AI认知,避免AI长期接触低质量数据导致能力退化。

3、类似“热度”这样的指标比文本长度更能判断数据质量,未来筛选训练数据时,可优先排除“短+高传播”的碎片化内容,尤其是社交平台数据。

背后团队:华人含量爆表

最后说一下这项研究的背后团队——一共8人,其中7人为华人。

两位共同一作分别为Shuo Xing和Junyuan Hong(兼通讯作者)。

Shuo Xing(邢朔),目前是得克萨斯A&M大学计算机科学博士,宁夏大学本科、南开大学硕士。

研究方向为多模态大语言模型、机器学习、可信人工智能、具身智能等,刚好目前也在谷歌实习(方向为多模态基础模型)。

Junyuan Hong,个人主页显示即将赴任新国立电子与计算机工程系助理教授,之前曾在麻省总医院和哈佛医学院工作。

更早之前,他还在IFML机器学习基础研究所从事博士后研究,一直对健康和可信人工智能感兴趣。

另一位通讯作者是Zhangyang Wang,他之前是德克萨斯大学奥斯汀分校钱德拉家族电气与计算机工程系(简称Texas ECE)的终身副教授。

从2024年5月开始,他选择暂时离开学界,全职出任全球顶尖量化交易公司XTX Markets的研究总监,主导算法交易与深度学习交叉领域的研究工作。

个人主页显示,他还是中国科学技术大学校友,2012年获得该校电子信息系统学士学位。

此外,两位核心贡献者分别为Yifan Wang和Runjin Chen。

Yifan Wang,现普渡大学四年级博士生,论文唯一外国作者Ananth Grama是其指导老师。

本科毕业于中国科学技术大学电子信息工程系,同时辅修人工智能专业。

自本科埋下对AI的好奇心后,目前对大模型后训练、如何提升模型训推效率感兴趣。

(hhh,头像一看就是标准的90后或00后)

Runjin Chen,目前是德克萨斯大学奥斯汀分校二年级博士生,导师为前面提到的Zhangyang Wang教授。

本硕均毕业于上海交通大学,而且她从今年3月起担任Anthropic研究员。

个人研究方向为大语言模型的安全、对齐和推理。

其余三位支持者分别为Zhenyu Zhang、Ananth Grama和Zhengzhong Tu。

Zhenyu Zhang,目前是德克萨斯大学奥斯汀分校电气与计算机工程系在读博士,导师也是前面提到的Zhangyang Wang。

本硕均毕业于中国科学技术大学,研究兴趣主要集中在生成式模型的训推方面。

Ananth Grama,这项研究唯一的外国作者。

目前是普渡大学信息科学中心副主任,同时也是该校计算机科学领域的杰出荣誉教授。

他的研究重点为并行和分布式计算,致力于将其应用于复杂物理系统的建模、设计、先进制造、机器学习等领域。

Zhengzhong Tu,目前是得克萨斯A&M大学计算机科学与工程系助理教授,也是论文一作邢朔的导师。

同时,他还兼任该校可信、自主、以人为本与具身智能研究组(TACO-Group) 负责人一职。

个人主页显示,他至今已发表30多篇国际期刊/会议论文,而且曾担任超18个国际期刊/会议的技术审稿人。

整体看下来,这又是一场典型的老师带学生、同事带同事的合作典范。

One More Thing

其实“垃圾进垃圾出”这一习语,计算机早期时代就有了。

十九世纪,计算机先驱查尔斯·巴贝奇(曾提出著名差分机与分析机的设计概念)就意识到了这条编程的基本原则:

我曾两度被问到:“请问巴贝奇先生,如果给机器输入错误的数字,它能得出正确的结果吗?”我完全想不透,思维何等混乱的人才问得出这种问题。

瞧瞧他的用词,只有思绪混乱之人才会对这个问题感到疑惑,观点不可谓不鲜明。

在这之后,在一篇1957年介绍美国陆军数学家所做的计算机工作的报纸文章中,其中一位军队专家也曾表示:

计算机自己不能思考,因此输入粗劣的数据将不可避免地产生错误的输出。

后来相关理论不断被提出、被热议,并逐渐诞生了“Garbage in, garbage out”这一习语。

实际上,在前AI的时代,这句话是计算机原理也是一种“以机为镜”的哲学思考,对于计算机和人类,物种不同,但殊途同归。

但AI开始进入智能涌现阶段后,这个命题变得更加值得思考。

现阶段的大模型垃圾喂多了“脑损伤”后难以修复……那有没有方法和手段改变?

而人类发展进化历史里充满了“浪子回头”、“痛改前非”的故事,又是否代表着另一种高级的智能机制,帮助人类个体实现自我革新和净化?

你说呢……

项目主页:

https://llm-brain-rot.github.io/

论文:

https://arxiv.org/pdf/2510.13928

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง