“最强具身VLA大模型”,究竟强在哪儿?

让机器人从失败中学习

henry 发自 凹非寺

量子位 | 公众号 QbitAI

看似轻描淡写,实则力透纸背。

Physical Intelligence刷屏全网的机器人基础模型π*0.6,一亮相就秀出了实力:

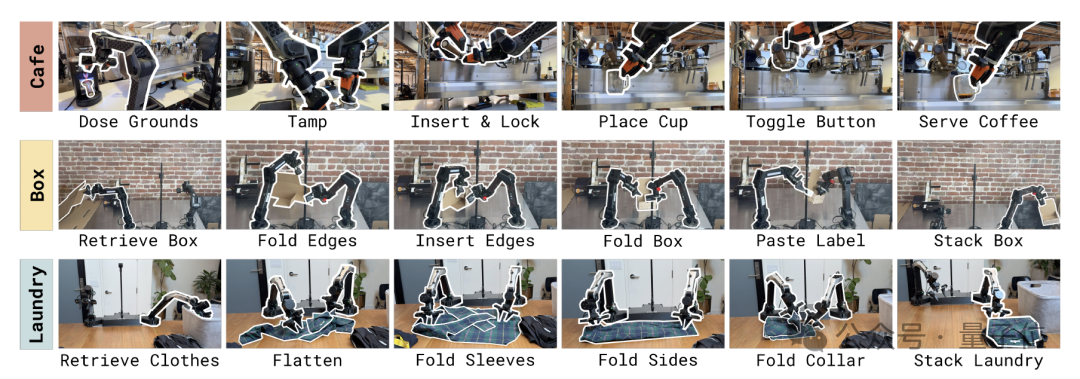

让机器人连续一整天制作意式浓缩咖啡,数小时不间断折叠各类衣物,还能精准组装工厂所需的包装纸箱。

在π*0.6的加持下,这些任务的成功率都达到了90%以上。

然而,仔细阅读论文就会发现,比起连做13个小时咖啡,π*0.6真正的突破在于引入了一种更直觉的学习方法——Recap:

- 指导:用人类示范教它基础动作

- 辅导:纠错指导让它修正错误

- 练习:从自主经验中不断优化、变得更强

这彻底扭转了过去机器人只会逼近 “真值” 的模仿学习模式,让机器人能从自己的错误中成长。

就连网友也直呼:

从错误中学习,这不比人都强?

最强VLA模型——π*0.6

π*0.6延续了Physical Intelligence此前一贯的VLA(视觉-语言-动作模型)路线,是今年四月份发布π0.5以来最新的VLA模型。

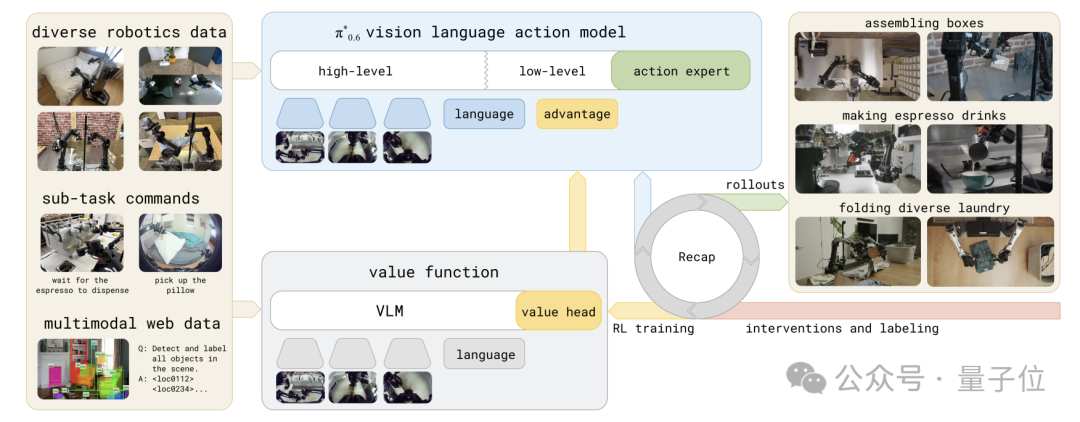

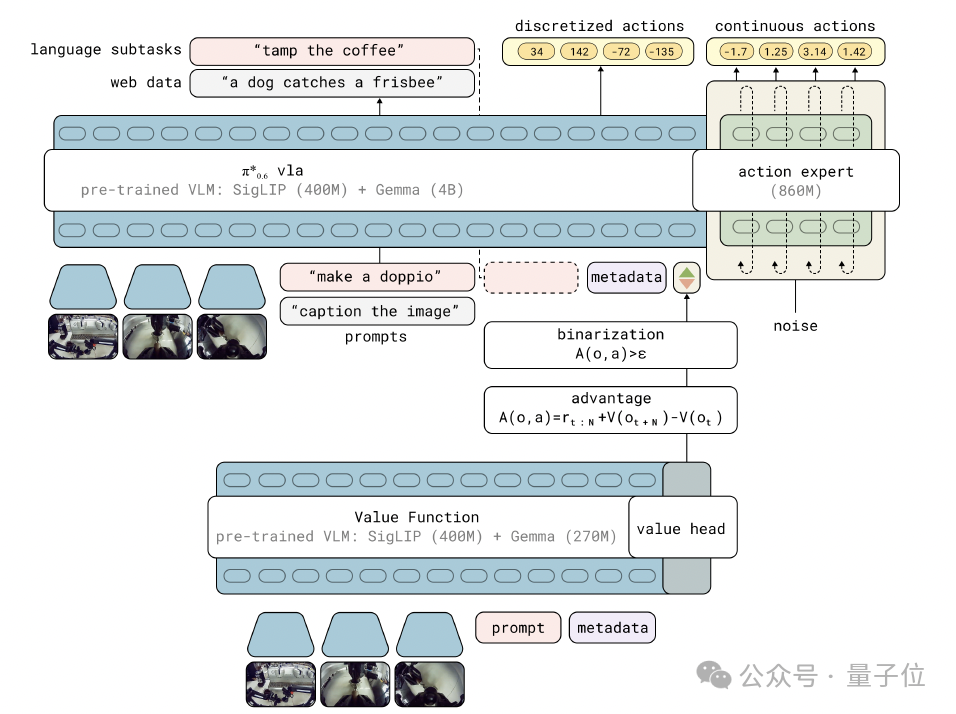

总的来说,π*0.6的核心贡献在于提出了一种通用训练方法——基于优势条件策略的经验与纠偏强化学习(RL with Experience & Corrections via Advantage-conditioned Policies,RECAP)。

RECAP让VLA能够使用奖励反馈和人类介入进行训练,其主要包含三个阶段:

- 离线RL:基于多机器人、多任务的示范数据(包括失败数据)训练价值函数和策略

- 微调:用人类示范将π*0.6适配到具体任务(咖啡/折衣服/组装盒子)

- 在线阶段:机器人自主执行任务,获得稀疏奖励,并结合专家在线纠偏,更新价值函数,再通过优势条件化改进策略

接下来,让我们具体来看。

首先,对于为什么RECAP选择价值函数,而不是标准的策略梯度,这里有个关键的巧思。

一方面,真实机器人数据极度异构:包括人类示范、专家干预、以及机器人在不同策略下的执行轨迹。标准的策略梯度方法需要on-policy的新鲜数据,难以有效吸收这些历史混合数据,因此天然不适合具身场景。

另一方面,VLA模型基于Flow Matching生成连续动作,这类模型没有显式的log π(a|s),导致无法像传统策略那样对直接求梯度。

换句话说,PPO、REINFORCE 这些算法在这种模型结构上根本施展不开。

因此,RECAP没有走传统RL的路线,而是采用了一个巧妙的“优势条件化”策略:

模型仍按监督学习方式训练,但额外给它一个输入,告诉它当前动作的优势值(advantage)。优势越高,代表“这个动作更值得模仿”。

于是整个流程变成了:

价值函数负责评价 → 优势条件化负责表达 → VLA用监督学习吸收所有数据

换句话说,RECAP用价值函数判断动作质量,再用优势条件化把原本需要RL求解的策略更新,重新写成了大模型最擅长的监督学习问题。

训练价值函数与策略提取:

为了让模型从异构数据中学习,首先需要训练一个能够识别“好坏”的价值函数。无论数据来自哪里(演示或自主尝试),处理过程如下:

- 计算经验回报:对每条轨迹,从当前时间步到结束计算累计回报,并归一化、离散化成201个区间,为价值函数提供训练目标。

- 训练分布式价值函数:用多任务分布式价值函数预测离散价值分布,通过最小化交叉熵损失进行训练,再提取连续价值函数,得到每个状态-动作的实际价值。

- 计算优势(advantage):用动作的实际回报减去价值函数预测,得到优势值,并二值化形成高/低优势指标,作为策略训练的额外输入,引导模型选择更优动作。

有了优势信号,我们就能实现高效的策略提取。这种方法完美满足了前文提到的对离线RL的需求:

- 充分利用多样化的离策略数据:包括最初的人类示范、专家干预,以及机器人自主执行的轨迹(既有最新策略的,也有早期策略的)。

- 可扩展性:方法需要能够应用于大型VLA模型,包括那些使用流匹配(flow matching)或扩散(diffusion)生成动作的模型。

- 同时利用优劣数据:既要有效利用近似最优的动作,也要利用次优动作的数据,这对于通过自主经验提升策略尤其重要。

通过这种设计,RECAP成功地在不依赖昂贵在线PPO更新的情况下,利用混合质量的离线数据实现了机器人的自我进化。

在线阶段:专家纠错 + 自主经验

在机器人自主执行阶段,RECAP通过两类数据持续优化策略:

- 专家纠错:专家远程干预纠正严重错误(如纸箱折叠顺序颠倒),每一次纠错动作都会被标记为“正向优势”,训练模型学习如何恢复错误。

- 自主经验:模型自主完成的轨迹,无论成功还是失败,都纳入训练数据。通过价值函数和优势指标,自动筛选有效信号,优化精细动作。

模型架构与性能

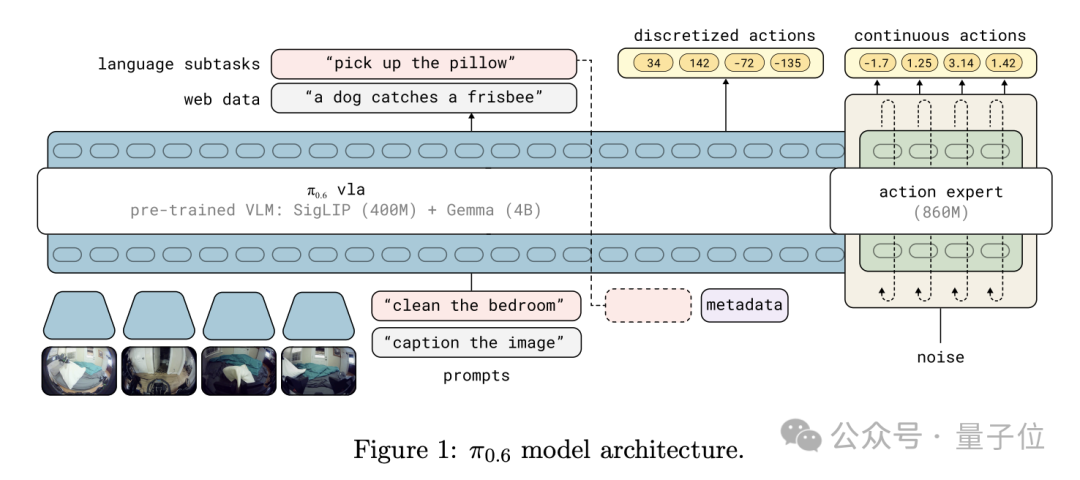

π*0.6是在π0.6基础上构建的,而π0.6又是对π0.5的升级版本。

π0.6的Backbone从Pi0、π0.5的Gemma(2.6B)扩展到Gemma3(4B),Action Expert参数量也升级到了860M。

在模型架构方面,π0.6延续了π0和π0.5架构,通过流匹配(flow matching) 和离散动作token 输出生成动作片段。

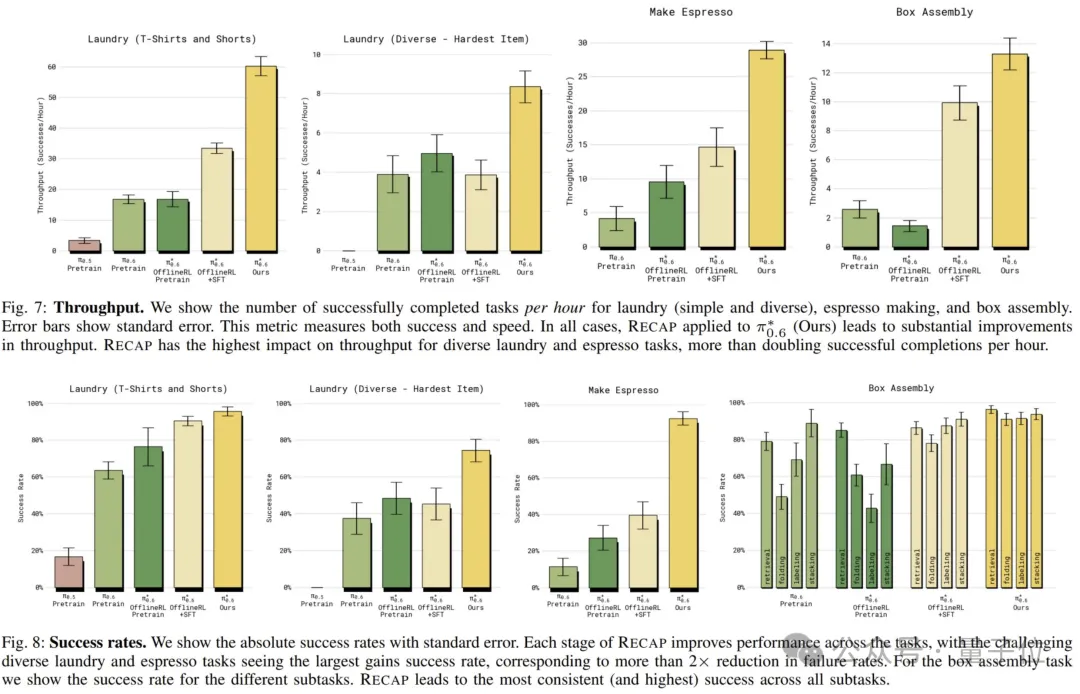

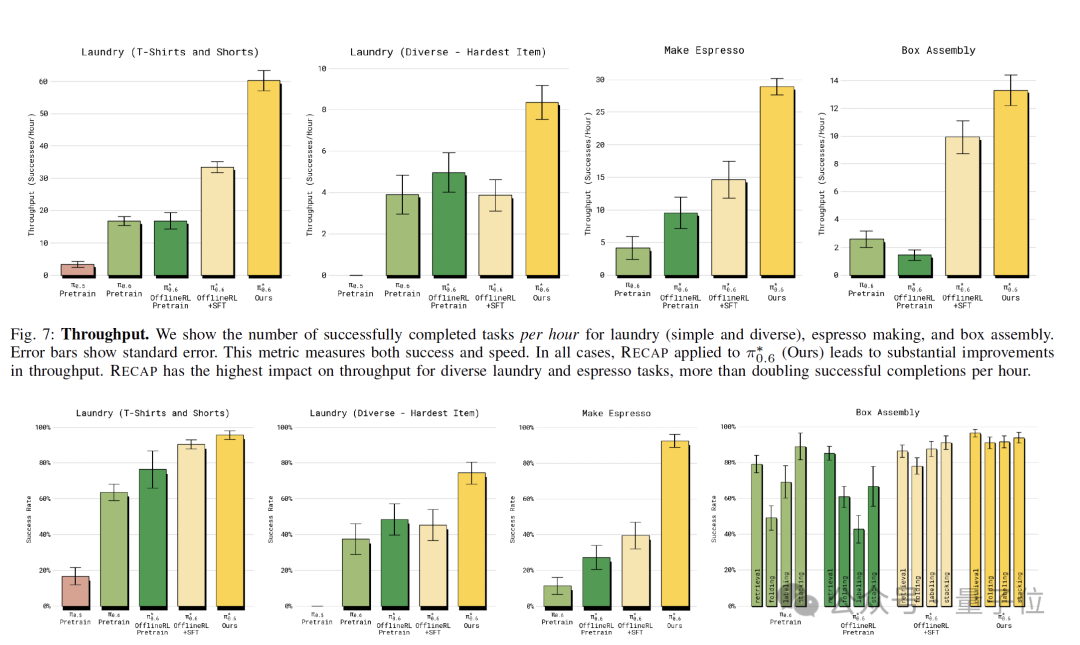

从实验来看,研究团队在三个高难度的现实任务中评估了模型:折叠多样化的衣物、组装纸箱(工厂环境)和制作浓缩咖啡。

在最难的任务(如折叠多样化衣物和制作咖啡)中,RECAP将任务的吞吐量(每小时成功次数)提高了一倍以上,相比于仅进行监督微调(SFT)的模型,RECAP将任务失败率降低了约2倍。

与此同时,模型表现出极高的稳定性,例如连续13小时制作咖啡、连续2小时折叠衣物而无需人为重置。

从失败经验中学习

正如开头提到的,Recap最具启发性的地方,莫过于它让机器人能够从错误经验中学习。

俗话说“失败乃成功之母”,但在传统的模仿学习,乃至更广泛的监督学习中,逼近真值或最优解通常被认为是最直接、最有效的策略。

这种方法在大规模语言模型(LLM)和其他机器学习系统上确实表现出色,数学上也简洁优雅。

然而,对于现实世界的机器人,仅仅知道如何做对,却不知道如何从错误中恢复,就会成为关键障碍。

在LLM等生成静态输出的AI系统中,监督学习假设数据是独立同分布(i.i.d.),预测输出不会影响后续输入,因此偶尔的偏差不会带来致命问题。

但对于需要持续与外界互动的系统,例如机器人,情况则完全不同。

模仿学习中模型的每一次动作都会影响未来状态,一旦出现轻微错误,就可能进入训练数据未覆盖的新状态,从而触发滚雪球式误差。这些错误叠加后,任务可能彻底失败。

因此,要想让机器人“每次都成功”,光靠复制示范数据是不够的。

解决之道在于:让视觉-语言-动作(VLA)模型能够从自身实际犯过的错误中学习,就像人类通过练习不断纠正失误一样。

问题在于,这些经历该如何标注?如果简单地让模型复制过去的行为,它只会学会重复错误。关键是如何从“坏数据”中提炼出有效的训练信号。

Recap通过指导中辅以纠正,练习中辅以强化来实现这一点:

教练式纠偏(corrections)当机器人犯错时,专家通过遥操作介入,示范如何恢复、如何更好地完成任务。

不同于传统的示范教学,这里不是教“该怎么做”,而是教“当事情出错时该如何修正”。

这种针对性纠偏弥补了传统模仿数据的不足,是防止错误累积的关键。

强化学习(reinforcement learning)

然而,仅仅依靠人类提供纠正措施是远远不够的,机器人需要自主学习。

机器人需要根据一个回合的总体结果自行判断其行为的好坏,并迭代地学习执行好的行为,同时避免坏的行为。

由此,就引出了基于对错奖励的强化学习。

如上文所说,为了实现强化学习,核心在于解决信用分配(credit assignment)的问题。

比如,要知道机器人执行的哪些动作导致了好的结果,哪些动作导致了坏的结果。

这里,Recap通过训练一个价值函数(value function)来应对这一挑战,它可以预测当前状态相较于其他状态的优劣。

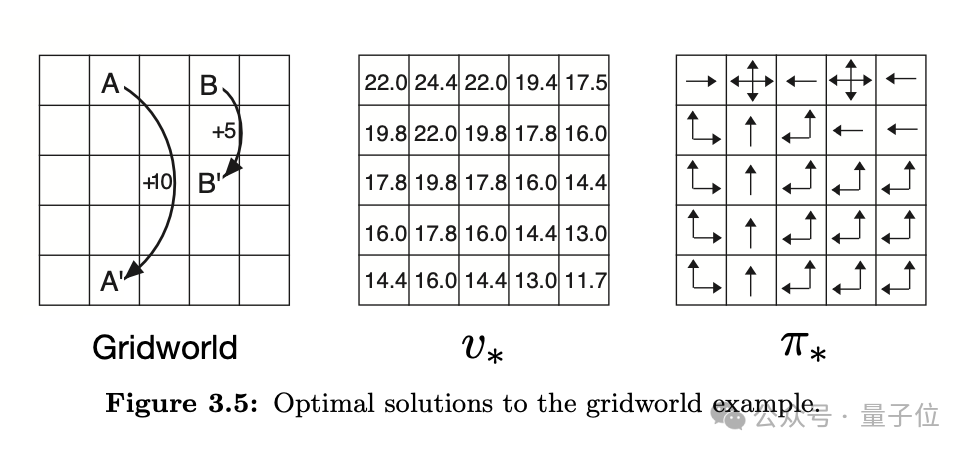

△图源:Reinforcement learning: An introduction

举例来说,在经典的格子世界中,智能体会通过一次次尝试更新每个状态的价值:落在好格子上,价值提高;掉进坏格子里,价值降低。

随着价值评估逐渐准确,智能体自然会倾向于选择那些通向高价值状态的动作。

同样的逻辑放到机器人身上:价值函数的变化为模型提供了一个简单而强大的判断信号。

- 让价值上升的动作:代表机器人朝任务成功更近了一步,应当被强化;

- 让价值下降的动作:意味着偏离目标,需要被抑制或修正。

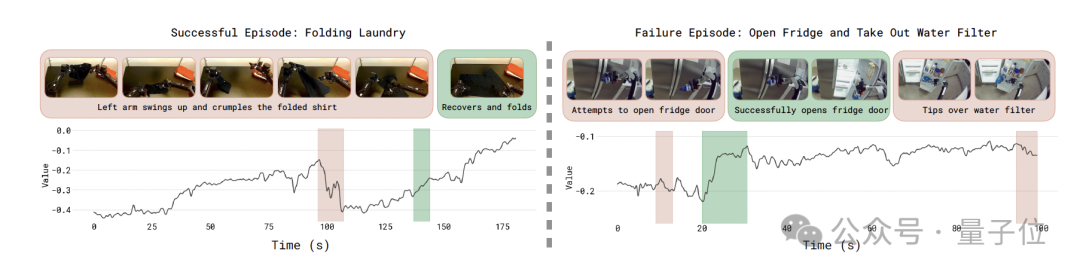

举例来说,在折叠衣服任务中(左图),红色区域表示机器人突然将衣服拉起的错误动作,对应价值下降;而绿色区域表示机器人正确完成折叠时,价值上升。

可以说,价值函数帮助机器人识别“关键步骤”与“错误来源”,让它真正具备在复杂真实环境中从经验中变强的能力。

当训练好价值函数后,下一步是“策略抽取”:让策略(即VLA模型)以价值变化为条件进行训练。

所有数据——包括成功和未成功——都被保留,同时告知模型哪些动作是有效的、哪些动作应避免。

这种优势条件化(advantage-conditioned)训练能够让模型在保留全部经验的前提下,从失败中学习,从而表现超越单纯示范数据的水平。

综上,Recap不仅让机器人学会了执行任务,更重要的是,它让机器人学会了自我纠正和优化策略,为后续复杂任务的鲁棒性和效率提升提供了可扩展的解决方案。

与此同时,如果从好数据(示范)少,坏数据(错误经验)多的视角来看,π*0.6 的突破可能更具深远意义 ——

它证明了机器人能从真实执行中收集的 “不完美经验” 里,提炼出高效的学习信号,这也为后续机器人研究开辟了全新思路,提供了极具价值的探索方向。

参考链接:

[1]https://www.pi.website/download/pistar06.pdf

[2]https://www.pi.website/blog/pistar06

[3]https://www.physicalintelligence.company/download/pi05.pdf

[4]https://x.com/svlevine/status/1990574916622856290

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง